Aber sind wir tatsächlich wegen einer menschengemachten Klimakatastrophe gezwungen, unsere westlichen Volkswirtschaften und damit unseren Lebensstandard durch eine Aufgabe unserer gegenwärtigen technologischen Basis zu zerstören? Der Mainstream der Klimawissenschaft verdächtigt Kohlenstoffdioxid (CO2) aus dem industriellen Verbrauch von fossilen Energieträgern, den natürlichen Treibhauseffekt soweit zu verstärken, dass die Erde schließlich unbewohnbar wird. Legionen von Klimaalarmisten, weltweit bezahlt mit Milliarden von Euros aus staatlichen Forschungsmitteln, von privaten Stiftungen und ökologischen NGOs, stützen die Wahrnehmung einer angeblichen Klimakatastrophe in der Bevölkerung und behaupten, ihre AGW-Theorie sei gesicherte Wissenschaft. In einer abartigen Verzerrung wissenschaftlicher Ideale fordern sie ein Ende der Klimadebatte und werden dabei von einer ideologisierten Mehrheit der Massenmedien unterstützt.

Unprofitable Wissenschaftszweige drängen sich an die Tröge des Klimawahns, Psychologen und Historiker publizieren eine wachsende Zahl von Veröffentlichungen, in denen der häretische Einfluss von unabhängigen Klimawissenschaftlern, sogenannten „Klimaleugnern“, auf die öffentliche Wahrnehmung einer Klimakatastrophe gegeißelt wird. Gegenwärtig wird von einigen Politikern sogar gefordert, die wissenschaftlichen Standpunkte solcher „Klimaleugner“ unter Strafandrohung zu stellen, um diese in der öffentlichen Diskussion mundtot zu machen.

Solche unabhängigen Klimawissenschaftler, mit abweichenden wissenschaftlichen Ergebnissen zum angeblich menschengemachten Klimawandel, arbeiten meist mit spärlichen Forschungsmitteln oder sogar ehrenamtlich. Aber anstelle einer offenen und fairen wissenschaftlichen Diskussion über ihre Erkenntnisse werden sie üblicherweise persönlich diskeditiert, und der Klimamainstream versucht, sie aus der wissenschaftlichen Gemeinschaft herauszumobben.

Es sieht so aus, als wären der klimawissenschaftliche Mainstream und seine politischen Unterstützer vom Virus einer Gutmenschen-Korruption befallen, die von einem ökologischen kohlenstoff-freien Paradies auf Erden träumt.

Im Angesicht der geplanten Dekarbonisierung unserer Welt sollten wir nicht vergessen, dass sich im Laufe der kulturellen Evolution des Menschen die verfügbare pro-Kopf Energiemenge mehrfach drastisch erhöht hatte und unseren heutigen Lebensstandard erst ermöglicht:

- Steinzeit (= kleine dörfliche Gemeinschaften):

Die verfügbare pro-Kopf Energiemenge betrug etwa das 3 bis 6-fache des Grundbedarfs.

- Zeitalter des Ackerbaus (=fortgeschrittene regionale Kulturen):

Die verfügbare pro-Kopf Energiemenge betrug etwa das 18 bis 24-fache des Grundbedarfs.

- Industriezeitalter (=globalisierte Welt):

Die verfügbare pro-Kopf Energiemenge beträgt etwa das 70 bis 80-fache des Grundbedarfs.

Der industrielle Gebrauch von fossilen Energieträgern seit Beginn der Industrialisierung hat das Gesundheitswesen, die individuelle Lebenserwartung, unseren Lebensstandard, die Verfügbarkeit und die Qualität von Lebensmitteln, das Transportwesen, die Kommunikation und den allgemeinen technologischen Standard für jedermann nachhaltig verbessert.

Im Umkehrschluss heißt dass, unser gegenwärtiger Lebensstandard beruht zwingend auf der Nutzung fossiler Energieträger.

Das Prinzip der menschengemachten Klimakatastrophe kann jeder Laie ganz einfach verstehen: Je höher der atmosphärische CO2-Anteil steigt, umso höher wird die globale Durchschnittstemperatur. Folglich glaubt eine überwältigende Mehrheit der Bevölkerung in den Industrienationen, der Verbrauch fossiler Energieträger würde durch den verursachten CO2-Ausstoß zu einer Klimakatastrophe führen. Aber ist diese direkte Abhängigkeit zwischen Temperatur und atmosphärischem CO2-Gehalt wissenschaftlich wirklich bewiesen?

Die AGW-Theorie steht in fundamentalem Widerspruch zu diversen wissenschaftlichen und wirtschaftlichen Fakten:

(1) Die gegenwärtigen Klimamodelle können die tatsächliche Klimahistorie gar nicht abbilden: Aktuelle Klimamodelle sind nicht einmal in der Lage, den historisch gemessenen Temperaturverlauf bis zum Jahr 1850 korrekt zurückzurechnen. Diese Schwäche der Klimamodelle beweist, dass weder alle klimarelevanten Parameter, noch ihr tatsächlicher Klimaeinfluss und schon gar nicht die Interaktion dieser Parameter miteinander korrekt in die aktuellen Klimamodelle eingeflossen sind. Mit solchen Klimamodellen wird dann aber das zukünftige Klima bis weit in die Zukunft hinein hochgerechnet und die Politik beruft sich bei der vorgesehenen globalen Dekarbonisierung auf solche Modellergebnisse.

(2) Die Klimawissenschaften sind bis heute nicht in der Lage, den natürlichen und den angeblich menschengemachten Klimaantrieb zu trennen. Bis heute wurde eine solche quantitative Trennung beider Effekte nirgendwo veröffentlicht. Die meteorologischen Temperaturmessungen begannen um 1850, am Ende der „Kleinen Eiszeit“ und zu Beginn der Industrialisierung. Der Temperaturanstieg von der „Kleinen Eiszeit“ muss eine natürliche Ursache gehabt haben, denn diese „Kleine Eiszeit“ endete ohne jeden menschlichen Einfluss. Aber im Gegenteil, die Klimawissenschaft rechnet diesen Anstieg der menschengemachten Klimaerwärmung zu, obwohl der Temperaturanstieg viel schneller verlaufen ist, als die Entwicklung der Industrialisierung.

(3) Klimamodelle ignorieren den Einfluss von natürlichen solaren Zyklen auf das Klima. Die bekannten Zyklen (Schwabe, Hale, Yoshimura, Gleißberg, Seuss-de-Vries, Dansgaard-Oeschger, and Hallstatt)mit Perioden von 11 bis mehr als 2.000 Jahre sind in den computerbasierten Klimamodellen nicht enthalten. Die Klimawissenschaft argumentiert mit der geringen Veränderung der Solarkonstanten über solche Zyklen. Aber diese Zyklen waren vor der Industrialisierung die einzige Ursache für natürliche Klimaschwankungen in unserer aktuellen Warmzeit. Die Klimawissenschaft ignoriert die Ergebnisse von Svensmark, dass nämlich die Kerne zur Wolkenbildung aus der kosmischen Strahlung geliefert werden, die wiederum vom Magnetfeld der Sonne gesteuert wird. Dieser Effekt stellt eine natürliche Verstärkung der Strahlungsschwankungen unserer Sonne dar. Bei einer schwachen Sonne kann vermehrt kosmische Strahlung in die Erdatmosphäre eindringen und führt über eine verstärkte Wolkenbildung zu einer weiteren Abkühlung. Das CLOUD-Experiment am Züricher CERN Institut hat das herkömmliche Aerosolmodell für die Wolkenbildung in Klimamodellen um einen Faktor von einem Zehntel bis einem Tausendstel reduziert und gleichzeitig die Wirksamkeit des Svensmark-Effekts bis zum Zehnfachen bestätigt.

(4) Die historisch gut dokumentierte Mittelalterliche Warmzeit (MWP), die der “Kleinen Eiszeit” vorausgegangen war, wurde im dritten Bericht des IPCC (TAR 2001) von der Mann’schen „Hockeystick-Kurve“ unterdrückt, offenbar, um zur Stützung der AGW-Theorie ein konstantes vorindustrielles Klima auf dem Niveau der „Kleinen Eiszeit“ nachzuweisen. Diese „Hockeystickkurve“ wurde inzwischen zwar wissenschaftlich widerlegt, dient aber Klimaalarmisten immer noch als Argument für den menschengemachten Klimawandel, während die Mittelalterliche Wärme Periode von der Klimawissenschaft auf ein europäisches Phänomen herabgestuft worden ist.

Aber das Gegenteil ist der Fall: Die Auswertung von hunderten von wissenschaftlichen Veröffentlichungen weltweit durch Lüning und Vahrenholt beweist, dass die mittelalterliche Wärmeperiode ein globales Ereignis war, das durch die Variabilität der Sonneneinstrahlung verursacht worden ist. Dadurch wird aber die Theorie vom menschengemachten Klimawandel existenziell in Frage gestellt. Online Atlas von Lüning/Vahrenholt.

(5) Die Klimawissenschaft verleugnet in ihren Klimamodellen die natürlichen Bahnschwankungen unserer Erde um die Sonne(Milanković-Zyklen), um ihren eingängigen linearen Zusammenhang zwischen Globaltemperatur und CO2-Gehalt der Atmosphäre aufrecht zu erhalten. Inzwischen reduziert die Klimawissenschaft die historische Klimaentwicklung sogar auf die zweite Hälfte des vergangenen Jahrhunderts, nur um CO2 als den angeblichen Hauptklimaantrieb zu stützen. Bereits im Jahre 1924 hatten Wladimir Köppen und Alfred Wegener, der Vater der modernen Plattentektonik, die orbitalen Milanković-Zyklen als Ursache der paläoklimatischen Schwankungen der vergangenen Eiszeitalter identifiziert und nachgewiesen.

Reprint des Buches “Die Klimate der geologischen Vorzeit” (Bornträger 1924) mit englischer Übersetzung.

(6) Eine wachsende Versauerung der Ozeane durch den vom Menschen verursachten CO2-Aussoß soll in Zukunft zu einer Einschränkung des marinen Artenreichtums führen. Erstens kann eine bestimmte Menge an CO2 entweder als klimaaktives Gas in der Atmosphäre wirken oder, gelöst in Meerwasser, zu einer Versauerung der Ozeane führen, aber nicht beides zur gleichen Zeit. Üblicherweise werden aber beide Effekte für sich mit dem gesamten anthropogenen CO2-Aussoß berechnet.

Zweitens sinkt die Lösungsfähigkeit von CO2 mit steigender Wassertemperatur. Je wärmer also das Meerwasser wird, umso weniger CO2 kann es aufnehmen und versauern. Der verzögerte Anstieg von atmosphärischem CO2 nach paleoklimatischen Temperaturanstiegen beweist diesen Zusammenhang und wird von Eiskernanalysen bestätigt.

(7) Ein globaler Meeresspiegelanstieg durch eine vom Menschen verursachte Klimaerwärmung soll zu einem Verschwinden der pazifischen Inseln führen und Tieflandgebiete und Hafenstädte in aller Welt überfluten. Ein dramatischer Meeresspiegelanstieg von mehr als einhundert Metern ist ein natürliches Phänomen zu Beginn aller Warmzeiten. Die Existenz mariner Eismassen wird offenbar allein durch die Meerwassertemperatur bestimmt, während landgebundene Eismassen auf eine Veränderung der vertikalen geographischen Klimazonen reagieren. Die Durchschnittstemperaturen in zwischeneiszeitlichen Warmperioden schwanken üblicherweise um einige Grade und terrestrische Gletscher reagieren darauf mit natürlichen Vorstößen und Rückzügen. Aus den Alpen ist bekannt, dass Gletscher beim gegenwärtigen Abschmelzen Bäume aus der Mittelalterlichen Warmzeit freigeben, die damals dort natürlich gewachsen waren.

Was wir heute auf Grönland und der antarktischen Halbinsel beobachten, ist ein Gletscherrückzug in größere Höhenlagen, während die Eismassen auf dem antarktischen Kontinent weiter anwachsen. Satellitenmessungen der Meeresspiegelschwankungen im offenen Ozean sind sehr viel anfälliger für Fehler bei der Gezeitenkorrektur, Meeresströmungen, zusätzlichen windgetriebenen Wassermassen und Meereswellen als feste Pegel an den Küsten. Diese konventionellen Pegelmessungen zeigen aber seit vorindustriellen Zeiten einen konstanten Meeresspiegelanstieg von einigen Millimetern pro Jahr. Ohne zielgerichtete Adjustierung historischer Messwerte wird sich dieser Trend sicherlich auch in Zukunft weiterhin so fortsetzen.

(8) Der „Stillstand“ des globalen Temperaturanstiegs, der inzwischen etwa 20 Jahre andauert, hat bereits mehrfach zu Korrekturen an den historischen Temperaturmessungen geführt. Verbesserte Klimamodelle verlagern diese „fehlende Wärme“ jetzt in die Tiefen der Ozeane. Offensichtlich hatten die Klimamodelle diesen Stillstand des globalen Temperaturanstiegs nicht abgebildet. Aber anstatt nun die Eingangsbedingungen der zugrundeliegenden Gleichungssysteme zu korrigieren, um die Modelle mit den aktuellen Messwerten in Übereinstimmung zu bringen, werden die Ergebnisse aktueller Klimamodelle dahingehend angepasst, dass sie zu den Vorhersagen veralteter Modellrechnungen passen.

Es bleibt die Frage offen, wie die „fehlende Wärme“ in tiefere Lagen der Ozeane entweichen konnte, ohne von dem weltumspannenden Messbojennetz ARGO bemerkt worden zu sein.

(9) Die Klimawissenschaften reduzieren die Auswirkungen einer globalen Klimaerwärmung auf dessen negative Folgen und veröffentlichen Horrorszenarien über einen Temperaturanstieg von 3 Grad bis zum Jahre 2100, während in jedem Winter tausende Menschen erfrieren. Für das Jahr 2014 wurde allein in Europa von etwa 40.000 Kältetoten berichtet, einfach weil diese Menschen ihre Stromrechnungen nicht mehr bezahlen konnten.

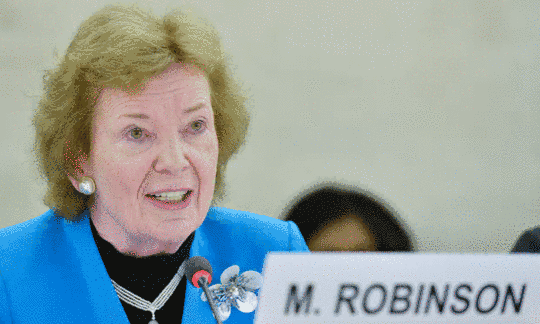

(10) Die Klimawissenschaft nimmt für sich in Anspruch, sie würde das Vorsorgeprinzip für die gesamte Menschheit verfolgen, indem sie den angeblich menschengemachten Klimawandel bekämpft. Die letzte große Klimaprophezeiung wurde von den wohlversorgten Propheten der Apokalypse rechtzeitig zum Pariser COP21-Klimagipfel veröffentlicht:

Der menschliche CO2-Ausstoß wird die nächste Eiszeit verhindern – in 50.000 Jahren! Ist es wirklich das Vorsorgeprinzip, eine gefährdete Eiszeit in 50.000 Jahren vor dem Menschen zu retten? Nein, das ist wahrhaftige Science-Fiction, wenn die Klimawissenschaft gesichertes paläoklimatisches Wissen über hunderttausende von Jahren ignoriert und auf der Datenbasis eines halben Jahrhunderts Spekulationen über eine in 50.000 Jahren ausfallende Eiszeit verbreitet. Mit dem Vorhaben, die Welt von ihren natürlichen Klimaschwankungen zu befreien, zerstören wir unsere Wirtschaft und die Zukunft unserer Kinder und Enkel. Und was ist mit den tatsächlichen Gefahren, die in Zukunft die Existenz der Menschheit bedrohen könnten, was ist mit Supervulkan-Eruptionen, Asteroideneinschlägen und der Abschwächung des Erdmagnetfeldes, was ist das Vorsorgeprinzip gegen diese sehr realen Bedrohungen?

(11) Erneuerbare Energien aus Sonnenstrahlung und Wind sollen die konventionelle Energieerzeugung ersetzen, um eine Klimaerwärmung durch CO2 zu vermeiden. Bisher kann solche erneuerbare Energie aber nur mit hohen Subventionen erzeugt werden, die direkt vom Verbraucher eingezogen werden, der wiederum einen Lebensunterhalt in einer mit konventioneller Energie betriebenen Industriegesellschaft verdient. Um unseren Lebensstandard zu erhalten, muss also nach einer globalen Dekarbonisierung der globale Energieverbrauch vollständig durch erneuerbare Energien gedeckt werden. Es werden in den Medien Zahlen verbreitet, die besagen, eine solche Dekarbonisierung sei bezahlbar und bis zum Jahre 2100 umsetzbar.

Aber diese publizierten Zahlen schließen nicht einmal die Kosten für die lebensnotwendigen Energiespeicher und die neuen Verteilungsnetzwerke ein, um bei nächtlicher Windstille die Versorgungssicherheit zu garantieren; und ebenfalls fehlen dort die steigenden Herstellungskosten für nahezu alle Produkte des täglichen Lebens. Durch diese steigenden Kosten, bei möglicherweise sinkenden Stückzahlen, werden durch fallende Löhne oder gar insgesamt weniger Beschäftigte die globalen Bruttoinlandsprodukte sinken. Die Frage ist, wer dann die steigenden Subventionen für erneuerbare Energien bezahlen soll.

(12) Der Landschaftsverbrauch in naturnahen Gebieten durch die Erzeugung von Solar- und Windenergie ist etwa 1.000- bis 10.000-mal höher als der Flächenverbrauch für konventionelle Kraftwerke. Es fragt sich, was die Dekarbonisierung der Welt aus unseren naturnahen Landschaften und den natürlichen Ressourcen unserer Erde machen wird.

(13) Gleichzeitig wird Druck auf die industrielle Landwirtschaft ausgeübt, sich auf eine ökologische Produktion ohne Kunstdünger und chemischen Pflanzenschutz umzustellen. Die landwirtschaftliche Erzeugung von Nahrungsmitteln steht bereits in Konkurrenz mit der Landnutzung für erneuerbare Energien. Durch die Einführung von Öko-Kraftstoffen, Stichwort E10, hat sich die weltweite Anbaufläche für Nahrungsmittel bereits verringert und Millionen Menschen zusätzlich leiden unter Unterernährung und Hunger. Die beabsichtigte globale ökologische Nahrungsmittelproduktion geht mit einem geringeren spezifischen Flächenertrag einher und dürfte daher den Ansprüchen einer wachsenden Weltbevölkerung in keiner Weise genügen.

Diese Zusammenstellung legt nahe, dass die Theorie vom menschengemachten Klimawandel auf falschen wissenschaftlichen Annahmen und wirtschaftlichen Spekulationen aufbaut.

Trotzdem verbreiten die Propheten des Weltuntergangs mit sehr unterschiedlichen persönlichen Motiven weiterhin ihre Weltuntergangs-Spekulationen und befeuern damit eine Massenhysterie gegen unser gegenwärtiges Wirtschaftssystem, das allein auf der Nutzung fossiler Energien basiert. Der religiöse Glaube an eine vom Menschen verursachte Klimaerwärmung ist ihre Waffe, um unsere gegenwärtige technische Zivilisation zu zerstören und die Menschheit in eine schöne neue kohlenstoff-freie Welt zu führen. Wir leben heute in einer neuen kulturellen Epoche, dem Anthropozän, in dem sich die fundamentalen Unterschiede zwischen wissenschaftlichen Fakten, persönlichen Meinungen und religiösen Gewissheiten zunehmend verwischen, während übersättigte Menschen ernsthaft glauben, sie könnten ihre Kuh schlachten und weiterhin deren Milch trinken.

Das wirkliche Problem der Menschheit bleibt eine ständig wachsende Weltbevölkerung und deren ausreichende Versorgung mit Nahrungsmitteln und Energie sowie der Erhalt natürlicher Lebensräume, die das Erbe der gesamten Menschheit darstellen.

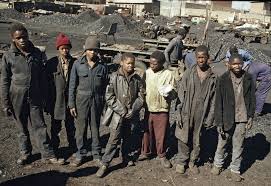

Die Armut in der Dritten Welt ist aber eine direkte Folge von Energiemangel und fehlender demokratischer Beteiligung. Der einzige Weg, der aus diesem Dilemma herausführt, ist eine Demokratisierung und wirtschaftliche Entwicklung dieser Gesellschaften. Eine solche Entwicklung würde ein weiteres Wachstum der Weltbevölkerung eindämmen, wie es der demographische Wandel in den Industrienationen im vergangenen Jahrhundert bewiesen hat. Während einer solchen Entwicklung kann der Verbrauch fossiler Energien in den Industrieländern unter Beibehaltung des gegenwärtigen Lebensstandards minimiert und der Schutz der weltweiten natürlichen Ressourcen sukzessive ausgeweitet werden.

Aber mit dem religiösen Glauben an eine menschengemachte Klimakatastrophe haben sich nun die gewählten und nicht gewählten politischen Führer dieser Welt, unterstützt von wissenschaftlichen Wahrsagern, indoktrinierten Massenmedien, religiösen Führern, mißgeleiteten ökologischen NGOs und malthusianischen Stiftungen entschieden, die Menschheit genau in die entgegengesetzte Richtung zu führen.

Ihr Fahrplan für die herbeigesehnte Dekarbonisierung der Welt bis zum Jahre 2100 wird eher über den Niedergang demokratischer Rechte in den Industrienationen zu einer nachhaltigen globalen Energieverknappung führen, die uns malthusianische Perspektiven für eine Globale Dritte Welt von ökologischen Biokleinbauern eröffnen mag. Oder um es weniger verklausuliert zu formulieren, in einer dekarbonisierten Welt werden die Menschen, unabhängig wie groß deren Zahl am Ende noch sein mag, zwölf Stunden am Tag in der Landwirtschaft arbeiten, um ein Viertel der gegenwärtig verfügbaren pro-Kopf Energiemenge zu erzeugen – gerade so viel wie einstmals in vorgeblich glücklicheren ökologisch-vorindustriellen Zeiten.

Und nun, während in Vorbereitung einer globalen Dekarbonisierung die Klimaideologen bereits weltweit ihre Messer wetzen, um die Menschheit aus diesem fossil befeuerten Paradies zu vertreiben, schauen die übersättigten Lämmer in den westlichen Industrienationen diesem Unterfangen gelassen wiederkäuend zu, als ginge sie das Ganze überhaupt nichts an…

Uli Weber ist Autor des Buches Klimahysterie ist keine Lösung.

Übernommen vom Die kalte Sonne Blog