Wurde ein Klimawandel-Einfluss bisher übersehen? Was ist, wenn Gott anstelle von CO2 das Klima lenkt?

Aus diesem Grund sind sich die christlich geprägten Klimaeliten absolut sicher, dass alle Wetter- oder Klimaänderungen nicht mehr von Gott, sondern nur noch vom Menschen verursacht sein kann.

Da die Erde jedoch nicht aufhört, das Wetter und Klima über längere Zeiträume zu verändern und schwanken zu lassen, führte dies zu verschiedenen Ursachentheorien:

– Im Mittelalter waren sich die Eliten über Jahrhunderte sicher, dass Klima- und Wetterveränderungen alleine durch Hexen verursacht werden. Die Folgen und die Art der Beweisführung waren fürchterlich, was man aber dem Zeitgeist geschuldet betrachten muss, wie es ein Bamberger Bischof vor einiger Zeit ausdrückte um zu vermitteln, dass den Verursacher keine Schuld trifft. Denn weil es damals Gesetz war, ist es juristisch einwandfrei und wird nur aufgrund späterer Gesetzesänderungen nicht rückwirkend zu einer Schuld.

– Aktuell sind sich die Klimawissenschafts-Eliten absolut sicher, dass beobachtete Klima- und Wetterveränderungen diesmal durch Menschen-verursachtes CO2 hervorgerufen sein muss und wie im Mittelalter auch ausschließlich die Richtung „zum Schlechten“ haben kann.

– Darstellung der Kirche:

Ökumenischer Rat der Kirchen: [2] "Es gibt keine offensichtliche Beziehung zwischen Evangelium und Klimawandel", erklärte Jakob Wolf, Leiter der Abteilung für Systematische Theologie an der Universität Kopenhagen.

Der Beleg dafür ist jedoch nicht aus den Religionsschriften abgeleitet, sondern aus der Doktrin, dass eine genügend oft verbreitete öffentliche Meinung immer auch die göttliche ist (Details dazu sind in Kirche und Klimawandel[8] nachlesbar).

Nun gibt es eine Hochreligion, nennen wir sie muslimisch geprägt, die weit nach der Bibel eine neuere und damit endgültig gültige Anweisung und Weissagung von Gott bekommen hat. Im Gegensatz zu den Evangelien, von denen kein Verfasser wirklich bekannt ist (die Apostelnamen sind rein fiktive Zuweisungen) und deshalb nur als „von Gott beim Schreiben geführt“ gelten, ist der Koran direkt vom Engel Gabriel übermittelt weshalb er einen authentischen Urheber hat, was ihn weit über das Neue Testament erhebt. Zudem ist er so umfassend, dass es zu seinem Verständnis nicht erforderlich ist, die vorhergehenden Schriften der damit endgültig überholten Buchreligions-Vorläufer inhaltlich zu betrachten.

Leider ist der Koran in seiner Versform und Reihenfolge nicht nach zeitlichem Ablauf, sondern nach Verslänge, schwer zu interpretieren. Wobei noch erschwerender dazu kommt, dass Gott alle seine Ur-Schriften (Talmud, neues Testament und Koran) in nicht eindeutigen Schriftformen übermittelt hat mit der Konsequenz, dass sie ausschließlich der jeweilige Schreiber sicher zurück-lesen kann (die damaligen Schriftformen waren als Gedächtnisstützen gedacht), den direkt zu fragen aber unmöglich ist. Während die Juden dies akzeptieren und entsprechend handeln, sind sich die Theologen der zwei anderen Religionsableger im Gegensatz absolut sicher, die Angaben Gottes richtig und genau interpretieren zu können. Und deshalb muss sehr sorgfältig beachtet werden, was Vertreter der mohammedanischen Religion nun über die wahre Ursache des Klimawandels herausgefunden haben.

Nicht gemäß den religiösen Vorschriften verhüllte Frauen beeinflussen das Klima und bringen Flüsse zum Versiegen

Ein leitender iranischer Geistlicher in Isfahan verkündete es in einer Predigt:

[1] Seyyed Youssef Tabatabi-nejad, a senior Islamic cleric in Isfahan, Iran, said during his weekly sermon last Friday that women dressing inappropriately is causing climate change.

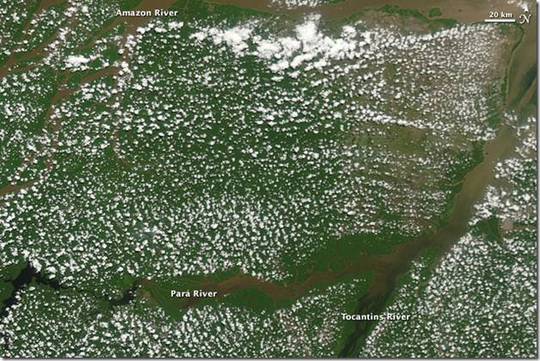

In his sermon, Tabatabi-nejad announced that his “office had received photos of women next to the dry Zayandeh-run River (a major river that runs through Isfahan), [dressed] as if they were in Europe. It is these sorts of acts that cause the river to dry up.”

Sinngemäß:

unangemessen gekleidete Frauen verursachen Klimawandel.

In seiner Predigt erklärt der Geistliche Tabatabi-Nejad, dass sein Büro Fotos von Frauen neben dem trockenen Zayandeh Fluss (einem großen Fluss, der durch Isfahan läuft) erhalten hatte, in denen diese Frauen gekleidet waren, als ob sie in Europa wären. Diese (nicht der religiösen Vorschrift entsprechende) Handlungen sind die Ursache dass der Fluss versiegte.

Die Einflussmöglichkeit des Himmels auf das Klima ist geradezu extrem

Viele mögen geneigt sein, darüber zu lächeln. Tatsache aber ist, dass im Westen oft hochrangige Politiker in höchsten Kirchengremien Mitglied sind (Umweltministerin Frau Hendricks z.B. ist Mitglied des Zentralkomitees der deutschen Katholiken, Göring Eckhardt ist im Kuratorium der internationalen Martin-Luther-Stiftung und war bis 2013 im Präsidium des deutschen evangelischen Kirchentags, Ministerpräsident Kretschmann, in seiner Jugend bei der Kommunistischen Studentengruppe / Marxisten-Leninisten, ist Mitglied im Diözesanrat der Erzdiözese Freiburg und im Zentralkomitee deutscher Katholiken[4] und wollte in seiner frühen Jugend sogar katholischer Pfarrer werden) und damit kenntlich machen, wie wichtig ihnen Kenntnisse, Festlegungen und Entscheidungen der Theologie sind und dass sie diese für richtig erachten.

Weil man diesen Einfluss des Himmels (an-)erkennt, wird er in den christlichen Kirchen auch mannigfaltig genutzt und dazu folgerichtig auch für das Klima gebetet: Pfarrverband Holzkirchen „Beten für das Klima“

Im Alten Testament ist beleg, dass Gott erheblich mehr und auch spontanen Einfluss auf das Klima erwirken kann als der maximale, jährliche anthropogenen Anteil von 120 St. CO2-Moleküle auf 1.000.000 Luftmoleküle[3]:

Elia war ein Mensch von gleicher Art wie wir,

und er betete inständig, dass es nicht regnen solle,

und es regnete drei Jahre und sechs Monate nicht im Land;

und er betete wiederum;

da gab der Himmel Regen, und die Erde brachte ihre Frucht.

(Jakobus 5:17+18)

Zudem kann Gott problemlos die Sonne still stehen lassen und damit den größten, denkbaren Klima-Einfluss ausüben:

Damals redete Josua zu Jehova, an dem Tage, da Jehova die Amoriter vor den Kindern Israel dahingab,

und sprach vor den Augen Israels:

Sonne, stehe still zu Gibeon; und du, Mond, im Tale Ajjalon!

Und die Sonne stand still, und der Mond blieb stehen

(Josua 10, 13 – 14)

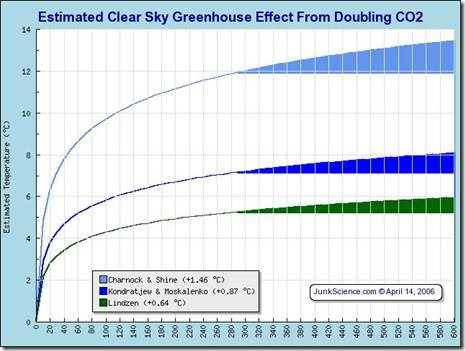

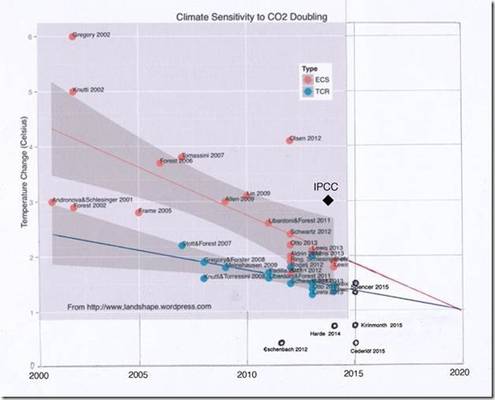

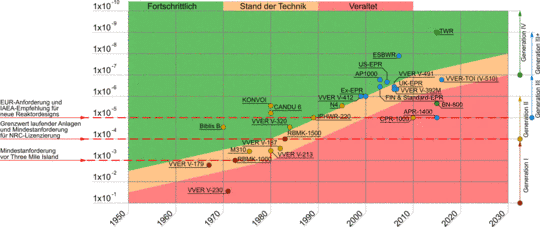

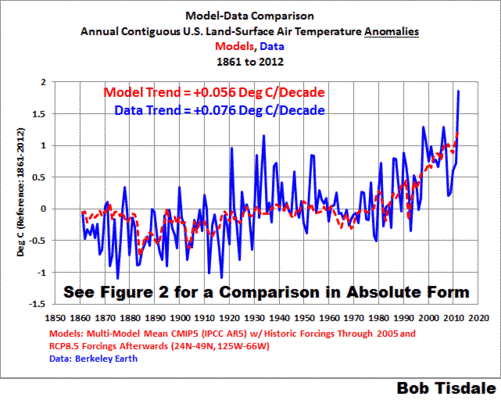

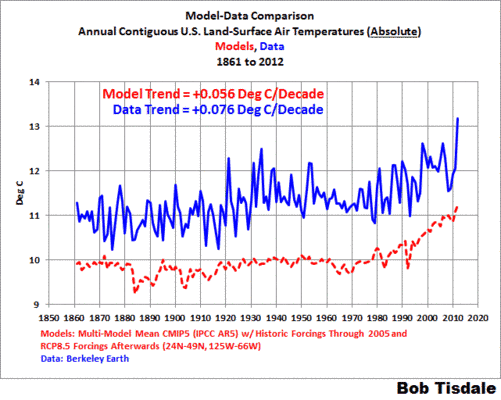

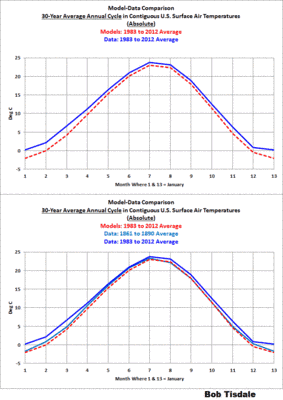

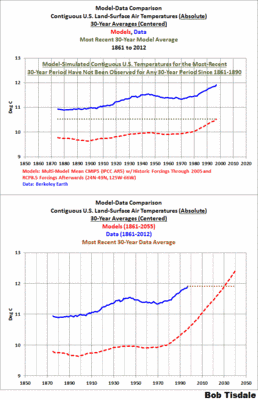

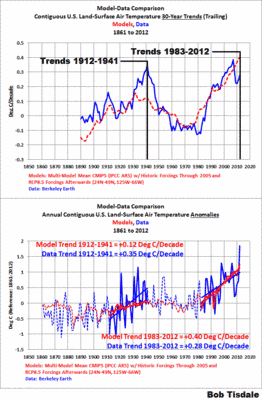

Es ist also keinesfalls von der Hand zu weisen, dass der Klimaeinfluss des Himmels mangels Wissen darüber in den Klimasimulationen sträflich vernachlässigt ist und damit vielleicht eine der Ursachen darstellt, dass diese so konstant versagen:“ Wendepunkt in der Klimadebatte? Klimamodelle nähern sich den Realitäten an“ und „Wissenschaftler geben zu, dass ihr Modell der globalen Erwärmung vollkommen falsch sein könnte“ [6].

Betrachtet man es wissenschaftlich statistisch korrelativ, dann ist diese Aussage ebenfalls nicht zu widerlegen. Seit dem Beginn der Industrialisierung steigen Temperatur und Meeresspiegel. Neben dem steigenden CO2 wurden aber auch die europäischen Frauen immer unzüchtiger in den Kleidervorschriften. Vom früher auch in Europa zwingenden Kopftuch bis zum Bikini und FKK.

Und seit dem Erstarken fundamentalistischer Islamströmungen haben wir den Hiatus (Temperaturstagnation).

Geht man weiter zurück, war zur Römerzeit mit dem bekannt frivolem weiblichem Umgang ebenfalls eine Warmzeit.

Ob die Grünen und als „Obergrünste“ inzwischen unsere Bundeskanzlerin dies intuitiv erkannt haben und auch deshalb die Rettung der Welt über diesen islamischen Weg versuchen?

[9] DIE WELT 05.07.12: Die Grünen wollen den Islam einbürgern

Den Kirchen empfiehlt der Autor, Anträge auf ausreichend hohe Forschungsgelder an das Umweltbundesamt oder direkt an Frau Hendricks zu melden, bestimmt werden diese bereitwilligst genehmigt. Denn unabhängig davon, ob es wirklich nur die vor allem im Westen fehlenden Kopftücher sind welche das Klima aufheizen, besteht eine erkennbare, gewaltige Lücke zwischen den Anschauungen Gottes und denen der Menschen, die eventuell von Theologen geklärt werden kann und muss.

Während Gott in einer weisen Entscheidung nach einer für die Menschen furchtbaren Kälteperiode die Temperaturen wieder ansteigen ließ und damit den Hunger in der Welt reduzierte (siehe EIKE: Ernteerträge und Klimawandel [5])

Bild 1 Erträge in Deutschland von 1800 – 2007

… und dem Globus die wirkliche Gefahr der nächsten Eiszeit droht,

Bild 2 [7] Zyklische Wiederholung von Eiszeiten (gezeigt anhand des Meerespegel-Verlaufs)

… hat sich der säkulare Westen darauf versteift, in der moderaten Erwärmung verbunden mit dem Überangebot an Nahrung unbedingt etwas Negatives sehen zu müssen was bekämpft werden muss. Zu welchen Auswüchsen dies an medialer Interpretation von Klimadaten führt zeigt anbei ein aktuelles Beispiel:

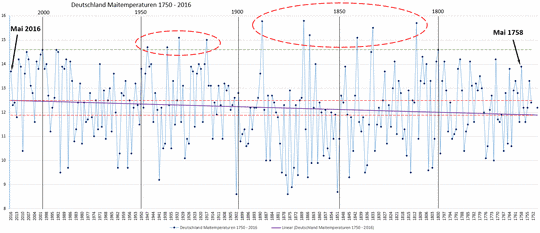

Obwohl der Mai nach der linearen Regression seit über 150 Jahren kaum messbar wärmer wird (um 0,7 °C seit 1750) und die weit höchsten Werte vor 1900 und die danach vor 1950 lagen, gelingt es Medien, daraus eine alarmistische Erwärmung zu dichten:

Die Durchschnittstemperatur im Mai 2016 lag mit 13,6 Grad in etwa um +1,5 Grad über dem langjährigen Mittelwert von 1961-1990 und gegenüber der Referenzperiode von 1981-2010 betrug die Abweichung noch +0,6 Grad. Anders formuliert ist der Mai 2016 zu warm ausgefallen.

Bild 3 Die Mai-Monate in Deutschland von 1750 bis 2016. Quelle WIKIPEDIA (Tabellenwerte vom Autor grafisch umgesetzt)

Man darf sich einfach nicht freuen, dass die früher extremeren Temperatur-Schwankungen und die Kälte geringer geworden sind.

Es wäre nicht verwunderlich, wenn Gott eine solche Ignoranz gegenüber seiner Weitsicht missfällt und er es deshalb ab und zu etwas „wetterwackeln“ ließe um auf den Unsinn der Klima-Simulationen und Klimahysterie hinzuweisen.

Die Klimaforschung ist längst nicht beendet, sondern fängt vielleicht erst richtig an

könnte darauf hin eine Schlagzeile lauten.

Und wie gesagt, die zur Lösung solcher Probleme bei uns über einen Staatsvertrag wie Beamte finanzierten Kleriker versagen bei der Klärung bisher völlig, schlimmer noch, sie sehen gar keinen Grund dafür [2][8]. Wer satt und mit Pension versorgt ist, geht eben ungern nur zur Inspiration 40 Tage in härenem Gewand in die Wüste, außer dort (be-)findet sich ein auf Spesen bezahltes Luxuscamp mit medial ausreichend beachteter Klimadiskussion.

Man sollte diese wichtige Frage aber nicht alleine islamischen Theologen überlassen, sonst sind die christlichen wirklich so überflüssig, wie es aus dem Koran gelesen wird (Kommentar: die folgende Argumentation ist messerscharf und sorgfältig aus der Geschichte des Neuen Testaments abgeleitet):

Ahmadiyya Muslim Jamaat Deutschland: [10] Wie ist das Verhältnis des Islam zum Christentum?

Im Christentum haben wir es heute eher mit der Lehre von Paulus zu tun, als mit dem, was Jesusas lehrte und praktizierte. All die herausstechenden Merkmale des Christentums von heute, wie etwa der Glaube an die Göttlichkeit von Jesusas, somit der Glaube an die Trinität, der Glaube an die Erbsünde und die Erlösung von Sünde durch den angeblichen Opfertod von Jesusas am Kreuz, haben nach unserer Meinung ihren Ursprung nicht in der Lehre Jesuas, sondern in dem, was Paulus daraus machte.

Vollendung der Religionen: Der Islam erhebt den Anspruch, die Vollendung unter den Religionen gebracht zu haben (5:4). Diese Vollendung bezieht sich sowohl auf die Verifizierung einzelner, bereits vorhandener Lehren, als auch auf die Einführung neuer Lehren

Der Autor hat nie ein Hehl daraus gemacht, welche Meinung er zur CO2-Klimahysterie und welch kritische er zu den Religionen hat. Dass ihn zur Kritik an Ursachen zum Klimawandel aber sogar die sich als einzig wahre Religionsausrichtung bezeichnende unterstützt, hätte er sich nie träumen lassen.

„kaltesonne“ dankt er für den Hinweis auf die Predigt des iranischen Geistlichen.

In vielen Foren gilt es als schick, auch zur banalsten Antwort einen neunmalklugen Satz irgend eines der unendlich vielen im WEB unvergesslich hinterlegten Zitate von Personen der Weltgeschichte zu zitieren.

Anbei der Versuch ein solches neu in die Welt zu setzen:

Wenn die säkulare Wissenschaft versagt, beginnt die theologische zu leben. Versagt auch die, fragt man die Esoterie. Diesen Weg kann man sich sparen, lässt man gleich Computer simulieren die Gefahren.

Reimt sich nicht so toll, aber es kommt ja auf den Inhalt an.

Quellen

[1] mrc TV June 13, 2016: Muslim Cleric: Immodest Women are Causing Climate Change

[2] Ökumenischer Rat der Kirchen, 22. Dezember 2009: Was Theologie zur Rettung der Welt vor dem Klimawandel beitragen kann

[3] EIKE 11.06.2015: Mit CO2-Reduzierung retten wir die Welt – Einige Rechenspiele (nicht nur) für regnerische Nachmittage

http://www.eike-klima-energie.eu/klima-anzeige/mit-co2-reduzierung-retten-wir-die-welt-einige-rechenspiele-nicht-nur-fuer-regnerische-nachmittage/

[4] Opposition 24: Die Grüne Kirchen Connection

http://opposition24.com/die-gruene-kirchen-connection/85535

[5] EIKE 30.06.2015: Ernteerträge und Klimawandel

http://www.eike-klima-energie.eu/klima-anzeige/ernteertraege-und-klimawandel/

[6] EIKE 19.05.2016: Wissenschaftler geben zu, dass ihr Modell der globalen Erwärmung vollkommen falsch sein könnte

http://www.eike-klima-energie.eu/news-cache/wissenschaftler-geben-zu-dass-ihr-modell-der-globalen-erwaermung-vollkommen-falsch-sein-koennte/

[7] EIKE 07.04.2016: Der Verlauf des Meeresspiegels im Holozän und seit 2.000 Jahren

http://www.eike-klima-energie.eu/news-cache/der-verlauf-des-meeresspiegels-im-holozaen-und-seit-2000-jahren/

[8] EIKE 18.04.2016: Kirche und Klimawandel Viel „Mensch“, viele Bibelsprüche, die Orientierung vom PIK, von kritischer Reflexion keine Spur

http://www.eike-klima-energie.eu/news-cache/kirche-und-klimawandel/

[9] DIE WELT 05.07.12: Die Grünen wollen den Islam einbürgern. Die Grünen streben eine rechtliche Gleichstellung des Islam mit Christentum und Judentum an. Muslime hätten damit wie die Kirchen Privilegien beim Bau von Moscheen und könnten Steuern erheben.

[10] Ahmadiyya Muslim Jamaat Deutschland: Wie ist das Verhältnis des Islam zum Christentum?

http://www.ahmadiyya.de/islam/haeufige-fragen-zum-islam-faq/islam-und-christentum/