Klimamodelle simulieren NICHT das Klima der Erde

Einführung

Die vom IPCC verwendeten Klimamodelle simulieren das Klima nicht so, wie es auf der Erde besteht. Diese Realität der Klimamodelle wird wahrscheinlich für viele Laien in punkto Klima überraschend sein.

Im ersten Teil dieser Reihe zeigten wir, wie die räumliche Verteilung der modellierten Erwärmungsraten der Oberflächen der globalen Ozeane von 1982 bis 2015 (also der Ära mit satellitengestützten Temperaturmessungen) keine Ähnlichkeiten aufweist mit der räumlichen Verteilung der gemessenen, auf Daten basierenden Erwärmung und Abkühlung. Und wir haben besprochen, warum es wichtig ist, dass die vom IPCC verwendeten Modelle in der Lage sind zu simulieren, wann und wo und warum die Temperaturen der Ozeanoberflächen variieren. Das ist relativ leicht zu verstehen. Wo und wann sich die Oberflächen der Ozeane erwärmen, nicht erwärmen oder sich gar aus natürlichen abkühlen und um welchen Betrag – zusammen mit anderen natürlich auftretenden Faktoren – diktiert, wo und wann Landtemperaturen steigen und fallen und wo der Niederschlag zunimmt oder abnimmt – auf jährlicher dekadischer oder multidekadischer Grundlage.

In diesem Teil zeigen wir die Vergleiche zwischen Modellen und Daten in Gestalt von Zeitreihen-Graphiken global und für eine Anzahl von Regionen. Wie schon erwähnt handelt es sich dabei um Darstellungen in absoluter Form anstatt von Anomalien. Damit sollen Additionsprobleme der Modelle illustriert werden.

Warum absolute Temperaturen?

Die tatsächlichen Temperaturen der Ozeanoberfläche bestimmen zusammen mit zahlreichen anderen Faktoren, wie viel Feuchtigkeit aus den Ozeanen verdunstet und daraus folgend, wie viel Feuchtigkeit sich in der Atmosphäre befindet … was die Feuchtevariable (1) für Niederschlag, (2) für den auf Wasserdampf bezogenen Treibhauseffekt und (3) für die negativen Rückkopplungen durch die Wolkenbedeckung diktiert. Mit anderen Worten, die Meeresoberflächen-Temperaturen nicht angemessen zu simulieren bedeutet, dass auch die atmosphärischen Komponenten der gekoppelten Ozean-Atmosphäre-Modelle nicht stimmen können.

Einleitende Information

Der in diesem Beitrag verwendete Datensatz der Ozean-Oberflächentemperatur [sea surface temperature] ist die wöchentliche und monatliche Version von NOAA’s Optimum Interpolation (OI) Sea Surface Temperature (SST) v2 (a.k.a. Reynolds OI.v2). Wir verwenden ihn, weil (1) es der längste verfügbare Datensatz mit satellitengestützten Wasseroberflächen-Temperaturen ist, (2) weil dessen Satellitendaten bias-adjustiert sind auf der Grundlage von Temperaturmessungen von in Schiffe einströmendem Kühlwasser und von Bojen (sowohl treibend als auch fest) und (3) – und das ist am wichtigsten – weil die NOAA-Reynolds OI.v2-Daten „eine gute Schätzung der Wahrheit“ genannt worden sind. Siehe hier. Die Autoren stellten hinsichtlich der Reynolds OI.v2-Daten fest (Hervorhebung von mir):

Obwohl die NOAA OI-Analyse einiges Rauschen enthält infolge deren Verwendung unterschiedlicher Datentypen und Bias-Korrekturen für Satellitendaten, wird sie von den Satellitendaten dominiert und zeigt eine gute Schätzung der Wahrheit.

Dies ist nicht die (übermäßig aufgeblähte und eine extrem hohe Erwärmungsrate zeigende) hoch aufgelöste tägliche Version der NOAA’s Reynolds OI.v2-Daten, welche wir illustriert und diskutiert haben in dem Beitrag mit dem Titel [übersetzt] „Über die monumentalen Differenzen zwischen den Datensätzen der globalen Meeresoberflächentemperatur während der von der NOAA herausgepickten Stillstandsperiode der globalen Erwärmung von 2000 bis 2014“ (hier). Auf der Grundlage jenes Beitrags verwenden wir auch nicht die den „Stillstand zerschlagenden“ [pause buster] Daten von NOAA ERSST.v4, aus welchen der Ozean-Anteil der von NOAA und GISS kombinierten Temperaturprodukte von Land + Wasser besteht. Die NOAA hat die zahlreichen Parameter in ihrem ERSST.v4-Modell adjustiert, so dass die Erwärmungsraten für die von der NOAA gewählten Zeiträume von 1951 bis 2012 und 2000 bis 2014 am extremen oberen Rand der Unsicherheits-Bandbreite für jene Perioden liegen. Und wie wir in jenem Beitrag gezeigt und illustriert haben, weist die originale Version (wöchentlich, monatlich, auf 1°C aufgelöst) der Reynolds OI.v2-Daten, die wir hier zeigen, im Wesentlichen die gleiche Erwärmungsrate auf wie die UKMO HADSST3-Daten der von der NOAA gewählten Stillstandsperiode von 2000 bis 2014.

Die in diesem Beitrag präsentierten Klimamodelle sind diejenigen, die im CMIP5-Archiv gespeichert sind, welcher vom IPCC für dessen 5.Zustandsbericht verwendet worden ist. Die CMIP5-Klimamodell-Ergebnisse der Wasseroberflächentemperatur sind verfügbar über den KNMI Climate Explorer, spezifiziert auf dieser Website unter der Überschrift Ocean, ice and upper air variables. Die Wasseroberflächentemperatur wird als TOS bezeichnet. Um mit vorherigen Beiträgen konsistent zu sein werden das „CMIP5-Mittel“ und das Historic/RCP6.0-Szenario verwendet. Das RCP6.0-Szenario liegt A1B am nächsten, welches in den CMIP3-Modellen verwendet wurde (also für den 4. IPCC-Zustandsbericht). Und wieder benutzen wir das Modellmittel, weil es die erzwungene Komponente der Klimamodelle repräsentiert. Im Wesentlichen repräsentiert das Modellmittel den Konsens der das Klima modellierenden Gruppen darüber, wie sich die Oberflächen der Ozeane erwärmen sollten, falls sie durch anthropogene Treibhausgase und die anderen in den Modellen verwendeten Treiberfaktoren in den Modellen getrieben werden würden. Für weitere Diskussionen siehe hier.

Weil die Vergleiche zwischen Modell und Daten absolut vorgenommen werden, werden jährliche Daten gezeigt. Die Reynolds OI.v2-Daten beginnen im November 1981, so dass sich die Vergleiche über 34 Jahre erstrecken, von 1982 bis 2015.

Die in die Graphiken eingezeichneten linearen Trends wurden mittels EXCEL berechnet (hier).

Globale Zeitreihen

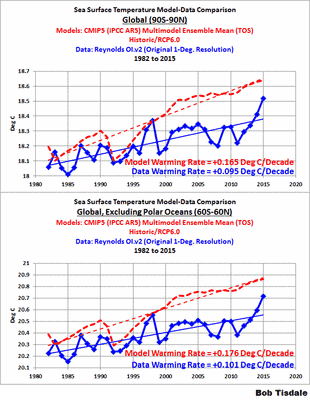

Abbildung 1 zeigt zwei Modelle-Daten-Vergleiche der Oberflächentemperaturen während der Satellitenära, keine Anomalien. Die obere Graphik für die Breiten zwischen 90N und 90S umfasst auch die polaren Ozeane. Die untere Graphik zeigt den Bereich zwischen 60N und 60S, also ohne die polaren Ozeane. Es macht kaum einen Unterschied, ob wir die polaren Ozeane in diesen Modelle-Daten-Vergleich einbeziehen oder nicht. Die Disparität zwischen den Modellen und den Daten ist ohne die polaren Ozeane etwas größer, aber unter dem Strich zeigen die Modelle zu viel Erwärmung.

Abbildung 1

Die Differenzen zwischen Modellen und Daten auf globaler Basis beleuchten ein sehr grundlegendes Problem mit den Modellen. Die Modellierer müssen sich allein auf anthropogene Treibhausgase und andere anthropogene Faktoren konzentrieren, um die Klimamodelle zu treiben, weil die Klimamodelle Timing, Größenordnung und Dauer natürlich auftretender Prozesse nicht angemessen simulieren, die zur Erwärmung der Ozeanoberfläche führen können. Auf der Grundlage jener Modelle (die keinerlei Bezug zur realen Welt haben), wurde erwartet, dass sich die Oberflächen der Ozeane grob mit einer Raten von 0,17°C pro Dekade während der letzten 34 Jahre erwärmt haben müssten. Aber in der realen Welt zeigten sich beobachtete Erwärmungsraten infolge der Kombination der natürlichen Variabilität und Treibhausgasen von lediglich 0,10°C pro Dekade. Das ist eine monumentale Differenz zwischen Hypothese und Realität.

Ein weiteres Faktum muss berücksichtigt werden: Die Daten existierten, während die Modellierer ihre Klimamodelle für das CMIP5-Archiv vorbereitet haben. Mit anderen Worten, die Modellierer kannten ihre Ziele. Und das beste, was die Modellierer tun konnten war, die Erwärmungsrate der Oberfläche der globalen Ozeane fast zu verdoppeln. Das ist eine grauenhafte Modellierungsmaßnahme … selbst mit der jüngsten leichten Erwärmung primär durch The Blob und durch den El Nino 2015/2016.

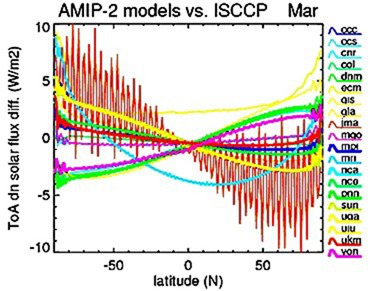

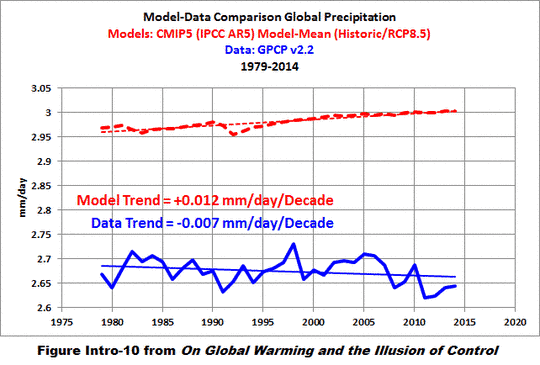

Man beachte auch, dass von Klimamodellen simulierten Ozeanoberflächen etwas wärmer sind als beobachtet. Für den Bereich zwischen 60N und 60S liegen die mittleren simulierten Temperaturen der Ozeanoberfläche im Zeitraum 1982 bis 2015 um etwa 0,2°C höher als beobachtet. Vielleicht ist das der Grund, warum die Modelle global zu viel Niederschlag simulieren. Siehe Abbildung 2, was in meinem E-Buch On Global Warming and the Illusion of Control die Abbildung Intro-10 ist.

Abbildung 2

Tropische Wasseroberflächen-Temperaturen

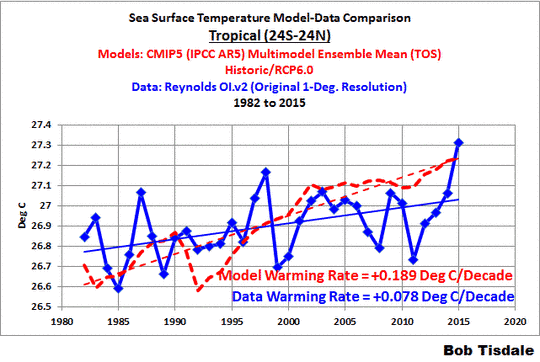

Die Modelle überschätzten die Erwärmung der Wasseroberflächen-Temperaturen der tropischen Ozeane (24N bis 24S) während der letzten 34 Jahre … keine Überraschung. Überraschend ist, wie ähnlich die modellierten und die beobachteten Wasseroberflächen-Temperaturen in den Tropen sind. Siehe Abbildung 3. In den tropischen Ozeanen liegt die mittlere simulierte Wasseroberflächentemperatur im Zeitraum 1982 bis 2015 um lediglich etwa 0,02°C über den beobachteten Werten.

Abbildung 3

Während die absoluten Temperaturen sich ziemlich ähnlich sind, haben die Modelle die Erwärmung drastisch überschätzt. Den Daten zufolge hat sich die Oberfläche der tropischen Ozeane mit einer nicht gerade alarmierenden Rate von +0,08°C erwärmt. Die Modelle hingegen zeigen, dass sie sich im Falle der Erwärmung durch anthropogene Treibhausgase um etwa +0,19°C erwärmt haben müssten. Jetzt berücksichtige man, dass die tropischen Ozeane (24N bis 24S) 76% der Tropen und 46% der globalen Ozeane ausmachen.

Diese Disparität zwischen Modellen und Daten stützt die Vergleiche zwischen Modellen und Daten bzgl. der tropischen mittleren Troposphäre von John Christy im Juni 2013. Siehe die Beiträge von Roy Spencer dazu hier und hier. Die Modelle haben die Erwärmungsraten der mittleren Troposphäre über den Tropen gewaltig übertrieben.

Kommen wir zu den tropischen Ozeanen. Wie Abbildung 4 zeigt, beträgt die Differenz zwischen den simulierten und den beobachteten Erwärmungsraten für die tropischen Seegebiete des Atlantischen und des Indischen Ozeans (24S bis 24N; 80W bis 120E) etwa 0,08°C pro Dekade, wobei natürlich die Modelle zu viel Erwärmung zeigen.

Abbildung 4

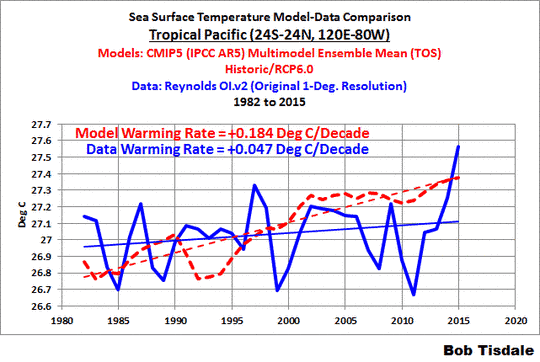

Im tropischen Pazifik (24S bis 24N; 120E bis 80W) zeigen die Modelle sogar eine Erwärmung mit einer Rate, die fast 0,14°C über der beobachteten Rate liegt (siehe Abbildung 5).

Abbildung 5

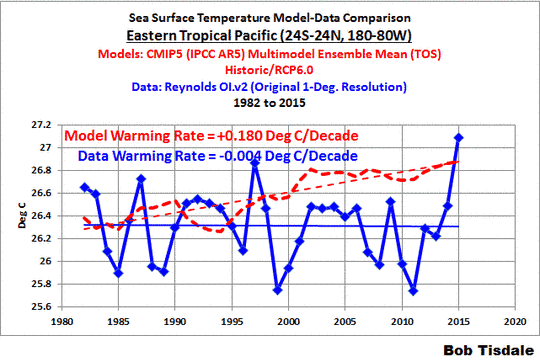

El Nino- und La Nina-Ereignisse wirken sich im östlichen tropischen Pazifik am stärksten aus. Während eines El Nino fließt warmes Oberflächen- und oberflächennahes Wasser entlang des Äquators in den tropischen Ostpazifik, wobei das oberflächennahe Wasser, wärmer als normal, an die Oberfläche aufquillt. Während einer neutralen ENSO-Phase (weder El Nino noch La Nina) und während La Nina-Ereignissen quillt kühles Wasser unter der Oberfläche nach oben. Offensichtlich haben die Klimamodellierer nicht einmal ansatzweise Aspekte des tropischen Pazifiks erfasst. Während es den Daten zufolge im östlichen tropischen Pazifik (24N bis 24S; 180W bis 80W) während der letzten Jahre keine Erwärmung der Oberfläche gegeben hat, zeigt der Konsens der Modelle, dass die Oberfläche sich mit einer Rate von 0,18°C erwärmt haben sollte. Siehe Abbildung 6.

Abbildung 6

Außertropische Wasseroberflächen-Temperaturen

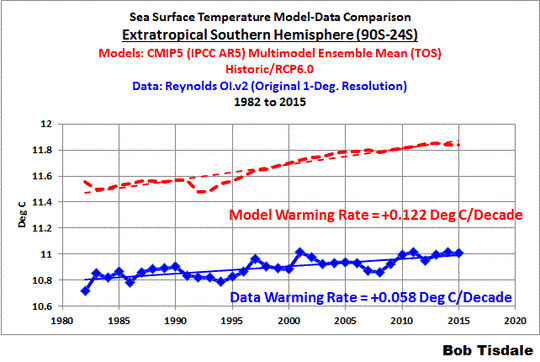

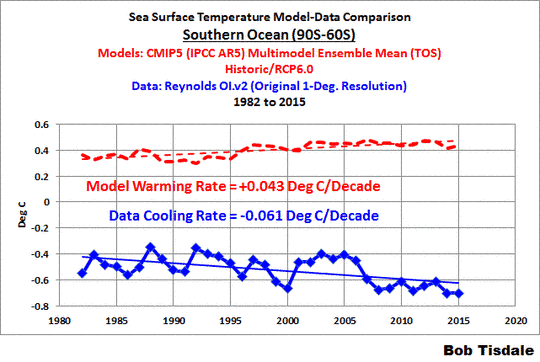

Für die außertropischen Ozeane der Südhemisphäre (90S bis 24S), Abbildung 7, ist die beobachtete Erwärmungsrate ebenfalls mit etwa 0,06°C pro Dekade extrem niedrig. Andererseits zeigen die Klimamodelle, dass sich die Ozeane mit einer fast doppelt so hohen Rate, nämlich 0,12°C pro Dekade erwärmt haben müssten, falls anthropogene Treibhausgase für die Erwärmung in dieser Region verantwortlich wären. Jetzt führe man sich vor Augen, dass die außertropischen Ozeane der Südhemisphäre etwa 33% der globalen Ozeane ausmachen (etwa 23% der gesamten Planetenoberfläche).

Abbildung 7

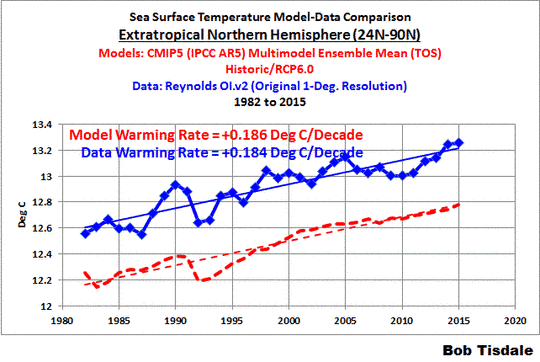

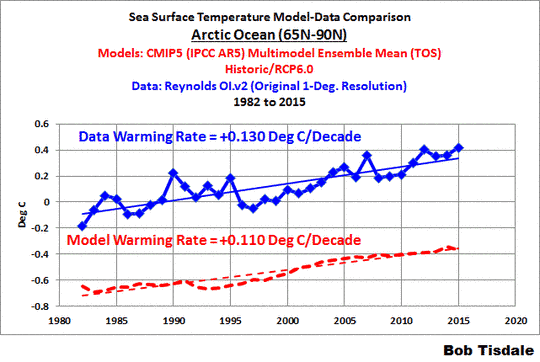

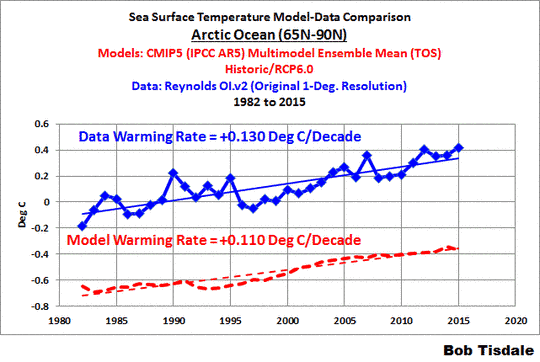

Andererseits scheinen die Klimamodelle die Erwärmungsrate der Wasseroberflächen ziemlich richtig gezeigt haben im kleinsten Teil der globalen Ozeane, nämlich in den außertropischen Ozeanen der Nordhemisphäre (24N bis 90N). Siehe Abbildung 8. Die außertropischen Ozeane der Nordhemisphäre machen lediglich 21% der globalen Ozeanoberfläche aus (etwa 15% der gesamten Planetenoberfläche).

Abbildung 8

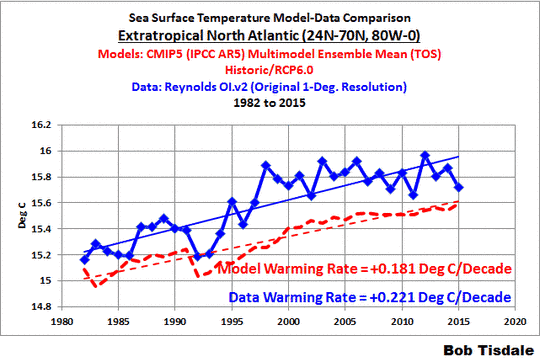

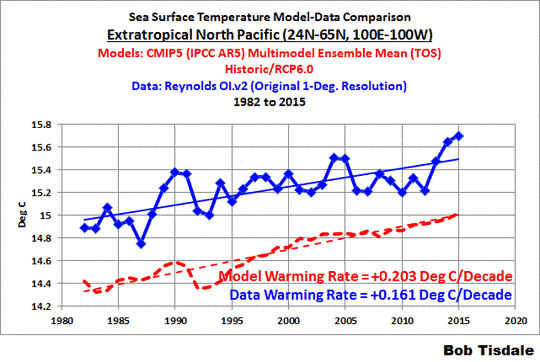

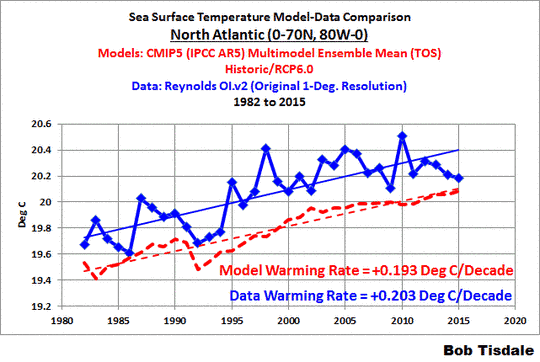

Unglücklicherweise für die Modellierer haben die Modelle die Erwärmung der Oberfläche des außertropischen Nordatlantik (Abbildung 9) unter- und die Erwärmung im außertropischen Nordpazifik überschätzt (Abbildung 10), so dass sie die Erwärmung insgesamt der außertropischen Nordhemisphäre unrichtig dargestellt haben. Keine Überraschung.

Abbildung 9

———————————————-

Abbildung 10

Jetzt beachte man die Ähnlichkeiten zwischen den modellierten und den beobachteten Oberflächentemperaturen (nicht Trends) der tropischen Ozeane (Abbildung 9). Die mittlere beobachtete tropische Wasseroberflächentemperatur für den Zeitraum 1982 bis 2015 liegt nur um 0,02°C unter den Modellwerten. Dann ist da noch die Differenz zwischen den Modellen und den Beobachtungen in den außertropischen Regionen der Südhemisphäre (Abbildung 7) und der Nordhemisphäre (Abbildung 8). Für den Zeitraum 1982 bis 2015 liegen die modellierten Wasseroberflächentemperaturen der Südhemisphäre um etwa 0,8°C über den beobachteten Werten. Auf der Nordhemisphäre beträgt dieser Unterschied +0,4°C. All dies sind weitere Hinweise darauf, dass die ozeanischen Zirkulationen in den Klimamodellen falsch abgebildet sind.

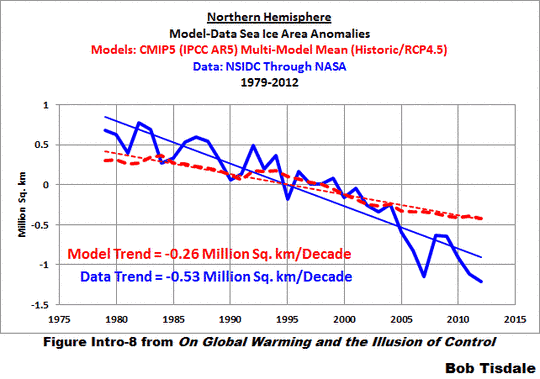

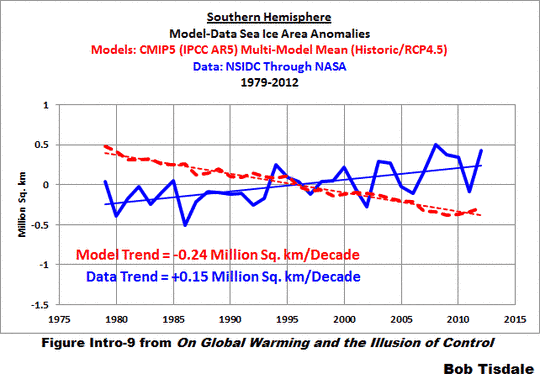

Diese Disparitäten in absoluten Temperaturwerten können helfen zu erklären, warum die Klimamodellierer nicht den Meereisverlust der Nordhemisphäre und den Meereiszuwachs der Südhemisphäre erklären können. Siehe die Abbildungen 11 und 12, in welchen das modellierte und das beobachtete Gebiet mit Meereis in der Nord- und Südhemisphäre verglichen wird. Hierbei handelt es sich um die Abbildungen Intro-8 und Intro-9 in einem E-Book On Global Warming and the Illusion of Control.

———————————————-

Abbildung 12

Individuelle Ozeanbecken

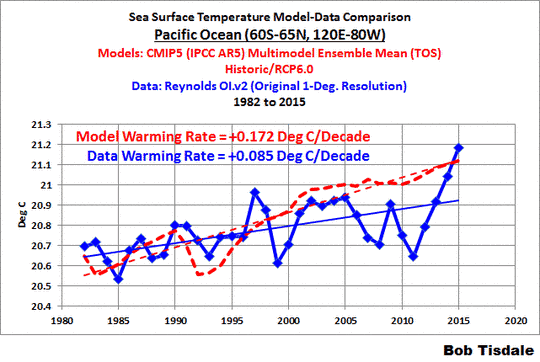

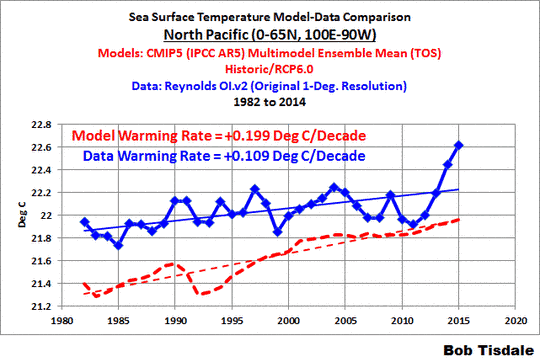

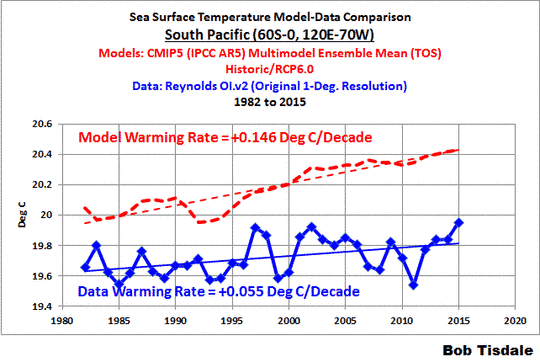

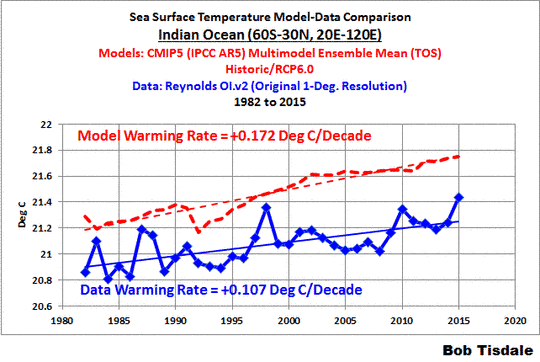

Jetzt folgen vergleiche Modelle vs. Daten für die individuellen Ozeanbecken … ohne Kommentar:

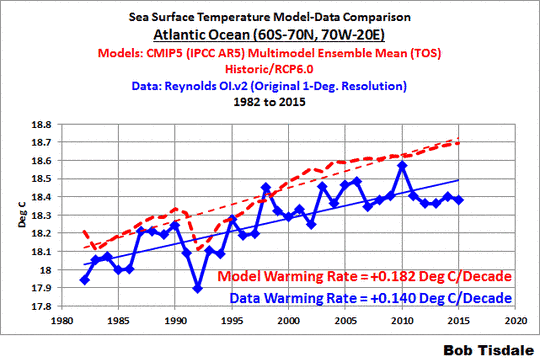

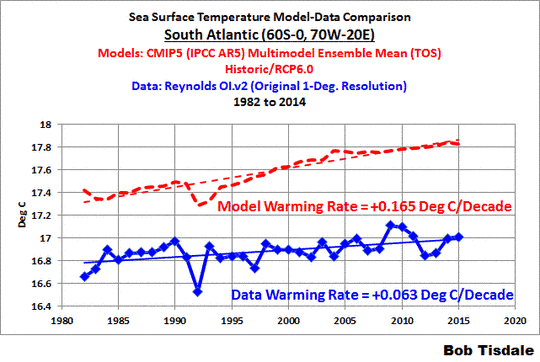

Abbildung 13

———————————————-

Abbildung 14

———————————————-

Abbildung 15

———————————————-

Abbildung 16

———————————————-

Abbildung 17

———————————————-

Abbildung 18

———————————————-

Abbildung 19

———————————————-

Abbildung 20

———————————————-

Abbildung 21

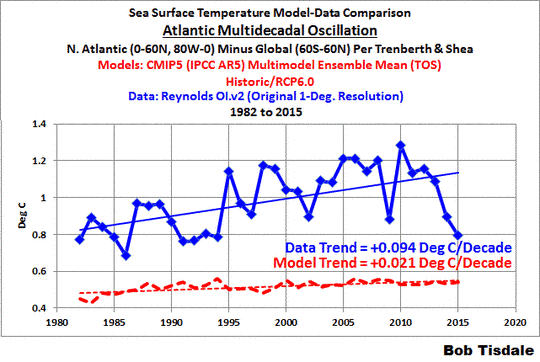

Atlantische multidekadische Oszillation

Die Atlantische Multidekadische Oszillation wird oft beschrieben als die Variationen der Oberflächentemperaturen im Nordatlantik, die mit einer Periode von 50 bis 80 Jahren schwingen. In dieser Hinsicht wird diese AMO typischerweise mittels Trendbereinigung der langzeitlichen Wasseroberflächen-Temperaturanomalien des Nordatlantiks dargestellt. Das Argument gegen die Trendbereinigung lautet, dass sie nicht die „globale Erwärmung“ berücksichtigt.

Falls jemand mit der AMO nicht vertraut ist, siehe man bei der NOAA hier sowie die folgenden beiden Beiträge:

An Introduction To ENSO, AMO, and PDO — Part 2

Multidecadal Variations and Sea Surface Temperature Reconstructions

Über einige multidekadische Zeiträume erwärmt sich die Wasseroberfläche des Nordatlantiks schneller als die übrigen globalen Ozeane, und während anderer multidekadischer Perioden erwärmt sich die Wasseroberfläche langsamer als die übrigen globalen Ozeane und kann sich auch dramatisch abkühlen. Im längsten Teil des Zeitraumes von November 1981 bis Dezember 2014 befanden sich die Wasseroberflächentemperaturen des Nordatlantiks in einer ihrer natürlichen Erwärmungsphasen.

Wie früher schon erwähnt zählen die Daten aus dem Nordatlantik nicht für die Erwärmung der globalen Ozeane. Daher sind die zusätzlichen langzeitlichen Variationen der Wasseroberflächentemperaturen des Nordatlantiks eine bessere Darstellung der AMO, über jene der globalen Ozeane hinaus. Um das zu bewerkstelligen, haben Trenberth and Shea (2006) die globalen Wasseroberflächen-Temperaturanomalien (60S bis 60N) von den Wasseroberflächen-Temperaturanomalien des Nordatlantiks (0 bis 60N; 80W bis 0) subtrahiert. Dieses Verfahren trägt der zusätzlichen Variabilität der Daten aus dem Nordatlantik über die Variationen der globalen Daten hinaus Rechnung. Aber für diesen Beitrag fügen wir diesem Verfahren eine kleine Änderung zu. Wir präsentieren die Differenz zwischen den globalen Daten und denen aus dem Nordatlantik in absoluten Zahlen, nicht als Anomalien.

Trenberth und Shea (2006) arbeiteten mit HadISST-Daten. Darum verwendete ich jenen Datensatz für diese Diskussion in vorherigen Aktualisierungen. Siehe Abbildung 22. Sie ist Abbildung 25 aus diesem Beitrag. Sie zeigt die modellierten und beobachteten Differenzen zwischen den globalen Wasseroberflächentemperaturen und denen des Nordatlantiks, und zwar für den Zeitraum 1870 bis 2014, d. h. das Porträt der AMO nach Trenberth and Shea (2006).

Abbildung 22

Offensichtlich zeigen die Daten, dass es keine merklichen multidekadischen Variationen der Wasseroberflächentemperaturen des Nordatlantiks gibt, die über jene in den globalen Daten hinausgehen. Dies zeigt natürlich, dass die natürlichen Variationen der Oberflächentemperaturen des Nordatlantiks eine globale Erwärmung verstärken oder unterdrücken können. Oder wie es die NOAA am Ende ihrer Website zur AMO schreibt:

Im 20. Jahrhundert haben die Klimaschwingungen der AMO alternierend die globale Erwärmung kompensiert oder übertrieben, was die Gründe für globale Erwärmung schwieriger zu finden macht.

Unglücklicherweise zeigt das Modellmittel der Klimamodelle nicht jene zusätzliche Variabilität in den Wasseroberflächentemperaturen des Nordatlantiks. Dies zeigt, dass die AMO durch die Faktoren getrieben wird (primär anthropogene Treibhausgase), die die globale Erwärmung in den Klimamodellen erzeugen.

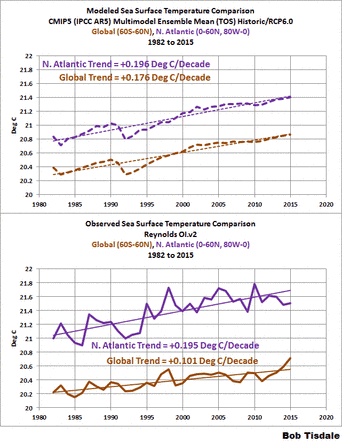

Wollen wir also jene Graphik mit Hilfe der Reynolds OI.v2-daten aktualisieren, was unsere Sichtweite auf die letzten 34 Jahre limitiert. Zunächst die Komponenten:

Abbildung 23

Die obere Graphik in Abbildung 23 zeigt die modellierten Wasseroberflächentemperaturen der globalen Ozeane (60S bis 60N) und des Nordatlantiks (0 bis 60N; 80W bis 0) für den Zeitraum 1982 bis 2015. Der modellierte Trend des Nordatlantiks ist der Erwärmungsrate der globalen Ozeane sehr ähnlich, beträgt doch die Differenz lediglich 0,02°C pro Dekade. Die untere Graphik zeigt die gemessenen Wasseroberflächentemperaturen des Nordatlantiks und global. Die Daten zeigen, dass die Erwärmungsrate des Nordatlantiks fast 0,1°C pro Dekade höher ist als der der globalen Ozeane.

Abbildung 24 enthält den Modell-Daten-Vergleich der AMO während der Satellitenära mittels des Verfahrens von Trenberth und Shea (2006), außer dass wir wieder mit absoluten Temperaturwerten arbeiten. Dem Modellmittel zufolge sollte sich die Wasseroberfläche des Nordatlantiks lediglich mit einer Rate erwärmt haben, die etwas höher liegt als die der globalen Ozeane. Aber die Daten zeigen, dass die Oberfläche des Nordatlantiks in der Lage ist, sich mit einer Rate zu erwärmen, die um fast 0,1°C höher ist als die der globalen Ozeane, ohne von den Faktoren getrieben zu werden, die die Modelle treiben (primär Treibhausgase).

Abbildung 24

Abbildung 24 zeigt noch ein anderes Problem: Die Differenz zwischen der Oberflächentemperatur des Nordatlantiks und der globalen Ozeane ist zu klein … was erneut darauf hinweist, dass die Ozean-Zirkulationen in den Modellen falsch dargestellt sind.

Schlussbemerkungen

Wir leben auf einem mit Ozeanen bedeckten Planeten. Man könnte denken, dass es eine der obersten Prioritäten der Klimamodellierer ist, die Prozesse zu simulieren, die dazu führen, dass die Wasseroberflächentemperaturen jährlich, dekadisch und multidekadisch variieren. Traurigerweise haben die Modellierer einen anderen Weg gewählt … sie haben sich entschlossen, Modelle eines Planeten zu erzeugen, der keinerlei Beziehung aufweist zu dem, auf dem wir leben.

Klimamodell-Simulationen der Wasseroberflächentemperaturen liegen weit von jeder Realität entfernt. Das heißt, sie modellieren einen virtuellen Planeten – einen Science-Fiction-Planeten – der keinerlei Ähnlichkeit mit der Erde aufweist. Spezifischer: die vom IPCC herangezogenen Klimamodelle simulieren nicht (1) die tatsächlichen Erwärmungs- und Abkühlungsraten der Ozeanoberfläche, (2) die räumliche Verteilung dieser Trends und (3) die absoluten Temperaturen. Es wäre nett, wenn die Klimamodellierungs-Agenturen versuchen würden, die Oberflächentemperaturen dieses Planeten zu simulieren, und nicht diejenigen irgendeines Phantasie-Planeten. Dann könnten ihre Modelle einen gewissen Wert haben. Derzeit jedenfalls dienen sie keinem Zweck … außer zu demonstrieren, wie schlecht sie das Klima der Erde simulieren.

Link: http://wattsupwiththat.com/2016/02/12/climate-models-are-not-simulating-earths-climate-part-2/

Übersetzt von Chris Frey EIKE