Glaubt man den „offiziellen“ Informationen, so ist das Klima der Vergangenheit genau bekannt. Schaut man sich jedoch die zugrunde liegenden Daten an, kann man feststellen, dass diese ganz andere Bilder zeigen. Konkret: Sie sind so ungenau, dass man darauf basierend praktisch beliebige Klimaverläufe rekonstruieren kann!

Proxidaten und statistische Methoden

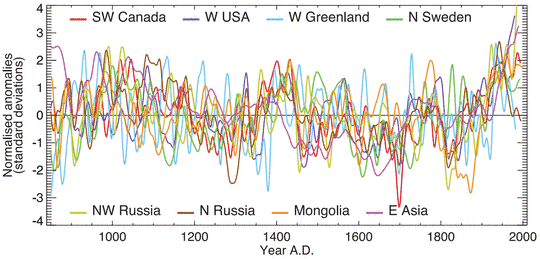

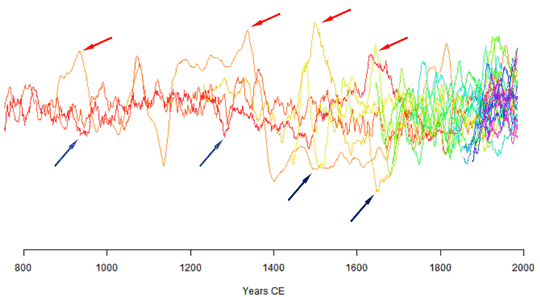

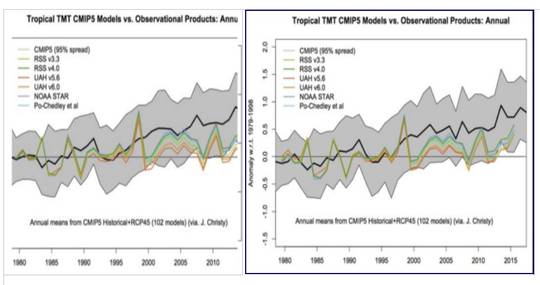

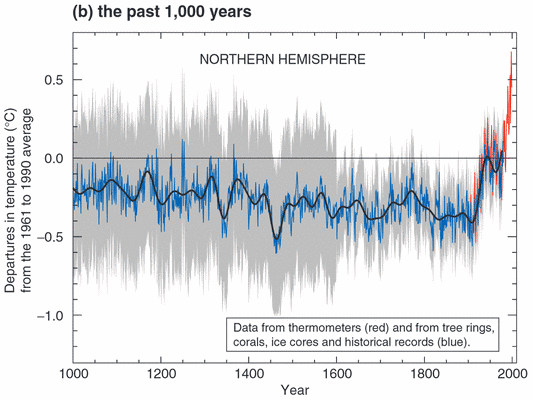

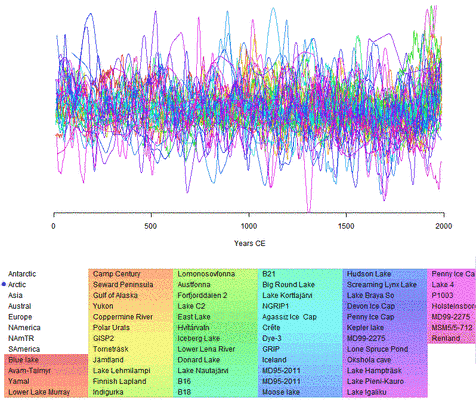

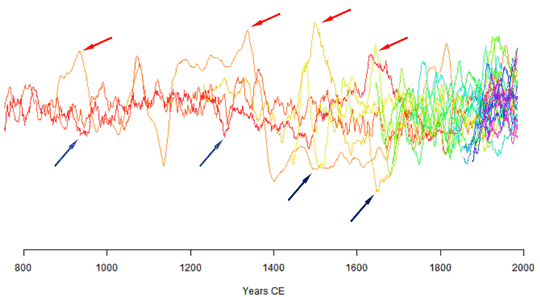

Im EIKE Beitrag „Rekontruierte Temperaturverläufe der letzten zwei Jahrtausende“ wurde bereits angesprochen wie unterschiedlich viele Proxidaten sind und anhand des folgenden Bildes aus einem IPCC Bericht gezeigt, zu welchen „Spaghettimustern“ dies führt.

Bild 1 Temperaturverläufe verschiedener Rekonstruktionen der Nordhemisphäre. Quelle: IPCC AR4 2007: Figure 1

Diese „Spaghettimuster“ zeigen signifikante Probleme auf:

— Drastische Zeitverschiebungen der Temperaturextreme zwischen Rekonstruktionen der gleichen Gegend

— Teilweise gegensätzliche Max- / Min-Kurvenverläufe

— Wie im Artikel gezeigt wird den Verdacht, dass viele Proxis mehr Rauschen als Daten beinhalten

Es stellt sich die Frage, ob eine statistische Weiterverarbeitung solch chaotischen Datenmaterials überhaupt zulässig ist. Solche Verläufe können nicht wie zwingend erforderlich aus gleichwertigem und vor allem homogenen Datenmaterial stammen und es ist auch zu bezweifeln, ob sie den Verlauf der Temperaturen ausreichend repräsentieren.

Alternativaussage: Oder der Klimaverlauf wäre wirklich so lokal begrenzt wie es verschieden Proxis angeben – womit es dann aber nirgends einen globalen, nicht einmal einen großflächig einheitlichen Klimaverlauf geben würde.

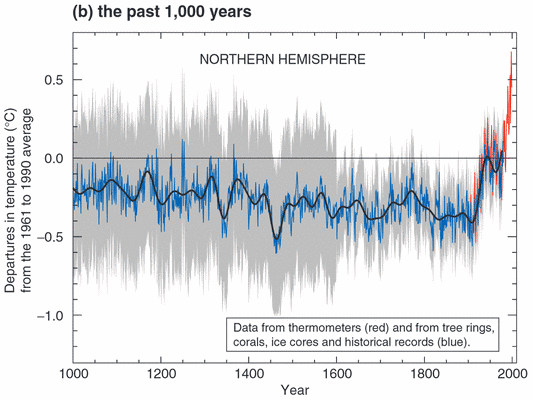

Das Ergebnis wird bei der Hockey Stick Kurve (Bild 2) erkennbar.

Obwohl eine hohe Spannweite (graue Schatten) besteht, ergibt sich eine „ruhige“ Mittelwertkurve mit angeblich geringer Varianz. Diese hat nur einen Mangel: Sie repräsentiert nicht einen wahrscheinlichen Temperaturverlauf, sondern die Fehler des Datenmaterials.

Allerdings wird es anders verkündet:

WIKIPEDIA Hockeyschläger-Diagramm:

Das Hockeyschläger-Diagramm wurde von verschiedenen Seiten mehrfach auf Fehler überprüft. Die Ergebnisse von Mann et al. wurden damit mehrfach bestätigt.

Prof. Rahmstorf PIK:

[9] Von der Wissenschaft glänzend bestätigt, von der “Klimaskeptiker”-Lobby verunglimpft

In der Fachwelt gelten die Arbeiten von Mann et al. als hoch respektierte Pionierleistung (die Forscher erhielten eine Reihe von Preisen, Mann und Bradley z.B. beide die Oeschger-Medaille der European Geosciences Union).

Bild 2 Hockey Stick-Kurve

Quelle: IPCC Report AR2 von 2001, Figure 1: Variations of the Earth’s surface temperature over the last millennium.

Warum der Autor trotz solcher immer wiederholten Darstellungen bekannter und hoch gelobter Wissenschaftler bei seiner gegensätzlichen Ansicht bleibt, versucht er mit diesem Beitrag zu begründen.

Probleme der Proxi-Temperaturrekonstruktionen

Anbei ohne viel Mathematik anschaulich darstellbare Problematiken.

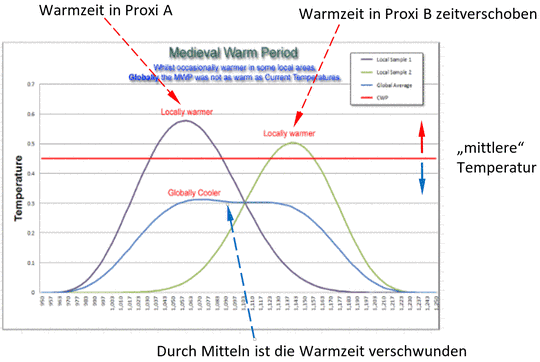

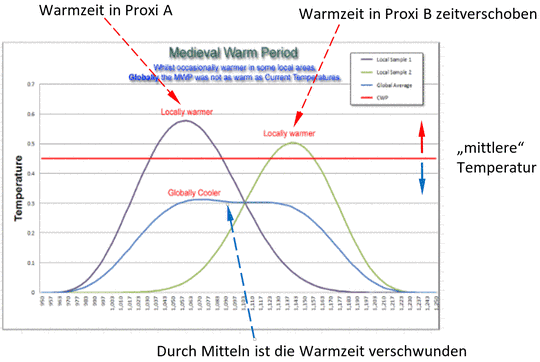

Zeitverschiebungen

Bild 3 zeigt, wie alleine durch Verschiebungen oder Fehler der Zeitdatierung zweier Proxis aus einer Warmzeit durch Mitteln eine Kaltzeit wird. Gleiches passiert, falls Weltgegenden Klimaveränderungen zeitlich verschoben „erleben“, wie es sein könnte falls z.B. die mittelalterliche Warmzeit als eine „Welle“ um die Welt ging und nicht zeitgleich überall auftrat. Dieser mathematische Effekt ist sicher einigen vom Drehstrom bekannt. Obwohl in allen drei Drehstrom-Phasenleitungen Strom fließt, ist der arithmetische Mittelwert des Summenstromes im Mittelpunktsleiter null, da sich die Phasenverschiebungen aufheben. Nach den AGW-Rechenregeln dürfte aus der Drehstromsteckdose somit keine Energie fließen.

Bild 3[4] Darstellung wie durch Zeitversatz zweier Proxis aus einer Warmzeit (Kurven: dunkelblau, grün) durch Mittelung eine Kaltzeit wird (Kurve: Globally Cooler, hellblau)

Wie extrem Zeitverschiebungen in Proxis enthalten sind, ist in Bild 21 gezeigt.

Problem Temperaturrekonstruktion

In der Hockeystick-Kurve ist die Temperatur in 0,1 Grad Schritten aufgeteilt und so dargestellt, als wäre die Mittelwertkurve mit ihrer Verlaufsspanne von ca. +- 0,25 Grad sicher ermittelt.

Jedoch: Eine moderne, sorgfältig geeichte elektronische Temperatur-Messstation misst die Temperatur auf +- 0,2 Grad genau. Diese werden seit ca. 1990 … 2000 verwendet. Vorher las man vom Thermometer ab. Es wird angenommen, dass die absolute Messgenauigkeit vor 1980 ungefähr ±1°C betrug und aktuell auch nicht viel besser als ca. +- 0,6 Grad ist [5]. Und dies gilt nur für den gleichen Mess-Standort – nicht für Flächenbetrachtungen.

Proxis müssen immer kalibriert werden. Schon dadurch kann das Ergebnis nicht genauer werden als der des Kalibrierwertes, in der Regel noch mit Temperaturwerten vor 1980 durchgeführt. Dazu kommen noch die Fehler der Kalibrierkette.

Es ist deshalb vollkommen unglaubwürdig, Temperaturen der Vergangenheit im Bereich von +-0,1 Grad bestimmen zu können. Solche systematischen Fehler lassen sich auch nicht durch Mittelung beseitigen, da die dazu nötign Anforderungen an die Datenbasis nicht eingehalten werden.

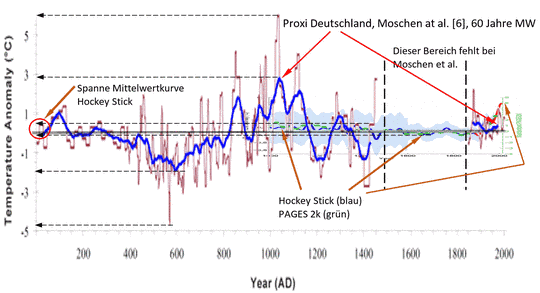

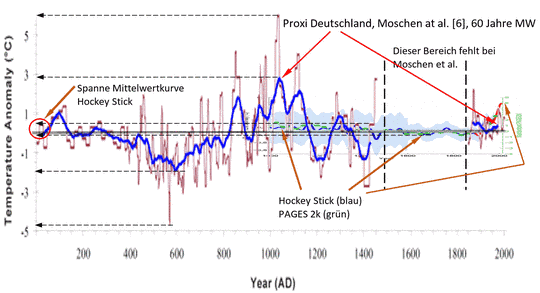

Um die Problematik zu zeigen, hat der Autor die Hockey-Stick-Kurve und PAGES 2k Projektion auf ein Proxi von Deutschland[6] gelegt (Bild 4). Die Temperaturvariabilität unterscheidet sich mit einem Faktor nahe 10 um eine ganze Größenordnung. Man beachte auch den Unterschied im Jahr 2000.

Proxi Deutschland, Moschen at al[6].

— Spannweite Temperatur: > 10 Grad

— Spannweite Mittelwertkurve ca. 6 Grad

Hockey-Stick (Zeitraum vor 1850):

— Spannweite Temperatur: ca. 1,5 Grad

— Spannweite Mittelwertkurve: ca. 0,4 Grad

Bild 4 Ein Proxi von Deutschland und den Hockey-Stick-Verlauf übereinander gelegt

Quellen: Proxi Deutschland: Moschen at al. 2011, Temperature variability at Durres Maar[6], Hockey-Stick: [9]

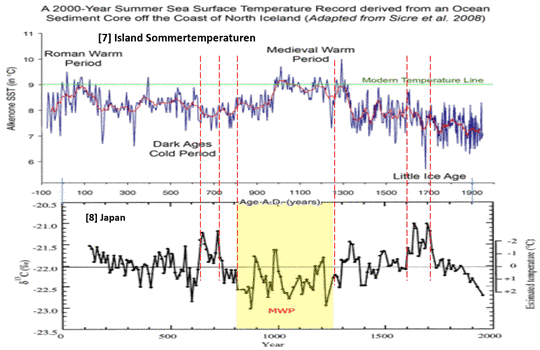

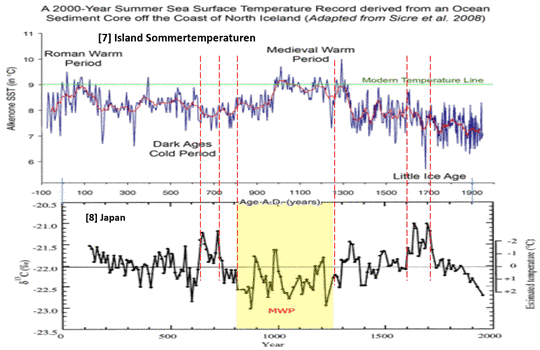

Der Verlauf Deutschland und auch der Stand zum Jahr 2000 sind nicht so exotisch wie man meinen könnte. Eine Proxirekonstruktion aus Island und Japan zeigen einen ähnlichen Verlauf. Erkennbar sind jedoch bei diesen beiden Proxis eklatante Zeitverschiebungen und gegensätzliche Max / Min-Verläufe (Bild 5). Gemeinsam ist ihnen eine große Temperaturspanne und das vollkommene Fehlen des Hockey-Stick-Endes.

Bild 5, Proxiverläufe Island [7] und Japan[8]

Quellen: [7] Sicre at al. 2008: Decadal variability of sea surface temperatures off North Iceland over the last 2000 years. Earth and Planetary Science Letters 268: 137-142. Quelle: Co2Science. [8] Kitagawa at al., Japan, Quelle: Co2Science.

Problem Jahreszeiten- Abhängigkeit

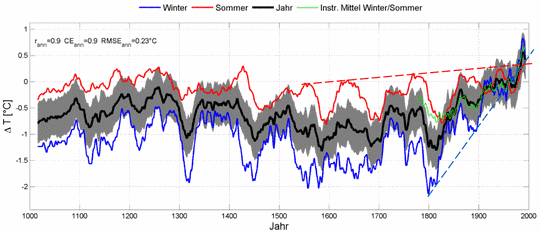

Viele Proxis stammen von Pollen und Baumringen. Sie bilden das Jahr deshalb nicht vollständig ab. Welche enormen Unterschiede sich für das Jahresmittel daraus ergeben können sei indirekt an der folgenden Proxidarstellung welche Sommer und Winter getrennt ausweist gezeigt.

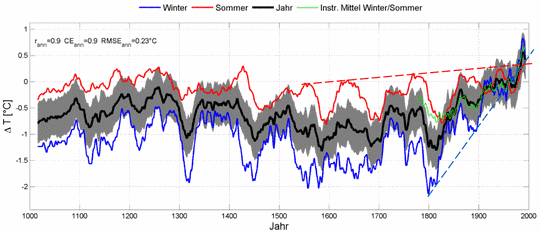

Anmerkung: Diese Rekonstruktion (so sie stimmen sollte) zeigt auch, dass die aktuelle Erwärmung fast vollständig durch wärmere Winter erzeugt wird (die zum Schluss sogar wärmer als die Sommer werden!) – ein eklatanter Widerspruch zur CO2-Theorie. Anmerkung: Dieses Phänomen ist in der Publizierung Das Phänomen der „Temperaturstufen“ [14] ebenfalls gezeigt.

Bild 6[12] Rekonstruktionsverlauf Mitteleuropa getrennt für Sommer, Jahreswert, Winter (vom Autor mit den gestrichelten Linien ergänzt)

Bildtext: Abb. 5.5.: Multi-Proxy-Reihe für Mitteleuropa. Die Reihe ist 31-jährig geglättet. Die grau hinterlegt Fläche zeigt den Fehler, welcher aus der Unsicherheit bei der Indexbildung resultiert. Der Vergleich mit dem Mittel der Sommer und Wintertemperaturen des GMD zeigt eine hohe Übereinstimmung (r=0.9).

Erklärung zum Bild (in der Dissertation):

[12]Bei Betrachtung des Verlaufs der rekonstruierten Temperaturen fällt der Gegensatz zwischen Sommer- und Wintertemperaturen auf. Die Sommertemperaturen weisen eine hohe und konstante mittelfristige Variabilität auf, welche auch in den letzten 50 Jahren keinen auffälligen positiven Trend zeigt. Hingegen weisen die Wintertemperaturen deutlichere Unterschiede sowohl in der Stabilität der Variabilität als auch im langfristigen Verlauf auf

Problem Rauschanteil

Ein weiteres, großes Problem ist der deutlich erkennbare Rauschanteil von Proxiverläufen (Bilder 10 und 11). Dieser ist jedoch schwer zu klassifizieren und in den Auswirkungen zu berechnen, weshalb er – obwohl sehr signifikant – als Einflussgröße nur gestreift wird.

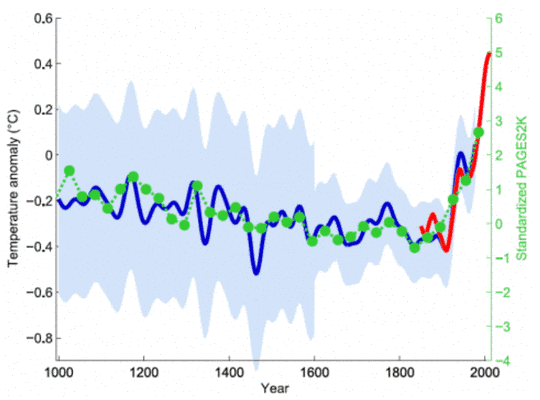

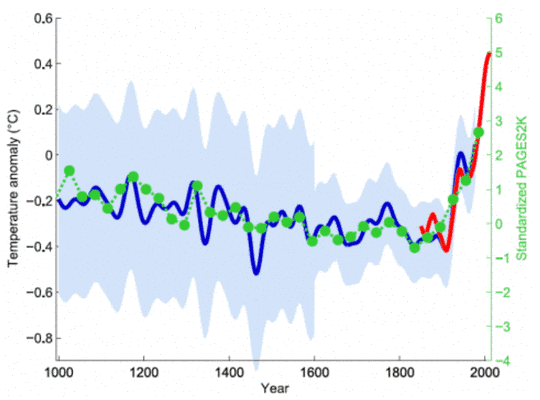

Das Projekt PAGES 2k

Zwischenzeitlich wird eine neue, groß angelegte Rekonstruktion des Temperaturverlaufs der Nordhemisphäre durchgeführt (PAGES 2k-Projekt ) (Bild 7). Diese hat laut den Studienautoren den Hockey Stick neu bestätigt. Prof. Rahmstorf vom PIK berichtete darüber:

Prof. Rahmstorf Paläoklima: Die Hockeyschläger-Debatte:

Vorige Woche haben wir hier die neue Klimarekonstruktion des PAGES 2k-Projekts besprochen, die einmal mehr den Hockeyschläger-Verlauf der Klimageschichte der letzten tausend Jahre bestätigt hat.

Bild 7[9], Hockey-Stick und PAGES 2 k Rekonstruktion

Bildtext: Grüne Punkte zeigen die 30-Jahresmittel (flächengewichteter Mittelwert über die Kontinente) der neuen PAGES 2k-Rekonstruktion. Die rote Kurve zeigt die globale Mitteltemperatur laut HadCRUT4 Messdaten ab 1850 (mit einem 30-Jahresfenster geglättet). Dazu in blau der ursprüngliche hockey stick von Mann, Bradley und Hughes (1999) mit seinem Unsicherheitsbereich (hellblau). Grafik: Klaus Bittermann.

Komischerweise zeigt das PAGES 2k Ergebnis einen noch geraderen Verlauf des Mittelwertes als der Hockey-Stick.

Bei diesem Ergebnis stellt sich die Frage: Ist der Verlauf mit neuen, viel besseren – bedeutet sicher statistisch auswertbaren Daten – generiert und damit genauer, oder wurden die Fehler der Vergangenheit nur wiederholt?

Eine kleine Sichtung soll zeigen, was wahrscheinlicher ist.

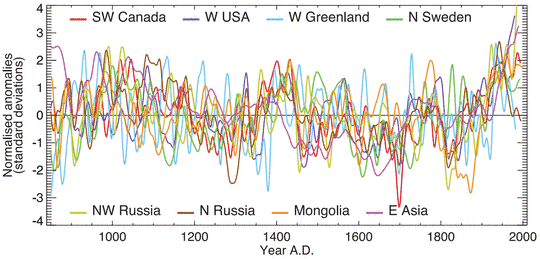

Die Urdaten des PAGES 2k-Projektes sind in Excel verfügbar. Der Autor hat daraus örtlich konzentrierte Datensätze zweier Erdteile (Nordeuropa, Südamerika) herausgezogen und gesichtet. Leider sind die Temperaturwerte in den Daten nicht in Grad, sondern unterschiedlichsten Dimensionen angegeben, weshalb nur die Verläufe, aber nicht die Absolutwerte vergleichbar sind.

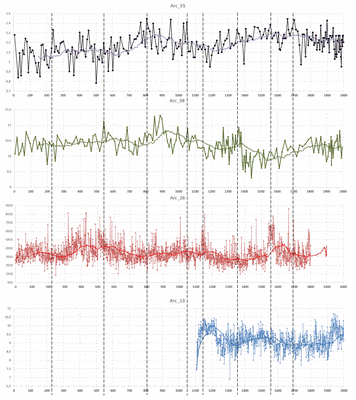

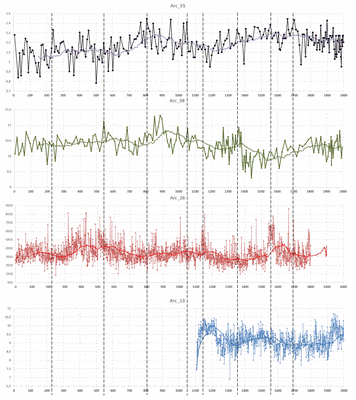

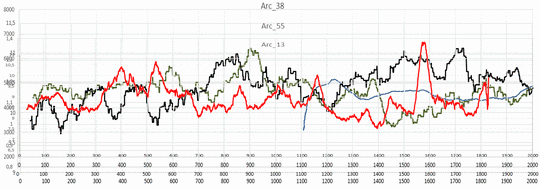

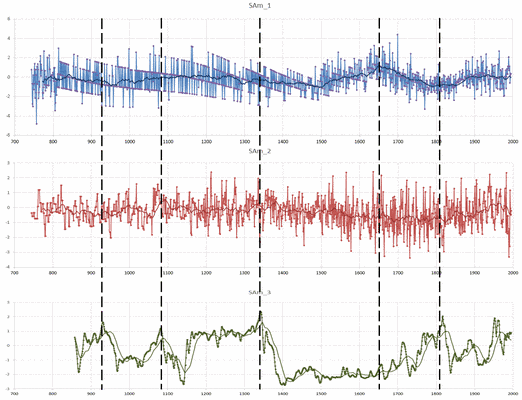

PAGES 2k Proxivergleich Raum Norwegen, Schweden, Finnland

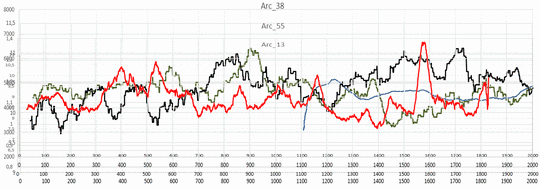

Aus der Arktis sind die Proxis: ARC_55; 38¸26; 13 dargestellt (Bild 8). Diese repräsentieren einen begrenzten räumlichen Bereich und man sollte erwarten, dass sie deshalb ähnliche Verläufe zeigen.

Bild 8 Proxis Bereich Arctic ARC_55; 38¸26; 13 des PAGES 2k Datensatzes vom Autor übereinander gelegt. Zeitachse genau, die Vertikalachsen sind nicht in vergleichbaren Maßstäben.

Jedoch erkennt man in Bild 8 stattdessen deutliche Zeitverschiebungen und teils gegensätzliche Verläufe, zudem große Streuungen. Bildet man die Mittelwerte, sind natürlich die Streuungen verschwunden. Dafür werden die anderen Probleme deutlicher (Bild 9).

Ersichtlich ist, dass über erhebliche Zeitabschnitte keine vernünftige Korrelation besteht. Das kann man sich bei Datensätzen aus der gleichen Gegend aber schwer vorstellen.

Bild 9, Mittelwerte aus Bild 8 (Proxis des Projekt PAGES 2k Datensatzes ARC_55; 38¸26; 13) vom Autor übereinander kopiert. Zeitachse genau, die Vertikalachsen sind nicht in vergleichbaren Maßstäben und wurden vom Autor verschoben.

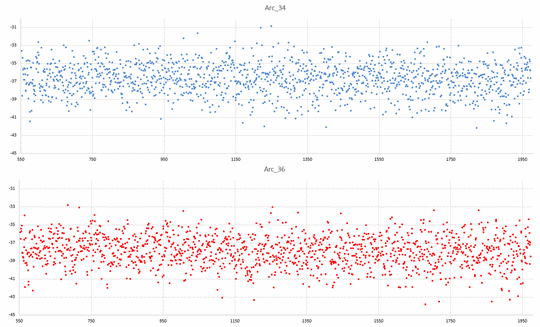

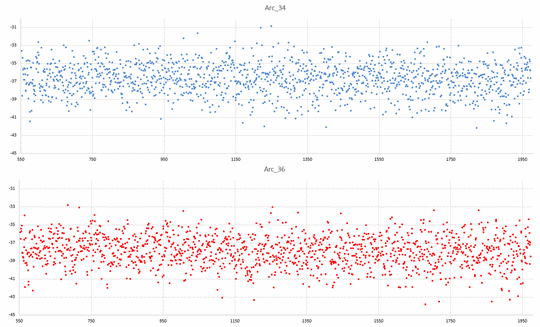

Detailsichtung der Datensätze Arktik ARc_34 und ARc_36 aus der gleichen Gegend von Grönland

Die Datensätze ARc_34 und ARc_36 (Eisbohrkern-Daten) wurden vom Autor auf gleiche Spannweite und den Endwert 0 (im Jahr 1973) normiert. Bild 10 zeigt die sich ergebenden Proxiverläufe.

Bild 10 Proxi ARc_34 (blau) und ARc_36 (rot) (beides Eisbohrkern-Daten) des PAGES 2k Datensatzes. Normiert auf gleiche Spannweite und Endwert 0 im Jahr 1973

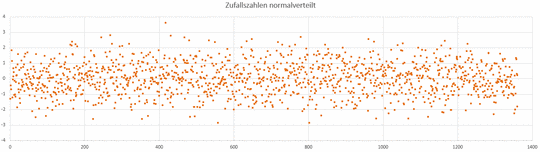

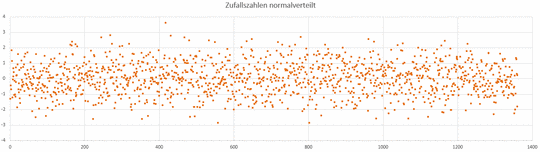

Im folgenden Bild sind normalverteilte Zufallszahlen dargestellt. Die Ähnlichkeit mit den vorhergehenden Proxi-Bildern ist verblüffend.

Bild 11 Bild normalverteilter Zufallszahlen

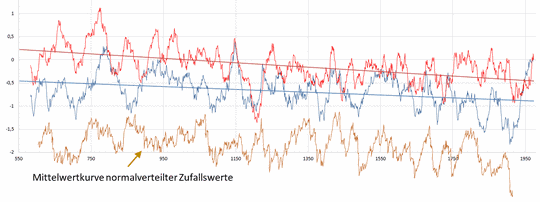

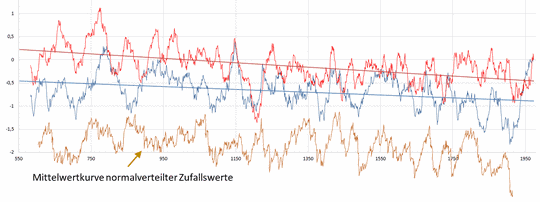

Bild 12 zeigt zusätzlich die Mittelwerte und Regressionsgeraden. Im Bild sieht man, dass die Kalibrierungen zum Jahr 1973 nicht übereinstimmen, denn die Mittelwertkurven und Regressionsgeraden haben zueinander einen erheblichen Offset. Die zugefügte Mittelwertkurve aus den Zufallswerten von Bild 11 (braun) zeigt eine fast identische Verlaufscharakteristik (vor allem zur blauen Proxikurve), womit die Wahrscheinlichkeit dass die Proxis im Wesentlichen Rauschen darstellen erhärtet wird.

Bild 12 30-Jahre Mittelwerte der Proxis ARc_34 (blau) und ARc_36 (rot) des PAGES 2k Datensatzes. Normiert auf gleiche Spannweite und Endwert 0 im Jahr 1973. Zugefügt eine Mittelwertkurve normalverteilter Zufallswerte (braun) mit gleicher Auflösung und entsprechend der blauen Kurve schief gestellt

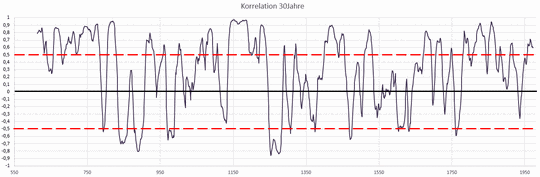

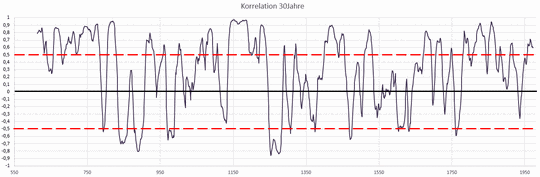

Doch auch die Übereinstimmung der Mittelwertverläufe selbst ist desaströs (Bild 13). Eine Übereinstimmung welche einen Münzwurf überschreitet (K >= +0,5) besteht nur für 42 % des Zeitraums, eine vollständig negative Korrelation (K < 0) besteht für 27 % des Zeitraumes.

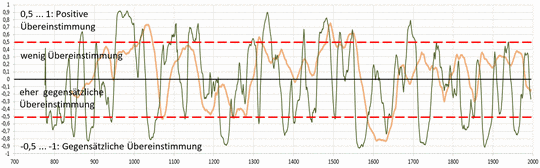

Bild 13 Korrelationsverlauf der 30-Jahre Mittelwerte der Proxis ARc_34 und ARc_36 (Bild 9.2) des PAGES 2k Datensatzes vom Jahr 613 – 1973

Aussagen des Korrelationskoeffizienten:

Koeffizient = +1: Übereinstimmung

Koeffizient = +0,5: Übereinstimmung entspricht einem Münzwurf (50 %)

Koeffizient = 0: Keinerlei Übereinstimmung

Koeffizient = -1: genau entgegengesetzte Übereinstimmung

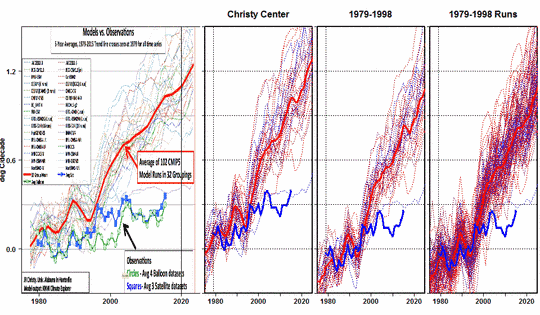

Beispiele Kontinental-globaler Proxisammlungen

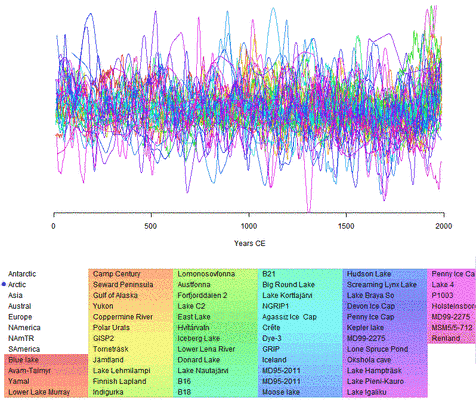

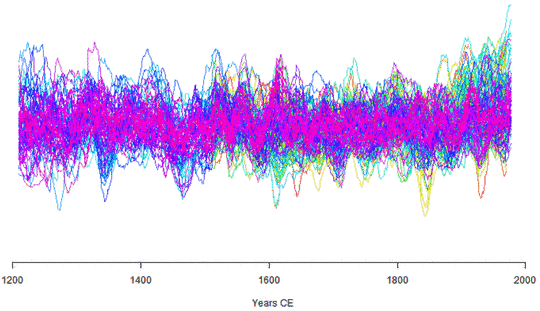

Bevor noch weitere Detailsichtungen erfolgen, eine Übersicht wie es aussieht wenn alle Proxiverläufe eines Kontinentes gemeinsam dargestellt sind.

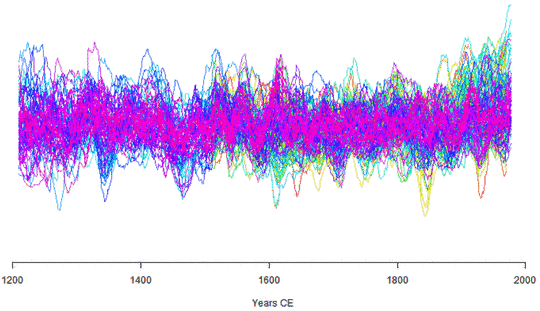

Über einen WEB-Viewer „Aktive viewer for the Pages 2K Proxis“ lassen sich die PAGES 2k Daten direkt ansehen. Daraus beispielhaft der Proxiverlauf der gesamten Arktis (Bild 14) und Nordamerika (Bild 14.1). Man sieht auch ohne Statistik, dass diese Bilder keinen globalen Klimaverlauf sondern ein Chaos durch Proximängel zeigen.

Dazu die einfache Frage: Welche Statistik soll daraus den wirklichen Verlauf extrahieren? Ein stur berechneter Mittelwert erzeugt jedoch immer einen mehr oder weniger geraden Strich. Und dieser Strich wird um so „gerader“, je mehr solch unbrauchbare Datensätze „zusammen gepackt“ werden. Durch das Erhöhen der Anzahl Proxis wird rechnerisch der Mittelwert immer genauer (die Vier-fache Probenmenge verdoppelt die Genauigkeit), wie es viele Rekonstruktionen stolz ausweisen – in Wirklichkeit wird es aber schlechter, weil die fehlende Datenintegrität nur Rauschen zufügt und das „Wissen“ über die Grundgesamtheit nicht verbessert, sondern „verwässert“.

Bild 14 Alle Proxis Arctic des Projekt PAGES 2k Datensatzes. Quelle: Active viewer for the Pages 2K Proxis

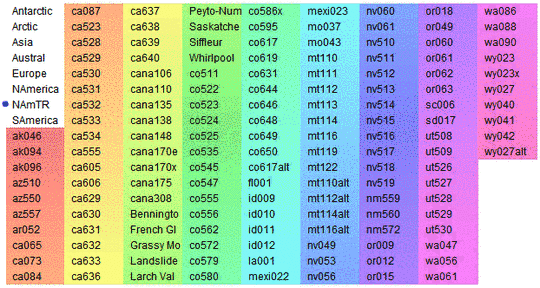

Nun der „Spaghettiverlauf“ von Nord-Amerika. Auch hier das identische Problem (Bild 11).

Bild 14.1 Alle Proxis Arctic NAmericaTR des Projekt PAGES 2k Datensatzes. Quelle: Active viewer for the Pages 2K Proxis

Bild 14.2 Liste aller Proxis Arctic NAmericaTR des Projekt PAGES 2k Datensatzes. Quelle: Active viewer for the Pages 2K Proxis

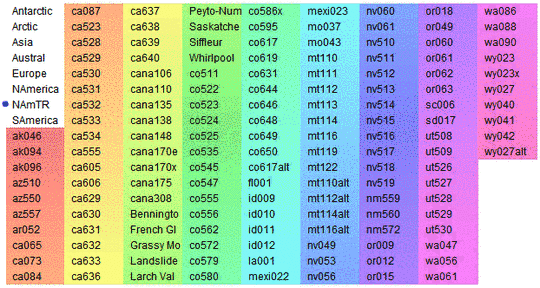

PAGES 2k Proxivergleich Raum Südamerika Westküste

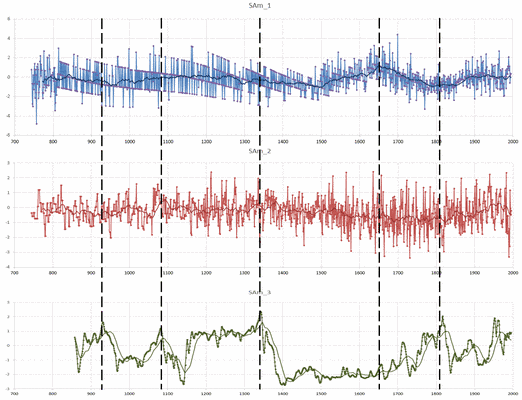

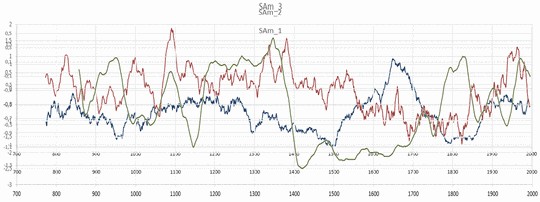

Das Vorgehen zur orientierenden Analyse von Arktisdaten nun wiederholt für Proxis aus Süd-Amerika. Die ausgewählten drei Samples stammen alle aus dem mittleren Bereich der südamerikanischen Westküste. Die Datensätze SAm_1;_2 stammen sogar vom gleichen Eisfeld. Die Klimaverläufe (SAm_1;_2) wurden jedoch nach unterschiedlichen Verfahren ermittelt.

SAm_1 Quelccaya Peru Ice-Core, Verfahren accumulation

SAm_2 Quelccaya Peru Ice-Core, Verfahren δ180

SAm_3 Laguna Aculeo Chile, Verfahren Lake sediment

Bild 15 Proxis Bereich Südamerika SAM_1, SAM_2¸ SAM_3 des PAGES 2k Datensatzes vom Autor übereinander gelegt. Zeitachse genau, die Vertikalachsen sind nicht in vergleichbaren Maßstäben.

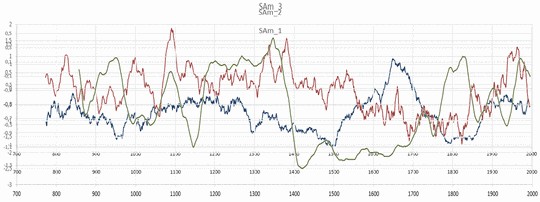

Wieder zeigen sich erhebliche Zeitverschiebungen, teils gegensätzliche Verläufe und große Streuungen. Im übereinander gelegten Verlaufsbild der Mittelwerte (Bild 16) erkennt man es noch deutlicher.

Bild 16 Proxis des PAGES 2k Datensatzes SAM_1; 2¸ 3 vom Autor übereinander kopiert. Mittelwerte (von Bild 15), Zeitachse genau, die Vertikalachsen sind in den Originalen nicht in vergleichbaren Maßstäben und wurden vom Autor deshalb auf eine ungefähr gleich große Spanne verschoben.

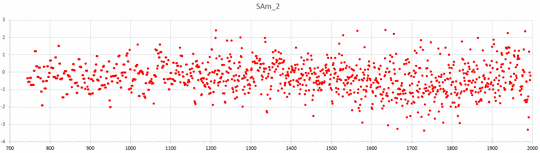

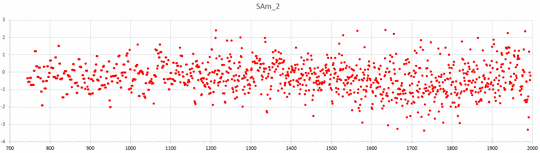

Bild 17 zeigt den Datensatz SAm_2 im Original ohne verbindende Linien. Wieder besteht der große Verdacht, dass der Datensatz im Wesentlichen aus Rauschen besteht.

Bild 17 Proxi SAm_2 des PAGES 2k Datensatzes

Detailsichtung der Datensätze Südamerika SAm_1 und SAm_2 vom gleichen Eisfeld

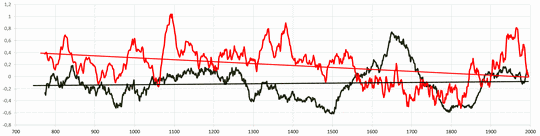

Die Datensätze SAm_1 und SAm_2 wurden vom Autor auf gleiche Spannweite und den Endwert 0 (im Jahr 1995) normiert. Bild 18 zeigt die sich ergebenden Mittelwertverläufe und Regressionsgeraden.

Es zeigt sich:

— Die Mittelwerte verlaufen teils über mehrere Hundert Jahre gegensätzlich

— Die Regressionsgeraden ergeben für SAm_1 (schwarz) einen minimalen Anstieg , für SAm_2 (rot) einen deutlichen Temperaturabfall.

Bild 18 Mittelwert (n = 30 Jahre) SAm_1 (schwarz) SAm_2 (rot). Regressionsgeraden SAm_1 (schwarz) SAm_2 (rot)

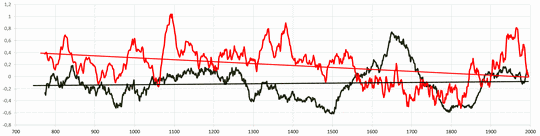

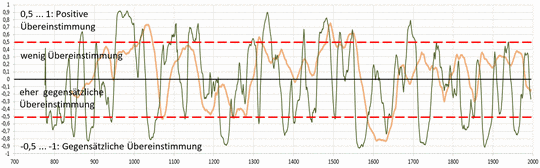

Die Korrelationskurven der beiden Mittelwertverläufe zeigt Bild 19. Zwischen den beiden Kurven besteht weder im 30 Jahre noch im 100-Jahre-Intervall und nicht einmal in der jüngeren Zeit eine längere Korrelation über dem „Münzwurfwert“ + 0,5. Für über 50 % der Zeit besteht sogar ein gegensätzlicher Verlauf.

Korrelationen innerhalb des 30-Jahre Intervalls (Bild 19):

K >= 0,5 16 % des Zeitraums

K < 0 53 % des Zeitraums

Es besteht deshalb mehr als der Verdacht, dass die Proxis im Wesentlichen nur Rauschen darstellen.

Bild 19 Korrelation der 30-Jahre Mittelwertkurven von SAm_1 / SAm_2 über die Zeitabschnitte 30 Jahre (grün) und 100 Jahre (braun).

Zuletzt noch das Gesamtbild aller Proxis Südamerika (Bild 20). Auch darin sind wieder vollkommen gegensätzliche Verläufe und Zeitverschiebungen erkennbar.

Bild 20 Alle Proxis SAmerica des Projekt PAGES 2k Datensatzes. Quelle: Active viewer for the Pages 2K Proxis

Damit wiederholend die Feststellung:

Entweder gab es auch in diesem begrenzten Bereich von Südamerika kein einheitliches Klima – was unwahrscheinlich erscheint – oder die Proxis spiegeln es einfach nicht wieder.

Auch in dieser Gegend kann man leicht belegen, dass Proxis der gleichen Gegend (hier sogar vom gleichen Eisfeld) vollkommen gegensätzliche Klimaverläufe anzeigen und extrem fehlerbehaftet sein müssen – sich sogar die Frage stellt, ob sie überhaupt einen Klimaverlauf wiederspiegeln.

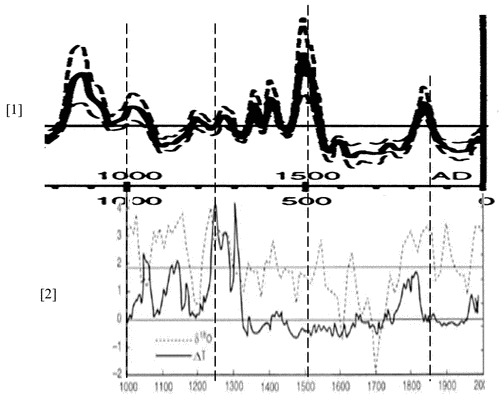

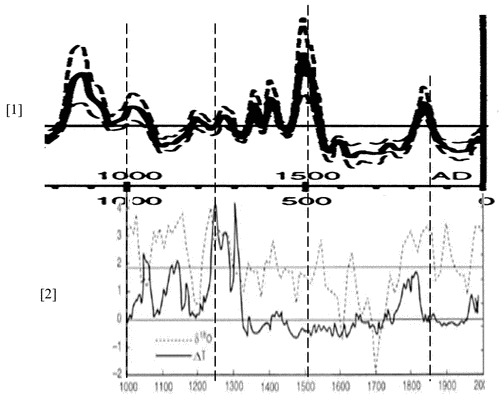

Zwei Proxis aus der gleichen Höhle in Afrika

als ein Beispiel für eklatante Proxi-Zeitfehler.

In zwei Studien welche im MWP-Projekt von CO2SCIENCE verwendet (und gemittelt) wurden:

[2] Tyson at al., Cold Air Cave, Makapansgat Valley, South Africa und

[1] Holmgren at al. Cold Air Cave, Makapansgat Valley, South Africa

ist jeweils eine Proxirekonstruktion aus der gleichen Höhle gelistet. Legt man diese zwei Rekonstruktionen aus den Studien übereinander zeigt sich das Bild 21. Man könnte meinen, die Höhle hat gleichzeitig zwei vollkommen verschiedene Klimate erlebt. Auf jeden Fall wird das Ergebnis durch Mitteln (was in dem Projekt erfolgte) niemals richtig.

Bild 21 Zwei Proxis [1][2] aus der Höhle Makapansgat Valley, South Africa vom Autor im angegebenen Zeitmaßstab übereinander platziert

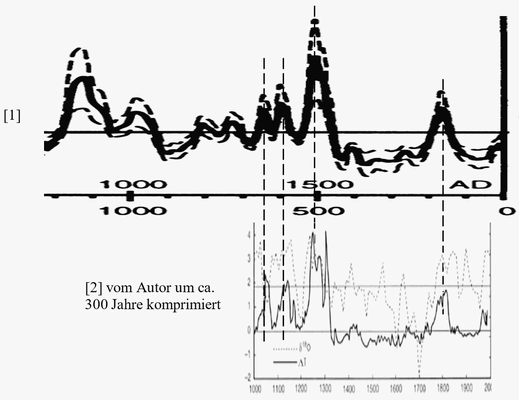

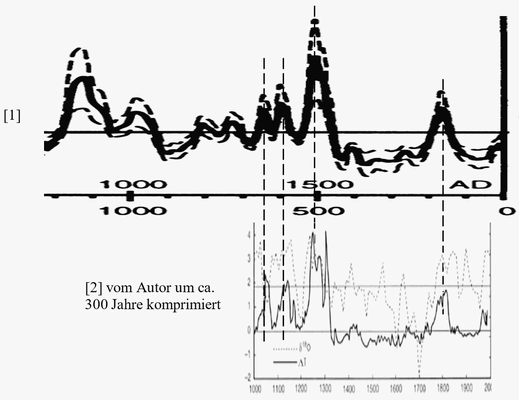

Komprimiert man allerdings die Zeitachse der Proxirekonstruktion aus [2] um ca. 300 Jahre!, dann werden beide Verläufe deckungsgleich (Bild 22). Ein exemplarisches Beispiel für teils extreme Probleme der Zeitzuordnungen und leider dem extrem laschen (eher sträflichen) Umgang damit.

Bild 22 Proxis [1][2] von Bild 16. Proxi [2] vom Autor zeitlich komprimiert und dadurch mit [1] in Deckung gebracht

Dazu bedenke man, dass im Projekt aus den Daten von Bild 21 durch Mitteln ein „wahrscheinlicher Verlauf“ „ermittelt“ wurde – der wie gezeigt jedoch vollkommen falsch ist. Und solche Verschiebungs- Konstellationen sind ein häufiger Fall.

Fazit PAGES 2k Projekt

Es ist erkennbar, warum das Projekt PAGES 2k die Hockeystick-Kurve bestätigen muss. Es wurden auch bei der Wiederholung gleich ungeeignete Datensätze und statistische Verfahren verwenden. Damit muss das gleiche Ergebnis – eine ziemlich linear verlaufende Mittelwertkurve – herauskommen. Da nutzt es nichts, dass zum Projekt 79 Haupt-Autoren gelistet sind.

Auch die Darstellung bei RealClimate dazu kann der Autor nicht teilen und würde anstelle des dort zustimmenden „ … forward“ ganz konkret ein desaströßes „ … backward“ sagen:

RealClimate: The PAGES-2k synthesis, Guest commentary by Darrell Kaufman (N. Arizona U.)

„…In a major step forward in proxy data synthesis, the PAst Global Changes (PAGES) 2k Consortium has just published a suite of continental scale reconstructions of temperature for the past two millennia in Nature Geoscience.“

Dazu ein leicht angepasster Statistikseminar-Einsteigerwitz:

Patient steht mit einem Fuß in kochendem Wasser und mit dem anderen im Trocken-Eis. Der Computer berechnet mit höchster Signifikanz, dass sich der Patient im Mittel pudelwohl fühlt und die Standardabweichung dazu sehr gering sei. Kurz darauf stirbt der Patient. Ein Klimawissenschaftler folgert nun: Die Standardabweichung war noch zu groß. Mit mehr Probanden wird sie aber kleiner und sie fühlen sich immer signifikanter pudelwohl.

Merkt das niemand?

Doch, natürlich. Aber es wird ignoriert – da man keine Lösung hat. Die richtige Lösung: Zugeben, dass man falsch angefangen hat und unbedingt neu aufsetzen müsste – ist politisch derzeit nicht vorstellbar. Es wäre auch ein schlimmes Desaster – nicht nur für die beteiligten Wissenschaftler.

Man geht da doch lieber in die Offensive und verkauft weiterhin sogar solche offensichtlichen Mängel und Fehler als Erfolg und heftet sich (noch kurz vor dem Untergang?) möglichst viele Orden an die Brust, Nobelpreis-Aspiranz gleich inbegriffen, Beispiele:

Prof Rahmstorf mit seinem uneingeschränkten Lob zum PAGES 2k Ergebnis „Paläoklima: Die Hockeyschläger-Debatte“ und Klimaretter.Info „Einen Nobelpreis für James Hansen!“

Prof Rahmstorf in „Paläoklima: Die Hockeyschläger-Debatte“: In der Fachwelt gelten die Arbeiten von Mann et al. als hoch respektierte Pionierleistung (die Forscher erhielten eine Reihe von Preisen, Mann und Bradley z.B. beide die Oeschger-Medaille der European Geosciences Union).

Nur selten werden Hinweise auf Probleme publiziert. Ein positives Beispiel ist die zu einer Studie des Alfred Wegener Instituts – deren Kommentierung jedoch schon fast einer Bankrotterklärung entspricht:

[11] NEUE STUDIE ZEIGT ERHEBLICHE DIFFERENZEN ZWISCHEN KLIMAARCHIVEN UND KLIMAMODELLEN – Das Klima der Erde scheint in den letzten 7000 Jahren sehr viel unbeständiger gewesen zu sein als bisher gedacht.

Über Zeiträume von Jahren und Jahrzehnten stimmten Mess- bzw. Klimaarchivdaten und Modellläufe recht gut überein. Doch je länger die Zeitskalen, desto größer wurde die Diskrepanz – am stärksten in tropischen Meeresregionen. Auf tausendjähriger Zeitskala unterschätzten gängige Klimamodelle die aus den Klimaarchiven rekonstruierten Schwankungen der Meeresoberflächentemperaturen um den Faktor 50.

„Theoretisch gibt es nun zwei denkbare Erklärungen“, so Thomas Laepple. „Entweder liefern die Klimaarchive keine verlässlichen Temperaturdaten, oder die Klimamodelle unterschätzen die Variabilität des Klimas. Vielleicht stimmt auch beides ein bisschen.“

Ein Kommentar aus einem Blog zum PAGES 2k Datensatz zeigt, dass nicht nur der Autor (und vielleicht ein paar politisch nicht ausreichend umgeschulte Forscher des AWI) die Datensätze und das statistische Vorgehen als ungeeignet betrachten:

Blog: RealClimate, The PAGES-2k synthesis

Kommentar

To my eye, flipping between the proxies from a given region shows there to be lots of noise both within a given series and between any pair of series. This is very evident for the various ‘CAN composite’ series, which from Nick’s map appear to be geographically close together. When I spend some time flipping between these it is really impossible for me to say with any confidence that they are measures of the same thing – whatever that thing might be – and that if they are then the signal to noise ratio is miniscule.

If I had a student who brought data like this to me along with a statistical analysis I would send him back to the lab to get better data. Paleoclimate studies can’t do this, of course, but I’m wondering if it would at least be worthwhile to calculate correlations between proxies absent any underlying assumptions in order to assess whether the data has any value.

For example, wouldn’t one expect all the geographically close ‘CAN composite’ series to be more similar to each other than they are to, say central Asia? Shouldn’t it be a requirement that this be true before going ahead and throwing it into the mix? Otherwise it seems to me that garbage is being mixed with what is already a very small signal and I can’t see any good coming of that.

If I had to give an overall impression of the state of progress of paleoclimate reconstructions over the past 15 years I would say that it largely consists of taking more and more data and dumping it into ever more elaborate statistical procedures in the hope that a silk purse will emerge. It’s not at all clear to me that we wouldn’t be better off going back a step and trying to improve the data.

[Übersetzung von Chris Frey: Meiner Ansicht nach zeigt das Hin- und Herschwingen zwischen Proxys einer bestimmten Regioneine Menge Rauschen erzeugt, sowohl in einer gegebenen Einzelreihe als auch in jedwedem Satz von Reihen. Dies ist sehr offensichtlich bei den verschiedenen ,CAN-Komposit-Reihen‘ der Fall, welche Nicks Graphik zufolge geographisch nahe beieinander zu liegen scheinen. Wenn ich eine Weile zwischen diesen hin- und herschalte, ist es mir wirklich unmöglich, mit einiger Sicherheit zu sagen, dass es Messungen der gleichen Sache sind – was auch immer diese Sache sein mag – und falls das so ist, dann ist das Signal im Verhältnis zum Rauschen minimal.

Falls mir ein Student mit einer Analyse wie dieser unterkommen würde, , würde ich ihn in sein Laboratorium zurückschicken, um bessere Daten zu bekommen. Mit paläoklimatischen Studien geht das nicht, aber ich frage mich, ob es nicht zumindest wert ist, Korrelationen zu berechnen zwischen Proxys, denen jedwede zugrunde liegende Hypothese fehlt, um abzuschätzen, ob die Daten überhaupt von Wert sind. Beispiel: Würde man nicht erwarten, dass alle geographisch benachbarten ,CAN-Reihen‘ miteinander ähnlicher sind als beispielsweise mit Zentralasien? Sollte nicht die Notwendigkeit bestehen, bevor man weitergeht und alles in den Mix hineinwirft? Anderenfalls scheint mir , dass Müll mit etwas vermischt wird, dass bereits nur ein sehr geringes Signal ist, und ich kann daran nichts Gutes finden.

Falls ich einen Gesamteindruck des Status‘ des Fortschritts bei paläoklimatischen Rekonstruktionen während der letzten 15 jahre geben müsste, würde ich sagen, dass dieser Status im Wesentlichen gekennzeichnet ist durch das Sammeln von immer noch mehr Daten und diese mit immer weiteren statistischen Verfahren zu bearbeiten – in der Hoffnung, dass sich irgendetwas zeigt. Mir ist in keiner Weise eingängig, warum es nicht besser wäre, einen Schritt zurückzugehen und bessere Daten zu bekommen versuchen.]

Antwort des Admin

[Response: And what specific suggestions for “improving the data” do you have in mind? It is worth noting that in my experience, the correlation among weather station data is no higher than among similarly spaced paleoclimate data. To me, this says that the paleoclimate data quality if just fine– and that the noise is in regional vs global climate, not the quality of the proxies themselves. In short, we need more data, not “better” data (though better is fine, obviously). Getting more data, of course, it exacty what the authors of the PAGES 2k paper are trying to do.–eric]

[Übersetzung von Chris Frey: Erwiderung: Und welche spezifischen Vorschläge zur „Verbesserung der Daten“ schweben Ihnen vor? Man muss sagen, dass meiner Erfahrung nach die Korrelation unter den Daten von Wetterstationen nicht höher ist als unter ähnlich gelagerten paläoklimatischen Daten. Ich schließe daraus, dass die Qualität der paläoklimatischen Daten einfach gut ist – und dass das Rauschen dem Unterschied zwischen regionalem und globalem Klima geschuldet ist und nicht der Qualität der Proxys selbst. Kurz gesagt, wir brauchen mehr Daten, nicht „bessere“ Daten (obwohl natürlich ,besser‘ sehr schön wäre). Und mehr Daten zu erhalten ist natürlich genau das, was die Autoren der PAGES 2k-Studie versuchen.]

Kommentierung

Bei der Antwort des Admin bleibt einem wirklich „die Spucke weg“. Weil die Daten von Temperatur-Messstationen genau so wenig übereinstimmen (wie Proxidaten) müssen es Proxidaten auch nicht. Dazu die Aussage, nicht die Daten müssen genauer werden, sondern man benötigt eben mehr (schlechte). Und die Bestätigung, dass dies das Vorgehen im Projekt PAGES 2k bestimmt (hat).

Dabei macht der Admin genau den im Artikel angesprochenen Fehler:

— Bei den Temperaturmessungen hat man eine Genauigkeit, bei der eine größere Abdeckung durch mehr Messstellen die bisherige Ungenauigkeit globaler Kurven verringert.

— Bei den Temperaturproxis ist die erforderliche Basisgenauigkeit, Datenhomogenität, Zeitzuordnung und Rauschfreiheit nicht gegeben, so dass mehr Proxis kein besseres Ergebnis, sondern nur eine immer geradere, falsche Kurve liefern können.

Nachtrag

Als Bonmot noch eine Darstellung, was jemand der für die CRU-Datensammlung eingesetzt wurde über die Datenqualität in Mails sagte. Es könnte vom Autor stammen, dem es bei seinen Recherchen ganz genau so geht. Denn es ist wirklich so: Die Datenqualität – ob Temperaturdaten, Proxis oder Meeresspiegel – ist weltweit einfach nur grottenschlecht. Entsprechend sind es auch die Zukunfts-Projezierungen „Rezension: UBA Studie 24/2015 Die Vulnerabilität Deutschlands gegenüber dem Klimawandel“

Es wäre alles kein Problem – wenn diese Mängel und offensichtlichen Fehler nicht das Geld der Bürger kosten würden.

CRU: Datensammlung oder Datenmüll?

Quelle: ScienceSkepticalBlog, 16. Januar 2010: Ilmastogate – Finnische Doku zu Klimagate mit deutscher Übersetzung

Eine wichtige Aufgabe der CRU ist die Pflege der Daten und des Computer-Codes zur Berechnung der globalen Durchschnittstemperatur. Es ist dieses Material, dass Jones so standhaft vor externer Überprüfung geschützt hat. Die bekannt gewordenen Dokumente enthüllen jetzt einen möglichen Grund für die Geheimhaltung. Die wissenschaftlichen Daten und der Computer-Code im Zentrum der Weltpolitik sind in einem Zustand, dass sie nicht einmal für Leute zu entschlüsseln sind, die verantwortlich für die Pflege der Daten sind. Vor kurzem wurde junger Computer Programmierer, genannt Harry, eingestellt um das Chaos in Ordnung zu bringen. Harrys genervte Anmerkungen sind jetzt für die Öffentlichkeit verfügbar (Anm.: Der im Original hier eingestellte Link verweist nicht mehr auf die richtige Fundstelle).

„OH VERF****. Es ist Sonntag Abend, ich habe das gesamte Wochenende gearbeitet, und gerade als ich dachte, ich wäre fertig, finde ich schon wieder ein neues Problem. Es gibt keine einheitliche Datenintegrität. Es ist eine einzige Ansammlung von Problemen die anwachsen sobald man sie gefunden hat.“

Es ist genau ebendiese Datenbank, welche Harry so verflucht, mit der die Welt-Mitteltemperatur ermittelt wird, die im 20. Jahrhundert um 0,7 °C angestiegen sein soll. Diese Daten sind auch wichtig für die Zukunft. Die Computermodelle zur Vorhersage eines zukünftigen Anstiegs der Globaltemperatur werden mit Hilfe dieser CRU-Statistik getestet und kalibriert. Wenn sie in der Lage sind, den Anstieg im letzten Jahrhundert zu reproduzieren, wie er von der CRU konstruiert worden ist, sollen sie angeblich in der Lage sein, das Klima bis zum Ende des 21. Jahrhunderts vorhersagen zu können.

Quellen

[1] Holmgren, K., Tyson, P.D., Moberg, A. and Svanered, O. 2001. A preliminary 3000-year regional temperature reconstruction for South Africa. South African Journal of Science 97: 49-51.

[2] Tyson, P.D., Karlen, W., Holmgren, K. and Heiss, G.A. 2000. The Little Ice Age and medieval warming in South Africa. South African Journal of Science 96: 121-126.

[3] ScienceScepticalBlog, 12. Oktober 2013 : Der Hockeystick: Rise and Fall des Symbols für den menschgemachten Klimawandel

http://www.science-skeptical.de/klimawandel/der-hockeystick-rise-and-fall-des-symbols-fuer-den-menschgemachten-klimawandel/0010940/

[4] itsnotnova: Nova’s Warm Period https://itsnotnova.wordpress.com/2012/09/03/novas-warm-period/

[5] EIKE, 26.04.2016: Systematischer Fehler bei Klimamessungen: Die Aufzeichnung der Lufttemperatur an der Erdoberfläche

http://www.eike-klima-energie.eu/news-cache/systematischer-fehler-bei-klimamessungen-die-aufzeichnung-der-lufttemperatur-an-der-erdoberflaeche/

[6] Moschen at al. 2011, Temperature variability at Durres Maar

Moschen et al. present "a high resolution reconstruction of local growing season temperature anomalies at Durres Maar, Germany [50°52’N, 6°53’E], spanning the last two millennia

[7] Sicre at al. 2008: Decadal variability of sea surface temperatures off North Iceland over the last 2000 years. Earth and Planetary Science Letters 268: 137-142. Quelle: Co2Science

[8] Kitagawa at al. 1995: Climatic implications of δ13C variations in a Japanese cedar (Cryptomeria japonica) during the last two millennia. Geophysical Research Letters 22: 2155-2158. Bildquelle: Co2Science.

[9] SciLogs 23. Mai 2013 von Stefan Rahmstorf in Klimadaten: Paläoklima: Die Hockeyschläger-Debatte

http://www.scilogs.de/klimalounge/palaeoklima-die-hockeyschlaeger-debatte/

[10] ScienceSkepticalBlog, 16. Januar 2010: Ilmastogate – Finnische Doku zu Klimagate mit deutscher Übersetzung

[11] kaltesonne 22. November 2014: Neue AWI-Studie warnt: Klimamodelle unterschätzen natürliche Schwankungen der Meeresoberflächentemperaturen um den Faktor 50

http://www.kaltesonne.de/neue-awi-studie-zeigt-erhebliche-differenzen-zwischen-klimaarchiven-und-klimamodellen/

[12] Riemann, Dirk 2010, Dissertation: Methoden zur Klimarekonstruktion aus historischen Quellen am Beispiel Mitteleuropas

[13] SciLogs, Prof. Rahmstorf 17. Juni 2013: Paläoklima: Das ganze Holozän

[14] EIKE 06.11.2015: Langfrist-Temperaturverläufe Deutschlands: Das Phänomen der „Temperaturstufen“

http://www.eike-klima-energie.eu/news-cache/langfrist-temperaturverlaeufe-deutschlands-das-phaenomen-der-temperaturstufen/