Den Stillstand zerschlagende SST-Daten: Hat die NOAA eine Beziehung zwischen NMAT und SST hinweg adjustiert, die laut Konsens der CMIP5-Klimamodelle existieren sollte?

Bild rechts: © Chris Frey 2015

Hintergrund

Die NOAA hat ihr globales Temperatur-Erzeugnis Anfang dieses Jahres überarbeitet, um eine größere globale Erwärmung zu zeigen im Zeitraum nach 1998. Diese Datenmanipulationen haben vermeintlich die Verlangsamung der globalen Erwärmung in jenem Zeitraum beendet. Die von der NOAA durchgeführten Änderungen der globalen Temperatur wurden in drei Studien präsentiert. Die größten Änderungen wurden im Anteil der Wassertemperatur vorgenommen, und diese Änderungen waren Thema in den Studien von Huang et al. (2015) und Liu et al. (2015). Diese beiden Studien waren im Februar 2015 veröffentlicht worden – und von den Mainstream-Medien nicht zur Kenntnis genommen worden. Die Alarmisten jedoch haben nicht die Studie von Karl et al. (2015) übersehen Possible Artifacts of Data Biases in the Recent Global Warming Hiatus (Zahlschranke; gesamte Studie hier). Während sich die Überarbeitung auf den gesamten Zeitraum der globalen NOAA-Temperaturen seit dessen Beginn in den 1850-er Jahren erstreckte, haben sich Karl et al. (2015) auf die Zeiträume 1998 bis 2014 und 2000 bis 2014… konzentriert, während derer die NOAA den Anteil der Wassertemperatur bis zu einem Ausmaß adjustiert hatte, dass sie behaupten konnten, die Verlangsamung der globalen Erwärmung hatte es nie gegeben.

Natürlich waren diese Behauptungen irreführend. Grund: Selbst mit den NOAA-Änderungen an den Temperaturaufzeichnungen gibt es immer noch die sich unverändert erweiternde Diskrepanz zwischen Beobachtungen und der aufgrund von Klimamodellen prophezeiten globalen Erwärmung. Mit anderen Worten, die Manipulationen der NOAA an den globalen Temperaturaufzeichnungen haben diese Diskrepanz zwischen Modellen und Daten etwas kleiner gemacht, sie aber nicht eliminiert.

Der US-Kongress-Abgeordnete Lamar Smith ist Vorsitzender des Committee on Science, Space and Technology des Repräsentantenhauses. Wie viele andere Menschen auch hat Repräsentant Smith die NOAA-Änderungen bzgl. ihrer Temperaturaufzeichnung hinterfragt. Kürzlich hat Repräsentant Smith formell die NOAA-E-Mails angefordert, in denen es um die Änderungen der globalen Temperaturaufzeichnungen geht, und bis jetzt ist Dr. Kathryn Sullivan von der NOAA dieser Anforderung nicht gefolgt. Es gibt eine Fülle von Nachrichten-Artikeln über den Streit zwischen Smith und der NOAA, aber dieser ist nicht Gegenstand dieses Beitrags.

In diesem Beitrag geht es um die primäre Adjustierung, die die größte Auswirkung hat auf die den Stillstand zerschlagende [„pause busting“] Natur der neuen NOAA-Rekonstruktion der globalen Wassertemperatur an der Ozeanoberfläche. Ich komme zu dem Ergebnis, dass die NOAA einen Unterschied zwischen Messungen der Wassertemperatur durch Schiffe und der nächtlichen Lufttemperatur über Ozeanen hinweg adjustiert haben könnte. Diesen sollte es jedoch dem Konsens der im jüngsten IPCC-Bericht 5 verwendeten Klimamodelle zufolge geben. Wieder einmal legt dies die Vermutung nahe, dass eine weitere NOAA-Hypothese korrekt ist.

Zusätzlicher Hintergrund: Korrekturen eines Bias‘ der Wassertemperatur der Ozeane

Verschiedene Verfahren waren zur Anwendung gekommen, um Wassertemperaturen zu erhalten seit dem Beginn von Temperaturaufzeichnungen Mitte des 19. Jahrhunderts: Eimer aus unterschiedlichen Materialien (Holz, Segeltuch, isoliert); in Maschinen einströmendes Kühlwasser und Bojen (fest und treibend). Zusätzlich wurde die Lufttemperatur über der Wasseroberfläche von Schiffen gemessen … eine Größe, die maritime Lufttemperatur genannt wird. Jedes Verfahren enthält ihre eigenen Messfehler, Unsicherheiten und Verzerrungen. (Für Neulinge auf diesem Gebiet: Kent et al. (2010) Effects of instrumentation changes on ocean surface temperature measured in situ. Darin findet sich eine detaillierte und leicht verständliche Übersicht. Oder Kennedy (2014) A review of uncertainty in in situ measurements and data sets of sea-surface temperature. Eine Kopie der eingereichten Studie findet sich hier).

Mit Beginn Mitte des 20. Jahrhunderts haben die Datensammler den Verzerrungen Rechnung getragen, die sich aus den unterschiedlichen Eimer-Typen ergeben sowie durch den Übergang von Eimern zu einströmendem Wasser in Schiffsmotoren. Zusätzlich wurde der Bias zwischen Schiffs- und Bojenmessungen in der Studie seit Anfang dieses Jahrhunderts diskutiert. Die im einströmenden Kühlwasser gemessenen Wassertemperaturen (ERI) sind etwas wärmer als die von Bojen gemessenen Temperaturen. Aber die Datensammler haben bis vor Kurzem nicht versucht, dem Schiffs-Bojen-Bias Rechnung zu tragen infolge der großen Unsicherheit der Messungen im einströmenden Wasser bzw. von Bojen und infolge der massiven Unsicherheiten bzgl. des Schiffs-Bojen-Bias‘. (Siehe Reynolds et al. 2002. Also see Kennedy et al. (2011) Part 1 und Part 2 als Dokumentation jener Unsicherheiten).

Für ihre neuen, den „Stillstand zerschlagenden“ Daten hat die NOAA:

● die Schiffsdaten adjustiert mittels der HadNMAT2-Daten der nächtlichen Lufttemperatur vom UKMO als Referenz. Dies setzt natürlich die Hypothese voraus, dass sich die nächtlichen maritimen Lufttemperatur-Daten mit der gleichen Rate ändern wie die Wassertemperatur (sowohl tagsüber als auch nachts),

● die Bojen-Daten adjustiert, um der Temperaturdifferenz Rechnung zu tragen zwischen in Schiffen einströmendem Wasser und Bojen in Gebieten, in denen es beides gibt. Die Auswirkungen hiervon würden über die letzten Jahrzehnte hinweg variieren, weil sich das Verhältnis von Bojen zu Schiffsmessungen mit der Zeit verändert hat. Es gab zunehmende Bojen-Messungen und abnehmende Schiffsmessungen,

● die Bojendaten stärker gewichtet als die Schiffsdaten in Perioden, in denen es sowohl Schiffs- als auch Bojendaten gibt. Dies wurde gemacht, um den unterschiedlichen Genauigkeiten der Schiffs- und Bojen-Temperaturmessungen Rechnung zu tragen … Bojendaten haben sich als genauer erwiesen als Schiffsdaten.

Karl et al. (2015) zufolge hatten die Adjustierungen der Schiffsdaten die größte Auswirkung auf die Trends von 2000 bis 2014:

Von den 11 Verbesserungen in der ERSST-Version 4 (13) hatte die Fortsetzung der Schiffs-Korrekturen die größte Auswirkung auf die Trends des Zeitraumes 2000 bis 2014. Sie machte 0,030°C der Trenddifferenz von 0,064°C zu Version 3b aus. (Die Korrektur der Bojenwerte trug 0,014°C pro Dekade zum Unterschied bei, und das zusätzliche Gewicht, das man den Bojendaten wegen deren größerer Genauigkeit zugewiesen hat, macht 0,012°C pro Dekade aus).

In diesem Beitrag werden wir die Adjustierungen des Bias‘ zwischen Schiffen und Bojen umreißen sowie die Wichtung der Daten von Bojen und dem in Schiffe einströmendem Wasser. Dies wurde schon in zahlreichen anderen Blogbeiträgen diskutiert. Wir hier wollen aus konzentrieren auf…

Die Hypothesen der NOAA bei der Verwendung von NMAT-Daten*, um schiffsbasierte Messungen der Wassertemperatur zu adjustieren

[*Wie oben erwähnt: NMAT = Night Marine Air Temperature. Ich weiß nicht, ob das ein fester Begriff ist, der etwas anderes meint als die direkte Übersetzung aussagt. Im Folgenden gehe ich aber von der direkten Übersetzung als dem aus, was gemeint ist. Anm. d. Übers.]

Die NOAA hat zahlreiche Annahmen gemacht, um die Verwendung von NMAT-Daten zur Adjustierung der schiffsbasierten Messungen der Wassertemperatur zu rechtfertigen. Sie sind gelistet in der Studie von Huang et al. (2015) mit dem Titel Extended Reconstructed Sea Surface Temperature Version 4 (ERSST.v4) – Part I: Upgrades and Intercomparisons. Dort schreiben sie auf Seite 919:

Die Bias-Adjustierung von Wassertemperaturdaten von Schiffen wurde ursprünglich von Smith und Reynolds (2002) ins Spiel gebracht, was die NMAT-Daten als Referenz involvierte. NMAT wurde gewählt, weil die Differenzen der Wassertemperatur stabiler sind als maritime Lufttemperaturen tagsüber, die eine große Bandbreite haben können infolge der solaren Aufheizung der Schiffsdecks und der Instrumente selbst. Um die Bias-Adjustierung vorzunehmen ist es jedoch notwendig anzunehmen, dass

1) die Differenzen zwischen SST und NMAT nahezu konstant sind während des klimatologischen Zeitraumes (1971 bis 2000);

2) die klimatologische Differenz zwischen SST und NMAT in anderen Zeiträumen konstant ist;

3) die NMAT-Daten einen geringeren Bias aufweisen (homogener sind) als die SST-Daten, mit denen sie verglichen werden;

4) der Mix verschiedener SST-Messmethoden (Eimer oder ERI) invariant ist über alle globalen Ozeane, und die räumliche Verteilung von Verzerrungen folgt der klimatologischen Differenz zwischen SST und NMAT in neuer Zeit (1971 bis 2000); und

5) der Bias relativ langsam und gleichmäßig mit der Zeit variiert.

Wir brauchen nur die ersten beiden NOAA-Hypothesen zu untersuchen.

NOAA fuhr dann fort mit der Beschreibung, wie sie ihre ersten beiden Hypothesen getestet hatte:

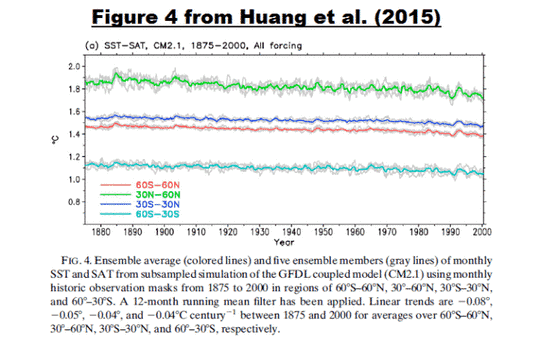

Um die ersten beiden Hypothesen zu testen, welche eine grobe physikalische Kohärenz zwischen zwei stark korrelierenden, aber physisch unterschiedlichen Messgrößen nahelegen, wurde die mittlere Differenz zwischen SST- und Lufttemperatur-Daten bei Tag und Nacht (SAT) in 2 m Höhe berechnet durch Untermengen der monatlichen Outputs der GFDL CM2.1-Modelle mit monatlichen Beobachtungs-Masken von 1875 bis 2000 (Abbildung 4). Die Modell-SAT wird herangezogen, weil der Modellbias hypothetisch tagsüber und nachts gleich ist. Es zeigt sich, dass die ersten beiden Hypothesen gültig sind, da die Modellsimulationen zeigen, dass die Differenz zwischen SAT und SST nahezu konstant ist und dessen lineare Trends in allen vier unterschiedlichen Zonen geographischer Breite schwach sind.

Huang et al. führen nicht näher aus, was sie mit „monatlichen Beobachtungs-Masken“ meinen. Meinen sie, dass die NOAA alle Gitterpunkte maskiert hat, die keine Schiffsdaten enthalten? Ich habe den Verdacht, dass genau das der Fall ist.

Wichtiger Hinweis: Im Folgenden habe ich nicht den Schritt unternommen, die Gitternetze ohne Schiffsdaten zu maskieren, weil ich versuche, die globale (ohne polare Ozeane), von den Klimamodellen erwartete Beziehung zwischen der maritimen Lufttemperatur und der Wassertemperatur zu illustrieren. (Ende Hinweis).

Komischerweise geht die NOAA davon aus, dass die modellierte Beziehung zwischen Wassertemperatur und der Lufttemperatur darüber (sowohl tagsüber als auch nachts) die gleiche ist wie die Beziehung zwischen NMAT und Wassertemperatur, wobei Letztere Tages- und Nachtwerte enthält. Das heißt, dass die NOAA nächtliche maritime Lufttemperaturen (und nicht maritime Lufttemperaturen tagsüber und nachts) heranzieht, um die Wassertemperatur zu adjustieren. Trotzdem aber präsentieren sie modellierte Wassertemperaturen und maritime Lufttemperaturen (tagsüber und nachts) als Rechtfertigung. Ist das gemeint, wenn es heißt „Die Modell-SAT wird verwendet, da der Modellbias vermutlich der Gleiche ist tagsüber und nachts“? Genau so scheint es zu sein.

Meine Abbildung 1 ist Abbildung 4 bei Huang et al. (2015)

Abbildung 1

Erstens, man beachte, dass der auf Klimamodellen basierende Graph in ihrer Abbildung 1 im Jahre 2000 endet. Das ist komisch, sind wir doch am Zeitraum 2000 bis 2014 interessiert. Zweitens, sie haben die Trends von 1875 bis 2000 gelistet in der Bildunterschrift zu Abbildung 4, aber sie haben es versäumt, den Trend zu zeigen für ihre klimatologische Periode von 1971 bis 2014 (siehe deren Hypothese 1 oben).

Drittens, und sehr wichtig: Das gekoppelte Ozean-Atmosphäre-GFDL CM2.1-Klimamodell aus dem NOAA Geophysical Fluid Dynamics Laboratory (GFDL) ist eine seltsame Wahl als Verwendung in einer Studie des Jahres 2015. Zu Beginn der GFDL-Website über das neue und verbesserte GFDL CM3 model heißt es:

Das erfolgreiche Modell von GFDL, CM2.1 (Delworth et al. 2006) wurde als Startzeitpunkt gewählt, um die nächste Generation der gekoppelten CM3-Modelle zu entwickeln.

Mit anderen Worten, das 10 Jahre alte GFDL CM2.1-Klimamodell kann man als obsolet ansehen, soweit es durch das GFDL CM3-Modell ersetzt worden ist. Das GFDL CM2.1-Modell wurde von Delworth et al. (2006) unterstützt GFDL’s CM2 Global Coupled Climate Models. Part I: Formulation and Simulation Characteristics. Im Abstract wird angegeben, dass es für den 4. IPCC-Zustandsbericht 2007 aktuell war.

Wir wissen aus Erfahrungen der Vergangenheit, dass es weite Bandbreiten geben kann bei den absoluten Werten der Temperatur von Modell zu Modell ebenso wie eine große Bandbreite von Trends. Die Verwendung eines Klimamodells einer früheren Generation seitens der NOAA könnte jeden dazu führen zu glauben, dass die NOAA genau jenes GFDL CM2.1-Modell aus früherer Generation gewählt hat (nach Art von Rosinenpickerei), weil es genau das Ergebnis lieferte, das man sich gewünscht hatte.

Schauen wir also mal auf das Multimodell-Mittel aller neuen und verbesserten Klimamodelle, die im IPCC-Bericht #5 (2013) herangezogen worden waren. Diese Modelle sind gespeichert im CMIP5 archive, und deren Multimodell-Mittel (zusammen mit den Ergebnissen der individuellen Modelle) sind verfügbar im KNMI Climate Explorer. Das Multimodell-Mittel (das Mittel aller Modelle) repräsentiert im Grunde den Konsens (das Gruppendenken) der Klimamodellierungs-Gruppen, wie die Wassertemperatur und die maritime Lufttemperatur (in diesem Beispiel) auf die Klima-Antriebe reagieren, die man als Antrieb für die Modelle verwendet hat. Infolge der großen Bandbreite der Klimamodell-Ergebnisse stellt die Verwendung des Mittelwertes aller Modelle im CMIP5-Archiv sicher, dass man uns keine Rosinenpickerei vorwerfen kann dergestalt, dass wir ein bestimmtes Modell herausgreifen, das eine Agenda unterstützt. Und wir brauchen nur die Klimamodell-Ergebnisse für die globalen Ozeane untersuchen mit Ausnahme der polaren Ozeane (60°S bis 60°N); das heißt wir brauchen nicht die zusätzlichen Unterabteilungen untersuchen, wie sie in Abbildung 4 von Huang et al. (2015) zum Ausdruck kamen (= meine Abbildung 1).

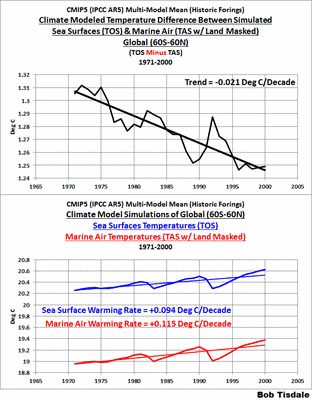

Wir beginnen mit dem Zeitraum von 1875 bis 2000, der in Abbildung 4 von Huang gezeigt wird. Die obere Graphik in Abbildung 2 zeigt die Modelldifferenz zwischen den simulierten globalen Wassertemperaturen (60°S bis 60°N) und den maritimen Lufttemperaturen während der von der NOAA gewählten Periode von 1875 bis 2000, wobei die maritime Lufttemperatur (TAS, Landoberflächen maskiert) von den Wassertemperaturen subtrahiert werden. Während dieses Zeitraumes wurden nur die historischen Klimaantriebe von den Modellierungsgruppen verwendet. Für den von der NOAA gewählten Zeitraum von 1875 bis 2000 zeigt der Konsens der jüngsten Generation die modellierte Differenz zwischen der globalen Wasser- und maritimen Lufttemperaturen, die mit einer Rate von -0,008°C pro Dekade abnimmt … also mit genau der gleichen Rate wie die -0,008°C pro Dekade, die die NOAA für den Zeitraum 1875 bis 2000 geltend macht. Auf den ersten Blick scheint dies die Ergebnisse von Huang et al. (2015) zu bestätigen. Die untere Graphik in Abbildung 2 illustriert im gleichen Zeitrahmen das Multimodell-Mittel der simulierten Wassertemperaturen und der maritimen Lufttemperaturen, die für die Grundlagen der oberen Graphik stehen. Ich habe die Modellergebnisse des Zeitraumes 2000 bis 2014 hinzugefügt (gestrichelte Kurven) in beiden Graphiken als Referenz.

Abbildung 2

Man beachte jedoch, dass sich in der oberen Graphik der Abbildung 2 eine deutliche Trendänderung zeigt, die etwa Mitte der siebziger Jahre begonnen hat und von einem nachfolgenden starken Rückgang gefolgt wurde.

Untersuchen wir also den Trend der von der NOAA herangezogenen klimatologischen Periode von 1971 bis 2010. Siehe Abbildung 3. Für diese NOAA-Periode zeigt der Konsens der jüngsten Klimamodell-Generation die modellierte Differenz zwischen der globalen Wasser- und der maritimen Lufttemperatur, die mit einer stärkeren Rate von -0,021°C pro Dekade abnimmtn … weit größer als die -0,008°C pro Dekade, die von der NOAA für den Zeitraum 1875 bis 2000 propagiert wird.

Abbildung 3

Was die untere Graphik der Abbildung 3 betrifft: die modellierte maritime Lufttemperatur steigt etwas rascher als die modellierte Wassertemperatur während des klimatologischen NOAA-Zeitraumes. Mit anderen Worten, der Konsens der neuen und verbesserten Klimamodelle widerspricht dem NOAA-Ergebnis (Huang et al.) hinsichtlich ihrer ersten Hypothese zur Verwendung maritimer Lufttemperaturen, um die Verzerrungen der mit Schiffen gemessenen Wassertemperaturen zu adjustieren … oder irgendwelche Daten der Wassertemperatur.

Aber am Zeitraum 1971 bis 2000 sind wir nun wirklich nicht interessiert. Interessanter für uns ist der Zeitraum 2000 bis 2014, weil es genau der Zeitraum war, den die NOAA (Karl et al. 2015) für die Behauptung herangezogen hatte, dass die „Fortsetzung der Schiffsdaten-Korrekturen den größte Auswirkung auf die Trends von 2000 bis 2014 hatte; verantwortlich für 0,030°C pro Jahrzehnt der 0,064°C-Trenddifferenz zu Version 3b“.

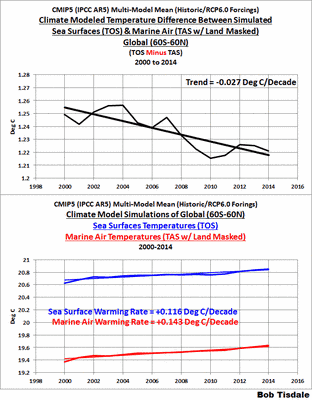

Abbildung 4 gleicht den Abbildungen 2 und 3, außer dass wir in Abbildung 4 die Modellergebnisse illustrieren für den Zeitraum 2000 bis 2014. Der einzige Unterschied ist, dass Modelle jetzt auch die projizierten Antriebe enthalten, zusätzlich zu den historischen Antrieben. Der Übergang von historischen zu projizierten Antrieben erfolgt laut den meisten Modelle 2005/2006. Es ist kein von mir ausgesuchtes Feature. Aber ich habe das RCP6.0-Antriebsszenario gewählt, weil ich mich nicht dem Vorwurf aussetzen wollte, das Worst-Case-RCP8.5-Szenario herauszupicken.

Es ist keine große Überraschung, dass das Multimodell-Mittel in der oberen Graphik der Abbildung 4 einen Rückgang der Temperaturdifferenz zeigen zwischen den Wasser- und den maritimen Lufttemperaturen. Tatsächlich ist der Trend von -0,027°C pro Dekade der modellierten Temperaturdifferenz vergleichbar mit der Adjustierung der Schiffsdaten von 0,030°C pro Dekade seitens der NOAA (die nächtliche maritime Lufttemperaturdaten verwendet hatte) für den Zeitraum 2000 bis 2014.

Abbildung 4

Das heißt, mit Verwendung der neueren Modelle ist es Konsens unter den Modellierer-Gruppen zu erwarten, dass sich maritime Luft im Zeitraum 2000 bis 2014 rascher erwärmt als die Oberflächen der Ozeane … mit einer Rate, die vergleichbar ist mit der „Korrektur“, die man mittels der nächtlichen maritimen Lufttemperatur an die Schiffsdaten angebracht hatte. Dies widerspricht der zweiten der NASA-Hypothesen, der zufolge „die klimatologische Differenz zwischen SST und NMAT in anderen Zeiträumen konstant ist“. Das ist eindeutig nicht der Fall.

Einfach gesagt, die NASA scheint eine Differenz zwischen Temperaturmessungen von Schiffen und der nächtlichen maritimen Lufttemperatur hinweg adjustiert zu haben. Diese Differenz sollte es dem Konsens der neueren Klimamodelle zufolge jedoch geben. Dies legt die Vermutung nahe, dass die andere Große Hypothese der NOAA, nämlich dass „die Modell-SAT verwendet wird, da der Modell-Bias vermutlich tagsüber und nachts gleich ist“ korrekt ist.

Stellen wir das mal in einen größeren Zusammenhang. Die NOAA scheint anzunehmen, dass sich die NMAT mit der gleichen Rate erwärmt wie die MAT sowohl tagsüber als auch nachts. Sie hat maritime Lufttemperaturen anstatt die nächtlichen maritimen Lufttemperaturen herangezogen, um ihre ersten beiden Hypothesen zu verifizieren. Man beachte auch, dass der Konsens der jüngsten Generation von Klimamodellen zeigt, dass sich die maritimen Lufttemperaturen mit einer höheren Rate erwärmen sollten als die Wassertemperaturen seit etwa Mitte der siebziger Jahre. Und doch, zieht man diese Überlegungen in Betracht, zeigt das Enderzeugnis der NOAA, also ihr neuer „Stillstands-Vernichter“, nämlich die ERSST.v4-Daten, die gegenteilige Beziehung. Ihre neuen Wassertemperatur-Daten zeigen eine merklich höhere Erwärmungsrate als die nächtlichen maritimen Lufttemperaturen (HadNMAT2), die man als Referenz herangezogen hatte. Siehe Abbildung 5, welches Abbildung 1 im Beitrag Open Letter to Tom Karl of NOAA/NCEI Regarding “Hiatus Busting” Paper ist.

Abbildung 5

Bemerkung: Diese Graphik endet im Jahre 2010, weil da die HadNMAT2-Daten aufhören. Dies wirft natürlich folgende Frage auf: Wie adjustiert die NOAA (ungerechtfertigterweise) die Schiffsdaten nach dem Jahr 2010?

Unter dem Strich: Der jüngsten Generation von Klimamodellen zufolge sollte sich die maritime Lufttemperatur schneller erwärmen als die Wassertemperaturen, aber nicht in der NOAA-Welt, an der so viel herumgedoktert wurde.

Zum Schluss

Noch einmal, meine Illustrationen zeigen die erwartete globale Beziehung zwischen maritimen Lufttemperaturen (tagsüber und nachts) und der Wassertemperaturen, weil die NOAA diese heranzieht, um eine Beziehung zu verifizieren zwischen der nächtlichen maritimen Lufttemperatur und der Wassertemperatur.

Auch habe ich die Modellergebnisse nicht maskiert, so dass sie nur das Netz mit schiffsbasierten Wassertemperaturen enthalten, wie es die NOAA getan zu haben scheint. Aber dem Konsens der im IPCC-Bericht 5 verwendeten Klimamodelle zufolge ist die Beziehung global (60°S – 60°N) dergestalt, dass sich die maritime Lufttemperatur seit Mitte der siebziger Jahre rascher erwärmt hat als die Wassertemperatur.

Ich habe folgenden Verdacht: Wenn die Whistleblower von Kongressmann Lamar Smith besorgt sind hinsichtlich des Hypes um die Studie von Karl et al. (2015) „vor einer angemessenen Begutachtung der zugrunde liegenden Wissenschaft und der angewandten neuen Verfahren“, diskutieren sie über:

● Die Unsicherheiten der Bias-Adjustierungen,

● Die Unsicherheiten in den Daten,

● natürlich über die grundlegenden Verfahren einschließlich der Art und Weise, mit der die NOAA jene Adjustierungen über die Ozeane verteilt hatte, und

● am wichtigsten bzgl. der „zugrunde liegenden Wissenschaft“: wie die NOAA eine Differenz hinweg adjustiert zu haben scheint zwischen Temperaturmessungen von Schiffen und der nächtlichen maritimen Lufttemperatur, die es dem Konsens der neuen Klimamodelle zufolge geben sollte.

Vielleicht wird Dr. Sullivan von der NOAA die von Repräsentant Smith angeforderten E-Mails noch rechtzeitig zur Verfügung stellen, so dass wir meinen Verdacht sowie den Verdacht auch vieler Anderer bestätigt sehen können.

Link: http://wattsupwiththat.com/2015/11/30/pause-buster-sst-data-has-noaa-adjusted-away-a-relationship-between-nmat-and-sst-that-the-consensus-of-cmip5-climate-models-indicate-should-exist/

Übersetzt von Chris Frey EIKE