Sonne macht Klima: Neues aus Europa

Die Wissenschaftler fanden charakteristische Zyklizitäten, darunter die bekannten solaren Eddy- (1000 Jahre), Suess-de Vries- (200 Jahre) und Gleissberg- (90 Jahre) Zyklen:

Auswirkungen des solaren Antriebs und der Nordatlantischen Oszillation auf das Klima im kontinentalen Skandinavien während des Holozäns

Sedimentablagerungen aus den Nautajärvi and Korttajärvi-Seen in Finnland, die die letzten 10.000 Jahre abdecken, zeigen Beweise für Klima- und Umweltoszillationen im Zeitbereich von vielen Jahrzehnten bis zu Jahrtausenden. Wir haben zwei unabhängige Verfahren angewendet, um periodische Erscheinungen aus diesen Zeitreihen zu extrahieren und ihre statistische Zuverlässigkeit abzuschätzen. Analysen zeigten, dass jahreszeitliche Sedimentflüsse mit Umweltveränderungen korrespondieren sowie mit statistisch signifikanten Periodizitäten von 1500 bis 1800, 1000, 600 bis 800, fast 300, fast 200, 150 bis 170, fast 90 und 47 Jahren. Sie zeigen eine variable Kohärenz mit verschiedenen klimatreibenden Faktoren und anderen Paläo-Proxyaufzeichnungen auf der Nordhemisphäre. Die Ergebnisse zeigen, dass das Winterklima im Holozän im kontinentalen Skandinavien durch eine Kombination vieler Faktoren getrieben worden ist, zumindest durch die Sonnenaktivität und von atmosphärischen Zirkulationsmustern im Bereich Nordatlantik-Europa, wobei die Einflüsse mit der Zeit variieren.

Insbesondere der 1000-Jahres-Zyklus tritt hervor. In der Discussion schreiben die Autoren:

Die Identifizierung des 1000-Jahre-Zyklus‘ zeigt, dass der solare Antrieb möglicherweise klimatische und umweltliche Fluktuationen im kontinentalen Skandinavien während des Holozäns ausgelöst hat.

Auch im Bereich der Nordsee gibt es neue Hinweise auf eine solare Klimabeeinflussung. Im Juli 2014 veröffentlichte eine Forschergruppe der Universität Mainz bestehend aus Hilmar Holland, Bernd Schöne, Constanze Lipowsky und Jan Esper im Fachblatt The Holocene eine Klimastudie auf Basis von Anwachsstreifen in Muschelschalen. Dabei deckten die Wissenschaftler die vergangenen 1000 Jahre ab. Holland und Kollegen fanden, dass das Klima immer dann besonders stark schwankte, wenn die Sonnenaktivität auf Minimalwerte absank. Dies gilt insbesondere für die solaren Maunder- und Spörer-Minima während der Kleinen Eiszeit. Hier die Kurzfassung der Arbeit:

Dekadische Klimavariabilität der Nordsee während des letzten Jahrtausends, rekonstruiert mittels bestimmter Muschelschalen auf arktischen Inseln (von der Gemeinen Islandmuschel)

Ununterbrochene und jährlich aufgelöste Aufzeichnungen des Paläoklimas sind von grundlegender Bedeutung, um die gegenwärtigen globalen Änderungen in einen Zusammenhang zu stellen. Derartige Informationen sind besonders relevant für den europäischen Bereich, wo Wetter- und Klimaprojektion immer noch eine große Herausforderung darstellen, wenn sie nicht sogar unmöglich sind. Diese Studie präsentiert die ersten genau datierten, jährlich aufgelösten und multiregionalen Chronologien aus den Schalen der Gemeinen Islandmuschel aus der Nordsee. Sie überdecken den Zeitraum 1040 bis 2010 und enthalten wichtige Informationen über supra-regionale Klimabedingungen (Wassertemperatur, ozeanische Produktivität, Wind). Das Wachstum der Muscheln variierte periodisch in Zeiträumen von 3 bis 8, 12 bis 16, 28 bis 36, 50 bis 80 und 120 bis 140 Jahren. Möglicherweise zeigt dies eine enge Verbindung mit der Nordatlantischen Oszillation, ozean-internen Zyklen im Nordatlantik, kontrolliert durch Ozean-Atmosphäre-Kopplungen sowie der Atlantischen Multidekadischen Oszillation. Zunehmende Klima-Instabilität, das heißt eine stärkere quasi-dekadische Variabilität, scheint verbunden mit dem Vorherrschen atmosphärischer Antriebe und signifikant geringeren Einstrahlungs-Phasen (d. h. Spörer- und Maunder-Minima). Eine gesteigerte klimatische Variabilität über kürzere Zeiträume wurde ebenfalls beobachtet, und zwar während besonders warmer Phasen oder Verschiebungen (z. B. während der ,Mittelalterlichen Klimaanomalie‘ [?] und seit etwa 1970). Stabilere Klimabedingungen, das heißt verlängerte Warm- oder Kaltphasen (Mittelalterliche Klimaanomalie, Kleine Eiszeit) fielen jedoch zusammen mit einem Vorherrschen multidekadischer ozeanischer Zyklen. Ob die Anzahl von Sonnenflecken und eine höhere Klimavariabilität ursächlich zusammenhängen und welche Prozesse und Abläufe dem zugrunde liegen, ist nicht Gegenstand dieser Studie.

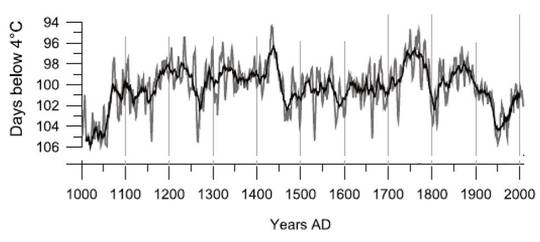

Gehen wir nun einige hundert Kilometer nach Osten, nach Polen. Ein Team um Ivan Hernández-Almeida nahm sich im Nordosten des Landes ebenfalls die Klimageschichte des letzten Jahrtausends vor. In einem Artikel, der Mitte August 2015 in den Quaternary Science Reviews erschien, berichteten die Wissenschaftler von starken natürlichen Klimaschwankungen und einer deutlichen solaren Beeinflussung. Hernández-Almeida fanden eine klare Gliederung in Mittelalterliche Wärmeperiode, Kleine Eiszeit und Moderne Wärmeperiode. Dabei fielen die Winter vor 1000 Jahren während der Mittelalterlichen Wärmeperiode sogar milder aus als heute (Abbildung 1). In den letzten 50 Jahren ist im Datensatz zudem eine Verschärfung der polnischen Winter zu erkennen. Im Folgenden die Kurzfassung der Arbeit:

Eine auf den Goldbraunen Algen basierende quantitative Rekonstruktion der Strenge von Wintern aus Tonsedimenten in Seen in Nordostpolen während des letzten Jahrtausends sowie deren Beziehung zur natürlichen Klimavariabilität

Zellen von Algen werden als starke Proxys zur Bestimmung der Temperatur in der kalten Jahreszeit angesehen. In dieser Studie betrachten wir die Beziehung zwischen Algen-Ansammlungen und der Anzahl von Tagen mit einer Temperatur unter 4°C (DB4°C) im Epilimnion* eines Sees in Nordpolen, um eine Transfer-Funktion zu entwickeln und die Strenge der Winter in Polen für das letzte Jahrtausend zu rekonstruieren. DB4°C ist eine Klimavariable abhängig von der Länge des Winters. Bestimmte Verfahren [Multivariate ordination techniques]wurden angewendet, um die Verteilung von Algen in Sedimenten von 37 Flachlandseen zu studieren, verteilt entlang einer Vielzahl umweltlicher und klimatischer Gradienten in Nordpolen. Von allen gemessenen Umweltvariablen, stufenweiser Auswahl der Variablen und individuellen Freisetzungs-Analysen (RDA) ergab die Variable DB4°C als die wichtigste Variable für Algen … . Eine quantitative Transferfunktion wurde erzeugt, um DB4°C aus Sedimentablagerungen zu schätzen mittels der partiellen Regression kleinster Quadrate. Das Zwei-Komponenten-Modell (PLS-2)enthielt einen Koeffizienten der Bestimmung von Rcross = 0,58 mit der Wurzel aus dem mittleren quadratischen Fehler der Vorhersage (RMSEP) von 3,41 Tagen (auf der Grundlage von ,einen auslassen‘). [?] Die sich daraus ergebende Transfer-Funktion wurde angewendet auf einen jährlich unterteilten Sediment-Bohrkern aus dem Lake Żabińskie. Er erlaubte eine neue, sub-dekadische Rekonstruktion von DB4°C mit hoher chronologischer Genauigkeit für den Zeitraum vom Jahr 1000 bis 2010. Während des Mittelalters (Jahre 1180 bis 1440) waren die Winter allgemein kürzer (wärmer) außer während einer Dekade mit sehr langen und kalten Wintern um das Jahrzehnt von 1260 bis 1270 (im Anschluss an den Vulkanausbruch im Jahre 1258). Im 16. und 17 Jahrhundert sowie zu Beginn des 19. Jahrhunderts war es zu sehr langen und strengen Wintern gekommen. Der Vergleich mit anderen Rekonstruktionen der kalten Jahreszeit in Europa sowie atmosphärische Indizes hier zeigen, dass ein großer Teil der Winter-Variabilität (rekonstruierte DB4°C) dem Wechselspiel geschuldet ist zwischen den Oszillationen der zonalen Strömungen, die von der North Atlantic Oscillation (NAO) gesteuert werden, sowie dem Einfluss kontinentaler Antizyklonen (Sibirisches Hoch, Bedingungen Ostatlantik/Westrussland). Unterschiede zu anderen europäischen Aufzeichnungen werden geographischen klimatologischen Unterschieden zugeordnet zwischen Polen und Westeuropa (tief liegende Länder; Alpen). Der erstaunliche Gleichlauf zwischen der Kombination vulkanischer und solarer Antriebe sowie die DB4°C-Rekonstruktion vor dem 20. Jahrhundert zeigen, dass das Winterklima in Polen hauptsächlich auf eine natürlich angetriebene Variabilität reagiert (vulkanisch und solar). Der Einfluss von Variabilität ohne Antrieb ist gering.

[*Das Wort habe ich noch nie gehört. Bei WIKIPEDIA steht erläutert, was das ist: Das Epilimnion (Epilimnial) nennt man in der physikalischen Limnologie die obere erwärmte und stark bewegte Wasserschicht in einem geschichteten stehenden Gewässer. Das Epilimnion ist durch die Sprungschicht, das Metalimnion, von der unteren Wasserschicht, dem Hypolimnion getrennt. Quelle und Weiteres. Anm. d. Übers.]

Abbildung 1: Schwankungen in der Härte der polnischen Winter während der letzten 1000 Jahre. Aufgetragen ist die Anzahl der Tage mit Temperaturen unter 4°C. Ausschlag nach unten zeigte strenge Winter, Ausschlag nach oben milde Winter an. Aus: Hernández-Almeida et al. 2015.

Auf unserem europäischen Streifzug durch die aktuelle Literatur zur Klimawirkung der Sonne geht es jetzt an den Südwestzipfel des Kontinents. In Portugal untersuchte eine Forschergruppe um Santos et al. die Temperaturgeschichte der letzten 400 Jahre. Zum Wissenschaftlerteam gehört unter anderem auch Eduardo Zorita vom Helmholtz-Zentrum in Geesthacht. Im Fachblatt Climate of the Past berichten Santos und Kollegen über klare klimatische Auswirkungen der solaren Maunder und Dalton Minima auf das Temperaturgeschehen:

Neue Erkenntnisse aus der rekonstruierten Temperatur in Portugal während der letzten 400 Jahre

Die Konsistenz einer bestehenden rekonstruierten jährlichen Temperaturreihe (Dezember bis November) für das Gebiet um Lissabon ab dem Jahr 1600 basiert auf einer europaweiten Rekonstruktion, erzeugt aus: 1) fünf lokalen Tiefenprofilen der Temperatur aus Bohrlöchern, 2) synthetische Temperatur-Tiefenprofile, erzeugt sowohl aus rekonstruierten Temperaturen als auch zwei regionalen Paläoklima-Simulationen in Portugal, 3) instrumentellen Datenquellen im 20. Jahrhundert und 4) Temperaturindizes aus dokumentarischen Quellen zum Ende des Maunder-Minimums (1675 bis 1715). Die geringe Variabilität der rekonstruierten Temperatur in Portugal ist nicht ganz konsistent mit lokalen Tiefen-Temperaturprofilen aus Bohrlöchern und mit der simulierten Reaktion der Temperatur in zwei regionalen Paläoklima-Rekonstruktionen, getrieben durch Rekonstruktionen verschiedener Klimatreiber. … Weitere Kalibrierungen zeigen die klaren Fußabdrücke des Maunder- und des Dalton-Minimums, die allgemein mit Änderungen der Sonnenaktivität in Verbindung gebracht werden sowie mit explosiven Vulkanausbrüchen. …

Schließlich sei noch auf einen Artikel aus Österreich von Auer und Kollegen hingewiesen, der im Februar 2015 in Climate of the Past erschien. Die Forscher untersuchten eine 17 Millionen Jahre alte Sedimentabfolge in den Alpen. Dabei stießen sie im Rahmen einer hochauflösenden paläoklimatischen Untersuchung auf eine stark ausgeprägte natürliche Klimavariabilität und charakteristische solare Zyklen des Gleissberg und Suess-de Vries Typs. Auer und Kollegen schlussfolgern, dass das Klima des Miozäns maßgeblich durch solare Aktivitätsschwankungen gesteuert wurde. Im Folgenden die Kurzfassung der Studie:

Zwei ausgeprägte dekadische und jahrhundertliche Zyklizitäten trieben die Intensität maritimer Auftriebe von Tiefenwasser sowie den Niederschlag zum Ende des Frühen Miozäns in Mitteleuropa.

Innerhalb einer 5,5 Meter dicken Aufeinanderfolge von Sedimenten aus den Karpaten im nordalpinen Voralpenland (NAFB; Österreich), datiert zur CNP-Zone NN4, wurde kontinuierlich ein hoch aufgelöster Bereich aufgezeichnet. Einhundert Testmengen wurden mit einer Auflösung von etwa 10 mm (= etwa 17 Jahre) pro Schicht gezogen und analysiert mittels eines integrierten Multiproxy-Verfahrens. Frühere Analysen der Geochemie und Kalkablagerungen deuten auf kleinräumige, kurzzeitige Variationen der Umweltbedingungen in Paläo-Zeiten wie etwa Schichtenbildung in Wassersäulen, primäre Produktivität, Flüsse organischen Materials, Sauerstoffanreicherung tieferer Wasserschichten, Süßwasser-Zufluss und Änderungen des relativen Meeresspiegels. Die Ergebnisse zeigen eine hochdynamische dünne maritime Schicht, die Gegenstand häufiger Umweltänderungen im Zeitmaßstab von Jahrzehnten und Jahrhunderten war. Zeitreihen-Analysen von neun verschiedenen Proxy-Datensätzen wurden einer REDFIT-Analyse unterzogen, um eine möglicherweise zyklische Natur dieser Variationen zu erkennen. Die Analysen zeigten, dass unterschiedliche Proxys für Niederschlag, Intensität von Tiefenwasser-Aufwallung und Gesamt-Produktivität wahrscheinlich von unterschiedlichen Zyklizitäten getrieben werden. Eine Best-Fit-Adjustierung der wahrscheinlichen Sedimentations-Raten innerhalb des hoch aufgelösten Bereiches führte zu Periodizitäten, die gut zum niedrigeren (ca. 65 Jahre) und höheren (ca. 113 Jahre) Gleissberg-Zyklus ebenso wie zum Suess/deVries-Zyklus (ca. 211 Jahre) passen. Der Abschnitt überdeckt einen Zeitraum von etwa 1190 Jahren auf der Grundlage der Korrelation mit solaren Zyklen, was zu einer geschätzten Sedimentationsrate von 575 mm pro 1000 Jahre führte. Zum ersten Mal sind kurzfristige Klima-Variabilitäten im dekadischen bis jahrhundertlichen Zeitmaßstab aufgelöst in dünnen maritimen Sedimenten. Die Ergebnisse deuten auf eine enge Relation zwischen Klima-Variabilität und solarem Antrieb während der Zeit des Late Burdigalian. Außerdem, wenn man akzeptiert, dass diese Zyklizitäten wirklich solaren Ursprungs sind, würde dies zeigen, dass der Niederschlag von den beiden Gleissberg-Zyklen getrieben wurde, während das Aufwallen vom Suess-Zyklus getrieben wurde. Außerdem wurden Proxys der primären Produktivität durch beide Zyklen beeinflusst.

Beitrag zuerst erschienen bei der „Kalten Sonne“ hier. Übersetzung der englischen Passagen von Chris Frey EIKE

Anmerkung EIKE Redaktion: Die kalte Sonne hatte bereits am 20.August 2015 (hier) die EIKE-News vom 12.August 2015 (hier) über eine Publikation von Lüdecke, Weiss, Hempelmann abgedruckt. Diese Arbeit erschien in der Fachzeitschrift "Climate of the Past Discussion" der Europäischen Geophysikalischen Union (egu) (hier). In ihr wurde der Klimaeinfluss des De Vries /Suess Sonnenzyklus untersucht. Diese Arbeit ist in der obigen Zusammenfassung der neuesten Publikationen zum Klimaeinfluss der Sonne leider nicht mit aufgeführt.