"Klima“ und Wetter

und Wetter

Alle Welt spricht vom „Klima“, meistens unheilverkündend und drohend. Kaum sind die Katastrophen-Meldungen der letzten „Klima“-Konferenz im Unterbewusstsein des strapazierten Publikums versickert, werden die Katastrophentrommeln zur Einstimmung auf die nächste „Klima"-Konferenz geschlagen.

Bundeskanzlerin und Vizekanzler, beide ehemals Bundes-Umweltminister, sprechen oft und gerne über „Klima“. „Die Grünen“ ohnehin; der angeblich bedrohliche „Klima“-Wandel ist nach dem Atomausstieg das einzig verbliebene Thema ihrer auf Angst und schlechtem Gewissen gegründeten und auf Bevormundung wie Drangsalierung ausgerichteten Politik. Welcher Politiker wollte es sich mit „Die Grünen“ verscherzen? Die nächsten Wahlen kommen bestimmt. Potentielle Koalitionspartner dürfen nicht vergrault werden. Diese Verbeugung vor den „Grünen“ ist weltweit zu beobachten. Als deutliches Beispiel sei das jüngst in Frankreich verabschiedete Gesetz zur „Energetischen Transition“ genannt.

Doch wichtiger als solches Parteienkalkül ist die parteiübergreifende Einigkeit: Die fossilen Energieträger müssen zurückgedrängt werden. Mögen die Gründe für diese wirtschafts-, energie- und umweltpolitische Maxime von Lager zu Lager sehr unterschiedlich sein, in einem Punkt herrscht Einigkeit: Mit „Klima“ lässt sich einzigartig argumentieren, um der Verbrennung von Erdöl, Erdgasund vor allem von Kohle gewaltiges Katastrophenpotential anzuhängen. Denn wer wollte einem politischen Programm widersprechen, nach dem der ansonsten drohende Weltuntergang abgewendet werden soll. Und warum sollte es illegitim sein, einem richtigen und für überaus wichtig erachteten Ziel eine zweifelhafte oder falscheBegründung zu geben? Also ziehen alle die „Klima-Karte“. Das Ziel heiligt die Mittel! Die Drohformel lautet :

. Verbrennung setzt CO2 frei

. CO2 ist Treibhausgas

. Treibhausgas erzeugt „Klima“-Erwärmung

. „Klima“-Erwärmung verursacht weltweit Katastrophen.

Wie sollten Medien und Öffentlichkeit bei dieser Konstellation schweigen? Im Gegenteil: „Klima“ ist intensivst beackertes Lieblingsthema. Im „Klima“-Theater gibt es täglich neue Vorstellungen. Der Schuft ist stets und überall das „Treibhausgas“, der „Klimakiller“, sprich: das CO2.

Und wo bleibt der mündige Bürger? Muss er sich fraglos, ohnmächtig von dem gewaltigen Strom an Daten, Interpretationen, Meinungen und Warnungen zum „Klima“-Wandel in die schier grundlose See von Angst und Bedrohung reißen lassen? Oder gibt es abseits aller Spekulationen, Prognosen und Prophezeiungen doch noch einen Platz der Tatsachen, an dem er mit Vernunft – und nur mit Vernunft – fest und sicher ankern kann?

„Klima“ ist ein vager Begriff. Gleichgültig ob wir vom Wetter-“Klima“, Konsum-“Klima“, Verhandlungs-“Klima“, Raum-“Klima“ sprechen, stets geht es um Erahntes, Erspürtes, Imaginiertes, Interpretierbares und Interpretationsbedürftiges. Nie geht es um einen eindeutigen Sachverhalt, um eine exakt nachprüfbare Tatsache.

Die Weltorganisation für Meteorologie (WMO) definiert „Klima“ als den mindestens dreißigjährigen Durchschnitt von „Wetter“. Folglich ist „Klima“-Wissenschaft die Wissenschaft vom mindestens dreißigjährigen Durchschnitt des Wetters und der Wetterfolgen.

„Klima“ ist definitionsgemäß ein auf dem Wege der Durchschnitts- und Trendberechnung erzeugtes theoretisches Konstrukt. Wie alle Durchschnitte aus sehr vielen Einzelgrößen ändert sich auch „Klima“, wenn überhaupt, niemals rasch oder gar dramatisch. „Klima“ ist äußerst träge. Wer von dramatischem „Klima“-Wandel“ spricht, hat nichts verstanden. Eher zeigt ein Elefant hohe Sprünge, als dass sich das „Klima“ dramatisch ändert.

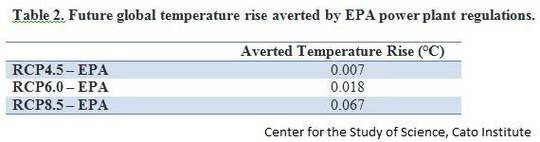

Nehmen wir zum Beispiel das für „Klima“-Wissenschaft winzig anmutende Gebiet der Kölner Bucht. Fragen wir ausschließlich nach ihrem durch Temperatur beschriebenen „Klima“. Allein für diese Antwort benötigen wir mindestens 5.256.000 tatsächlich gemessene Werte, nämlich die für mindestens zwanzig Standorte, über mindestens dreißig Jahre, stündlich tatsächlich gemessene Lufttemperatur. Dennoch hätten wir nur eine äußerst magere Teilantwort. Wir wüssten nichts über die Sonnenscheindauer, die Niederschläge, die Windverhältnisse und die Art und Häufigkeit von Extrem-Wetterlagen.

Wir wüssten erst recht nichts zur „Klima-Entwicklung“. Dazu wären die entsprechenden meteorologischen Daten mindestens weiterer dreißig Jahre erforderlich – sowie auf Durchschnitts-Rechnung bestens programmierte Computer.

Praktisch ist immer nur das Wetter. „Klima“ kommt lange, lange nach Wetter. Ohne Wetter gäbe es kein „Klima“. Aber umgekehrt wird es immer Wetter geben, völlig unabhängig davon, ob eine Unmenge von Wetterdaten zu „Klima“ kondensiert wird, oder ob der „Durchschnittswolf“ ungedreht bleibt.

Wetter findet statt. Wetter ist aktuell. Wetter kann sein: schön, gut, schlecht, furchtbar, heiß, warm, kalt, eisig, regnerisch, trocken, windstill, windig, stürmisch, orkanartig usw.. Wetterwechsel können allmählich, rasch, dramatisch sein.

„Klima“ hat keine Folgen. Aber jedes Wetter hat seine eigenen Folgen für Mensch und Natur. Je extremer das Wetter ist, desto extremer sind die Folgen. Auf gefährliche, zerstörerische Wetterereignisse, Wetterlagen kann man versuchen, sich nach besten Kräften vorzubereiten. Wetterschäden kann man so weit wie möglich beseitigen.

An diese Banalitäten gilt es nach Jahren des „Klima“-Wahns und nach Jahren einer an Vagheit kaum zu überbietenden „Klima“-Wandel-Debatte zu erinnern. So wie man weder die „Durchschnittsmutter“ noch ihre „durchschnittlich“ 1,38 Kinder jemals treffen wird, wird man niemals „Klima“ beobachten oder erleben können. Beobachtet und erlebt wird immer das Wetter.

Aber ist den mit „Klima“ Argumentierenden überhaupt an exakter Beobachtung und rationaler Argumentation gelegen? Wollen sie überhaupt vor dem morgen drohenden Unwetter schützen oder die Schäden des gestrigen Unwetters beseitigen? Ist „Klima“ nicht gerade deshalb so beliebt, weil sich auf dem Boden von definitorischer Vagheit und oft weit über die eigene Lebenserwartung hinausreichender Langfristigkeit so herrlich unkontrollierbar und ungestraft spekulieren, warnen und Untergang prophezeien lässt? Liefert „Klimaforschung“ nicht genau das, was sich seit Jahrtausenden als Herrschafts- und Zuchtinstrument bestens bewährt hat:

Katastrophendrohung gepaart mit Heilsversprechen bei Wohlverhalten.

"Klima-Forschung“

Im letzten Drittel des vorigen Jahrhunderts begann ein bis dahin am Rande existierendes Arbeitsgebiet an Universitäten und außeruniversitären Forschungseinrichtungen mit einer gewaltigen „Landnahme“ bei etablierten Wissenschaften. Das neue Arbeitsgebiet nannte sich „Klima-Forschung“ oder „Klima-Wissenschaft“. Die dienstbar gemachten altehrwürdigen Wissenschaften sind Meteorologie, Ozeanographie, Polarforschung sowie als „Hilfswissenschaften“ Physik, Chemie, Biologie und Mathematik.

Die „Klima-Forschung“ hat einen für „Wissenschaft“ im tradierten Sinne tödlichen Entwicklungsfehler: „Klima-Forschung“ wurde in starken Fesseln der Politik groß gezogen.

Von frühen Tagen an gilt als Finanzierungs-Voraussetzung, dass das „Klima“ erkrankt sei. Das Papier der Bewilligungsbescheide für die gewaltig aufwachsenden Zuwendungen an „Klima-Forscher“ und „Klima-Modellierer“ trug wie ein Wasserzeichen die Prämisse, dass sich das „Klima“ gefahrbringend entwickele, dass für den gesamten Erdball eine riesige Gefahr unübersehbar schrecklicher „Klima“-Folgen bestehe.

Das „Klima“-Katastrophenpotential – eigentlich gemeint sind Wetterfolgen – gab und gibt der Politik den entscheidenden Finanzierungsimpuls. Und die „Klima-Wissenschaft“ setzte und setzt alles daran, dass dieser Katastrophen-Ast, auf dem sie bestens sitzt, wächst und weiter wachsen wird.

Verursacher der „Klima-Misere“ sei der Mensch. Die „Klima-Erkrankung“ sei menschengemacht, also anthropogen. Diese Prämisse des anthropogenen „Klima-Wandels“ ist zu verstehen als Ausdruck eines kollektiven schlechten Gewissens, mindestens als kollektiver Kater nach Jahrzehnten einer rasanten Industrialisierungsparty, auf der die fossilen Primärenergieträger Erdgas, Erdöl und Kohle die Rolle des Champagners inne hatten. Eine rasch an Bedeutung gewinnende Stimmung fragte mit unüberhörbarem Zweifel: „Darf es so weiter gehen?“ Und die „Klima-Wissenschaft“ antwortete so erwartungsgemäß wie eindringlich: „So darf es nicht weiter gehen!“

Mit der Katastrophen-Prämisse eng verbunden ist die Therapie-Prämisse. Da die „Klima-Erkrankung“ die Folge übermäßiger menschenverursachter CO2-Emissionen sei, gelte es zur „Klima-Rettung“ Vorschläge auszuarbeiten, wie die anthropogene CO2-Emission minimiert werden könne. Auch dieser Instrumentalisierung durch die Politik hat die „Klima-Forschung“ stets engagiert entsprochen.

Neben die aus Geistesgeschichte und Philosophie gespeiste, an den Einzelnen gerichtete anthropotechnische Forderung:

„Du musst Dein Dein Leben ändern“ (vgl. P. Sloterdijk) trat die industrie- und energiepolitische Kollektivforderung: „Wir müssen das Weltklima retten“.

Diese Kollektivforderung trägt unübersehbar religionsähnliche oder religionsersetztende Merkmale wie „unbedingter Wahrheitsanspruch“, „Endzeit-Prophetie“, „Heilsversprechen“, „Fanatismus“, „Intoleranz“.

Die zur Rettung des Weltklimas über eine Minderung der anthropogenen CO2-Emissionen im Einzelnen vorgelegten „wissenschaftlichen“ Anregungen, Vorschläge und Forderungen wurden rasch unübersehbar. Darum riefen bereits 1988 die Vereinten Nationen und die Weltorganisation für Meteorologie eine zwischenstaatliche Organisation (IPCC) ins Leben mit der Aufgabe, Ordnung, Übersicht und politische Bewertung in die wissenschaftlichen „Klima-Befunde“ zu bringen.

Auftragsgemäß hat das IPCC bisher fünf Sachstandsberichte sowie mehr als zehn Sonderberichte vorgelegt.

Die Sachstandsberichte sind jeweils zweigeteilt in einen kompakten politischen Teil sowie einen äußerst umfangreichen Materialteil. Der Materialteil enthält die Originaltexte zu den Ergebnissen aktueller „klima-wissenschaftlicher“ Forschungsarbeiten.

Die Kurzfassung ist als politisch orientierte Lese- und Interpretationshilfe zum Materialteil gedacht. Sie richtet sich an die Entscheider in den das IPCC tragenden Ländern. Sie wird von politisch ausgewählten Autoren verantwortet. die von den Regierungen dieser Länder benannt werden. Diese Regierungsvertreter „aller Herren Länder“ verhandeln in langwierigen Konferenzen und unüberschaubaren Abstimmungsprozeduren den Zustand wie die voraussichtliche Entwicklung des weltweiten „Klima“. Die politische Kurzfassung ist daher das Ergebnis von politischen und wirtschaftlichen Interessen, Opportunitäten, Machtverhältnissen, Mehrheitsvoten, Argumentationsgeschick und ähnlich sachfremden Kriterien.

So verständlich der politische Wunsch nach kurzfassender Auswertung und prägnanter Schlussfolgerung sein mag, so inakzeptabel ist der gewählte Weg. Die – politisch ausgewählten – Redakteure der IPCC-Kurzfassungen agieren wie ein „klimawissenschaftliches Zentralkomitee“ oder wie ein „klimawissenschaftlicher Vatikan“ mit weltweit exklusivem Exegese- und Vorschlagsrecht.

Jedoch sind Zustand und voraussichtliche Entwicklung des „Klima“ keine politische sondern sie sind ausschließlich eine (natur-)wissenschaftliche Frage. „Klima-Forschung“, so sie diesen Namen verdient, ist reinste Naturwissenschaft. Eine wissenschaftliche Frage kann nicht und darf nicht nach Mehrheits- und Machtverhältnissen beantwortet werden.

Man stelle sich einmal vor, die Auswertung und Zusammenfassung der ungeheuren Experimental-Daten-Mengen der CERN-Wissenschaftler am weltgrößten Teilchenbeschleuniger in Genf würden einem von den CERN-Trägerstaaten politisch ausgewählten Redaktionskomitee übertragen. Ein gewaltiger Aufschrei wäre die Folge.

Eine Frage an die Wissenschaft muss ausschließlich „wissenschaftlich“, also durch beleg- und nachprüfbare Forschungsarbeit beantwortet werden. Und auch die Antwort muss „wissenschaftlich“ bewertet werden. So lange dieser rein innerwissenschaftliche Prozess nicht zu eindeutig beleg- und nachprüfbaren Ergebnissen geführt hat, ist die Antwort offen.

„Klima-Wahrheit“

Also lautet die Kernfrage: Welche „Klima-Wahrheit“ liegt vor?

Die Antwort ist so einfach wie ernüchternd :

1. Bei der im Zentrum stehenden Frage nach „Klimawandel“ handelt es sich überhaupt nicht um eine „Klima-Frage“. Es gibt kein umfassendes „Welt-Klima“. Es gibt auf der Welt nur einzelne Klimazonen, von arktisch über gemäßigt, subtropisch bis tropisch.

Die Frage nach dem globalen „Klimawandel“ ist nicht mehr und nicht weniger als die Frage nach der Entwicklung der Erdwärme. Sie wird bestimmt als die sowohl für Jahreszeiträume als auch über weltweit verteilte Messpunkte gemittelte Durchschnittstemperatur der boden- bzw. wassernahen Luft.

„Welt-Klima“ muss zutreffend heißen „Erdwärme“.

Die Probleme der Messung und rechnerischen Verarbeitung der Messergebnisse zu einer einzigen Erdwärme eines bestimmten Jahres sind gigantisch. Umso erfreulicher ist es, dass nach Jahren heftiger Debatten und Auseinandersetzungen in der Fachwelt nun weitgehend Einvernehmen herrscht:

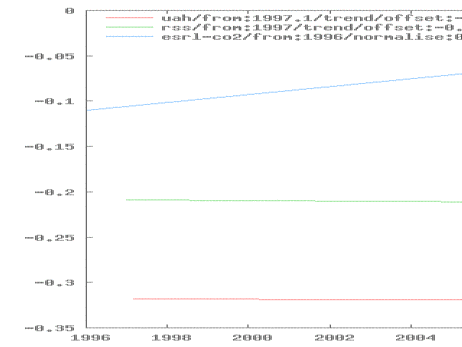

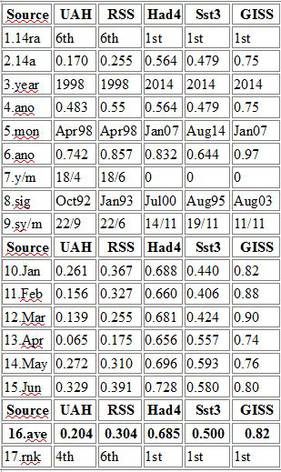

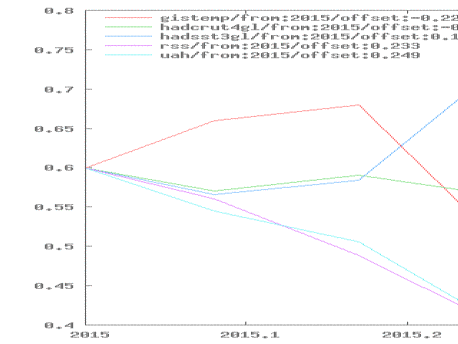

Während der letzten rd. 130 Jahre zwischen dem Ende des Neunzehnten Jahrhunderts und dem Anfang des Einundzwanzigsten Jahrhunderts ist es auf der Erde im Trend um knapp ein Grad Celsius wärmer geworden. Die trendmäßige Erwärmung beträgt demnach weniger als 0,01 Grad Celsius pro Jahr. Für die letzten 16 Jahre von 1998 bis 2014 wurde keine trendmäßige Erwärmung mehr gemessen.

2. Ebenfalls während der genannten letzten 130 Jahre ist der CO2-Gehalt der Luft von etwa 0,03 Vol.-Prozent auf etwa 0,04 Vol.-Prozent angestiegen. Im Gegensatz zur Erderwärmung ist dieser Trend ungebrochen und wird mit Sicherheit auch in den kommenden Jahren anhalten.

3. CO2 und einige andere Spurengase absorbieren einen Teil der Wärmestrahlung (Infrarotstrahlung), während kurzwelligere Strahlung, und derart ist der größte Teil der Sonnenstrahlung, passieren kann. Insbesondere aus der Infrarot-Strahlung der Erde wird ein Teil durch diese Spurengase absorbiert und davon wiederum nur die Hälfte zur Erde zurück gestrahlt. Diese Eigenschaft macht CO2 und einige andere Spurengase zu so genannten Treibhausgasen.

Da jedoch die CO2-Absorptionsbanden bereits weitgehend gesättigt sind, nimmt der Treibhauseffekt durch zusätzliches CO2 nur noch mit dem Logarithmus der CO2 -Konzentration zu: Für eine in Grad Celsius konstante Erwärmungswirkung bedarf es jeweils einer Verdoppelung des CO2-Gehaltes der Luft.

Anders ausgedrückt: Zusätzlich in die Luft gelangende und dort verbleibende CO2-Moleküle haben von Molekül zu Molekül eine rapide abnehmende Treibhauswirkung. Diese "Sättigung der Strahlungs-Banden" ist physikalisch unbestritten.

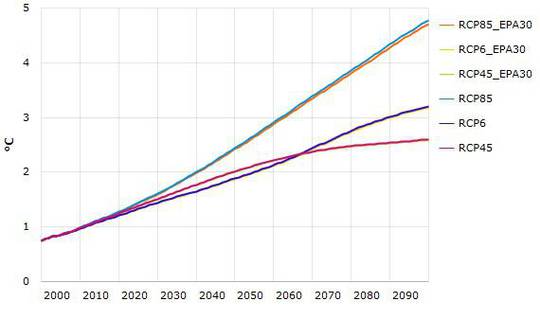

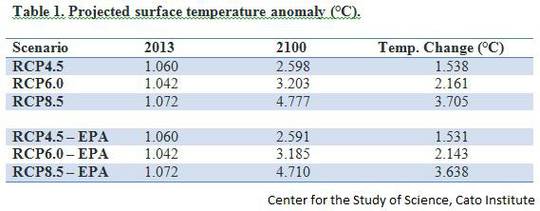

Entsprechend ergibt sich von den Klimamodellen berechnete enorme Erderwärmung von 2 bis 5 Grad Celsius für die nächsten 100 Jahre gar nicht aus einer prognostizierten CO2-Zunahme. Vielmehr wurden und werden in die Modelle ausschließlich hypothetische, durch keinerlei tatsächliche Beobachtungen gestützte „Sekundäre Verstärkungs-Prozesse“ eingebaut. Vor allem wird postuliert, dass die bisherige Erderwärmung um knapp ein Grad Celsius während der letzten über einhundert Jahre zu einer höheren Luftfeuchtigkeit (zusätzlichen Wasserdampf in der Luft) führt. Da Wasserdampf das wichtigste Treibhausgas ist, soll dieser zusätzliche Wasserdampf in der Modell-Theorie zu weiterer Erwärmung führen.

Im Gegensatz zu dieser Theorie zeigen die tatsächlichen meteorologischen Messungen der vergangenen Jahrzehnte keine Zunahme des Wasserdampf-Gehaltes der Atmosphäre, und sie zeigen auch keine zusätzliche Erwärmung.

„CO2-Freispruch“

Man mag es nicht glauben, aber es ist richtig: Weitere Wahrheiten gibt es nicht.

Einzig auf diesen drei völlig unspektakulären Tatsachen wurde weltweit ein gigantisch-monströses „Klima-Politik“-Gebilde errichtet. Im Zentrum steht das anthropogene CO2, ein Gas, das für den Menschen ungiftig und für das Pflanzenwachstum unerlässlich ist (Photosynthese) und das etwa 0,04 Prozent des Luftvolumens ausmacht (in 10 Litern Luft befindet sich ein Schnapsgläschen CO2).

Dem CO2 wird ohne wissenschaftlichen Grund die Rolle des „Klima-Killers“ zugewiesen.

Sämtliche Politik, soweit sie von „Klima-Rettung durch Verminderung menschenverursachter CO2-Emissionen“ bestimmt wird, folgt einem CO2-Trugbild, einem CO2-Wahn:

1. Die tatsächlich beobachtete Erderwärmung ist mit etwa einem Grad Celsius über mehr als einhundert Jahre derart unspektakulär, dass sie für einen Treibhaus-Effekt keinen Platz lässt.

2. Trotz unverändert stetiger Zunahme des CO2-Gehaltes der Atmosphäre gibt es seit nunmehr 16 Jahren keinen Erwärmungstrend. Auch wenn es zu früh ist, diese „Erwärmungspause“ sicher zu verstehen und einzuordnen, bietet sie ausreichend Grund zur Besinnung und Entdramatisierung im weltweiten „CO2-Drama“.

3. Von Jahr zu Jahr zeigt sich deutlicher, dass die milliardenschweren Klimamodelle versagt haben. Für die inzwischen nachprüfbaren Jahre prognostizierten sie sämtlich eine viel zu hohe Erderwärmung. Der wichtigste Grund für die Fehlprognosen ist die systematische Überschätzung der Bedeutung des (anthropogenen) CO2 für die Erdwärme.

Damit ist das anthropogene CO2 „freigesprochen“.

Das anthropogene CO2 ist für Erdwärme und Erderwärmung nicht relevant. Dieser „CO2-Freispruch“ ist zentral und unabdingbar. Was immer zu „Erderwärmung“, „Klima“ und „Klimafolgen“ festgestellt und gefolgert werden kann, muss nach dem „CO2-Freispruch“ stehen. Ob und welche Folgen die unspektakuläre und zur Zeit pausierende Erderwärmung von etwa einem Grad Celsius über mehr als einhundert Jahre auch gehabt haben mag: Das anthropogene CO2 ist „aus dem Spiel“.

„Klima-Politik“

Entgegen aller Behauptungen, Warnungen und Verängstigungen zeitigt der leichte Anstieg der durchschnittlichen Erdtemperatur von knapp einem Grad Celsius über einen Zeitraum von mehr als einhundert Jahren keinerlei besorgniserregende Begleiterscheinungen oder Folgewirkungen:

Extreme Wetterereignisse wie Stürme, Orkane, extreme Niederschlagsmengen, Perioden extremer Dürre, dramatische Hitze- oder Kälteperioden sind weltweit nach Anzahl und Ausmaß nicht vermehrt aufgetreten. Extremwetter-Ereignisse gehören unabwendbar zur meteorologischen Erdgeschichte. Ihr Auftreten ist das Ergebnis hochkomplexer, zufallsbestimmter (stochastischer) Wetterprozesse.

Obwohl also die weltweiten Wetterbeobachtungen für die jüngere und jüngste Vergangenheit keine trendmäßige Veränderung extremer Wetterereignisse verzeichneten, haben die durch diese Wetterkatastrophen verursachten Schäden (Tote, Verletzte, Ernteausfälle, Sachschäden) zugenommen. Der Grund liegt im Bevölkerungs- und Besiedelungswachstum. Ein Orkan über einem unbesiedelten Landstrich richtet geringere Schäden an als ein Orkan über einem dicht besiedelten Landesteil. Darauf weisen nachdrücklich auch die Rückversicherer hin.

In der nun seit Jahrzehnten geführten „Klima-Debatte“ ging es scheuklappenartig stets nur um „Klima“ und „Klimakatastrophen“. So wurde eine kollektive Angstneurose gezüchtet. Extreme Wetterereignisse, die früher als „normal“, als „zu den natürlichen Launen des Wetters“ gehörend hingenommen, oft auch erlitten wurden, spielen heute immer häufiger die Rolle von Vorboten der rasch nahenden ganz großen „Klimakatastrophe“. So wusste z. B. das ZDF im Juli 2015 zunächst aus fragwürdiger Datenquelle zu berichten, dass erste Halbjahr 2015 sei weltweit das heißeste aller (Aufzeichnungs-) Zeiten gewesen. Nur Tage später wurde die Gefahr einer neuen Eiszeit propagiert, da der Golfstrom -“natürlich“ verursacht durch den „Klimawandel“- versiegen könne.

Die Katastrophenverstiegenheit findet ihren – je nach Geschmack erheiternden oder bedrückenden – Ausdruck auch im jüngsten „Monitoringbericht 2015“ des Umwelt-Bundesamtes. Dort wird tatsächlich „Klima Angst“, benannt als „psychische Betroffenheit von der ständigen Androhung von Stürmen und Hochwassern“, als zu therapierende Folge des „Klima-Wandels“ aufgeführt. „Die ich rief die Geister, werd‘ ich nun nicht wieder los!“

Es gibt keine Beschleunigung des seit über einhundert Jahren beobachteten moderaten Anstiegs der Weltmeere. Die Meldungen zu einem in jüngster Zeit angeblich beschleunigten Meeres-Spiegel-Anstieg werden von den tatsächlichen Messungen nicht bestätigt. Weltweit zeigen weder die Pegel-Daten noch die Satelliten-Daten eine Beschleunigung des Meeres-Spiegel-Anstieges. Wenn überhaupt von einer Trendveränderung die Rede sein soll, müsste eher von einer Abschwächung des Meeresanstiegs gesprochen werden.

Die Tatsache, dass es weltweit keine trendmäßige Zunahme von extremen Wetterereignissen gibt, kann kein „Trost“ sein für die von derartigen Wetter-Katastrophen heimgesuchten Menschen, Tiere und Natur. Aber dies muss ein Grund sein, von der „Erwärmungs-Katastrophik“ abzulassen und sich mit aller Kraft wie allen Mitteln auf die unmittelbare Vor- wie Nachsorge zu Wetter-Katastrophen zu konzentrieren.

Inzwischen sind im öffentlichen Bewusstsein wie in der Politik die guten und vom CO2 völlig unabhängigen Gründe für eine schrittweise und nachhaltige Reduzierung des Einsatzes fossiler Energieträger fest verankert.

Weitgehend unbestritten gilt, dass

⁃ die Erde nicht beliebig und grenzenlos ausgebeutet werden darf,

⁃ der Auf- und Ausbau einer eigenen Versorgung mit erneuerbarer Energie den Energieimport und damit den Kapitalabfluss in politisch „unzuverlässige“ Länder mindert

⁃ die sparsame und effiziente Energieverwendung in allen Lebensbereichen ein unverzichtbares Gebot der Wirtschaftlichkeit und Wohlstandsmehrung ist.

Dass es Zeit ist, die imaginäre „Klima“-Debatte mit ihren völlig nichtssagenden Durchschnittswerten aufzugeben, wird auch klar, wenn man die tatsächliche Temperatur an tatsächlichen Orten betrachtet. Dazu wurde jüngst vermeldet, dass an einem heißen Tag dieses Sommers im Zentrum großer Städte eine um 12 Grad Celsius höhere Tageshöchsttemperatur gemessen wurde als im etwa zwanzig Kilometer entfernten, unbesiedelten Umland. Über beiden Orten wehte oder stand die selbe Luft mit dem selben CO2-Gehalt. Und dem von hitzebedingter Kreislaufschwäche geplagten älteren Menschen im Stadtzentrum werden das berühmt-berüchtigte „Zwei-Grad-Erwärmungsziel“ (G8-Gipfel 2009) ebenso wie der „Verzicht auf fossile Energieträger ab dem Zweiundzwanzigsten Jahrhundert“ (G20-Gipfel 2015) kaum als Stärkung in den Sinn gekommen sein.

Entsprechendes gilt für die ruß- und feinstaubgeplagten Menschenmassen in China und in den vielen anderen Ländern mit veralteten Kohlekraftwerken. Binnen kurzer Frist könnten diese mit modernsten Filtern aufgerüstet werden, so dass sehr bald einhundert-prozentig ruß- und staubfreier Kraftwerksbetrieb gewährleistet wäre.

CO2 würde zwar weiterhin entweichen. Aber darf dieses Gesetz jeglicher Verbrennung ein Alibi sein, heute möglichen Menschen- und Umweltschutz bis zum „post-fossilen Sankt-Nimmerleins-Tag“ zu vertagen?

Weitere Beispiele ließen sich anfügen: Die übertriebene Fixierung auf die Reduzierung menschenverursachter CO2-Emissionen führt zu massiven Fehlsteuerungen. Politische Aufmerksamkeit und Energie werden fehlgeleitet, zweifelhafte und unsinnige gesetzliche Vorschriften bleiben in Kraft oder werden zusätzlich erlassen und erhebliche Kapitalströme werden fehlgelenkt.

Es gibt allerbeste Gründe für eine „klimapolitische Entspannung“. Eine dem Menschen, der Umwelt und der Natur dienende Energie- und Umweltpolitik sollte sich wieder am Hier und Heute orientieren. Und die „Klimawissenschaft“ sollte ihre Energie und Arbeit statt in aussichtslos komplexe mathematische Simulations- und Prognosemodelle in die Erforschung und das Verstehen der Grundlagen jeglicher „Klima-Aussage“ investieren. Das wären vor allem die Ozeanographie, die Polarforforschung und ganz besonders die Meteorologie.

Diese Rückbesinnung sollte die anthropozentrische Übertreibung der Erwärmungs- und CO2-Debatte mindern, die sich in dem „Zwei-Grad-Erwärmungs-Begrenzungs-Ziel“ nachdrücklichst manifestiert.

Die in unübersehbare Dimensionen aufgewachsene Förderung und Verbrennung fossiler Energieträger basierte und basiert auch heute oftmals auf rücksichtsloser Ignoranz gegenüber den damit verbundenen Natur- und Umweltschäden („macht Euch die Erde untertan“).

Die Vorstellung, die globale Erdwärme über den anthropogenen CO2-Ausstoß beeinflussen zu können, offenbart eine gigantische Selbstüberschätzung des Menschen für das globale Erdschicksal

(„Gott der Allmächtige schuf den Menschen nach seinem Ebenbilde“).

———————————————————————————————-

* W. Krelle, D. Beckerhoff u. a., Ein Prognosemodell für die wirtschaftliche Entwicklung der Bundesrepublik Deutschland, Meisenheim, 1969

D. Beckerhoff, Wer atmet, der sündigt, Bonn, 2012; Konkurs der Modelle, Bonn, 2013; Bonjour CO2, Bonn 2013

———————————————————————————————-

und Wetter

und Wetter