Bild rechts: Ozeanriesen vor der Kugelbake in Cuxhaven. Bild: © Chris Frey 2015

Hintergrund

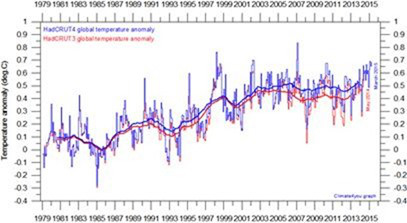

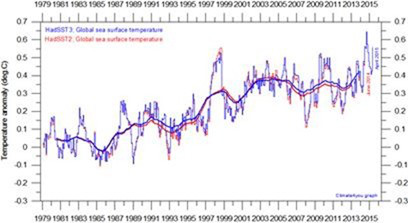

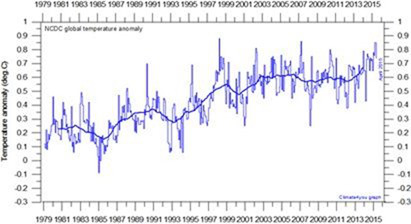

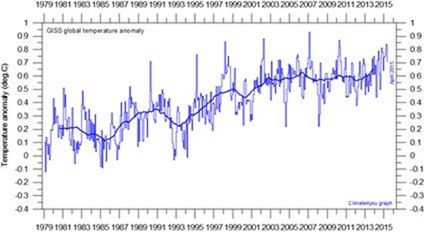

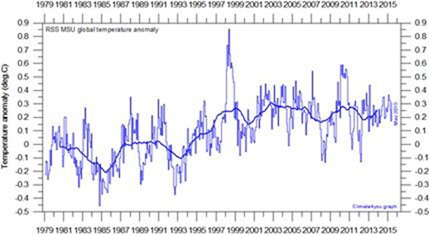

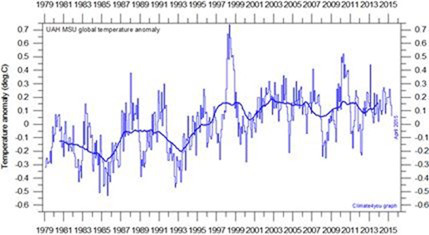

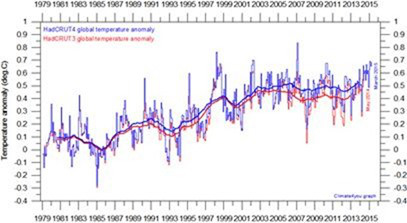

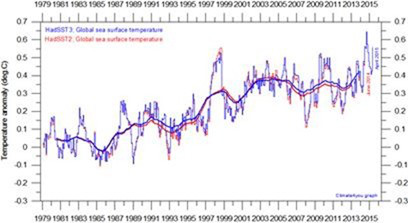

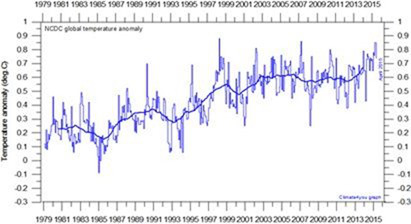

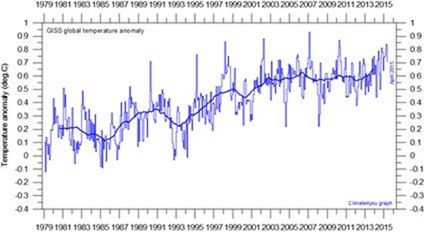

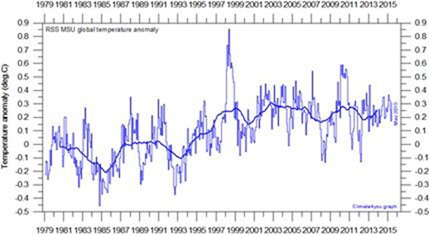

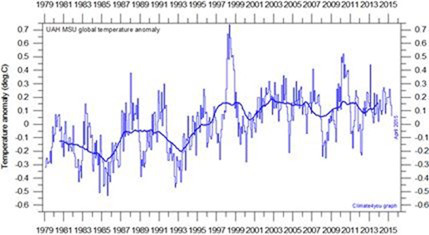

Der Gedanke, dass es seit Ende der neunziger Jahre einen Stillstand der globalen Erwärmung gegeben hatte, stammt aus Analysen vieler verschiedener Datensätze:

HadCRUT(land surface + ocean)

NCDC(land surface + ocean)

GISS(land surface + ocean)

RSS(lower troposphere)

UAH(lower troposphere)

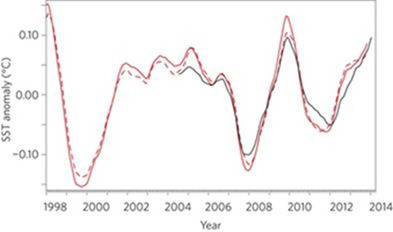

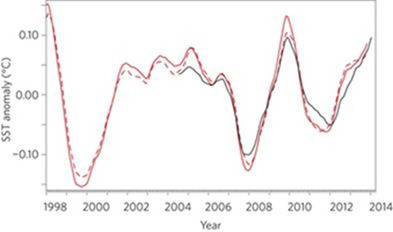

Ocean Heat Content (0-2000m)Argo floats (black line)

NOAA SST est’s (red solid and dashed lines)

Quellen: Alle Daten von http://www.climate4you.com/GlobalTemperatures.htm außer der letzten Graphik, die von hier stammt: http://www.nature.com/nclimate/journal/v5/n3/full/nclimate2513.html.

Der jüngste Bericht des IPCC hat diesen Stillstand festgestellt und wie folgt kommentiert (Working Group I, Chapter 9, Box 9.2):

Die gemessene globale mittlere Temperatur GMST) hat einen viel geringeren zunehmenden linearen Trend an den Tag gelegt während der letzten 15 Jahre als während der letzten 30 bis 60 Jahre … Abhängig vom beobachteten Datensatz wird geschätzt, dass der GMST-Trend von 1998 bis 2012 nur etwa ein Drittel bis halb so groß ist wie der Trend von 1951 bis 2010.

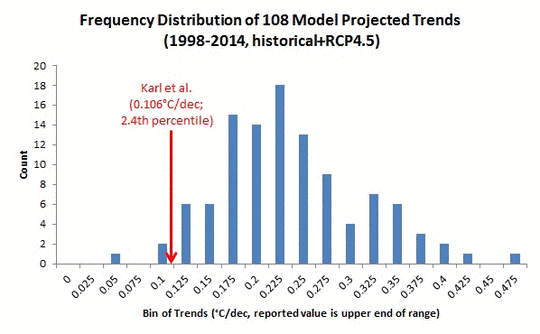

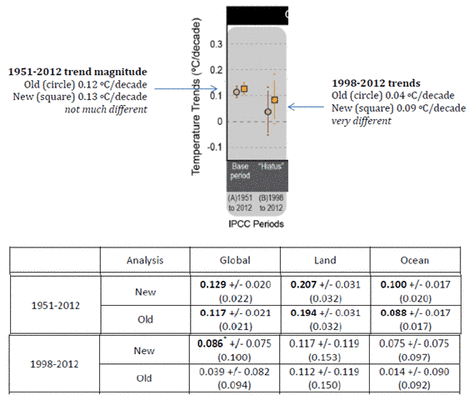

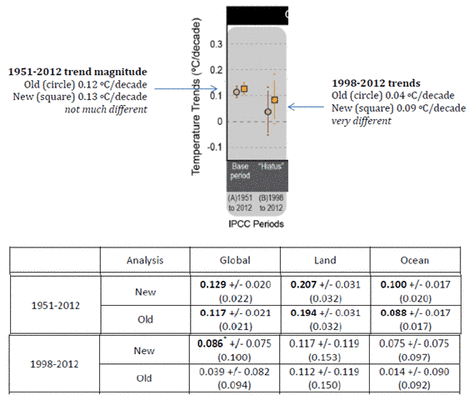

Neue Schätzungen von K15

Karl et al. (2015, was ich hiernach nur noch K15 nennen möchte) haben eine ganz andere Meldung ausgestreut und sagen, dass der Trend nach 1998 viel höher ist als ursprünglich gedacht. Er ist tatsächlich genauso hoch wie im Intervall nach 1951. Sie begründen ihre Schätzungen wie folgt:

Die große Quelle der Änderung ist eine Korrektur nach oben (+0,06°C/ Dekade) des globalen Trends der Wassertemperatur (SST) nach 1998. Der Festlands-Trend wurde nur geringfügig geändert:

Was also hat sich in den SST-Aufzeichnungen verändert? Man behalte im Hinterkopf, dass es nur sehr wenige Aufzeichnungen der Lufttemperatur über den Ozeanen gibt, vor allem vor dem Jahr 1950. Um also langfristige Klimaschätzungen zu erhalten, nutzen Wissenschaftler die SST-Daten, die seit dem 19. Jahrhundert von Schiffen gemessen worden sind. Die langfristigen SST-Aufzeichnungen wurden niemals zum Zwecke einer Klima-Analyse gesammelt, und es ist notorisch schwierig, mit ihnen zu arbeiten. Viele Beurteilungen müssen vorgenommen werden, um eine finale Aufzeichnung zu erhalten, und wie der K15-Beitrag zeigt, verursachen Änderungen bei einigen dieser Beurteilungen erhebliche Änderungen bei den finalen Ergebnissen.

Grundlegendes zu den SST-Daten

Es gibt umfangreiche Literatur zu den Verfahren, eine konsistente Klimaaufzeichnung aus den SST-Archiven abzuleiten. Bei K15 wird eine dieser Aufzeichnungen herangezogen, genannt die Extended Reconstructed Sea Surface Temperature Version 4 (ERSSTv4). Damit wird eine neue globale Klimaaufzeichnung berechnet. Die Differenz ihrer Trends ist Änderungen zwischen den Versionen ERSST 3b und 4 geschuldet.

Fast alle historischen SST-Produkte sind abgeleitet aus dem International Comprehensive Ocean-Atmosphere Data Set (ICOADS, http://icoads.noaa.gov/) [comprehensive = umfassend] oder einem der Vorläufer desselben. ICOADS kombiniert etwa 125 Millionen SST-Aufzeichnungen von Schiffsbeobachtungen und weitere 60 Millionen Messungen von Bojen und anderen Quellen [1]. Ein großer Beitragender zum ICOADS-Archiv ist die UK Marine Data Bank. Unter anderen historischen Quellen finden sich u. A. die Marine, Handelsflotten, Containerschiffe, Bojen-Netzwerke usw.

Die SST-Daten wurden historisch mit verschiedenen Verfahren zusammengestellt:

● Hölzerne Eimer wurden über Bord geworfen, mit Meerwasser gefüllt und wieder an Deck gehievt; danach wurde die Wassertemperatur im Eimer mit einem Thermometer gemessen.

● Gleiches Verfahren, nur mit Segelplanen

● Gleiches Verfahren, nur mit isolierten Eimern

● Automatische Temperaturmessungen im Kühlwasser für die Schiffsmotoren

● Sensoren an der Außenwand der Schiffe

● Treibende und feste Bojen

Zusätzlich gibt es Archive von Marine Air Temperature (MAT), gemessen von Schiffen mit meteorologischer Ausrüstung an Deck.

Hier folgt eine Liste mit einigen der Probleme, mit denen es die Wissenschaftler zu tun haben, wenn sie auf der Grundlage dieser Zusammenstellungen konsistente Temperaturverläufe konstruieren wollen:

● Schiffe befahren zumeist bestimmte Routen, und riesige Gebiete der Ozeane (vor allem auf der Südhemisphäre) haben niemals ein Schiff gesehen [3]

● Seeleute sind nicht gezwungen, Eimer-Messungen vorzunehmen während Stürmen und anderen gefährlichen Bedingungen.

● Messungen wurden nicht notwendigerweise immer zur gleichen Tageszeit durchgeführt

● Während des Prozesses, den Wassereimer an Deck zu hieven, kann sich die Temperatur der Wasserprobe ändern

● Die Änderungen sind unterschiedlich, je nachdem, wie groß das Schiff ist, ob der Eimer aus Holz oder Planen besteht, ob er isoliert ist und wie schnell die Messung durchgeführt wird

● Das Einströmen von Kühlwasser (ERI) kann bei kleinen Schiffen direkt unter der Wasseroberfläche, bei großen Schiffen aber bis zu 15 Meter unter der Oberfläche erfolgen

● Genauso können die Sensoren in der Außenwand in ganz unterschiedlichen Tiefen liegen und außerdem Gegenstand von Temperatureffekten mit der Zeit sein, da die Schiffsmotoren die Außenwand aufheizen

● MAT-Messungen werden in Höhe des Decks gewonnen, und moderne Schiffe sind viel höher als ältere Modelle. Die Instrumente befinden sich also nicht in der gleichen Höhe über dem Meeresspiegel

● Bojen tendieren dazu, näher an der Wasseroberfläche zu messen als die ERI-Daten

● Es gab nicht viele Messbojen in den Ozeanen der Welt vor den siebziger Jahren, aber jetzt gibt es viel mehr, deren Werte jetzt in die Mittelung Eingang finden

Jetzt füge man zu diesen Problemen noch hinzu, dass bei Dateneingang in dieses Archiv in etwa der Hälfte aller Fälle gar nicht bekannt ist, welche Methode zur Datengewinnung verwendet worden ist (Hirahari et al. 2014). In einigen Fällen wurde angemerkt, dass beispielsweise ERI-Messungen durchgeführt worden waren, jedoch ohne die Angabe, in welcher Tiefe. Oder die Höhe des Schiffes bleibt unbekannt, wenn eine MAT-Messung durchgeführt wird. Und so weiter.

Schiffe und Bojen werden als in situ-Messungen betrachtet. Da in situ-Daten niemals den ganzen Ozean abgedeckt haben, verwenden die meisten Forscher Satellitenaufzeichnungen, die jedoch erst seit dem Jahr 1978 zur Verfügung stehen, um über nicht erfasste Gebiete zu interpolieren. Infrarot-Daten vom Advanced Very High Resolution Radiometer (AVHRR)-System können die Wassertemperatur akkurat messen, müssen jedoch mit bestehenden SST-Aufzeichnungen kalibriert werden. Außerdem können diese Messungen beim Vorhandensein tiefer Wolken oder dichter Aerosole unzuverlässig sein. Während der letzten paar Jahre haben neue Satelliten-Verfahren (Tropical Rainfall Measuring Mission oder TRMM sowie der Advanced Microwave Scanning Radiometer oder AMSR-E) eine genauere Datensammlung ermöglicht, auch bei Wolken- und Aerosol-Bedingungen.

Hadley, GISS und Hirahara et al. 2014 [4] verwenden allesamt Satellitendaten, um Interpolations-Schätzungen in datenarmen Gebieten zu verbessern. Das ERSST-Team (d. h. K15) haben das vor der Version 3b gemacht, dann aber nicht mehr wegen ihrer Bedenken hinsichtlich der Genauigkeit.

Die drei wesentlichen ERSSTv4-Adjustierungen

Die oben genannten Messprobleme sind gut bekannt. Viel Arbeit wurde während der letzten Jahrzehnte dafür geleistet zu versuchen, einige der Metadaten für in situ-Temperaturmessungen zu gewinnen und auch Korrekturen abzuschätzen, um Verzerrungen auszumerzen, die den Rohdaten innewohnen. K15 haben einige vergleichsweise geringe Änderungen der Bias-Korrektur-Verfahren vorgenommen, und das Ergebnis ist eine große Zunahme des Trends nach 1998.

A. Sie addierten 0,12°C zu den Bojen-Messwerten, angeblich um sie vergleichbar zu machen mit Schiffsmessungen. Wie die Autoren anmerken, repräsentieren Bojen-Messwerte einen steigenden Anteil an den Beobachtungen der letzten Jahrzehnte, was den vermeintlichen Erwärmungstrend verstärkt.

B. Sie haben den Bojen-Messwerten bei den Berechnungen zusätzliches Gewicht verliehen.

C. Sie haben auch Adjustierungen an die nach 1941 von Schiffen gewonnenen Daten angebracht, vor allem eine große Abkühlungs-Adjustierung bei Messungen von 1998 bis 2000.

Nimmt man all diese Veränderungen zusammen, lässt sich der verstärkte Trend der letzten 15 Jahre zum größten Teil erklären. So muss nun jeder für sich selbst darüber befinden, ob diese Adjustierungen angemessen sind oder nicht.

Vielleicht sind sie es. Das Hauptproblem für uns Beobachter ist, dass andere Teams die gleichen Dinge bearbeitet haben und zu ganz anderen Ergebnissen gekommen sind. Und die K15-Daten nach 1998 passen nicht zu den Ergebnissen anderer unabhängiger Quellen einschließlich Wettersatelliten.

A.Betrachtet man die erste Adjustierung, nehmen K15 die Bojen-Daten und addieren 0,12°C zu jedem Messwert. Sie errechneten diese Zahl, indem sie Stellen betrachteten, an denen Bojen- und Schiffsdaten an den gleichen Stellen gesammelt worden sind. Dabei stellten sie fest, dass die Schiffsdaten im Mittel um 0,12°C wärmer waren als die Bojendaten. Also wurden die Bojendaten entsprechend korrigiert. Dies entspricht in etwa der Größenordnung, die auch von anderen Teams gefunden worden ist, obwohl der Bias normalerweise den Schiffen und nicht den Bojen zugeordnet wird:

Jüngere SST-Beobachtungen werden hauptsächlich durch treibende Bojen durchgeführt, die in den globalen Ozeanen ausgesetzt worden sind (Abbildungen 1 und 2). Die Bojen messen die Wassertemperatur direkt ohne Meerwasser an Deck oder in das Innere eines Schiffes zu expedieren. Daher geht man davon aus, dass Bojenmessungen genauer sind als Eimer- oder ERI-Daten… In dieser Studie betrachten wir diese Differenz als einen Bias in den ERI-Messungen, und bei den Treibbojen werden keine Verzerrungen angenommen. Der mittlere ERI-Bias von +0,13°C wurde erhalten und liegt innerhalb der Bandbreite des globalen Gebietes, das in Tabelle 5 bei Kennedy et al. 2011 gelistet ist (Zitat aus Hirahari et al. 2014, S. 61)

Jenes Zitat bezieht sich auf eine Studie von Kennedy et al. (2011, Tabelle 5) [5], in der von einem mittleren Bias von +0,12°C die Rede ist. Allerdings merken Kennedy et al. auch an, dass die Schätzung sehr unsicher ist: sie beträgt 0,12°C ± 1,7°C! Außerdem variiert der Bias in verschiedenen Gebieten. Dies ist der grundlegende Unterschied zwischen dem Verfahren von K15 und den Verfahren Anderer. K15 addierten 0,12°C zu allen Bojendaten, aber die Hadley-Gruppe und die Hirahari-Gruppe verwendeten gebietsspezifische Adjustierungen.

B. Es gibt hinsichtlich dieses Schrittes keine detaillierten Angaben. K15 sagen einfach: Weil die Bojendaten als zuverlässiger angesehen werden, erhielten sie mehr Gewicht in der statistischen Prozedur, und dies „führte zu mehr Erwärmung“. Die Schritte A und B waren für fast die Hälfte der zusätzlichen Erwärmung verantwortlich.

C. Zuvor wurde von Anderen angemerkt, dass die SST-Daten von Schiffen einen rapideren Erwärmungstrend zeigen als in der Nähe gemessene Lufttemperaturen von Bojen (Christy et al. 2001) [6]. K15 berechnen eine Adjustierung an die SST-Daten auf der Grundlage von Vergleichen mit nächtlichen MAT-Daten aus einem Datensatz mit der Bezeichnung HadNMAT2. K15 sagen, dass dies für etwa die Hälfte der neuen Erwärmung in ihrem Datensatz verantwortlich ist. Sie verteidigen dies mit der Aussage, dass dies die Schiffsaufzeichnungen auf eine Linie mit den NMAT-Daten gebracht hat. Allerdings ist dieser spezielle Schritt schon zuvor von Kennedy et al. sowie Hirahara et al. in Erwägung gezogen worden. Diese sprachen sich für alternative Methoden aus, weil die NMAT-Daten ihre eigenen „überall vorhandenen systematischen Fehler“ haben [7], von denen einige bereits oben erwähnt worden sind. Statt also mechanische Formeln auf der Grundlage der NMAT-Daten zu verwenden, haben andere Teams sehr detailliert auf verbleibende Metadaten geschaut für jeden Messtyp. Dann haben diese Teams Korrekturen auf der Grundlage der involvierten Systeme und Örtlichkeiten vorgenommen.

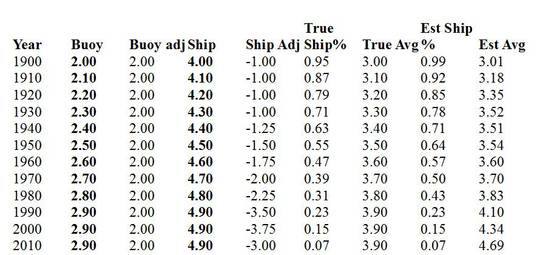

Numerisches Beispiel

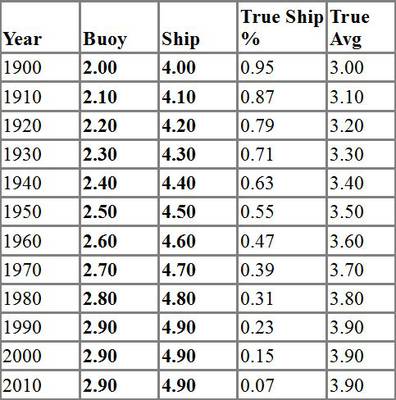

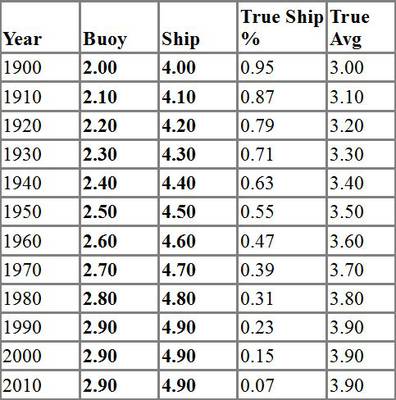

Hier folgt ein einfaches numerisches Beispiel, um zu zeigen, wie diese Hypothesen wichtige Änderungen der Ergebnisse verursachen können. Nehmen wir an, wir haben SST-Daten von zwei Quellen: Schiffe und Bojen. Nehmen wir weiter an, dass Schiffe die Temperatur immer um genau 1°C überschätzen und Bojen um genau 1°C unterschätzen. Wir verfügen über einen Satz von Messungen alle 10 Jahre, und wir sind uns nicht sicher, welcher Anteil von Schiffen und welcher von Bojen stammt. Sowohl Schiffe als auch Bojen messen den zugrunde liegenden Trend, der eine Erwärmung von 0,1°C von 1900 bis 1990 zeigt; danach gibt es keinen Trend mehr.

Die folgende Tabelle zeigt die simulierten Zahlen. Nehmen wir an, der wirkliche Anteil der Schiffe im Datenkollektiv beginnt bei 95% im Jahre 1900 und nimmt in jedem Jahrzehnt um 8% ab, bis zu einem Anteil von 7% im Jahre 2010.

Das wirkliche Mittel wird berechnet unter Verwendung des Gewichtes in der Spalte True Ship %, wobei 1°C zu den Bojendaten addiert werden und 1°C von den Schiffsdaten subtrahiert werden. Das Ergebnis zeigt die folgende Graphik:

Die dünnen schwarzen und grauen Linien sind die Schiffs- (oben) und die Bojendaten (unten), während die dicke schwarze Linie in der Mitte das Wahre Mittel ist.

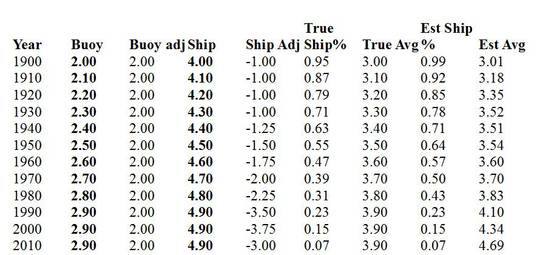

Aber jetzt nehmen wir einmal an, dass wir nicht wissen, welche korrekte Adjustierung an die Bojen- oder die Schiffsdaten anzubringen ist, und wir kennen auch nicht die True Ship-Prozentzahlen. Wir schätzen das globale Mittel folgendermaßen:

● Man adjustiere die Bojendaten um +2°C jedes Jahr (etwas zu viel)

● Man adjustiere die Schiffsdaten um -1°C jedes Jahr (die richtige Größenordnung)

● Nach 1940 fügen wir auch eine Abkühlungs-Adjustierung den Schiffsdaten hinzu. Sie beginnt bei -0,25°C und steigt um diesen Betrag in jedem Jahrzehnt.

● Außerdem kühlen wir die Schiffsdaten um 1°C nur in den Jahren 1990 und 2000

● Wir schätzen die Schiffs-Prozentzahlen. Sie beginnen bei 99% im Jahre 1900 (etwas hoch) und reduzieren dies um 7% in jedem Jahrzehnt (etwas zu wenig) bis zum Jahr 1990. An diesem Punkt beobachten wir die True Ship-Prozente und folgen ihnen nachfolgend genau.

Bevor wir die Ergebnisse betrachten, frage man sich selbst, ob man glaubt, dass diese Adjustierungen einen großen Unterschied machen.

Das neue geschätzte Mittel ist die rote gestrichelte Linie.

Bis zum Jahr 1990 passt es ganz gut, aber der akkumulierte Effekt all der kleinen Fehler ist der künstliche Trend, der zum Ende der Reihe auftaucht. An dieser Stelle würden wir hoffen, einige unabhängige Daten des Trends nach 1990 zu haben, um das Ergebnis zu vergleichen, um festzustellen, ob unsere Verfahren und Hypothesen vernünftig waren.

Dieses Beispiel beweist natürlich nichts über K15, außer dass kleine Änderungen bei den Hypothesen, wie die Unsicherheiten in den Daten große Auswirkungen auf die Endergebnisse haben können. Aber das war vorher schon klar, weil K15 selbst erklären, dass ihre neuen Hypothesen – keine neuen Beobachtungen – das sind, was den Erwärmungstrend zum Ende ihres Datensatzes zum Vorschein brachte.

Schlussfolgerung

Sind die neuen K15-Adjustierungen korrekt? Offensichtlich ist es nicht an mir, dies zu sagen – es ist etwas, das von Spezialisten auf diesem Gebiet debattiert werden muss. Aber ich habe Folgendes beobachtet:

● Alle zugrunde liegenden Daten (NMAT, Schiffe, Bojen usw.) haben inhärente Probleme, und viele Teams haben sich viele Jahre lang bemüht herauszufinden, wie man mit diesen Fehlern umgeht.

● Die HadNMAT2-Daten sind weit gestreut und unvollständig. K15 vertreten die Position, dass das In-Linie-Bringen der Schiffsdaten mit diesem Datensatz die Schiffsdaten zuverlässiger macht. Diese Position haben andere Teams nicht übernommen, einschließlich des Teams selbst, dass die HadNMAT2-Daten entwickelt hatte.

● Es ist sehr seltsam, dass eine Abkühlungs-Adjustierung an die SST-Aufzeichnungen von 1998 bis 2000 einen so großen Effekt auf den globalen Trend haben soll, nämlich die Beseitigung des Stillstands, der in so vielen anderen Datensätzen hervortritt, besonders angesichts dessen, dass andere Teams keine Gründe gefunden hatten, solche Adjustierungen vorzunehmen.

● Das Ausreißer-Ergebnis in den K15-Daten könnte bedeuten, dass alle anderen etwas übersehen, oder es könnte einfach bedeuten, dass die neuen K15-Adjustierungen ungültig sind.

Es wird interessant sein, die Spezialisten auf diesem Gebiet während der kommenden Monaten über diese Frage reden zu hören.

Ross McKitrick

[1] Woodruff, S.D., H. F. Diaz, S. J. Worley, R. W. Reynolds, and S. J. Lubker, (2005). “Early ship observational data and ICOADS.” Climatic Change, 73, 169–194.

[2] See http://www.metoffice.gov.uk/hadobs/hadsst3/Kennedy_2013_submitted.pdf for a review.

[3] Rayner, N. A., D. E. Parker, E. B. Horton, C. K. Folland, L. V. Alexander, D. P. Rowell, E. C. Kent, and A. Kaplan, (2003): Global analyses of sea surface temperature, sea ice, and night marine air temperature since the late nineteenth century. Journal of Geophysical Research, 108(D14), 4407, doi:10.1029/2002JD002670.

[4] Hirahara, S. et al. Centennial-Scale Sea Surface Temperature Analysis and Its Uncertainty, Journal of Climate Vol 27 DOI: 10.1175/JCLI-D-12-00837.1

[5] http://www.metoffice.gov.uk/hadobs/hadsst3/part_2_figinline.pdf

[6] Christy, John R., David E. Parker, Simon J. Brown, et al. 2001 Differential trends in tropical sea surface and atmospheric temperatures since 1979. Geophysical Research Letters 28, no. 1

[7] http://www.metoffice.gov.uk/hadobs/hadsst3/Kennedy_2013_submitted.pdf page 28.

Link: http://wattsupwiththat.com/2015/06/04/a-first-look-at-possible-artifacts-of-data-biases-in-the-recent-global-surface-warming-hiatus-by-karl-et-al-science-4-june-2015/

Übersetzt von Chris Frey EIKE