Geeignet für Vorhersagen, weil eine eindeutige Lösung eine abgeleitete und hochspezifische Aussage darüber ist, wie sich die physische Realität verhält. Es erlaubt, dass nur eine Möglichkeit unter einer unendlichen Anzahl von Möglichkeiten auftreten wird. Eine eindeutige Lösung behauptet eine extreme Unwahrscheinlichkeit, so dass sie anfällig ist für Widerlegung durch Beobachtung.

Falsifizierbar, weil, wenn die Vorhersage falsch ist, die physikalische Theorie widerlegt wird.

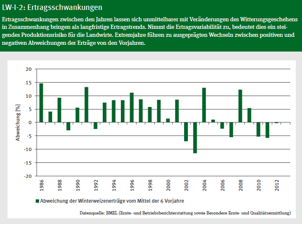

Grafik 1 im früheren Beitrag ergab, dass die großen Unsicherheitsbereiche in den Projektionen der zukünftigen globalen Lufttemperaturen sie prädiktiv nutzlos machen. Mit anderen Worten, sie haben keine physikalische Bedeutung. Siehe auch hier (528 kB pdf) und Grafik 1 hier, eine Abhandlung jetzt gerade in Energy & Environment erschienen, mit der allgegenwärtigen Nachlässigkeit, die Konsens-Klimatologie infiziert. [1]

Dieser Beitrag zeigt, dass Nachberechnungen historisch jüngster globaler Lufttemperaturtrends ebenfalls keine physikalische Bedeutung haben.

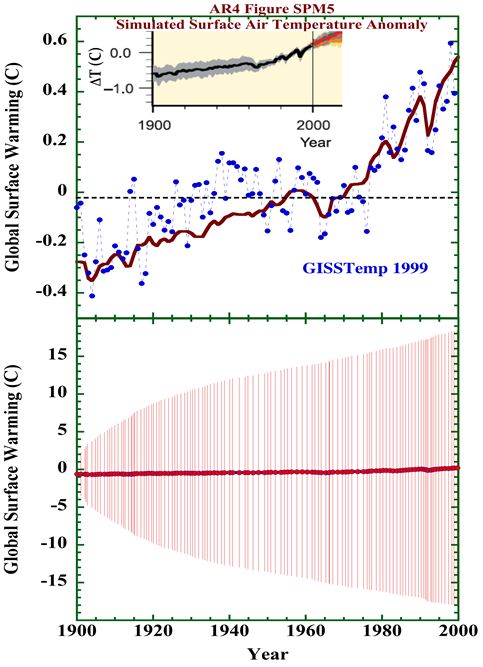

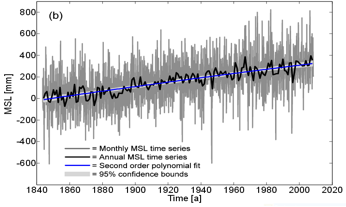

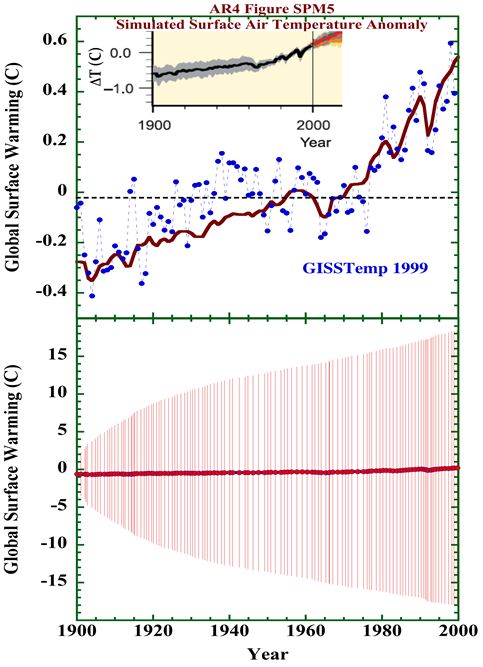

Die folgende Grafik zeigt Daten aus Grafik SPM.5 [Link eingefügt, d.Übersetzer] des IPCC 4AR. [2] Die dunkelrote Linie im oberen Bereich zeigt die Multi-Modell-Simulation der durchschnittlichen globalen Oberflächen-Lufttemperatur des 20. Jahrhunderts. Die blauen Punkte sind die Version von 1999 der GISS-Aufzeichnungen von Land + Meer der globalen Durchschnittstemperatur. [3] Die Übereinstimmung zwischen den simulierten und beobachteten Temperaturen ist gut (Korrelation R = 0,85; p <0,0001). Der Einschub an der Spitze der Tafel zeigt den SPM.5 Multi-Modell-Durchschnitt wie im 4AR veröffentlicht. Der graue IPCC Unsicherheitsbereich über der Simulation des 20. Jahrhunderts ist eine ± Standardabweichung über die Durchschnittswerte der Multi-Modelle.

Der relativ enge Unsicherheitsbereich des IPCC impliziert, dass die Nach-Simulation erhebliches Vertrauen verdient. Die gute Übereinstimmung zwischen den beobachteten und simulierten Temperaturen des 20. Jahrhunderts liegt innerhalb der Korrelation = grundlegende Norm der Konsensklimatologie.

Der untere Teil von Grafik 1 zeigt auch die Unsicherheitsbereiche der Multi-Modell Nachberechnungen des 20. Jahrhunderts. Diese stellen den durchschnittlichen CMIP5 ± 4 Wm-2 Fortpflanzungsfehler des systematischen Cloud Forcings [theoretischer Wärmeantrieb der Wolken] dar, der sich durch die gesamte Simulation zieht. Die Fortpflanzung erfolgt durch Einsetzen des Wolkenfehlers in die bisher veröffentlichte lineare Gleichung, die die Projektionen der GCM Lufttemperatur genau emuliert; auch hier zu sehen (2,9 MB pdf). Systematische Fehlerfortpflanzung als die Summe der Quadratwurzeln.

Grafik 1. Oberes Feld (rote Linie), der Multi-Modell-Simulation der globalen Lufttemperatur des 20. Jahrhunderts (IPCC AR4 Grafik SPM.5). Kleiner Einschub: SPM.5 Multi-Modell-Nachberechnungen, Durchschnitt des 20. Jahrhunderts, wie veröffentlicht. Blaue Punkte: die GISS-Aufzeichnungen der 1999 Land + Meer globalen bodennahen Lufttemperaturaufzeichnungen. Unteres Feld: die SPM.5 Multi-Modell-Simulation des 20. Jahrhunderts mit dem Unsicherheitsbereich der Fehlerfortpflanzung, Summe der Quadratwurzel des CMIP5 durchschnittlichen ± 4 W/m² Cloud Forcing.

Die Konsens-Sensibilität wird nun fragen: Wie ist es möglich, dass im unteren Feld die Unsicherheitsbereiche so groß sind, wenn die simulierten Temperaturen offensichtlich in der Nähe der beobachteten Temperaturen sind?

Darum: Die Multi-Modell Simulationen der durchschnittlichen Nachberechnungen des 20. Jahrhunderts sind physikalisch bedeutungslos. Unsicherheitsbereiche sind die Breite der Ignoranz [Unwissenheit]. Systematische Fehler bewirken, dass je weiter das Klima in der Zeit projiziert wird, umso weniger ist über die Übereinstimmung zwischen Simulation und dem wahren physikalischen Zustand des zukünftigen Klimas bekannt. Der nächste Teil dieses Beitrags zeigt die Wahrheit dieser Diagnose.

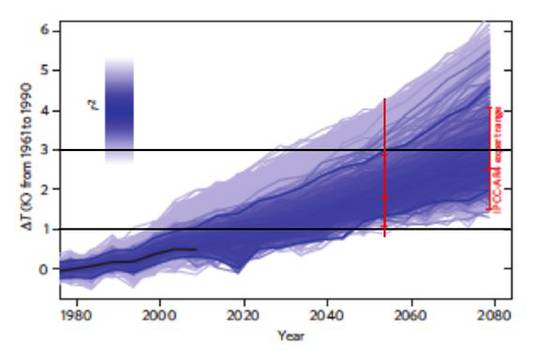

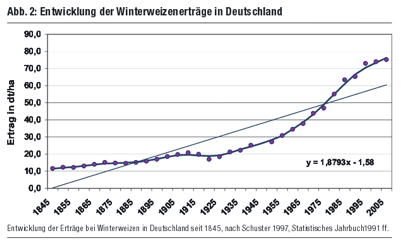

Bild 1 von Rowlands [4] unten zeigt “perturbed physics” „gestörte Physik" [siehe unten: Nachgeschlagen] Projektionen aus dem HadCM3L Klimamodell [Hadley Centre climate model Vers. 3L]. In gestörten Physik Projektionen," wird eine einzige Modellstruktur verwendet, und Störungen werden auf unsichere physikalische Parameter innerhalb dieser Struktur angewandt …" [5] Das heißt, ein gestörtes Physikexperiment zeigt die Veränderung der Klimaprojektionen, wenn Modellparameter schrittweise variiert werden über ihre physikalische Unsicherheit.

Grafik 2. Originale Legende: ". Entwicklung der Unsicherheiten in rekonstruierten globalen Mitteltemperatur-Projektionen unter SRES A1B im HadCM3L Ensemble" Die eingebettete schwarze Linie ist die Aufzeichnung der beobachteten Oberflächen-Lufttemperatur. Die horizontalen schwarzen Linien in 1 C und 3 C, und die vertikale rote Linie zum Jahresende 2055 sind vom Autor hinzugefügt.

Das HADCML Modell ist repräsentativ für das Verhalten aller Klimamodelle, darunter die erweiterten CMIP3 und CMIP5 Versionen. Verändernde Parameter erzeugen eine Spreizung der Projektionen mit zunehmenden Abweichungen mit der Simulationszeit.

Beim SRES A1B-Szenario erhöht sich das atmosphärische CO2 jährlich. Dies bedeutet, der Energiezustand des simulierten Klimas erhöht sich systematisch über die Jahre.

Die horizontalen schwarzen Linien zeigen, dass die HADCM3L die gleichen Temperaturänderungen für mehrere (tausend) Klima Energiezustände erzeugen. Das heißt, unterschiedliche Parametersätze projizieren eine konstante 1 C Temperaturerhöhung für jeden einzelnen Jahresklima Energiezustand zwischen 1995-2050. Die wissenschaftliche Frage ist, welche der Tausende von 1 C Projektionen ist die physikalisch richtige?

Ebenfalls, abhängig von Parametersätzen, kann eine konstante 3 C Temperaturerhöhung zu jedem einzelnen Jahresklima Energiezustand zwischen 2030-2080 führen. Welcher davon ist korrekt?

Keiner der verschiedenen Parametersätze ist als physikalisch korrekter bekannt als irgendein anderer. Es gibt also keine Möglichkeit, die Temperatur Projektion auszuwählen, die physikalisch unter allen Alternativen zu bevorzugen ist.

Welche ist korrekt? Keiner weiß es.

Die gleiche Logik gilt für die vertikale rote Linie. Diese Zeile zeigt, dass die HADCM3L mehrere (tausend) Temperaturänderungen für einen einzigen Klima Energiezustand (den 2055er Status) produziert. Jeder einzelne Rowlands, et al., Jahresklima-Energiezustand zwischen 1976-2080 hat Dutzende von simulierten damit verbundenen Lufttemperaturen.

Nochmals, keiner der verschiedenen Parametersätze, der diese simulierten Temperaturen produziert, ist als physikalisch korrekter bekannt als irgendein anderer. Es gibt wieder keine Möglichkeit zu entscheiden, welche unter all den verschiedenen Möglichkeiten der projektierten Jahreslufttemperatur physikalisch korrekt ist.

Diese Beispiele zeigen, dass die HADCM3L keine eindeutige Lösung für das Problem des Klimaenergiezustands produzieren können. Kein Satz von Modellparametern ist bekannt, der besser als jeder andere Satz von Modellparametern gültig ist. Keine Projektion ist bekannt, die physikalisch korrekter (oder inkorrekter) ist als jede andere Projektion.

Das bedeutet: für jede gegebene Projektion ist vom internen Zustand des Modells nicht bekannt, dass es den zugrunde liegenden physikalischen Zustand des wahren terrestrischen Klima enthüllt. Einfacher gesagt: Das Modell kann uns auf der Ebene der Auflösung des Treibhausgas-Antriebs einfach nichts über das physikalisch reale Klima sagen.

Das gleiche gilt notwendigerweise für jeden modellierten Klima-Energiezustand, einschließlich der modellierten Energiezustände der Klimavergangenheit.

Lassen Sie uns jetzt zurückblicken auf die Multi-Modell-Nachberechnung des durchschnittlichen 20. Jahrhunderts im oberen Bereich der Grafik 1. Analog der multiplen Temperaturprojektionen in Rowlands, et al., Grafik 1, die die Ignoranz Breite der Parametersätze darstellen, auf der Einzel Nachberechnungslinie SPM.5. Das bringt die Erkenntnis, dass es eine ebenso große Anzahl von gleichberechtigten, aber divergenten Nachberechnungen geben muss.

Jedes der multiplen Modelle, das eine Nachberechnung erzeugt, hat eine große Anzahl von alternativen Parametersätzen. Keiner dieser alternativen Sätze ist als physikalisch weniger gültig bekannt als jedweder andere Satz auch immer, der eine individuelle Modell-Nachberechnung erzeugt.

Es muss eine gestörte Physik-Aufspreizung existieren, sinngemäß zu Rowlands Grafik 1, für die Projektion der 20. Jahrhundert (Nachberechnung). Die alternativen Parametersätze, alle gleichermaßen gültig, würde eine Reihe von Nachberechnungen erzeugen, die mit der Zeit auseinanderlaufen würden. Beginnend ab 1900 würden die die einzelnen gestörte Physik-Nachberechnungen immer weiter von der bekannten Aufzeichnung der Lufttemperatur bis zum Jahr 2000 auseinander laufen. Aber sie wurden alle ausgespart aus Grafik SPM.5.

Die Modelle, die die SPM.5 Nachberechnungen des 20. Jahrhunderts ausführen, enthüllen überhaupt nichts über den wahren physikalischen Zustand des terrestrischen Klima des 20. Jahrhunderts, innerhalb der Auflösung des Antriebs im 20. Jahrhundert.

Das heißt, dass die Durchschnittswerte der Multi-Modell Nachberechnung in SPM.5 keine offensichtliche physikalische Bedeutung haben. Es ist der Durchschnitt der Nachberechnungsprojektionen, die keine physikalische Bedeutung haben. Dies ist der Grund für die großen Unsicherheitsbalken, trotz der Tatsache, dass der durchschnittliche Nachberechnungs-Temperaturtrend in der Nähe des beobachteten Temperaturtrends liegt. Die Modellzustände sagen uns nichts über die Ursache der beobachteten Temperaturen. Deshalb haben die Nachberechnungen der Lufttemperaturen keine physikalische Verbindung zu den beobachteten Lufttemperaturen. Die Divergenz der gestörten Physik-Nachberechnungen erhöht sich mit der Simulationszeit, in seiner Art und Weise genau durch die immer größeren Unsicherheitsbalken abgebildet.

Diese Schlussfolgerung gilt auch dann, wenn ein gegebenes Klimamodell zufälligerweise eine Projektierung erzeugt, die dem Verhalten der beobachteten Lufttemperaturen nachläuft. Solche Korrespondenzen sind zufällig, indem der für dieses Modell gewählte Parametersatz Offset Fehler haben muss. Diesem wurden versehentlich vorteilhafte Werte innerhalb ihrer Unsicherheitsgrenzen zugewiesen. Was auch immer diese vorteilhaften Werte sind, sie sind nicht bekannt, physikalisch korrekt zu sein. Ebenso wenig kann man die zufällige Korrelation mit Beobachtungen implizieren, dass der zugrunde liegende Modell Zustand dem wahren physikalischen Zustand des Klimas entspricht.

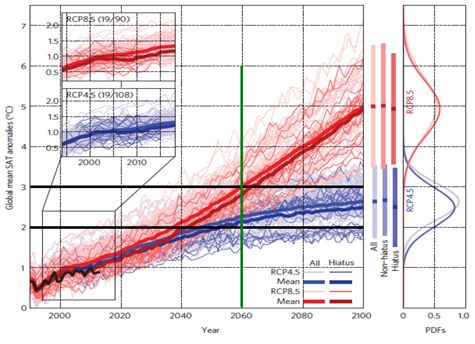

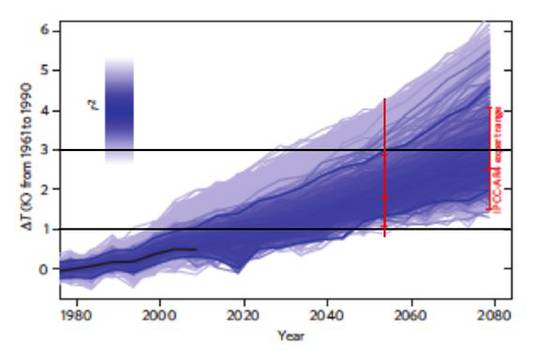

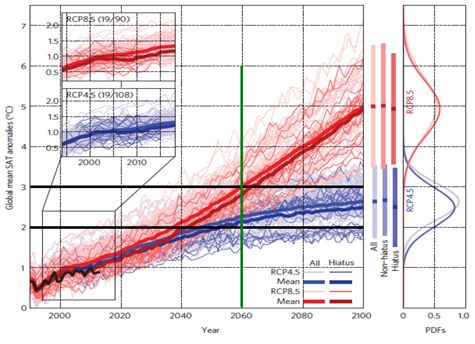

Die physikalische Bedeutung der kürzlich veröffentlichten Studie von M. England et al., [6] in Grafik 3 veranschaulicht, ist jetzt offensichtlich. England et al. berichten, dass einige CMIP5-Projektionen sich dem „Hiatus" der Lufttemperatur seit dem Jahr 2000 annähern. [lat. hiatus „Öffnung“, „Spalt“, „Kluft“ steht für die scheinbare Pause bei der globalen Erwärmung] Sie behaupteten dann, dass diese Übereinstimmung die „Robustheit der Erwärmungsprojektionen im 21. Jahrhundert" belegt und dass es „das Vertrauen in die letzten synthetisierten Projektionen im IPCC 5AR verstärkt."

Vergleichen Sie Grafik 1 von England et al., 2015 unten, mit der Grafik 1 Rowlands et al., 2012, oben. Die horizontalen schwarzen Linien und die senkrechte grüne Linie übermitteln die gleiche Diagnose wie die sinngemäßen Linien in Rowlands, et al., Grafik 1.

Der England et al.-Satz der CMIP5 Modelle produziert konstante Lufttemperaturen für mehrere Energiezustände und mehrere Lufttemperaturen für jeden einzelnen Jahresklima-Energiezustand. Dies trotz der Tatsache, dass "alle Simulationen identischen historischen Antrieben folgen ([6], Hintergrundinformationen)." Die Abweichung der Projektionen, trotz identischer Antriebe, zeigt deutlich eine Spreizung der Modellparameterwerte.

Grafik 3. Grafik 1 von England, et al. 2015 [6] Originale Legende: Globale durchschnittliche SAT-Anomalien in Bezug auf 1880-1900 in individuellen und Multi-Modell Durchschnitts CMIP5 Simulationen. Blaue Kurven: RCP4.5 Szenario; rote Kurven: RCP8.5 Szenario. Die horizontalen schwarzen Linien bei 2 C und 3 C und die vertikale grüne Linie auf 2060 sind vom Autor hinzugefügt.

Die Diagnose ergibt sich unmittelbar aus Grafik 3: CMIP5 Klimamodelle sind unfähig, eine eindeutige Lösung für das Problem des Klima-Energiezustandes zu liefern. Sie leiden alle unter internen Parametersätzen mit breiten Unsicherheitsbereichen. Die internen Zustände der Modelle verraten nichts über die zugrunde liegenden wahren physikalischen Zustände des Klimas in Vergangenheit oder Zukunft. Keine der CMIP5-Projektionen durch England et al. aufgeführt, hat eine erkennbare physikalische Bedeutung, egal ob sie über die "Erwärmungspause" führen oder nicht.

Das bringt uns zurück zur Bedeutung der großen Unsicherheitsbalken in dem unteren Feld der Nachberechnung des 20. Jahrhunderts in obiger Grafik 1. Diese ergeben sich aus dem Fortpflanzungsfehler der CMIP5-Modell ± 4 W/m² Durchschnitts Cloud Forcing. [7, 8] Wie Parameterunsicherheit, zeigen Cloud Forcings Fehler auch an, dass Klimamodelle keine eindeutige Lösung für das Problem des Klima- Energiezustandes bieten.

Unsicherheitsbalken sind eine Unwissenheitsbreite. Sie zeigen an, wie viel Vertrauen eine Vorhersage verdient. Parameter-Unsicherheit bedeutet, die richtigen Parameterwerte sind nicht bekannt. Cloud Forcing-Fehler bedeutet, der thermische Energiefluss der durch Wolken Feedback in die Troposphäre eingeführt wird, ist nicht bekannt. Modelle mit internen systematischen Fehlern präsentieren diesen Fehler in jedem einzelnen Schritt einer Klimasimulation. Je mehr Simulationsschritte, desto weniger ist über die Übereinstimmung zwischen dem simulierten Zustand und dem physikalisch wahren Zustand bekannt.

Je mehr Simulationsschritte, desto weniger Wissen, desto größer ist die Unwissenheit über die Modell Abweichungen vom physikalischen wahren Zustand. Das ist die Botschaft der zunehmenden Breite des Unsicherheitsbereichs des propagierten Fehlers.

Jede einzelne Projektion in Englands et al. Grafik 1 unterliegt dem ± 4 W/m² CMIP5 durchschnittliche Cloud Forcing Fehler. Zu einer korrekten Anzeige der physikalischen Bedeutung sollte ein Unsicherheitsbereich wie in obiger Grafik 1 unten gehören. Außerdem, der systematische Fehler in den Projektionen der einzelnen Modelle läuft in den Multi-Modell-Durchschnitt als quadratischer Mittelwert ein.[9]. Englands et al. Multi-Modell-Durchschnittsprojektionen – die dunklen roten und blauen Linien – haben sogar eine größere Unsicherheit als jede der einzelnen Projektionen. Dies ist eine Ironie, die regelmäßig Konsens-Klimatologen unterläuft.

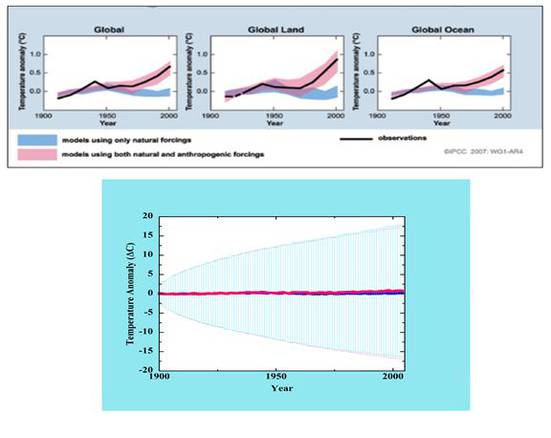

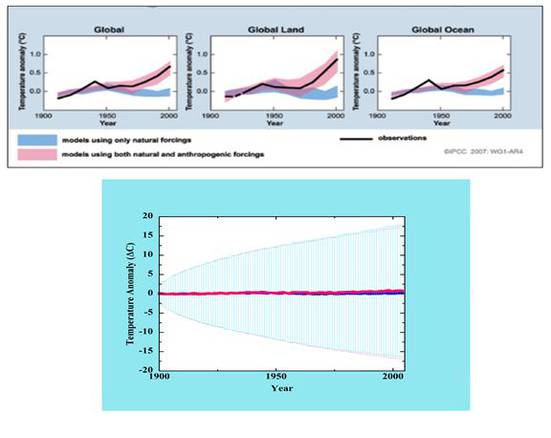

Also, wenn Sie eine Grafik wie in Abbildung 4 oben sehen (unten), geliefert von der US National Academy of Sciences [10], erkennen Sie, dass eine Präsentation, die vollständig wissenschaftlichen Standards entsprechen würde, wie Abbildung 4 unten aussehen würde.

Abbildung 4. Oben: Grafik 4 aus [10]; Original Legende: Modellsimulationen der Klimaänderungen des 20. Jahrhunderts entsprechen besser der beobachteten Temperatur, wenn sowohl natürliche als auch menschliche Einflüsse enthalten sind. Die schwarze Linie zeigt die beobachteten Temperaturen. Unten, das linke obere US NAS Feld, die globale 20. Jahrhundert Lufttemperatur Nachberechnung, aber jetzt mit Unsicherheits Balken von propagiert ± 4 W/m² CMIP5 durchschnittlichen Cloud Forcing Fehler.

Es macht überhaupt keinen Sinn zu behaupten, dass eine Erklärung der späteren Erwärmung des 20. Jahrhunderts, ohne Einschluss "menschlicher Einflüsse" nicht möglich ist, wenn in der Tat eine Erklärung der späteren Erwärmung des 20. Jahrhunderts in diesem Zeitraum nicht möglich ist.

Klima-Modellierer wählen Parametersätze mit Offset Fehlern, um die Lufttemperatur des 20. Jahrhunderts erfolgreich nachzuberechnen. [11] Das bedeutet, jedwede Übereinstimmung zwischen nachberechneten Temperaturen und beobachteten Temperaturen ist tendenziös – Die Korrespondenz ist absichtlich eingebaut.

Der frühere Beitrag wies nach, dass ihre eigenen Aussagen zeigen, dass Klima-Modellierer nicht als Physiker ausgebildet sind. Es zeigte sich, dass das Modellieren von Klimamodellen selbst eine freie Kunst in der Art der Kulturwissenschaft ist, jedoch mit Mathematik erarbeitet. In den Kulturwissenschaften intellektualisiert Theorie nur die Vorurteile der Theoretiker. Dieser Beitrag stellt die andere Seite der Medaille dar: der Mangel an Verständnis, der aus der mangelnden Berufsausbildung folgt.

Die Tatsache, dass England, et al., behaupten können, die "Robustheit der einundzwanzigsten Jahrhunderts Erwärmung Projektionen" und "mehr Vertrauen" in IPCC Projektionen zu erreichen, wenn ihre Modelle offensichtlich nicht in der Lage sind, den Energiezustand des Klimas zu lösen, zeigt lediglich, dass sie keinerlei Verständnis haben von der Quelle der physikalische Bedeutung. Darum erkennen sie nicht, dass ihre Modell Projektionen keine physikalische Bedeutung aufweisen. Ebenso die Redakteure und Rezensenten von Nature Climate Change, die Verwaltung der US National Academy of Sciences, und das gesamte IPCC von oben nach unten.

Die Beweise zeigen, dass diese Menschen nicht wissen, wie sich die physikalische Bedeutung aus der physikalischen Theorie ergibt. Sie wissen nicht, wie man die physikalische Bedeutung erkennt, wie man physikalische Bedeutung präsentiert, noch wie man physikalische Bedeutung zu bewerten hat.

Kurz gesagt, sie verstehen weder Vorhersage noch Widerlegung; beides ist gemeinsam die Grundlage der Wissenschaft.

Klima-Modellierer sind keine Wissenschaftler. Sie arbeiten nicht wissenschaftlich. Ihre Klimamodellprojektionen haben keine physikalische Bedeutung. Ihre Klimamodellprojektionen haben niemals irgendeine physikalische Bedeutung.

Bis auf den heutigen Tag gab es keine einzige THG-Emissionen-Klimaprojektion überhaupt, die physikalische Bedeutung hatte. Daher sind all diese strittige Debatten darüber, ob irgendein Modell, einige aus der Menge von Modellen oder ein Multi-Modell Durchschnitt, die globale Lufttemperatur nachvollziehen oder nicht, völlig sinnlos. Es spielt keine Rolle, ob eine physikalisch bedeutungslose Projektion einige Beobachtungen trifft oder nicht. Die Projektion ist ohne physikalische Bedeutung. Es hat keinen wissenschaftlichen Inhalt. Die Debatte hat keinen materiellen Inhalt. Die Diskutanten können genauso gut die Anfechter der Theologie sein.

Wenn also jemand über AGW sagt: “The science is settled!", kann man wahrheitsgemäß antworten, dass es tatsächlich „abgeschlossen“ ist, es gibt keine Wissenschaft in AGW.

Erschienen am 20. Mai 2015 auf WUWT hier

References:

1. Frank, P., Negligence, Non-Science, and Consensus Climatology. Energy & Environment, 2015. 26(3): p. 391-416.

2. IPCC, Climate Change 2007: The Physical Science Basis. Contribution of Working Group I to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change, S. Solomon, et al., Editors. 2007, Cambridge University: Cambridge.

3. Hansen, J., et al., GISS analysis of surface temperature change. J. Geophys. Res., 1999. 104(D24): p. 30997–31022.

4. Rowlands, D.J., et al., Broad range of 2050 warming from an observationally constrained large climate model ensemble. Nature Geosci, 2012. 5(4): p. 256-260.

5. Collins, M., et al., Climate model errors, feedbacks and forcings: a comparison of perturbed physics and multi-model ensembles. Climate Dynamics, 2011. 36(9-10): p. 1737-1766.

6. England, M.H., J.B. Kajtar, and N. Maher, Robust warming projections despite the recent hiatus. Nature Clim. Change, 2015. 5(5): p. 394-396.

7. Lauer, A. and K. Hamilton, Simulating Clouds with Global Climate Models: A Comparison of CMIP5 Results with CMIP3 and Satellite Data. J. Climate, 2013. 8. Frank, P., Propagation of Error and the Reliability of Global Air Temperature Projections; Invited Poster, in American Geophysical Union Fall Meeting. 2013: San Francisco, CA; Available from: http://meteo.lcd.lu/globalwarming/Frank/propagation_of_error_poster_AGU2013.pdf (2.9 MB pdf).

9. Taylor, B.N. and C.E. Kuyatt., Guidelines for Evaluating and Expressing the Uncertainty of NIST Measurement Results. 1994, National Institute of Standards and Technology: Washington, DC. p. 20.

10. Staudt, A., N. Huddleston, and I. Kraucunas, Understanding and Responding to Climate Change 2008, The National Academy of Sciences USA: Washington, D.C.

11. Kiehl, J.T., Twentieth century climate model response and climate sensitivity. Geophys. Res. Lett., 2007. 34(22): p. L22710. 26(11): p. 3823-3845.

Übersetzt von Andreas Demmig EIKE