Das Zweigradziel – Vorgabe für den Übergang zu einer planwirtschaftlich organisierten, sozialistischen Weltgesellschaft

Die Gipfeltreffen wurden seinerzeit von Helmut Schmidt und Giscard d’Estaing begründet, mit der Absicht, drängende Probleme der Weltpolitik in entspannter Runde zu besprechen und die gegenseitigen Standpunkte dazu zu klären. Das war auch in Elmau so. Eins war aber bemerkenswert anders. Wie aus dem Fazit Merkels hervorgeht, hat offenbar ein Problem breiten Raum eingenommen, das es in der realen Welt gar nicht gibt. Der vom Menschen verursachte Klimawandel!

Das Zweigradziel wurde erstmals in den Jahren 1975 und 1977 von dem U.S. Ökonomen William D. Nordhaus ohne Bezug auf irgend eine genauere wissenschaftliche Ableitung als Richtwert für eine Kosten-Nutzenanalyse formuliert. Als konkrete Planungsgrundlage tauchte es erstmals 2009 im dritten Sachstandsbericht des Intergovernmental Panel on Climate Change (IPCC) auf, jedoch nicht als Grundlage für einen bindenden Beschluss. Erst 2010 wurde es mit Hilfe des von Hans-Joachim Schellnhuber geleiteten Wissenschaftlichen Beirats der Bundesregierung für Globale Umweltveränderungen (WBGU) in die Klimarahmenkonvention der Vereinten Nationen (UNFCCC) mit der Absicht aufgenommen, es zu einem bindenden Beschluss zu machen, wie es jetzt in Elmau als Ziel für die anstehende Klimakonferenz COP 21 in Paris beschlossen wurde. Jenseits der Zweigradgrenze werden angeblich in der Klimaentwicklung sogenannte „Kippelemente“ erreicht, nach deren Eintreten die Folgen des Klimawandels unabsehbar und irreversibel werden können. Eine wissenschaftlich zwingende Erklärung warum diese kritische Grenze, sofern es so etwas überhaupt geben kann, gerade bei 2 ° liegt, existiert nach wie vor nicht. Das Zweigradziel ist ein politisches Totschlagsargument, mit dem sich letztlich auch die absurdesten Vorhaben begründen lassen.

Warum ist Klimawandel gefährlich?

Das Wort Klima bedeutet griechisch „Neigung“. In der Meteorologie versteht man darunter den (30 jährigen) Mittelwert bestimmter Wetterparameter, vor allem der Lufttemperatur, der für bestimmte Klimaregionen (also etwa der Arktis, der Tropen usw.) auf der Erde berechnet wird. Es handelt sich also um eine statistische Größe, die per definitionem variabel ist. Auch eine Globaltemperatur lässt sich daraus (mit vielen messtechnisch bedingten) Unsicherheiten berechnen, was aber eigentlich wenig Sinn macht. Eine messbare Größe ist das jedenfalls nicht.

Klimaänderungen gibt es, seit die Erde besteht. Einen durch den Menschen verursachten Klimawandel infolge eines durch CO2 Emission verstärkten sogenannten Treibhauseffekts gibt es dagegen nicht! Es gibt überhaupt keinen durch irgend welche mit Infrarotstrahlung wechselwirkenden Gase verursachten „Treibhauseffekt“. Einen durch Infrarotstrahlung realisierten Wärmetransport aus der kalten Hochatmosphäre auf den warmen Erdboden kann es nach dem 2. Hauptsatz der Thermodynamik (1) nicht geben! Auch für ein normales Gewächshaus spielt die Strahlung keine Rolle. Das wurde bereits 1909 von dem amerikanischen Physiker Robert W. Wood experimentell nachgewiesen! Ein durch Wärmestrahlung aus der oberen Troposphäre verursachter „natürlicher Treibhauseffekt“, der dafür sorgt, dass die untere Troposphäre wärmer ist, als die nach der Strahlungsformel von Stephan-Boltzmann berechnete Oberflächentemperatur von ca. -18 C existiert nicht. Die für ein Temperaturgleichgewicht mit der Einstrahlung nötige Wärmeabstrahlung erfolgt aus der Hochatmosphäre. Dafür liegen auch umfangreiche Messungen aus den Nimbussatelliten vor. Die Temperaturschichtung in der Troposphäre wird nach der feucht-adiabatischen Höhenformel berechnet. Das einzige „Klimagas“, was darin vorkommt, ist der Wasserdampf. Alle diese Zusammenhänge sind in unzähligen wissenschaftlichen Abhandlungen detailliert beschrieben, siehe etwa (2).

Wem der bloße Hinweis auf den 2. Hauptsatz der Thermodynamik zu abstrakt ist, kann sich dem Problem auch auf anderen Wegen nähern. Am einfachsten über den gesunden Menschenverstand. In der Atmosphäre kommen auf 10000 Luftmoleküle 4 Moleküle Kohlendioxyd (CO2). Die Vorstellung, dass das ganze thermische Gleichgewicht der Atmosphäre erschüttert wird und sogar Kipp-Punkte überschritten werden, die zu irreversiblen und katastrophalen Veränderungen führen, wenn statt 4 z.B 6 oder auch 8 Moleküle CO2 auf 10000 Luftmoleküle kommen, erscheint sehr verwegen.

Schließlich kann man sich dem Problem ganz wissenschaftlich über die Physik nähern. Von dem in diesem Zusammenhang vernachlässigbaren Wärmestrom aus dem Erdinneren abgesehen erhält die Erdoberfläche alle Wärme aus der Einstrahlung der Sonne. Im Bereich der Erdbahn liegt die von der Sonne eingestrahlte Energie zwischen 1360 und 1380 W/m². Es ist üblich, diesen auf die Querschnittsfläche der Erde entfallenden Energiestrom auf die ganze Oberfläche verteilt zu betrachten, das ergibt 343 W/m². Etwas vereinfacht unter Vernachlässigung von nach Wetter und Ort unterschiedlichen Bedingungen ergibt sich folgende Verteilung der eingestrahlten Energie:

30% werden reflektiert und 20% durch Wasserdampf, Wolken, Schwebstoffe und Gase mit 3- und mehratomigen Molekülen wie Ozon und CO2 absorbiert, dass heißt in Wärme umgewandelt. Der Rest erwärmt den Erdboden. Damit es auf der Erde nicht ständig wärmer wird, muss die eingestrahlte Energie wieder weg gekühlt werden. Das geschieht durch Abstrahlung aus der oberen Atmosphäre bei für derartige Reaktionen nötigen, etwas größeren freien Weglängen. Der Boden erwärmt die darüber liegende Luft durch Konvektion und als Verdampfungswärme. Ein kleiner Teil, etwa 6%, wird direkt in den Weltraum abgestrahlt. In der Atmosphäre bildet sich nun nach den klassischen Gesetzen der Thermodynamik ein Temperaturgefälle über der Höhe, das nach der sogenannten feuchtadiabatischen Höhenformel berechnet wird. Die Infrarot-strahlungsfähigen Bestandteile der Luft, vor allem Wasserdampf und CO2, strahlen bei von der Höhe abhängigen Temperaturen Energie in den Weltraum ab. Die Wärmeverteilung zwischen Atmosphäre und Erdoberfläche hängt im wesentlichen von der Bewölkung ab. Der wesentliche Beitrag des CO2 zum Klimageschehen besteht in der Kühlung. Eine Rückübertragung von Wärme durch „Gegenstrahlung“ kann es nicht geben. Vom Erdboden abgegebene Wärme kann nicht dazu benutzt werden, den Erdboden, aus dem sie stammt, zu erwärmen.

Damit wäre geklärt: CO2 ist kein Klimagas. Es gibt keine Treibhausgase.

Faktum ist jedoch, dass alle diese, mehr oder weniger leicht zugänglichen Quellen in der öffentlichen Aufmerksamkeit keine Wirkung zeigen. Jahrelange Gehirnwäsche durch die zahllosen Lobbygruppen wie Greenpeace, BUND, NABU, das Umweltministerium usw. haben die öffentliche Meinung und leider selbst die „Qualitätspresse“ wie SZ oder „Die Zeit“ unfähig zur kritischen Beurteilung der unentwegt in breitem Strom verbreiteten Nachrichten über den durch den Klimawandel drohenden Weltuntergang gemacht. Selbst der seit über 18 Jahren zum Stillstand gekommene Erwärmungstrend wird völlig ausgeblendet und nach wie vor werden alle möglichen und unmöglichen Ereignisse als Folge des (überhaupt nicht stattfindenden) Klimawandels beschrieben.

Der Klimawandel ist zum nicht mehr hinterfragbaren Dogma geworden. Eine tatsächlich zu beobachtende Erwärmung ist nicht mehr nötig. Kuriose Wortschöpfungen wie „Klimaschutz“ (wie kann man eine statistische Rechengröße schützen?) oder Klimaleugner sind in die Alltagssprache aufgenommen.

Es mag sein, dass ein großer Teil der Politiker und Journalisten einfach nicht das Rüstzeug hat, um die o.a. recht einfachen naturwissenschaftlichen Fakten zu verstehen. Es ist aber kaum vorstellbar, dass dies auch für eine ausgebildete Physikerin wie Angela Merkel oder Prof. Schellnhuber gilt, der Theoretische Physik studiert hat. Was also ist das eigentliche Ziel hinter dem Zweigradziel?

Merkel: „Wir wissen, dass wir dafür tiefe Einschnitte bei weltweiten Treibhausgasemissionen brauchen und haben uns deshalb dazu bekannt, dass wir im Laufe dieses Jahrhunderts eine Dekarbonisierung der Weltwirtschaft brauchen“.

Kleiner Exkurs über das Element Kohlenstoff:

Am Anfang des Universums, nach dem Urknall, gab es zunächst keinen Kohlenstoff. Dieser ist erst in der Frühphase der Sternentstehung als Endpunkt der atomaren „Wasserstoffverbrennung“ kleinerer Sterne in der Größenordnung der Sonne entstanden.

Heute macht der Kohlenstoff ca 0,46% der sichtbaren Materie aus. In der Erdkruste wird der Anteil zwischen etwa 0,018% und 0,048% geschätzt. Der Mensch besteht zu etwa 22% aus Kohlenstoff (2).

Das 4-wertige Element hat die einzigartige Eigenschaft, sich außer mit vielen anderen Elementen auch mit sich selbst verbinden zu können und dabei mit einfach-, doppel- und dreifach Bindungen lange Ketten und Ringe zu bilden. Auf diese Weise sind in der Biochemie Millionen von Verbindungen möglich. Die Vielfalt dieser Kohlenstoffverbindungen ist die Grundlage allen organischen Lebens auf der Erde! Im Leben und Vergehen der Lebewesen wird der für den Aufbau der Körpersubstanz nötige Kohlenstoff aus seiner Sauerstoffverbindung, Kohlendioxyd, von den Pflanzen durch die Assimilation aus der Luft gewonnen und und nach dem Tod durch Verwesung wieder der Luft zugeführt.

In diesem Zusammenhang ist die Frage interessant, wo die riesigen Kohlenstoffmengen herkommen, die heute in den Kohleflözen und vor allem auch in den Kalksteingebirgen gespeichert sind. Die Antwort ist: Sie waren in der Atmosphäre, deren CO2 Gehalt etwa im Kambrium bis zu 20 mal höher war als heute. Dabei war das Kambrium eine der aktivsten Phasen der Evolution in der tausende Tier- und Pflanzenarten entstanden (Die kambrische Explosion!).

Wie heute in Anbetracht dieser seit langem bekannten Fakten von dem unsichtbaren und ungiftigen, die Grundlage allen Lebens bildenden Gas Kohlendioxyd als „Verschmutzung“ der Luft gesprochen werden kann, ist eine geradezu blasphemische Verirrung.

Nun wird also Dekarbonisierung angesagt. Wie wird das in der Praxis realisiert werden und was ist der eigentliche Zweck?

Der technisch naheliegendste und am wenigsten kostspielige Weg wäre der Ausbau der Kernenergie. Der ist aber, wie Frau Merkel zu erkennen behauptet hat, in Deutschland wegen der großen Erdbeben- und Tsunamigefahr nicht gangbar.

Den ersten noch etwas unbeholfenen Schritt machte der grüne Trittin mit seiner Energiewende und dem dafür geschaffenen „Erneuerbare-Energien-Gesetz (EEG)“. Dies verschaffte Deutschland den nach Dänemark teuersten Strom und veränderte schon jetzt manche deutsche Landschaften etwa im Norden entlang der A 20 und in Rheinland-Pfalz entlang der A 61. Aus grüner Sicht könnte man sagen, dass dort das eher langweilige Landschaftsbild durch die vielen Windturbinen mit ihren sich zeitweilig drehenden Flügeln deutlich abwechslungsreicher geworden ist. Die mit der Bezeichnung „erneuerbare Energie“ implizierte Außerkraftsetzung des 1. Hauptsatzes der Thermodynamik ist allerdings noch nicht richtig gelungen. Es ist festzustellen: Wenn der Wind nicht weht und die Sonne nicht scheint, ist die Energie einfach unerneuerbar weg!

Selbst die zahlreichen Experten im UBA und bei den NGO’s wie Greenpeace, BUND, NABU usw. haben aber erkannt, dass ein Industrieland nicht nur Strom braucht, wenn der Wind weht und/oder die Sonne scheint. Um dieses Problem zu lösen braucht man aber „nur“ geeignete Speicher zu bauen, wie sie die Technik in Form von Pumpspeicherwerken, Druckluftspeichern mit ihren dazu gehörenden Wärmespeichern oder Wasserstofferzeugern (Power to Gas) kennt. Für eine so, nach Meinung all dieser Experten realisierbare, grundlastfähige Versorgung mit Elektroenergie braucht man allerdings ein vielfaches der derzeit installierten Windkraftanlagen, Fotovoltaik- und Biogasanlagen, zumal dieses System ja auch noch die vielen Elektroautos und noch nicht auf Nullenergie umgestellten Haushalte versorgen muss.

Einige Ausnahmen für nicht dekarbonisierte Systeme muss es auch noch geben. Auf das Flugzeug etwa wird man nicht völlig verzichten wollen. Auch beim Militär fällt einem die Vorstellung eines Kampfpanzers mit Elektroantrieb noch schwer.

Alles in Allem haben wir dann aber endlich die von den Grünen aller Parteien schon lange versprochenen gigantischen Zahlen neuer Arbeitsplätze, deren Finanzierung allerdings noch nicht ganz geklärt ist.

Leider können selbst grüne Techniker (so etwas soll es geben) leicht ausrechnen, dass für das hier umrissene totale Dekarbonisierungsprogramm die Fläche Deutschlands nicht ausreicht. In diesem Zusammenhang ist dann oft von noch nicht ausgeschöpften, sagenhaften Effizienzsteigerungen die Rede. Schellnhuber im Kölner Stadtanzeiger vom 10.06.15: „Energie muss überall effizienter genutzt werden“. Und das ausgerechnet bei alleiniger Verwendung der Maschinen mit dem schlechtesten Wirkungs- und vor allem Flächennutzungsgrad wie Fotovoltaik und WKA.

Wenn bei einer Mangelsituation die marktwirtschaftliche Problemlösung der Anpassung der Produktion an den Bedarf nicht den politischen Vorgaben entspricht, muss eben der planwirtschaftliche Weg gegangen werden, indem der Bedarf an das Angebot angepasst wird. Die Klimakanzlerin hat auf diesem Gebiet in ihrer Jugend auch als Funktionärin des Parteiapparats umfangreiche Erfahrungen gesammelt, die ihr jetzt zu Gute kommen. Die erforderlichen theoretischen Grundlagen liefert ihr Think-Tank, der WBGU (Wissenschaftlicher Beirat der Bundesregierung Globale Umweltveränderungen). Dieser Rat wurde 1992 vor dem sogenannten „Erdgipfel von Rio“ als „unabhängiges“ Beratergremium gegründet, das von der Bundesregierung mit der Erstellung von Sondergutachten beauftragt werden kann. Die Mitglieder werden vom Bundeskabinett berufen (wodurch garantiert ist, dass der jeweilige Rat das gewünschte Ergebnis liefert). Gegenwärtiger Vorsitzender ist Prof. Dr. Dr. hc Hans-Joachim Schellnhuber vom PIK (Potsdam Institut für Klimafolgen (interessante Wortschöpfung)) mit 300 Mitarbeitern. Der Rat legt der Bundesregierung jährlich ein Hauptgutachten vor zum Thema „Welt im Wandel“.

Eine Besonderheit dieser „Gutachten“ ist, dass sie in der Regel keine Beratung etwa durch objektiv, ohne Bewertung beschriebene Probleme und mit möglichst alternativen Problemlösungsvorschlägen machen, sondern gleich die entsprechenden Maßnahmen in Form sogenannter „Leitplanken“ vorgeben. Im Rahmen dieser Gutachten werden Factsheets herausgegeben.

Welche konkreten Vorstellungen Angela Merkels Berater dabei im Auge haben und die sie, wenn man ihren Worten in Elmau folgt, in Paris zur Grundlage verbindlicher Beschlüsse machen will, ist beschrieben im Hauptgutachten 2011 unter dem Titel:

„Gesellschaftsvertrag für eine Große Transformation“. In der Einführung heißt es: „Dieser Bericht begründet die dringende Notwendigkeit einer post-fossilen Wirtschaftsweise, zeigt zugleich die Machbarkeit der Wende zur Nachhaltigkeit auf und präsentiert zehn konkrete Maßnahmenbündel zur Beschleunigung des erforderlichen Umbaus. … Damit die Transformation tatsächlich gelingen kann, muss ein Gesellschaftsvertrag zur Innovation durch einen neuartigen Diskurs zwischen Regierungen und Bürgern innerhalb und außerhalb des Nationalstaats geschlossen werden.“

Und weiter: „ …dass dies nur gelingen kann, wenn Staaten, Unternehmen und die gesamte Zivilgesellschaft gemeinsam die richtigen Weichen stellen und alle Mittel der regionalen und globalen Zusammenarbeit ausschöpfen.“

Welche Weichen richtig sind, entscheidet der WBGU zusammen mit dem Sekretariat der Klimarahmenkonvention der Vereinten Nationen UNFCCC. Für den noch unter dem Nationalsozialismus aufgewachsenen Autor klingt dies in Sprache und Diktion wie ein Auszug aus einem Kompilat aus „Mein Kampf“ und dem „Kommunistischen Manifest“. Dieser Stil setzt sich dann auch in den hier speziell diskutierten Ausführungen zur Klima und Energiepolitik fort.

Worum es im Kern letztlich geht, hat Ottmar Edenhofer (Stellvertretender Direktor und Chefökonom des PIK) 2010 auf dem Klimagipfel in Cancun erstmalig ausgesprochen. Wegen ihrer Klarheit soll die oft zitierte Aussage hier nochmals angeführt werden.

„ … Der Klimagipfel in Cancun .. ist keine Klimakonferenz, sondern eine der größten Wirtschaftskonferenzen seit dem zweiten Weltkrieg. Warum? Weil wir noch 11000 Gigatonnen Kohlenstoff in den Kohlereserven unter unseren Füßen haben – und wir dürfen nur noch 400 Gt in der Atmosphäre ablagern, wenn wir das Zweigradziel halten wollen. 11000 zu 400 – da führt kein Weg dran vorbei, dass ein Großteil der fossilen Reserven im Boden bleiben muss.

De facto ist das eine Enteignung der Länder mit den Bodenschätzen. …

Zunächst mal haben wir Industrieländer die Atmosphäre der Weltgemeinschaft quasi enteignet. Aber man muss klar sagen: Wir verteilen durch die Klimapolitik de facto das Weltvermögen um.

…. Man muss sich von der Illusion freimachen, dass internationale Klimapolitik Umweltpolitik ist. Das hat mit Umweltpolitik, mit Problemen wie Waldsterben oder Ozonloch, fast nichts mehr zu tun“

Damit ist deutlich gesagt, worum es eigentlich geht. Die Kritiker der Klimapolitik sollten aufhören sich mit Diskussionen um die Gültigkeit irgendwelcher Klimaprognosen ablenken zu lassen.

Die Frage muss lauten: Cui Bono? Wer will hier wen abzocken?

Das geht auch letztlich aus dem neuesten Produkt aus dem Hause WBGU hervor. Das 150 seitige Sondergutachten: „Klimaschutz als Weltbürgerbewegung“, ein bombastischer, pseudowissenschaftlicher Schwulst, der im Auftrag des Bundesministeriums für Bildung und Forschung und des Bundesministeriums für Umwelt, Naturschutz, Bau und Reaktorsicherheit entstanden ist. An Hand unzähliger Computersimulationen wird eine Welt beschrieben, in der alle Lebensbereiche unter der Leitung eines gestaltenden Staates, international vom UNFCCC koordiniert, dem Ziel der Dekarbonisierung untergeordnet werden.

Der erste Satz der Zusammenfassung lautet: „Der 5. Sachstandsbericht des IPCC macht unmissverständlich klar: Inakzeptable Klimafolgen, die sich jenseits der 2° Leitplanke häufen dürften, können nur vermieden werden, wenn der weitere Anstieg der Treibhausgaskonzentration so bald wie möglich gestoppt wird. Der WBGU empfiehlt daher, die CO2 Emissionen aus fossilen Energieträgern bis spätestens 2070 auf Null zu senken.“

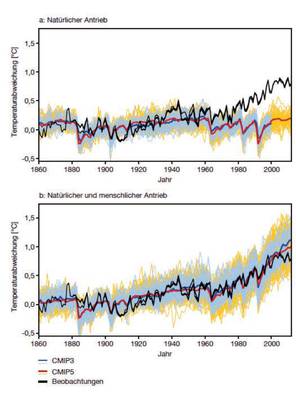

Auf den Seiten 13 und 14 heißt es dazu mit Bezug auf den o.a. Bericht, dass bei Änderungen in einem Klimasystem die Unterscheidung von externen Einflüssen von der internen Variabilität schwierig ist. Dafür habe man „Experimente“ mit Klimamodellen gemacht, aus denen eindeutig hervorging, dass die Erwärmung der letzten 50 Jahre „nur durch den durch anthropogene Emissionen erzeugten Anstieg im CO2 Gehalt der Atmosphäre erklärt werden kann“. Dazu werden Diagramme mit Vergleichen der Modellrechnungen aus CMIP3 und CMIP5 (3) gezeigt (siehe Bild ), auf denen auf nicht ganz klare Weise ein „natürlicher“ und ein vom Menschen beeinflusster Antrieb unterschieden wird. Auf dem entsprechenden Diagramm ist gut erkennbar, wie seit etwa dem Jahr 2000 die gemessenen Werte hinter den Modellrechnungen zurückbleiben. Dazu nochmals Zitat aus IPCC 5: „Daraus resultiert, dass es extrem wahrscheinlich (>95% Wahrscheinlichkeit) ist, dass mehr als die Hälfte des Anstiegs der Oberflächentemperatur der Erde von 1951 bis 2010 durch menschliche Aktivitäten zustande gekommen ist“. Der Wert der Klimasensitivität (4) bezüglich CO2 wird laut IPCC 2013 mit 66% Wahrscheinlichkeit zwischen 1,5 und 4,5 °C angegeben. Das ist ungefähr so, als ob in der Versicherungs-Statistik festgestellt wird, dass mit 95% Wahrscheinlichkeit die Menschen nicht älter als 100 Jahre werden.

Auf einer derart schwachen Faktenlage fußt die oben zitierte apodiktische Feststellung über die „unmissverständliche“ Tatsache des menschengemachten Klimawandels in der Zusammenfassung. Vermutlich dachten sich die Autoren, dass die Politiker und Journalisten ohnehin nur die Zusammenfassung lesen werden.

Die Autoren halten eine kritische Diskussion der behaupteten Fakten für CO2 usw. nicht für nötig Es wird über Modellergebnisse geschwafelt. Man bewegt sich in einer virtuellen Welt und auf dieser dünnen Argumentationsgrundlage wird die dringende Empfehlung zum Umbau der gesamten Weltwirtschaft abgeleitet.

In der Zusammenfassung heißt es weiter: „ Der zeitnahe Ausstieg aus den CO2 Emissionen ist unabdingbar. Die Aussagen des 5. IPCC Sachstandberichts sind eindeutig: Der Klimawandel findet statt und der Einfluss des Menschen ist unstrittig. Die Beweislage zur globalen Erwärmung ist überwältigend.“ (das haben die durch „Experimente“ mit Klimamodellen herausgefunden!!) und weiter: „Jede weitere Verzögerung der Dekarbonisierung der Weltwirtschaft würde die gebotene Klimastabilisierung erschweren und erheblich verteuern.“

(Hervorhebungen durch den Autor)

Zu den damit verbundenen Kosten heißt es in der Zusammenfassung: „Eine weltweite Transformation zu einer klimaverträglichen Gesellschaft ist ohne große Konsumverluste und Kosten für die Weltwirtschaft realisierbar“.

Dieser Punkt wird im weiteren Verlauf des Textes immer wieder behandelt, jedoch nie mit wirklich harten Fakten belegt. Es ist hier nicht möglich weiter auf das unglaubliche Geschwafel einzugehen, das in diesem Bericht dem Leser zugemutet wird. Erwähnenswert ist vielleicht noch, dass das Wort „Kernenergie“ in der ganzen Studie nur einmal vorkommt, wo beiläufig erwähnt wird, dass diese an der gegenwärtigen Energieversorgung mit 6% beteiligt ist.

Wie man angesichts der sich bereits jetzt in Deutschland durch die Energiewende sichtbar werdenden Probleme und der gigantischen Kapitalverluste, die notwendigerweise mit einer Dekarbonisierung der Elektrizitätswirtschaft verbunden sind, von geringen Kosten reden kann, ist geradezu grotesk. Gleichzeitig sollen auf dem nächsten Klimagipfel in Paris gigantische Transferleistungen festgeschrieben werden, die die Industrieländer zusätzlich zu den eigenen durch die Dekarbonisierung verursachten Lasten aufbringen sollen.

In welcher Welt leben die Autoren dieser Studie, die von einem Team unter Leitung eines Prof. für theoretische Physik mit zwei Doktortiteln geleitet wird?

Bei dieser Sachlage ergibt sich die Frage, wie könnte denn einmal die Erfolgskontrolle all der teuren „Klimaschutzmaßnahmen“ aussehen. In dieser Hinsicht ist festzustellen, dass sich die Klimakanzlerin in einer sehr komfortablen Situation befindet. Es gibt Abschätzungen, nach denen die von menschlichen Aktivitäten verursachten CO2 Emissionen nur mit 5% am natürlichen CO2 Kreislauf beteiligt sind. Wenn man dann noch bedenkt, dass Deutschland nur etwa 2,5% des vom Menschen verursachten CO2 Eintrags liefert, kann man feststellen, dass selbst eine 100 prozentige Minderung der deutschen CO2 Emissionen im CO2 Gehalt der Atmosphäre praktisch kaum messbar sein wird. Da andererseits aus paläontologischen und historischen Daten klar erkennbar ist, dass der CO2 Gehalt der Atmosphäre mit einer Verzögerung bis zu einigen 100 Jahren der Temperatur folgt, und da diese nicht steigt und man sogar Abkühlungstendenzen erwarten kann, wird der CO2-Anteil der Atmosphäre in Zukunft vermutlich nicht im selben Maß wie bisher weiter steigen oder sogar sinken. Das kann dann als Erfolg der Dekarbonisierungspolitik verkauft werden.

Abschließend nochmals die Frage: Cui bono? Wer ist die in der Studie beschriebene Weltbürgerbewegung?

Der Autor findet dazu keine überzeugende Antwort. Im Laufe der menschlichen Geschichte hat es immer wieder Zeiten kollektiven Wahns gegeben. Der Hexenwahn, der Faschismus, der Marxismus – werden spätere Geschichtsschreiber vom Zeitalter des Klimawahns sprechen?

(1) Siehe z.B. E. Schmidt, Thermodynamik: Wärme kann nie von selbst von einem Körper niederer Temperatur auf einen Körper höherer Temperatur übergehen.

(2) Rutherford Online – Lexikon der Elemente

(3) CMIP5: Coupled Model Intercomparison Project of the World Climate Research.

(4)Damit wird der prognostizierte Anstieg der Globaltemperatur bei Verdoppelung des CO2 Gehalts bezeichnet.

Lohmar, den 15.06.2015

Normann Treinies