===================================================

Hier Teil 1

===================================================

In Deutschland kein Klimawandel in Sicht – das kann die SZ nicht auf sich sitzen lassen (1)

Helmut Kuntz / Mai 2015

Die SZ Wochenendausgabe 117 vom 23.-25. Mai 2015 kam gleich mit zwei vollen Seiten Apokalypse zum Klimawandel in Deutschland. Anlass war der Monitoring-Bericht 2015 des Umweltbundesamtes (UBA), herunterzuladen hier.

Im ersten Teil mit der Überschrift „Die ersten Boten des Wandels“ wurde auf das Thema eingestimmt:

„Das Klima ändert sich auch in Deutschland. Die ersten Anzeichen sind schon deutlich zu sehen, berichtet das Umweltbundesamt. Sie sind nur ein Vorgeschmack auf die Umbrüche, die dem Land bevorstehen. Weil sich vieles davon nicht mehr verhindern lässt, müssen sich Behörden, Betriebe und Bürger anpassen.“

Im zweiten Teil „Es gibt kein Entweder – oder“ durfte die UBA-Chefin und ausgebildete Soziologin ein Interview bestreiten: „Maria Krautzberger über den zähen Kampf gegen die Erderwärmung und Katastrophenschutz als letztes Mittel.“

Dabei konnte sie zeigen, wodurch sie sich für dieses politisch wichtige Amt empfohlen hat, zu dem Kenntnis, oder Akzeptanz von Faktenwissen ein erhebliches Hindernis bedeutet (hätte). Denn munter wiederkäut sie politisch korrekt die IPCC-Standard-Statements im Monitoringbericht ihrer eigenen Behörde – gegen die Fakten.

—————————————————————————————————————————–

Hinweis d.A. :

Als „Klimawandel“ ohne Zusatz wird in folgendem immer der anthropogen (CO2-) bedingte Wandel verstanden. Nach „Text:“ folgen Auszüge aus dem Bericht.

—————————————————————————————————————————–

Was im UBA-Monitoring-Bericht 2015 steht

Wenn Deutschland etwas macht, dann gründlich. Die Akademikerschwemme will beschäftigt werden. Und für den Klimawandel ist immer Geld vorhanden – zumindest, wenn er verzweifelt gesucht werden muss. Entsprechend liest sich der Bericht mit 258 Seiten als Arbeitsbeschaffungsmaßnahme für alle, die das Wort Klimawandel bereits richtig aussprechen können. Es werden 97 Klimaindikatoren gemonitort und auf einen Beleg für den Klimawandel „abgeklopft“. Dazu gehören z.B. auch witterungsbedingte Unfälle, Temperaturindex der Vogelartengemeinschaft, (psychische) Betroffenheit durch die ständige „Androhung“ von Stürmen und Hochwasser, Zugriffe auf Klima-Apps usw. Am Bericht selbst sind 54 gelistete Institutionen beteiligt.

Und das Fazit daraus?

Da wohl nicht jeder Leser die lange Sichtung bis zum Schluss durchlesen will, anbei die Meinung des Verfassers. Der Bericht zeigt deutlich, dass praktisch nichts in Deutschland auf den messbaren Einfluss eines anthropogenen Klimawandels hinweist. Das Klima ändert sich natürlich – aber eben nicht „unnatürlich“. Im Grunde haben wir aktuell nichts anderes als das schlechte Wetter, über das sich schon Napoleon beklagt hatte.

Nach der Sichtung plagt einen jedoch eine schlimme Ahnung. Wenn es bereits im Klima-gemonitorten Deutschland nicht möglich ist, den Klimawandel zu belegen, bzw. belastbare Daten zu erfassen, wie schafft das der IPCC dann angeblich weltweit? Was nutzen die Massen an peer-reviewten Papern, wenn die Daten noch wesentlich ungenauer und noch stichproben-artiger sind?

—————————————————————————————————————————–

Monitoringbericht 2015 zur Deutschen Anpassungsstrategie an den Klimawandel;

Bericht der Interministeriellen Arbeitsgruppe Anpassungsstrategie der Bundesregierung

—————————————————————————————————————————–

Welche Auswirkungen hat der Klimawandel und wie bereiten wir uns vor?

Text: Treibhausgase, die jetzt in der Atmosphäre sind, beeinflussen das Klima der nächsten Jahrzehnte. Sich auf diese Veränderungen vorzubereiten, heißt, rechtzeitig und aktiv auf Klimaänderungen zu reagieren, die bereits nicht mehr vermeidbar sind. Dies gilt, auch wenn noch nicht alle Zusammenhänge aufgeklärt sind und das mögliche Ausmaß der Klimafolgen heute in vielen Bereichen noch nicht im Einzelnen absehbar ist. Gleichzeitig muss der Klimaschutz zügig voranschreiten, um zu verhindern, dass mit steigenden Treibhausgaskonzentrationen die klimatischen Veränderungen zunehmen und die Anpassungszwänge weiter wachsen.

Auswertung

Eine Analyse ohne Statistik ist nicht vollständig. Also zählen wir die Verwendung geeigneter Kennwörter, um ein Bild zu bekommen, ob die Verfasser nicht heimlich Aussagen hinterlegt haben, die offiziell nicht verkündet werden durften.

Die Worte "sicher / gesichert“

kommen im ganzen Bericht nur 3 (drei!) mal vor. Zur Temperaturerhöhung seit 1881, zur Erhöhung der Anzahl heißer Tage, und weil die Wasserversorgung auch in Zukunft gesichert ist.

Bei den Begriffen "nicht gesichert" und „nicht verändert“ habe ich ab 50 aufgehört weiterzuzählen.

Begriffe der Unsicherheit in umschreibender Form wie "es wird davon ausgegangen" , "es wird diskutiert" , "ist zu erwarten" , "es liegt nahe" , "ein Einfluss des Klimawandels ist anzunehmen" , "es könnte …" , "nicht signifikant verändert" , "Unschärfen der Interpretation …“ … ziehen sich konsequent durch praktisch alle Kapitel. Wegen der Variabilität der (Um-)Schreibungen ist ein Zählen sehr aufwendig und wurde deshalb nicht durchgeführt.

Fazit

Vergleicht man die "sicheren“ mit den "ungesicherten“ Fakten, dann tut sich ein Abgrund auf. Er zeigt aber, der Bericht ist bis auf wenige Kapitel ehrlich, die daraus abgeleiteten Aussagen sind es nicht.

Exemplarische Sichtung einzelner Kapitel

Temperatur

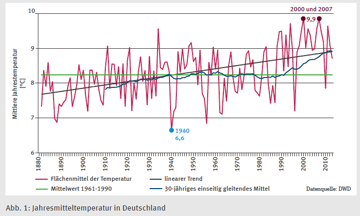

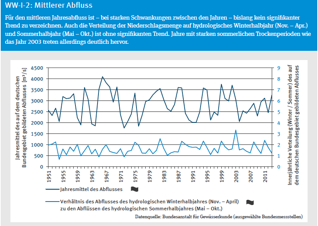

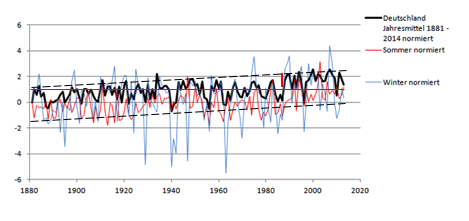

Text: Das Jahresmittel der Lufttemperatur ist im Flächenmittel von Deutschland von 1881 bis 2013 statistisch gesichert um 1,2 Grad angestiegen* (Abb. 1). Auch im Vergleich der Klimareferenzperiode (1961-1990) zum aktuellen Bezugszeitraum (1981-2010) ist der Mittelwert der Lufttemperatur in Deutschland von 8,2 °C auf 8,9 °C gestiegen.

Was zeigt die eigene Auswertung

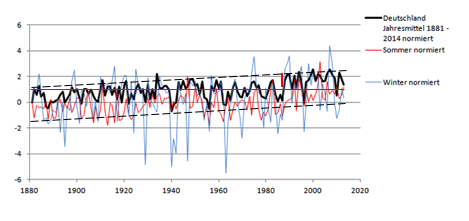

Bild : Die auf den Startwert 1881 normierten Deutschlandtemperaturen

(gleicher Datensatz wie im Bericht)

Man sieht, dass die Temperatur seit 1880 stetig in einem Trendkanal (leicht) wärmer wird. Schon das ist vollkommen unspektakulär und kann nicht als Klimawandel interpretiert werden.

Würden die extremen Winter von 1930 bis 1965 wegfallen, hätte es damals schon die aktuelle heutige Mitteltemperatur gegeben. Und aktuell haben wir wieder die Temperatur von 1881.

1990 scheint etwas passiert zu sein, was aber nicht mit dem Klimawandel zusammenhängen kann, denn der kann nicht so sprunghaft erfolgen. Vielleicht war es ein el Nino oder einfach eine Datenhomogenisierung, aber sicher nicht das CO2.

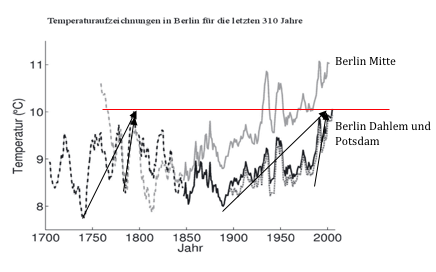

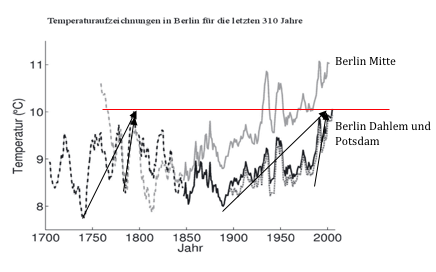

Bild : Langfristverlauf Stationen Berlin

(Anm.: der Verlauf Hohenpeißenberg zeigt das gleiche Schema)

Betrachtet man zusätzlich den Langfristverlauf am Beispiel Berlin (für Deutschland gesamt fanden sich keine für Privatpersonen recherchierbaren Daten), dann sieht man ebenfalls, dass die aktuelle Temperatur nichts besorgniserregendes sein kann. Schnelle Anstiege / Abfälle erfolgten auch früher und damals in noch „schlimmerer“ Ausprägung.

Fazit

Der Temperaturverlauf Deutschlands ist vollkommen unspektakulär. Ein CO2-Einfluss oder der ominöse „Kipp-Punkt“ sind nirgends zu erkennen. Auf eine Erwähnung der ca. 20-jährigen Stagnation der letzten Jahre hat man ganz verzichtet.

Demnach gibt es keinerlei Anlass zu einer Panik. Es bleibt aber die Frage, warum kein Hinweis auf die aktuelle Stagnation zu finden ist, und warum eine Darstellung und fundierte Interpretation der Langfristverläufe ebenfalls unterlassen wurde.

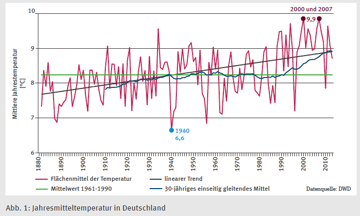

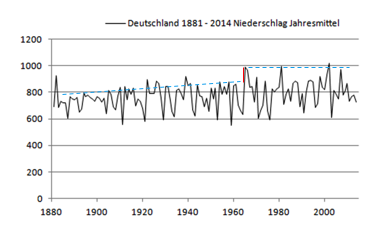

Niederschlagsmengen

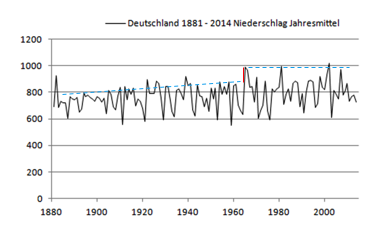

Text: In der Summe ergibt sich daher im Flächenmittel von Deutschland seit 1881 ein Anstieg der mittleren jährlichen Niederschlagsmenge von 10,6 %.

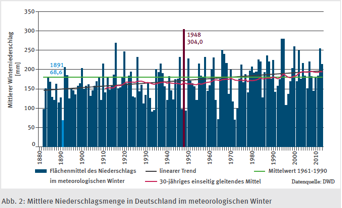

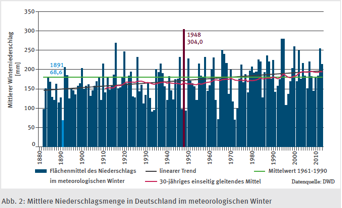

Text: Die stärksten Änderungen wurden bislang für den Winter beobachtet. Wie Abbildung 2 zeigt, hat das Flächenmittel der mittleren Niederschlagsmenge seit dem Winter 1881 / 1882 um 28,0 % zugenommen.

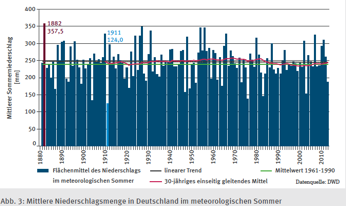

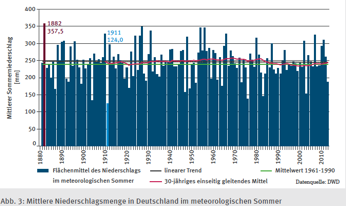

Text: Für die Sommermonate lässt sich bislang kaum eine Änderung feststellen. Zwar hat die mittlere Niederschlagsmenge zu dieser Jahreszeit seit 1881 um 1,2 % abgenommen, jedoch lässt sich aus diesem minimalen, im Bereich der natürlichen Variabilität liegenden Rückgang nicht einmal auf eine Tendenz schließen (Abb. 3).

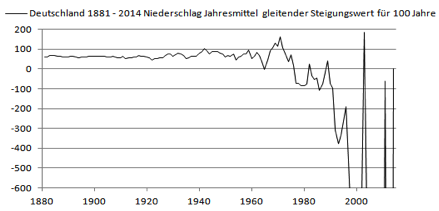

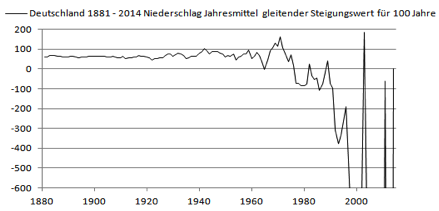

Die eigene Auswertung zeigt :

Das Niederschlags-Jahresmittel fehlt im Bericht als Grafik, deshalb hier das aus dem DWD-Datensatz selbst ermittelte anbei.

Bis ca. 1960 bleibt der Niederschlags-Anstieg konstant. Aber dann könnte man fast vermuten, dass um 1960 etwas passiert ist, was mit dem Klimawandel gar nichts zu tun hat.

Im Bericht steht nichts dazu.

Allerdings wird man bei Google fündig. Die Erhöhung um 1960 soll den damaligen Atombombenversuchen geschuldet sein, deren Aerosole den Niederschlag verstärkten. Unabhängig davon, ob das stimmt, nimmt der Jahresniederschlag seitdem wieder ab, was eine Auswertung der gleitenden Geraden-Steigung (Endpunkt 2014) deutlich zeigt.

Fazit

Eine Änderung der Niederschlagsmenge seit 1881 um +10,6 % darf man sicher als absolut unspektakulär bezeichnen, vor allem, da diese bereits 1881 begann. Zudem ist der geänderte Verlauf ab 1960 nicht dem Klimawandel zuzuordnen. Da sie seitdem auch wieder abnimmt (zeigt im Bericht die Abb.8 seit 1990 ebenfalls deutlich), kann als ziemlich sicher gelten, dass der alte Trendwert bald wieder erreicht ist. Ein Indiz könnte auch der Winter 2014/15 sein, der die niedrigste Niederschlagsmenge seit „Menschen-Gedenken“ aufwies (wo der Klimawandel doch zwingend nassere Winter fordert).

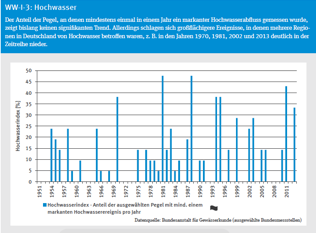

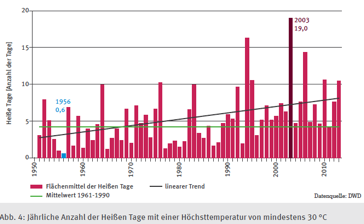

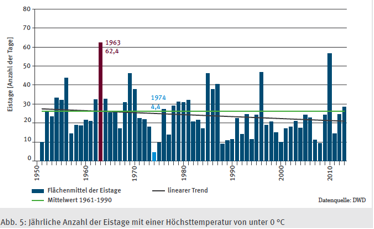

Änderungen der Extreme

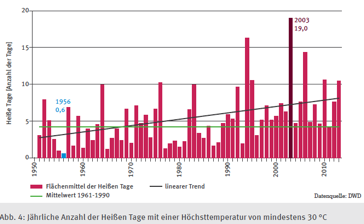

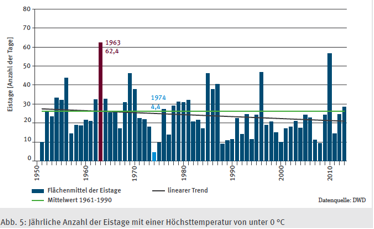

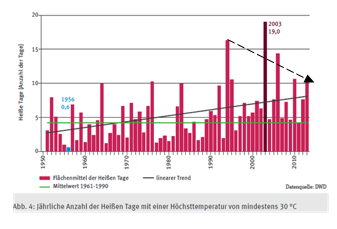

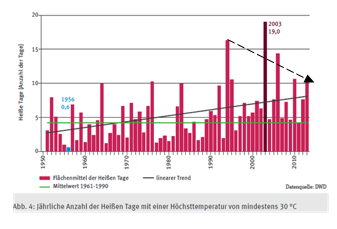

Text: Seit 1951 hat die Anzahl der Heißen Tage im Flächenmittel von Deutschland von im Mittel etwa drei Tagen pro Jahr auf derzeit im Mittel etwa acht Tage pro Jahre zugenommen (Abb. 4).

Dieser Anstieg ist trotz der großen Variabilität dieses Index von Jahr zu Jahr statistisch gesichert. Demgegenüber ist die Abnahme der mittleren Anzahl der Eistage von rund 27 Tagen pro Jahr auf derzeit etwa 21 Tage pro Jahr deutlich weniger markant und statistisch auch nicht nachweisbar (Abb. 5). … In den vergangenen zehn Jahren ist die Zahl der Heißen Tage wieder leicht zurückgegangen, dennoch gab es im Süden und Osten nach wie vor weitverbreitet mehr als zehn solcher Tage pro Jahr.

Die eigene Auswertung zeigt

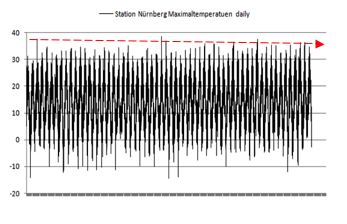

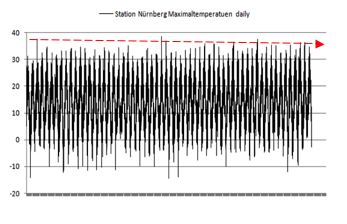

Leider sind beim DWD keine globalen Temperaturdaten Deutschlands in Tagesauflösung (frei) verfügbar. Deshalb muss die Interpretation anhand eines Bildes aus dem Bericht und einer exemplarischen Station (im Süden, wo die Anzahl höher sein soll) erfolgen.

Station Flughafen Nürnberg 1950 – 2015 Maximalwerte

Fazit

Die sprunghafte Änderung nach 1990 kann nicht von CO2 verursacht sein (so schnell kann das Klima auf die geringe relative Erhöhung nicht reagieren). Zudem pendelt sich dieser Sprung auch schon wieder ein und hat aktuell schon den Wert von 1960 „zurückerobert“. Bedenkt man, dass dabei sicher auch noch Wärmeinseleffekte „mitspielen“, bangt man eher, ob die wenigen schönen Sommer schon wieder der Vergangenheit angehören.

Die DWD-Station Nürnberg zeigt seit 1950 überhaupt keine signifikante Änderung, aber deutlich die natürliche hohe Variabilität der Tagestemperaturen.

Anm.: Trotzdem hat die Uni Erlangen der damals neu ernannten Nürnberger Klimamanagerin in einer Expertise pflichtbewusst bestätigt. dass Nürnberg sehr vom Klimawandel betroffen sei ("sein kann"). Dies setzt Nürnberg – das sowieso kein Geld hat – auch eifrig um (Politikerweisheit: wenn man kein Geld hat, macht noch weniger auch nichts mehr aus).

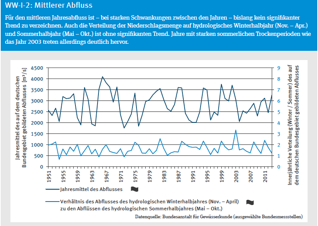

Niederschlag

Text: Die zeitliche Entwicklung der Flächenmittelwerte beider Extremindizes ähnelt grundsätzlich dem Verlauf der mittleren Niederschlagsmengen zur jeweiligen Jahreszeit. Im Winter haben daher nicht nur die mittleren Niederschlagsmengen um 28 % zugenommen, sondern auch das Flächenmittel der maximalen 5-Tagessumme ist von im Mittel rund 38 mm zu Beginn des Auswertungszeitraums um ca. 7 mm auf aktuell im Mittel etwa 45 mm angestiegen (Abb. 8). Infolge der großen Unterschiede dieses Index von Jahr zu Jahr ist dieser Anstieg derzeit aber statistisch nicht gesichert. Die Zahl der Tage mit einer Niederschlagssumme von 20 mm und mehr im Sommer ist dagegen seit 1951 nahezu unverändert geblieben und verläuft somit ebenfalls parallel zu der Entwicklung der mittleren Niederschlagsmengen in den Monaten Juni bis August.

Hinsichtlich der Anzahl der Tage mit einer Niederschlagsmenge von mehr als 20 mm im Sommer sind hingegen – in guter Übereinstimmung mit der Entwicklung der mittleren Niederschlagsmengen zu dieser Jahreszeit – über eine auch nur regional und sehr schwach ausgeprägte dekadische Variabilität hinaus bislang keine Änderungen auszumachen (Abb. 10).

Fazit

Dem Berichtsteil braucht man nichts hinzuzufügen. Er sagt einfach, dass die dauernden Meldungen über vorhandene und zu erwartende Sintflut-Regenfälle schlichtweg falsch sind, es gibt sie nicht.

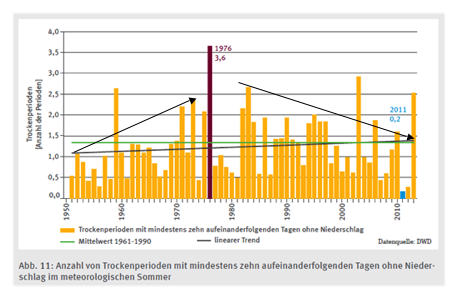

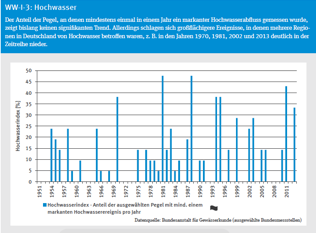

Trockenheit

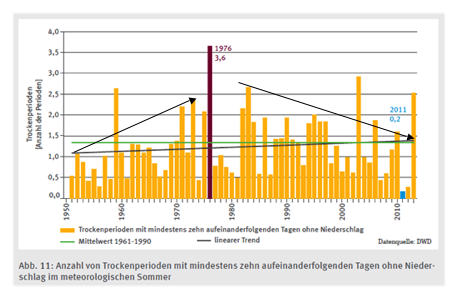

Text: Neben der Frage nach der Veränderung der Starkniederschläge ist insbesondere im Sommer auch von großer Wichtigkeit, inwieweit die Erwärmung mit einer zusätzlichen Austrocknung einhergeht. Dementsprechend soll noch die Veränderung der Häufigkeit von Trockenperioden betrachtet werden. Hierzu wird die Anzahl der Episoden mit mindestens zehn aufeinanderfolgenden Tagen ohne Niederschlag ausgewertet.

Wie Abbildung 11 zeigt, ist die Anzahl solcher Trockenperioden im Flächenmittel von Deutschland seit 1951 um ca. 0,3 Ereignisse pro Jahr geringfügig angestiegen. Bereits aufgrund der Seltenheit solcher Ereignisse mit einem Mittelwert von nur 1,3 Fällen pro Jahr im klimatologischen Referenzzeitraum 1961-1990 sowie der extrem hohen Variabilität von Jahr zu Jahr ist aber auch diese Zunahme bislang statistisch keineswegs gesichert. Hinzu kommen ausgeprägte natürliche Schwankungen mit abwechselnden Phasen stärker und geringer ausgeprägter Trockenheit, die sich deutlich in der räumlichen Entwicklung der mittleren Anzahl dieser Trockenperioden abzeichnen (Abb. 12).

Anm. zum Bild: Die schwarzen Pfeile wurden durch den Verfasser zugefügt.

Fazit

Auch hierzu braucht man dem Bericht nichts hinzuzufügen. Er sagt einfach ehrlich, dass sich diesbezüglich überhaupt nichts verändert hat.

==================================================

Ende von Teil 1 ; Teil 2 folgt

==================================================

Anm. EIKE-Red.: Anbei die komplette PDF zum Download

Über den Autor:

Helmut Kuntz absolvierte ein Hochschulstudium mit den Schwerpunkten Messtechnik und Statistik. Er analysiert deshalb nicht Klimatheorien, sondern die in den Studien vorgenommenen, statistischen Auswertungen und prüft sie auf Plausibilität (auch im Vergleich mit anderen Publizierungen). Die dabei gewonnenen Ergebnisse vergleicht er abschließend mit den oft als Pressemitteilung publizierten Kurz-Aussagen. Sein Ergebnis: Die Pressemitteilungen melden oft etwas anderes, als in den Studien ermittelt wurde (so dass man auf die Idee kommen könnte, diese werden teilweise unabhängig von den Studien vor-geschrieben).

Related Files