Die Säulen der Energiewende wanken – Der weitere Ausbau von Wind- und Solarstrom ist sinnlos.

Es ist bereits mehrfach dargelegt worden, dass es sich dabei um eine katastrophale Fehlentscheidung handelt, weil die Versorgungssicherheit bedroht wird, weil die Kosten untragbar hoch werden und weil insbesondere der Ausbau der Windkraft nicht nur zu massiven Naturschäden, sondern auch sogar zu einer Bedrohung der Gesundheit der Menschen führt.

Obwohl das begründet und bewiesen wurde, hat sich die Regierung bisher unbeeindruckt gezeigt.

Eine nähere Prüfung der bisherigen Entwicklung führt nun zu überraschenden Ergebnissen:

Wir verdanken Rolf Schuster die minutiöse Verfolgung und Darstellung der Stromerzeugung aus Wind- und Solaranlagen, deren Verlauf er über mehrere Jahre durch Auswertung der EEX-Strombörsedaten sowie der Informationen von Übertragungsnetzbetreibern (z.B.TenneT) in zahlreichen Grafiken dokumentiert hat. Auch in diesem Papier verwende ich mehrfach seine Dokumentationen.

In den Darstellungen der in den vergangenen Jahren gemessenen Leistungserzeugung von Photovoltaik-Anlagen (Abb.1), Land-Windkraftanlagen (Abb.2) sowie Offshore-Windparks (Abb.3) sind in den Abbildungstexten bereits Anmerkungen zu dem wachsenden Auseinanderdriften der installierten Kapazitäten einerseits und den von diesen tatsächlich produzierten elektrischen Leistungen andererseits angestellt worden.

Abb 1: Tatsächliche Leistung aller installierten Photovoltaikanlagen im Zeitraum 2011 – März 2015. Obere Grenze des gelben Bereichs: Die installierte Leistung aller PV-Anlagen. Der Leistungsgang besteht aus 365 „Nadeln“ im Jahr, die täglich zwischen ca. 9:00 und 15:00 Uhr auftreten und je nach Wetterlage mehr oder weniger hoch sind. Niemals erreichen sie die installierte Maximalleistung. In den Wintermonaten – bei maximalem Strombedarf – bricht die PV-Leistung fast völlig ein. Quelle: EEX; Darstellung: Rolf Schuster

Der Blick auf die besonders teure Solarstromerzeugung – siehe Abb.1 – zeigt, dass sich im Laufe der letzten 3 Jahre zwar die installierte Leistung deutlich erhöht hat, nicht jedoch die erzeugte Leistung.

Abb.2: Gesamte aktive Windstromleistung Deutschlands 2011 – März 2015. Obere rote Linie: Installierte Maximalleistung der Anlagen. Quelle: EEX Leipzig; ab 2015 ÜNB. Darstellung Rolf Schuster

Abb.3: Leistung der Offshore-Windparks Sept. 2009 – Sept. 2014. Mehrere starke, z.T. längere Leistungseinbrüche durch technische Probleme. Die Fortsetzung in 2015 wies für Januar eine Leistungserzeugung von Null bis 400 MW und für März Null bis 750 MW aus – bei einer installierten Leistung von 1.700 MW im Januar und 1.850 MW im März. Quelle: TenneT-TSO, Darstellung Rolf Schuster

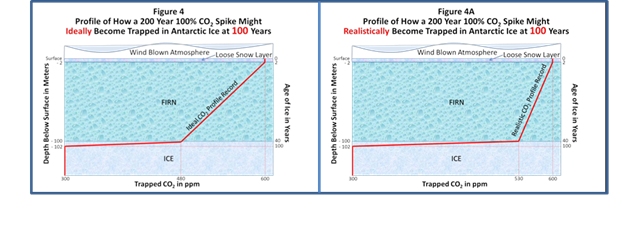

Aus der Darstellung der kombinierten Leistungserzeugung aller Wind- und Solarstromanlagen zwischen

2012 und dem Frühjahr von 2015 (Abb.4) erschließt sich diese Diskrepanz besonders deutlich.

Abb.4: Die Leistungserzeugung von Wind- und Solarstrom zusammen – von 2011 bis März 2015. Die Solarstrom-„Nadeln“ treten vom Frühling bis Herbst auf; im Winter nur Windstrom – mit großen Schwankungen durch Starkwind-Ereignisse. Abgesehen von diesen Windstromspitzen ist keine Erhöhung der Gesamtleistung über den 3-jährigen Zeitraum erkennbar, obwohl in dieser Zeit die Installierte Leistung aller Anlagen von 44.000 MW auf 80.000 MW gesteigert wurde. Quelle: EEX Leipzig; ab 2015 ÜNB. Darstellung Rolf Schuster

Bereits auf den ersten Blick erkennt man die Merkwürdigkeit:

Während die Summe der Erzeugungskapazitäten in diesem Zeitraum von 44.000 MW auf enorme 80.000 MW anstieg, dümpelte die produzierte Leistung in einem „Durchschnitt“ von geschätzt 3.000 MW dahin – dies jedoch als völlig ungesicherte Leistung. Dazu muss bemerkt werden, dass es im Grunde angesichts des zerrissenen und stark fluktuierenden Leistungsverlaufs, der auch immer wieder auf Null einbricht, überhaupt keinen Mittelwert geben kann, der irgendetwas aussagt. In den Sommermonaten zeigt sich Solarstrom um die Mittagszeit; im Winter ausschließlich stark fluktuierender Windstrom.

Auffallend ist nun die ausbleibende Zunahme der Erzeugung trotz des starken Zubaus an Anlagen. Das einzige, was sich z.B. 2014 gegenüber 2012 geändert hat, ist die Höhe der Windstrom-Spitzen bei Starkwindereignissen.

Rolf Schuster hat die Minimal- und Maximalwerte der jeweiligen Jahre durch eine Datenbankabfrage ausgewertet und kommt zu dem Ergebnis, „dass der Minimalwert (bei zunehmender installierter Leistung) keinen positiven Trend erkennen lässt, wo hingegen die Maximalwerte enorm angestiegen sind.“

Hier hat wieder die Physik zugeschlagen: Weil sich die Leistung eines Windrades mit der 3. Potenz der Windgeschwindigkeit ändert, bedeutet jede Periode geringerer Windgeschwindigkeiten, dass die Windrad-Leistung auf Null einbricht. Daher werden Windkraftanlagen diese Null-Einbrüche niemals los.

Bei Starkwind hingegen wirkt dieses Gesetz in gleicher Weise: Das Windrad läuft in Richtung seiner Maximalleistung hoch.

Für die Netzbetreiber werden deshalb die zu bewältigenden Fluktuationen des Windstroms mit dessen zunehmendem Ausbau immer bedrohlicher.

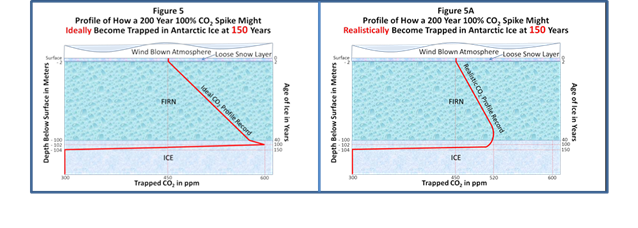

Abb.5: Windstrom-Leistung 2006-2013. Es wurden die Viertelstunden-Extremwerte – also maximale bzw. minimale Viertelstunden-Leistung je Monat dargestellt. Quellen: EEX, IWET; Darstellung: E. Wagner 2.12.2013

Eine gleichfalls aufschlussreiche Darstellung von E. Wagner zeigt Abb.5. Bei den Viertelstunden-Maximalwerten der Leistung setzt ab 2011 eine Stagnation ein. Dass die Maximal-Spitzen mit zunehmender WKA-Zahl höher werden, entspricht R. Schusters Feststellung.

Interessant ist aber auch die Betrachtung der minimalen Viertelstundenleistung über die 8 Jahre: Sie liegt durchgehend bei Null. Und daran ändert auch die Vermehrung der Windräder nichts. Was alle – bis auf die Regierung – schon immer wussten: Hochdruck-Wetterlagen, die weit größere Ausdehnungen besitzen als das kleine Deutschland, bedeuten Flauten – also Null Windstrom, und das auch immer wieder einmal für zwei oder mehr Wochen am Stück.

Rolf Schuster hat sich auch das Leistungsäquivalent des Wind- plus Solarstromangebots und dessen Veränderung im Laufe der Jahre näher angesehen:

Dies ist der Quotient von realer Einspeiseleistung dividiert durch die installierte Leistung. Das Ergebnis: Dieses Leistungsäquivalent sinkt stetig mit wachsendem Ausbau – von 0,15 auf 0,125 in den letzten 4 Jahren.

Für die Ergebnisse dieser Dokumentationen gibt es mehrere, vermutlich gleichzeitig zutreffende Erklärungen:

1. Der Zubau an Windrädern erfolgt immer öfter in besonders ungeeigneten Regionen Mittel- und Süddeutschlands. Dort erzeugen auch besonders große Schwachwindanlagen (bereits diese offizielle Bezeichnung ist eine fachliche Bankrotterklärung) weit weniger Strom als kleinere Anlagen in Norddeutschland.

2. Der teilweise länger andauernde Ausfall von Offshore-Windparks beginnt sich auf die Bilanz der gesamten Windkraft negativ auszuwirken. Von dem „wichtigen Standbein“ ist keine Rede mehr.

3. Auch die Photovoltaik (PV) leidet unter einem zunehmenden Mangel geeigneter Flächen (Süddächer) – und wohl auch an einer abnehmenden Neigung von Hauseigentümern, sich darauf einzulassen.

4. Bei PV-Anlagen gilt das Umgekehrte wie bei Windrädern: In Süddeutschland gibt es die relativ höchsten Erträge. Jeder Solarstrom-Ausbau in Mittel- und Norddeutschland führt zu deutlich geringeren Erträgen.

5. Die mit den Jahren zunehmende Degradierung der Solarmodule könnte sich bei vielen älteren Anlagen bemerkbar machen.

6. Ein von der Lobby gerne benutztes Argument, dass es sich jeweils leider um ein besonders schlechtes Windjahr/Sonnenjahr gehandelt habe, kann den sehr deutlichen Trend zu einer Stagnation von Wind- und Solarstrom nicht erklären.

Die Konsequenzen dieser bereits abgelaufenen Entwicklung:

· Die oben genannten Ziele der Regierung sind in Bezug auf den künftigen Anteil der „Erneuerbaren“ an der Stromerzeugung unerreichbar. Durchaus erreichbar ist natürlich das kostspielige Vollpflastern Deutschlands mit Windrädern und PV-Anlagen. Nur nutzt es nichts – außer der Lobby.

· Sehr ernst zu nehmen ist das Anwachsen größter Windstrom-Leistungsspitzen im Winter.

· Die zunehmende Landschaftsverschandelung, die Gesundheitsgefährdung der Menschen, die Tötung von Greifvögeln und Fledermäusen und die Gefährdung der Netzstabilität sind somit die einzigen verbleibenden Auswirkungen eines weiteren Ausbaus der Windkraft.

· Wind- und Solarstrom tragen auch bei größtem weiterem Ausbau nichts zur gesicherten Leistung bei. Ohne Kohlekraftwerke wird auch künftig nicht gehen.

· Der Beitrag der beiden „Erneuerbaren“, die angeblich die zentralen Stützen der Energiewende sind, zur Stromversorgung kann allenfalls nur noch geringfügig wachsen und kaum ein einziges konventionelles Kraftwerk ersetzen. Andererseits sollen aber die noch verbliebenen 8 Grundlast-Kernkraftwerke eins ums andere vom Netz genommen werden. Nur Kohlekraftwerke können sie ersetzen, deshalb sind sämtliche CO2-Einsparungsziele der Regierung Makulatur.