Climategate Fortsetzung: Wir wir IMMER NOCH mit gefälschten Daten zur globalen Erwärmung hinters Licht geführt werden

Bild rechts: Manipulation! Quelle: w.r.wagner / pixelio.de

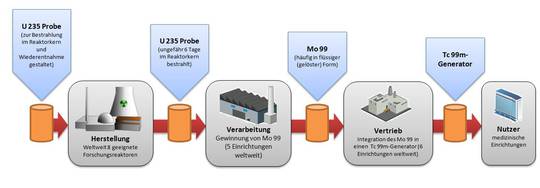

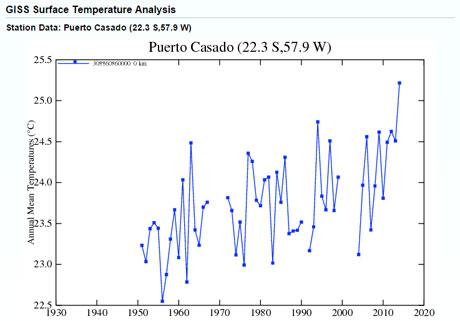

Verwirrt durch jene Behauptungen über das Jahr 2014 („das wärmste jemals“), welche angeführt wurden durch den meistgenannten aller fünf offiziellen globalen Temperaturreihen – nämlich der vom GISS – untersuchte Homewood eine Stelle in der Welt, an der die Temperatur den GISS-Daten zufolge stärker gestiegen sein soll als an fast jeder anderen Stelle des Globus‘: Ein großer Gebietsstreifen in Südamerika, der sich von Brasilien bis nach Paraguay erstreckt.

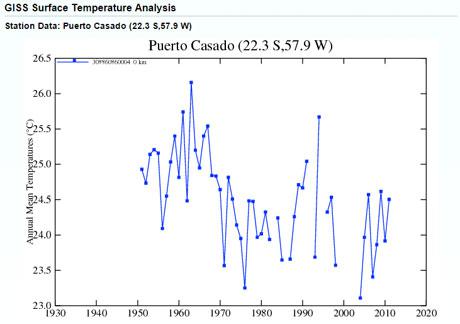

Da er wusste, dass es in diesem Streifen kaum Wetterstationen gab, entschloss er sich, sich auf drei ländliche Stationen zu konzentrieren, die ein großes Gebiet in Paraguay abdecken. GISS zeigte in diesem Gebiet zwischen 1950 und 2014 einen besonders steilen Anstieg der Temperatur von über 1,5°C: das ist doppelt so stark wie die akzeptierte globale Zunahme für das gesamte 20. Jahrhundert.

Aber als Homewood dann in der Lage war, die GISS-Angaben mit den Originaldaten zu vergleichen, aus denen sie abgeleitet worden waren, stellte er fest, dass sie verändert worden waren. Weit entfernt davon, wie die neue Graphik einen Anstieg zu zeigen, ist die Temperatur den Originaldaten zufolge während dieser 65 Jahre um ein ganzes Grad Celsius zurückgegangen. Als er mit den anderen beiden Stationen das Gleiche getan hat, fand er genau das Gleiche. In jedem Falle zeigten die Originaldaten keinen Anstieg, sondern einen Rückgang.

Tatsächlich hatte Homewood einfach ein weiteres Beispiel unter Tausenden von Beweisstücken entdeckt, die während der letzten Jahre ans Licht gekommen waren und zeigten, dass etwas sehr Seltsames mit den Temperaturdaten passiert war, auf die sich die Wissenschaftler der Welt so stützen. Und besonders gilt das für das IPCC, das die größte und teuerste Angstmache aller Zeiten losgetreten hat: den Glauben nämlich, dass sich die Welt im Würgegriff einer beispiellosen Erwärmung befindet.

Wie konnte es dazu kommen, dass man uns gesagt hat, dass die globalen Temperaturen einen großen Sprung nach oben vollzogen haben auf ihr höchstes Niveau seit 1000 Jahren? In Wirklichkeit war der Anstieg nicht stärker als während ihrer Aufwärtssprünge zwischen 1860 und 1880 sowie zwischen 1910 und 1940. Diese Anstiege waren Teil der graduellen natürlichen Erwärmung, seit die Welt aus der Jahrhunderte langen „Kleinen Eiszeit“ herausgekommen war.

Dieser Glaube wurde vollständig auf fünf offizielle Datensätze übertragen. Drei davon basieren auf Messungen an der Erdoberfläche, deren Versionen dann vom GISS, der NOAA und von HadCRUT4 zusammengestellt worden waren. Die anderen beiden Datensätze wurden aus Satellitenmessungen abgeleitet und dann von Remote Sensing Systems (RSS) [Remote Sensing = Fernerkundung] in Kalifornien sowie von der University of Alabama in Huntsville (UAH) zusammengestellt.

Die adjustierte Graphik vom GISS:

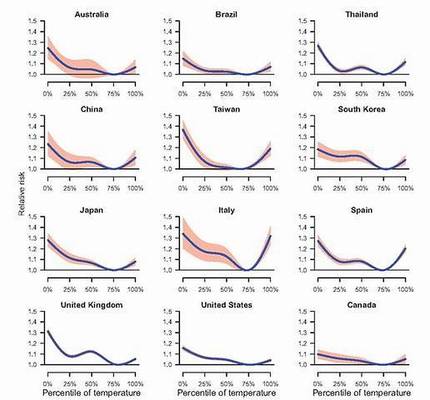

Während der letzten Jahre haben diese beiden sehr unterschiedlichen Messverfahren der globalen Temperatur zunehmend ziemlich unterschiedliche Ergebnisse erbracht. Die oberflächenbasierte Aufzeichnung zeigte einen so stark steigenden Temperaturtrend, dass man das Jahr 2014 als „das wärmste jemals seit Beginn von Aufzeichnungen“ nennen konnte. Unterdessen haben RSS und UAH während der letzten 18 Jahre überhaupt keinen Anstieg verzeichnet, und das Jahr 2014 rangierte nur an sechster Stelle der wärmsten Jahre seit 1997.

Eine Überraschung ist, dass diese drei Aufzeichnungen von der Erdoberfläche alle von passionierten Gläubigen an die vom Menschen verursachte globale Erwärmung betrieben worden sind, wobei im Grunde alle Festlandsdaten nur aus einer einzigen Quelle stammen. Dabei handelt es sich um das Global Historical Climate Network (GHCN), betrieben vom US National Climate Data Center der NOAA, welche wiederum dem US Department of Commerce untersteht.

Aber zwei Aspekte dieses Systems der Messung oberflächennaher Temperaturen am Boden haben schon lange eine zunehmende Zahl von Statistikern, Meteorologen und wissenschaftlichen Experten-Bloggern die Stirn runzeln lassen. Ein Aspekt ist, dass das vermeintlich weltweite Netzwerk der Stationen, von denen das GHCN seine Daten bezieht, ein Betrug ist. Bis zu 80% der Erdoberfläche sind überhaupt nicht mit Stationen abgedeckt. Außerdem wurde um das Jahr 1990 die Anzahl der Stationen mehr als halbiert von 12.000 auf weniger als 6000 – und die meisten verbliebenen Stationen konzentrieren sich in städtischen Gebieten oder an Stellen, von denen Studien gezeigt haben, dass sie dank des UHI um etwa 2 K höhere Temperaturen aufweisen als in der ländlichen Umgebung, wo Tausende Stationen einkassiert worden waren.

Hier folgen die Rohdaten in graphischer Form:

Um die riesigen Lücken zu füllen haben jene, die die Aufzeichnungen zusammenstellen das „von Computern berechnete Einfüllen“ eingeführt, wobei die höheren Temperaturen der verbliebenen Stationen auf riesige umgebende Gebiete projiziert worden sind (GISS gibt den Wert von Einzelstationen als für ein Gebiet gültig an, das bis zu 1,6 Millionen Quadratmeilen groß ist). Dieser Vorgang allein ergab schon einen scharfen Temperaturanstieg während der Jahre nach 1990.

Aber noch verwirrender waren die Beweise, dass selbst diese Daten danach Gegenstand fortgesetzter „Adjustierungen“ waren, und zwar ausschließlich in nur eine Richtung. Temperaturen aus früheren Zeiten wurden nach unten, die aus jüngerer Zeit nach oben korrigiert. Daraus ergibt sich der Eindruck, dass die Temperatur viel stärker gestiegen sei als aus den Originaldaten hervorgeht.

Ein frühes herausragendes Beispiel hiervon wurde von Steve McIntyre entdeckt, dem Statistiker, der die Trickserei hinter dem beim IPCC so beliebten „Hockeyschläger-Graph“ bloßgestellt hatte. Dieser zeigte bekanntlich im Gegensatz zu Beweisen zuvor, dass das Jahr 1998 das wärmste Jahr seit 1000 Jahren gewesen sei. Es war McIntyre, der im Jahre 2007 die gesamten nachträglichen Adjustierungen der US-Temperaturen zwischen 1920 und 1999 enthüllt hatte, die vom GISS (damals geleitet vom ausgesprochenen Klimaaktivisten James Hansen) zusammengestellt worden waren. Diese kehrten einen allgemeinen Abkühlungstrend um zu einem 80-jährigen Erwärmungstrend. Selbst Hansen hatte zuvor eingeräumt, dass die „Staubschüssel-Jahre“ in den dreißiger Jahren die wärmste Dekade in den USA im gesamten 20.Jahrhundert war.

Gewissenhafte Forscher haben seitdem zahlreiche ähnlich Beispiele aus der ganzen Welt gefunden, von den USA und Russland bis nach Australien und Neuseeland. In Australien wurden ein Abkühlungstrend von 1°C pro Jahrhundert in einen Erwärmungstrend von 2°C bis 3°C umgewandelt. In Neuseeland gab es einen massiven Aufstand der Akademiker, nachdem sich herausgestellt hatte, dass Daten, die zwischen 1850 und 1998 überhaupt keinen Trend zeigten, so adjustiert worden waren, dass sich ein Erwärmungstrend von 0,9°C pro Jahrhundert ergab. Diese verfälschte Version wurde natürlich in einem IPCC-Bericht hervorgehoben. Dies wurde ausführlicher auf dem Blog WUWT beleuchtet, dem Blog, der eine führende Rolle bei der Aufdeckung derartiger Machenschaften spielte und spielt [ein Hyperlink hierzu war im Original nicht angegeben].

Die bei Weitem umfassendste Dokumentation dieser Vergewaltigung sauberer Wissenschaft findet sich in einer für das Science and Public Policy Institute geschriebenen Studie mit dem Titel: „Surface Temperature Records: Policy-Driven Deception?“ von zwei altgedienten, erfahrenen US-Meteorologen, nämlich Joseph D’Aleo und Anthony Watts [kein Hyperlink genannt]. (Falls Warmisten versucht sind, diesen Artikel online zu kommentieren, wäre es willkommen, wenn sie ihre Kritik auf die Beweise richten könnten anstatt lediglich persönliche Attacken auf alle zu reiten, die ihre eigenen Ansichten nicht teilen).

[Dieser Zusatz von Booker ist an sich schon ein Skandal! Anm. d. Übers.]

Einen der provokativeren Punkte im Zuge der Debatte um 2014 als „dem wärmsten Jahr jemals“ stammt von dem kanadischen Akademiker Dr. Timothy Ball, der in einem kürzlich bei WUWT veröffentlichten Beitrag einen Eisbohrkern heranzog, um mit dessen Daten zu belegen, dass die gegenwärtigen Temperaturen der Erde unter den niedrigsten 3 Prozent aller aufgezeichneten Temperaturen seit dem Ende der letzten Eiszeit vor 10.000 Jahren rangieren.

In Wirklichkeit reichen die Implikationen solcher Verzerrungen von Daten viel weiter, als dass sie lediglich einen der bizarrsten Irrwege der Wissenschaftsgeschichte belegen. Die Tatsache, dass alle unsere Politiker auf diese Angst erzeugenden Schikanen hereingefallen sind, hat in UK [und natürlich nicht nur dort! Anm. d. Übers.] zur selbstmörderischsten Energiepolitik im Vergleich zu allen anderen Ländern geführt [Na, ich denke, da hat er nicht gründlich genug nach D geschaut! Anm. d. Übers.]

Aber mindestens ein Trost bleibt: Falls sie hoffen, im Dezember in Paris einen „universellen Klimavertrag“ unterzeichnen zu können, können wir ziemlich sicher sein, dass dies nicht wahrscheinlicher ist als dass das Jahr 2014 wirklich „das wärmste jemals“ war.

Übersetzt von Chris Frey EIKE