Modelle überschätzen 60-jährige dekadische Trends

Die jüngste Studie in dem Magazin Nature von Jochem Maritzke & Piers Forster mit dem Titel „Antrieb, Rückkopplung und interne Variabilität in globalen Temperaturtrends“ hat viel Aufmerksamkeit erregt, weil sie die Behauptung aufstellt, dass Klimamodelle gut sind und diese die Erwärmung trotz der beobachteten 17 Jahre Stillstand seit 1998 nicht überschätzen. Sie versuchen, dies zu belegen, indem sie zeigen, dass 15-Jahre-Trends in den HadCRUT4-Daten in CMIP5-Modellen erwartet werden können durch eine quasi zufällige interne Variabilität, während irgendwelche 60-Jahre-Trends deterministisch sind (anthropogen). Sie identifizieren ,deterministisch‘ und ,interne Variabilität‘ in den Modellen mittels einer Multi-Regressionsanalyse mit ihren bekannten Antrieben als Input.

![]()

Darin ist ∆F der Antrieb, α ist die Klima-Rückkopplung und κ der Anteil der Wärmeaufnahme durch die Ozeane und ε ist die zufällige Variation.

Dieses Verfahren wurde von Nick Lewis kritisiert und erzeugte eine endlose Diskussion auf den Blogs Climate Audit und Climate-Lab darüber, ob dieses Verfahren statistisch sinnvoll sei. Allerdings halte ich dies zum größten Teil für irrelevant, da es sich um eine Analyse der Differenz zwischen Modellen handelt und nicht um beobachtete Daten.

Erstens, die Hypothese, dass die gesamte interne Variabilität quasi-zufälliger Natur ist, ist wahrscheinlich falsch.Tatsächlich gibt es eindeutige Beweise einer 60-jährigen Oszillation in den GMST-Daten, [Global Mean Surface Temperature] möglicherweise im Zusammenhang mit AMO/PDO – siehe bei realclimate. In diesem Sinne sind vermutlich alle Modelle falsch, weil sie diese nicht-zufällige Verteilung nicht enthalten. Zweitens, wie ich zeigen werde, sind die beobachteten 15-Jahre-Trends bei HadCRUT4 selbst nicht quasi-zufällig. Drittens, ich zeige, dass die beobachteten 60-Jahre-Trends nach 1945 von den Modellen kaum beschrieben werden und dass im Wesentlichen alle Modelle bis 1954 höhere Trends prophezeit haben als beobachtet worden sind. Dies bedeutet, dass die ,deterministische‘ Komponente aller CMIP5-Modelle tatsächlich die GMST-Reaktion auf Treibhausgas-Konzentrationen überschätzen.

Beweise für regelmäßige Klima-Oszillationen

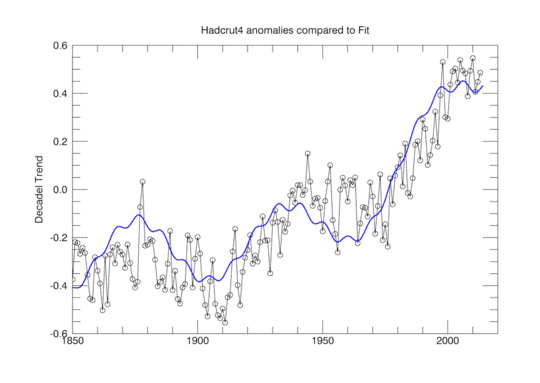

Abbildung 1 zeigt, dass die Bodendaten gut durch eine Formel (beschrieben hier) beschrieben werden können, die sowohl einen Term des Gesamt-CO2-Antriebs als auch einen Term der 60-Jahre-Oszillation enthält. Diese Formel lautet:

![]()

Die physikalische Rechtfertigung für eine solche 0,2°C-Oszillation ist die beobachtete PDO/AMO, die genau wie die ENSO die globalen Temperaturen beeinflussen können, jedoch über einen längeren Zeitraum. Kein Modell enthält gegenwärtig irgendeine solche regelmäßige natürliche Oszillation. Stattdessen wurde der Albedo-Effekt von Aerosolen und Vulkanen so frisiert, dass er mit GMST der Vergangenheit übereinstimmt und deren Schwingungen folgt. Viele andere haben diese Oszillation der GMST entdeckt, und sogar Michael Mann sagt jetzt, dass eine Abschwächung von PDO/AMO ursächlich für den Stillstand sein könnte.

15- und 60-Jahre-Trends in Beobachtungen und Modellen

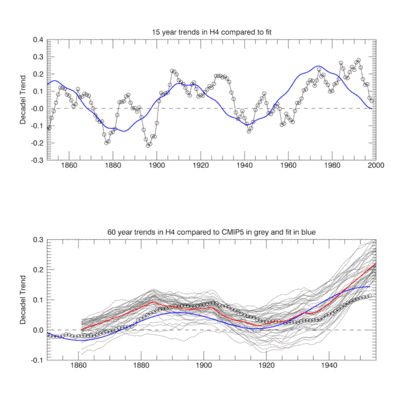

Ich habe die in der Studie von M&F beschriebene Analyse wiederholt. Ich benutze lineare Regressions-Anpassungen über Zeiträume von 15 und 60 Jahren der HadCRUT4-Daten und auch die o. g. angepasste Formel*. Zusätzlich habe ich 42 CMIP5-Modellsimulationen heruntergeladen der monatlichen Temperaturdaten von 1860 bis 2014. Dann habe ich die monatlichen Anomalien berechnet und diese danach über jedes Jahr gemittelt. Danach habe ich für jede CMIP5-Simulation die 15- und 60-Jahre-Trends berechnet für zunehmende Start-Jahre wie in M&F beschrieben.

[*Im Original lautet dieser Satz: I have repeated the analysis described in M&F. I use linear regression fits over periods of 15y and 60y to the Hadcrut4 data and also to the fitted equation described above.]

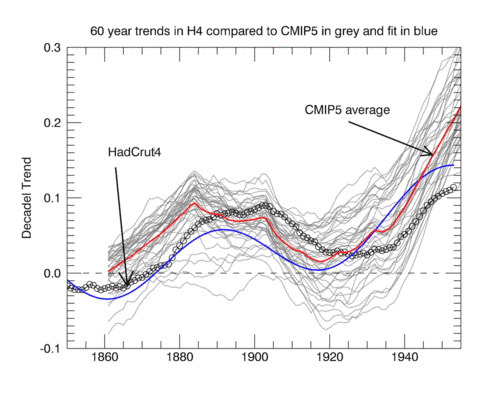

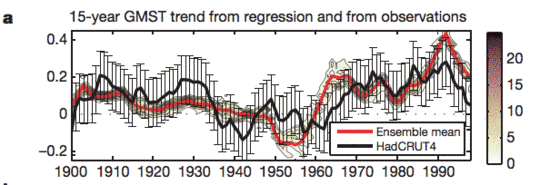

Abbildung 2 zeigt die berechneten 15-Jahre-Trends im HadCRUT4-Datensatz im Vergleich zu Trends aus der Anpassung. Zum Vergleich zeigen wir zuerst Abbildung 2a aus M&F unten.

Die Regressionsanalyse von M&F zeigt dann anschließend, dass die deterministischen Effekte in den CMIP5-Modellen für längere 60-Jahre-Trends dominieren sollten. Im Einzelnen beträgt der Fehler in den 60-Jahre-Trends, wie er von den Modellen vorgegeben wird, ± 0,081°C, das liegt um 30% unter der Zufalls-Variation. Daher kommt der Lackmus-Test der Modelle, wenn man die 60-Jahre-Modelltrends mit den Beobachtungen vergleicht, weil jetzt die statistische Variation viel kleiner ist. Hier folgen meine Ergebnisse:

Diese Analyse zeigt zwei Effekte, die M&F nicht erwähnt haben. Erstens, die 15-Jahre-Variation in den Trends der beobachteten Daten ist nicht zufällig, sondern zeigt ein periodisches Verhalten, wie es auch bei dem Fit auftritt. Dies ist charakteristisch für eine zugrunde liegende Klima-Oszillation. Die quasi-zufällige Variation in den CMIP5-Modellen wie in Abbildung 2a oben umfasst die Gesamt-Magnitude der Variation, aber nicht deren Struktur.

Zweitens zeigen die 60-Jahre-Trends auch eine viel kleinere, aber immer noch übrig bleibende Struktur, die die zugrunde liegende Oszillation reflektiert, gezeigt in blau. Der Spread in 42 Modellen ist natürlich deren unterschiedlichen effektiven Strahlungsantrieben und Rückkopplungen geschuldet. Die Tatsache, dass vor 1920 alle Modelltrends den beobachteten Trends folgen können, liegt teilweise an der Parametrisierung der Aerosole, um zu den Nachhersage-Temperaturen zu passen. Nach 1925 beginnen die beobachteten Trends, unter das Mittel von CMIP5 zu fallen, so dass bis zum Jahr 1947 sämtliche Beobachtungen unter den 42 Modelltrends des CMIP5-Ensembles liegen. Diese Zunahme der Modelltrends über den beobachteten 60-Jahre-Trend hinaus kann jetzt nicht durch die natürliche Variation erklärt werden, weil M&F argumentieren, dass die deterministische Komponente dominieren muss. Die Modelle müssen zu sensitiv bzgl. des Treibhausgas-Antriebs sein. Allerdings lassen M&F diese Tatsache weg, einfach weil sie nicht bestimmen können, welche Komponente in den Modellen diesen Trend verursacht. Tatsächlich basiert die Schlussfolgerung der Studie auf der Analyse von Modelldaten und nicht von beobachteten Daten. Das ist bizarr. Sie ziehen in ihrer Studie folgende Schlussfolgerung:

Es gibt eine wissenschaftliche, politische und öffentliche Debatte hinsichtlich der Frage, ob die Differenz der GMST zwischen simulierten und beobachteten Daten während der Stillstands-Periode ein Anzeichen dafür sein könnte, dass ein Gleichgewichts-Modell auf einen gegebenen Strahlungsantrieb reagiert, der systematisch zu stark ist oder – äquivalent dazu – auf eine simulierte Klima-Rückkopplung systematisch zu schwach reagiert. Im Gegensatz dazu finden wir keine substantielle physikalische oder statistische Verbindung zwischen der simulierten Klima-Rückkopplung und simulierten GMST-Trends während der Stillstands- oder irgendeiner anderen Periode, weder für den 15-Jahre noch für den 60-Jahre-Trend. Die Rolle der simulierten Klima-Rückkopplung bei der Erklärung der Differenz zwischen Simulationen und Beobachtungen ist daher entweder gering oder sogar vernachlässigbar. Der Vergleich von simulierten und beobachteten GMST-Trends erlaubt keine Rückschlüsse, welche Größenordnung der simulierten Klima-Rückkopplungen – im Bereich zwischen 0,6 bis 1,8 W/m² im CMIP%-Ensemble* – besser zu den Beobachtungen passt. Weil es die beobachteten GMST-Trends nicht zulassen, zwischen simulierten Klima-Rückkopplungen zu unterscheiden, die um einen Faktor 3 variieren, ist die Behauptung, dass die Klimamodelle die GMST-Reaktion auf Strahlungsantriebe infolge steigender Treibhausgaskonzentrationen systematisch übertreiben, offensichtlich unbegründet.

[*Der Satz zwischen den Bindestrichen lautet im Original: ranging from 0.6 to 1.8 W m22 uC21 in the CMIP5 ensemble. Ich weiß nicht, was die Zahlen und Buchstaben in der Mitte bedeuten sollen. Anm. d. Übers.]

Es sieht fast so aus, als ob sie zu der Schlussfolgerung gekommen sind, die sie von Anfang an haben wollten – nämlich dass die Modelle für den Zweck geeignet sind und dass der Stillstand ein statistischer Zufall ist, der den 15-Jahre-Trends zufolge nicht unerwartet kommt. Auf diese Weise können sie die Schlussfolgerungen des AR 5 aufrecht erhalten, aber nur, wenn sie die Beweise dafür ignorieren, dass die beobachteten Daten die AMO/PDO-Oszillation und eine moderate globale Erwärmung stützen.

Die Physik basierte immer auf der Entwicklung theoretischer Modelle, um die Natur zu beschreiben. Diese Modelle machen Vorhersagen, die nachfolgend durch Experimente getestet werden können. Falls die Ergebnisse dieser Experimente mit den Vorhersagen nicht übereinstimmen, dann muss man entweder das Modell so aktualisieren, dass es die neuen Daten erklären kann, oder man muss das Modell verwerfen. Was man nicht tun darf ist, die experimentellen Daten zu verwerfen, weil die Modelle nicht beschreiben können, warum sie nicht mit den Daten übereinstimmen.

Meine Schlussfolgerung lautet, dass die 60-Jahre-Trenddaten starke Beweise zeigen, dass CMIP5-Modelle die globale Erwärmung durch zunehmende Treibhausgase tatsächlich übertreiben. Die Diskrepanz zwischen den Klimaprojektionen und den Beobachtungen wird nur immer schlimmer werden, falls sich der Stillstand weitere 10 Jahre fortsetzt. Der gegenwärtige 60-Jahre-Trend ist tatsächlich nur wenig größer als im Jahre 1900. Wenn sich die Oszillation um das Jahr 2030 wieder umkehrt, wird die Erwärmung wieder einsetzen, aber die Klimasensitivität ist dann immer noch viel geringer als die Modelle vorhersagen.

Link: http://wattsupwiththat.com/2015/03/17/models-overestimate-such-60-year-decadal-trends/

Übersetzt von Chris Frey EIKE