Im Angesicht der kalten Winter der 1960er und 1970er Jahre sind die Medien in eine “Eiszeithysterie” verfallen.

In der TV-Dokumentation „In Search of…” (welche wöchentlich von 1976-1982 ausgestrahlt wurde, durch die Sendung führe u.a. Leonard Nimoy) wurde u.a. über eine drohende Eiszeit berichtet.

Hier die Dokumentation mit Leonard Nimoy: The Coming Ice Age: An inquiry into whether the dramatic weather changes in America’s northern states mean that a new ice age is approaching. Original broadcast: May 1978.

Aber in Wirklichkeit hat es diese “Eiszeithysterie” ja nie gegeben? Zumindest wenn es nach den Klimaschützern geht.

Wir erinnern uns?

In der obigen Dokumentation kamen einige Klimawissenschaftler zu Wort. U.a. Prof. Dr. H. Stephen Schneider. „Klimatologe“ an der Stanford University, USA. Bis zu seinem Tod im Jahre 2010 war Schneider einer der bekanntesten Vertreter, der vehement vor einer drohenden Klimaerwärmung, ausgelöst durch den Menschen warnte. In den 1970er Jahren warnte er hingegen noch vor einer drohenden Eiszeit.

Es wurde spekuliert durch den Einsatz von Atombomben, oder durch eine dunkle Bestäubung das Polareis zum Schmelzen zu bringen und somit eine drohende Eiszeit abzuwenden.

Rasool und Schneider prognostizierten 1971 in der renommierten Fachzeitschrift SCIENCE für den Fall, dass sich die globalen Aerosolemissionen vervierfachen würden, ein Absinken der globalen Durchschnittstemperatur um bis zu 3,5 °C und warnten davor, dass dies eine Eiszeit auslösen könnte.

S. I. Rasool und S. H. Schneider: Atmospheric Carbon Dioxide and Aerosols: Effects of Large Increases on Global Climate. In: Science. Band 173 (3992), 1971, S. 138-141. doi:10.1126/science.173.3992.138

Eine weitere Arbeit zum Thema Aerosole und den Auswirkungen auf die Globaltemperatur, an welcher Scheider beteiligt war, findet sich hier:

R. J. Charlson, Halstead Harrison, Georg Witt, S. I. Rasool, and S. H. Schneider. Aerosol Concentrations: Effect on Planetary Temperatures: Science 7 January 1972: Vol. 175. no. 4017, pp. 95 – 96. DOI: 10.1126/science.175.4017.95-a

Stephen Schneider wechselte schließlich die Seite und war Leitautor in der Working Group II (TAR) des IPCC Weltklimaberichtes der UN von 2001.

Eine weitere TV-Dokumentation dieser Zeit, welche sich mit einer drohenden Eiszeit auseinandersetzt, wurde unter dem Titel “THE WEATHER MACHINE” ausgestrahlt.

“The Weather Machine” BBC 1974

Zu Wort kommt George Kukla, ein in der Tschechei geborener „Klimatologe“. Er ist emeritierter Professor für Klimatologie an der Columbia University und Forscher am Lamont-Doherty Earth Observatory.

Schon in der 1970er Jahren, in welchen die Scheebedeckung der Nordhalbkugel und damit die Reflektion der einfallenden Sonneneinstrahlung deutlich zunahm, vertrat Kukla eine Abkühlungsthese und wurde vielfach in der Presse zitiert.

Sieh z.B.

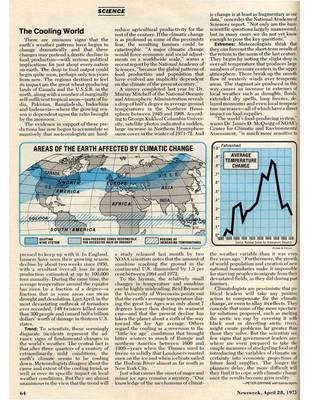

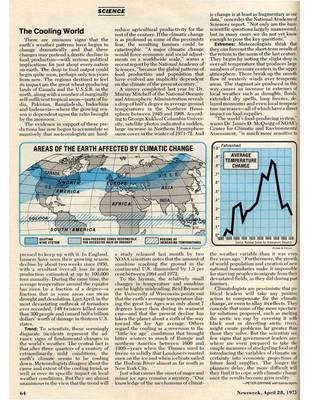

New York Times, 21 Mai 1975

Newsweek, 28 April 1975

George Kukla sagt heute:

“The only thing to worry about global warming is the damage that can be done by worrying. Why are some scientists worried? Perhaps because they feel that to stop worrying may mean to stop being paid.”

„Das Einzige, worüber man sich bei der globalen Erwärmung Sorgen machen sollte ist der Schaden, welcher durch die Sorge angerichtet werden kann. Warum sind einige Wissenschaftler besorgt? Vielleicht weil sie spüren, dass das Ende der Besorgnis ein Ende der Bezahlung bedeuten kann.“

Veröffentlichungen u.a.

G. Kukla, R.K. Matthews and J.M. Mitchell, Jr., The end of the present interglacial. Quaternary Research 2 (1972), pp. 261–269

Kukla, G. J., and R. K. Matthews, 1972, “When will the present interglacial end?,” Science, 178:190-191

Kukla, G.J. and H.J. Kukla, 1974: Increased surface albedo in the Northern Hemisphere. Science, 183, 709-714.

G. J. Kukla et al.: New data on climatic trends. In: Nature 270, 1977, 573–580. doi:10.1038/270573a0

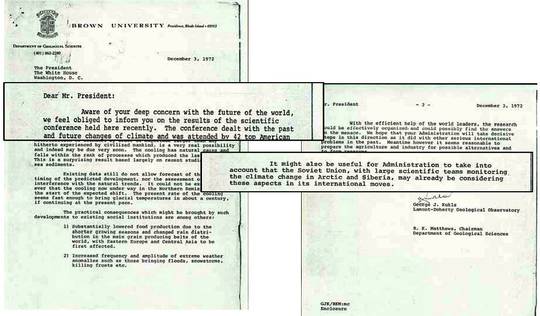

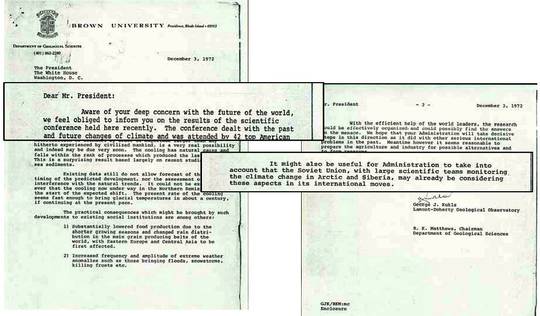

Im Januar 1972 kamen Kukla und Matthews zu einer Konferenz in der Brown University in Providence/ Rode Island zusammen. Teilgenommen haben die damaligen “Topforscher” aus Europa und Amerika. Diskussionsthema war “The Present Interglacial, How and When will it End?” (“Die aktuelle Warmzeit, wie und wann wird sie enden?”). Die Schlussfolgerungen wurden in den zwei oben genannten Veröffentlichungen von 1972 zusammengefasst.

Die Hauptergebnisse der Konferenz teilen Kukla und Matthews dem Büro des US-Präsidenten Nixon im folgenden Schreiben vom 3. Dezember 1972 mit:

In dem Schreiben warnen Sie vor einer drohenden Eiszeit und deren Auswirkungen.

“Sehr geehrter Mr. Präsident:

In Bewusstsein, Ihrer tiefen Besorgnis über die Zukunft der Welt, fühlen wir uns verpflichtet, Sie über die Ergebnisse der wissenschaftlichen Konferenz zu informieren, die hier vor kurzem stattgefunden hat. Die Konferenz befasste sich mit den bisherigen und zukünftigen Veränderungen des Klimas, teilgenommen haben 42 Top-Forscher aus Amerika und Europa. Anliegend fügen wir die Schlussfolgerungen, welche bereits in SCIENCE erschienen sind und in Kürze in QUATERNARY RESEARCH erscheinen werden, bei.

Das wichtigste Ergebnis des Treffens war, dass eine globale Verschlechterung des Klimas, von der Größenordnung größer als alle bisher von den zivilisierten Menschheit erlebten, eine sehr reale Möglichkeit ist, die wohlmöglich sehr schnell eintreten kann.

Die Kühlung ist natürlichen Ursprungs und fällt in den Rang von Prozessen, welche die letzte Eiszeit verursacht haben. Dies ist ein überraschendes Ergebnis, welches vor allem auf die jüngsten Studien von Tiefsee-Sedimenten hervorgeht.

Die vorliegenden Daten erlauben bisher keine exakte Vorhersage bzgl. des Eintretens der vorhergesagten Entwicklung, noch eine Beurteilung der Beeinträchtigungen auf die Menschheit, durch den natürlichen Trend. Es kann jedoch nicht ausgeschlossen werden, dass die Abkühlung, welche gerade auf der Nordhalbkugel im Gange ist, der Beginn der erwarteten Klimaumstellung ist. Die aktuelle Rate der Abkühlung scheint schnell genug von statten zu gehen, um eiszeitliche Temperaturen innerhalb eines Jahrhunderts mit sich zu bringen, bei Fortsetzung der gegenwärtigen Geschwindigkeit.

Die praktischen Konsequenzen, die sich daraus für die existierenden sozialen Systeme ergeben, sind unter anderem:

(1) Eine deutlich gesenkte Nahrungsmittelproduktion aufgrund der kürzeren Vegetationsperioden und einer veränderten Niederschlagsverteilung in den wichtigsten Getreideerzeugungsgebieten der Welt, mit Osteuropa und Zentralasien die als erste betroffen sein werden.

(2) Eine erhöhte Häufigkeit und ein stärkeres Auftreten von extremen Wetterereignissen und -anomalien, wie Überschwemmungen, Schneestürme, Tote durch Frostperioden, etc. …”

Die Folgen

Das Schreiben erregte reichlich Aufsehen.

Angesichts der „Getreidekrise” im Jahre 1972 und zahlreicher Wetterkapriolen, welche später auf den El Niño von 1972-1973 zurückgeführt wurden, herrschte eine kollektive Angstsituation, auch im Weißen Haus.

Das Weiße Haus nahm die Angelegenheit sehr ernst und leitete das Kukla-Matthews-Schreiben an das Amt für internationale wissenschaftliche und technische Angelegenheiten des State Departments weiter. (Bureau of International Scientific and Technological Affairs of the State Department). Das wiederum leitete das Schreiben an die höchst beauftragte, ressortübergreifende Stelle, das Interdepartmental Committee for Atmospheric Sciences (ICAS) weiter, um die Angelegenheit „zu überprüfen und geeignete Maßnahmen” einleiten zu können. Das ICAS stellte daraufhin ein Ad-hoc-Gremium zusammen, um auf das Schreiben zu antworten. Darin vertreten waren Dr. David M. Hirschfield ((Chair) Department of Agriculture), Mr. Joseph O. Fletcher (National Science Foundation), Dr. J. Murray Mitchell, Jr. (National Oceanic and Atmospheric Administration), Col. John S. Perry (Department of Defense).

Das folgende Jahr war ein besonders arbeitsreiches, da das Gremium Rat von Experten auf dem Gebiet einholte. Letztendlich kam man zu dem Schluss, dass das Thema von so einer übergeordneten Bedeutung ist, dass man ein nationales Klimaprogramm ins Leben rufen sollte, was dann letztendlich auch geschah.

Damit sollte klar geworden sein, dass das Thema einer drohenden Eiszeit in den frühen 1970er Jahren nicht nur von medialen, sondern auch politischem Interesse war.

Das Thema einer drohenden Abkühlung war auch für die CIA von Bedeutung. Einer der Hauptprotagonisten war dabei Reid Bryson.

Bryson ging davon aus, dass Schmutzpartikel und die steigende Luftverschmutzung für die beobachtet Abkühlung seit dem zweiten Weltkrieg verantwortlich sind und das diese Effekte für eine weitere Abkühlung sogen könnten.

Veröffentlichungen u.a.

Bryson, Reid, A; Kutzbach, John E. (1968). Air pollution. Washington: Association of American Geographers. ASIN B0006BWL46.

James T. Peterson and Reid A. Bryson, Science, 4 October 1968. “Atmospheric Aerosols: Increased Concentrations during the Last Decade”

Bryson, Reid A. (1974). “A Perspective on Climatic Change.” Science 184: 753-60.

Bryson, Reid A., and W.M. Wendland (1975). “Climatic Effects of Atmospheric Pollution.” In The Changing Global Environment, edited by S.Fred Singer, pp. 139-47. Boston: Reidel.

Bryson, Reid A., and W.M. Wendland (1975). “Climatic Effects of Atmospheric Pollution.” In Global Effects of Environmental Pollution, edited by S. F. Singer, pp 130-38

Bryson, Reid A., and Thomas J. Murray (1977). Climates of Hunger: Mankind and the World’s Changing Weather. Madison: University of Wisconsin Press.

Schon 1974 hatte die CIA die Regierung darauf aufmerksam gemacht, dass ein Klima-Umschlag stattfinde, der „bereits zu großen Wirtschaftsproblemen auf der ganzen Welt geführt hat“.

So glaubt der amerikanische Klimatologe Reid Bryson von der University of Wisconsin, auf dessen Studien sich die CIA stützte, dass sich auf der gesamten nördlichen Halbkugel das Klima immer mehr abkühle. In ihrem Report warnten die Geheimdienstler vor durch Wetterumschwünge hervorgerufene Energie- und Nahrungsmittelkrisen, die ihrerseits zu politischen Krisen führen könnten.

Angesichts der „Getreidekrise“ im Jahre 1972 herrschte nach etlichen Wetter bedingten Missernten in den sechziger Jahren eine kollektive Angstsituation. Die Nachrichten und Schlagzeilen in den Medien häuften sich und es kam zu einer Nachrichtendichte, die den amerikanischen Geheimdienst CIA veranlasste, den vielen wilden Spekulationen nach den Ursachen dieser Wetterkapriolen nachzugehen und die führenden Klimatologen um Auskunft und Rat zu ersuchen.

Anfang der siebziger Jahre kam die CIA zu dem Ergebnis, dass die Veränderungen des Klimas „vielleicht die größte Herausforderung (seien), der sich Amerika in den kommenden Jahres ausgesetzt sehen wird“. Aus der Angst heraus, dass die USA ihre Vormachtstellung als Getreideexporteur durch Missernten verlieren könnten, gab der CIA mehrere Studien über das Klima der Welt, die wahrscheinlich zu erwartenden Veränderungen und deren vermutliche Auswirkungen auf Amerika und die übrige Welt in Auftrag.

Politischer Sieger unter den diversen Studien war die Wiskonsin-Studie, die unter der Leitung von Professor Reid Bryson entstand. Sie sagte vorher, „dass die Erde zu dem Klimasystem zurückkehrt, das von Beginn des 17. Jahrhunderts bis zur Mitte des 19. Jahrhunderts geherrscht hat und üblicherweise die neoborale oder „Kleine Eiszeit“ genannt wird.“ In dieser Zeit lebte Nordeuropa überwiegend in der Dämmerung ständigen Winters. Schlechte Ernährung hatte große Epidemien in Europa, Russland, Indien und Afrika zur Folge, während die Iberische Halbinsel, Italien und Griechenland blühten. Professor Brysons Gedankengang lautet so: „Bis etwa 1940 wurde die Welt wärmer; Mitte der vierziger Jahre setzte dann eine entgegen gesetzte Entwicklung ein, da sich die Polarluft nach Süden ausdehnte und sich die nördliche Halbkugel abkühlte. Prof. Bryson glaubte, dass die 3 Hauptfaktoren dabei sind: vulkanische Asche, vom Menschen erzeugter Staub und Kohlendioxid.“ Er glaubte, dass die Chancen für einen beschleunigten Abkühlungstrend hoch sind, wie übrigens viele Klimaforscher seiner Zeit (z.B. Prof. George Kukla).

Die nachrichtendienstlich relevanten Ergebnisse des CIA wurden 1977 in den USA unter dem Titel “The Weather Conspiracy”, “Die Wetter Verschwörung” publiziert. 1978 erschien dieses Buch in Deutschland von einem Impact-Team unter dem Titel “Der Klima-Schock” veröffentlicht. Auf der Titelseite liest man: “Die nächste Eiszeit steht kurz bevor. Der Bedarf an Heizenergie wird unerfüllbar. Große Teile der Erde werden unzugänglich. Der Hunger wird größer.”

In einer TV-Diskussion von 2007 bezog Bryson, der 2008 verstorben ist, noch einmal eindrücklich Stellung.

Kommen wir auf weitere Arbeiten und Protagonisten dieser Zeit zu sprechen, die eine drohende Eiszeit, bzw. einen Abkühlungstrend diskutieren.

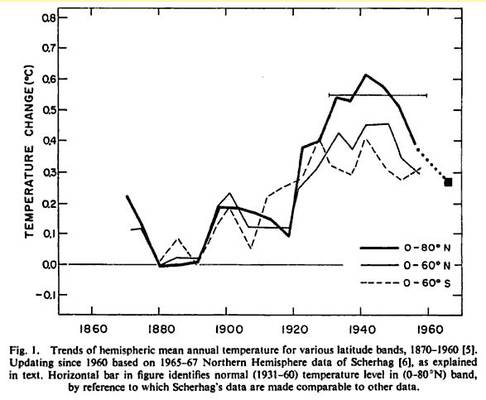

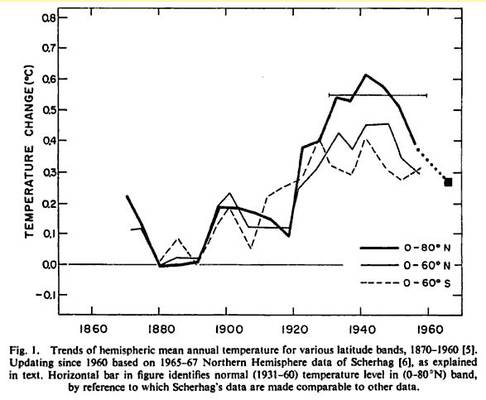

Murray J. Mitchell veröffentlichte im Jahr 1963 die erste up-to-date Temperatur-Rekonstruktion und zeigte, dass ein globaler Abkühlungs-Trend in den 1940er Jahren begonnen hatte. Mitchell verwendete Daten von fast 200 Wetterstationen, zusammengestellt unter dem World Weather Records Projekt unter der Schirmherrschaft der Weltorganisation für Meteorologie (World Meteorological Organization). Damit berechnete er die durchschnittlichen Temperaturen für verschiedene geographische Breitenbereiche. Seine Analyse zeigte, dass die globalen Temperaturen seit den 1880er Jahren, dem Beginn seiner Aufzeichnung, relativ stetig zugenommen hatten bis etwa um das Jahr 1940. Ab etwa 1940 setzte dann eine stetige multidekaden Abkühlung ein (Mitchell 1963). In den frühen 1970er Jahren, als Mitchell den Stand seiner Arbeit aktualisierte (Mitchell 1972), war die Ansicht über den globalen Abkühlungstrend allgemein akzeptiert, wenn auch wenig verstanden.

Mitchell, J.M., Jr., 1963: On the world-wide pattern of secular temperature change. In: Changes of Climate. Proceedings of the Rome Symposium Organized by UNESCO and the World Meteorological Organization, 1961.

Oder

Robert A. McCormick und John H. Ludwig: Climate Modification by Atmospheric Aerosols. In: Science 156 (3780), 1967, S. 1358-1359. doi:10.1126/science.156.3780.1358

McCormick und Ludwig kamen in dieser Studie von 1967 zu dem Schluss, dass die anthropogenen Aerosolemissionen die Albedo erhöhten und dadurch die Abkühlung verursacht hätten.

G. Yamamoto, and M. Tanaka, “Increase of global albedo due to air pollution,” J. Atmos. Sci. 29, 1405–1412 (1972).

Zu einen ähnlichen Schluss kamen Yamamoto und Tanaka in ihrer Studie von 1972.

Zu dem Thema Aerosole und Klima existieren etliche Studien aus dieser Zeit.

Die entscheidende Frage war, ob sich der Cooling-Trend fortsetzen würde, oder sich langfristig gesehen die angenommene “Treibhauswirkung” des CO2 durchsetzen würde.

Bzgl. der Wirkung der Aerosole prognostizierten Rasool und Schneider 1971 für den Fall, dass sich die globalen Aerosolemissionen vervierfachen würden, ein Absinken der globalen Durchschnittstemperatur um bis zu 3,5 °C und warnten davor, dass dies eine Eiszeit auslösen könnte. Zu einem ähnlichen Ergebnis kamen Yamamoto und Tanaka in ihrer Studie von 1972.

Bzgl. der Treibhauswirkung des CO2 wurde i.d.R. auf die Studie von Syukuro Manabe und Richard T. Wetherald aus dem Jahre 1967 zurückgegriffen.

Syukuro Manabe and Richard T. Wetherald, Thermal Equilibrium of the Atmosphere with a Given Distribution of Relative Humidity, Journal of the Atmospheric Sciences 1967

Hiernach ergab sich für eine CO2-Verdoppelung (bei gleichbleibender Luftfeutigkeit) eine Temperatuerhöhung von 2°C. Einige Autoren gingen davon aus, dass die Aeorosole weiterhin der dominierende Faktor bleiben würden (oder werden würden), andere gingen davon aus, dass irgendwann (in Laufe von Jahrzehnten) die Treibhauswirkung des CO2 überwiegen könnte. So schreibt Carl Sagan (der “Schöpfungsvater” der Treibhaustheorie auf der Venus, (Sagan, C., The Radiative Balance of Venus, Tech Rep. JPL No. 32-34, 1960.)) beispielsweise zum Einfluss des CO2 in “Earth and Mars: Evolution of Atmospheres and Surface Temperatures” von 1972:

“Major variations in the CO2 abundance will have only minor greenhouse effects because the strongest bands are nearly saturated. A change in the present CO2 abundance by a factor of 2 will produce directly a 2 ° variation in surface temperature”

“Große Schwankungen in der CO2-Menge haben nur eine geringfügig Auswirkung auf den Treibhauseffekt, da die stärksten Absorptions-Banden (des CO2) nahezu gesättigt sind. Eine Änderung der derzeitigen CO2-Menge um den Faktor 2 bewirkt unmittelbar eine 2 ° Veränderung der Oberflächentemperatur.”

Aber auch Sagan war zwiegespaltener Meinung. In der Wissenschaft Serie Cosmos von 1980: A Personal Voyage, warnte der Physiker Carl Sagan vor einer katastrophalen Abkühlung durch das Verbrennen und den Kahlschlag der Wälder. Er postulierte, dass die erhöhte Albedo der Erdoberfläche zu einer neuen Eiszeit führen könnte.

Sagan, C., O. B. Toon, and J. B. Pollack, 1979: Anthropogenic albedo changes and the Earth’s climate. Science, 206, 1363-1368.

Aus der ganzen Debatte sollte letztendlich eines ersichtlich geworden sein, nämlich welche Bedeutung damals den Aerosolen beigemessen wurde (bis zu -3,5°C Abkühlung) und welche dem CO2 (bis zu +2°C Erwärmung).

Mein Fazit: Wie die Klimadebatte der vergangenen und heutigen Tage zeigt, gab es zu keiner Zeit einen wissenschaftlichen Konsens. Die Protagonisten haben im Laufe der Zeit ihre Meinungen geändert, oder auch nicht, einige sind von uns gegangen und neue sind hinzugekommen. Das vorherrschende Medien- und Meinungbild wurde vorwiegend durch aktuelle Wetterereignisse wie Kälteeinbrüche und Hitzewellen geprägt. Mr. Spock würde sagen: “Lebe lang und in Frieden”.

Artikel zuerst erschienen bei Science Skeptical hier