Die Ergebnisse der Untersuchungen gab das AWI am 26. Januar 2015 per Pressemitteilung bekannt:

Winter in sibirischen Permafrostregionen werden seit Jahrtausenden wärmer

Wissenschaftlern des Alfred-Wegener-Institutes, Helmholtz-Zentrum für Polar- und Meeresforschung (AWI) ist es erstmals gelungen, mit einer geochemischen Methode aus der Gletscherforschung Klimadaten aus Jahrtausende altem Permafrost-Grundeis zu entschlüsseln und die Wintertemperatur-Entwicklung im russischen Lena-Delta zu rekonstruieren. Ihr Fazit: In den zurückliegenden 7000 Jahren ist die Wintertemperatur in den sibirischen Permafrostregionen langfristig gestiegen. Als Grund für diese Erwärmung nennen die Forscher eine sich ändernde Stellung der Erde zur Sonne, verstärkt durch den steigenden Ausstoß von Treibhausgasen seit Beginn der Industrialisierung. Die Studie erscheint als Titelgeschichte der Februar-Ausgabe des Fachmagazins Nature Geoscience und heute vorab schon einmal online.

Was bedeuten diese Resultate? Zugegeben handelt es sich um eine für Laien komplexe Thematik. Es geht um schwierige geochemische Methoden, schwer fassbare lange Zeiträume, eine behauptete Verknüpfung mit der anthropogenen Klimaerwärmung sowie Milankovic-Zyklik. All das spielt im fernen Sibirien, das vermutlich kaum einer der Leser genauer kennt. Hängenbleiben wird beim ersten Überfliegen der Pressemitteilung „Klimaerwärmung seit tausenden von Jahren, Industrialisierung, Treibhausgase“. Seht her, da ist ein weiterer Beweis für unser frevelhaftes Tun und die unaufhaltbare Klimakatastrophe in Zeitlupe. Aber nicht so schnell. Lassen Sie uns die Komponenten der Studie einzeln diskutieren und auf ihre Gültigkeit und Bedeutung überprüfen.

Langfristige Erwärmung der Winter im Verlauf der letzten 7000 Jahre

Ein übraus interessantes Resultat: Eine langfristige, natürliche Erwärmung der Winter im Untersuchungsgebiet in den letzten Jahrtausenden. Exakte Temperaturwerte können die AWI-Forscher nicht angeben, wie das AWI in seiner Pressemitteilung erläutert:

Um wie viel Grad Celsius genau die arktischen Winter wärmer geworden sind, können die Wissenschaftler nicht in absoluten Zahlen sagen: „Das Ergebnis der Sauerstoff-Isotopenanalyse verrät uns zunächst nur, ob und wie sich das Isotopenverhältnis verändert hat. Steigt es, sprechen wir von einer relativen Erwärmung. Wie groß diese allerdings genau ausgefallen ist, können wir noch nicht ohne Weiteres sagen“, erklärt Thomas Opel.

Aber es wäre sicher ganz nett gewesen, wenn eine ungefähre Temperaturabschätzung erwähnt worden wäre. Die heutigen Wintertemperaturen betragen im Lenadelta minus 30 Grad bis minus 40 Grad, wie die Encyclopaedia Brittanica weiß:

The climatic features of the Lena River basin are determined by its location, with its upper course well inside the continent and its lower course in the Arctic. In winter the powerful Siberian anticyclone (high-pressure system) forms and dominates all of eastern Siberia. Because of the anticyclone, the winter is notable for its clear skies and lack of wind. Temperatures fall as low as −60 to −70 °C, with average air temperature in January ranging from −30 to −40 °C. In July averages range between 10 and 20 °C.

Nun war es laut AWI vor ein paar tausend Jahren also noch etwas kälter, sagen wir einfach mal minus 45 Grad, nur um einen Wert zu haben. Es geht also in der ganzen Geschichte um eine Winter-„Erwärmung“ die sich von „sehr, sehr super saukalt“ hin zu „immer noch sehr super saukalt“ entwickelt hat. Bei Nennung dieser Temperaturen hätte vielleicht dem einen oder anderen Leser die Idee kommen können, dass die Winter-Erwärmung der Gegend zweitrangig ist und möglicherweise sogar ganz gut getan hätte.

Nun könnte man sagen, ja, im Winter ist die Entwicklung wohl eher weniger interessant. Wie sieht es denn im Sommer aus, wo laut Encyclopaedia Brittanica heute mit bis zu 20°C zu rechnen ist? Müssen wir hier Angst vor einer „arktischen Turboerwärmung“ haben? Die AWI-Pressemitteilung erklärt etwas verklausuliert, dass Rekonstruktionen der Sommertemperaturen eine gegenteilige Entwicklung anzeigen: In den letzten Jahrtausenden ist es in Sibirien immer kälter geworden:

Die neuen Daten sind die ersten eindeutig datierten Wintertemperaturdaten aus der sibirischen Permafrostregion und zeigen einen klaren Trend: „In den zurückliegenden 7000 Jahren sind die Winter im Lena-Delta kontinuierlich wärmer geworden – eine Entwicklung, die wir so bisher aus kaum einem anderen arktischen Klimaarchiv kennen“, sagt Hanno Meyer. Denn: „Bisher wurden vor allem fossile Pollen, Kieselalgen oder Baumringe aus der Arktis genutzt, um das Klima der Vergangenheit zu rekonstruieren. Sie aber speichern vor allem Temperaturinformationen aus dem Sommer, wenn die Pflanzen wachsen und blühen. Die Eiskeile stellen eines der wenigen Archive dar, in denen reine Winterdaten gespeichert werden“, erklärt der Permafrost-Experte. Mit den neuen Daten schließen die Wissenschaftler zudem eine wichtige Lücke: „Die meisten Klimamodelle zeigen für die zurückliegenden 7000 Jahre in der Arktis eine langfristige Abkühlung im Sommer sowie eine langfristige Erwärmung im Winter an. Für letztere aber gab es bisher keine Temperaturdaten, eben weil die meisten Klimaarchive hauptsächlich Sommerinformationen speichern. Jetzt können wir zum ersten Mal zeigen, dass Eiskeile ähnliche Winterinformationen enthalten wie sie von den Klimamodellen simuliert werden“, so AWI-Modellierer und Ko-Autor Dr. Thomas Laepple.

Noch klarer wird es in der offiziellen Kurzfassung der Arbeit (Auszug):

Relative to the past 2,000 years1, 2, the Arctic region has warmed significantly over the past few decades. However, the evolution of Arctic temperatures during the rest of the Holocene is less clear. Proxy reconstructions, suggest a long-term cooling trend throughout the mid- to late Holocene3, 4, 5, whereas climate model simulations show only minor changes or even warming6, 7,8.

Bei den genannten Literaturzitate 3 bis 5 handelt es sich um:

3. Marcott, S. A., Shakun, J. D., Clark, P. U. & Mix, A. C. A reconstruction of regional and global temperature for the past 11,300 years. Science 339, 1198_1201 (2013).

4. Vinther, B. M. et al. Holocene thinning of the Greenland ice sheet. Nature 461, 385_388 (2009).

5. Wanner, H. et al. Mid- to Late Holocene climate change: An overview. Quat. Sci. Rev. 27, 1791_1828 (2008).

Gerne hätte an dieser Stelle auch einer Arbeit einer internationalen Forschergruppe um Benoit Lecavalier von der University of Ottawa aus dem März 2013 in den Quaternary Science Reviews erwähnt werden können. Die Forscher fanden, dass sich Grönland in den letzten 8000 Jahren um etwa 2,5°C abgekühlt hat (siehe „Ein Thema das die Medien meiden wie der Teufel das Weihwasser: Vor 5000 Jahren war es in Grönland zwei bis drei Grad wärmer als heute”).

Die Sommer wurden in den letzten 7000 Jahren kälter und die Winter wärmer. So kann man den aktuellen Erkenntnisstand zusammenfassen. Ursache für diesen Langzeittrend sind die Milankovic-Zyklen, die auf Veränderungen der Erdbahnparameter zurückzuführen sind. Dies sind langfristige Zyklen im Bereich von 20.000 bis 100.000 Jahre, die für die aktuelle Klimadiskussion keine große Rolle spielen. Sie sind auch die Ursache für das sogenannte mittelholozäne Klimaoptimum, als die globalen Temperaturen vor 7000 Jahren um zwei Grad höher lagen als heute.

Während die Hauptstory, nämlich die Erwärmung der sibirischen Winter in den letzten Jahrtausenden, durchaus plausibel erscheint, muss man sich doch wundern, weshalb die zeitgleiche Sommer-Abkühlung nicht besser in der AWI-Pressemitteilung herausgearbeitet wurde. Letztendlich geht es neben den Jahreszeiten doch auch darum, wie sich der Jahresmittelwert entwickelt hat. Dazu kein Kommentar vom AWI.

Zu klären wäre auch, weshalb die AWI-Presseabteilung nicht schon einige Monate zuvor aktiv geworden ist, als ein ebenfalls von Hanno Meyer angeführtes Forscherteam im September 2014 im Fachblatt Global and Planetary Change eine Studie zu Kamschatka publizierte. Die Forscher rekonstruierten die Temperaturen in der Region für die vergangenen 5000 Jahren und fanden interessanterweise einen langfristigen Abkühlungstrend. Über lange Zeiten war Kamschatka während der letzten Jahrtausende offenbar wärmer als heute, eine überraschende Erkenntnis (eine genaue Besprechung der Arbeit gibt es auf The Hockey Schtick). Das wäre eine schöne Schlagzeile geworden:

Kamschatka hat sich in den letzten 5000 Jahren abgekühlt.

Aber offenbar war dem AWI diese Schlagzeile zu heiß. Beim weiteren Stöbern wird man das böse Gefühl nicht los, dass man in der AWI-Pressestelle bewusst Studien ausspart, die nicht so recht in die Klimakatastrophengeschichte zu passen scheinen. Bereits im Mai 2013 waren erste Ergebnisse zum Kamschatka-Projekt in den Quaternary Science Reviews publiziert worden, zu denen die Öffentlichkeitsabteilung des AWI keinen Mucks machte (siehe unseren Blogbeitrag „Überraschende Forschungsergebnisse des AWI aus dem subarktischen Kamtschatka: In den letzten 4500 Jahren war es bis zu 4 Grad wärmer als heute”). Die unheimliche Serie setzte sich im September 2013 fort, als im Fachmagazin Palaeogeography, Palaeoclimatology, Palaeoecology eine AWI-Studie eines internationalen Forscherteams um Juliane Klemm erschien. Auch diese Forschergruppe hatte Unerhörtes herausgefunden, etwas was man auf keinen Fall mit der Presse teilen wollte (siehe unseren Blogbeitrag: „Neue AWI-Studie: Heutige Sommertemperaturen in der sibirischen Arktis unterscheiden sich kaum von denen der letzten Jahrtausende”).

Was hat nun die Klimakatastrophe mit all dem zu tun?

Zurück zum aktuellen Paper über das Lena-Delta. Die Erwärmung der Wintertemperaturen in den letzten 7000 Jahre mag interessant sein, ist aber lediglich die Hinleitung zur eigentlichen „Pointe“ der Studie, nämlich, dass der menschengemachte Klimawandel der letzten 150 Jahre die Wintertemperaturen im Studiengebiet nach oben gejagt hätte. In der AWI-Pressemitteilung liest sich das so:

Deutliche Hinweise fanden die Wissenschaftler bei der Suche nach den Ursachen der Erwärmung. Hanno Meyer: „Wir sehen in unserer Kurve eine klare Zweiteilung. Bis zum Beginn der Industrialisierung um das Jahr 1850 können wir die Entwicklung auf eine sich ändernde Position der Erde zur Sonne zurückführen. Das heißt, damals haben die Dauer und Intensität der Sonneneinstrahlung von Winter zu Winter zugenommen und auf diese Weise zum Temperaturanstieg geführt. Mit dem Beginn der Industrialisierung und dem zunehmenden Ausstoß von Treibhausgasen wie Kohlendioxid aber kam dann noch der vom Menschen verursachte Treibhauseffekt hinzu. Unsere Datenkurve zeigt ab diesem Zeitpunkt einen deutlichen Anstieg, der sich wesentlich von der vorgegangenen langfristigen Erwärmung unterscheidet.“

Leider versäumt es das AWI, der Pressemitteilung die Temperaturkurve bzw. die Isotopen-Proxy-Kurve beizufügen. Wie muss man sich diesen „deutlichen Anstieg“ im Detail vorstellen? Stattdessen werden der Presse stimmungsvolle Expeditionsfotos angeboten. Das schönste hiervon wollen wir auch hier im Blog nicht vorenthalten (Abbildung 1).

Abbildung 1rechts oben:. Die Wissenschaftler Alexander Dereviagin, Dr. Thomas Opel und Dr. Hanno Meyer (v.l.) machen eine kurze Mittagspause. Foto: Volkmar Kochan/rbb. Quelle: AWI.

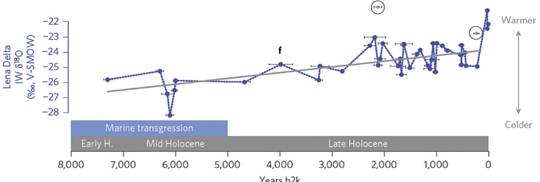

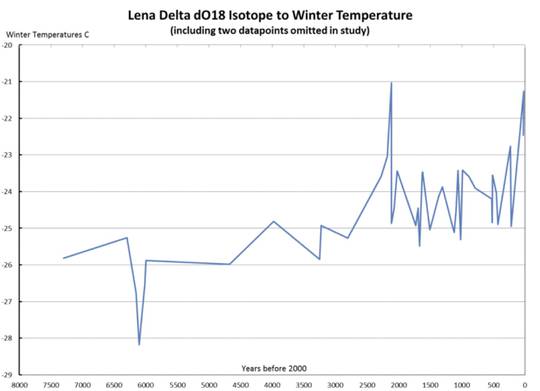

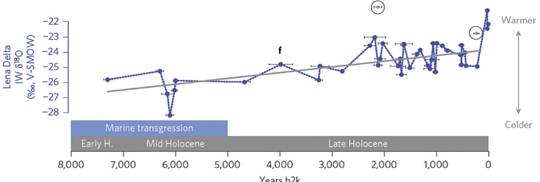

Wirklich ein schönes Foto. Aber trotzdem wäre die Kurve doch um einiges informativer gewesen. Wir schauen daher in die Originalpublikation, wo die gesuchte Kurve abgedruckt ist (Abbildung 2).

Abbildung 2: Winter-Temperaturentwicklung des sibirischen Lena-Deltas während der letzten 8000 Jahre auf Basis von Sauerstoffisotopenmesssungen an Eiskeilen. Abbildung aus Meyer et al. 2015.

Der langfristige Winter-Erwärmungstrend ist gut erkennbar. Ganz am Ende der Kurve, in der industriellen Phase ab 1850, springen die letzten drei Datenpunkte steil nach oben. Offensichtlich handelt es sich um einen Nachfahren der berühmten Hockeystick-Kurve. Nie waren die Sauerstoff-Isotopenwerte höher als in den letzten anderthalb Jahrhunderten.

Es drängen sich sogleich einige wichtige Fragen auf:

–Spiegelt die Isotopenkurve tatsächlich die Temperaturen wieder? Isotopenverschiebungen können vielerlei Gründe haben und müssen nicht unbedingt Temperaturen abbilden. In vielen Fällen sind Niederschlagsänderungen Hauptkontrollfaktor für Veränderungen der Sauerstoffisotopen.

–Gibt es andere Winter-Temperaturrekonstruktionen aus der Region, die den behaupteten Verlauf mit anderen Methodiken betätigen könnten?

– Wie sehen die real gemessenen Winter-Temperaturen sowie Jahresmittelwerte des Lena-Delta-Gebiets für die letzten 150 Jahre aus?

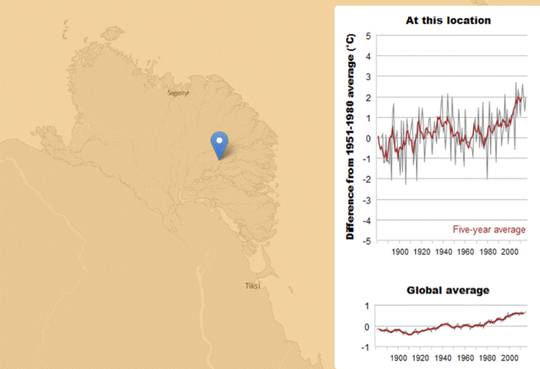

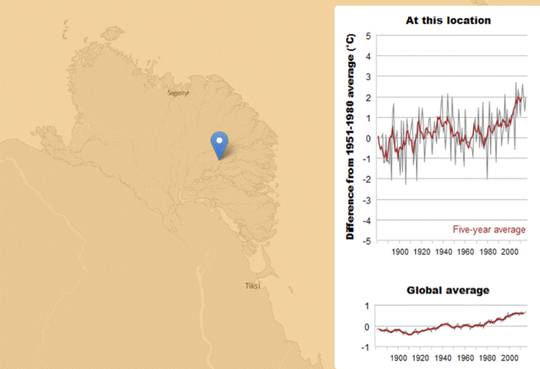

Schauen wir uns hierzu die GISS-Temperaturkarte des New Scientist an, in welcher der Temperaturverlauf in der Lenadelta-Region für die vergangenen 130 Jahre angegeben ist (Abbildung 3). Fazit: Ja es ist wärmer geworden, so wie in fast allen Teilen der Erde nach Beendigung der Kleinen Eiszeit. Dabei fiel die Wiedererwärmung in den arktischen Gebieten stärker aus als zum Beispiel in den Tropen. Soweit ist das Resultat also nachvollziehbar.

Abbildung 3: GISS-Temperaturverlauf der Lenadelta-Region für die vergangenen 130 Jahre. Quelle: New Scientist.

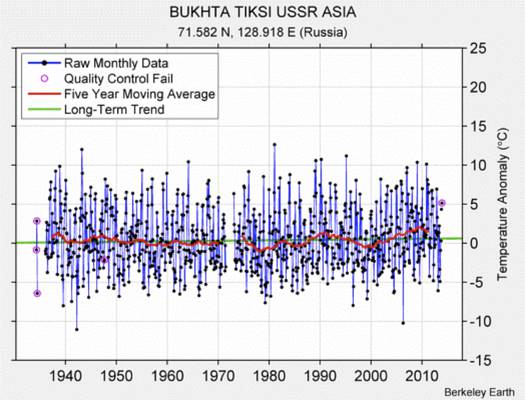

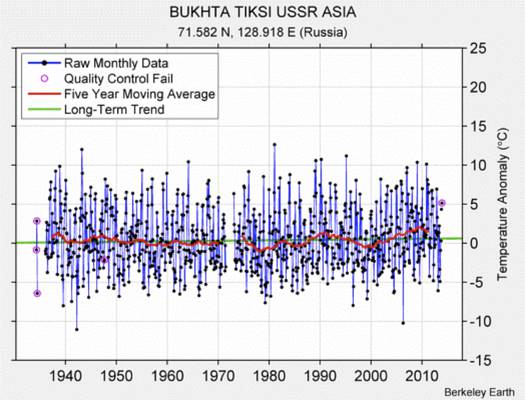

Nun wissen wir aber leider auch, dass die GISS-Datenbank lange vom bekennenden Klimaaktivisten James Hansen geführt wurde und die Temperaturrohdaten arg nachbearbeitet wurden. Daher schauen wir lieber auf einen Rohdatensatz des Ortes Tiksi, der seit 1936 Messdaten liefert. Die Daten stammen aus dem BEST-Projekt der University of California in Berkeley, sollten also relativ vertrauenswürdig sein (Abbildung 4). Der Ort Tiksi ist auf der Landkarte in Abbildung 3 eingezeichnet.

Die Überraschung ist groß: Der im GISS-Datensatz dargestellte starke Erwärmungstrend ist in den Originaldaten kaum zu erkennen. Anstatt einer GISS-Erwärmung von 2 Grad pro Jahrhundert verzeichnet BEST lediglich eine Erwärmungsrate von etwa 0,5 Grad nach Qualitätsüberprüfung.

Abbildung 4: Temperaturdaten der Wetterstation Tiksi im Lena-Delta laut BEST-Projekt.

Die wirkliche Frage muss jedoch sein, auf welchem Niveau sich die Temperaturen während der Mittelalterlichen Wärmeperiode (MWP) im Lena-Delta bewegten. In einer zusammenfassenden Darstellung zur MWP für den asiatischen Teil Russlands auf co2science.org stoßen wir bei unseren Recherchen auf eine Veröffentlichung von Matul et al., die 2007 im Fachblatt Oceanology erschien. CO2 Science fasst die Ergebnisse der Arbeit wie folgt zusammen:

What was done

The authors studied the distributions of different species of siliceous microflora (diatoms), calcareous microfauna (foraminifers) and spore-pollen assemblages found in sediment cores retrieved from 21 sites on the inner shelf of the southern and eastern Laptev Sea, starting from the Lena River delta and moving seaward between about 130 and 134°E and stretching from approximately 71 to 78°N, which cores were acquired by a Russian-French Expedition during the cruise of R/V Yakov Smirnitsky in 1991.

What was learned

In the words of the five Russian researchers, this endeavor revealed “(1) the warming at the beginning of the Common Era (terminal epoch of the Roman Empire) during ~1600-1900 years BP; (2) the multiple, although low-amplitude, coolingepisodes at the beginning of the Middle Ages, 1100-1600 years BP; (3) the Medieval Warm Period, ~600-1100 years BP; (4) the Little Ice Age, ~100-600 years BP, with the cooling maximum, ~150-450 years BP; and (5) the ‘industrial’ warming during the last 100 years.”

What it means

“Judging from the increased diversity and abundance of the benthic foraminifers, the appearance of moderately thermophilic diatom species, and the presence of forest tundra (instead of tundra) pollen,” Matul et al. conclude that “the Medieval warming exceeded the recent ‘industrial’ one,” and that “the warming in the Laptev Sea during the period of ~5100-6200 years BP corresponding to the Holocene climatic optimum could be even more significant as compared with the Medieval Warm Period.” Once again, therefore, we have another example of a paleoclimate study that challenges the contention of Hansen et al. (2006) that “probably the planet as a whole” is “approximately as warm now as at the Holocene maximum.”

Die Autoren um Matul rekonstruierten also mithilfe von Mikroorganismen die holozäne Klimageschichte des Lena-Deltas und der vorgelagerten Laptevsee. Matul und Kollege fanden dabei für die vergangenen 2000 Jahre die bekannte Millenniumszyklik bestehend aus Römischer Wärmeperiode, Kälteperiode der Völkerwanderungszeit, Mittelalterlicher Wärmeperiode, Kleiner Eiszeit und Moderner Wärmeperiode. Interessanterweise war die Mittelalterliche Wärmeperiode offenbar deutlich wärmer als heute. Zudem war das mittelholozäne Klimaoptimum im Untersuchungsgebiet vor 6000 Jahren sogar noch wärmer.

Nun wundert es doch sehr, dass die AWI-Gruppe diese wichtige Arbeit in ihrer neuen Lena-Delta Arbeit mit keiner Silbe erwähnt. Selbst wenn Matul et al. wohl überwiegend Sommertemperaturen rekonstruiert haben, hätte die Arbeit doch auf jeden Fall Berücksichtigung finden müssen. Sind die Sommertemperaturen nicht vielleicht viel wichtiger als die sowieso unterkühlten Winterwerte?

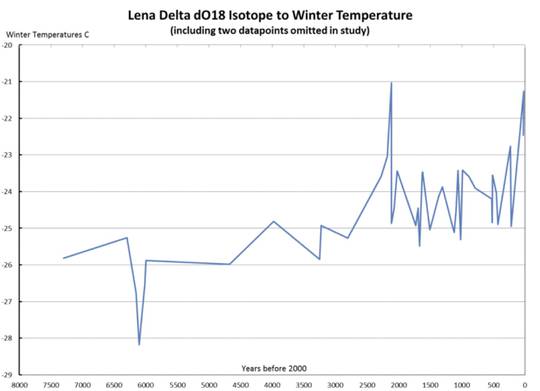

Bill Illis konnte in einer Diskussion zum AWI-Paper auf WUWT zeigen, dass die AWI-Autoren zwei möglicherweise wichtige Datenpunkte aus der Betrachtung ausschlossen (Abbildung 5). Einer davon zeigte während der Römischen Wärmeperiode eine bedeutende Winter-Erwärmung an, die sich etwa auf heutigem Temperaturniveau bewegte. Der Wert wurde unter Hinweis auf „oberflächennahe Kontaminierung“ aus dem Rennen geschmissen und in der Auswertung ignoriert.

Abbildung 5: Plot der Temperatur-Proxy-Wert aus Meyer et al. 2015, mit zwei zusätzlichen Werten, die die Autoren wegen „möglicher Kontaminierung“ verworfen hatten. Plot: Bill Illis/WUWT.

Unterm Strich

Was bleibt unterm Strich? Eine paläoklimatologische Studie findet eine unerwartete Entwicklung, die sogleich als Beleg für die drohende Klimakatastrophe missbraucht wird. Wichtige anderslautende Befunde aus der gleichen Region sowie andere AWI-Arbeiten werden totgeschwiegen. Der auffällige Hockeyschläger-Charakter der approximierten Temperaturentwicklung lässt die Alarmglocken schrillen: Ist die verwendete Methodik zuverlässig? Weshalb wurden möglicherweise wichtige Datenpunkte bei der Bearbeitung ignoriert? Wie wichtig ist die ultrakalte Wintertemperaturentwicklung wirklich im Vergleich zum Sommerverlauf? Weshalb können andere Messreihen und Temperaturrekonstruktionen den rasanten Hockeyschläger-Anstieg nicht reproduzieren? Immerhin geben sich die AWI-Forscher ergebnisoffen, wie sie in der Pressemitteilung betonen:

In einem nächsten Schritt wollen die Forscher nun überprüfen, ob dieselben Anzeichen für eine langfristige Winter-Erwärmung der Arktis auch in anderen Permafrostregionen der Welt zu finden sind. Thomas Opel: „Wir haben Daten aus einem Gebiet 500 Kilometer östlich des Lena-Deltas, die unsere Ergebnisse stützen. Wir wissen allerdings nicht, wie es zum Beispiel in der kanadischen Arktis aussieht. Wir vermuten, dass die Entwicklung dort ähnlich ist, belegen aber können wir diese Annahme noch nicht.“

Siehe auch den Blog-Beitrag „Arktische Turboerwärmung auf dem Prüfstand: Ein Konzept auf wackeligen Beinen”

Zuerst erschienen bei "Die kalte Sonne" hier