Das Rätsel der Eiszeiten XIV: Konzepte und Daten

January 30, 2014 by scienceofdoom

In früheren Beiträgen haben wir uns die Ideen über die Gründe für die Auslösung und Beendigung von Eiszeiten angesehen – und sie kritisiert. Als Ursache wurde die Einstrahlung in den hohen nördlichen Breiten ausgemacht. Diese Ideen sind bekannt unter dem Label „Milankovitch-Antriebe“. In der Regel habe ich dieses Konzept veranschaulicht, indem ich die Einstrahlungsdaten in bestimmten Breiten und in der einen oder anderen Form geplottet habe.

Die Einstrahlung auf verschiedenen Breiten hängt ab von Schiefe und Präzession (ebenso wie von der Exzentrizität). Schiefe ist die Neigung der Erdachse – die in Zyklen über etwa 40.000 Jahre variiert. Präzession ist die Verlagerung des Punktes der größten Annäherung (Perihel) und wie diese mit dem Sommer auf der Nordhemisphäre zusammenfällt – dies variiert mit einem Zyklus über etwa 20.000 Jahre. Der Effekt der Präzession wird modifiziert durch die Exzentrizität der Erdachse – die in einem Zyklus über etwa 100.000 Jahre variiert. Falls der Erdorbit ein perfekter Kreis wäre (Exzentrizität = 0), dann hätte die „Präzession“ keinerlei Auswirkungen, weil die Entfernung der Erde von der Sonne konstant wäre. Mit zunehmender Exzentrizität wird die Auswirkung der Präzession größer.

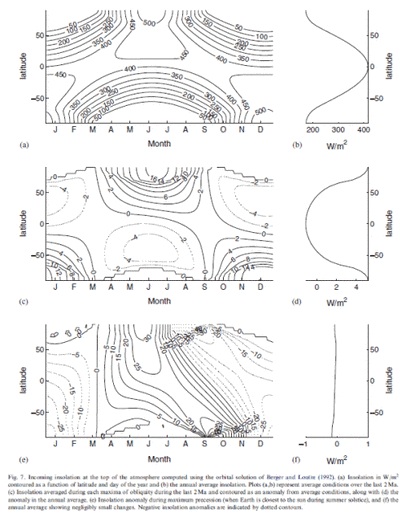

Wie kann man dies noch deutlicher machen? Peter Huybers gibt in seiner Studie 2007 eine gute Erklärung für Schiefe und Präzession zusammen mit einigen sehr interessanten Gedanken, die später in einem weiteren Artikel aufgegriffen werden. Die obere Graphik zeigt die mittleren Werte der Einstrahlung pro Breite und Tag des Jahres (über 2 Millionen Jahre). Die zweite Graphik zeigt die Anomalie im Vergleich mit dem Mittelwert zu Zeiten maximaler Schiefe. Die dritte Graphik zeigt die Anomalie im Vergleich zum Mittel zu Zeiten maximaler Präzession. Die Graphen rechts zeigen das jährliche Mittel dieser Werte:

Abbildung 1

Wir erkennen sofort, dass Zeiten maximaler Präzession (untere Graphik) kaum Auswirkungen auf die jährlichen Mittelwerte haben (rechte Seite der Graphik). Dies ist so, weil die Zunahme im Sommer und Herbst durch die korrespondierende Abnahme im Frühjahr kompensiert wird. Wir können aber auch sehen, dass Zeiten maximaler Schiefe (mittlere Graphik) TATSÄCHLICH Auswirkungen auf die jährlichen Mittelwerte haben (rechte Seite der Graphik). Die Gesamtenergie verschiebt sich von den Tropen zu den Polen. Ich habe versucht, jedoch nicht sehr effektiv, einiges hiervon (mit zu vielen Graphiken) im Teil V zu erklären: Part Five – Obliquity & Precession Changes.

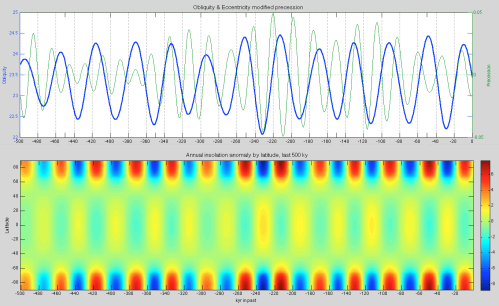

Hier folgt nun eine andere Art und Weise, dieses Konzept zu betrachten. Für die letzten 500.000 Jahre habe ich die Schiefe (blau) und Präzession modifiziert durch Exzentrizität (e sin w) (hellgrün) in der oberen Graphik geplottet und zusätzlich in der unteren Graphik die jährliche Anomalie in Abhängigkeit von Breite und Zeit. WordPress zwingt alles in 500 Pixel weite Graphiken, die nicht allzu hilfreich sind. Also klicke man darauf, um die HD-Version zu bekommen:

Abbildung 2 – click to expand

Man kann leicht erkennen, dass die Schiefe-Zyklen über 40.000 Jahre mit Anomalien in hohen Breiten (Nord und Süd) korrespondieren, was über ziemlich viele Perioden hinweg gutgeht. Wenn die Schiefe (blau) hoch ist, gibt es in den hohen Breiten der Nord- und Südhemisphäre eine Zunahme der jährlichen mittleren Einstrahlung. Falls wir die Präzession (grün) betrachten, sehen wir keine korrespondierende Änderung des jährlichen Mittels (weil die Zunahme in einer Jahreszeit zumeist durch die Abnahme in der anderen Jahreszeit kompensiert wird). Huybers Studie enthält noch viel mehr als das, und ich empfehle ihre Lektüre. Er verfügt über eine globale Proxy-Datenbasis über 2 Millionen Jahre, die nicht abhängig ist von „orbitalem Tuning“ (Anmerkung 1) und eine interessante Erklärung und Demonstration der Schiefe als dem dominanten Faktor bei der „Steuerung“ der Eiszeiten. Wir werden auf seine Darlegungen zurückkommen.

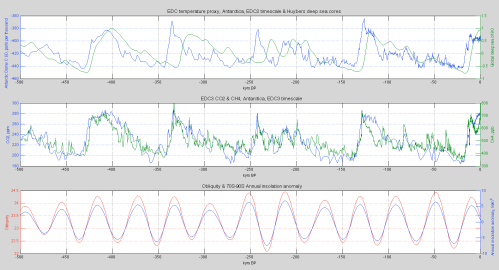

In der Zwischenzeit habe ich verschiedene Datenquellen gesammelt. Eine große Herausforderung bzgl. des Verständnisses von Eiszeiten ist, dass die Graphiken es in den verschiedenen Studien nicht zulassen in die interessierende Zeitperiode hineinzuzoomen. Ich gedachte, dem abzuhelfen, indem ich die Daten zur Verfügung stelle – und die Daten in High Definition vergleiche anstatt in Schnappschüssen von 800.000 Jahren auf einer halben Breite eines Standard-pdf. Es ist ein laufender Prozess. Die obere Graphik (unten) enthält zwei Versionen von Temperatur-Proxys. Eine ist Huybers globale Proxy aus dem Eisvolumen (δ18O) aus Tiefsee-Bohrkernen (olivgrün), während die andere eine lokale Proxy für die Temperatur (δD) aus dem antarktischen Eisbohrkern Dome C (75°S, blau) ist. Diese Örtlichkeit ist allgemein bekannt als EDC, d. h. EPICA Dome C. Die beiden Datensätze werden in den ihnen eigenen Zeitmaßstäben gezeigt (mehr zu Zeitmaßstäben weiter unten):

Abbildung 3 – click to expand

Die mittlere Graphik zeigt CO2 (blau) und CH4 (grün) aus Dome C. Es ist erstaunlich, wie eng CO2 und CH4 mit den Temperatur-Proxys und untereinander zusammenhängen. (Die CO2-Daten stammen von Lüthi et al. 2008 und die CH4-Daten von Loulerge et al. 2008). Die untere Graphik zeigt die Schiefe (rot) und die jährliche Einstrahlungs-Anomalie (blau) im Breitenmittel zwischen 70°S und 90°S. Weil wir hier die jährliche Einstrahlungs-Anomalie betrachten, ist dieser Wert vollständig in Phase mit der Schiefe. Warum sind die beiden Datensätze in der oberen Graphik außer Phase? Noch weiß ich darauf keine vollständige Antwort. Offensichtlich ist die Verzögerung von der Atmosphäre in die Tiefsee ein Teil der Erklärung.

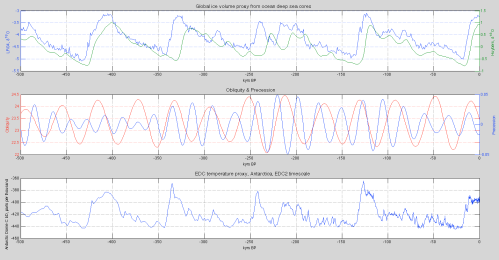

Hier folgt nun ein 500.000 Jahre-Vergleich von LR04 (Lisiecki & Raymo 2005) und Huybers Datensatz – beides Tiefsee-Bohrkerne – aber LR04 verwendet „orbitales Tuning“. Die zweite Graphik enthält Schiefe & Präzession (modifiziert durch Exzentrizität). Die dritte Graphik zeigt EDC aus der Antarktis:

Abbildung 4 – click to expand

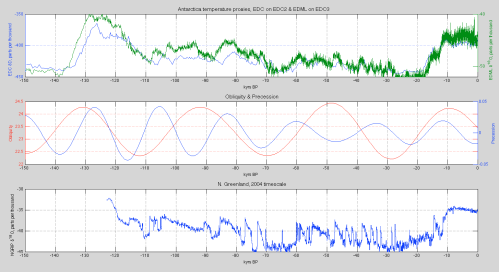

Jetzt zoomen wir auf die letzten 150.000 Jahre mit zwei antarktischen Eisbohrkernen in der oberen Graphik und NGRIP (Nordgrönland) in der unteren Graphik:

Abbildung 5 – click to expand

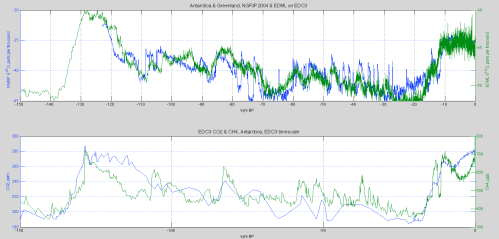

Und hier nun sehen wir EDML (hochaufgelöster Antarktis-Bohrkern) im Vergleich zu NGRIP (Grönland) während der letzten 150.000 Jahre (NGRIP reicht nur 123.000 Jahre zurück) plus CO2 & CH4 aus EDC – erneut zeigt sich die enge Korrespondenz von CO2 und CH4 mit den Temperaturaufzeichnungen in beiden Polargebieten:

Abbildung 6 – click to expand

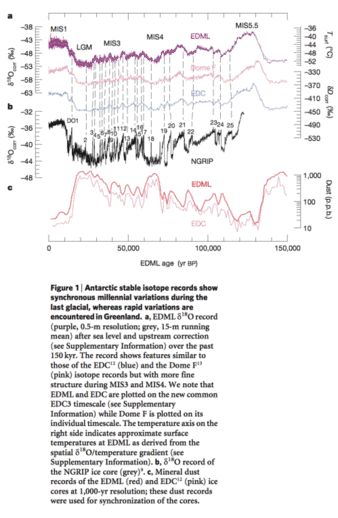

Der Vergleich und der Bezug zu „abrupter Klimaänderung“ in Grönland und der Antarktis wurde von EPICA 2006 thematisiert (man beachte, dass die Zeitskala in entgegen gesetzter Richtung zu den Graphiken oben verläuft).

Bildinschrift: Aufzeichnungen stabiler Isotope in der Antarktis zeigen synchrone tausendjährige Variationen während der letzten Eiszeit, während rapide Variationen in Grönland auftraten. a) EDML δ18O-Aufzeichnung (violett, Auflösung 0,5 m; Grau: 15 m gleitendes Mittel) nach der Korrektur von Meeresspiegel und stromaufwärts (siehe ergänzende Information) während der letzten 150.000 Jahre. Die Isotopen-Aufzeichnung zeigt Eigenarten ähnlich denen von EDC12 (blau) und Dome F13 (rosa), aber mit feinerer Struktur während MIS3 und MIS4. Wir bemerken, dass EDML und EDC geplottet sind im neuen allgemeinen EDC3-Zeitmaßstab (siehe ergänzende Information) während Dome F geplottet ist in seinem individuellen Zeitmaßstab. Die Temperaturachse auf der rechten Seite zeigt angenäherte Bodentemperaturen bei EDML, wie abgeleitet aus dem räumlichen Gradienten zwischen δ18O und Temperatur. b) δ18O-Aufzeichnung des NGRIP-Eisbohrkerns (grau). c) Staubaufzeichnung en der Eisbohrkerne EDML (rot) und EDC12 (rosa) in einer Auflösung von 1000 Jahren; diese Staub-Aufzeichnungen wurden benutzt für die zeitliche Synchronisation der Bohrkerne.

aus EPICA 2006

Abbildung 7 – click to expand

Zeitmaßstäbe

Wie die meisten Studien einräumen, ist der Zugang zu Daten der genauesten „hypothesenfreien“ Zeitmaßstäbe der Heilige Gral der Eiszeit-Analyse. Allerdings gibt es keine hypothesefreien Zeitmaßstäbe. Aber es gab inzwischen viele Fortschritte. Huybers Zeitmaßstab basiert primär auf a) Sedimentierungs-Modellen, b) dem Zusammenbinden der verschiedenen identifizierten Zeitpunkte der Anfänge und Beendigungen für jede einzelne Proxy und c) der unabhängig datierten Brunhes-Matuyama-Umkehrung vor 780.000 Jahren. Der Zeitmaßstab von EDC (EPICA Dome C) basiert auf einer Vielfalt von Altersmarkierungen:

●Für die ersten 50.000 Jahre mit der Verbindung der Daten mit Grönland (via hoher Auflösung von CH4 in beiden Aufzeichnungen), die nach Schichten gezählt werden können, infolge viel höheren Niederschlags.

●Vulkanausbrüche

●10Be-Ereignisse (Be10 ist ein kosmisches Isotop, red. Anmerkung), die unabhängig datiert werden können

●Eisfluss-Modelle – wie Eis unter Druck fließt und komprimiert wird

●und schließlich „orbitales Tuning“

EDC2 war der Zeitmaßstab, mit dem die Daten im bahnbrechenden 2004 EPICA-Paper präsentiert worden sind. Diese 2004 Studie zeigte den EDC-Bohrkern zurück bis 800.000 Jahre (davor war der Vostok-Bohrkern am längsten, der 400.000 Jahre zurückreichte). Die EPICA 2006-Studie war dann der Dronning Maud Land Core (EDML), der einen kürzeren Zeitraum abdeckte (150.000 Jahre), jedoch mit höherer Auflösung, was eine bessere Abstimmung zwischen der Antarktis und Grönland ermöglichte. Dies führte schließlich zu dem verbesserten EDC3-Zeitmaßstab.

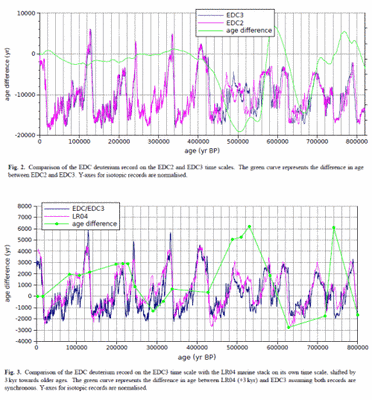

In einer technischen Studie zur Datierung zeigen Parannin et al. 2007 die Unterschiede zwischen EDC3 und EDC2 und auch zwischen EDC3 und LR04.

Abbildung 8 – Click to Expand

Falls man also Daten hat, muss man den Zeitmaßstab kennen, in dem sie geplottet sind. Ich verfüge über den EDC3-Zeitmaßstab hinsichtlich Eisbohrkern-Tiefe, so dass ich als Nächstes die EDC-Temperatur-Proxy (δD) von EDC2 auf EDC3 bringen werde. Ich habe auch Staubwerte bzw. Eisbohrkern-Tiefen für den EDC-Bohrkern – Staub als eine weitere faszinierende Variable, die zum Höhepunkt von Eiszeiten etwa 25 mal stärker ist im Vergleich zu Zwischeneiszeiten – all dies erfordert die Konversion zum EDC3-Zeitmaßstab. Andere Daten enthalten u. A. noch weitere atmosphärische Komponenten. Dann verfüge ich über die NGRIP-Daten (Nordgrönland), die 123.000 Jahre zurückreichen, allerdings im ursprünglichen Zeitmaßstab von 2004, der dann in den GICC5-Zeitmaßstab übergeführt wurde. Mitte 2013 wurde schließlich ein neuer antarktischer Zeitmaßstab vorgeschlagen – AICC2012 – der alle antarktischen Bohrkerne in einen gemeinsamen Zeitmaßstab zusammenführt. Siehe Referenzen unten.

Conclusion

Dieser Artikel sollte Schiefe und Präzession in einer anderen und hoffentlich nützlicheren Weise beleuchten und am Anfang einige Daten in hoher Auflösung zeigen.

References

Glacial variability over the last two million years: an extended depth-derived agemodel, continuous obliquity pacing, and the Pleistocene progression, Peter Huybers, Quaternary Science Reviews (2007) – free paper

Eight glacial cycles from an Antarctic ice core, EPICA community members, Nature (2004) – free paper

One-to-one coupling of glacial climate variability in Greenland and Antarctica, EPICA Community Members, Nature (2006) – free paper

High-resolution carbon dioxide concentration record 650,000–800,000 years before present, Lüthi et al, Nature (2008)

Orbital and millennial-scale features of atmospheric CH4 over the past 800,000 years, Loulergue et al, Nature (2008)

A Pliocene-Pleistocene stack of 57 globally distributed benthic D18O records, Lorraine Lisiecki & Maureen E. Raymo, Paleoceanography (2005) – free paper

The EDC3 chronology for the EPICA Dome C ice core, Parennin et al, Climate of the Past (2007) – free paper

An optimized multi-proxy, multi-site Antarctic ice and gas orbital chronology (AICC2012): 120–800 ka, L. Bazin et al, Climate of the Past (2013) – free paper

The Antarctic ice core chronology (AICC2012): an optimized multi-parameter and multi-site dating approach for the last 120 thousand years, D. Veres et al, Climate of the Past (2013) – free paper

Anmerkungen

Anmerkung 1 – See for example Thirteen – Terminator II, under the heading What is the basis for the SPECMAP dating?

It is important to understand the assumptions built into every ice age database.

Huybers 2007 continues the work of HW04 (Huybers & Wunsch 2004) which attempts to produce a global proxy datbase (a proxy for global ice volume) without any assumptions relating to the “Milankovitch theory”.

Link: http://scienceofdoom.com/2014/01/30/ghosts-of-climates-past-fourteen-concepts-hd-data/

Teil I und II: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-i-und-ii/

Teil III: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iii-hays-imbrie-shackleton/

Teil IV: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iv-umlaufbahnen-jahreszeiten-und-mehr/

Teil V: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-v-aenderungen-der-ekliptik-und-der-praezession/

Teil VI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-vi-hypothesen-im-ueberfluss/

Teil VII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-7-global-circulation-models-i/

Teil VIII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-8-global-circulation-models-ii/

Teil IX: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-9-global-circulation-models-iii/

Teil X: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-10-global-circulation-models-iv/

Teil XI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-xi-das-ende-der-letzten-eiszeit/

Teil XII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-xii-gcm-v-wie-enden-eiszeiten/

Teil XIII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-xiii-terminator-ii/