Grüner Staatsekretär und Ex-AGORA Chef Baake gegen Gesinnungsgrünen und AGORA Chef Graichen:

Dr. Patrick Graichen, vom Umweltministerium “ausgeliehener” Chef von “Agora- Energiewende“ wie man auf deren Website nachlesen kann,.. „eine gemeinsame Initiative der Stiftung Mercator und der European Climate Foundation“ hatte jüngst in einem Anfall von Ehrlichkeit behauptet: „Wir haben uns geirrt!“ und meinte damit, dass die NIE (Nachhaltig instabile Energien) statt der verhassten Kern- und Kohlekraftwerke nunmehr die „guten“ Gaskraftwerke verdrängen. ZEIT Redakteur Frank Drieschner fasste sein Interview mit Graichen so zusammen (alle Details hier):

Graichen sagt kurz gefasst: Nicht in ein paar Details, sondern in einem zentralen Punkt. Die vielen Windräder und Solaranlagen, die Deutschland baut, leisten nicht das, was wir uns von ihnen versprochen haben. Wir hatten gehofft, dass sie die schmutzigen Kohlekraftwerke ersetzen würden, die schlimmste Quelle von Treibhausgasen. Doch das tun sie nicht… und weiter schreibt Drieschner…

Um den Irrtum zu verstehen, muss man sich noch einmal den Grundgedanken der Energiewende vor Augen führen. Der ging ungefähr so: Deutschland steigt aus der Nuklearenergie aus und setzt stattdessen auf erneuerbare Energien, auf Sonne und Wind vor allem. Wenn es mal nicht genug Ökostrom gibt, dann springen Emissionsarme Gaskraftwerke ein, bis irgendwann auch diese überflüssig werden. Der böse Atomstrom verschwindet zuerst, als Nächstes der schmutzige Kohlestrom, die Luft wird sauberer, und Deutschland wird zum Vorbild und Vorreiter beim Klimaschutz.

So haben sich das alle gedacht. Nur leider wird daraus nichts. Das ist der Irrtum, den Patrick Graichen beklagt.

…………»Im Nachhinein ist das alles logisch«, sagt Graichen. »Trotzdem hat hier vor drei, vier Jahren keiner diese Logik so durchschaut. «

Doch obwohl dieses Statement bereits einem Offenbarungseid gleichkommt, ließ es ihm Drieschner nicht als sozusagen „höhere Gewalt“ durchgehen, sondern ging ihn und seine Kollegen im Artikel „Schmutziger Irrtum“ kräftig an. So erkennt Drieschner richtig…

…Die Energiewende würde nicht funktionieren: Wer es wissen wollte, der konnte es wissen, auch damals schon. Aber wer wollte es wissen? Rund um die Erneuerbaren ist in den vergangenen Jahren ein regelrechter politisch-industrieller Komplex herangewachsen. Sein Einfluss ist wahrscheinlich nur dem Geflecht zwischen Staat und Atomwirtschaft im vergangenen Jahrhundert vergleichbar. Alle Akteure in diesem Komplex verbindet ein Interesse: Probleme der Energiewende müssen lösbar erscheinen, damit die Wind- und Sonnenbranche weiter subventioniert werden.”

Von dieser ebenso richtigen, wie späten Erkenntnis alarmiert, meldete sich der heutige grüne Staatssekretär im Bundeswirtschaftsministerium und vorherige AGORA Chef Baake empört zu Wort. Was nicht ist, was nicht sein darf, ist ganz offensichtlich sein Credo, denn er verlangte und bekam von „DIE ZEIT“ Platz für eine ausführliche Stellungnahme zu den Ausführungen von Graichen/Drieschner. Die erschien dann am 12.12.14 in der Online-Ausgabe unter dem trotzigen Titel:

und fängt dann mit den folgenden Behauptungen an:

„Die deutsche Energiepolitik funktioniert.“

Um dann nach bekannter Politikerart, das Offensichtliche – aber mit der Abschwächung „vorerst“- einzugestehen:

„Trotzdem steigt vorerst die Klimabelastung. Eine Antwort auf Frank Drieschner „

Im dann folgenden Text wird dann erst einmal auf die große Errungenschaft des EEG eingegangen, an der Baake, damals grüner Staatssekretär unter Umweltminister Jürgen Trittin, so kräftig beteiligt war, dass man es fast sein Baby nennen könnte. Um dann in den folgenden Absätzen immer wieder geschickt Ursache und Wirkung zu vertauschen. Danach ist zwar der Anteil von Elektroenergie aus NIE Quellen um 114 TWh gestiegen – was weder Graichen noch Drieschner bestritten hatten- und Elektroenergie aus Kernkraftwerken um 72 TWh gefallen – was auch niemand bestreitet, 8 Kernkraftwerke wurden ja zwangsweise abgeschaltet- um dann richtig festzustellen, dass trotz dieser segensreichen Wirkung des EEG, die Stromproduktion aus fossil befeuerten Kraftwerken auf „gleichem Niveau“ lag wie zu Beginn. Dass sie sogar um 13 TWh[1] höher lagen als im Jahre 2000 verschweigt Baake aber dem Leser. Und auch, dass die NIE Quellen bereits 2013 mit 147 TWh, also mit rd. 25 %, an der gesamten Stromerzeugung beteiligt waren. Und damit eigentlich die Produktion aus den 8 KKW ohne zusätzlichen CO2 Ausstoß komplett hätten ersetzen können und müssen. Wenn, ja wenn nicht das leidige Problem der auch noch zufälligen Volatilität da wäre. Weil dieser in Massen und völlig am Bedarf vorbei erzeugte NIE Zufalls-Strom, zwar von niemandem gebraucht wurde, aber auf jeden Fall abgenommen, vom Verbraucher bezahlt und ins Netz eingespeist werden musste und sich deshalb seinen Weg – oft ins Ausland- suchte. Häufig war es nur per Zuzahlung – vornehmer „negativer Preis“ genannt- bereit ihn auch abzunehmen.. Beim grünen Baake[2] liest sich diese staatliche erzwungene Ressourcen- und Geldverschwendung so

Den Betreibern von Kohlekraftwerken gelang es in den vergangenen Jahren, immer größere Strommengen ins Ausland zu verkaufen. Dies blieb nicht ohne Wirkung auf die Klimabilanz in Deutschland.

Kein Wort von der staatlicherseits angeordneten Überproduktion untauglichen Stroms, der per gesetzlich festgeschriebener Vorrangeinspeisung in jeder Menge und zu jeder Zeit zu festgelegten Preisen ins Netz gedrückt wird.

Stattdessen versucht er hier zum ersten Mal den Leser auf eine falsche Fährte zu locken. Denn, weil – so seine spitzfindige Erklärung- Deutschland zu viel Strom produzierte, und zwar nicht etwa aus NIE Quellen, sondern aus Kohlekraftwerken, hätte man diesen nur ins Ausland verkaufen können. Leider gelegentlich auch, so Baake, nur unter Zuzahlungen- aber dies nur, weil, so will er die Leser glauben machen, die Fossil-Kraftwerker ihre Produktion nicht schnell genug hätten absenken können. Und nur deshalb, so Baake, seien die CO2 Emissionen –leider, leider, leider, wieder angestiegen.

Und auch, weil die Fossil-Kraftwerker zu wenig für ihre Emissionsrechte zu zahlen hätten. Denn, wenn wie geplant, diese einen Preis von 25 bis 30 € pro Tonne CO2 hätten, wäre Kohlestrom viel zu teuer und nur Strom aus den jetzt noch teureren Gaskraftwerken hätte die unvermeidlichen Lücken füllen können. Daher sei

„…Die schlechte CO₂-Bilanz (ist) nicht das Ergebnis des "schmutzigen Irrtums" einer fehlgeleiteten Energiewende, sondern das eines politischen Versagens.“

Und versagt hätten nicht etwa er und seine anderen grünen Genossen aller Parteien, die den Verbrauchern doppelt und dreifach überteuerten Strom aufzwingen wollen, sondern die anderen. Die hätten aus politischem Kalkül, das ihm und seinen Genossen natürlich völlig abgeht, diese Mehrfach-Abzocke verhindert. Vornehmlich die EU“…. die Russland, die Ukraine und China; ..ihr Emissionshandelssystem hineingelassen (hat).“

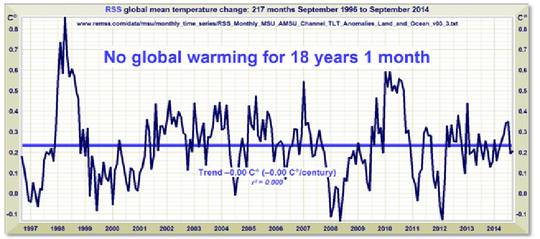

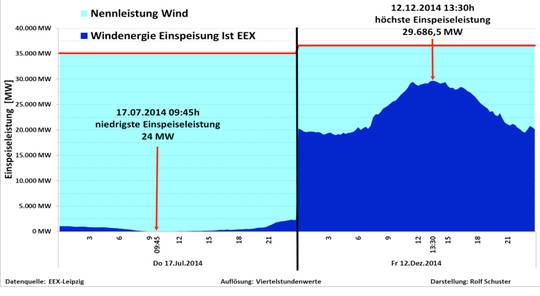

Abbildung 1: Windeinspeisung von Strom am 17.7.14 mit 24 MW im Minimum und am 12.12.14 mit 29.687 MW. Die Differenz müssen die fossil befeuerten und Kernkraftwerke ausgleichen.

Welche Konsequenz diese Forderung nach mehr Flexibilität für die konventionellen Kraftwerksbetreiber hat, zeigt eindrucksvoll Abb. 1. Die eingespeiste Windleistung schwankte zwischen diesen beiden Tagen um das rd. 1.200 fache. Nur ein sehr krankes Hirn kann sich diese Art der Stromversorgung für ein Industrieland ausdenken. Doch Baake ficht das alles nicht an. Denn niemals dürften er und/oder seine Gesinnungsgenossen sich in die Niederungen der Naturgesetze gegeben haben, nach denen sich alles richten muss. Auch die Politik. Ob sie will oder nicht.

Naturwissenschaften gehören in diesen Kreisen eben nicht zur Bildung, wie der intelligente Spötter, Anglist und Romancier Schwanitz schon vor Jahren zwar überheblich aber treffend feststellte. Prof. Helmut Alt bringt die verheerend irreführenden Aussagen des Staatssekretärs Baake daher konsequent auf den Punkt:

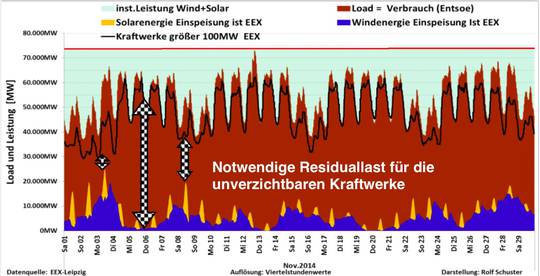

Warum die Argumentation von Herrn Rainer Baake, Staatsekretär im BMWI, energietechnisch und energiewirtschaftlich unvertretbar ist, kann mit dem neben- stehenden Leistungsdiagramm für den Monat November 2014 bereits hinreichend bewiesen werden:

Abb. 2 : Wind- Solar und konvent. Leistungs-Einspeisung für den Nov. 2014

Zum Zeitpunkt des Leistungsmaximums am Donnerstag den 13. November 2014 war die Summe aus Wind- und Sonnenleistung nahezu gleich Null. An solchen Tagen zeigt sich als harte Realität in Deutschland, dass auch bei beliebig vielen Wind- und Sonnenanlagen die hundertprozentige Ersatzleistungsbereitstellung aus konventionellen Kraftwerken unabdingbar ist. Da können auch teure „smart grids“ nicht weiterhelfen.

Man benötigt also komplett zwei Systeme, eines für die Zeit, wenn der Wind weht und eines wie bisher, für die Zeit wenn der Wind nicht weht! Das wird aber unter Wettbewerbsbedingungen unbezahlbar und für unser Land unzumutbar sein. Die 72 TWh KKW – Strom zu 3,5 ct/kWh wurden ersetzt durch fluktuierenden EEG-Strom zu rd. 16 ct/kWh, also zu Mehrkosten von jährlich über 9 Mrd. €!

Daher ist es auch so unkritisch, ob die Transportleitungen gebaut oder termingerecht fertig werden, so lange die BNA die Abschaltung der vorhandenen Kraftwerke verbietet – und das wird so sein – (und die Eigentümer dann nicht insolvent werden, vorsichtshalber gliedert E.ON schon mal die Kraftwerkssparte aus!), haben wir doch eine sichere Stromversorgung. Nicht verfügbare Transportleitungen erhöhen nur faktisch die Zeitdauer der ohnehin auftretenden Windflauten!

Doch das ist noch nicht alles was Baake so an Irreführung betreibt. Denn auch er will den Leser glauben machen, dass man nur das Netz groß genug machen müsse, um Schwankungen jederzeit aus diesem Netz ausgleichen könne. Gräbt also die Schnapsidee vom Stromsee wieder aus. Denn, so doziert er:

„…Unser zukünftiges Stromsystem wird sehr dezentral sein. Millionen von Erzeugern werden mit Kunden über intelligente Systeme verbunden sein. Der Übergang ist so radikal wie die Ablösung der Großrechner durch PCs. Dezentralität darf aber nicht mit Autonomie verwechselt werden. Die Energiewende in Deutschland wird sich vor allem auf Windkraftanlagen und Photovoltaik (PV) stützen. Nur mit diesen kann regenerativer Strom in ausreichender Menge und kostengünstig hergestellt werden. „

Offensichtlich hat Baake noch nie eine europäische Wetterkarte mit ihren europaweiten Hoch- und Tiefs gesehen. Viel Strom hier bedeutet also fast immer (zu)viel Strom dort, oder auch das Gegenteil, kein Strom hier bedeutet also fast immer kein Strom dort. Das Netz gleicht überhaupt nichts aus, mag es so „intelligent“ sein, wie seine Schöpfer es uns weismachen wollen, sondern transportiert -mit fast Lichtgeschwindigkeit- die daraus entstehende Instabilität in die entlegensten Winkel.

Und dann legt er noch eine falsche Spur, denn die Volatilität seiner Favoriten sieht er durchaus, glaubt aber, indem er das Problem auf ganz Europa verlagert, seine Leser weiter für dumm verkaufen zu können und bietet ihnen dafür die folgende „Lektion“ an

„..Die erste Lektion lautet: Je besser wir uns in Deutschland und Europa mit Netzen verbinden, umso einfacher und kostengünstiger wird die Energiewende. Weil der Wind nicht überall gleich stark weht und die Sonne je nach Wetter in den Regionen unterschiedlich stark scheint, müssen die Schwankungen durch Netze ausgeglichen werden…“

Kein Wort davon, dass sowohl diese Stromerzeugung, wie Verteilung, wenn sie denn gebaut würden, erneut die Kosten, den Landschaftsverbrauch, die Tiermassaker, die Instabilität in immer neue astronomische Höhen treibt. Im Gegenteil, Baake faselt von „einfacher und kostengünstiger“ Energiewende.

Und damit immer noch nicht genug. Er will uns noch weitere Lektionen lehren (Hervorhebung vom Autor):

Die zweite Lektion lautet: Unser System muss flexibler werden. Konventionelle Stromerzeuger mussten ihre Produktion schon immer an die sich pausenlos, aber ziemlich regelmäßig ändernde Nachfrage anpassen. Jetzt müssen sich die Stromerzeuger zusätzlich an der wetterabhängigen Produktion von Strom aus Wind und Sonne ausrichten. Das hat nichts mit dem gesetzlichen Vorrang der Erneuerbaren in unseren Netzen zu tun, sondern hat seine Ursache in der Logik des Strommarkts. …

Offensichtlich rechnet Baake damit, dass ihm seine Leser bei DIE ZEIT diese komplette Verdrehung der Wirklichkeit nicht nur abnehmen, sondern auch weiterhin seinen wirren Vorstellungen folgen. So geht es nämlich bis zum Ende des Artikel weiter und weiter und weiter. Weil nicht anders möglich, bereitet er – aus Rücksichtnahme auf die Volatilität, und die damit verbundene Backup-Notwendigkeit- einer staatlichen Planwirtschaft bei den Versorgern den Weg, indem er einen „Kapazitätsmarkt“ fordert, und verspricht dann den Gläubigen eine heile, helle Stromzukunft. Nicht ohne zuvor die irrwitzige Behauptung aufgestellt zu haben:

Für die Versorgung mit erneuerbaren Energien verfügen wir heute über leistungsfähige Technologien. Sie können Strom kostengünstig produzieren.

Zwar ist die tägliche Realität ein kompletter Gegenbeweis für diese steile These, aber das ficht einen wahren, dazu in der Sache völlig ahnungslosen jedoch tiefgläubigen Politiker, nicht an. Denn am Schluss formuliert er seine völlig realitätsfremde Vision und beschwört die Leser (Hervorhebungen vom Autor):

Entscheidend ist jetzt, dass wir ein neues, dezentrales und vernetztes Stromsystem mit niedrigen Systemkosten errichten. Die Energiewende darf nicht nur eine ökologische, sie muss auch eine ökonomische Erfolgsgeschichte werden. Wir müssen zeigen, dass es möglich ist, eines der größten Industrieländer der Welt mit wachsenden Anteilen erneuerbarer Energien zuverlässig und mit bezahlbaren Preisen zu versorgen. Die Welt beobachtet uns sehr genau. Wenn uns der Umstieg auf regenerative Quellen gelingt und Wertschöpfung und Arbeitsplätze in der Industrie erhalten bleiben, dann wird dieses Beispiel der größte Beitrag sein, den Deutschland im Kampf gegen den Klimawandel leisten kann.

Da fragt sich der kühle Beobachter: Und wenn nicht? Wenn der Kampf gegen die Naturgesetze zwangsläufig gescheitert ist, wer kommt dann für den bewusst angerichteten Schaden auf? Werden dann Herr Baake und seine Genossen zur Verantwortung gezogen? Vermutlich nicht, stattdessen werden sie befördert werden und ihre Nachfolger weiter emsig nach einem dritten Weg suchen.

Ob das am Anfang dieses dialektischen Baakeschen Aufrufs stehende Bekenntnis seines Nachfolgers bei AGORA „Wir haben uns geirrt“ Graichen zu personellen Konsequenzen für den mutigen Bekenner führen wird, wissen wir nicht. Es ist aber sehr wahrscheinlich, auch wenn dieser, als nur „beurlaubter“ Beamter, dann sicher weich fallen wird. Wir werden daher das Gespann Baake/Graichen im Auge behalten. Und Finanziers von AGORA nämlich die Mercator Stiftung und die European Climate Foundation auch.

[1] Quelle: Arbeitsgemeinschaft Energiebilanzen AGEB siehe Bruttostromerzeugung Deutschland in TWh;

[2] Bei Wikipedia findet man über Baake (Auszug): Nach dem Abitur arbeitete Rainer Baake von 1974 bis 1978 als Community Organizer in Chicago. Er studierte darauf Anfang der 1980er Jahre in MarburgVolkswirtschaft und wurde Diplom-Volkswirt. 1983 trat Baake den Grünen bei und übernahm 1985 nach eigenen Angaben als erster Grüner ein hauptamtliches Wahlamt: Nach dem Abschluss von Koalitionsverhandlungen zwischen SPD und Grünen wählte der Kreistag des Landkreises Marburg-Biedenkopf Baake zum Ersten Kreisbeigeordneten und Stellvertreter des Landrates. Dabei trug er unter anderem auch Verantwortung als Umweltdezernent.[3] Rainer Baake war Staatssekretär im damaligen Hessischen Ministerium für Umwelt, Energie und Bundesangelegenheiten (1991 bis 28. Oktober 1998, siehe Kabinett Eichel I und II) unter Joschka Fischer. Zusammen mit Fischer legte er die Hanauer Nuklearbetriebe still und diskutierte mit RWE die Sicherheit des Atomkraftwerkes Biblis. Baake erarbeitete Strategien zur Förderung der Erneuerbaren Energien und zur Steigerung der Energieeffizienz.