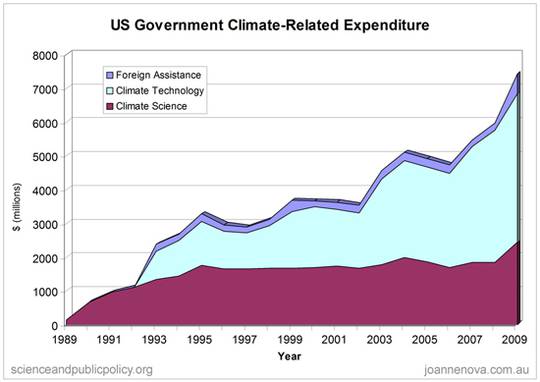

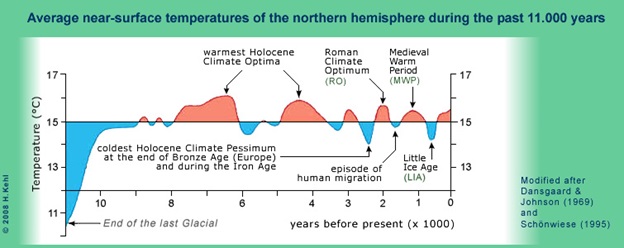

Abb.1 zeigt die Temperaturentwicklung der letzten 11.000 Jahre nach Schönwiese. Gleich zu mehreren Zeiten war es wärmer als heute, Quelle: PD Dr. H. Kehl

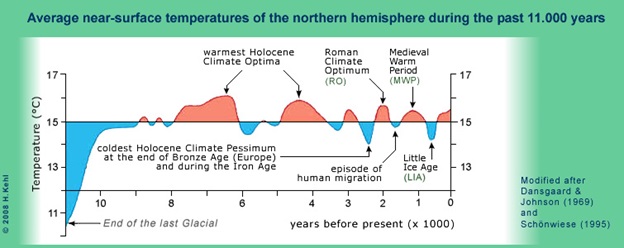

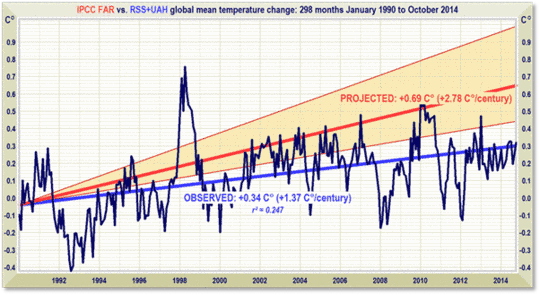

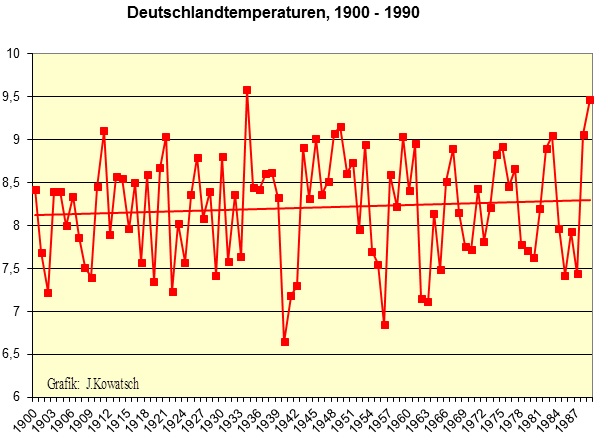

So lässt auch die Gegenwart keinen Raum zur Sorge oder gar Panikmache. Der Temperaturanstieg nach der letzten Kälteperiode, die etwa bis 1850 reichte, fiel nicht nur in unserm Land verhalten aus (Abb.2).

Abb.2: In den ersten 90 Jahren des letzten Jahrhunderts war das Klima weitgehend stabil. Neben dem ständigen Wechselspiel zwischen wärmeren und kälteren Jahren, gab es Zwischenphasen mit leichten Erwärmungen aber auch kältere Jahrzehnte. Man beachte vor allem den Kälteeinbruch 1940/41/42, der auf einen starken El Nino zurückzuführen war, wie Untersuchungen der ETH, Prof. Brönnimann, zeigen (Spektrum der Wissenschaft 03/05, “Pazifik ließ Europa frieren“). Wie wir heute wissen, sind die Auswirkungen von El Nino weltweit zu spüren.

Zwischen 1900 bis 1990 sind die Temperaturen in Deutschland kaum gestiegen. Der leichte Trendlinienanstieg ist zum einen auf den ansteigenden Hauptsonnenzyklus (den im Mittel 208-jährigen De Vries/Suess-Zyklus) und zum anderen, auf den zunehmenden Wärmeinseleffekt, der Verstädterung der Landschaft, zurück zu führen. Die eigentliche „Klimalüge“ nahm 1988 an Fahrt auf, als sich der selbsternannte Weltklimarat gründete (von der Politik gegründet wurde) und ohne belastbare physikalische Grundlagen postulierte, dass die ständige Zunahme an Kohlendioxid in der Atmosphäre einen Treibhauseffekt verursachen würde und damit einen Gärtnerbegriff, der auf der physikalischen Grundlage der Konvektionsunterdrückung und der verzögerten Abkühlung (Abkühlungsgesetz nach Newton) beruht, auf die Erdatmosphäre übertrugen, ohne zu berücksichtigen, dass dort gänzlich andere Rahmenbedingungen vorliegen, als in einem Gärtnerhäuschen.

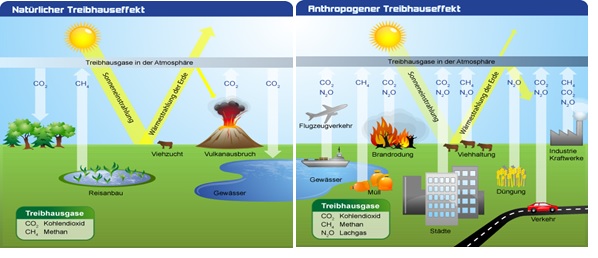

„Treibhauseffekt“

Der Begriff “Treibhauseffekt“ basiert auf der Absorptionswirkung der Atmosphärengase für die sog. Erdrückstrahlung oder auch „Gegenstrahlung“ genannt, was in den Modellen theoretisch mit dem Glasdach eines Treibhauses vergleichbar wäre, welches die Wärme sozusagen „einsperrt“. Der Begriff ist jedoch irreführend, da in einem Glastreibhaus die Erwärmung durch die unterdrückte Konvektion (Luftaustausch) und der verzögerten Abkühlung erfolgt. Die Analogie zum Glastreibhaus besteht darin, dass sowohl das Glas eines Gewächshauses, als auch die sog. Treibhausgase wie CO2, einen Teil der langwelligen IR-Strahlung, die vom Boden abgestrahlt wird, absorbieren. Wobei Absorption keinesfalls gleich Erwärmung ist, da beides völlig unterschiedliche physikalische Begriffe sind. Die Atmosphärengase (Moleküle), allen voran der Wasserdampf, werden dadurch zu Schwingungen angeregt. Der sog. Treibhauseffekt wurde von dem Chemiker Arrhenius bereits 1896 als mögliche Erderwärmung in die wissenschaftliche Diskussion gebracht, dort aber nach etwa 10 Jahren Diskussion (Angström, 1900, 1901 und Schäfer 1903; Solger, 1905; Dannenberg, 1908) wieder verworfen.

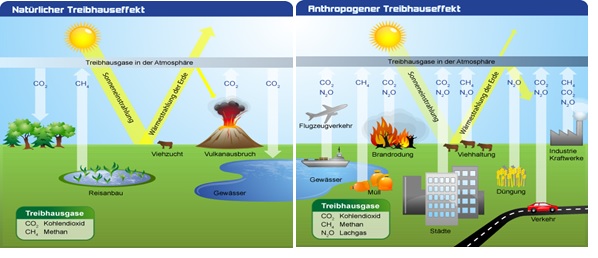

Abb.3: Schematische Darstellung des vermeintlichen natürlichen und des vermeintlichen anthropogenen Treibhauseffekts. Die Abbildung links zeigt den sog. natürlichen Treibhauseffekt (THE). Wasserdampf und Kohlenstoffverbindungen in der Atmosphäre sollen wie die Scheiben eines Glashauses wirken. Hierdurch wird die rein rechnerische Temperatur der Erde ohne Atmosphäre von -18°C auf erträgliche +15°C angehoben. Die Erde würde sich demnach ohne zusätzliche Energie von selbst erwärmen, was grundsätzlich nicht möglich ist. Die sog. Treibhausgase lassen das kurzwellige Licht durch, verhindern aber teilweise die Rückstrahlung der langwelligen Infrarotstrahlung in den Weltraum. Abbildung rechts zeigt den sog. anthropogenen Treibhauseffekt. Durch das Ausbringen großer Mengen sog. Treibhausgase durch den Menschen, sollen die natürlichen Regelprozesse, der Kohlenstoffkreislauf, aus dem Gleichgewicht geraten und eine ungebremste Erwärmung stattfinden. Die Politik will diese auf 2°C begrenzen.

Der überwiegende Teil (ca. 60-80%) der Bodenwärme wird nicht über Strahlung, sondern über Konvektion abgegeben. Auf dem Weg nach oben wird die innere Energie der Gase gemäß dem 1. Hauptsatz der Thermodynamik in Volumenarbeit umgesetzt, weil die Gase sich bei ihrem Aufstieg ausdehnen. Die Energie wird letztendlich in großer Höhe (der oberen Atmosphärenschicht) in das Weltall abgestrahlt. Die übrigen 20-40% werden vom Boden als Wärmestrahlung abgegeben. Davon geht der größte Anteil direkt durch das atmosphärische Fenster in den Weltraum. Dabei erfolgt der Wärmetransport in der Troposphäre adiabatisch, d.h. durch Konvektion und Advektion und oberhalb der Troposphäre gewinnt, aufgrund der stetig abnehmenden Teilchendichte, die Strahlungsübertragung an Bedeutung. Am Oberrand der Atmosphäre kann Wärme nur noch über Strahlung an den Weltraum abgegeben werden.

Ein kleiner Rest der Bodenwärme (ca. 15% von den 20-40%) wird von IR-aktiven Gasen, sog. Treibhausgasen (THG) in der Atmosphäre absorbiert. Diese Energie wird in der Troposphäre über Zusammenstöße an die Luft wieder abgegeben und damit ebenfalls der Konvektion zugeführt und dann aus großer Höhe in das Weltall abgestrahlt. Da diese Abstrahlung jederzeit stattfindet, wird keine Wärme in irgendeinem Kreislauf gehalten oder gar dem Boden wieder zugeführt. Der THE scheitert somit am Energiemangel. Um diesen zu beheben, wird eine sog. Gegenstrahlung eingeführt, die den Boden zusätzlich erwärmen soll. Dies ist jedoch eine Energiebilanzfälschung. Durch diese “Gegenstrahlung“ soll es zu einer Erwärmung am Boden und einer Abkühlung in der Höhe kommen. In Messungen wird dies jedoch widerlegt. Immer, wenn der Boden durch die erhöhte Sonneneinstrahlung wärmer wurde, wird zeitlich verzögert, oben mehr abgestrahlt, wodurch die obere Atmosphäre dann kälter wird.

Daher ist der Vergleich mit einem “Treibhaus“ irreführend. In einem Treibhaus wird durch das Glas der Bereich des sichtbaren Sonnenspektrums durchgelassen. Anhand der Kirchoff-Planck-Funktion lässt sich der Anteil berechnen und liegt bei ca. 70%. Das Strahlungsmaximum liegt anhand der Planck-Kurve (5.800 Kelvin = Sonnenoberflächentemperatur) bei 0,5 μm Wellenlänge. Das Glas ist in diesem Wellenlängenbereich also weitgehend durchlässig. Der Boden eines Gewächshauses hat hingegen eine Temperatur von ca. 300 Kelvin. Nach der Planckkurve und dem Wienschen Verschiebungsgesetz liegt dessen Maximum bei 10 μm. Für diesen Wellenlängenbereich ist das verwendete Glas jedoch undurchlässiger, so dass die Wärmestrahlung „eingeschlossen“ bleibt und weiter, auch die Luftzirkulation, die die Wärme abführen könnte, unterbunden ist. Ein solches Konstrukt gibt es in der Atmosphäre nicht.

Jeder, der sich schon einmal den Kopf an Glas gestoßen hat, kennt den Unterschied zwischen Glas und Gas, also zwischen einem festen und einem gasförmigen Körper.

Anstatt einem Treibhaus, gibt es in der Atmosphäre dagegen Wetter. Das Wetter tritt dabei lokal völlig unterschiedlich auf. Daher existiert auch keine Globaltemperatur. Diese ist eine rein statistische Größe. Die Schichtatmosphäre ist durch einen Dichte- und Temperaturgradienten gekennzeichnet, der in einem elektrischen Feld von ca. 500 kV zwischen Ionosphäre und Erdboden existiert. Kosmische und solare Partikelstrahlung, sowie ca. 2.000 Gewitter, mit über 10 Millionen Blitze, die sich täglich entladen, liefern Energie (direkt oder indirekt) zur Wetterveränderung. Des Weiteren befindet sich im Innern der Erde eine permanente Kernenergieheizung mit einer Maximaltemperatur von ca. 5.000°C, welche geothermische Energie liefert. Organismen an/in der Erdoberfläche produzieren seit über 3 Milliarden Jahre Abwärme. Kontinuierlich wird Wärmeenergie in andere Energieformen (z.B. chemische Energie) umgewandelt. Alle Vorgänge unterliegen zyklischen Veränderungen (Tag/Nacht, Jahreszeiten usw.), bei denen starke Ungleichgewichte entstehen. Die Erde ist weiter eine irreversible (sich drehende) Wärmekraftmaschine nach dem 2. Hauptsatz der Thermodynamik, in der Wärme (Sonnenenergie = warmes Reservoir und Nachtseite/Weltall = kaltes Reservoir) gewandelt wird, wodurch die Wind- und Wasserkreisläufe angetrieben werden, sowie die Photosynthese in Gang gesetzt wird. Mit einem Gewächshaus ist dies alles nicht vergleichbar.

Allein diese Kurzbeschreibung entlarvt den Treibhauseffekt als Chimäre, als Konstrukt, den es in der realen Welt nicht gibt. Ein Konstrukt derer, die ihn dazu instrumentalisieren, um politischen Absichten umzusetzen und/oder finanziellen Gewinn zu erzielen. Und alles zu Lasten derer, die beides finanzieren müssen, uns Steuerzahler. Hier wird ein Schreckgespenst aufgebaut, das gar nicht existiert und mit anderer Leute Geld in die Schranken gewiesen werden soll (2°C-Ziel), damit sich ein paar Wenige als Retter aufspielen können. Dies alles erinnert fatal an den Film „Illuminati“ und den dortigen Camerlengo, der ebenfalls ein nicht vorhandenes Schreckgespenst aufbaute um anschließend als Retter zu erscheinen und Papst zu werden.

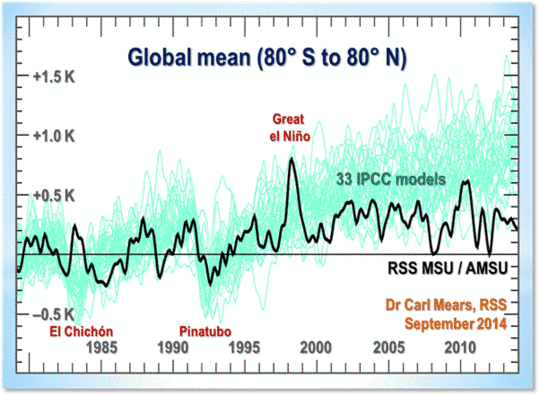

Der Erde droht keine Gefahr der Überhitzung, wie IPCC und Co. behaupten: Wegen des seit über einem Jahrhundert steigenden Kohlendioxidgehaltes auf nunmehr bald 0,04% = 400ppm würden die Temperaturen seit über 100 Jahren ständig steigen. Dass diese Behauptung falsch ist, wissen unsere Leser längst.

Der Deutsche, Hartmut Bachmann, war dabei, als 1988 das IPCC gegründet wurde. Er schildert in vielen Schriften und Büchern, wie dieses Lügengebilde IPCC gegründet wurde, deren Aufgabe es nicht ist, wissenschaftliche Erkenntnis zu gewinnen, also ergebnisoffen ein Thema zu bearbeiten, sondern mit einem fertigen Ergebnis ein Thema angeht. Mit Wissenschaft hat dies nichts zu tun.

http://rubikone.de/downloads/Wind_Allgemein/Klimal%C3%BCge%20Bachmann.pdf

Es begann die Zeit mit ständig neuen Erwärmungskatastrophenmeldungen. Jeder Starkregen und jeder heiße Sommertag war fortan ein Zeichen der sich anbahnenden Katastrophe und wenn es keine gab, dann wurden diese erfunden und die Statistik auf den Kopf gestellt. Obwohl z.B. die Population der Eisbären am Nordpol zunahm, wurde prompt eine Abnahme der Eisbärenpopulation verkündet. Und auch die Inuit, die Ureinwohner, die sich an der Erwärmung Grönlands freuten, wurden vor der Weltöffentlichkeit als Opfer dargestellt.

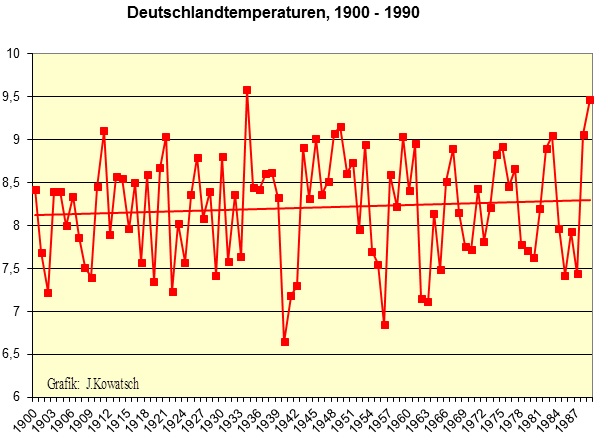

Alle diese fiktiven Berichte dienten und dienen nur dem Zweck, durch weltweit einzuführende Kohlendioxidsteuern/-Abgaben, dem angeblichen Klimakiller zu begegnen. Die C02- und Klimasteuern erweisen sich bis heute als eine geniale Geldvermehrungsmaschine, die der Steuerzahler zu bedienen hat. Sie dienen weder dem Umwelt- noch dem Naturschutz, geschweige dem Klima. Das Klima, als statistische Größe des Wetters, richtet sich nach anderen Faktoren. Dem Wetter ist es vollkommen egal, ob der atmosphärische CO2-Pegel 300ppm, 400ppm oder 500ppm oder mehr beträgt. Es richtet sich nach anderen Faktoren, wie den Windströmungen, der solaren Aktivität, dem Sonnenstand, den Hoch- und Tiefdruckgebieten, der Erdrotation, um nur einige zu nennen und keine dieser Teilaspekte, wird in irgendeiner Art und Weise von sog. Treibhausgasen beeinflusst. Wenn aber kein Teilaspekt des Klimas, das Wetter, von CO2 beeinflusst wird, so wird auch die statistische Gesamtgröße (das Klima) nicht von CO2 beeinflusst. Eigentlich ganz logisch. Aber wo gilt schon Logik, wenn es um politische Interessen und/oder viel Geld geht. Beides beinhaltet eine andere Logik. Diese hat mehr mit Lüge/Verschleierung und Desinformation zu tun.

So sind viele „Wissenschaftler“ der 2.ten Reihe, in Deutschland z.B. die Professoren Schellnhuber, Rahmstorff und Latif auf den Geldzug aufgesprungen, bzw. wurden dafür geworben und vermehren durch Falschaussagen und gespielte Theatralik ihre Finanzen, bzw. derer, die sie unterstützen/beauftragen. Natürlich auch die Medien. Denn der Mainstream will nicht Wahrheit, sondern Sensationen. Ebenso hat die Politik eine zusätzliche vortreffliche Einnahmequelle für marode Staatshaushalte entdeckt.

Abbildung 4 zeigt den Unterschied zwischen einem aufrechten Wissenschaftler und einem Mainstream-Wissenschaftler aus Karikatursicht.

Seröse Wissenschaft ist hier seit mehr als 20 Jahren ins Abseits gestellt. Früher starben z.B. die Schmetterlinge wegen der Uniformierung der Landschaft (keine Brutablagen), der Zerstörung und Vergiftung ihrer Biotope. Heute sterben sie wegen des Klimawandels. So sind auch die Umweltverbände zu Mitschuldigen geworden, denn sie beteiligen sich gerne an diesem Geldsegen zur angeblichen Rettung der Erde und mehren dadurch ihre(n) Macht/Einfluss, weil sie den Geldgewinnlern nach dem Mund reden.

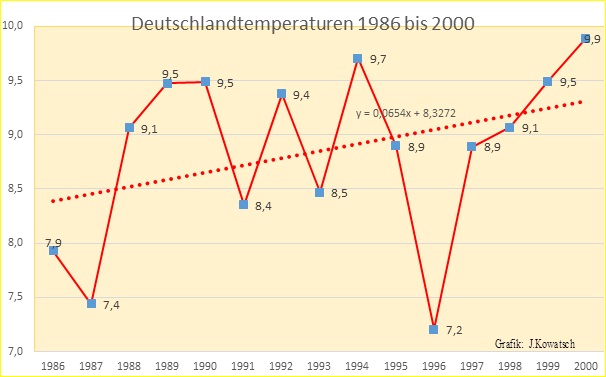

Geschickt wurde Cherry-Picking betrieben und die Jahre der Temperaturentwicklung betrachtet, die mit der atmosphärischen CO2-Zunahme im Gleichklang stehen. Der CO2-Gehalt der Atmosphäre nahm zu und auch die Temperaturen stiegen ab 1886/87 weltweit. So auch in Deutschland. Das staatliche Institut, DWD, wurde von der Politik für ihre Zwecke benutzt und schürt seither, fernab aller wissenschaftlichen Realitäten, die Mär des anthropogenen Klimawandels.

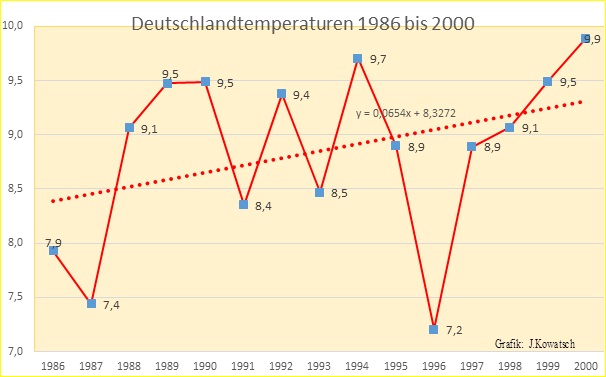

Um die Jahrtausendwende begannen dann die Hiobsbotschaften des Klimapanikorchesters, zu dem auch die großen Versicherungsgesellschaften zählen. Man hatte ein starkes Jahrzehnt der Erwärmung von 1986 an vorzuweisen und die meisten Menschen glaubten zur Jahrtausendwende, es würde so weitergehen. Doch betrachten wir zunächst die Grafik 5, die Jahre der steigenden Temperaturen.

Abb.5: In der Zeit von 1986 bis zur Jahrtausendwende stiegen die weltweiten Temperaturen ständig an, die vereinigte Front der Klimaerwärmungsbefürworter konnte eine für sie erfolgreiche Statistik vorlegen.

Ein Teil dieser Erwärmung von 1986 bis 2000 geht dabei auch auf Tricksereien zurück. Z.B. wurde das hier beschrieben: http://www.eike-klima-energie.eu/news-cache/neue-studie-die-haelfte-der-globalen-erwaermung-kommt-aus-der-homogenisierung-von-wetterstationsdaten/ Schließlich waren die Leute vom selbsternannten Weltklimarat nun aktiv und griffen in die Statistik der Datenerfassung aktiv ein. 2009 kam durch Climategate einiges ans Licht der Öffentlichkeit.

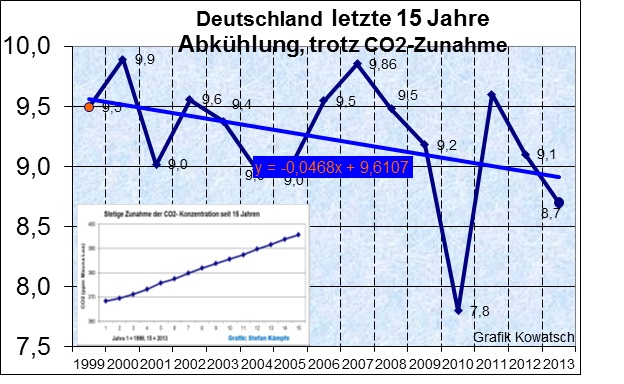

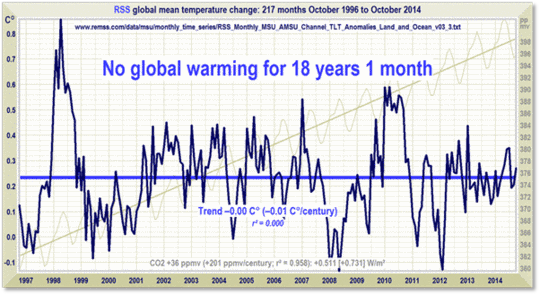

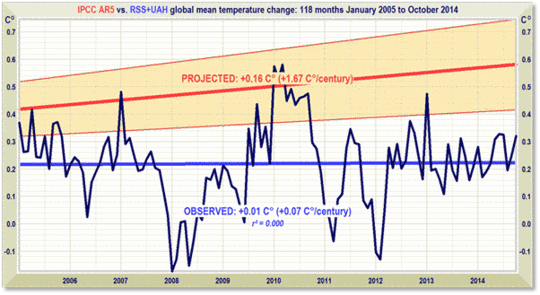

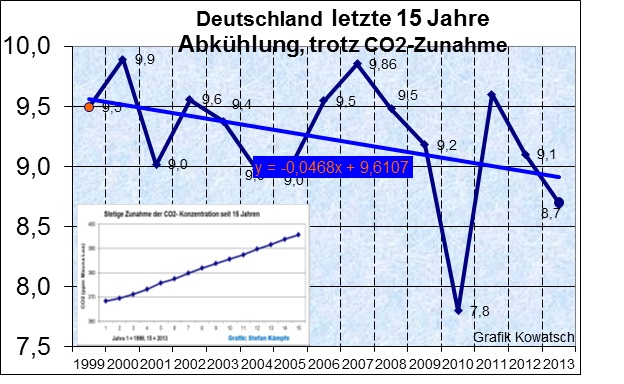

Mehr Kohlendioxid gleich mehr Erwärmung. Mit dieser einfachen Formel hatte die Klimalüge sich weltweit durchgesetzt. Nach Versuchsbeweisen oder technischen Anwendungen einer CO2-Erwärmung fragte niemand mehr. Was nicht verwundert, den kein Ingenieur der Welt wird sich der Lächerlichkeit preisgeben und eine technische Anwendung des vermeintlichen, nicht existierenden, physikalischen Effekts, dem Treibhauseffekt vorzulegen. Da es weder das eine (technische Anwendung), noch das andere (Versuchsbeweis) gibt. Doch ab der Jahrtausendwende ging das Klima seinen eigenen Weg. Weltweit bereits ab 1998 und deutschlandweit ab 2000 fielen die Temperaturen wieder. Obwohl die seriöse Klimawissenschaft längst auf diesen Tatbestand in immer neuen Veröffentlichungen hinweist, wird er von den deutschen Medien einfach totgeschwiegen. Was ebenfalls nicht verwundern kann, hat doch journalistische Arbeit in unserem Land wenig mit investigativem Journalismus, dafür umso mehr mit Sensationsjournalismus zu tun. Spielt doch der letztere Geld in die Taschen der Verleger und Journalisten. Abgesehen davon, dass zum Verständnis des Klimawandels, physikalische Kenntnisse notwendig sind, die vielerorts in den Medien nicht vorhanden sind. Erschwerend kommt beim deutsch geprägten Linksjournalismus hinzu, dass Realität der ideologischen Brille weicht. Lediglich der MDR Wetterexperte, Thomas Globig, darf ab und zu eine Statistik der fallenden Temperaturen seit 2000 zeigen.

Die Temperaturtendenz ist fallend, obwohl die Kohlendioxidkonzentration in der Atmosphäre zunimmt. Hat etwa CO2 seit der Jahrtausendwende kühlende Wirkung?

Abb.6: Die Medien führen die Bevölkerung seit 15 Jahren gezielt in die Irre, etliche Redakteure behaupten, dass besonders in den letzten Jahren die Erwärmung sich verstärkt fortgesetzt hätte und alles sei noch viel schlimmer, als man zur Jahrtausendwende prophezeit hätte.

Die seriösen und unabhängigen Klimawissenschaftler warten nicht mit Katastrophenmeldungen auf, sondern, sie wollen diese Temperaturverläufe, die in der Grafik 5 und Grafik 6 dargestellt sind, mit wissenschaftlichen Methoden erklären. z.B. hier: Temperaturen seit 1980, einzelne Stationen, drei Teile

http://www.eike-klima-energie.eu/news-cache/erst-zum-gipfel-dann-wieder-talwaerts-die-temperaturentwicklung-in-deutschland-seit-1980-und-deren-wesentliche-ursachen-teil-1/

http://www.eike-klima-energie.eu/news-cache/erst-zum-gipfel-dann-wieder-talwaerts-die-temperaturentwicklung-in-deutschland-seit-1980-und-deren-wesentliche-ursachen/

http://www.eike-klima-energie.eu/news-cache/erst-zum-gipfel-dann-talwaerts-die-temperaturentwicklung-in-deutschland-seit-1980-und-deren-wesentliche-ursachen/

Teil 2: „Die wahren Ursachen der Temperaturänderungen in Deutschland und, das lebensnotwendige CO2- harmlos und nützlich“ in Kürze

Josef Kowatsch, Hüttlingen

Stefan Kämpfe, Weimar

Teil 2 finden Sie hier

Eine Anmerkung des EIKE-Pressesprechers

Als Pressesprecher ist es meine Aufgabe, in wissenschaftlichen Fragen die in der EIKE Präambel niedergelegten und vom EIKE-Fachbeirat vertretenen Positionen zu schildern und zu vertreten. In diesem Sinne weist der ansonsten vieles Richtige enthaltende Aufsatz der Autoren Kowatsch, Kämpfe und Leistenschneider (Leistenschneider hat seine Autorenschaft inzwischen entfernt) Defizite auf, die bei etwas sorgfältigerem Literaturstudium hätten leicht vermieden werden können. Sie betreffen die Schilderung bzw. Diskussion des sog. Treibhauseffekts (besser Atmosphäreneffekt), der im Aufsatz keine mir als wissenschaftlich bekannte Position wiedergibt und daher zu revidieren bzw. besser ganz wegzulassen ist. Als Arbeitsgrundlage, die diskutiert (und falls die Autoren dazu in der Lage sind, fachlich wiederlegt) werden kann, empfehle ich den Beitrag von Pierrehumbert, der als pdf beiliegt. Nebenbei: die Empfehlung dieses Aufsatzes bedeutet nicht, dass ich ihm voll zustimme. So stellt beispielsweise der dort beschriebene Wasserdampf-Feedback eine theoretische Fiktion dar, die durch Messungen nicht belegt ist. Er soll nur zeigen, auf welchem Niveau eine TE-Diskussion sinnvoll sein könnte. Wenn eine niveaugerechte Diskussion nicht möglich ist, sollten Aussagen zu komplexen physikalischen Details, die auf Grund unzureichender fachlicher Kenntnis nur fehlerhaft sein können, besser vermieden werden. Der Grundtenor des Aufsatzes wäre ohnehin der gleiche geblieben.

Fest steht, dass es bis heute keine begutachtete Veröffentlichung gibt, die auf der Basis von Messungen einen anthropogenen Beitrag auf Klimaänderungen zu belegen vermag. Somit erübrigen sich alle Spekulationen über theoretische physikalische Details der Wirkung des anthropogenen CO2. Eine Klimawirkung des menschgemachten CO2 ist aus dem natürlichen Temperaturrauschen bis heute definitiv nicht herauszuhören. Auf detaillierteres einzugehen erfordert tiefe physikalische Spezialkenntnisse, die zu Publikationen in begutachteten Fachjournalen befähigen. Daher sollte ein näheres Eingehen von Laien auf solche Details in allgemeinverständlichen Aufsätzen unterbleiben.

Nochmals: meine Kritik betrifft nicht den Grundtenor des Aufsatzes, dem ich m.E. zustimme.

Prof. Dr. Horst-Joachim Lüdecke

Related Files