Selten werden Modelle und Vergleiche zwischen Modellen und Daten in absoluten Termen gezeigt. Dies wird mit diesem Beitrag nachgeholt, und zwar nach einer Diskussion der absoluten mittleren Oberflächen-Temperatur der Erde von den Datensammlern: GISS, NCDC und BEST. Danach wenden wir uns wieder den Anomalien zu.

Die folgenden Abbildungen und der größte Teil des Textes wurden für mein demnächst erscheinendes Buch aufbereitet. Ich habe die Nummerierung der Abbildungen für diesen Beitrag geändert und die Einführung umformuliert. Diese Präsentation zeigt eine total andere Perspektive bzgl. der Differenzen zwischen modellierten und gemessenen Werten der globalen mittleren Temperatur. Ich glaube, dass es Ihnen gefallen wird… anderen aber vielleicht nicht.

Vorab aus meinem demnächst erscheinenden Buch:

Die schwer fassbare absolute globale mittlere Temperatur und die Diskussion darüber beim GISS

Einige werden bereits den Ursprung dieser Kapitelüberschrift kennen. Sie stammt von der Surface Temperature Analysis Q&A-Website The Elusive Absolute Surface Air Temperature (SAT). Der einführende Text zu dieser Website lautet:

Die GISTEMP-Analyse betrifft ausschließlich Temperaturanomalien, nicht die absolute Temperatur. Temperaturanomalien sind berechnet relativ zur Referenzperiode 1951 bis 1980. Der Grund, eher Anomalien denn die absolute Temperatur zu betrachten ist, dass sich die absolute Temperatur auf kurze Distanzen markant ändert, während monatliche oder jährliche Temperaturanomalien repräsentativ für ein viel größeres Gebiet sind. Tatsächlich haben wir gezeigt (Hansen und Lebedeff 1987), dass Temperaturanomalien bis zu räumlichen Distanzen von 1000 km stark korrelieren.

Auf der Grundlage der Ergebnisse von Hansen und Lebedeff (1987) in der Studie Global trends of measured surface air temperature hat GISS einen Datensatz erzeugt, der Temperaturanomalien auf dem Festland an Stelle der Wassertemperatur setzte. Das heißt, GISS hat einfach die Festlands-Temperaturdaten auf die Ozeane ausgedehnt. Dann hat GISS jenen älteren Temperatur-Datensatz mit dem Land-Ozean-Temperaturindex ausgetauscht, welcher die Wassertemperatur für die meisten Ozeangebiete nutzt und als ihr primäres Produkt dient. Sie benutzen immer noch die 1200 km-Extrapolation, um Landgebiete und mit Meereis bedeckte Ozeangebiete, von wo keine Messdaten vorliegen, mit Daten zu füllen.

Aber zurück zur GISS Q&A-Website: Nach Beantwortung einiger Zwischenfragen schließt GISS mit (Fettdruck von mir):

Frage: Was mache ich, wenn ich absolute Temperaturwerte brauche und nicht Anomalien?

Antwort: In 99,9% aller Fälle wird man sehen, dass Anomalien genau das sind, was man braucht, nicht absolute Temperaturwerte. In den übrigen Fällen muss man sich eine der verfügbaren Klimatologien heraussuchen und die Anomalien hinzufügen (mit Rücksicht auf die geeignete Referenzperiode). Für das globale Mittel erzeugen die vertrauenswürdigsten Modelle einen Wert von etwa 14°C, aber er kann leicht auch zwischen etwa 13°C und 15°C liegen. Regional und vor allem lokal ist die Lage sogar noch schlechter.

Mit anderen Worten, GISS stellt sein Verständnis der globalen Temperaturen auf die Grundlage von Klimamodellen, besonders auf die „vertrauenswürdigsten Modelle“. Und sie sagen auf der Grundlage dieser „vertrauenswürdigsten“ Klimamodelle, dass die mittlere globale Temperatur während ihrer Referenzperiode von 1951 bis 1980 (deren Klimatologie) etwa 14°C +/- 0,6°C beträgt.

Der Wert von 14°C auf jener GISS-Website deckt sich mit dem Wert, der unten auf der GISS-Website Land-Surface Air Temperature Anomalies Only (Meteorological Station Data, dTs) gelistet ist. Die Werte dieser Website basieren auf Hansen und Lebedeff 1987. Unten auf der Website schreiben sie:

Die Best Estimate des absoluten globalen Mittels von 1951 bis 1980 beträgt 14,0°C. Man addiere dies also zu der Temperaturänderung, falls man eine absolute Skala benutzen möchte (diese Anmerkung bezieht sich ausschließlich auf globale jährliche Mittelwerte, J-D und D-N!)

Das ist die gleiche Adjustierung der absoluten globalen Temperatur, die GISS für seinen Land-Ozean-Temperaturindex fordert. Siehe hier auf der Website unten.

ANMERKUNG: Mancher könnte es seltsam finden, wenn GISS den gleichen Korrekturfaktor für beide Datensätze verwendet. Einer der GISS-Datensätze erstreckt sich über Lufttemperaturen entlang von Küsten und auf Inseln mit einem Umkreis von 1200 km, während der andere GISS-Datensatz (GISS LOTI) für die meisten globalen Ozeangebiete die Wassertemperatur verwendet. (Bei den LOTI-Daten ersetzt GISS die Daten der Wassertemperatur durch Daten der Temperatur auf dem Festland nur in den polaren Ozeanen, wo jemals Meereis lag). Falls wir annehmen, dass küstennahe Temperaturen und solche auf Inseln ähnlich der Lufttemperatur über marinen Gebieten sind, dann beträgt die Verzerrung höchstens 0,2°C, vielleicht etwas mehr. Die mittlere globale absolute ICOADS-Wassertemperatur der letzten 30 Jahre (1984 bis 2013) beträgt 19,5°C, während die absolute globale mittlere Lufttemperatur über Ozeanen 19,3°C beträgt. Der Grund für „vielleicht etwas mehr“ ist, dass Messungen der Wassertemperatur von Schiffen aus ebenfalls durch den „Wärmeinseleffekt“ beeinflusst sein können, und die ICOADS-Daten sind um diesen Wärmeinseleffekt nicht korrigiert worden. (Ende der Anmerkung).

Die NCDC-Schätzung ist ähnlich, obwohl sie anders hergeleitet worden ist

NCDC bietet ebenfalls eine Schätzung der absoluten globalen mittleren Temperatur. Siehe hier. Dort schreiben sie unter der Überschrift „globale Höhepunkte“ (Fettdruck von mir):

Das Jahr 2013 zieht mit 2003 als dem global wärmsten Jahr gleich seit Beginn von Aufzeichnungen im Jahre 1880. Die jährliche kombinierte Land- und Wassertemperatur lag um 0,62°C über dem Mittel des 20. Jahrhunderts von 13,9°C.

Und nicht rein zufällig stimmen diese 13,9°C von NCDC (aus Daten abgeleitet, wie wir gleich sehen werden) mit dem GISS-Wert von 14,0°C überein. Dies könnte zeigen, dass die „vertrauenswürdigsten Modelle“ nach GISS mit dem datenbasierten Wert getunt worden sind.

Die Quelle jener 13,9°C-Schätzung der globalen Temperatur wird auf den NOAA-Websites zu globalen Temperaturanomalien (hier) identifiziert, besonders unter der Überschrift von globalen langfristigen mittleren Land- und Wassertemperaturen (hier). Sie wurden im Jahre 2000 geschrieben, sind also 14 Jahre alt. Auch kann man auf der Website bemerken, dass die absoluten Temperatur-Mittelwerte für den Zeitraum 1880 bis 2000 gelten und dass NCDC die gleichen 13,9°C als Absolutwert für das 20. Jahrhundert verwendet. Das ist kein Problem, das ist Haarspalterei. Es gibt nur einen Unterschied von 0,03°C in den mittleren Anomalien dieser beiden Zeiträume.

Genau wie GISS beschreibt auch die NOAA Probleme bei der Abschätzung einer absoluten globalen Mitteltemperatur:

Absolute Schätzungen der globalen mittleren Temperatur sind aus einer Reihe von Gründen schwierig zu erstellen. Da es in einigen Gebieten der Welt nur sehr wenige Temperatur-Messstationen gibt (z. B. in der Sahara), muss über riesige, kaum mit Daten besetzte Gebiete interpoliert werden. Im Gebirge stammen die meisten Messungen aus Tälern, wo die Menschen leben, so dass man die Auswirkungen der Höhenlage auf das Mittel der Region berücksichtigen muss ebenso wie andere Faktoren, die die Oberflächen-Temperatur beeinflussen. Die Konsequenz ist, dass die unten stehenden Schätzungen immer noch Approximationen sind, die die inhärenten Hypothesen hinsichtlich Interpolation und Datenverarbeitung enthalten, obwohl sie als die besten derzeit verfügbaren Werte angesehen werden. Zeitreihen monatlicher Temperaturaufzeichnungen werden viel öfter als Abweichungen von einer Referenzperiode ausgedrückt (z. B. 1961 bis 1990, 1880 bis 2000), da diese Aufzeichnungen einfacher interpretiert werden können und man einige Probleme umgeht, die bei der Schätzung der absoluten Temperatur in großen Gebieten auftreten.

Es scheint, dass der NCDC-Wert auf Messdaten beruht, wenngleich es auch alte Daten sind, während der GISS-Wert für einen anderen Zeitraum und basierend auf Klimamodellen ähnlich ist. Das wollen wir jetzt mal in absoluten Zahlen vergleichen.

Vergleich von GISS- und NCDC-Daten in absoluter Form

Die globalen Land- und Wassertemperaturen von NCDC sind verfügbar, indem man auf den Link „Anomalies and Index Data“ klickt, der sich oben auf der NCDC-Website der Global Surface Temperature Anomalies befindet. Und die GISS LOTI-Daten sind hier verfügbar.

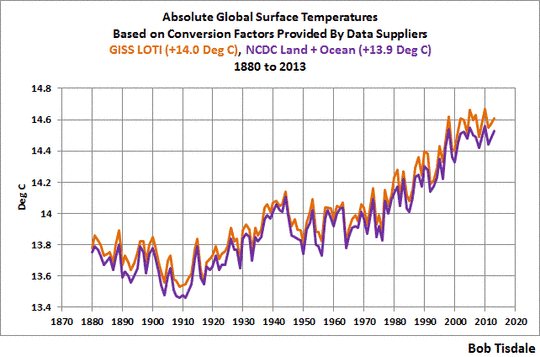

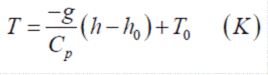

Verwendet man die oben beschriebenen Faktoren, zeigt Abbildung 2 die jährlichen mittleren globalen Temperaturen in absoluter Form von GISS und NCDC seit Beginn im Jahre 1880 bis zum jüngsten vollständigen Jahr 2013. Die GISS-Daten sind ein wenig wärmer als die NCDC-Daten, im Mittel etwa 0,065°C, aber alles in allem passen sie zusammen. Und das sollten sie auch. Sie verwenden den gleichen Wassertemperatur-Datensatz (ERSST.v3b der NOAA), und auch die meisten Daten der Festlandstemperatur sind die gleichen (aus der GHCN-Datenbasis der NOAA). GISS und NCDC füllen einfach Datenlücken unterschiedlich (das gilt vor allem für die Arktis und die Südlichen Ozeane), und GISS verwendet ein paar Datensätze mehr in Gebieten, wo GHCN nur sehr wenige Daten enthält.

Abbildung 2

Hinzu kommt der globale Land- und Wassertemperatur-Datensatz von BEST mit einem unterschiedlichen Faktor

Und das ist der BEST-Datensatz (Berkeley Earth Surface Temperature), also das Produkt von Berkeley Earth. Die ihren Festlands-Temperaturdaten zugrunde liegende Studie stammt von Rhode et al. (2013) mit dem Titel A New Estimate of the Average Earth Surface Land Temperature Spanning 1753 to 2011. Darin findet man, dass man die BEST-Festlandstemperaturen in absoluter Form illustriert hat.

Ihre Klimatologie (Referenztemperaturen für Anomalien) wurde in der Studie von Rhode et al. (2013) Berkeley Earth Temperature Process über Verfahren gezeigt. Sie enthielt auch diesen Anhang. Zum Thema Klimatologie schreiben Rhode et al. in dieser Studie:

Das globale Festlands-Mittel von 1900 bis 2000 beträgt 9,35°C ± 1.45°C, was im Ganzen konsistent ist mit der Schätzung von Peterson von 8,5°C. Diese große Unsicherheit bei der Normalisierung ist in den schattierten Bändern nicht enthalten, die wir in unsere Tavg-Plots gelegt haben, da sie nur die absolute Skala beeinflussen und nicht relative Vergleiche. Außerdem stammt vieles dieser Unsicherheit aus der Existenz von nur drei GHCN-Messpunkten im Inneren der Antarktis. Dies bringt den Algorithmus dazu, die absolute Normalisierung für große Gebiete der Antarktis als erzwungen zu betrachten. Vorangegangene Arbeiten mit vollständigeren Daten aus der Antarktis und von anderswoher zeigen, dass zusätzliche Daten diese Normalisierungs-Unsicherheiten um Größenordnungen reduzieren können, ohne den zugrunde liegenden Algorithmus zu ändern. Der Analyseprozess von Berkeley Average ist irgendwie einmalig dahingehend, dass eine globale Klimatologie und eine Schätzung der globalen mittleren Temperatur als Teil seiner natürlichen Operationen erzeugt wird.

Interessant, dass der Mittelungsprozess der Berkeley-Temperatur sie mit einer Schätzung der globalen mittleren Festlandstemperatur in absoluter Form ausstattet, während es GISS und NCDC schwierig finden, hierzu eine Schätzung zu finden.

Der Bezug auf Peterson in obigem Zitat von Rhode et al. geht zurück auf die Studie Observed Changes in Surface Atmospheric Energy over Land von Peterson et al. (2011). Der Wert von 8,5°C von Peterson et al. als absolute Lufttemperatur auf dem Festland ist der gleiche Wert, der in der Tabelle unter der Überschrift Global Long-term Mean Land and Sea Surface Temperatures auf den Websites von NOAA Global Surface Temperature Anomalies gelistet ist.

Berkeley Earth hat auch Daten veröffentlicht für zwei globale Festlands- + Ozean-Temperaturprodukte. Die Existenz von Meereis ist der Grund für zwei. Lufttemperatur-Produkte für das Festland enthalten keine mit Meereis bedeckten Ozeanflächen, und Wassertemperaturen enthalten keine Lufttemperaturen über polarem Meereis, falls und wo es existiert. Von den 361,9 Millionen km² Gesamtfläche der globalen Ozeane bedeckt polares Meereis im Mittel nur 18,1 Millionen km² jährlich im Zeitraum von 2000 bis 2013. Während polares Meereis nur etwa 5% der Oberfläche der globalen Ozeane und nur etwa 3,5% der gesamten Erdoberfläche überdeckt, bemüht sich die klimawissenschaftliche Gemeinschaft, dort die Lufttemperatur zu bestimmen. Das gilt vor allem für die Arktis, wo der natürlich auftretende Prozess polarer Verstärkung dafür sorgt, dass die Arktis mit verstärkten Erwärmungsraten aufwartet, wenn sich die Nordhemisphäre erwärmt (und sich entsprechend mit erhöhten Raten abkühlt in Perioden einer nordhemisphärischen Abkühlung).

(Siehe auch die Beiträge Notes On Polar Amplification und Polar Amplification: Observations versus IPCC Climate Models.)

Während ich dies schreibe, ist keine stützende Studie für die BEST Land + Ozean-Temperaturdaten von der Website der Berkeley Earth Papers verfügbar, ebensowenig wie auf ihrer Poster-Website. Es gibt jedoch eine einführende Diskussion auf der BEST-Datensite für ihr kombiniertes Produkt. Die BEST Land- + Ozeandaten sind ihre Lufttemperaturen, die mit einer modifizierten Version der HadSST3-Wassertemperaturen zusammengeführt werden. Eingefügt haben sie das mit einer als Kriging bezeichneten Methode. (Siehe Kriging, geschrieben von Geoff Bohling vom Kansas Geological Survey.)

Die jährlichen Berkeley Land + Ozeantemperatur-Anomalien finden sich hier und ihre monatlichen Daten hier. Die Begründung für die Präsentation der beiden Land + Ozeanprodukte stützt meine Ausführungen oben. Berkeley Earth schreibt:

Zwei Versionen dieses Mittelwertes sind im Umlauf. Sie unterscheiden sich darin, wie sie mit mit Meereis bedeckten Stellen umgehen. In der ersten Version werden Temperaturanomalien bei vorhandenem Meereis extrapoliert aus Lufttemperatur-Anomalien über dem Festland. In der zweiten Version werden Temperaturanomalien bei vorhandenem Meereis extrapoliert aus Anomalien der Wassertemperatur (normalerweise gemessen in Gebieten mit offenem Wasser an der Peripherie des Meereises). Für die meisten Ozeangebiete gilt, dass die Wassertemperaturen ähnlich sind der Lufttemperatur unmittelbar darüber; allerdings können Lufttemperaturen über Meereis substantiell von der Wassertemperatur unter dem Eis abweichen. Die Lufttemperatur-Version dieses Mittelwertes zeigt größere Änderungen in jüngster Zeit, teils weil Änderungen der Wassertemperatur begrenzt sind durch den Gefrierpunkt von Meerwasser. Wir glauben, dass die Verwendung von Lufttemperaturen über Meereis eine natürlichere Beschreibung der Änderungen der Temperatur auf der Erde bietet.

Die Verwendung von Lufttemperaturen über Meereis kann eine realistischere Repräsentation der arktischen Temperaturen im Winter bieten, wenn das Meereis die Landmassen erreicht und wenn diese Landmassen schneebedeckt sind, so dass sie die gleichen Albedo-Werte aufweisen. Während der Sommermonate jedoch kann die Albedo von Meereis verglichen mit den Landmassen unterschiedlich sein (Schneeschmelze legt die Temperatursensoren der Umgebung frei und die Albedo von Landflächen unterscheidet sich von der über Meereis). Offenes Wasser separiert auch das Festland von Meereis an vielen Stellen, was das Problem noch komplizierter macht. Da gibt es keine einfachen Verfahren.

Berkeley Earth listet auch die geschätzten absoluten Lufttemperaturen während der Referenzperiode für beide Produkte:

Geschätzte globale Mittlere Temperatur I von Januar 1951 bis Dezember 1980:

* Unter Verwendung der Lufttemperatur über Meereis: 14,774 +/- 0,046

* Unter Verwendung der Wassertemperatur unter dem Meereis: 15,313 +/- 0,046

Die geschätzte absolute globale mittlere Temperatur unter Verwendung der Lufttemperatur über Meereis liegt um 0,5°C unter den Daten, für die sie die Wassertemperatur unter dem Meereis verwendeten. Die Modelle, die weiter unten in diesem Beitrag gezeigt werden, repräsentieren Lufttemperaturen, und darum werden wir die Berkeley-Daten nutzen, bei denen die Lufttemperatur über dem Meereis eingeht. Dies stimmt auch mit den Verfahren bei den GISS LOTI-Daten überein.

Der Wassertemperatur-Datensatz wird bei Berkeley Earth) HadSST3) nur in Form der Anomalien angeboten. Und ohne eine stützende Studie gibt es keine Dokumentation darüber, wie Berkeley Earth diese Anomaliewerte in absolute Werte konvertiert hat. Die Datenquellen ICOADS sowie die Daten von HadISST und ERSST.v3b werden in absoluter Form gezeigt, so dass einer davon wahrscheinlich als Referenz gedient hat.

Vergleich von BEST, GISS und NCDC-Daten in absoluter Form

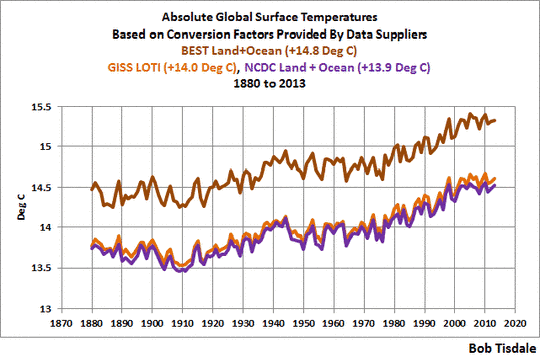

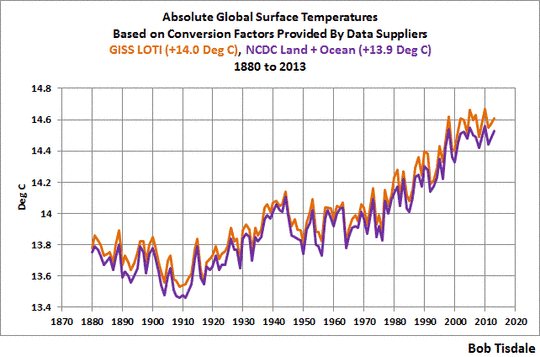

Die Daten der jährlichen mittleren globalen Temperatur in absoluter Form seit dem Startjahr 1880 bis zum letzten vollständigen Jahr 2013 von BEST, GISS und NCDC zeigt Abbildung 3. Die BEST-Daten sind wärmer als die anderen beiden, aber wie zu erwarten war, verlaufen die Kurven ähnlich.

Abbildung 3

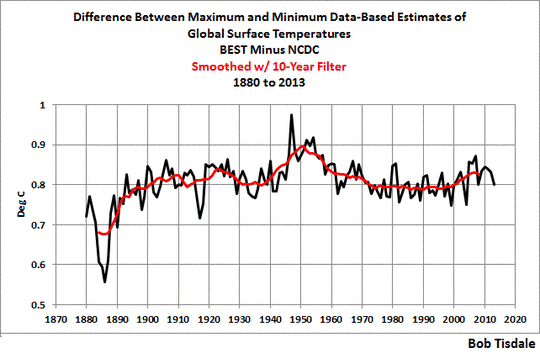

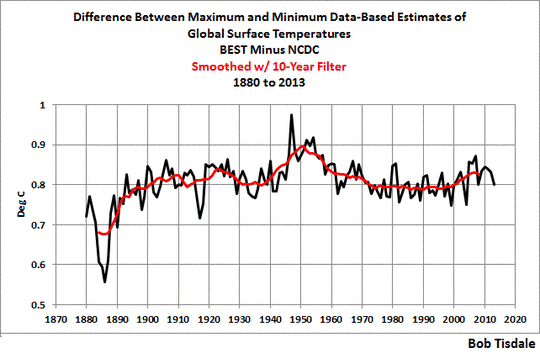

In Abbildung 4 habe ich den kältesten Datensatz (NCDC) vom wärmsten Datensatz (BEST) subtrahiert. Die Differenz wurde außerdem geglättet mit einem gleitenden 10-Jahres-Filter (rote Kurve). Die meiste Zeit liegen die BEST-Daten in absoluter Form um etwa 0,8°C über der NCDC-Schätzung. Die Spitzenabweichung, die etwa 1940 beginnt und um 1950 ihren Höhepunkt erreicht, sollte verursacht sein durch die Adjustierungen, die das UK Met.-Office an den HadSST3-Daten vorgenommen hat, die an die Daten von NOAA ERSST.v3b nicht angebracht worden sind (die sowohl von GISS als auch von NCDC verwendet werden). Über diese Adjustierungen werde ich später etwas schreiben. Ich habe den Verdacht, dass die geringere Differenz zu Beginn der Datenreihe auch damit zusammenhängt, wie die Wassertemperaturdaten behandelt worden sind, aber es gibt keine Möglichkeit, dazu sicher etwas zu sagen, solange man keinen Zugang zu den von BEST modifizierten HadSST3-Daten hat. Der jüngste Anstieg sollte verursacht sein durch die Differenz, wie die beiden Anbieter (BEST und NCDC) mit den Daten des Arktischen Ozeans umgehen. Berkeley Earth weitet die Lufttemperatur-Daten über dem Festland bis über die Ozeane aus, während NCDC Wassertemperaturen im Arktischen Ozean ausklammert, wenn dort Meereis schwimmt, und man dabei nicht landbasierte Daten auf die Gebiete über dem Eis ausweitet.

Abbildung 4

Und nun zu den Modellen.

CMIP5-Modellsimulationen der absoluten Lufttemperatur der Erde, beginnend im Jahre 1880

Wie wir schon oft besprochen haben, werden die Ergebnisse der im 5. IPCC-Zustandsbericht verwendeten Modelle im Climate Model Intercomparison Project Phase 5 archive gespeichert, und jene Ergebnisse sind öffentlich zugänglich und können in leicht handhabbaren Formaten durch den KNMI Climate Explorer heruntergeladen werden. Die Ergebnisse bzgl. der Lufttemperatur im KNMI Climate Explorer können eingesehen werden auf der Website der Monthly CMIP5 scenario runs und werden als „TAS“ bezeichnet.

Die Modellergebnisse beim KNMI Climate Explorer sind verfügbar für die historischen Antriebe mit Übergängen zu den unterschiedlichen zukünftigen RCP-Szenarien (Siehe das Kapitel Emissions-Szenarien). Für dieses Kapitel präsentieren wir das historische und das Worst-Case-Zukunftsszenario RCP8.5. Wir verwenden das Worst-Case-Szenario allein als Referenz dafür, wie hoch die Temperaturen den Modellen zufolge steigen könnten, falls die Treibhausgas-Emissionen so weitergehen wie für dieses Szenario projiziert. Die Verwendung des Worst-Case-Szenarios hat wenig Auswirkung auf die Vergleiche zwischen Modell und Daten von 1880 bis 2013. Man erinnere sich, die Zukunfts-Szenarien beginnen in den meisten Modellen nach 2005, bei anderen noch später, so dass es nur sehr kleine Unterschiede gibt zwischen den Modellergebnissen der verschiedenen Modell-Szenarien während der ersten paar Jahre. Außerdem habe ich für dieses Kapitel die Ergebnisse separat für alle individuellen Modelle und ihre Ensemble-Mitglieder heruntergeladen. Es gibt insgesamt 81 Ensemble-Mitglieder aus 39 Klimamodellen.

Anmerkung: Die Modellergebnisse liegen in absoluter Form in Grad Celsius vor (auch in K), so dass ich sie in keiner Weise adjustiert habe.

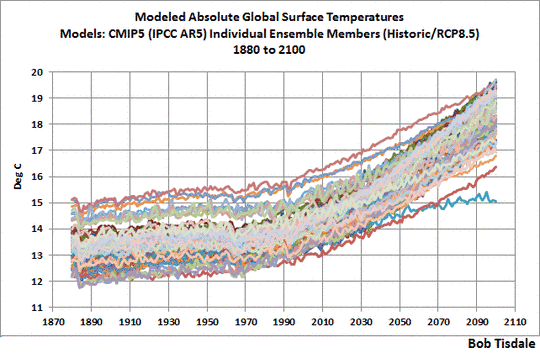

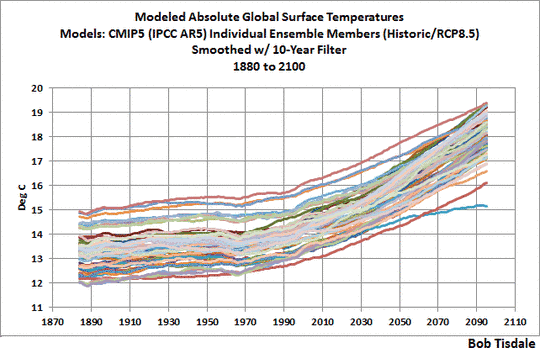

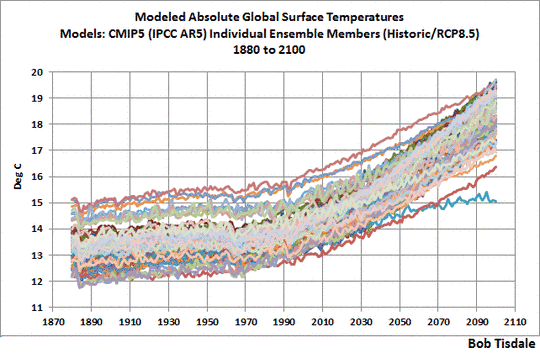

Damit im Hintergrund ist Abbildung 5 eine Spaghetti-Graphik, die die von CMIP5 archivierten Ergebnisse der Klimamodellsimulationen der globalen Lufttemperatur von 1880 bis 2100 zeigen, mit historischen und RCP8.5-Antrieben. Eine größere Version der Graphik mit einer Auflistung aller Ensemble-Mitglieder steht hier.

Abbildung 5

Wie auch immer der Wert der globalen mittleren Temperatur derzeit aussieht oder in Zukunft oder in der Vergangenheit – die im 5. IPCC-Zustandsbericht verwendeten Modelle haben ihn mit Sicherheit überholt.

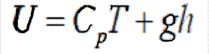

Einige Leute könnten jetzt argumentieren wollen, dass absolute Temperaturwerte unwichtig sind – und dass wir uns wegen der Erwärmungsraten in Vergangenheit und Zukunft Sorgen machen. Wir können diesem Argument auf zwei Wegen begegnen: Erstens haben wir in den Kapiteln CMC-1 und CMC-2 schon gesehen, dass Klimamodelle sich sehr schwer tun mit der Simulation der Temperaturen von 1880 bis 1980 und von 1980 bis heute. Später werde ich die Modellfehler noch sehr viel detaillierter beschreiben. Zweitens, absolute Temperaturen sind aus einem anderen Grund wichtig. Natürliche und verstärkte Treibhauseffekte hängen von der Infrarotstrahlung ab, die von der Erdoberfläche emittiert wird, und die Menge der von unserem Planeten in den Weltraum abgestrahlten Infrarotstrahlung ist eine Funktion der absoluten Temperatur und nicht von Anomalien.

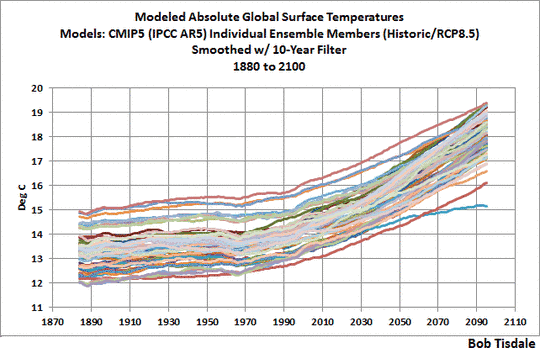

Wie oben in Abbildung 5 gezeigt, starten die Modelle bei einer absoluten globalen mittleren Temperatur, die zwischen fast 12,2°C bis etwa 14,0°C reichen. Aber mit den Ausreißern erweitert sich die Bandbreite auf Werte zwischen 12,0°C und 15,0°C. Die Bandbreite der modellierten absoluten globalen Mitteltemperatur ist einfacher zu erkennen, falls wir die Modellergebnisse mit 10-Jahres-Filtern glätten. Siehe Abbildung 6:

Abbildung 6

Wir könnten die Bandbreite durch die Entfernung der Ausreißer reduzieren, aber ein Problem beim Entfernen der Ausreißer ist, dass die warmen Ausreißer relativ dicht bei der jüngeren (besseren?) Berkeley-Earth-Schätzung der absoluten Temperatur der Erde liegen. Siehe Abbildung 7, in der ich zu den jährlichen, nicht den geglätteten, Ergebnissen zurückkehre.

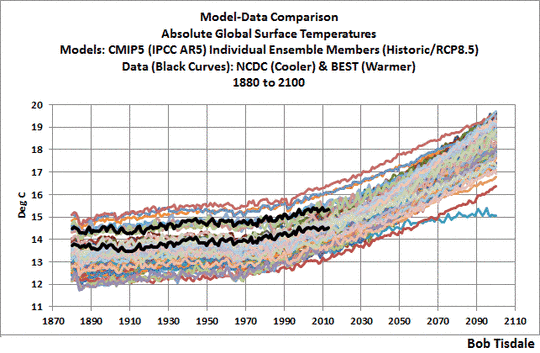

Abbildung 7

Das andere Problem bei der Entfernung der Ausreißer ist, dass das IPCC eine politische Institution ist, nicht eine wissenschaftliche. Als Ergebnis verwendet diese politische Institution auch Modelle von Agenturen rund um den Globus, selbst solche, die noch schlechtere Ergebnisse liefern als die (schlechte Leistung der) anderen, was die Gruppe als Ganzes noch weiter hinabzieht.

Mit Berücksichtigung dieser beiden Dinge werden wir alles von den Modellen in dieser Präsentation beibehalten, selbst die offensichtlichsten Ausreißer.

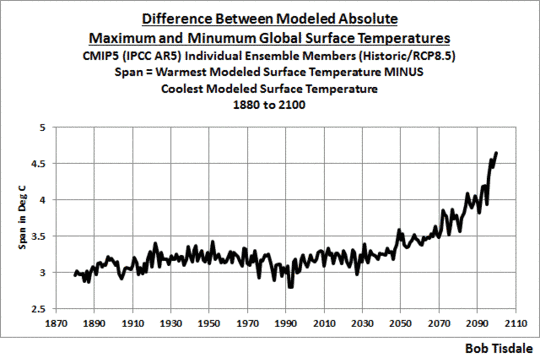

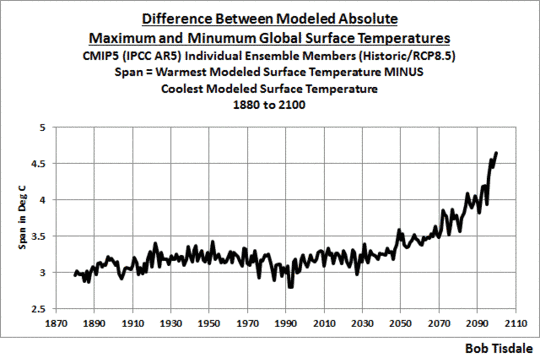

Schaut man noch einmal auf die große Bandbreite der Modellsimulationen der globalen mittleren Temperaturen in Abbildung 5, scheint es eine Spanne von mindestens 3°C zwischen den kältesten und den wärmsten zu geben. Das wollen wir mal festklopfen.

In Abbildung 8 habe ich die kältesten modellierten Temperaturen von den wärmsten modellierten Temperaturen in jedem Jahr subtrahiert, von 1800 bis 2100. Im größten Teil des Zeitraumes zwischen 1880 und 2030 ist die Spanne zwischen den kältesten und den wärmsten modellierten Temperaturen größer als 3°C.

Abbildung 8

Diese Spanne hilft, etwas hervorzuheben, dass wir schon ein paarmal angesprochen haben: Der Gebrauch von Modell-Mittelwerten aus den multimodellierten Ensemble-Mitgliedern, das Mittel aller Läufe aller Klimamodelle. Es gibt nur eine globale mittlere Temperatur, und deren Schätzungen variieren. Es gibt offensichtlich bessere und schlechtere Simulationen davon, wo auch immer der Wert liegt. Gibt uns die Mittelung der Modellergebnisse eine gute Antwort? Nein.

Aber der Mittelwert, das Mittel aller Modelle, gibt uns tatsächlich etwas von Wert. Er zeigt uns den Konsens, das Gruppendenken, hinter den modellierten globalen mittleren Temperaturen und wie diese Temperaturen variieren würden, falls (großes falls) sie auf die Antriebe reagieren würden, die die Klimamodelle treiben. Und wie wir sehen werden, die gemessenen Temperaturen reagieren nicht auf die von den Modellen simulierten Antriebe.

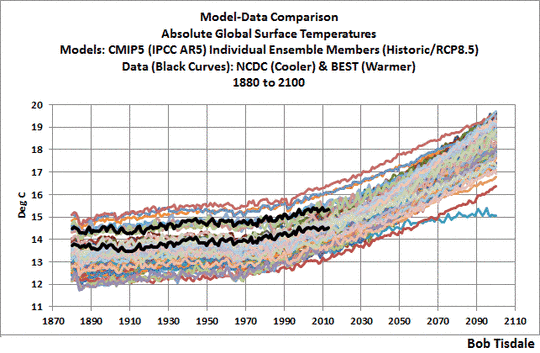

Vergleich Modell mit Daten

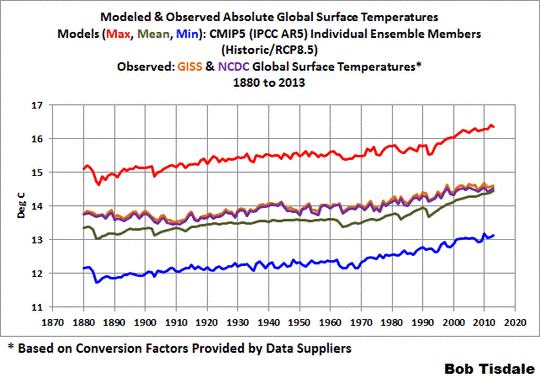

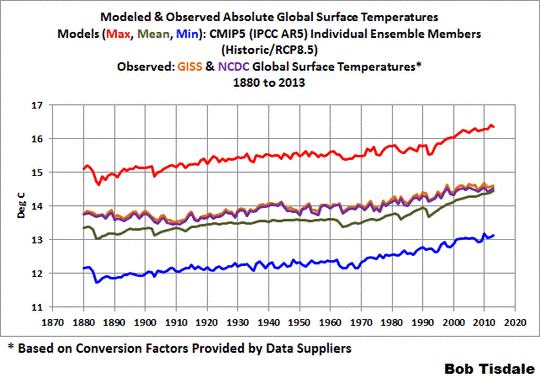

Infolge der Unterschiede zwischen den neueren (BEST) und den älteren (GISS und NCDC) Schätzungen der absoluten globalen Mitteltemperatur, werden sie separat präsentiert. Und weil die GISS- und NCDC-Daten so ähnlich sind, verwenden wir deren Mittelwert. Außerdem werden wir für die Vergleiche nicht alle der Ensemble-Mitglieder als Spaghetti-Graphik präsentieren. Wir zeigen das Maximum, den Mittelwert und das Minimum.

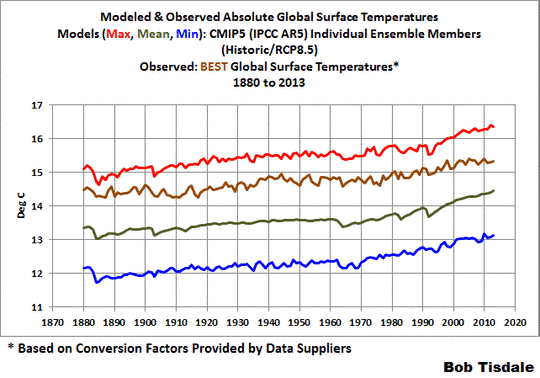

Mit diesen Festlegungen werden in Abbildung 9 das Mittel der Schätzungen der absoluten globalen Mitteltemperatur aus GISS und NCDC mit den Maxima, Minima und Mittelwerten der modellierten Temperaturen verglichen. Der Modellmittelwert liegt ausreichend nahe bei den GISS- und NCDC-Schätzungen der absoluten globalen Mitteltemperaturen, wobei das Modell im Mittel etwa 0,37°C niedriger liegt als die Daten im Zeitraum von 1880 bis 2013.

Abbildung 9

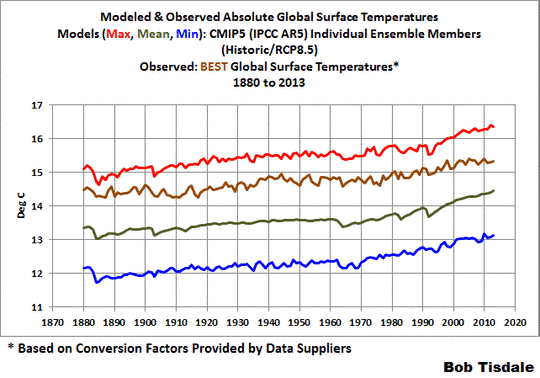

Abbildung 10 zeigt die BEST-Schätzung (neuer = besser?) der absoluten globalen Mitteltemperaturen von 1880 bis 2013 im Vergleich zu Maximum, Minimum und Mittelwert der modellierten Temperaturen. In diesem Falle liegt die BEST-Schätzung näher am Maximum und weiter vom Modellmittel entfernt als bei den Schätzungen von GISS und NCDC. Das Modellmittel liegt etwa 1,14°C niedriger als die BEST-Schätzung für den Zeitraum 1880 bis 2013.

Abbildung10

Differenz zwischen Modell und Daten

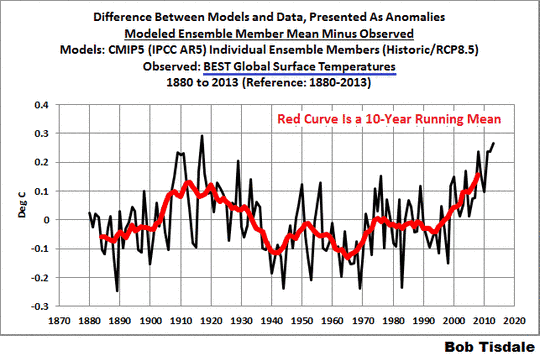

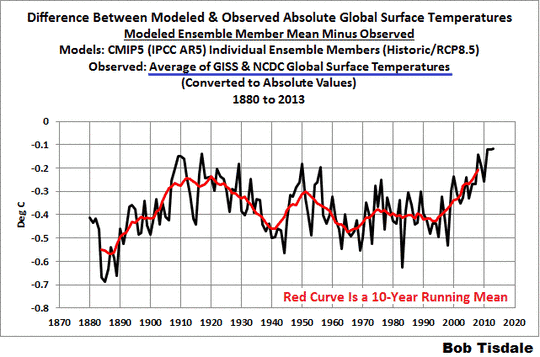

In den nächsten beiden Graphiken werden wir die datenbasierten Schätzungen der absoluten globalen Mitteltemperaturen der Erde vom Mittelwert der CMIP5-Modellsimulationen subtrahieren. Man beachte dies bei der Betrachtung der folgenden beiden Graphiken: Falls das Modellmittel die dekadischen und multidekadischen Variationen der Temperatur auf der Erde angemessen simuliert und einfach nur die Marke des absoluten Wertes verfehlt worden ist, wäre der Unterschied zwischen den Modellen und den Daten eine gerade horizontale Linie, bestimmt durch die Differenz.

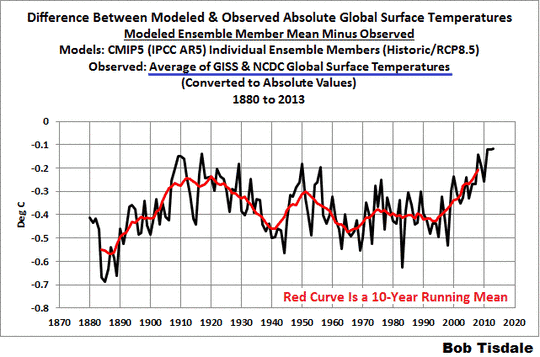

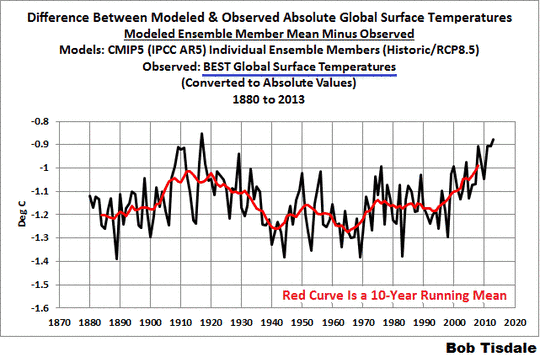

Abbildung 11 zeigt die Differenz zwischen dem Modellmittel der Temperatursimulationen und das Mittel der Schätzungen von GISS und NCDC, wobei die Daten von den Modellwerten subtrahiert worden sind. Bei der folgenden Diskussion dreht es sich um das 10-Jahres-Mittel, das in rot ebenfalls eingezeichnet ist.

Abbildung 11

Der größte Unterschied zwischen Modellen und Daten tritt in den achtziger Jahren des 19. Jahrhunderts auf. Der Unterschied verringert sich drastisch während der folgenden rund 30 Jahre. Grund: Die Modelle simulieren nicht angemessen die zu jener Zeit stattgefunden habende Abkühlung. Die Differenz zwischen Modell und Daten nimmt dann von 1910 bis 1940 wieder zu. Dies zeigt, dass die Modelle nicht nur die Abkühlung zuvor, sondern auch die Erwärmung von 1910 bis 1940 nicht angemessen simulieren konnten. Der Unterschied durchläuft einen Zyklus bis zu den neunziger Jahren, wobei der Unterschied graduell wieder zunimmt. Und von den neunziger Jahren bis heute hat der Unterschied wegen des Stillstands zum geringsten Wert seit 1880 abgenommen.

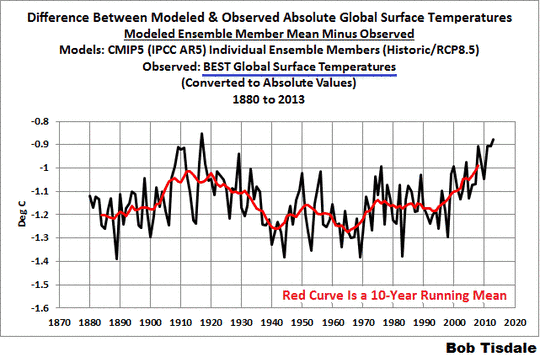

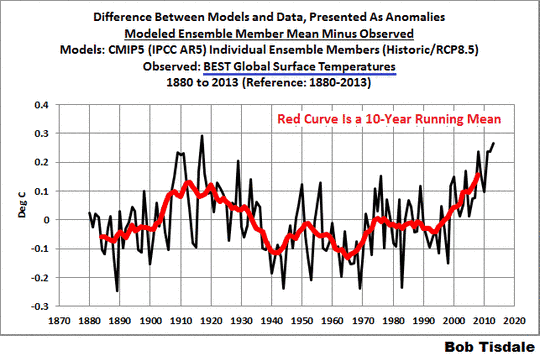

Abbildung 12 zeigt den Unterschied zwischen der BEST-Schätzung der Temperatur und das Modellmittel der Simulationen. Die Kurve verläuft ähnlich der in Abbildung 11 bzgl. der GISS- und NCDC-Daten. Die BEST-Daten der globalen Temperatur zeigen weniger Abkühlung von 1880 bis 1910, und als Folge ist der Unterschied nicht so groß zwischen Modellen und Daten. Aber es gibt immer noch eine starke Zunahme der Differenz von 1910 bis etwa 1940 mit dem Scheitern der Modelle bei der angemessenen Simulation der damals eingetretenen Erwärmung. Und natürlich hat auch hier der jüngste Stillstand zu einer weiteren Abnahme der Temperaturdifferenz geführt.

Abbildung 12

Zusammenfassung dieses Kapitels

Es gibt eine Spanne von etwa 0,8°C bei den Schätzungen der absoluten globalen Mitteltemperatur, wobei die wärmere Schätzung von der neueren Schätzung stammt auf der Grundlage einer aktuelleren Datenbasis der globalen Temperatur. Mit anderen Worten, die BEST-Schätzung scheint wahrscheinlicher zu sein als die GISS- und NCDC-Werte.

Die Klimamodellsimulationen der absoluten globalen Temperaturen zeigen eine viel größere Spanne, die von 1880 bis 2013 im Mittel bei etwa 3,15°C liegt. Um das in die richtige Perspektive zu rücken, haben Politiker vorgeschlagen, dass wir die Erwärmung der globalen Temperatur auf 2,0°C begrenzen. Ein anderer Weg, jene 3,15°C Modellspanne in die richtige Perspektive zu setzen: Man betrachte, dass das IPCC in seinem 4. Zustandsbericht im Grunde behauptet hat, dass die gesamte Erwärmung von 1975 bis 2005 anthropogenen Treibhausgasen geschuldet ist. Diese Behauptung basierte auf Klimamodellen, die die natürliche Variabilität nicht angemessen simulieren können. Also war die Behauptung bedeutungslos. Unabhängig davon, die globalen Temperaturen sind zwischen 1975 und 2005 nur um etwa 0,55°C gestiegen, basierend auf dem Mittel der linearen Trends in den Daten von BEST, GISS und NCDC.

Und der Unterschied zwischen der modellierten und der gemessenen absoluten globalen mittleren Temperatur war nur ein anderer Weg zu zeigen, wie schlecht die globalen Temperaturen von den jüngsten und größten Klimamodellen simuliert werden können, die das IPCC in seinem 5. Zustandsbericht herangezogen hat.

ABER

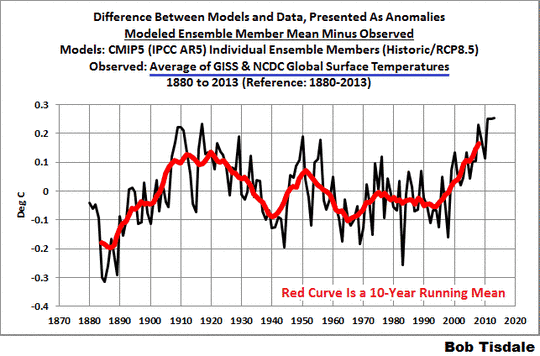

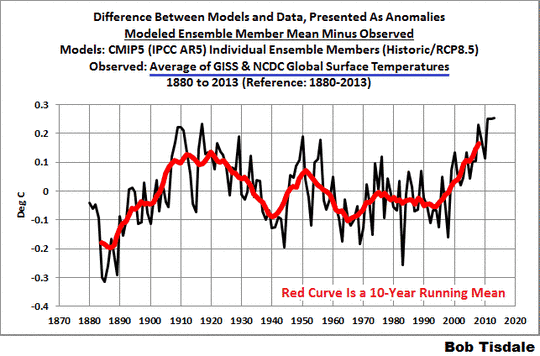

Manchmal können wir etwas anderes erkennen, wenn wir Daten als Anomalien zeigen. In den Abbildungen 13 und 14 habe ich die Differenzen zwischen Modellen und Daten ersetzt durch ihre jeweiligen Mittelwerte von 1880 bis 2013. Das konvertiert die absoluten Differenzen in Anomalien. Wir verwenden die Gesamtmenge der Daten als eine Referenz um sicherzustellen, dass wir die Ergebnisse nicht verzerren durch die Wahl des Zeitraumes. Mit anderen Worten, niemand kann sich darüber beschweren, dass wir hinsichtlich der Referenzjahre Rosinenpickerei betrieben haben. Die Konzentration auf 10-Jahres-Mittel (rote Kurven) hilft, die Auswirkungen des gegenwärtigen Stillstands in die richtige Perspektive zu setzen.

Man behalte im Hinterkopf: Falls die Modelle die dekadischen und multidekadischen Variationen der Temperaturen der Erde angemessen simulieren würden, wäre die Differenz eine flache Linie, und in den folgenden beiden Fällen würde jene flache Linie bei der Null-Anomalie liegen.

Für die Mittelwerte der GISS und NCDC-Daten: Abbildung 13 zeigt, dass die Divergenz zwischen Modellen und Daten heute wegen des derzeitigen Stillstands die größte (und schlimmste) ist seit etwa 1890 ist.

Abbildung 13

Und betrachtet man die Differenz zwischen den Modellsimulationen der globalen mittleren Temperatur und der BEST-Daten, ist das Modellverhalten wegen des Stillstands das schlechteste jemals während der jüngsten 10-Jahres-Periode, seit man globale Temperaturen simuliert, wie Abbildung 14 zeigt.

Abbildung 14

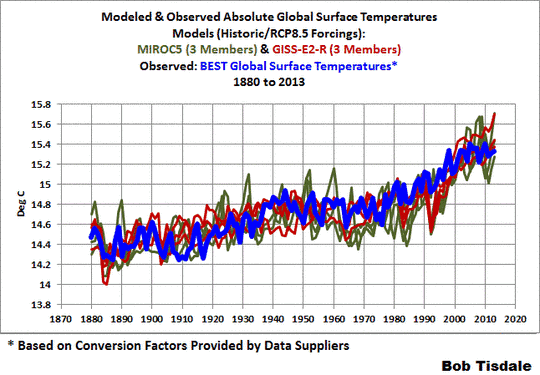

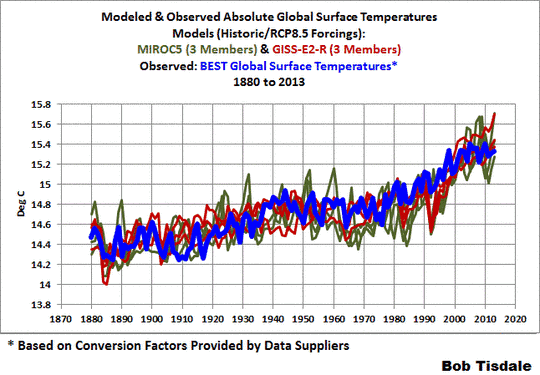

Falls man al zu Abbildung 7 zurückgeht, erkennt man, dass es eine kleine Untermenge von Modellläufen gibt, die der Berkeley Earth-Schätzung der absoluten globalen Mitteltemperatur zugrunde liegt. Sie liegen so dicht beieinander, dass es sehr wahrscheinlich so aussieht, als wären jene Modelle am jene Temperaturen angepasst worden.

Nun dachte ich mir, dass man daran interessiert sein könnte zu wissen, um welche Modelle es sich handelt. Siehe Abbildung 15. Sie sind 3 Ensemble-Mitglieder des MIROC5-Modells von der International Centre for Earth Simulation (ICES Foundation) und die 3 Ensemble-Mitglieder des GISS ModelE2 with Russell Ocean (GISS-E2-R).

Abbildung 15

Das heißt nicht, dass die Modelle MIROC5 und GISS-E2-R besser sind als irgendwelche anderen Modelle. So weit ich weiß, können auch diese Modelle wie alle anderen immer noch nicht die gekoppelten Ozean-Atmosphäre-Prozesse simulieren, die dazu führen können, dass sich die globalen Temperaturen über multidekadische Zeiträume erwärmen oder diese Erwärmung zum Stillstand bringen können wie die AMO und ENSO. Wie oben schon erwähnt, dass sie näher an der aktualisierten Schätzung der absoluten Temperatur der Erde liegen, zeigt einfach, dass jene Modelle dahingehend getunt worden sind. Vielleicht sollte man beim GISS in Betracht ziehen, ihre Schätzung von 14,0°C als absolute globale Temperatur für ihre Basisperiode zu aktualisieren.

Wir haben die vielfältigen Fehlleistungen der Modelle während der letzten Jahre gezeigt. Unter den besprochenen Themen waren:

* Global Precipitation

* Satellite-Era Sea Surface Temperatures

* Global Surface Temperatures (Land+Ocean) Since 1880

* Global Land Precipitation & Global Ocean Precipitation

Alle Beiträge waren auch bei WattsUpWithThat gepostet.

Link: http://wattsupwiththat.com/2014/11/10/on-the-elusive-absolute-global-mean-surface-temperature-a-model-data-comparison/

Übersetzt von Chris Frey EIKE