Dieser Beitrag durch den Begründer von RealClimate Stefan Rahmstorf war eine Erwiderung auf den im Journal Nature veröffentlichten Kommentar „Climate policy: Ditch the 2 °C warming goal“ von Victor und Fennel (2014). Konfrontiert mit den Realitäten einer immer langsameren Zunahme der Temperatur brachten Victor und Fennel eine Anzahl anderer Komplexe ins Spiel einschließlich des ozeanischen Wärmegehaltes.

Ich bin mir nicht sicher, ob Rahmstorf wusste, was er da tat. Sein Beitrag auf RealClimate wird viele Jahre lang enthusiastisch von Skeptikern verwendet werden. Rahmstorfs Beitrag wird immer dann fröhliche Urständ‘ feiern, wenn Alarmisten wie die bei SkepticalScience versuchen, einen fortgesetzten Anstieg des ozeanischen Wärmegehaltes als Grund für die fortgesetzte Divergenz zwischen Klimamodellen und Temperatur anzuführen. Beispiel: Der Beitrag What has global warming done since 1998? bei SkepticalScience kann jetzt getrost verworfen werden.

Weil der Beitrag von Stefan Rahmstorf wichtig ist, habe ich ihn hier archiviert.

1.) Falls man einmal durch die Kommentare bei RealClimate geht, wird man einige wenige von Roger Pielke Jr. finden. Pielke Sr. hat seit Jahren argumentiert, dass der ozeanische Wärmegehalt der ideale Komplex zur Messung der globalen Erwärmung ist. Ich stimme dem zu… der ozeanische Wärmegehalt wäre die auszuwählende Größe, FALLS (großes falls) es die Absicht ist zu quantifizieren, wie viel Wärme tatsächlich in den Ozeanen gespeichert wird und dann diese Beobachtungen zu vergleichen mit der Theorie und den Ergebnissen der Klimamodelle. Aber hier handelt es sich nicht um eine Diskussion über die globale Erwärmung, damit die Wissenschaftler die Fehler in den Klimamodellen dingfest machen können. Hier geht es um eine Diskussion um Größen, die für politische Entscheidungen wertvoll sind und die natürlich die große Hypothese befeuern, die die Politik braucht, um die Erwärmung zu bekämpfen, was Viele in Frage stellen.

Wir leben auf der Oberfläche. Daher ist die Erwärmung der Oberfläche oder das Fehlen derselben die maßgebliche Größe. Lufttemperaturen auf dem Festland imitieren und übertreiben die Temperatur über den Ozeanen, nicht in den Tiefen der Ozeane. Die Verdunstung an der Ozean-Oberfläche ist die große Hauptquelle von Feuchtigkeit in der Atmosphäre, und die Verdunstung findet an der Wasseroberfläche statt und nicht in den Tiefen der Ozeane.

2.) Ja, der Wärmegehalt der Ozeane beeinflusst wirklich die Rate des Meeresspiegel-Anstiegs, aber selbst dieser Einfluss ist minimal. Levitus et al (2012) zufolge beläuft sich der Trend der thermisch bedingten Volumenänderung beim Anstieg des Meeresspiegels auf nur 0,54 mmpro Jahr für die Tiefen zwischen 0 und 2000 Metern im Zeitraum 1955 bis 2010. Und noch einmal, falls der Meeresspiegel auf das Niveau steigen sollte, dass er während der letzten Zwischeneiszeit eingenommen hat, läge der Meeresspiegel heute 6 bis 9 Meter über dem heutigen Niveau. Siehe dazu auch Kopp et al. (2013) Probabilistic assessment of sea level variations during the last interglacial stage, und Dutton & Lambeck (2012) Ice volume and sea level during the last interglacial.

Keine Politik bzgl. Kohlendioxid wird den Landeinwärts-Marsch [inland march, ?] der Ozeane aufhalten.

Eine Erwärmung der Ozeane um 250000000000000000000000 Joule „würde im Wesentlichen Null Einfluss“ auf die Oberfläche haben, auf der wir leben.

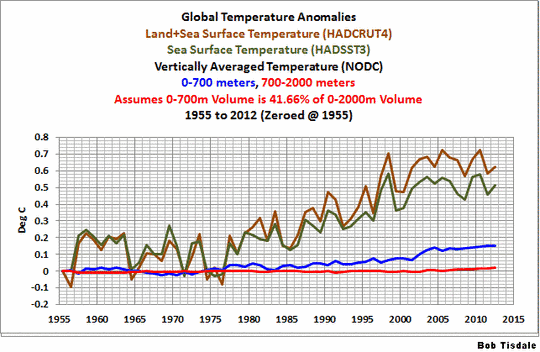

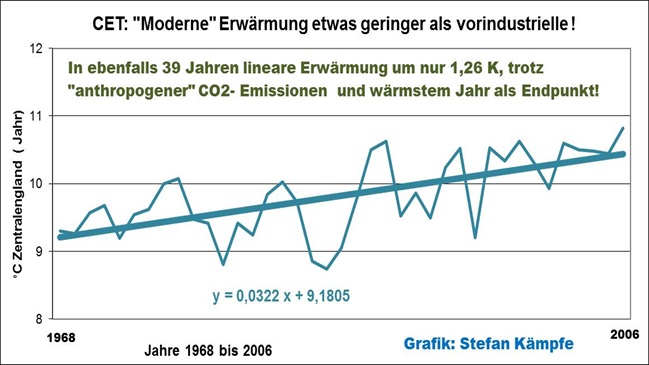

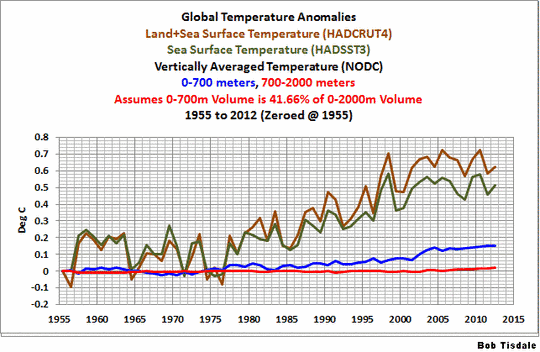

Wir haben in zahlreichen Beiträgen die vertikal zwischen 0 und 2000 m Tiefe gemittelten Temperaturdaten vom NODC präsentiert und diskutiert. Wir haben besprochen, wie die Daten des ozeanischen Wärmegehaltes mit einem sehr ausdrucksvollen Term (10↑22 Joule) beschrieben werden. Aber mit uns vertrauteren Termen zur Beschreibung der Temperatur wird die Erwärmung lediglich in Hundertstel Grad Celsius ausgedrückt. In dem Beitrag Rough Estimate of the Annual Changes in Ocean Temperatures from 700 to 2000 Meters Based on NODC Data haben wir sogar die Erwärmung an der Oberfläche gezeigt bis zu einer Tiefe von 700 Metern, zusammen mit einer groben Schätzung der Verhältnisse in den Tiefen zwischen 700 und 2000 Metern. Siehe Abbildung 1, also der Abbildung 3 aus dem o. g. Beitrag:

Abbildung 1

Unter der Überschrift „2. Der ozeanische Wärmegehalt hat keine direkte Beziehung zu irgendwelchen Auswirkungen“ schreibt Stefan Rahmstorf (Fettdruck von mir, Tisdale):

Der ozeanische Wärmegehalt hat um etwa 2,5 X 10↑23 Joule seit 1970 zugenommen (IPCC AR5). Welche Auswirkungen könnte dies haben? Die Antwort lautet: Das hängt davon ab. Falls diese Wärme völlig gleichmäßig im gesamten Ozean verteilt wäre, wäre die Wassertemperatur um weniger als 0,05°C gestiegen (globale Ozean-Masse 1,4 X 10↑21 kg; Wärmekapazität 4 J/gK). Diese geringe Erwärmung hätte im Wesentlichen Null Auswirkungen.

Das heißt, ist die hypothetische Wärme der vom Menschen verursachten globalen Erwärmung erst einmal von den Ozeanen absorbiert, ist sie für Landbewohner nicht mehr von Belang. Skeptiker sagen dies schon seit Jahren. Die Zufuhr „geringer Erwärmung“ in den Tiefen der Ozeane erzeugt eine geringe Hintergrund-Erwärmung, die im Wesentlichen „Null Auswirkung“ auf dem Festland hat.

Aber die Ozeanoberfläche erwärmt sich mit einer viel höheren Rate

Unter dieser Überschrift schreibt Stefan Rahmstorf (Fettdruck von mir, Tisdale):

Der einzige Grund, warum die Wärmeaufnahme der Ozeane einen Einfluss hat, ist die Tatsache, dass sich dies in hohem Maße an der Oberfläche konzentriert, wo die Erwärmung daher sichtbar ist (siehe Abbildung 1). Hinsichtlich Auswirkungen ist also das Problem die Erwärmung der Oberfläche – welche viel besser beschrieben wird durch Messungen der Wassertemperatur an der Oberfläche als mit dem ozeanischen Gesamt-Wärmeinhalt. Die Erwärmung der Oberfläche steht nicht in einfacher Beziehung zur Gesamt-Wärmeaufnahme, weil diese Verbindung durch Meeresströme und Änderungen der Durchmischung gestört wird. (Übrigens, dies gilt auch für den Meeresspiegel-Anstieg infolge thermischer Ausdehnung, weil der Koeffizient der thermischen Ausdehnung bei warmem Oberflächenwasser viele Male größer ist als bei den kalten Tiefenwassern – erneut ist es die Erwärmung an der Oberfläche, die zählt, während uns der ozeanische Gesamt-Wärmeinhalt wenig über die Stärke des Meeresspiegel-Anstiegs sagt).

(Hinweis an Stefan Rahmstorf: In Ihrer Abbildung 1 geht es nicht um die Oberflächen-Erwärmung!)

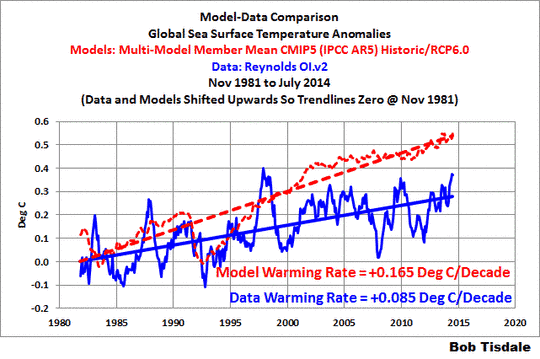

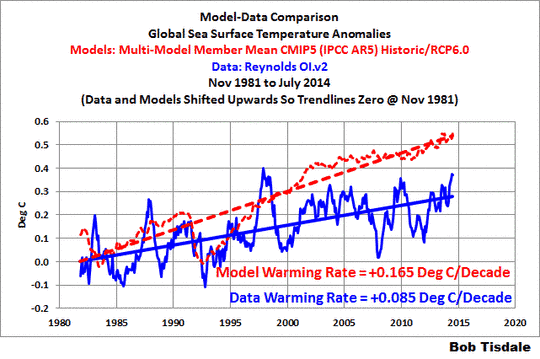

Aber was Stefan Rahmstorf nicht erwähnt, ist die Tatsache, dass die Ozean-Oberflächen nicht kooperieren mit den vom IPCC im 5. Zustandsbericht verwendeten Klimamodellen. Während der letzten über drei Jahrzehnte hat sich die Ozeanoberfläche mit einer Rate erwärmt, die nur etwa halb so groß ist wie die von den Klimamodellen simulierte. Siehe Abbildung 2:

Abbildung 2

Diese Abbildung war als Abbildung 3 enthalten in dem Beitrag On The Recent Record-High Global Sea Surface Temperatures – The Wheres and Whys.

Nicht rein zufällig… die gemessene Ozean-Erwärmung in der Tiefe ist nur etwas halb so groß wie von den Klimamodellen vorhergesagt. Das heißt, es gibt immer noch eine große Menge fehlender hypothetischer Wärme. Vielleicht sind die Rückkopplungen, die die zusätzliche hypothetische Wärme der Ozeane in den Klimamodellen treiben, doch nicht so positiv wie die Klimawissenschaftler glauben. Es wird jedoch noch Jahrzehnte dauern, bis die klimawissenschaftliche Gemeinde diesen Tatbestand einräumen wird.

Probleme bei der Messung des ozeanischen Wärmegehaltes … und die Wassertemperatur der Ozeane unterhalb der Oberfläche

Wir haben die Probleme mit den Daten des ozeanischen Wärmegehaltes und mit den Referenzmessungen der Temperatur unter der Wasseroberfläche in zahlreichen Beiträgen während der letzten Jahre aufgedeckt. Beispielhaft seien hier genannt:

Is Ocean Heat Content Data All It’s Stacked Up to Be?

AMAZING: The IPCC May Have Provided Realistic Presentations of Ocean Heat Content Source Data

Und es gibt zusätzliche Beiträge unter der Kategorie Ocean Heat Content Problems.

Unter der Überschrift „3.) Ozeanischer Wärmegehalt ist schwierig zu messen“ schreibt Stefan Rahmstorf weiter in seinem Beitrag:

Grund hierfür ist, dass man kleine Temperaturänderungen über ein riesiges Volumen messen muss, die viel kleiner sind als Änderungen an der Wasseroberfläche. Schätzungen des ozeanischen Wärmegehaltes haben eine Reihe von Begutachtungen durchlaufen, Instrumenten-Kalibrierungen usw. Falls wir um nur 0,05°C systematisch falsch liegen im gesamten Ozean infolge des Abdriftens von Instrumenten, wäre der Fehler größer als die gesamte Wärmeaufnahme der Ozeane seit 1970. Falls die Oberflächen-Messungen systematisch um 0,05°C abweichen würden, wäre dies eine vernachlässigbare Korrektur im Vergleich zu der seit 1950 beobachteten Erwärmung um 0,7°C.

Danke, Stefan!

Unter dem Strich

Wie wir schon seit Jahren sagen, die Daten des ozeanischen Wärmegehaltes (und die Temperaturmessungen bis in die Tiefe der Ozeane, auf denen sie basieren), sind ein problematischer Datensatz. Selbst während der ARGO-Ära. Siehe den Artikel von Paul Voosen vom Oktober 2011 mit dem Titel Provoked scientists try to explain lag in global warming. Er enthält Zitate von einer Handvoll sehr bekannter Klimawissenschaftler – einschließlich Kevin Trenberth. Voosen sagte zu Trenberths Meinung über ARGO Folgendes:

Trenberth stellt in Frage, ob die ARGO-Messungen ausgereift genug sind, um so deutliche Aussagen machen zu können, wie Hansen es tut. Er hat viele Diskrepanzen gesehen unter den Analysen der Daten, und immer noch gibt es „Probleme hinsichtlich fehlender und falscher Daten und Kalibrierung“, sagte er. Die ARGO-Bojen sind wertvoll, fügte er hinzu, aber „sie sind noch nicht da“.

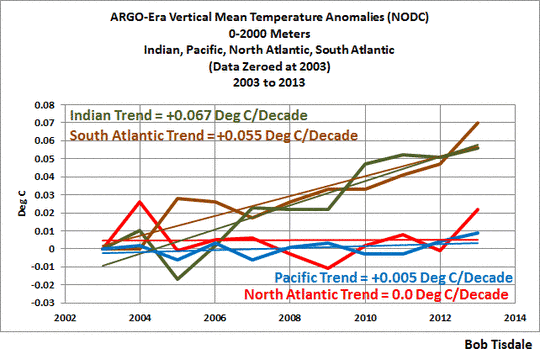

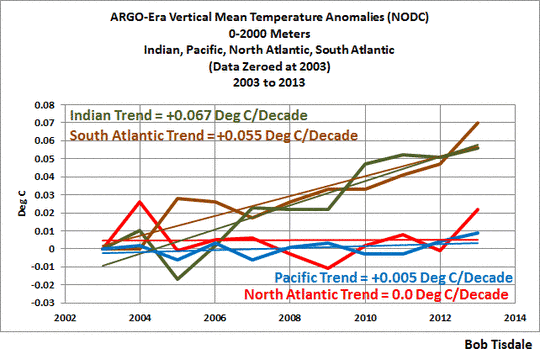

Und sie stützen nach wie vor nicht die hypothetische, vom Menschen verursachte globale Erwärmung. In einem offenen Brief an Kevin Trenberth – NCAR (hier) habe ich eine aktualisierte Graphik der vertikalen mittleren Temperatur-Anomaliedaten von NODC für den Indischen, den Pazifischen, den Nord- und Südatlantischen Ozean präsentiert, und zwar in Tiefen zwischen 0 und 2000 Metern aufgrund der ARGO-Messungen (die 2003 begonnen haben). Siehe Abbildung 3 unten (= Abbildung 5 im verlinkten Beitrag). Der flache Verlauf des Trends im Pazifik zeigt, dass es keinen substantiellen Anstieg der Wassertemperatur unterhalb der Oberfläche des Pazifiks gegeben hat, und zwar bis zu einer Tiefe von 2000 Metern während der letzten 11 Jahre. Im Nordatlantik war es genauso. Anthropogene Treibhausgase können die Erwärmung im Südatlantik und dem Indischen Ozean nicht erklären, wenn sie offensichtlich keinerlei Einfluss auf die Erwärmung des Nordatlantiks und des Pazifiks bis zu 2000 Metern während der letzten 11 Jahre hatten.

Abbildung 3

Sind sie neu bei den Diskussionen zur Erwärmung der Ozeane?

Seit nunmehr fast 6 Jahren habe ich gezeigt, wie die Daten des ozeanischen Wärmegehaltes und die Daten aus der Satelliten-Ära belegen, dass natürlich auftretende gekoppelte Ozean-Atmosphäre-Prozesse verantwortlich waren für deren Erwärmung. Siehe den illustrierten Essay The Manmade Global Warming Challenge (42mb). Er ist gratis. Und lassen Sie sich nicht von den „ natürlich auftretenden gekoppelten Ozean-Atmosphäre-Prozessen“ ängstigen. Sie sind nicht schwer zu verstehen.

Link: http://wattsupwiththat.com/2014/10/23/finally-some-reality-from-realclimate-but-unfortunately-they-remained-unreal-about-some-things/

Übersetzt von Chris Frey EIKE