Fukushima — ein Zwischenbericht

…da warn´s nur noch drei

Anfang August ging die Meldung um die Welt, daß über 90% der Brennelemente (1166 von 1331 abgebrannten Brennelementen) aus dem Lagerbecken des Blocks 4 geborgen und abtransportiert sind. Man erwartet bis Ende des Jahres die vollständige Räumung. Wir erinnern uns: Zum Zeitpunkt der Naturkatastrophe war der Block 4 für einen planmäßigen Brennelementewechsel außer Betrieb. All seine Brennelemente waren nicht mehr im Reaktordruckgefäß, sondern bereits im zugehörigen Lagerbecken. Dieses Lagerbecken wurde infolge der Wasserstoffexplosion mit Trümmern der "Reaktorhalle" zugeschüttet. Kein schöner Anblick und überdies vermeidbar, wenn man eine übliche "Betonhülle" um das Kernkraftwerk gebaut hätte. Um es auch unserer — von der japanischen Industriegesellschaft so enttäuschten — Kanzlerin und ihren Jüngern aus CD(S)U und FDP noch einmal klar und deutlich zu sagen: Ein solcher Schadensverlauf ist in einem Kernkraftwerk in Deutschland technisch ausgeschlossen. Jedes Kernkraftwerk in Deutschland (und fast alle auf der Welt) haben eine Stahlbetonhülle, die einer solch kleinen Explosion locker stand hält. Kein Reaktor in Deutschland ist mit einem anderen Block über eine gemeinsame Lüftungsanlage verbunden. Insofern hätte es in einem deutschen Kernkraftwerk (und in fast allen auf der Welt) gar kein explosives Gas geben können. Selten kann ein Ingenieur eine so eindeutige Aussage treffen.

An diesem Unfall sieht man, welch robuste Konstruktion ein Siedewasserreaktor an sich ist. Selbst eine schwere Explosion mit Einsturz der Reaktorhalle führt zu praktisch keiner Freisetzung von Radioaktivität in die Umwelt. Jeder moderne Reaktor hat darüber hinaus noch beträchtliche weitere Sicherheitsreserven. Dies ist auch der Grund, warum nur diese Reaktoren in Fukushima bei dem Tsunami und dem vorausgehenden Erdbeben kaputt gegangen sind. Es war nicht ohne Grund geplant, sie einige Monate später still zu legen. Eine bittere Lektion, die Japan aber angenommen hat: Alle Reaktoren befinden sich immer noch in einer umfangreichen Überprüfung. Es ist absehbar, daß einige nie mehr wieder in Betrieb gehen werden.

Wenn alle Brennelemente aus dem Block 4 ausgeräumt sind, ist das Kapitel faktisch abgeschlossen: Es verbleibt eine technische Ruine, die man auch als Denkmal stehen lassen könnte. So lange man sie nicht betritt, ist sie genauso ungefährlich, wie ein "Bankpalast" aus Granit. Der japanischen Gemütslage entsprechend, wird man aber eher nicht innehalten, sondern nicht eher ruhen, bis man das Grundstück in eine Rasenfläche verwandelt hat.

Die Problemruinen

Weiterhin problematisch sind die ersten drei Reaktoren des Kraftwerks. Sie waren zum Zeitpunkt des Erdbebens in Betrieb und sind durch den Ausfall der erforderlichen Nachkühlung zerstört worden. Bisher ergibt sich immer noch kein eindeutiges Bild: Die Strahlung in unmittelbarer Nähe der Reaktoren ist noch so stark, daß man keine Menschen zur Untersuchung einsetzen kann und will. Japan ist nicht Russland. Bisher hat man sich nur mit Robotern versucht zu nähern. Dies ist aber schwieriger, als es den Anschein hat. Man hat ein extrem schwieriges Einsatzgebiet, das überdies noch durch Trümmer versperrt ist. Zum großen Teil steht es auch noch unter Wasser. Solange man aber keinen genauen Überblick hat, kann man auch keinen Bergungsplan ausarbeiten. Hier ist noch von jahrelanger Arbeit auszugehen. Sie vollzieht sich auf mehreren parallelen und sich ergänzenden Ebenen.

Jedes mal, wenn man an ein unüberwindlich scheinendes Hindernis gelangt, muß man sich erst neue Spezialvorrichtungen und modifizierte Roboter entwickeln, bauen und testen. Inzwischen arbeitet man weltweit (insbesondere mit den USA und Großbritannien) zusammen, die bereits über umfangreiche Erfahrungen aus dem Abbruch ihrer militärischen Anlagen verfügen. Hier wird eine beträchtliches technisches Wissen entwickelt, das weit über das Niveau von "Windmühlen" und "Sonnenkollektoren" hinausgeht. Die deutsche Industrie wird das dank ihrer Verweigerungshaltung in einigen Jahren noch auf ganz anderen Gebieten bitter zu spüren bekommen.

Zur Zeit scheut Japan jedenfalls keine Kosten und Mühen. Als ein Beispiel mag die Myonen-Analyse dienen. Myonen sind Elementarteilchen, die z. B. in großen Mengen durch die kosmische Strahlung in der oberen Erdatmosphäre gebildet werden. Diese Myonen treffen zu Tausenden, jede Minute auf jeden Quadratmeter unserer Erdoberfläche (Anmerkung: Wann demonstriert Greenpeace endlich gegen diese unverantwortliche Strahlenbelastung? Vorschlag: Gottesstrahlen in Köln hunderte male stärker, als die Strahlenbelastung aus Fukushima). Ein großer Teil dieser Strahlung durchdringt auch massive Bauwerke. Allerdings werden die Teilchen abhängig von der lokalen Dichte gestreut. Mißt man nun die "Flugbahnen" der Myonen vor dem zu untersuchenden Objekt und nach der Durchdringung, so erhält man ein sehr genaues Bild der Zusammensetzung. Ganz ähnlich einer Röntgenaufnahme: Die dichteren Knochen zeichnen sich deutlich von sonstigem Gewebe ab. Da nun Uran und Plutonium eine — auch gegenüber allen Baustoffen, wie Stahl, Beton usw. — außergewöhnlich hohe Dichte besitzen, erwartet man ein ziemlich genaues Bild der Uranverteilung in den Unglücksreaktoren. Erst dann kann man sinnvoll und risikolos Löcher für Kameras etc. bohren, um sich ein abschließendes Bild zu machen.

Ein weiterer Weg ist die Analyse durch "nachrechnen" des Unfallablaufes. Solche Rechnungen sind allerdings mit erheblichen Unsicherheiten versehen, da man nicht über ausreichende Messwerte über die tatsächlichen Zustände während des Unglücks verfügt. Sie sind solange nur als grobe Abschätzungen zu werten, solange man keine "Aufnahmen" der tatsächlichen Brennelement-Reste vorliegen hat. Allerdings läßt sich die Aussagefähigkeit der Berechnungen Schritt für Schritt mit jeder neu gewonnenen Messung verbessern. Es verwundert daher nicht, daß die Ergebnisse verschiedener Institutionen noch recht weit auseinanderliegen: Man glaubt bisher, daß der gesamte Brennstoff des ersten Reaktors (ca. 77 to) damals aufgeschmolzen und weitestgehend aus dem Reaktordruckbehälter ausgelaufen ist und sich unterhalb in der Reaktorkammer gesammelt hat. Bei den Blöcken 2 und 3 gehen die Rechenergebnisse noch weiter auseinander. Hier glaubt man, daß mindestens noch ein Drittel (von je 107 to) sich in den Druckbehältern befindet.

Der Dauerbrenner Abwasser

Seit dem Unglück steht die Belastung des Grundwassers und etwaige Belastungen des Meerwassers im Vordergrund. Das Kraftwerk steht an einer Hanglage. Schon immer sind große Regenwassermengen unterirdisch um das Kraftwerk geflossen. Der Grundwasserspiegel war so hoch, daß alle unterirdischen Kanäle und Keller im Grundwasser stehen. Während des Betriebs hat man durch Entwässerung den Grundwasserspiegel ständig abgesenkt gehalten. Dieses Drainagesystem ist aber durch den Tsunami und das Erdbeben zerstört worden. Folglich stieg der Wasserstand an und die Gebäude schwammen auf und soffen ab. Da die technischen Anlagen ebenfalls undicht wurden, mischte sich das austretende radioaktiv belastete Kühlwasser ständig mit dem Grundwasser im Kellerbereich. Die bekannten Probleme entstanden. Inzwischen hat man oberhalb des Kraftwerks eine Speerwand errichtet um den Grundwasserstrom einzudämmen. Vor dieser Sperrzone wird durch Brunnen das Grundwasser entzogen. Dies ist eine Technik, wie man sie bei vielen Baustellen weltweit anwendet. Das abgepumpte Wasser wird um das Kraftwerk herum geleitet. Am 2. Mai wurden zum ersten mal 561 m^3 Wasser in Anwesenheit von Journalisten und Fischern ins Meer geleitet. Voller Stolz verkündete man, daß die Grenzwerte für die Einleitung ins Meer auf 1/10 (tatsächlich gemessene Werte weniger als 1/100) der Grenzwerte für Trinkwasser festgesetzt wurden. An der gesamten Uferlänge vor dem Kraftwerk hat man eine Sperrmauer errichtet, die 30 m tief unter den Meeresboden bis in eine wasserundurchlässige Bodenschicht reicht. Vor dieser Sperrmauer wird das angeströmte Grundwasser ständig abgepumpt. Durch diese Maßnahmen kann praktisch kein radioaktives Wasser mehr in das Meer gelangen. Durch die Sanierung des zerstörten Abwassersystems auf dem Gelände, ist es gelungen den Grundwasserspiegel wieder auf das alte Niveau abzusenken. Damit kann nicht mehr so viel Grundwasser in die unterirdischen Kellerräume eindringen und sich dort mit einem Teil des Kühlwassers vermischen. Dies hat zu einer Verringerung der zu lagernden radioaktiven Wässer um etwa die Hälfte geführt. Um längerfristig praktisch den gesamten Zustrom zu stoppen, hat man seit Juni begonnen das Kraftwerk unterirdisch komplett einzufrieren. Diese Arbeiten werden sich noch bis weit ins nächste Jahr hinziehen. Sind die "Eiswände" fertig, kann das Grundwasser unkontaminiert um die Ruine herum fließen. Bis März sollen über 1550 Bohrungen 30 bis 35 m tief abgesenkt, und mit Kühlflüssigkeit gefüllten Rohrleitungen ausgestattet werden. Diese werden dann mit Kühlflüssigkeit von -30°C ständig durchströmt. Geplante Kosten: Mehr als 300 Millionen US-Dollar.

Die Roboter

Block 2 war nicht von der Wasserstoffexplosion zerstört und wäre somit zugänglich. Gerade weil er aber immer noch "gut verschlossen" ist, ist er innerlich stark kontaminiert. Japanische Arbeitsschutzvorschriften sind streng, weshalb vor einem Betreten durch Menschen nur Roboter zum Einsatz kommen. Es sind mehrere Modelle aus aller Welt im Einsatz, die für die Reinigungsarbeiten in Japan modifiziert und umgebaut wurden. Die Roboter sind nicht nur mit "Wischern" und "Staubsaugern" ausgerüstet, sondern auch mit Dutzenden Kameras und Messinstrumenten. Sie werden von einer neu errichteten Zentrale aus ferngesteuert. Vordringliche Aufgabe ist die Reinigung der Anlage bis zur Schleuse des Containment. Es wird noch einige Wochen dauern, bis Arbeiter gefahrlos zu der Schleusentür vordringen können. Nächster Schritt wird dann sein, die Schleuse zu öffnen und (ebenfalls mit Robotern) bis zum Reaktordruckgefäß vorzudringen.

Bei allen Abbrucharbeiten in USA, UK und Japan nimmt der Robotereinsatz in letzter Zeit rapide zu. Dies liegt nicht nur an den Entwicklungsfortschritten auf diesem Gebiet, sondern vor allem auch an dem Preisverfall. Arbeiten, die noch vor zehn Jahren utopisch anmuteten, sind heute Routine geworden. Man "taucht" heute genauso selbstverständlich in Kernreaktoren, wie in Ölförderanlagen tausende Meter tief im Meer. Die Energietechnik — nicht zu verwechseln mit Windmühlen, Biogasanlagen und Sonnenkollektoren — ist auch weiterhin der Antrieb der Automatisierungs- und Regelungstechnik. Wer sich aus ihr zurückzieht, verschwindet kurz über lang ganz aus dem Kreis der Industrienationen (Morgenthau-Plan 2.0 ?).

Die volkswirtschaftlichen Kosten

Der betriebswirtschaftliche und volkswirtschaftliche Schaden durch das Unglück von Fukushima ist riesig. Für Japan ist es um so bitterer, daß er vollständig vermeidbar gewesen wäre, wenn man auf die Fachleute gehört hätte. Allein zwei Geologen sind unter Protest aus Sicherheitsgremien zurückgetreten, weil sie vor einem möglichen Tsunami in der bekannten Höhe gewarnt hatten. Es scheint ein besonderes Phänomen unserer Zeit — und ganz besonders in Deutschland — zu sein, die Warnungen und Ratschläge von Fachleuten zu ignorieren. Wohlgemerkt Fachleute, die sich durch einschlägige Ausbildung und jahrelange Erfahrung ausweisen. Nicht zu verwechseln mit ernannten "Experten", die meist weder eine Fachausbildung noch praktische Kenntnisse besitzen, diese Defizite aber durch "Festigkeit im Rechten-Glauben" ersetzen. Diese Hohepriester der Ignoranz in Parteien und Betroffenheitsorganisationen sind nicht weniger gefährlich als Voodoo-Priester in Afrika.

Der in Japan entstandene Schaden durch Ignoranz vollzieht sich auf zwei unterschiedlichen Ebenen: Die Kosten für die Aufräumarbeiten und die Entschädigung für die Evakuierten treffen den Betreiber Tepco mit tödlicher Wucht. Die Kosten durch steigende Energiepreise treffen alle Japaner und sind in ihren Auswirkungen noch nicht endgültig absehbar. Japan und Deutschland werden noch für zig Generationen von Wissenschaftlern genug Stoff für die Frage liefern: Wie und warum haben sich zwei Nationen freiwillig und sehenden Auges durch eine falsche Energiepolitik ruiniert?

Die Kosten für die Aufräum- und Dekontaminierungsarbeiten werden inzwischen auf über 100 Milliarden US-Dollar geschätzt. Glücklicherweise gilt hier, daß die Kosten für Tepco die Gehälter für zahlreiche Japaner sind. Allerdings muß die Frage erlaubt sein, ob viele Japaner nicht sinnvolleres zu tun hätten, als Grenzwerte unterhalb der vorhandenen Strahlung anzustreben.

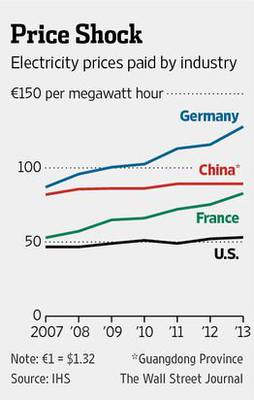

Viel bedenklicher — aber anscheinend nicht so offensichtlich — ist der volkswirtschaftliche Schaden. Die japanischen Energieversorger haben jährliche Mehrkosten von 35 Milliarden US-Dollar durch den Einkauf zusätzlicher fossiler Brennstoffe. Dies ist rausgeschmissenes Geld, da man täglich die abgeschalteten — und längst überprüften und für sicher befundenen — Kernkraftwerke wieder hochfahren könnte. Inzwischen importieren die Stromerzeuger jährlich für 80 Milliarden US-Dollar Kohle und LNG (verflüssigtes Erdgas). Japan ist der größte Importeur für LNG (90 Mio to jährlich) und der zweitgrößte Importeur für Kohle (190 Mio to jährlich, stark steigend) und der drittgrößte Importeur für Öl weltweit (4,7 Millionen barrel pro Tag). Sind die jährlichen Ausgaben hierfür schon imposant (289 Milliarden US-Dollar in 2012), so ist langfristig das Verhältnis zum Bruttosozialprodukt entscheidend: Es ist inzwischen doppelt so hoch wie in China (wobei das Bruttosozialprodukt in China schneller steigt, als der Energieverbrauch) und fast vier mal so hoch, wie in den USA (dort nimmt die Eigenproduktion ständig zu). Eine solche Schere ist für einen Industriestandort langfristig nicht tragbar. Es gibt also keinen anderen Weg, als zurück in die Kernenergie. "Wind und Sonne" sind bei diesen Größenordnungen nichts anderes als Spielerei (in 2012: 92% fossil, 6% Wasserkraft; 2010: 15% Kernenergie).

Strahlenbelastung

Die UNSCEAR (United Nations Scientific Committee on the Effects of Atomic Radiation) ist auch in ihrem neuesten Untersuchungsbericht zu dem Schluß gekommen, daß weder eine erhöhte Rate an Krebserkrankungen noch an Erbschäden in Japan feststellbar ist. Es wird ausdrücklich betont, daß die Strahlenbelastung durch die schnelle und großzügige Evakuierung viel zu gering ist um Folgeschäden auszulösen. Im Mittel sind die Menschen im Raum Fukushima mit 10 mSv über ihr gesamtes Leben zusätzlich belastet, während allein die Hintergrundstrahlung in Japan rund 170 mSv über ein Menschenalter beträgt. Es sind überhaupt nur Schädigungen feststellbar, wenn kurzfristig eine Strahlenbelastung von über 100 mSv vorgelegen hat. Deshalb befinden sich 160 Mitarbeiter in einem Langzeit-Überwachungs-Programm. Bisher konnten auch in dieser Gruppe keine Veränderungen festgestellt werden.

Parallel läuft ein Überwachungsprogramm von 360 000 Kindern auf Veränderungen der Schilddrüse (Anmerkung: Gerade bei Kindern und Jugendlichen kann die Anreicherung von Jod-131 zu Wucherungen in der Schilddrüse führen.) Die dabei festgestellten Fälle, sind eher auf die genaueren Untersuchungsmethoden als durch eine Strahlenbelastung zurückzuführen. Eine Vergleichsgruppe unbelasteter Kinder ist nicht vorhanden. Interessant wird eher die Zahl der "Krebstoten" nach Abschluss dieser Studie sein. Erfahrungsgemäß wird sie geringer als der japanische Durchschnitt werden, da durch die begleitende Überwachung "Krebs" früher erkannt und besser behandelt werden kann.

Ein, zumindest zwiespältiges, Ergebnis brachten die Evakuierungen mit sich: Innerhalb kurzer Zeit wurden 78 000 Menschen aus dem 20km-Radius ausgesiedelt. Weitere Menschen wurden aus dem 20 bis 30 km Radius in Schutzräume untergebracht.

Strahlenphobie tötet

In dem 20km-Radius um das Kraftwerk befanden sich acht Krankenhäuser und 17 Pflegeheime, in denen sich zum Zeitpunkt des Unglücks 1240 Patienten bzw. 940 Pflegefälle befanden.

Unmittelbar nach dem Tsunami wurde eine Evakuierung im 2km-Radius angeordnet. Am nächsten Morgen wurde der Radius auf 10 km ausgeweitet. Am Nachmittag ordnete die Regierung eine Ausweitung auf 20km an. Am Abend des zweiten Tags nach dem Tsunami stellte man fest, daß sich noch 840 Patienten in den Krankenhäusern und Pflegeheimen befanden. Die Regierung ordnete noch am späten Abend eine Notevakuierung an. Am folgenden Morgen begannen völlig panische und chaotische Transporte: Schwerkranke wurden ohne Begleitung durch medizinisches Personal in normale Fahrzeuge verfrachtet. Bettlägerige Patienten wurden teilweise schwer verletzt, weil sie während der Fahrt von den Sitzen rutschten. 27 Patienten mit Nierenversagen und Schlaganfällen wurden auf einen Transport ins 100km entfernte Iwaki verschickt. Zehn verstarben noch auf dem Transport. Insgesamt sollen 50 Patienten während oder kurz nach der Evakuierung verstorben sein. Todesursachen: Unterkühlung, Dehydration und drastische Verschlimmerung der vorhandenen medizinischen Probleme.

Das alles geschah, weil (einige) Menschen völlig absurde Vorstellungen von der Wirkung ionisierender Strahlung haben. Über Jahrzehnte systematisch aufgehetzt von Betroffenheits-Organisationen vom Schlage Greenpeace. Organisationen und Einzelpersonen ("Atomexperte"), die es zu ihrem persönlichen Geschäftsmodell gemacht haben, andere Menschen in Furcht und Schrecken zu versetzen. Wir sind es den Opfern schuldig, diesem Treiben wesentlich entschiedener entgegenzutreten. Das sind nicht die netten-jungen-Leute-die-immer-die-Waale-schützen, sondern straff geführte Unternehmen mit Millionenumsätzen. Aufklärung beginnt immer im persönlichen Umfeld. Jede Spende weniger, bereitet dem Spuk ein baldiges Ende. Wenn sich das Geschäftsmodell "Strahlenangst" erledigt hat, werden sich diese Typen schneller als gedacht lukrativeren Tätigkeiten zuwenden.

Dr. Klaus-Dieter Humpich

Der Beitrag erschien zuerst bei Nukeklaus hier