CO2-Daten mögen ja der IPCC-Hypothese genügen, entsprechen aber nicht der Realität

Man erschaffe die gewünschten Fakten

In einem Kommentar zu dem Beitrag auf WUWT „The Record of recent Man-made CO2 emissions: 1965-2013” hat Pamela Gray die Lage graphisch, aber pointiert zusammengefasst:

Wann endlich werden wir die Mathematik betreiben? Der allein anthropogene Anteil am atmosphärischen CO2, vor allem der Anteil Chinas, hat nicht die erforderliche Fähigkeit, auch nur ein winziges bisschen „Wetter“ auch nur ein wenig zu verändern. Man entferne nur den anthropogenen CO2-Anteil und lasse die vergangenen 30 Jahre bzgl. des Wetters noch einmal Revue passieren. Es wäre zu genau den gleichen Wetterabläufen gekommen. Oder vielleicht wäre es wegen der dem Wetter eigenen Natur noch schlimmer gekommen. Oder vielleicht besser. Jetzt mache man etwas wirklich Lächerliches: man nehme den Anteil Chinas heraus. Ich weiß, dass es in dem Beitrag nicht darum geht, China als den bösen Buben hinzustellen. Aber. Wirklich? Wirklich? All das für etwas, das so klein ist, dass man es gar nicht finden kann? Nicht einmal im Luftballon eines Kindes?

Die einzige Deutung, die mir einfällt ist, dass die Menge die Sinnlosigkeit der Behauptungen illustriert, wie Gray anmerkt, aber das IPCC und die EPA konzentrieren sich auf Trends und Zuordnungen. Es muss einen menschlichen Grund haben und stetig zunehmen, oder, wie sie es bevorzugen – es muss schlimmer werden.

Verengung des Blickwinkels

Es ist erforderlich, die Kritik an den vom IPCC erzeugten CO2-Niveaus während der ganzen letzten Jahre wieder aufzugreifen. Heutzutage ist die Vehemenz persönlicher Attacken eine Maßzahl für das Zutreffen der Kritik, zielen diese doch darauf ab, von Wissenschaft und Beweisen abzulenken.

Seit seiner Gründung konzentrierte sich das IPCC auf die menschliche Produktion von CO2. Es begann mit der Definition von Klimaänderung, die von der UNFCCC vorgegeben worden war und die vom Menschen als die einzige Quelle ausging. Ziel war es, die Hypothese zu belegen, dass der zunehmende atmosphärische CO2-Gehalt zu einer Erwärmung führen würde. Dies erforderte Beweise, dass das Niveau seit der vorindustriellen Zeit zugenommen hat und jedes Jahr weiter zunehmen wird wegen der menschlichen industriellen Aktivität. Wie lange wird es noch dauern, bis sie anfangen, die Rate der CO2-Zunahme zu reduzieren, um den sinkenden Temperaturen Rechnung zu tragen? Ihnen gehen allmählich die Entschuldigungen aus, zuletzt mindestens 30 [auf Deutsch beim EIKE hier], um das fortgesetzte Fehlen einer Temperaturzunahme zu erklären.Inzwischen sind es 17 Jahre und 10 Monate.

Das IPCC stellt die bizarre Behauptung auf, dass bis zum Jahr 1950 der menschliche CO2-Eintrag ein untergeordneter Treiber der globalen Temperatur war. Danach sind über 90% der Temperaturzunahme dem menschlichen CO2 geschuldet.

Das meiste der beobachteten Zunahme der globalen mittleren Temperatur seit Mitte des 20. Jahrhunderts ist sehr wahrscheinlich der beobachteten Zunahme der atmosphärischen Treibhausgas-Konzentrationen geschuldet.

Die Behauptung, dass eine geringfügige CO2-Zunahme aus anthropogenen Quellen, welches natürlicherweise nur 4% aller Treibhausgase ausmacht, der dominante Faktor innerhalb nur weniger Jahre wird, ist unglaublich. Diese Behauptung entstammt Computermodellen. Sie sind der einzige Ort auf der ganzen Welt, wo eine CO2-Zunahme eine Temperaturzunahme verursacht. Sie hängt ab von der menschlichen Produktion und dem zunehmenden atmosphärischen Niveau. Sie nehmen an, dass die Temperatur immer weiter steigt, wie alle drei IPCC-Szenarien implizieren.

Ihre Frustration ist, dass sie zwar die CO2-Daten kontrollieren, aber nachdem die University of Alabama in Huntsville (UAH) mit der Aufzeichnung von globalen Temperaturdaten via Satelliten begonnen hatte, war die Kontrolle der globalen Temperaturdaten beschränkt. Es hat sie allerdings nicht völlig davon abgehalten, wie McIntyre, Watts, Goddard, die New Zealand Climate Science Coalition und viele andere illustriert haben.

Und jetzt sind sie konfrontiert mit einem Problem, das T. H. Huxley aufgeworfen hatte:

Die große Tragödie der Wissenschaft – die Zerschlagung einer wunderbaren Hypothese durch eine hässliche Tatsache.

Dieser Artikel beleuchtet, wie das derzeitige atmosphärische CO2-Niveau bestimmt und kontrolliert wird, um zur Hypothese zu passen. Sie können sich an eine politische Agenda anpassen, aber sie können sich nicht die Agenda der Natur zupass machen.

Eine neue deduktive Methode: Man erschaffe sich Fakten, die zur Theorie passen

Farhad Manjoo fragte in dem Beitrag True Enough: Learning To Live In A Post-fact Society:

Warum hat in jüngster Zeit Gelehrsamkeit die Nachrichten gekapert? Warum scheinen sich Lügen so lange im kulturellen Unterbewusstsein zu halten, selbst nachdem sie längst nachhaltig offengelegt worden waren? Und warum funktioniert faktenfreie Propaganda so gut, wo doch mehr Menschen als je zuvor die Wahrheit mit Laptops und digitalen Kameras festhalten?

Manjoos Kommentare sprechen die Gesellschaft allgemein an, sind aber über die Klimawissenschaft besonders ausgeprägt wegen der unterschiedlichen Fähigkeiten der Öffentlichkeit hinsichtlich wissenschaftlicher Belange. Eine große Mehrheit kann leicht betrogen werden.

Manjoo argumentiert, dass die Leute sich die Fakten selbst zusammen schustern oder jemanden finden, der es für sie macht. Die Fabrikation von Daten ist die einzige Option in der Klimawissenschaft, weil – wie es der NRC-Bericht aus dem Jahr 1999 zeigte – es praktisch keine wirklichen Daten gibt. In dem Bericht vom US National Research Council (NRC) über Klimadaten vom 3. Februar 1999 heißt es:

Defizite hinsichtlich der Genauigkeit, Qualität und Kontinuität der Aufzeichnungen lassen ernste Zweifel an dem Vertrauen aufkommen, dass man den Forschungsergebnissen entgegen bringen kann.

Die Lage ist heutzutage noch schlimmer. Die Anzahl der verwendeten Stationen ist dramatisch reduziert worden, und Aufzeichnungen wurden hin zu niedrigeren historischen Daten verbogen. Dadurch nahm der Gradient in den Aufzeichnungen zu. Jüngst wurde das Fehlen von Ozean-Daten erkannt.

Zwei der führenden Ozeanographen von Harvard und dem MIT haben die begrenzten Daten angesprochen, die gegenwärtig die ozeanographische Gemeinschaft daran hindern, die Differenzen zwischen den vielen Schätzungen des ozeanischen Wärmegehaltes zu lösen.

Die Ozeane sind eine Schlüsselgröße hinsichtlich des CO2-Niveaus, und zwar wegen ihrer großen Kapazität als Quelle oder Senke.

Die Daten, die notwendig sind für eine ordentliche Festlegung der Klimaprozesse und daraus folgend der Klimaänderung, sind durchweg ungenügend. Dies gilt vor allem für die Struktur von Klimamodellen. Es gibt für mindestens 80% des den Globus umspannenden Netzes keine Daten, so dass sie raten: das nennt man Parametrisierung. Im IPCC-Bericht 2007 heißt es dazu:

Infolge der begrenzten Auflösung der Modelle können viele dieser Prozesse durch das Gitternetz der Modelle nicht angemessen aufgelöst werden und müssen daher parametrisiert werden. Die Unterschiede zwischen den Parametrisierungen sind ein wichtiger Grund für die Abweichungen der Klimamodelle untereinander.

Infolge der ungenügenden Datenlage tauchen unterschiedliche Ergebnisse auf, und die beteiligten Personen treffen eine subjektive Auswahl.

Das IPCC fabriziert die menschlichen Erzeugungs-Zahlen

Im IPCC-Bericht 2001 wurden 6,5 Gigatonnen Kohlenstoff als von menschlichen Quellen stammend identifiziert. Diese Zahl stieg auf 7,5 Gigatonnen im Bericht 2007 und bis 2010 auf 9,5 Gigatonnen. Woher haben sie diese Zahlen genommen? Antwort: Das IPCC hat sie erfunden und dann weiterverwendet. In der FAQ-Sektion fragen sie: „Wie erzeugt das IPCC seine Leitlinien?“

Zur Verwertung der ICC-Methoden werden Experten auf der ganzen Welt nominiert, die Berichte zu entwerfen, die dann extensiv zweimal begutachtet werden, bevor sie vom IPCC genehmigt werden.

Bis zum Bericht 2013 wurden diese Special Reports on Emissions Scenarios (SRES) genannt. Danach wurden sie zu Representative Concentration Pathways (RCP). Im März 2001 berichtet John Daly von Richard Lindzen unter Bezug auf die SRES und den gesamten IPCC-Prozess einschließlich SRES Folgendes:

In einem kürzlich geführten Interview mit James Glassman sagte Dr. Lindzen, dass der jüngste IPCC-Bericht (den er mit geschrieben hatte) „sehr stark wie ein Kinderspiel dessen war, was möglicherweise passiert“, vorbereitet durch eine „sonderbare Gruppe“ [a peculiar group] „ohne technische Kompetenz“.

William Kininmomth, Autor des aufschlussreichen Buches „Climate Change: A Natural Hazard“, war einst Leiter des National Climate Centre von Australien und dessen Delegation bei der WMO-Kommission für Klimatologie. Er schrieb Folgendes an die Site von ClimateSceptics:

Zuerst war ich verwirrt über das im AR 5 auftauchende RCP-Konzept. Ich kam zu der Schlussfolgerung, dass RCP nicht mehr ist als ein Taschenspielertrick, um die Leser zu verwirren und die Absurditäten in früheren Verfahren zu verstecken.

Man wird sich erinnern, dass die früheren Kohlenstoff-Emissionsszenarien vermeintlich auf soliden wirtschaftlichen Modellen beruhten. Allerdings ist diese Grundlage durch angesehene Ökonomen in Frage gestellt worden, und die Wirtschafts-Modellierung des IPCC blieb ziemlich zerfleddert und mit einem riesigen Fragezeichen darüber zurück.

Ich fühle, dass das RCP-Verfahren die zweifelhafte ökonomische Modellierung überbrückt: vorgeschriebene Strahlungs-Antriebe werden in die Klimamodelle gefüttert, um in der Zukunft einen Temperaturanstieg zu bekommen – falls der Strahlungsantrieb bei 8,5 W/m² ein Plateau erreicht irgendwann nach dem Jahr 2100, wird der globale Temperaturanstieg 3°C betragen. Aber was bedeuten 8,5 W/m²? Zuvor war bei einer Verdoppelung des CO2 ein Strahlungsantrieb von 3,7 W/m² im Gespräch. Um einen Strahlungsantrieb von 7,4 W/m² zu erreichen, müsste es noch eine Verdoppelung geben – eine viermal so hohe CO2-Konzentration. Folglich muss die atmosphärische CO2-Konzentration 1120 ppm nach dem Jahr 2100 übersteigen, um RCP 8,5 zu folgen.

Wir bleiben zurück mit der Frage nach dem Realismus eines solchen RCP 8,5-Szenarios. Besteht irgendeine Wahrscheinlichkeit, dass das atmosphärische CO2 nach 2100 1120 ppm erreichen wird? Das IPCC hat ein Strohmann-Szenario ins Spiel gebracht, um einen ,gefährlichen‘ globalen Temperaturanstieg von 3°C zu Anfang des 22. Jahrhunderts zu bekommen. Dabei wusste es vollkommen, dass eine solche Konzentration extrem unwahrscheinlich ist. Aber natürlich wird dies den Politikern und den politischen Entscheidungsträgern nicht erläutert. Ihnen wird nur das gefährliche Ergebnis vor Augen gehalten, falls man dem RCP 8,5 folgt ohne jeden Hinweis auf die geringe Wahrscheinlichkeit eines solchen Geschehens.

Eine Absurdität wird durch eine andere ersetzt! Oder habe ich etwas Grundlegendes übersehen?[1]

Nein, es fehlt nichts! Allerdings spielt es in der Wirklichkeit gar keine Rolle, ob sich dadurch irgendetwas ändert; es erfüllt das Ziel einer CO2-Zunahme und deren vermeintliche Auswirkung auf die globale Erwärmung. Die Untermauerung der IPCC-Klimawissenschaft und der Wirtschaft hängt von genauen Daten und profunden Kenntnissen der Prozesse statt. Beides ist nicht verfügbar.

Wir wissen, dass die Wetterdaten, auf denen Klimamodelle konstruiert werden, unzureichend sind, und die Lage wurde noch verschlimmert durch das Herausnehmen von Wetterstationen. Andere wurden ,adjustiert‘ und die Daten willkürlich herausgepickt. Wir wissen, dass die Kenntnisse der Prozesse unvollkommen sind, weil der IPCC-WGI-Bericht genau das sagt:

Unglücklicherweise sind die Wärme- und Wasserflüsse an der Oberfläche nicht gut dokumentiert.

Oder, damit die Modelle genau die jahreszeitlich wechselnde Verteilung des Niederschlags akkurat simulieren können, müssen sie korrekt eine Anzahl von Prozessen simulieren (z. B. Verdunstung, Kondensation, Transport). Dies ist im globalen Maßstab sehr schwierig zu evaluieren.

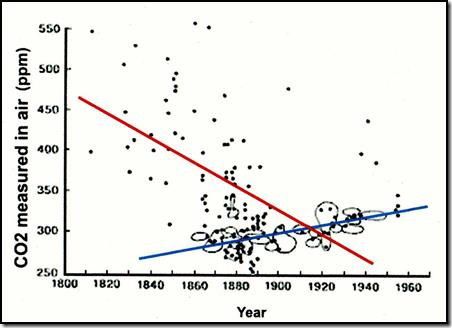

Zwei kritische Situationen standen im Mittelpunkt, das atmosphärische CO2-Niveau zu kontrollieren. Wir wissen, dass Guy Stewart Callendar, ein britischer Dampfmaschinen-Ingenieur, die niedrigen Zahlen aus 90.000 atmosphärischen CO2-Messungen im 19. Jahrhundert herausgepickt hatte. Dies etablierte nicht nur ein geringes vorindustrielles Niveau, sondern veränderte auch den Trend des atmosphärischen Niveaus (siehe folgende Abbildung:)

Abbildung 1 (Nach Jaworowski; Trendlinien hinzugefügt)

Callendars Arbeit war einflussreich hinsichtlich der von Gore aufgestellten Behauptungen über vom Menschen induzierte CO2-Zunahmen. Das einflussreichste Papier in der Klimagemeinschaft, vor allem an der CRU und beim IPCC, war jedoch die Studie von Tom Wigley aus dem Jahr 1983 mit dem Titel „The Pre-industrial carbon dioxide level“ (Climatic Change. 5, 315-320). Ich habe Seminare abgehalten über dessen Validität und Selektivität zur Etablierung einer vorindustriellen Basislinie.

Ich schrieb einen Nachruf auf Ernst Georg Beck, nachdem ich von seinem überraschenden Ableben erfahren hatte:

Ich war geschmeichelt, als er mich bat, eine seiner frühen Studien zur historischen Verteilung von atmosphärischem CO2 und dessen Beziehung zur globalen Erwärmung zu begutachten. Ich war begeistert von der Präzision, den Details und dem Wahrnehmungsvermögen und drängte auf die Veröffentlichung dieser Studie. Ich warnte ihn auch vor persönlichen Angriffen und unwissenschaftlichen Anwürfen, die er zu erwarten hatte. Am 6. November schrieb er mir: „In Deutschland ist die Lage vergleichbar mit den Zeiten der mittelalterlichen Inquisition“. Glücklicherweise war er nicht abgeschreckt. Sein Freund Edgar Gärtner erklärte Becks Beitrag in seinem Nachruf. „Aufgrund seines immensen Fachwissens und seiner methodischen Strenge fielen Ernst sehr frühzeitig zahlreiche Ungereimtheiten in den Aussagen des „Weltklimarates“ IPCC auf. Er hielt es schlicht für unvorstellbar, dass ein Anstieg des Kohlenstoffdioxid-Gehaltes der Luft von winzigen 0,03 auf kaum weniger winzige 0,04 Volumenprozent für die in den vergangenen Jahrzehnten eher gefühlte als gemessene Erwärmung der Erdatmosphäre verantwortlich sein sollte. Und er zweifelte daran, dass man die seit 1957/58 auf dem Hawaii-Vulkan Mauna Loa aufgezeichnete Kurve des CO2-Anstiegs linear bis ins 19. Jahrhundert nach rückwärts datieren kann“.*

[*Dieses Zitat ist das deutsche Original von Gärtner und keine Rückübersetzung aus Dr. Ball! Ball hatte glücklicherweise den Link angegeben und auf das deutsche Original verwiesen. Anm. d. Übers.]

Beck war der erste, der die Daten aus dem 19. Jahrhundert detailliert untersucht hat. Die Daten waren gesammelt worden für wissenschaftliche Versuche, präzise die Menge des CO2 in der Atmosphäre zu messen. Es begann im Jahre 1812, ausgelöst durch die Arbeit von Priestly zu atmosphärischem Sauerstoff und war Teil der wissenschaftlichen Bemühungen, alle atmosphärischen Gase zu quantifizieren. Es gab kein unmittelbares politisches Motiv. Beck hat mit den Ergebnissen keine Rosinenpickerei betrieben, sondern er hat das Verfahren untersucht, die genauen Messorte und so viele Details wie möglich für jede Messung. Dies stand in absolutem Kontrast zu dem, was Callendar und Wigley gemacht haben.

Das IPCC musste jetzt beweisen, dass:

● Zunahmen des atmosphärischen CO2-Gehaltes in den historischen Aufzeichnungen eine Erwärmung ausgelöst haben

● die gegenwärtigen Niveaus ungewöhnlich hoch sind im Vergleich zu den historischen Aufzeichnungen

● das gegenwärtige Niveau viel höher ist als in vorindustriellen Zeiten

● die Unterschiede zwischen dem vorindustriellen und dem jetzigen Niveau dem menschlichen CO2-Beitrag in die Atmosphäre geschuldet sind.

Becks Arbeit zeigt die Falschheit dieser Behauptungen, und indem er das getan hat, hat er sich eine große Last aufgeladen.

Nochmals aus meinem Nachruf:

Ernst Georg Beck war ein Gelehrter und Gentleman in jeder Hinsicht. Sein Freund schrieb: „Sie versuchten, Ernst Georg Beck im Internet als ahnungslosen Amateur und Datenfälscher zu denunzieren. Ernst konnte sich dagegen in den letzten Monaten wegen seiner fortschreitenden Krankheit leider kaum noch wehren“.* Seine Arbeit, seine Bestimmung und seine Ethik waren allesamt darauf gerichtet, Fragen in skeptischer Manier zu beantworten, was wirkliche Wissenschaft ist; die Antithese zu den Bemühungen all jener, die ihn herausforderten oder versuchten, ihn mundtot zu machen oder ihn zu verleumden.

[*Auch hier das Originalzitat]

Die CO2-Messungen aus dem 19. Jahrhundert sind nicht genauer als die Messungen der Temperatur: tatsächlich würde ich sagen, dass Beck zeigt, wie gut sie sind. Warum also sind beispielsweise seine Einschätzungen weniger gültig als jene, die zu Anfang der Central England Temperatures (CET) gemacht worden sind? Ich habe mich lange mit Hubert Lamb über die Anfänge dieser CET-Rekonstruktion von Manley unterhalten, weil die Instrumente, Messorte, Messungen Aufzeichnungen und das Wissen der Beobachter vergleichbar waren mit jenen in den Aufzeichnungen der Hudson Bay Company, mit denen ich mich befasst habe.

Als das vorindustrielle Niveau einmal erschaffen worden war, wurde es notwendig sicherzustellen, dass sich der neue nachindustrielle CO2-Trend fortsetzt. Dies wurde erreicht, als C. D. Keeling die Messstation am Mauna Loa eingerichtet hatte. Beck sagt dazu:

Die moderne Treibhaus-Hypothese basiert auf der Arbeit von G. S. Callendar und C. D. Keeling, die die Linie von S. Arrhenius fortsetzen, was jüngst durch das IPCC popularisiert worden ist.

Keelings Sohn betreibt jetzt die Station am Mauna Loa und, wie Beck anmerkt, besitzt das globale Monopol der Kalibrierung aller CO2-Messungen. Er ist auch Ko-Autor der IPCC-Berichte, die die Werte vom Mauna Loa und alle anderen Messungen als repräsentativ für das globale Niveau akzeptieren. Folglich kontrolliert das IPCC die Zahlen der menschlichen Erzeugung und des atmosphärischen CO2-Niveaus. Beide nehmen konstant und konsistent zu.

Dies lenkt ab von dem realen Problem mit den Messungen und Behauptungen. Die fundamentale IPCC-Prämisse ist es, die menschlichen Gründe der globalen Erwärmung zu benennen. Man kann nur dann den menschlichen Beitrag und Anteil bestimmen, wenn man natürliche Niveaus kennt und wie stark diese variieren, und wir haben nur sehr grobe Schätzungen.

Welche Werte werden für jede Komponente des Kohlenstoff-Zyklus‘ verwendet?

Dr. Dietrich Kölle ist einer der wenigen Wissenschaftler, der Schätzungen natürlicher jährlicher CO2-Emissionen unter die Lupe nimmt. Er kommt zu folgenden Ergebnissen:

Jährliche Kohlendioxid-Emissionen GtC pro Jahr:

1. Atmung (Menschen, Tiere, Phytoplankton) 45 bis 52

2. Ozeanische Ausgasung (tropische Gebiete) 90 bis 100

3. Vulkanische und andere Quellen aus dem Erdboden 0,5 bis 2

4. Bodenbakterien, Verrottung und Verfall 50 bis 60

5. Roden von Wäldern, Waldbrände 1 bis 3

6. Anthropogene Emissionen aus fossilen Treibstoffen (2010) 9,5

Gesamtmenge 196 bis 226,5

Quelle: Dr. Dietrich Kölle

Die IPCC-Schätzung der menschlichen Produktion (6) für das Jahr 2010 betrug 9,5 GtC, aber das ist die Gesamtproduktion. Einer der frühen Dinge in dem Betreiben, das Kyoto-Protokoll zu ratifizieren war ein Versuch, die USA zur Ratifikation zu bewegen. Die USA forderten Kohlenstoff-Zertifikate, vor allem für die Entfernung von CO2 durch Aufforstung, damit eine Gesamtzahl zur Anwendung kommt, die die USA als eine entwickelte Nation einschätzen. Das wurde abgelehnt. Realität ist, dass die Gesamtzahl besser den menschlichen Einfluss repräsentiert. Falls wir die menschliche Gesamtproduktion (6) mit 5 GtC für das Jahr 2010 ansetzen, liegt dies innerhalb der Bandbreite von Schätzungen für drei natürliche Quellen (1), (2) und (4).

Die Wahrheit wird ans Licht kommen

Wie lange wird das IPCC noch damit fortfahren, CO2-Daten zu erzeugen, die zu seiner Hypothese passen, dass die Temperatur weiterhin steigen wird? Wie lange wird es dauern, bis die Öffentlichkeit auf Pamela Grays anschauliche Beobachtung aufmerksam wird, die da lautet: Der allein anthropogene Anteil am atmosphärischen CO2, vor allem der Anteil Chinas, hat nicht die erforderliche Fähigkeit, auch nur ein winziges bisschen „Wetter“ auch nur ein wenig zu verändern. Der nunmehr fast 18 Jahre lange Stillstand und leichte Rückgang der globalen Temperatur ist essentiell unmöglich, wenn man die IPCC-Hypothesen zugrunde legt. Eine Behauptung lautet schon jetzt, dass der Stillstand nicht ihrer Wissenschaft oder ihren Projektionen widerspricht, sondern diese stattdessen anerkennt, zusammen mit falschen Prognosen.

Das IPCC und die EPA haben bereits gezeigt, dass es keine Rolle spielt, unrecht zu haben oder ertappt zu werden. Die Objektive ist die Angst erzeugende Schlagzeile, verstärkt durch die stetige Behauptung, dass es zunehmend schlimmer wird und dass die Zeit davonläuft. Aldous Huxley sagte: Fakten werden nicht dadurch aus der Welt geschafft, dass man sie ignoriert. Wir müssen sicherstellen, dass diese Fakten real sind und nicht ignoriert werden.

[1] Nachdruck mit Erlaubnis von William Kininmonth.

Link: http://wattsupwiththat.com/2014/08/05/co2-data-might-fit-the-ipcc-hypothesis-but-it-doesnt-fit-reality/#more-114086

Übersetzt von Chris Frey EIKE