scienceofdoom

Im Teil neun haben wir über eine GCM-Simulation der letzten 120.000 Jahre gesprochen, ein ziemlich ambitioniertes Projekt, das einige gemischte Ergebnisse zeitigte. Die größte Herausforderung ist einfach, ein ganzes GCM über eine so lange Zeit laufen zu lassen. Um das zu tun, hatte das Modell eine reduzierte räumliche Auflösung. Außerdem wurden alle Antriebe „beschleunigt“, so dass die Modellzeit tatsächlich über 1200 Jahre lief. Unter den Antrieben waren Größe, Ort und Höhe des Eisschildes ebenso wie Treibhausgase in der Atmosphäre. In der Realität handelt es sich dabei um Rückkopplungen, aber GCMs sind derzeit nicht in der Lage, diese zu erzeugen.

In diesem Beitrag betrachten wir eines der jüngsten GCMs, das jedoch nur über einen „Schnappschuss“-Zeitraum von 700 Jahren läuft. Das erlaubt die volle räumliche Auflösung, hat aber den Nachteil, dass ein vollständiger Eiszeit-Zyklus nicht einmal annähernd abgedeckt werden kann. Ziel dieses Artikels ist es, das Modell mit den orbitalen Bedingungen von vor 116.000 Jahren laufen zu lassen um zu sehen, ob sich eine permanente Schneedecke an den richtigen Stellen bildet. Dies ist ein Projekt ähnlich denen, die wir in Teil VII – GCM I (frühe GCMs) und Teil VIII – GCM II (GCMs vor einem Jahrzehnt) besprochen haben.

Die Studie kam zu einigen sehr interessanten Ergebnissen hinsichtlich der Rückkopplungen, die wir noch betrachten werden.

Jochum et al (2012)

Das Problem:

Modelle mittlerer Komplexität sowie flussbereinigte GCMs waren typischerweise in der Lage, eine Verbindung zwischen orbitalem Antrieb, Temperatur und Schneemenge zu simulieren. Bislang jedoch haben es vollständig gekoppelte, nicht flusskorrigierte, auf primitiven Gleichungen basierende Klimamodelle nicht vermocht, die Auslösung einer Eiszeit zu reproduzieren, ebenso wie die Abkühlung und Zunahme von Schnee- und Eisbedeckung, die von den warmen Zwischeneiszeiten zu den kalten eiszeitlichen Perioden überleiten.

Milankovitch (1941) postulierte, dass der Antreiber für diese Abkühlung die orbital bedingte Reduktion der Einstrahlung auf der sommerlichen Nordhalbkugel sei und die daraus folgende Zunahme permanenter Schneebedeckung. Die verstärkte permanente Schneebedeckung und seine positive Albedo-Rückkopplung sind natürlich nur Vorboten des Wachstums von Eisschilden. Das Scheitern der GCMs, die Auslösung der Eiszeiten nachzuvollziehen, zeigt ein Scheitern entweder der GCMs oder der Milankovitch-Hypothese.

Falls die Hypothese die Schuldige wäre, würde man sich natürlich fragen, ob das Klima in den GCMs überhaupt angemessen abgebildet werden kann. Wie auch immer, es scheint, als ob die Reproduktion der beobachteten Änderungen zwischen Eiszeit und Zwischeneiszeit hinsichtlich der Eismenge und der Temperatur einen guten Test darstellt, um die Genauigkeit einiger Schlüssel-Rückkopplungen zu evaluieren, die für Klimaprojektionen relevant sind.

Die potentiellen Gründe des Unvermögens der GCMs, die Auslösung der Eiszeit zu reproduzieren, sind vielfältig und reichen von der Numerik der GCMs bis zu vernachlässigten Rückkopplungen von Festlands-, atmosphärischen oder ozeanischen Prozessen auf der Theorie-Seite. Es ist allerdings ermutigend, dass es bei einigen GCMs nur geringer Modifikationen bedarf, damit diese eine Zunahme permanenter Schneebedeckung erzeugen (z. B. Dong und Valdes 1995). Nichtsdestotrotz muss es das Ziel der GCM-Gemeinde sein, das Auftreten zunehmender permanenter Schneebedeckung mit einem GCM zu erzeugen, das an das heutige Klima angepasst ist und ausschließlich Gegenstand von Änderungen des orbitalen Antriebs ist.

Ihr Modell:

Die numerischen Experimente wurden durchgeführt unter Verwendung der jüngsten Version des National Center for Atmospheric Research (NCAR) CCSM4, welches vollständig gekoppelte Atmosphären-, Ozean-, Festlands- und Meereismodelle enthält. CCSM4 ist ein hypermodernes Klimamodell, das in vieler Hinsicht Verbesserungen seines Vorgängers CCSM3 enthält. In unserem Zusammenhang hier besteht die wichtigste Verbesserung in der höheren atmosphärischen Auflösung, weil diese uns gestattet, die Höhe und die Schneebedeckung des Festlandes genauer zu repräsentieren.

Siehe Anmerkung 1 für einige weitere Modell-Einzelheiten aus der Studie. Und lange Zeit haben wir einige Grundlagen von CCSM3 betrachtet – Models, On – and Off – the Catwalk – Part Two. Grenzen des Modells – kein die Eisschilde betreffendes Modul (anders als das FAMOUS-Modell in Teil neun):

Das CCSM enthält immer noch nicht ein Eisschilde-Modul. Darum verwenden wir die Akkumulation von Schnee als das Hauptargument des Auslöse-Szenarios. Die Akkumulation von Schnee auf dem Festland wird berechnet aus der Summe von Schneefall, gefrierendem Regen, Schneeschmelze und dem Entfernen exzessiven Schnees. Exzessiver Schnee wird definiert als eine Schneemenge, die über 1 Meter Wasseräquivalent hinausgeht, also etwa 3 bis 5 m Schnee.

Das Entfernen des exzessiven Schnees ist eine sehr grobe Parametrisierung des Kalbens von Eisbergen, und zusammen mit dem Schmelzwasser wird exzessiver Schnee an das Netzwerk der Flüsse geliefert und eventuell den küstennahen Oberflächen-Gewässern der angrenzenden Ozean-Gitterpunkte zugefügt. Folglich werden die lokale Größe des Eisschildes und das globale Frischwasser-Volumen konserviert.

Probleme des Modells:

Eine weitere Bias, die für diese Diskussion relevant ist, ist die Temperatur auf dem Festland in hohen nördlichen Breiten. Wie im nächsten Abschnitt beschrieben wird, ist eine Menge der CCSM4-Reaktion auf orbitale Antriebe der reduzierten Schneeschmelze im Sommer geschuldet. Eine Kalt-Bias bei der Kontrolle wird es wahrscheinlicher machen, die Sommertemperatur unter dem Gefrierpunkt zu halten, so dass die Schnee-Akkumulation des Modells überschätzt wird. Im jährlichen Mittel sind Nordsibirien und Nordkanada um etwa 1°C bis 2°C zu kalt, Baffin-Insel sogar um etwa 5°C zu kalt (Gent et al. 2011). Die sibirischen Bias sind nicht so dramatisch, aber es ist ziemlich unglücklich, dass die Baffin-Insel, das Zentrum des Laurentide-Eisschildes, eine der stärksten Temperaturbias im CCSM4 aufweist. Ein genauerer Blick auf die Temperaturbias in Nordamerika zeigt jedoch, dass die Kalt-Bias dominiert wird von Bias im Herbst und Winter, während die Baffin-Insel im Frühjahr und Sommer um etwa 3°C zu kalt ist und der kanadische Archipel sogar eine geringe Warm-Bias aufweist.

Ihr Plan:

Die nachfolgenden Abschnitte werden zwei unterschiedliche Simulationen analysieren und vergleichen: einen Kontroll-Lauf 1850 (CONT), in welchem die orbitalen Parameter der Erde auf die Werte im Jahre 1900 gesetzt werden und die atmosphärische Zusammensetzung bei den Werten des Jahres 1850; und eine Simulation identisch mit CONT mit Ausnahme der orbitalen Parameter, die auf die Werte von vor 115.000 Jahren (OP115) gesetzt werden. Die atmosphärische CO2-Konzentration in beiden Experimenten beträgt 285 ppm.

Die Modelle wurden über 700 (simulierte) Jahre laufen gelassen. Dann folgen einige interessante Bemerkungen, warum sie keine Simulation über 120.000 Jahre durchführen können: Dieser experimentelle Aufbau ist natürlich nicht optimal. Idealerweise würde man gerne das Modell seit der letzten Zwischeneiszeit vor etwa 126.000 Jahren integrieren, für 10.000 Jahre in die Eiszeit mit sich langsam änderndem orbitalen Antrieb. Allerdings ist das nicht machbar; eine Integration über 100 Jahre CCSM auf den NCAR-Supercomputern würde etwa einen Monat dauern und einen substantiellen Teil der Computerbelegung der Klimagruppe beanspruchen.

Ergebnisse

Zunächst erzeugen sie in der Tat eine permanente Schneebedeckung in hohen Breiten. Die Studie bietet eine sehr gute Erklärung, wie die unterschiedlichen Klimafaktoren in hohen Breiten zusammenspielen, wo wir nach dem Einsetzen permanenter Schneebedeckung suchen. Es hilft uns zu verstehen, warum grundlegende Energiebilanzmodelle und selbst Modelläufe zwischenzeitlicher Komplexität (EMICs) keine zuverlässigen brauchbaren Antworten liefern können. Schauen wir mal:

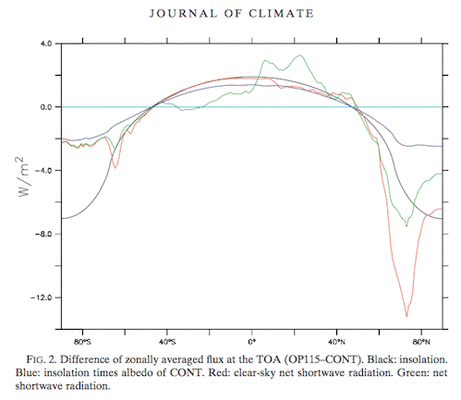

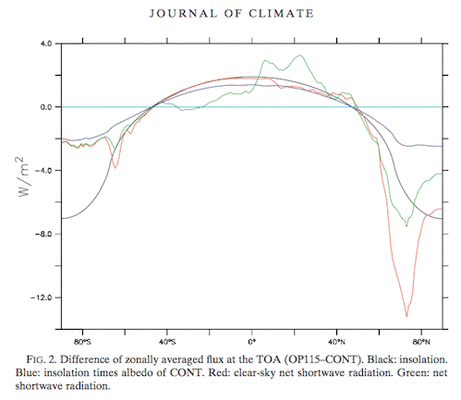

Bildunterschrift: Abb. 2: Differenz des zonal gemittelten Flusses an der Obergrenze der Atmosphäre (OP115 vs. CONT). Schwarz: Einstrahlung. Blau: Einstrahlung mal Albedo aus CONT. Rot: Gesamt-Kurzwellenstrahlung bei klarem Himmel. Grün: Gesamt-Kurzwellenstrahlung (Jochum et al 2012)

Die Graphik vergleicht die jährliche Sonneneinstrahlung pro Breitenkreis von 115.000 Jahren und heute. Man beachte den zentralen Punkt: Die einfallende Sonnenstrahlung – also die schwarze Kurve – war an den Tropen höher, während die jährliche Einstrahlung in hohen Breiten niedriger war.

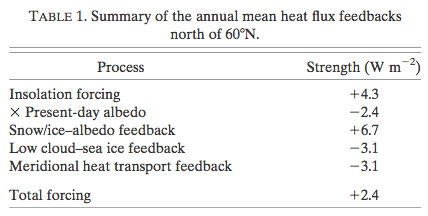

Konzentrieren wollen wir uns auf die Nordhemisphäre nördlich von 60°N, welche die Gebiete großräumiger Abkühlung und zunehmender Schneebedeckung überdeckt. Verglichen mit CONT ist die jährliche mittlere Einstrahlung über dieser Arktischen Domäne in OP115 geringer bei 4,3 W/m² (schwarze Linie), aber die hohe Albedo reduziert diesen Unterschied an der Obergrenze der Atmosphäre auf nur 1,9 W/m² (blaue Linie, siehe auch Tabelle 1).

In blau wird das Ergebnis gezeigt, wenn wir die bestehende Albedo berücksichtigen – das heißt, weil eine Menge Solarstrahlung schon in hohen Breiten reflektiert wird, werden sämtliche Änderungen der einfallenden Strahlung durch den Albedo-Effekt reduziert (bevor sich die Albedo selbst ändert). In grün wird das Ergebnis gezeigt, wenn wir die veränderte Albedo der größeren Schneebedeckung von 115.000 Jahren berücksichtigen.

Im CCSM4 führt diese größere Albedo im OP115 zu einer Kurzwellenstrahlung an der Obergrenze der Atmosphäre bei klarem Himmel, die um 8,6 W/m² geringer ist als im CONT – das ist 4 mal das ursprüngliche Signal. Die Schnee/Eis-Albedo-Rückkopplung wird dann berechnet mit 6,7 W/m² (8,6 bis 1,9 W/m²). Interessanterweise ist die Bedeckung mit tiefen Wolken im OP115 kleiner als im CONT, was die Differenz der Gesamt-Kurzwellenstrahlung an der Obergrenze der Atmosphäre um 3,1 bis 5,5 W/m² reduziert (grüne Linie). Zusammengefasst: ein Initial-Antrieb von 1,9 W/m² nördlich von 60°N wird um 6,7 W/m² verstärkt durch die Schnee/eis-Albedo-Rückkopplung und reduziert durch eine negative Wolken-Rückkopplung um 3,1 W/m².

Die zusammenfassende Tabelle:

Wegen der größeren meridionalen Temperatur- (Abbildung 1a) und Feuchtigkeits-Gradienten (Abbildung 4a) nimmt der atmosphärische Quer-Wärmefluss in die Arktis zu von 2,88 auf 3,0 PW. Dieser Unterschied von 0,12 PW bedeutet für die Arktis ein Mittel von 3,1 W/m²; das ist eine negative Rückkopplung, die genauso groß ist wie die Wolken-Rückkopplung und die 6 mal größer ist als die Zunahme des meridionalen Wärmetransportes im Ozean bei 60°N (nächster Abschnitt). Folglich kompensieren sich die negative Wolken-Rückkopplung und der meridionale Wärmetransport für die positive Rückkopplung fast vollständig. Übrig bleibt eine Gesamt-Rückkopplung von nur 0,5 W/m². Eine Möglichkeit, diese Rückkopplungen zu betrachten ist, dass das Klimasystem ziemlich stabil ist, wobei Wolken und meridionale Transporte den Einfluss von Albedo-Änderungen begrenzen. Dies könnte erklären, warum einige numerische Modelle Schwierigkeiten haben, die beobachtete Abkühlung in Verbindung mit dem orbitalen Antrieb zu erzeugen.

Ich glaube es ist wichtig zu beachten, dass sie ihre Ergebnisse durch einen unterschiedlichen Mechanismus zu einer der Studien bekommen, die wir in Teil 9 begutachtet haben:

Folglich ist die Zunahme von Schneefall im Gegensatz zu den Ergebnissen von Vetterotti und Peltier (2003) vernachlässigbar im Vergleich zur reduzierten Schneeschmelze.

Ihr Ergebnis:

Die globale Gesamt-Differenz hinsichtlich Schmelzen und Schneefall zwischen OP115 und CONT führt zu einer impliziten Schnee-Akkumulation, die äquivalent ist mit einem Rückgang des Meeresspiegels um 20 m innerhalb von 10.000 Jahren, einiges davon der Kaltverzerrung der Baffin-Insel geschuldet. Das ist weniger als die 50-m-Schätzung, die auf Rekonstruktionen des Meeresspiegels zwischen heute und vor 115.000 Jahren basiert, aber unabhängig davon zeigt sich, dass das Modell die richtige Größenordnung wiedergibt.

Atlantic Meridional Overturning Current (AMOC)

Diese Strömung hat enormen Einfluss auf die höheren Breiten im Atlantik, weil sie wärmeres Wasser aus den Tropen transportiert.

Der meridionale Wärmetransport der AMOC ist eine wesentliche Wärmequelle für den nördlichen Nordatlantik, aber man glaubt auch, dass er für kleine Störungen anfällig ist. Daraus ergibt sich die Möglichkeit, dass die AMOC den orbitalen Antrieb verstärkt oder sogar, dass diese Verstärkung für Vereisungen und Terminierungen der Nordhemisphäre notwendig ist. Tatsächlich zeigt JPML, dass eine Änderung des orbitalen Antriebs in mindestens einem GCM zu einer Abschwächung der MOC führen kann und zu einer daraus folgenden großräumigen Abkühlung der Nordhemisphäre. Hier beleuchten wir den Zusammenhang zwischen orbitalem Antrieb und Stärke der AMOC mit dem CCSM4, welches verbesserte Physik und eine höhere räumliche Auflösung als JPML aufweist.

Im Wesentlichen fanden sie eine begrenzte Änderung der AMOC in dieser Studie. Interessierte Leser können die Studie gerne einsehen. Dies ist ein wichtiges Ergebnis, weil frühere Studien mit geringerer Auflösung oder mit GCMs, die nicht vollständig gekoppelt sind, oftmals eine starke Rolle der MOC bei sich verstärkenden Änderungen gefunden hatten.

Schlussfolgerung

Dies ist eine interessante Studie. Sie ist wichtig, weil sie ein hypermodernes GCM verwendet, um permanente Schneebedeckung von 115.000 Jahren zu simulieren, einfach mit vorindustriellen Treibhausgas-Konzentrationen und Einstrahlungsbedingungen vor 115.000 Jahren. Das Modell weist eine Kalt-Bias auf (und eine verstärkte Feuchte-Bias) in hohen Breiten der Nordhemisphäre. Dadurch erhebt sich die Frage nach der Signifikanz des Ergebnisses (für meinen skeptischen Verstand):

• Kann ein hoch auflösendes AO-GCM ohne Kalt-Bias in hohen Breiten eine permanente Schneebedeckung nur mit vorindustriellen Werten der Treibhausgas-Konzentration und orbitalem Antrieb vor 115.000 Jahren erzeugen?

• Kann dieses Modell mit dieser Kalt-Bias in hohen Breiten das Ende einer Vereisung reproduzieren?

Das heißt nicht, dass die Studie nicht sehr wertvoll ist, und die Autoren haben sicher nicht versucht, die Schwächen des Modells zu übergehen – tatsächlich haben sie diese sogar noch unterstrichen. Was die Studie ebenfalls zeigt – und was wir auch in früheren Artikeln gesehen haben – ist: wenn wir uns durch Generationen und Komplexitäten der Modelle wühlen, können wir Erfolg haben; dann scheitert ein besseres Modell, dann führt ein noch besseres Modell wieder zum Erfolg. Auch haben wir angemerkt, während das (ebenfalls kalt-bias) Modell von Vetterotti und Peltier (2003) eine permanente Schneebedeckung durch verstärkte Feuchtetransporte in kritische Gebiete gefunden hatte (was sie als einen „Rückkopplungs-Mechanismus zwischen Atmosphäre und Cryosphäre“ bezeichnen), hat eine jüngere Studie mit einem verbesserten Modell keine Zunahme der Feuchtetransporte gefunden.

Die Details, wie unterschiedliche Modelle zum gleichen Ergebnis kommen, sind wichtig. Ich glaube nicht, dass irgendein Klimawissenschaftler dies anders sieht, aber es bedeutet, dass viele Studien mit „Erfolg“ nicht „Erfolg für alle“ bedeuten und nicht für einen „allgemeinen Erfolg“ stehen können. Die Details müssen untersucht werden.

Diese Studie aus dem Jahr 2012 zeigt die Bedeutung aller (derzeit bekannten) Rückkopplungen – eine Zunahme der Albedo durch verstärke Schneedeckenbildung wird fast vollständig durch negative Rückkopplungen ausgebremst. Und schließlich zeigt die Studie auch, dass ihr Modelllauf über 700 Jahre nicht die signifikante Abkühlung der Südpolarregion erzeugen kann:

Noch wichtiger ist jedoch das Fehlen jedweder Reaktion im Polargebiet der Südhalbkugel, die erforderlich sind, um Abbildung 1 zu erklären. Während Petit et al. 1999 zeigen, dass sich die Antarktis zu Beginn der letzten Eiszeit um 10°C abgekühlt hat, zeigt eine jüngere hoch aufgelöste Analyse von Jouzel et al. 2007, dass es nur wenig kälter war als heute (weniger als 3°C beim European Project for Ice Coring in Antarctica (EPICA), Stelle Dome C auf dem Antarktischen Plateau). Natürlich gibt es substantielle Unsicherheiten bei der Rekonstruktion der antarktischen Temperaturen.

Ich habe keinerlei Kommentare zu diesem speziellen Punkt, weil mir das Verständnis der jüngsten Arbeiten hinsichtlich Datierung und Korrelation mit EPICA fehlen (Eisbohrkerne aus Grönland und der Antarktis).

References

True to Milankovitch: Glacial Inception in the New Community Climate System Model, Jochum, Jahn, Peacock, Bailey, Fasullo, Kay, Levis & Otto-Bliesner, Journal of Climate (2012) – free paper

Notes

Anmerkung 1 – mehr zum Modell:

Die ozeanische Komponente hat eine horizontale Auflösung, die bei den Längengraden konstant 1,125° beträgt und hinsichtlich der Breite von 0,27° am Äquator bis etwa 0,7° in hohen Breiten reicht. In der Vertikalen gibt es 60 Schichten; die höchste Schicht hat eine Dicke von 10 m und die unterste Schicht eine solche von 250 m. Die atmosphärische Komponente verwendet eine horizontale Auflösung von 0,9° X 1,25° mit 26 Schichten in der Vertikalen. Das Meereis-Modell hat das gleiche horizontale Gitternetz wie das Ozean-Modell, und das Festlands-Modell hat das gleiche horizontale Gitternetz wie das atmosphärische Modell.

Link: http://scienceofdoom.com/2014/01/03/ghosts-of-climates-past-part-ten-gcm-iv/

Teil I und II: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-i-und-ii/

Teil III: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iii-hays-imbrie-shackleton/

Teil IV: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iv-umlaufbahnen-jahreszeiten-und-mehr/

Teil V: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-v-aenderungen-der-ekliptik-und-der-praezession/

Teil VI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-vi-hypothesen-im-ueberfluss/

Teil VII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-7-global-circulation-models-i/

Teil VIII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-8-global-circulation-models-ii/

Teil IX: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-9-global-circulation-models-iii/