Bild rechts: Monatliche globale mittlere Temperaturanomalien der unteren Troposphäre nach RSS (dunkelblau) und Trend (dicke hellblaue Linie). Von September 1996 bis Mai 2014 zeigt sich seit 17 Jahren und 9 Monaten kein Trend.

Die Stillstands-Periode von 17 Jahren und 9 Monaten ist der weiteste Schritt zurück, den man bei den RSS-Temperaturdaten gehen kann und immer noch einen Null-Trend findet. Aber die Länge des Stillstands der globalen Erwärmung, so signifikant sie inzwischen auch ist, ist von geringerer Bedeutung als die immer weiter zunehmende Diskrepanz zwischen den von den Modellen vorhergesagten Temperaturtrends und der beobachteten weniger begeisternden Temperaturänderung in der realen Welt.

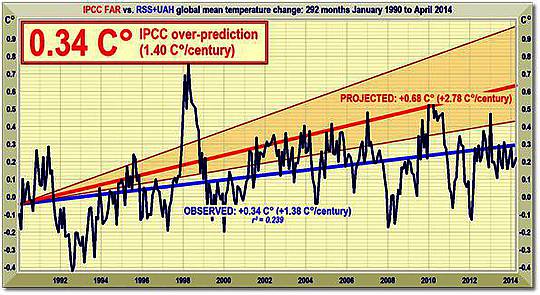

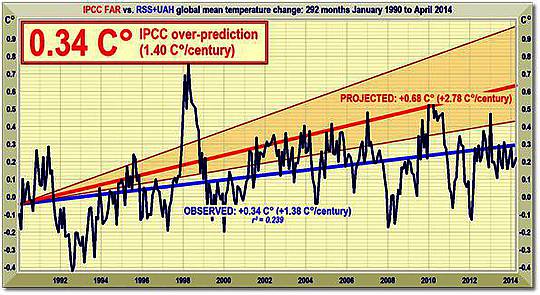

Im Ersten Zustandsbericht wurde noch vorhergesagt, dass die globale Temperatur um 1,0 (0,7; 1,5)°C bis zum Jahr 2025 steigen würde, das wäre äquivalent zu einer Rate von 2,8 (1,9; 4,2)°C pro Jahrhundert. In der Executive Summary wurde gefragt: „Wie viel Vertrauen haben wir in unsere Vorhersagen?” Das IPCC wies auf einige Unsicherheiten hin (Wolken, Ozeane usw.), kam aber zu der Schlussfolgerung:

„Nichtsdestotrotz … haben wir substantielles Vertrauen, dass unsere Modelle zumindest die Features der Klimaänderung im groben Rahmen vorhersagen können … Es gibt Ähnlichkeiten zwischen den Ergebnissen gekoppelter Modelle, die einfache Repräsentationen des Ozeans verwenden und jenen, die kompliziertere Beschreibungen verwenden, und unser Verständnis derartiger Unterschiede gibt uns einiges Vertrauen in die Ergebnisse“.

Jenes „substantielle Vertrauen” war substantielles Über-Vertrauen. Ein Vierteljahrhundert nach 1990 beträgt das Ergebnis bis heute 0,34°C – ausgedrückt als lineare Regression kleinster Quadrate des Mittels nach GISS, HadCRUT4 und NCDC der monatlichen globalen Temperaturanomalien. 0,34°C, das ist äquivalent zu einer Rate von 1,4°C pro Jahrhundert oder genau die Hälfte der zentralen Schätzung des IPCC (1990) und deutlich unter selbst der geringsten Schätzung (Abbildung 2).

Abbildung 2: Mittelfristige globale Temperatur-Projektionen des IPCC (1990) von Januar 1990 bis April 2014 (orangene Fläche und rote Trendlinie) im Vergleich zu beobachteten Anomalien (dunkelblau) und Trend (hellblau) als Mittel der monatlichen Temperaturanomalien nach RSS und UAH.

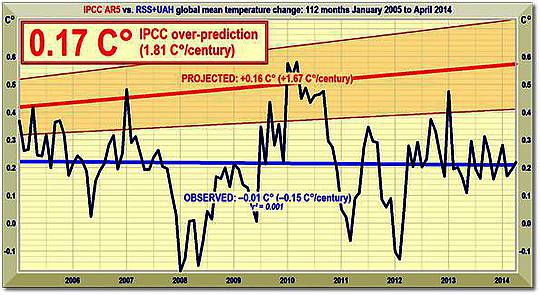

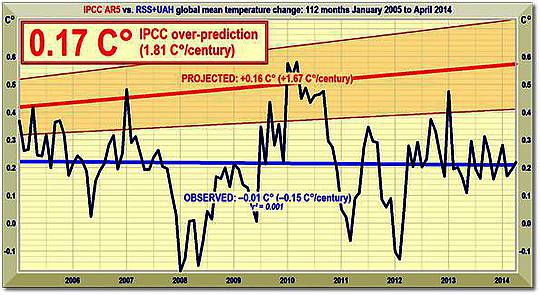

Abbildung 3: Vorhergesagte Temperaturänderung seit 2005 mit einer Rate äquivalent zu 1,7 (1,0; 2,3)°C pro Jahrhundert (orangene Fläche mit dicker roter Trendlinie des Best Estimate), verglichen mit den beobachteten Anomalien (dunkelblau) und Trend (hellblau).

Bemerkenswerterweise liegen auch die jüngsten und erheblich reduzierten kurzfristigen Projektionen der globalen Erwärmung immer noch exzessiv zu hoch (Abbildung 3).

Im Jahre 1990 lag die zentrale Schätzung der kurzfristigen Erwärmung um zwei Drittel höher als heute. Dann war es ein Äquivalent zu 2,8°C pro Jahrhundert. Inzwischen sind es lediglich 1,7°C – und, wie Abbildung 3 zeigt, ist selbst das noch eine substantielle Übertreibung.

Hinsichtlich der RSS-Satellitendaten gab es seit über 26 Jahren keine statistisch signifikante globale Erwärmung. Keines der Modelle hat das vorhergesagt – im Endeffekt ist es ein Vierteljahrhundert ohne jede globale Erwärmung.

Neue Versuche, die ernste und immer noch wachsende Diskrepanz zwischen Vorhersage und Realität hinweg zu erklären, gibt es inzwischen fast jeden Tag. Viel zu wenig Wissenschaftler hinter der Klima-Angst waren bisher gewillt, die offensichtlichste Erklärung anzubieten – dass nämlich die Modelle so programmiert worden sind, dass eine viel stärkere Erwärmung vorhersagen als wahrscheinlich eintritt.

Es kann gut sein, dass der lange Stillstand diesen Winter zu Ende geht. Ein El Niño-Ereignis hat eingesetzt. Die üblichen Verdächtigen haben gesagt, dass es Rekorde brechen wird, aber bislang gibt es viel zu wenig Informationen, um sagen zu können, zu wie viel vorübergehender Erwärmung es dadurch kommen wird. Die Temperaturspitzen der El Niño-Ereignisse von 1998, 2007 und 2010 kommen in den Abbildungen 1 bis 3 klar zum Ausdruck.

Zu einem El Niño kommt es alle drei oder vier Jahre, obwohl noch niemand genau sagen kann, was sie auslöst. Sie verursachen eine temporäre Temperaturspitze, oftmals gefolgt von einem starken Rückgang während der La Niña-Phase, wie man in den Jahren 1999, 2008 und 2011-2012 erkennen kann, als es einen „Doppel-Dip“ La Niña gab.

Das Verhältnis zwischen El Niños und La Niñas tendiert dazu, in die 30-jährige negative oder Abkühlungs-Phase der Pazifischen Dekadischen Oszillation zu fallen, deren jüngste Ende 2001 eingesetzt hat. Obwohl also der Stillstand zum Jahreswechsel einige Monate lang unterbrochen werden könnte, dürfte er Ende 2015 höchstwahrscheinlich wieder einsetzen.

Wie auch immer, es wird immer klarer, dass die globale Erwärmung nicht einmal annähernd mit der von den Klimamodellen vorhergesagten Rate stattgefunden hat, und es ist überhaupt nicht wahrscheinlich, dass sie selbst mit der jetzt vorhergesagten erheblich reduzierten Rate stattfinden wird. Es könnte in diesem Jahrhundert eine globale Erwärmung bis 1°C geben, aber nicht die vom IPVV vorhergesagten 3 bis 4°C.

Zentrale Fakten hinsichtlich der globalen Temperatur

Ø Der RSS-Satellitendatensatz zeigt keinerlei globale Erwärmung seit 213 Monaten, also von September 1996 bis Mai 2014. Das ist über die Hälfte der gesamten, 425 Monate langen Periode mit Satellitenaufzeichnungen.

Ø Die höchste auf ein Jahrhundert umgerechnete Erwärmungsrate war in Mittelengland von 1663 bis 1762 mit einer Rate von 0,9°C aufgetreten – vor der industriellen Revolution. Es kann also nicht unsere Schuld gewesen sein.

Ø Der globale Erwärmungstrend seit 1900 ist äquivalent zu 0,8°C pro Jahrhundert. Dies liegt deutlich innerhalb der natürlichen Variabilität und wird nicht viel mit uns zu tun haben.

Ø Der höchste Erwärmungstrend über zehn Jahre oder mehr ereignete sich in den 40 Jahren von 1694 bis 1733 in Mittelengland – mit einer Rate äquivalent zu 4,3°C pro Jahrhundert.

Ø Seit 1950, als ein menschlicher Einfluss auf die globale Temperatur zum ersten Mal theoretisch möglich war, lag der globale Erwärmungstrend äquivalent zu 1,2°C pro Jahrhundert.

Ø Die höchste Erwärmungsrate über zehn Jahre oder mehr seit 1950 ereignete sich während der 33 Jahre von 1974 bis 2006. Die Rate war äquivalent zu 2,0°C pro Jahrhundert.

Ø Im Jahre 1990 lautete die mittelfristige Schätzung des Erwärmungstrends äquivalent zu 2,8°C pro Jahrhundert, also um zwei Drittel über der heutigen IPCC-Vorhersage.

Ø Der globale Erwärmungstrend seit 1990, als das IPCC seinen ersten Bericht geschrieben hatte, ist äquivalent zu einer Rate von 1,4°C pro Jahrhundert – die Hälfte von dem, was das IPCC zu der Zeit vorhergesagt hatte.

Ø Im Jahre 2013 lautete die neue mittelfristige Vorhersage des IPCC auf eine Rate äquivalent zu 1,7°C pro Jahrhundert. Aber auch das ist noch übertrieben.

Ø Obwohl des IPCC seine kurzfristige Erwärmungs-Vorhersage zurückgefahren hat, ist dessen Vorhersage einer Erwärmung von 4,7°C bis zum Jahr 2100 weiterhin Business as Usual.

Ø Diese vom IPCC vorhergesagte Erwärmung von 4,7°C bis zum Jahr 2100 liegt mehr als doppelt so hoch wie der höchste beobachtete Erwärmungstrend in der realen Atmosphäre über zehn Jahre, der seit 1950 gemessen worden ist.

Ø Die IPCC-Vorhersage von 4,7°C bis zum Jahr 2100 liegt fast vier mal so hoch wie der beobachtete Erwärmungstrend in der realen Welt, seit wir theoretisch in der Lage gewesen sein könnten, die Temperatur zu beeinflussen (1950).

Ø Seit dem 1. Januar 2001, dem Beginn des neuen Jahrtausends, ist der Erwärmungstrend im Mittel von 5 Datensätzen Null. Keine Erwärmung seit 13 Jahren und vier Monaten.

Ø Jüngste Extremwetterereignisse können nicht mit der globalen Erwärmung in Verbindung gebracht werden, einfach weil es keine Erwärmung gegeben hat. So einfach ist das.

Technische Anmerkung

Die jüngste Graphik zum Thema zeigt der RSS-Datensatz während der 213 Monate seit September 1996 bis Mai 2014 – über die Hälfte der 425 Monate langen Überwachung per Satellit.

Terrestrische Temperaturen werden mit Thermometern gemessen. Thermometer, die korrekt aufgestellt sind in ländlichen Gebieten und weit weg von menschlichen Wärmequellen zeigen Erwärmungsraten deutlich unter denen, die veröffentlicht werden. Die Satellitendaten basieren auf Messungen durch die genauesten derzeit verfügbaren Thermometer – Platin-Widerstands-Thermometer, die nicht nur die Temperaturen in verschiedenen Höhen über der Erdoberfläche mittels Mikrowellen-Sounding messen, sondern sich auch ständig selbsttätig kalibrieren durch die Messung der bekannten Temperatur der kosmischen Hintergrundstrahlung via auf das Weltall ausgerichtete Spiegel. Sie macht 1% des Gefrierpunktes von Wasser aus bzw. liegt nur 2,73° über dem absoluten Nullpunkt. Es war die Messung dieser minimalen Variationen der kosmischen Hintergrundstrahlung, durch die die NASA das Alter des Universums bestimmt hat: 13,82 Milliarden Jahre.

Die Graphik ist akkurat. Die Daten stammen monatlich direkt von der RSS-Website. Ein Computer-Algorithmus liest sie aus dem File heraus, mittelt sie und plottet sie automatisch mittels einer ausgereiften Routine. …

Der jüngste monatliche Datenpunkt wird durch Augenschein inspiziert um sicherzustellen, dass er korrekt positioniert ist. Die hellblaue Trendlinie durch die dunkelblaue Kurve der einzelnen Datenpunkte zeigt, dass die aktuellen Daten bestimmt werden durch die Methode der linearen Regression kleinster Quadrate, die den Schnittpunkt mit der y-Achse berechnet sowie die Steigung der Linie mittels zwei etablierten und funktional identischen Gleichungen, die miteinander verglichen werden um sicherzustellen, dass es zwischen ihnen keine Diskrepanz gibt. Das IPCC und die meisten anderen Agenturen berechnen mittels linearer Regression globale Temperaturtrends. Prof. Phil Jones von der University of East Anglia verlangt dies in einer der Klimagate-E-Mails. Die Methode ist geeignet, weil die globalen Temperaturaufzeichnungen nur wenig Auto-Regression zeigen.

Dr. Stephen Farish, Professor für epidemiologische Statistik an der University of Melbourne hat freundlicherweise die Zuverlässigkeit des Algorithmus‘ verifiziert, der den Trend in der Graphik und den Korrelations-Koeffizienten bestimmt. Er ist sehr klein, weil trotz der hoch variablen Daten der Trend flach ist.

Link: http://wattsupwiththat.com/2014/06/04/the-pause-continues-still-no-global-warming-for-17-years-9-months/

Übersetzt von Chris Frey EIKE