scienceofdoom

In Teil VII haben wir eine Reihe von Studien aus den Jahren 1989 bis 1994 betrachtet. Diese haben versucht, mittels GCMs eine „Eiszeit beginnen zu lassen“. Die Entwicklung der „voranschreitenden Klimawissenschaft“ war dabei folgende:

1. Hinweise zu finden, dass das Timing des Beginns einer Eiszeit verbunden war mit der Umverteilung solarer Einstrahlung infolge orbitaler Änderungen – möglicherweise mit einer reduzierten sommerlichen Einstrahlung in hohen Breiten (Hays et al. 1976 – siehe Teil III).

2. Die Verwendung einfacher Energiebilanz-Modelle, um zu zeigen, dass hinter den plausiblen Überlegungen auch etwas Physik steckt (In Teil VI – Gewimmel von Hypothesen haben wir einige plausible Ideen kennengelernt).

3. Verwendung eines GCM (global circulation model) mit Anfangsbedingungen wie sie vor etwa 115.000 Jahren vorlagen, um zu sehen, ob man eine „nicht mehr verschwindenden Schneedecke“ in hohen Breiten erhält, die zuvor während der letzten Zwischeneiszeit nicht schneebedeckt waren – d. h. können wir eine neue Eiszeit beginnen lassen?

Warum brauchen wir ein komplexeres Modell, wenn doch schon ein Energiebilanzmodell „funktioniert“, d. h. eine andauernde Schneedecke erzeugen kann, um eine neue Eiszeit beginnen zu lassen? Wie Rind et al. 1989 in ihrer Studie schreiben:

Verschiedene Energiebilanz-Klimamodelle wurden verwendet, um abzuschätzen, wie groß die Abkühlung im Zuge veränderter orbitaler Parameter wäre. Mit einer geeigneten Anpassung der Parameter, von denen einige aufgrund von Beobachtungen gerechtfertigt sind, kann man die Modelle dazu bringen, die großen eiszeitlichen/zwischeneiszeitlichen Klimaänderungen zu simulieren. Allerdings rechnen diese Modelle nicht mit den Prinzipien all der verschiedenen Einflüsse auf die Lufttemperatur, die wir oben beschrieben haben, und sie enthalten auch keinen hydrologischen Zyklus, welcher es gestatten würde, eine Schneedecke entstehen oder sich ausweiten zu lassen. Die tatsächlichen Prozesse, die es einer Schneedecke gestatten, auch im Sommer bestehen zu bleiben, werden komplexe hydrologische und thermische Einflüsse enthalten, für welche einfache Modelle lediglich grobe Annäherungen bieten können.

Interessanterweise hat also der Schwenk zu komplexeren Modellen mit besser aufgelöster Physik gezeigt, dass es hinsichtlich des Beginns einer Eiszeit in Klimamodellen Probleme gibt. Das waren aber auch noch frühe GCMs mit begrenzter Rechenleistung. In diesem Artikel wollen wir die Ergebnisse von etwa einem Jahrzehnt später betrachten.

Überblick

Wir beginnen mit zwei Studien, die exzellente Überblicke des „Problems bis hier“ enthalten. Eine stammt von Yoshimori et al. (2002) und die andere von Vettori & Peltier (2004). Zu Ersterer:

Eine der fundamentalen und herausfordernden Dinge bei der Modellierung des Paläoklimas ist das Scheitern, den Beginn der letzten Eiszeit zu erfassen (Rind et al. 1989). In einem Zeitraum von vor 118.000 und 110.000 Jahren sank der Meeresspiegel rapide um 50 bis 80 Meter, verglichen mit der letzten Zwischeneiszeit, in der der Meeresspiegel nur 3 bis 5 Meter höher lag als heute. Dieses Absinken des Meeresspiegels macht etwa die Hälfte des letzten eiszeitlichen Maximums aus. Und der Beginn der letzten Vereisung bietet einen von nur wenigen wertvollen Testbereichen zur Validierung von Klimamodellen, vor allem der atmospheric general circulation models (AGCMs). Hierzu wurden viele Studien durchgeführt.

Phillipps & Held (1994) sowie Gallimore & Kutzbach (1995) haben eine Reihe von numerischen Sensitivitäts-Experimenten im Hinblick auf orbitale Parameter durchgeführt, indem sie mehrere extreme orbitale Konfigurationen durchspielten. Darunter befand sich ein Fall mit geringerer Neigung und kleinerem Perihel im Winter der Nordhemisphäre, was zu einem kühleren Sommer führte. Beide Studien kamen zum gleichen Ergebnis: Obwohl eine kühle sommerliche orbitale Konfiguration die besten Bedingungen für die Entwicklung permanenten Schnees und die Ausdehnung von Gletschern bietet, kann der orbitale Antrieb allein nicht für die permanente Schneebedeckung in Nordamerika und Europa verantwortlich sein.

Dieses Ergebnis wurde von Mitchell (1993), Schlesinger & Verbitsky (1996) sowie Vavrus (1999) bestätigt. Schlesinger & Verbitsky (1996) haben ein Eisschild – Asthenosphäre*-Modell mit einem AGCM-Output integriert und herausgefunden, dass eine Kombination von orbitalem Antrieb und Treibhaus-Antrieb durch reduziertes CO2 und CH4 ausreichend waren, um Zentren von Eisschilden in Nordeuropa und Amerika zu erhalten. Allerdings betrug das simulierte Eisvolumen nur etwa 31% der aus den Proxy-Werten abgeleiteten Schätzung.

[*Asthenosphäre: (griech.: asthenia = Schwäche). Die zwischen 100-200km

mächtige "schwache" oder "weiche" Zone der Erde im Oberen Erdmantel

unterhalb der Litosphäre. Mehr dazu siehe hier]

Mittels eines höher auflösenden Modells haben Dong & Valdes (1995) das Wachstum permanenter Schneedecken unter einer Kombination orbitaler und CO2-Antriebe simuliert. Ebenso wie in der Auflösung ihres Modells bestand ein weiterer wichtiger Unterschied zwischen ihrem Modell und anderen in Gestalt einer „umgebenden Orographie“ (d. h. sie haben mit der Höhe des Landes herumgespielt). Sie fanden dabei heraus, dass die Änderungen der Wassertemperatur infolge orbitaler Einflüsse eine sehr wichtige Rolle bei der Entstehung der Eisschilde in Nordamerika und Fennoskandien spielten.

Anmerkung zum letzten Abschnitt: es ist wichtig zu verstehen, dass diese Studien mit einem Atmosphäre-GCM durchgeführt worden sind und nicht mit einem Atmosphäre-Ozean-GCM – d. h. mit einem Modell der Atmosphäre mit einigen vorgegebenen Wassertemperaturen (diese könnten aus einem separaten Lauf eines einfacheren Modells stammen oder aus Werten, die aus Proxys berechnet wurden). Die Autoren kommentieren dann den potentiellen Einfluss auf die Vegetation wie folgt:

Die Rolle der Vegetation am Beginn einer Vereisung wurde von Gallimore & Kutzbach (1996), de Noblet et al. (1996) sowie Pollard und Thompson (1997) untersucht. Gallimore & Kutzbach integrierten ein AGCM mit einem Mixed Layer Ozean-Modell mit fünf verschiedenen Antrieben: 1) Kontrolle, 2) orbital, 3) Punkt 2 plus CO2, 4) Punkt 3 plus Ausdehnung der Tundra um 25% (basierend auf einer Studie von Harrison et al. (1995) und 5) Punkt 4 plus eine weitere Ausdehnung der Tundra um 25%. Dem Effekt der Ausdehnung der Tundra durch ein vegetation-snow masking feedback näherte man sich durch Zunahme des Anteils der Schneebedeckung. Und nur im letzten Fall konnte man eine andauernde Schneedecke sehen.

Pollard & Thompson (1997) führten ebenfalls ein interaktives Vegetations- und AGCM-Experiment durch sowohl mit orbitalem als auch mit CO2-Antrieb. Außerdem integrierten sie ein dynamisches Eisschilde-Modell. Sie integrierten weiterhin ein Eisflächen-Modell über 10.000 Jahre. Darin gingen die die Massenbilanz ein, welche vom AGCM-Ergebnis abgeleitet wurde. Dies wiederum erfolgte mit einem Vielschichten-Eisschild-Oberflächen-Säulen-Modell auf dem Gitternetz des dynamischen Eisflächen-Modells, welches den Effekt von gefrierendem Regen und Schmelzwasser beinhaltete. Obwohl ihr Modell das Wachstum eines Eisschildes über der Baffin-Insel und dem kanadischen Archipel vorhersagte, sagte es auch eine viel schnellere Wachstumsrate in Nordwestkanada und Alaska voraus. Keine dauerhafte Schneedecke fand sich in Keewatin oder Labrador (d. h. an den falschen Stellen). Außerdem war die Rate der Zunahme des Eisvolumens über Nordamerika um eine Größenordnung niedriger als aus Proxys geschätzt.

Sie schließen daraus:

Es ist schwierig, die Ergebnisse dieser früheren Studien zu synthetisieren, weil jedes Modell unterschiedliche Parametrisierungen ungelöster physikalischer Prozesse verwendet hat, unterschiedliche Auflösung hatte und auch noch unterschiedliche Kontroll-Klimate ebenso wie das experimentelle Design.

Zusammenfassend stellen sie fest: die Ergebnisse bis heute zeigen, dass weder orbitale Antriebe allein noch CO2 allein den Beginn einer Vereisung erklären können. Ferner sind die kombinierten Auswirkungen nicht konsistent. Die Schwierigkeit besteht in der Frage, ob dies auf die unzureichende Gitter-Auflösung des Modells oder auf Rückkopplungen aus der Biosphäre (Vegetation) zurückzuführen ist.

Ein paar Jahre später gaben dann Vettoretti & Peltier (2004) eine gute Übersicht zu Beginn ihrer Studie:

Ursprüngliche Versuche, ein größeres Verständnis der Natur von Eiszeit-Zwischeneiszeit-Zyklen zu erhalten, involvierten Studien, die auf einfachen Energiebilanz-Modellen (EBMs) basierten, die direkt auf die Simulation einer andauernden Schneedecke ausgerichtet waren unter Einfluss von angemessen modifizierten orbitalen Antrieben (z. B. Suarez und Held 1979). inzwischen wurden Analysen entwickelt, dass die gegenwärtig gebräuchlichen Modelle des Klimasystems explizit die Kopplung von Eisschilden zu den EBM enthalten müssen oder an vollständigere AGCMs der Atmosphäre ankoppeln sollen.

Die zuletzt entwickelten Modelle des vollständigen Zyklus’ über 100.000 Jahre haben sich bis zu einem Punkt entwickelt, an dem drei Modellkomponenten miteinander verbunden worden sind. Einmal ein EBM der Atmosphäre unter Einschluss der Eis-Albedo-Rückkopplung sowohl von Schnee an Land als auch Eis auf dem Meer, ein Modell der globalen Glaziologie, in dem die Eisschilde zum Wachsen und Schrumpfen gebracht werden durch meteorologisch gesteuerte Änderungen in der Massenbilanz und ein Modell der glazialen isostatischen Justierung, durch welchen Prozess die Höhe des Eisschildes unterdrückt oder erhöht werden kann, abhängig davon, ob Akkumulation oder Abtragung dominant ist.

Derartige Modelle wurden auch verwendet, um die Schlüsselrolle zu untersuchen, die Variationen des atmosphärischen Kohlendioxids im 100.000-Jahres-Zyklus spielen, vor allem beim Übergang aus einem eiszeitlichen Zustand (Tarasov und Peltier 1997, Shackleton 2000). Da diese Modelle hinsichtlich der Computerressourcen ziemlich effizient sind, die man hier braucht, sind sie in der Lage, die große Zahl von Eiszeit/Zwischeneiszeit-Zyklen zu simulieren. Dies ist erforderlich, um die Modell-Sensitivitäten zu verstehen.

Es gab innerhalb der modellierenden Zunft eine Bewegung, auch Modelle zu benutzen, die derzeit als earth models of intermediate complexity (EMICs) bezeichnet werden und die Sub-Komponenten enthalten, die nicht so raffiniert sind im Vergleich zu den gleichen Komponenten in modernen globalen Klimamodellen (GCMs). Diese EMICs versuchen, Repräsentationen der meisten Komponenten im realen System Erde einzuschließen, darunter die Atmosphäre, die Ozeane, die Cryosphäre und die Biosphäre bzw. der Kohlenstoffzyklus (z. B. Claussen 2002). Derartige Modelle haben nützliche Einsichten in die langzeitliche Klima-Variabilität geliefert und werden das auch weiterhin tun, indem sie es ermöglichen, eine große Zahl von Sensitivitäts-Studien durchzuführen. Damit soll die Rolle zahlreicher Rückkopplungs-Mechanismen untersucht werden, die aus der Wechselwirkung zwischen den Komponenten resultieren, die das Klimasystem ausmachen (z. B. Khodri et al. 2003).

Dann kommentieren die Autoren die gleichen Studien und Themen, die von Yoshimori et al. behandelt worden sind und fügen ihre eigene Studie aus dem Jahr 2003 sowie eine weitere Studie hinzu. Zu ihrer eigenen Forschung schreiben sie:

Vettoretti und Peltier (2003a) haben in jüngerer Zeit gezeigt, dass es einer neu kalibrierten Version des CCCma AGCM2 zu einer permanenten Schneebedeckung allein als Konsequenz orbitaler Antriebe kommt, wenn die atmosphärische CO2-Konzentration auf einem Niveau entsprechend der vorindustriellen Zeit fest gehalten wird. Diese erhält man durch Messungen der Luftbläschen, die im Vostok-Eisbohrkern eingeschlossen waren (Petit et al. 1999).

Die AGCM-Simulation zeigte, dass sich eine permanente Schneedecke in hohen nördlichen Breiten bildet ohne die Notwendigkeit der Berücksichtigung irgendwelcher Rückkopplungen durch Vegetation oder anderer Effekte. In dieser Arbeit wurde der Prozess des Beginns der Vereisung analysiert, und zwar mit drei Modellen, die drei verschiedene Kontrollklimata enthalten. Das waren jeweils das CCCma cold biased Modell, ein neu konfiguriertes Modell, das so modifiziert wurde, dass es "unbiased" aussieht, und ein Modell dass zur Wärme hin "gebiased" war hinsichtlich des modernen Satzes von AMIP2-Wassertemperaturen (Anmerkung: Bias = Tendenz, Verzerrung, Voreingenommenheit). Vettoretti und Peltier (2003b) zeigten eine Anzahl neuer Feedback-Mechanismen, die für die Ausweitung einer permanenten Schneebedeckung wichtig sind.

Im Einzelnen zeigte diese Arbeit, dass allmählich kälter werdende Klimata den Feuchtetransport in Regionen zunehmen ließen, die für den Beginn einer Vereisung empfänglich sind, und zwar durch verstärkte barokline Wirbelaktivität in mittleren und hohen Breiten. Um dieses Phänomen quantitativ abzuschätzen, wurde eine detaillierte Untersuchung zu Änderungen der Feuchtigkeits-Balance-Gleichung unter orbitalen Antrieben bzgl. der arktischen Eiskappe vor 116.000 Jahren durchgeführt. Ebenso wie die Aktivität einer „cryosphärischen Feuchtepumpe“ zu zeigen, schlugen die Autoren auch vor, dass die zonale Asymmetrie beim Beginn des Prozesses in hohen Breiten geologischen Beobachtungen zufolge eine Konsequenz zonal heterogener Zu- und Abnahmen des nordwärts gerichteten Transportes von Wärme und Feuchtigkeit ist.

Und sie fahren fort, andere Studien zu beleuchten, deren Betonung auf polwärts gerichteten Transporten von Feuchtigkeit liegt. Wir wollen jetzt einige Arbeiten aus jener Periode vorstellen.

Neuere Arbeiten mit GCMs

Yoshimori et al. 2002: Deren Modelle waren ein AGCM (atmosphärisches GCM) mit orbitalen Bedingungen vor 116.000 Jahren sowie Wassertemperaturen a) heute und b) vor 116.000 Jahren. Außerdem ein anderer Modelllauf mit obigen Bedingungen und veränderter Vegetation basierend auf der Temperatur (liegt die Sommertemperatur unter -5°C, wird der Vegetationstyp zu Tundra geändert). Weil ein „vollständig gekoppeltes“ GCM (Atmosphäre und Ozean) über einen langen Zeitraum zu viel Rechenleistung erforderte, wurde ein Kompromiss gewählt.

Die Wassertemperaturen wurden berechnet mittels eines mittelkomplexen Modells, einem einfachen atmosphärischen Modell und einem vollständigen Ozean-Modell (einschließlich Meereis) – und mit einem Modelllauf über 2000 Jahre (Ozeane haben viel thermisches Beharrungsvermögen). Die Details hierzu werden in Abschnitt 2.1 ihrer Studie beschrieben. Der Gedanke dahinter ist, Oberflächen-Wassertemperaturen (SST) zu erhalten, die mit Ozean und Atmosphäre konsistent sind.

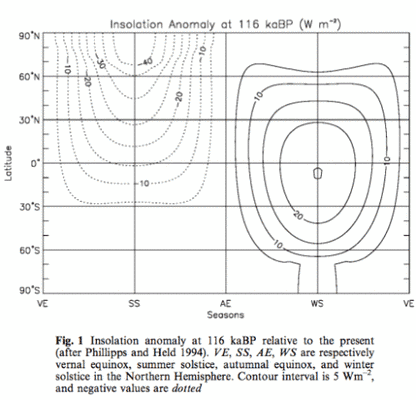

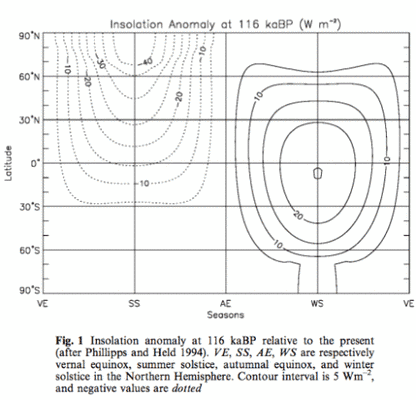

Die Wassertemperaturen werden dann als Randwertbedingungen benutzt für einen „ordentlichen“ GCM-Lauf über 10 Jahre – dies wird in Abschnitt 2.2 ihrer Studie beschrieben. Die Einstrahlungs-Anomalie (insulation anomaly) mit Bezug zum heutigen Tag:

Abbildung 1. Einstrahlungs-Anomalie vor 116.000 Jahren relativ zu heute (nach Phillipps und Held 1994). Die Bezeichnungen VE, SS, AE und WS stehen für Frühjahrs-Tag-und-Nacht-Gleiche, Sommersonnenwende, Herbst-Tag-und-Nacht-Gleiche sowie Wintersonnenwende auf der Nordhemisphäre. Das Intervall der Isolinien beträgt 5 W/m², und negative Werte sind gepunktet.

Sie geben für die Zeit vor 116.000 Jahren eine CO2-Konzentration von 240 ppm vor, ist dies doch „das niedrigst mögliche äquivalente CO2-Niveau“ (eine Kombination von CO2- und CH4-Antrieben). Dies gleicht einer Reduktion des Strahlungsantriebs um 2,2 W/m². Die vom ursprünglichen Modell berechneten Wassertemperaturen sind global um 1,1°C niedriger, verglichen mit den heutigen modellierten Werten. Dies liegt nicht an der Strahlungs-Anomalie, die die Sonnenenergie lediglich „umverteilt“, sondern an der geringeren atmosphärischen CO2-Konzentration. Die Wassertemperatur vor 116.000 Jahren im Nordatlantik lag um etwa 6°C niedriger. Dies ist dem niedrigen Einstrahlungswert im Sommer plus einer Reduktion im MOC geschuldet. Die Ergebnisse ihrer Arbeit:

● Mit heutigen Werten der Wassertemperatur sowie orbitalen und CO2-Werten von vor 116.000 Jahren gibt es eine kleine Ausdehnung der permanenten Schneebedeckung.

● Mit berechneten Werten der Wassertemperatur, orbitalen und CO2-Werten, alle vor 116.000 Jahren, ergibt sich eine große Ausdehnung permanenter Schneebedeckung in Nord-Alaska, Ostkanada und einigen anderen Gebieten.

● Mit hinzugefügten Änderungen der Vegetation (Tundra) breitet sich die permanente Schneebedeckung nördlich von 60° noch weiter aus

Sie kommentieren, gestützt durch Graphiken, dass eine größere Schneebedeckung teils durch geringere Schneeschmelze, aber auch teils durch stärkeren Schneefall entstehen kann. Dies ist selbst dann der Fall, wenn kältere Temperaturen im Allgemeinen für weniger Niederschlag sprechen.

Im Gegensatz zu früheren Eiszeit-Hypothesen zeigen unsere Ergebnisse, dass die Erfassung des Beginns einer Vereisung vor 116.000 Jahren „kühlere“ Wassertemperaturen erfordert als sie heute vorhanden sind. Auch zeigt der große Einfluss von Änderungen der Vegetation auf das Klima, dass die Einbeziehung der Vegetations-Rückkopplung wichtig ist für die Modell-Validierung, zumindest in diesem speziellen Zeitraum der Erdgeschichte.

Was wir nicht herausfanden ist, warum ihr Modell permanente Schneebedeckung erzeugt (selbst ohne Änderungen der Vegetation), wo frühere derartige Versuche das nicht gezeigt haben. Was nicht erwähnt worden zu sein scheint ist, dass zu den notwendigen Bedingungen kältere Wassertemperaturen gehören, induziert durch einen viel geringeren atmosphärischen CO2-Gehalt. Ohne den niedrigeren CO2-Gehalt kann dieses Modell keine Eiszeit beginnen lassen. Zusätzlich sagen Vettoretti & Peltier 2004 zu dieser Studie:

Die Bedeutung dieser Ergebnisse bleibt jedoch abzuwarten, da das ursprüngliche CCCma AGCM2-Modell in hohen Breiten hin zu kälteren Temperaturen "gebiased" und empfindlich auf den niedrigen CO2-Wer istt, der den Simulationen zugrunde liegt.

Vettoretti & Peltier 2003

Auf diese Studie beziehen sie sich in ihrer eigenen Arbeit von 2004. Diese Simulation zeigt, dass der Eintritt in eiszeitliche Bedingungen vor 116.000 Jahren nur die Einführung orbitaler Einstrahlung der Nach-Eemian-Zeit und standardmäßige vorindustrielle CO2-Werte erfordert.

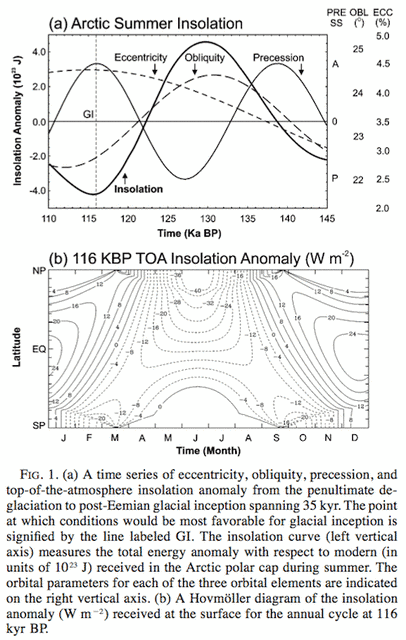

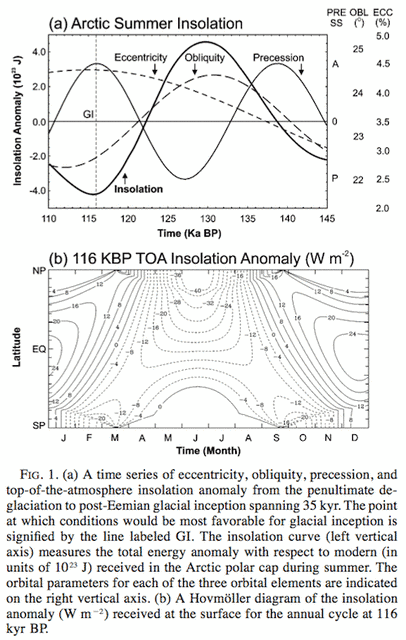

Im folgenden Bild sind die jahreszeitlichen und breitenabhängigen Variationen der solaren Einstrahlung an der Obergrenze der Atmosphäre TOA im Vergleich von vor 116.000 Jahren und heute gezeigt:

Abbildung 2: (a) Eine Zeitreihe der Exzentrizität, der Neigung, der Präzession und der Einstrahlungs-Anomalie an der Obergrenze der Atmosphäre vom vorletzten Abschmelzen bis zum Beginn der neuen Vereisung in der Nach-Eemian-Zeit [ein Zeitraum von 35.000 Jahren]. Der Punkt, an dem die Bedingungen für den Beginn einer Vereisung am günstigsten sind, wird durch die Linie mit der Bezeichnung GI gekennzeichnet. Die Einstrahlungskurve (linke vertikale Achse) misst die Gesamt-Energieanomalie im Vergleich zu heute (Einheit 10↑23 J), und zwar über der arktischen Eiskappe im Sommer. Die Orbital-Parameter für jedes der drei orbitalen Elemente sind auf der rechten vertikalen Achse aufgetragen. (b) Ein Hovmöller-Diagramm der Einstrahlungs-Anomalie (W/m²) an der Oberfläche für den jährlichen Zyklus vor 116.000 Jahren.

Aus Vettoretti & Peltier 2003

Kernpunkt ihres Modelltests war: sie nahmen ein atmosphärisches GCM gekoppelt mit festgesetzten Werten der Wassertemperatur – für drei verschiedene Datensätze – mit orbitalen und Treibhausgas-Bedingungen von vor 116.000 Jahren. Damit wollten sie herausfinden, ob sich eine permanente Schneebedeckung ergibt und wo:

Die drei Experimente der Zeit vor 116.000 Jahren zeigten, dass der Beginn einer Vereisung in zwei der drei Simulationen mit diesem Modell erfolgreich war. Das "warm-bias" Experiment erzeugte keine permanente Schneebedeckung in der Arktis außer im zentralen Grönland.

Das "kalt-bias" Experiment erzeugte in weiten Gebieten der Arktis nördlich von 60°N eine permanente Schneebedeckung. Starke Akkumulationen zeigten sich im kanadischen Archipel sowie in Ost- und Zentralsibirien. Die Akkumulation in Ostsibirien scheint exzessiv zu sein, da es kaum Beweise gibt, dass Ostsibirien jemals in einen Eiszeitzustand gelangte. Die Verteilung der Akkumulation in diesem Gebiet ist möglicherweise das Ergebnis exzessiver Niederschläge in der modernen Simulation.

Sie kommentieren weiter:

Alle drei Simulationen sind charakterisiert durch exzessive Sommerniederschläge über den meisten polaren Landgebieten. Ebenso zeigt ein Plot des jährlichen Mittleren Niederschlags in dieser Region des Globus‘, dass das CCCma-Modell im Gebiet der Arktis allgemein "nass-bias" ist. Früher wurden bereits gezeigt, dass das CCCma GCMII-Modell ebenfalls einen hydrologischen Zyklus hat, der stärker ist als beobachtet (Vettoretti et al. 2000b).

Es ist unklar, wie stark die Modell-Bias des exzessiven Niederschlags auch ihr Ergebnis der Schnee-Akkumulation in den „richtigen“ Gebieten beeinflusst. Im Teil II ihrer Studie graben sie sich in Details der Änderungen von Verdunstung, Niederschlag und Feuchtetransport in das arktische Gebiet.

Crucifix & Loutre 2002

Diese Studie (und die Folgende) verwendete ein EMIC – ein intermediate complexity model – welches ein Modell mit einer gröberen Auflösung und einfacherer Parametrisierung ist und deshalb auch viel schneller rechnet. Das erlaubt die Durchführung vieler unterschiedlicher Simulationen über viel längere Zeiträume, als es mit einem GCM möglich ist. Die EMICs sind auch in der Lage, Biosphäre, Ozean, Eisschilde und Atmosphäre zu koppeln – während den GCM-Läufen nur ein atmosphärisches GCM mit einer bestimmten Methode der Festsetzung von Wassertemperaturen zugrunde lag.

In dieser Studie geht es um die Klimaänderung in den hohen nördlichen Breiten während der letzten Zwischeneiszeit (von vor 126.000 Jahren bis vor 115.000 Jahren) unter Verwendung des earth system model of intermediate complexity ‘‘MoBidiC’’.

Zwei Reihen von Sensitivitäts-Experimenten wurden durchgeführt, um a) die jeweilige Rolle unterschiedlicher Rückkopplungen im Modell und b) die jeweiligen Auswirkungen von Neigung und Präzession zu bestimmen. MoBidiC enthält Repräsentationen der atmosphärischen Dynamik, der Ozean-Dynamik, Meereis und Vegetation. Eine Gesamtzahl von zehn numerischen Experimenten wird hier gezeigt. Das Modell simuliert wichtige Umweltänderungen in hohen nördlichen Breiten vor dem Beginn der letzten Vereisung, d. h.: a) eine mittlere jährliche Abkühlung um 5°C hauptsächlich im Zeitraum von vor 122.000 und 120.000 Jahren; b) eine Südverlagerung der nördlichen Baumgrenze um 14 Breitengrade; c) Akkumulation einer permanenten Schneedecke mit Beginn vor etwa 122.000 Jahren und d) ein graduelles Auftauchen von permanentem Meereis in der Arktis.

Die Reaktion der borealen Vegetation ist ein ernsthafter Kandidat, um den orbitalen Antrieb signifikant zu verstärken und den Beginn einer Vereisung auszulösen. Das Grundkonzept ist, dass in einem großen Gebiet ein Schneefeld eine viel höhere Albedo zeitigt als Gras oder Tundra (etwa 0,8) oder Wald (0,4).

Es muss angemerkt werden, dass die planetare Albedo auch bestimmt wird durch den Reflexionsgrad der Atmosphäre und im Besonderen durch die Wolkenbedeckung. Allerdings ist trotz der im MoBidiC geforderten Wolken die Oberflächen-Albedo definitiv der Haupttreiber planetarer Albedo-Änderungen.*

In ihrer Zusammenfassung schreiben sie:

In hohen Breiten simuliert MoBidiC eine jährliche mittlere Abkühlung von 5°C über den Kontinenten und eine Abnahme von 0,3°C der Wassertemperatur. Die Abkühlung ist hauptsächlich verbunden mit einer Abnahme der kurzwelligen Strahlungsbilanz an der Obergrenze der Atmosphäre um 18 W/m², teils kompensiert durch eine Zunahme von 15 W/m² in der atmosphärischen meridionalen Wärmetransport-Divergenz.

Die Änderungen werden hauptsächlich durch astronomische Antriebe ausgelöst, aber durch Meereis, Schnee und Rückkopplungen der Albedo durch Vegetation fast vervierfacht. Die Effizienz dieser Rückkopplungen wird verstärkt durch Synergien, die zwischen ihnen stattfinden. Die kritischste Synergie involviert Schnee und Vegetation und führt zu dauerhaftem Schnee nördlich von 60°N, beginnend vor 122.000 Jahren. Die Temperatur-Albedo-Rückkopplung ist auch verantwortlich für eine Beschleunigung des Abkühlungstrends in der Zeit von vor 122.000 Jahren bis vor 120.000 Jahren. Diese Beschleunigung wird nur nördlich von 60°N simuliert und fehlt in niedrigeren Breiten.

Siehe Fußnote 2 für Details des Modells. Dieses Modell weist eine Kalt-Bias bis zu 5°C im Winter in den hohen Breiten auf.

Calov et al. 2005

Wir untersuchen die Mechanismen des Beginns einer Vereisung mit dem Erde-System-Modell mittlerer Komplexität CLIMBER-2, welches dynamische Module der Atmosphäre, der Ozeane, der Biosphäre und der Eisschilde umfasst. Die Dynamik der Eisschilde wird durch das dreidimensionale polythermische Eisschild-Modell SICOPOLIS beschrieben. Wir haben transparente numerische Experimente durchgeführt, und zwar beginnend mit dem Eemian-Interglazial vor 126.000 Jahren. Das Modell läuft über 26.000 Jahre mit zeitabhängigen orbitalen und CO2-Antrieben.

Das Modell simuliert eine rapide Ausdehnung der mit Inlandeis bedeckten Gebiete der Nordhemisphäre, vor allem über Nordamerika, die vor 117.000 Jahren begonnen hatte. Während der folgenden 7000 Jahre ist das Eisvolumen im Modell graduell gestiegen, und zwar mit einer Rate, die mit einer Änderung der Höhe des Meeresspiegels um 10 m pro Millenium korrespondiert.

Wir haben gezeigt, dass der simulierte Beginn der Vereisung einen Bifurkations-Übergang im Klimasystem repräsentiert, und zwar von einem zwischeneiszeitlichen Zustand in einen eiszeitlichen Zustand, verursacht durch die starke Schnee-Albedo-Rückkopplung. Dieser Übergang erfolgt, wenn die sommerliche Einstrahlung in hohen Breiten der Nordhemisphäre unter einen bestimmten Wert fällt, der nur geringfügig niedriger liegt als die heutige sommerliche Einstrahlung (Bifurkation ist ein Begriff der Chaos-Therie).

Die Durchführung langzeitlicher Gleichgewichts-Läufe zeigt, dass es für die heutigen orbitalen Parameter mindestens zwei unterschiedliche Gleichgewichts-Zustände des Klimasystems gibt – den eiszeitlichen und den zwischeneiszeitlichen Zustand. Für die geringe sommerliche Einstrahlung vor 115.000 Jahren finden wir jedoch nur einen eiszeitlichen Gleichgewichts-Zustand, während in dem Modell bei starker Einstrahlung vor 126.000 Jahren nur ein zwischeneiszeitlicher Zustand existiert.

Durch die grobere Gitter-Auflösung des EMIC bekommen wir eine gewisse Vereinfachung:

Die Atmosphären-, Landoberflächen- und Vegetations-Modelle rechnen mit dem gleichen Gitterpunktsabstand, nämlich 10° Breite und etwa 51° Länge.

Ihr Eisschild-Modell ist wesentlich detaillierter, passen doch etwa 500 „Zellen“ des Eisschildes in 1 Zelle des Landoberflächen-Modells. Sie nehmen auch Stellung zu allgemeinen Problemen (bislang) mit Klimamodellen bei deren Versuch, Eiszeiten zu erzeugen:

Wir spekulieren, dass das Scheitern einiger Klimamodelle bei der erfolgreichen Simulation des Beginns einer Vereisung ihrer zu groben räumlichen Auflösung oder Klima-Bias geschuldet ist, die ihre Werte der sommerlichen Einstrahlung verschieben können. Dies passt mit einem Übergang von einem zwischeneiszeitlichen zu einem eiszeitlichen Klimastatus zusammen, der weit über die realistische Bandbreite orbitaler Parameter hinausgeht.

Ein weiterer wichtiger Faktor, der den Wert des Bifurkations-Übergangs bestimmt, ist die Albedo von Schnee.

In unserem Modell verhindert eine Reduktion der gemittelten Schnee-Albedo um nur 10% das rapide Einsetzen von Vereisung auf der Nordhemisphäre unter jeder orbitalen Konfiguration, die während des Quartiärs aufgetreten war. Die Albedo von Schnee ist in vielen Klimamodellen nur auf sehr grobe Weise parametrisiert und kann unterschätzt werden. Mehr noch, da die Albedo von Schnee stark von der Temperatur abhängt, kann die Unter-Repräsentation höher gelegener Gebiete in einem groben Klimamodell die Schnee-Albedo-Rückkopplung zusätzlich schwächen.

Schlussfolgerung

In diesem Beitrag haben wir ein paar Studien von vor etwa einem Jahrzehnt begutachtet, die frühere Probleme (siehe Teil Sieben) erfolgreich gelöst haben, zumindest vorläufig. Wir haben zwei Studien kennengelernt, die mit Modellen „mittlerer Komplexität“ und grober räumlicher Auflösung den Beginn der letzten Eiszeit simuliert haben. Und wir haben zwei Studien kennengelernt, die GCMs mit vorgegebenen ozeanischen Bedingungen verknüpfen. Diese haben eine permanente Schneebedeckung in kritischen Gebieten vor 116.000 Jahren simuliert.

Definitive Fortschritte

Aber man erinnere sich an die Bemerkung, frühe Energiebilanz-Modelle seien zu dem Ergebnis gekommen, dass es zu einer permanenten Schneebedeckung kommen könnte durch reduzierte sommerliche Einstrahlung in hohen nördlichen Breiten – Unterstützung für die „Milankovitch“-Hypothese. Dann jedoch haben deutlich verbesserte – aber immer noch rudimentäre – Modelle von Rind et al. 1989 sowie Phillipps & Held 1994 gezeigt, dass jene mit einer besseren Physik und einer höheren Auflösung nicht in der Lage waren, diesen Fall zu reproduzieren. Genauso war es mit vielen späteren Modellen.

Wir müssen immer noch ein vollständig gekoppeltes GCM (Atmosphäre und Ozean) betrachten, um zu versuchen, den Beginn einer Eiszeit zu erzeugen. Im nächsten Beitrag werfen wir einen Blick auf eine Anzahl von Studien aus neuerster Zeit einschließlich Jochum et al. (2012):

Bislang jedoch haben es vollständig gekoppelte GCMs nicht geschafft, den Beginn einer Vereisung zu reproduzieren und auch nicht die Abkühlung und die Zunahme der Schnee- und Eisbedeckung, die von warmen Zwischeneiszeiten zu kalten Eiszeitperioden führte.

Das Scheitern der GCMs hinsichtlich der Erzeugung eines Vereisungs-Beginns (siehe Otiento und Bromwich 2009 für eine Zusammenfassung), bedeutet ein Scheitern entweder der GCMs oder der Hypothese von Milankovitch. Natürlich, wenn die Hypothese die Schuldige wäre, müsste man sich fragen, ob man das Klima überhaupt ausreichend genug verstanden hat, um ein GCM zu entwickeln.

Wir werden auch sehen, dass die Stärke von Rückkopplungs-Mechanismen, die zu einer dauerhaften Schneedecke führen, in unterschiedlichen Studien signifikant variiert. Und eines der größten Probleme, mit denen man immer noch konfrontiert wird, ist die erforderliche Rechenleistung.

Zitat aus Jochum (2012):

Dieser experimentelle Aufbau ist natürlich nicht optimal. Idealerweise würde man gerne das Modell des letzten Interglazials vor etwa 126.000 Jahren für 10.000 Jahre in eine Eiszeit mit sich allmählich änderndem orbitalen Antrieb integrieren. Allerdings ist dies nicht machbar; eine 100-jährige Integration von CCSM auf einem NCAR-Supercomputer würde etwa 1 Monat dauern sowie einen substantiellen Teil der Rechenkapazität der Klimagruppe erfordern.

Link: http://scienceofdoom.com/2013/12/27/ghosts-of-climates-past-part-eight-gcm-ii/

Die bisherigen Teile:

Teil I und II: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-i-und-ii/

Teil III: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iii-hays-imbrie-shackleton/

Teil IV: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iv-umlaufbahnen-jahreszeiten-und-mehr/

Teil V: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-v-aenderungen-der-ekliptik-und-der-praezession/

Teil VI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-vi-hypothesen-im-ueberfluss/

Teil VII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-7-global-circulation-models-i/