Wir bleiben am Leben, obwohl unsere Gene einiges aushalten müssen – Teil III

Wären die Menschen böse oder dumm genug, einen Atomkrieg zu entfesseln, gäbe es erheblich schlimmere Dinge, über die man sich Sorgen machen müsste als Strahlung, und zwar sowohl während als auch nach einem solchen Krieg. Die Atombomben des 2. Weltkriegs haben ihre Opfer in genau der gleichen Weise getötet wie andere Bomben. Das Feuer-Bombardement japanischer Städte tötete mehr Menschen und hinterließ eine noch größere Zahl mit schwersten Verbrennungen und großen Schmerzen für immer. Im Jahre 1994 tötete eine simple Machete über eine halbe Million Menschen in Ruanda. Im Vergleich zu fehlenden Gliedmaßen und schrecklichen Verbrennungen waren die Auswirkungen von Strahlen auf die meisten Überlebenden banal. Wir werden später sehen, dass das Krebsrisiko durch Wurst größer ist als das bei einem Überlebenden der Atombombenabwürfe. Die gestiegene Krebsrate in den Überlebenden gab diesen eine mittlere Reduktion der Lebenszeit um etwa zwei Monate (hier) und hatte keinerlei langzeitliche Auswirkungen auf spätere Generationen.

Wenn man zwei Ursachen von Krebs miteinander vergleichen will, zählt man gewöhnlich aufgetretene Fälle oder vielleicht Todesfälle. Etwas, dass Millionen Krebstote zur Folge hat, ist schlimmer als etwas, dass nur 1000 Krebstote fordert. Sich auf das Leiden eines einzelnen Menschen unter diesen tausend zu konzentrieren kann zu einer grausamen, ungerechten und unmoralischen Bereitstellung von Ressourcen weg von Vielen und hin zu Wenigen führen.

Peter, Paul und Mary und die Hymne gegen Kernkraft

Dreißig Jahre des Brandmarkens hat den geringen Anteil von Strahlung an Krankheitsursachen weit über deren Bedeutung hinausgehoben. Die meisten unserer politischen Leithammel einschließlich Bill Clinton, der im Jahre 1994 das US-Programm zur Entwicklung des Integral Fast Reactor IFR vom Tisch gewischt hat, sind in einer Umgebung aufgewachsen, die Strahlung als Gift ansieht. Nunmehr seit Jahrzehnten wurde als die Hymne der Anti-Kernkraft-Bewegung das Lied Power von Peter,_Paul_and_Mary betrachtet einschließlich der vielen Cover-Versionen (eine davon hier bei youtube.com). Es hat einen ironischen Refrain:

Just give me the restless power of the wind

Give me the comforting glow of a wood fire

But please take all of your atomic poison power away.

[etwa:

Gib mir die pausenlose Kraft des Windes / Gib mir das komfortable Glühen eines Holzfeuers / Aber bitte nimm alles atomare Gift hinweg]

Poetischer Wohlklang ist keine Entschuldigung dafür, Unsinn an die vorderste Front zu rücken.

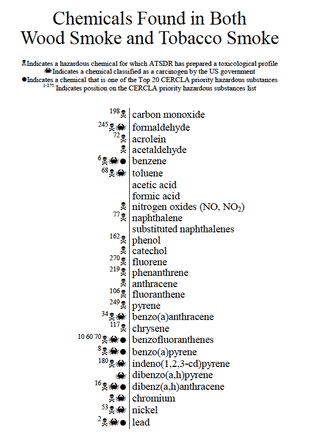

Holzfeuer sind tödlich. Kochfeuer, hauptsächlich aus Holz, manchmal auch getrockneter Dung von Vieh, töten jährlich eine halbe Million Kinder und weitere 3 Millionen Erwachsene (hier). Holzfeuer ist sicher natürlichen Ursprungs. Eine natürliche giftige Suppe von hässlichen natürlichen Chemikalien.

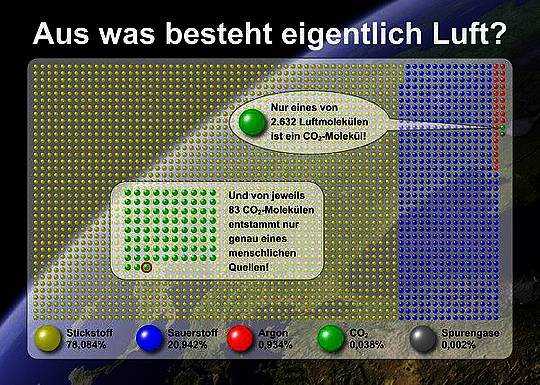

Quelle

Es verursacht COPD … chronische obstruktive Lungenkrankheiten (hier) bei Erwachsenen, und diese Störung führt zu Infektionen, die Kinder ohne Zugang zu medizinischer Hilfe wie in der Ersten Welt töten. Holzrauch ist nicht nur tödlich, sondern Holz ist auch ein Karzinogen der 1. Klasse; genau wie ionisierende Strahlung. „1. Klasse“ bedeutet einfach, dass es vielfach bei Erwachsenen nachgewiesen ist.

Quelle. Weder Holzstaub, Holzrauch oder Strahlung ist ein existenzielles Risiko für die Menschheit, aber Holzrauch ist im Allgemeinen anders als Strahlung für Individuen ziemlich tödlich.

Und dann gibt es da die Holzindustrie. Das ist eine der gefährlicheren auf diesem Planeten. In den achtziger Jahren, als die Anti-Kernkraft-Hymne in den USA und Australien auf und ab gespielt worden ist, sind allein in den USA 1492 Holzarbeiter ums Leben gekommen (hier) … und Zehntausende waren gesundheitlich beeinträchtigt. Die Anzahl zu Tode gekommener Holzarbeiter hat sich in den USA seitdem halbiert, aber die Todesrate ist immer noch eine der höchsten aller Industrien und liegt bei 70 Todesopfern pro Jahr pro 100.000 Arbeiter (hier). Ist das viel? Bei Verkehrsunfällen sterben pro Jahr unter 100.000 Menschen in Australien 6; in den achtziger Jahren waren es noch 20. Die Todesrate durch Lungenkrebs in den USA liegt bei 30 pro 100.000 Menschen pro Jahr. Holz ist tatsächlich etwas Wunderbares, aber Herstellung und Gebrauch sind tödlich und giftig.

Andererseits steht Kernkraft wie bereits erwähnt für saubere Luft, was sie zu etwas macht, dem man sehr dankbar sein muss, hat sie doch 1,8 Millionen Fehlgeburten seit den siebziger Jahren verhindert (hier). Minenarbeit unter Tage hat die Kumpel in den fünfziger Jahren radioaktivem Radongas ausgesetzt und ihr Lungenkrebs-Risiko höher werden lassen als bei Rauchern (hier und hier), aber moderne Technik macht den Uran-Bergbau zu einem der sichersten aller Bergbau-Tätigkeiten. Einfacher gesagt, Todesfälle sind ziemlich ungewöhnlich (hier), und Strahlendosen sind messbar und daher leicht zu kontrollieren. Wie misst man Holzrauch oder das Einatmen von Staub oder die Aufnahme von Staub durch Kinder, deren Mütter mit Holz kochen? … Man weiß erst, dass die Dosis zu hoch war, wenn das Kind krank wird.

Peter,Paul und Mary haben sich getrennt. Die Anti-Kernkraft-Hymne hat eine wunderbare Melodie, aber der Text ist verwirrender Plunder und Ballast*, und in dem Lied triumphiert Rhythmus über Vernunft.

[*Unübersetzbares Wortspiel: „addled flotsam and jetsam“]

Also müssen wir jetzt drei Jahrzehnte eines zu Herzen gehenden, aber grob irreführenden Markenzeichens zurückdrehen. Man stelle sich mal vor, wie unterschiedlich es auf dem Planeten während der letzten 23 Jahre zugegangen wäre, falls jedes Land auf ihm wie Frankreich Strom mit Emissionen von lediglich 80 g CO2/kWh erzeugt hätte anstatt des globalen Mittels von 570… mit den stärksten Emissionen in „Anti-Kernkraft-Australien“ mit 850 g CO2/kWh.

Dies hätte geschehen können, wenn Peter, Paul und Mary doch bloß geschrieben hätten:

Please spare me the transitory power of the wind

Give me that Cherenkov_glow of a fission fire

And please take all your kiddie killing wood smoke away.

(Ich glaube, das muss nicht übersetzt werden. C. F.)

Quelle

Um nun den Bereich von Protestsongs von Strahlungsexperten auf andere Experten auszuweiten, müssen wir mehr Details über Krebs erfahren.

Was Experten über Krebs wissen

Anfangen wollen wir mit zwei grundlegenden Tatsachen:

● Das Überleben einer Atomexplosion und der Empfang einer großen Dosis Strahlung stellt ein viel geringeres Krebsrisiko dar als ein karzinogener Lebensstil – Rauchen, Verzehr von reichlich rotem und verarbeitetem Fleisch, Übergewicht, keine Bewegung, um nur einige wesentliche Gründe für Krebs zu nennen. Auch die Körpergröße gehört dazu, was vielleicht überraschend ist, aber ich gehe später noch darauf ein.

● Das Leben auf strahlenverseuchtem Land nach so etwas wie Tschernobyl sowie der Verzehr von Nahrungsmitteln aus verstrahlten Gebieten birgt ebenfalls nachweislich ein viel geringeres Krebsrisiko als Krebs aufgrund mancher Lebensgewohnheiten.

Für einen Protestsongs hörenden Laien sind diese beiden Tatsachen sowohl erstaunlich als auch gefühlsmäßig falsch: „Das kann nicht stimmen!“ wäre die absehbare Antwort. Aber ein Experte würde eher antworten: „Ja, natürlich … weiß das nicht jeder?“ Nein, das weiß nicht jeder.

Was wissen Experten, das wir nicht wissen?

Beginnen wollen wir mit dem Vergleich dessen, was Experten über die Überlebenden der Atombomben im 2. Weltkrieg wissen im Vergleich zu Menschen in Australien (oder den USA oder UK) mit dem entsprechenden Lebensstil. Das Krebsrisiko der Überlebenden von Hiroshima und Nagasaki ist ausführlich untersucht worden. Es hat um etwa 11 Prozent zugenommen. Die Experten wissen das, aber wir anderen müssen da nachschauen. Aber natürlich tun wir das nicht, und selbst wenn wir es täten, hätten wir noch lange keine Vergleichsmöglichkeit. Ist eine Zunahme um 11 Prozent eine starke Zunahme?

Nein! Die Krebsrate in Australien beispielsweise liegt um ganze 50 Prozent höher als die in Japan (hier; allerdings scheint dieser Link nicht zu funktionieren). Standardisiert man die Zahlen hinsichtlich der unterschiedlichen Altersstruktur, kommt man auf 314 Krebsfälle pro 100.000 Menschen pro Jahr, in Japan sind es 201. Aber selbst diese 11 Prozent Zunahme unter den Überlebenden der Bomben sind irreführend, weil es ein Mittelwert ist, der künstlich nach oben getrieben wird durch die wenigen Überlebenden, die massiven Strahlendosen ausgesetzt waren, was die Zunahme viel größer ausfallen ließ. Die überwältigende Mehrheit aller Überlebenden erlebte lediglich eine Zunahme der Rate um 2 Prozent. Die wenigen Überlebenden, die die allgemeine Zahl so nach oben getrieben haben mit ihrer Zunahme des Risikos um 60 Prozent, wurden von einer kurzen, aber massiven Welle von Strahlung betroffen, die etwa 300.000 mal so hoch war wie die Hintergrundstrahlung, aber selbst diese massive Dosis hat ihr Krebsrisiko nur um einen Bruchteil desjenigen in Australien zunehmen lassen.

Die anderen Krebsarten sind Leukämien. Sie machen etwa 2 bis 3 Prozent aller Krebsfälle aus, so dass sie selbst bei einer Verdoppelung der Zahlen die obige Analyse nicht widerlegen. Aber sie verdoppeln sich nicht. Leukämie hat bei den Überlebenden um 6 Prozent zugenommen (hier), aber eine Verdoppelung der Rate bei den Wenigen, die massive Dosen abbekommen hatten, hat das Mittel auf 46 Prozent steigen lassen … aber das ist immer noch weniger als bei einem Leben im australischen Lebensstil.

Andererseits hatte der Unfall von Tschernobyl keinerlei Auswirkungen auf die Krebsrate mit Ausnahme einiger Fälle von Schilddrüsenkrebs. Auch dies ist Experten wohlbekannt. Wenn es um das allgemeine Krebsrisiko in verstrahlten Gebieten geht oder um den Verzehr von Nahrungsmitteln aus solchen Gebieten, müssen wir lediglich in die nationalen Krebsregister schauen, um zu sehen, was passiert ist. Krebsregister sind sehr einfache Dinge. Man bekommt die Diagnose Krebs, das wird aufgezeichnet und die Zahlen addiert. Dann entstehen einige einfache und transparente Statistiken daraus. Während der letzten 25 Jahre gab es in der Ukraine sowie in Russland und Weißrussland etwa 14 Millionen Krebsfälle. Legt man die australische Rate zugrunde, wären es 20 Millionen. Wie machen sich 6000 Fälle von Schilddrüsenkrebs mit etwa 15 Toten gegen die 6 Millionen eines extravaganten Lebensstils aus?

Krebs durch den Lebensstil ist immer ein viel höheres Risiko als Atombomben und Reaktorunfälle.

Anti-Kernkraft-Guru Helen Caldicott „warnt“ vor dem Krebsrisiko beim Verzehr türkischer Aprikosen (hier bei youtube), weil die Türkei durch den Fallout von Tschernobyl betroffen war. Krebsexperten andererseits wissen, dass die Krebsrate in der Türkei (hier, aber auch dieser Link scheint nicht zu gehen) weniger als halb so groß ist wie in Australien oder den USA. Im Jahre 2008 gab es in der Türkei 95.000 neue Krebsfälle bei einer Bevölkerung von 73 Millionen. Zum Vergleich: In Australien mit 22 Millionen Einwohnern waren es 107.000 neue Krebsfälle Wenn das mehr nach einem Drittel als der Hälfte aussieht, dann deshalb, weil die Experten solche Raten justieren, um der unterschiedlichen Altersstruktur in der Türkei Rechnung zu tragen.

Die Anti-Kernkraft-Bewegung ist stolz darauf, Angst machende Geschichten darüber zu verbreiten, was Strahlung bei unserer DNA anrichtet. Experten wissen, dass alles und jedes unter der Sonne einschließlich dieser selbst der DNA zusetzen. Das Umherwerfen mit technischem Jargon und das Verbreiten von Angst sind kein Ersatz für harte Daten zu realen Auswirkungen. Betrachtet man diese, befindet sich das nukleare Risiko fast am Ende jeder Risikotabelle. Es ist ihrer Natur nach ähnlich und sehr viel geringer als das Risiko von Unfällen in der Arbeit, beim Sport oder beim Renovieren der Wohnung. Und außerdem wird es drastisch in den Schatten gestellt durch 1,8 Millionen verhinderte Fehlgeburten infolge saubererer Luft.

Wenn die Menschen mit dem Narrativ „Strahlung ist Gift“ aufwachsen, dann ist es einfach unglaublich zu erfahren, dass das Überleben einer Atombombe viel weniger karzinogen ist als beispielsweise der häufige Verzehr von Würsten (hier), aber genauso ist es. Krebsexperten wie der in Teil II erwähnte Robert Gale verstehen das, aber Nicht-Experten finden das so erstaunlich, dass sie es nicht glauben. Darum soll hier noch etwas näher erläutert werden, was es ist, das dem Wissen der Experten nach den Unterschied ausmacht.

DNA-Schäden sind nicht Krebs

Man erinnere sich noch einmal an Teil I, in dem wir die Frage stellten, ob es eine Strahlungs-Untergrenze gibt, unterhalb der keine DNA-Schäden oder Mutationen möglich sind. Als wir diese Frage zum ersten Mal gestellt hatten, haben die meisten Wissenschaftler geraten, dass die Frage gleichbedeutend war mit der Frage, ob es eine Strahlungsdosis gibt, unterhalb der man keinen Krebs bekommt.

Sie lagen falsch.

Bei Menschen mit dem Laron-Syndrom kommt es zu vielen Mutationen und anderen DNA-Schäden, aber sie bekommen keinen Krebs. Sie sind einfach Beispiel für ein allgemeineres Prinzip, nämlich dass das Wachstum von Krebsgeschwüren Teamarbeit ist, das unter Anderem die richtige Menge an Mutationen erfordert sowie die Ausbreitung der Geschwüre, während die normalen Checks wirkungslos gemacht werden. Krebs ist nicht einfach wie ein Stock im Rad eines Fahrrades, sondern eine kooperierende und sich entwickelnde Gemeinschaft von Mutanten, die normale Prozesse im Körper dazu nutzen, ihre eigenen schändlichen Gelüste zu befriedigen. Da gibt es sehr viele DNA-Schäden, aber keinen Krebs.

Andererseits, Menschen, bei denen die Krebsrate weit höher liegt als alles, was selbst ein ärmlicher Lebensstil erzeugen kann, tragen Mutationen in sich, die die effiziente Heilung von DNA-Schäden verhindern. Das ist das Problem von Angelina Jolie. Es ist nicht so, dass ihre Mutation zusätzliche DNA-Schäden hervorruft; überhaupt nicht. Ihr Problem ist, dass die BRCA1-Mutation mehr der Mutationskraft hinter normalen DNA-Schäden freisetzt. Ein normales (nicht mutiertes) BRCA1-Gen ist Teil des genetischen Superteams zur Bekämpfung von Problemen, das normale Schäden repariert. Man behalte dabei im Gedächtnis, dass eine siebenfache Strahlung von Hiroshima-Bomben jeden Tag normale Schäden auslöst. Wenn also nur ein Mitglied dieses Reparatur-Teams durchdreht, ist man in Schwierigkeiten. Menschen, die unter dem Bloom-Syndrom leiden, haben sogar noch weniger Reparatur-Kapazität.

Quelle des Bildes. Zwergenwuchs und Laron-Syndrom schützen vor Krebs.

Treffen mit dem Krebs-Team

Was bedeutet die Aussage, dass eine Zelle zu einer Krebs-Zelle geworden ist? In der Regel bedeutet es, dass die Zelle sich selbst sehr oft reproduziert hat und sie sich alle in einer großen Masse zusammengeklumpt haben. Falls der Krebs in Ihrem Darmtrakt sitzt, kann dieser Klumpen den Darm stark verengen oder vollständig blockieren.

Normale Zellen tun das nicht. Wenn eine normale Zelle zu einer Krebs-Zelle wird, muss sie ihre Lebensweise fundamental ändern (hier). Normale Zellen klumpen nicht zusammen wegen der Mechanismen, die sie zu ihren Nachbarn auf Abstand halten. Diese Mechanismen müssen ausgeschaltet werden. Normale Zellen sind begrenzt hinsichtlich der Anzahl von Teilungen und Reproduktionen. Die Mechanismen hinter dieser Begrenzung müssen ausgeschaltet werden. Normale Zellen zerstören sich im Falle der Schädigung selbst. Auch dieser Mechanismus muss ausgeschaltet werden.

Das sind nur einige von vielleicht einem Dutzend Gründen, warum Krebs-Zellen so anders sind. Die zellulären Änderungen, die gebraucht werden, um eine normale Zelle in eine Krebs-Zelle zu transformieren, erfolgen meist durch Mutation, also Gen-Veränderungen. Aber natürlich nicht irgendwelche Gene. Weniger als 1 Prozent aller Gene sind involviert in die Änderungen, die eine Zelle zu einem Tumor werden lassen. Und innerhalb dieses einen Prozents haben Forscher sogar noch weniger gefunden, das besonders wichtig ist, um den Zellen die vielen Features zu vermitteln, die es ihr ermöglichen, zu einem Tumor zu werden.

Aber es gibt einen großen offensichtlichen Unterschied zwischen Strahlung und viralen oder chemischen Karzinogenen, wie man sie in Zigaretten, Diesel-Abgasen, Holzstaub, Ruß, rotem Fleisch usw. findet.

Worin besteht der Unterschied? Strahlung ist ein „equal opportunity“-Mutator [?].

Was heißt das? Wenn radioaktive Partikel oder Wellen auf eine Zelle treffen, haben sie physikalisch keine Möglichkeit, bestimmte Gene zu berühren. Sie schwirren umher, ziemlich zufällig. Dieses Herumschwirren erzeugt schädigende Nebenprodukte, aber auch diese konzentrieren sich nicht auf einen bestimmten Brennpunkt, weil die gleichen Nebenprodukte auch durch andere, normale Prozesse entstehen, und nichts ist involviert, das man mit gezielter Bosheit verwechseln könnte. Dies bedeutet, dass die meisten Strahlungsschäden in Genen oder anderen Strukturen auftreten, die für die Entstehung von Krebs irrelevant sind. Eines der Nebenprodukte beispielsweise von Strahlung, die auf das Wasser in der Zelle trifft (eine Zelle besteht zum allergrößten Teil aus Wasser) ist Wasserstoff-Peroxid. Das ist ein normales Nebenprodukt, welches DSBs [?] verursachen kann, und es gibt viele natürliche und einfachere Wege, die von Wasserstoff-Peroxid ausgelösten Schäden an der DNA zu vervielfältigen als eine große Strahlendosis abzubekommen. Eine davon sahen wir in Teil 1.

Jetzt vergleiche man dies mit einem Krebs auslösenden Virus. Zuerst: Was macht dieses Virus zu einem Krebsauslöser anstatt einfach nur einen Nieser auszulösen? Ein krebserzeugendes Virus kann ganz bestimmte Bereiche der Zelle treffen. Es kann sogar gezielt einen oder mehrere Gene treffen, die bei der Krebsentstehung involviert sind. Zum Beispiel kann ein Virus sehr spezielle Ziele befallen wie zum Beispiel ein sehr spezielles einzelnes Gen (mit der Bezeichnung p53). Dieses Gen unterdrückt Krebs, weshalb man ihm den illustrativen Titel The Guardian of the Genome verliehen hat. Es ist eines der Gene, das von Tabakrauch betroffen wird. Es würde eine außerordentlich hohe Dosis oder größtes Pech bedeuten, wenn Strahlung dieses Gen p53 treffen würde. Es ist dieses Fehlen der Spezialisierung auf bestimmte Ziele, dass Strahlung in karzinogener Hinsicht zu einem Schwächling macht.

Chemische Karzinogene können sich auch gezielt spezielle, Tumore unterdrückende Gene aussuchen. Während sich beispielsweise die Anti-Kernkraft-Bewegung auf Dinge konzentriert hat, die bei einem Kernkraftwerk schief gehen können, emittieren Kohlekraftwerke normalerweise eifrig verschmutzende Chrom- und Nickelanteile, die andere Tumore unterdrückende Gene angreifen können (hier), sowie Arsen, welches sich das magische p53-Gen vornehmen kann. Nickel und Arsen aus den Emissionen von Kohlekraftwerken kann von Bäumen aufgenommen werden und endet in Holzrauch, der sich in den Lungen von Jung und Alt ablagert.

Aber wir müssen den Unterschied quantifizieren, den Spezialisierung machen kann.

In einer Studie aus dem Jahr 2012 haben Forscher Mäuse mit einer Strahlendosis von 4 Gray [?] bestrahlt. Das ist eine massive Dosis. Sie ist etwa 20 mal stärker als der Mittelwert von Strahlung, dem die Überlebenden von Hiroshima ausgesetzt waren. Es ist gerade unterhalb der Dosis, die die Maus getötet hätte.

Und siehe da, die Maus bekam Krebs – allerdings erst nach 77 Wochen. Das ist wirklich eine lange Zeit in einem Mäuseleben und entspricht etwa 40 bis 50 Jahren menschlicher Lebenszeit. Und wie zuvor schon erwähnt sind Mäuse viel anfälliger für Krebs als Menschen. Andererseits, man gebe Mäusen eine große Dosis der karzinogenen Chemikalie PhIP (hier), und sie werden innerhalb nur weniger Wochen in voller Stärke an Krebs erkranken. Das ist der Unterschied zwischen zufälligem Herumballern und gezielten Attentaten. Ja, Strahlung kann Krebs verursachen, aber hinsichtlich der Effizienz nur mit der Note 6 minus.

Was ist PhIP und warum füttern die Menschen Mäuse damit? PhIP ist eines der vielen Molekülarten, die man in allen Arten von Fleisch findet, das bei hoher Temperatur verarbeitet wird, also z. B. auf einem Gartengrill. Darunter ist eine Gruppe, welche bei Mäusen bei massiven Dosen Krebs erregen kann … ähnlich wie bei Strahlung, aber wesentlich effizienter. Gibt es eine sichere Dosis? Natürlich nicht! Gibt es eine absolut sichere Distanz, die man in jedem Jahr mit dem Auto fahren kann? Natürlich nicht! Aber einige Fahrweisen bergen nur ein sehr geringes Risiko.

Ist PhIP ein Hoch-Risiko-Karzinogen … soll heißen, bewirkt es sehr oft die Entstehung von Krebs? Das ist keineswegs sicher, aber man findet Warnungen vor dem Grillen von Fleisch bei hoher Temperatur, und zwar im Kleingedruckten der meisten offiziellen Literatur zur Verhinderung von Krebs. Die im oben erwähnten Versuch verwendeten Dosen waren wie gesagt massiv und viel zu groß, um daraus irgendeine Relevanz für den Menschen abzuleiten. Ich wette auf Häm-Eisen [?] als primäre Ursache für Darmkrebs, aber es gibt viele mögliche Verdächtige.

Und was ist, wenn man [körperlich] groß ist? Warum stand dies in der Liste der Risikofaktoren für Darm- (und Brust-)Krebs? Nicht die Körpergröße selbst, sondern einige der für die Körpergröße zuständigen Faktoren sind gefährlich (hier). Im Einzelnen haben sich in großen Menschen viel mehr Zellteilungen ereignet, stimuliert von Wachstumshormonen, und das bedeutet ein größeres Potential für DNA-Schäden. Der statistische Zusammenhang ist eindeutig, und Experten haben auch eine ungefähre Vorstellung hinsichtlich der Ursachen, aber eine detaillierte Erklärung wird es wohl erst in einigen Jahren geben.

Man beachte genau, was ich hier tue. Ich versuche nicht zu beweisen, dass Tschernobyl allein nur eine minimale Auswirkung auf Krebs hatte. Das ist einfach eine bestätigte Tatsache. Alles, was ich versuchen will zu erreichen ist ein wenig mehr Verständnis dafür, warum dies für Experten keineswegs überraschend kommt. Immer wenn Fakten nicht eingängig sind, ist es einfach, verschleiernde Theorien zu verbreiten. Wenn man einmal verstanden hat, warum Experten nicht viel von Tschernobyl erwartet hatten, versteht man auch, warum es nichts weiter zu berichten gab.

Ein neuer Mitspieler

Zum Schluss möchte ich noch etwas behandeln, das schon in Teil II angesprochen worden ist … Epigenetik [?].

Das Verständnis für Krebs ist zu dessen Behandlung unabdingbar. Es ist schwierig, mit dieser Ansicht nicht überein zu stimmen, aber die erstaunliche Zunahme des Wissens hierzu während der letzten 20 Jahre hat nicht zu einer ähnlichen Verbesserung der Behandlungserfolge geführt. Wie es so üblich ist, hat man einmal einen fundamentalen Mechanismus erkannt, zeigt sich darunter ein weiterer noch unbekannter Mechanismus, der womöglich noch komplexer ist. Eine der jüngsten Ebenen in dieser Hinsicht ist Epigenetik. Die Gene in unserer DNA sind nicht unser Bauplan wie man ursprünglich gedacht hatte. Stattdessen sind sie lediglich ein Bauplan für eine Reihe von Werkzeugen. Die gesamte biologische Software, die kontrolliert, wie und wann diese Werkzeuge zur Anwendung kommen, liegt möglicherweise in der DNA, aber nicht in den Genen. Und die erste von vielleicht mehreren Ebenen dieser Software ist die epigenetische Ebene. Diese Ebene legt die Mechanismen fest, die die Aktivierung jedes Gens in jeder Zelle kontrollieren.

Mehr

Auf Folgendes sollte man sich konzentrieren:

Einige Menschen tragen DNA-Mutationen in sich, die sie sehr wahrscheinlich Darmkrebs bekommen lassen, und zwar auf die gleiche Weise, mit der BRCA1-Mutationen Frauen anfällig für Brustkrebs machen. Wie BRCA1-Mutationen schalten auch diese Mutationen Gene aus, die für die Reparatur von Schäden an der DNA zuständig sind; und alles, was dem DNA-Reparatursystem in die Quere kommt, sorgt für Probleme. Diese Darmkrebs-Mutationen sind für 5 bis 10 Prozent aller Fälle von Darmkrebs verantwortlich. Darum liegt das Niveau von Darmkrebs-Erkrankungen in Ländern ohne die normalen westlichen Risikofaktoren wie rotes und gegrilltes Fleisch, Fettleibigkeit, Alkohol, wenig Bewegung usw. so niedrig.

Aber epigenetische Mechanismen können Gene genauso effektiv ausschalten wie Mutationen, aber sie tun es, ohne die DNA-Sequenz zu verändern. Epigenetische Mechanismen werden kontrolliert durch triviale Dinge wie das, was man isst, wie viele Sorgen man hat und vielleicht auch noch ein paar Dinge, die wir nicht kennen – noch nicht.

Wenn also Krebs durch epigenetische Änderungen gesteuert wird, kann es wie durch eine Mutation verursachter Krebs aussehen, aber wenn die Ärzte nach einer solchen suchen, finden sie keine. Es wird während der kommenden Jahrzehnte sehr viel Neues zu Epigenetik geben, aber man sollte keine Wunder erwarten.

Aber Epigenetik liegt im Zentrum dessen, wie unser Lebensstil sich auf unsere Gesundheit auswirkt. Darum wird sie wohl unsere Ansicht von uns selbst fundamental ändern. Zum Beispiel hat die Epigenetik alle Argumente zerstört, die etwa so klingen: „Wir haben etwas schon hunderte Jahre lang getan, es ist in unseren Genen, es stand nicht genügend Zeit für genetische Änderungen zur Verfügung, also liegt dieses etwas in unserer Natur“. Für „etwas“ kann man viele Verhaltensweisen einsetzen: Gewalt, Frauen vergewaltigen, Fleisch essen, Monogamie, heterosexuell sein. Die Epigenetik zeigt, dass das Argument auf falsche Voraussetzungen beruht. Die Epigenetik erlaubt die Modifizierung der Art und Weise, wie die DNA-Reparatur-Werkzeuge eingesetzt werden, schon innerhalb von Tagen und Wochen. Wenn eine Katze ihr Junges im Babystadium nicht ausreichend ableckt, kommt es zu semi-permanenten nachteiligen genetischen Veränderungen, die nicht nur ein Leben lang andauern können, sondern mittels der Gene auch an folgende Generationen weitergegeben werden können. Mehr als nur ein paar Kätzchen haben gelitten, um diesen Tatbestand zu beweisen, und es gibt sehr gute Gründe anzunehmen, dass es bei Menschen genauso ist [vielleicht kann sogar der Übersetzer davon ein Lied singen, wenn man „Ablecken“ durch „Zuwendung“ ersetzt!]

Falls das [zärtliche] Ablecken eines Kätzchens Aktivierungs-Anweisungen in den Genen verändern kann, die das zukünftige Katzenleben betreffen, was ist dann mit der Strahlung durch einen Nuklearunfall – wie etwa von Cäsium-137? Eine vor kurzem erschienene Studie kommt zu dem Ergebnis, dass selbst riesige Dosen von Gammastrahlung durch Cäsium-137 nicht die Wirkung von Zärtlichkeiten der Katzenmutter aufwiegen können. Strahlung hatte keine Auswirkungen auf genetische Aktivierungs-Anweisungen.

Abschließende Bemerkungen

[Im ersten der drei Absätze erwähnt der Autor zunächst den IPCC-Bericht Nr. 5 sowie alle Schrecken, die dort projiziert werden. Leider scheint er das zu glauben, ohne das ihm klar wird, dass nun er davon geängstigt wird, weil er zu wenig darüber weiß, also genau das, was er uns unterstellt, die wir viel zu wenig von Strahlung wissen {siehe hierzu den letzten Absatz}. Er schlägt dann aber den Bogen zu den Erneuerbaren und prangert die Unlogik entsprechender Kreise an. A. d. Übers.]

…

Gegenwärtig agieren viele Umweltgruppen so, als ob die Risiken in Verbindung mit Nuklear-Unfällen genauso groß sind wie die [vermeintlichen, A. d. Übers.] Risiken in Verbindung mit der Klimaänderung. Sie scheinen sich … voll auf die Technologie der Erneuerbaren Energie zu stürzen: Wind und Sonne. Andererseits wollen viele nicht einsehen, dass die einzige Technologie, die die Abhängigkeit von Öl und Kohle erfolgreich bekämpft, wie sich während der Ölkrise des Jahres 1970 gezeigt hat, die Kernkraft ist.

Es ist meine Überzeugung, dass der Hauptgrund für diese Irrationalität darin zu suchen ist, dass die Öffentlichkeit allgemein und die meisten Umweltaktivisten im Besonderen nichts über die Dinge wissen, die sie ängstigen. Darum ängstigen sie sie. Diese Reihe hat versucht, dieses Defizit zu beheben. Während die allgemeine Öffentlichkeit weder Zeit noch Lust hat, die Details zu durchforsten, um rationale Energie-Entscheidungen zu treffen, ist es die Pflicht unserer politischen und umweltlichen Meinungsmacher genau dies zu tun. Sie müssen die Wissenschaft in Betracht ziehen und dann der wachsenden Liste von Personen beitreten, die glauben, das Anti-Kernkraft = Anti-Zukunft ist. So einfach ist das.

Link: http://bravenewclimate.com/2013/11/15/stayin-alive-gene-pool-p3/

Übersetzt von Chris Frey EIKE