Neue Studie: Politik der Dekarbonisierung ignoriert die technische Machbarkeit

Die Studie enthüllt, dass Größenordnung, Umfang, Machbarkeit, Kosten, Ressourcen und andere Erfordernisse der Dekarbonisierungs-Agenda niemals hinsichtlich anderer Aspekte menschlicher und physikalischer Ressourcen des Planeten getestet worden sind.

Die Tatsache, dass die Kohlenstoffemissionen trotz vieler Projekte, die es schon jetzt auf der ganzen Welt gibt, unaufhaltsam steigen, führt zu einer einfachen Frage. „Was bekommen wir für unser Geld?“

Die Studie von Prof. Kelly behandelt die Rolle technologischer Änderungen, die der globalen Dekarbonisierungs-Agenda auf die Sprünge helfen sollen: Erfolg in UK und Scheitern überall sonst bedeutet immer noch scheitern.

Der jüngste Bericht des IPCC zeigt, dass einige der schlimmeren Auswirkungen viel weniger wahrscheinlich sind, was die Frage aufwirft, wie viel dieser Agenda kurzfristig wirklich gebraucht wird.

Mit der neuen Studie ist beabsichtigt, einige zentrale Lehren aus der Realität erfolgreicher technologischer Änderungen in der jüngeren Vergangenheit zu ziehen und wie sie hinsichtlich der globalen Herausforderung der Klimaänderung einzuordnen sind.

Die Studie kommt zu dem Ergebnis, dass die Lücke zwischen der Rhetorik und der Wirklichkeit auf der Grundlage von einigen der einfachsten technologischen Voraussetzungen gefährlich groß ist.

—————————-

Bei obigem Text handelt es sich um die Presseerklärung der GWPF zu der genannten Studie. Diese soll jetzt aber auch hier näher erläutert werden, und zwar in Gestalt einer Zusammenfassung und der Übersetzung weiter Passagen. Alle Zwischentexte sind kursiv gesetzt, direkte Übersetzungen erscheinen in gerader Schrift.

Technologische Neuerungen im Zusammenhang mit der Dekarbonisierung

Lektionen aus der jüngeren Geschichte

Prof. Michael J. Kelly

Einführung

Die Gemeinschaft der Klimawissenschaftler hat viele Politiker und Entscheidungsträger von der Notwendigkeit der Dekarbonisierung der Weltwirtschaft in kürzester Zeit überzeugt. Aber deren Anliegen, und ob das glaubwürdig ist oder nicht, ist nicht Gegenstand dieser Studie. Vielmehr sollen hier einige der Lektionen der jüngsten Geschichte der technologischen Evolution beleuchtet werden, die in dem ganzen Durcheinander nicht untergehen sollten.

Es gibt Regeln hinsichtlich der Einführung neuer Technologien, und man wird bestraft, wenn man sich über diese Regeln hinwegsetzt. Falls wir darauf aus sind, die Weltwirtschaft zu dekarbonisieren, sollten wir danach trachten, dabei erfolgreich zu sein, und nicht wie derzeit zu Maßnahmen greifen, die mit Sicherheit nicht erfolgreich sein werden. In der Tat, wenn wir die Einführung der kohlebefeuerten Dampfmaschine von James Watt und das Aufkommen elektrischen Stromes als Energiequelle betrachten, können wir erkennen, warum das erfolgreich war und dann daraus ableiten, was für das Projekt der Dekarbonisierung erforderlich ist. Aus der jüngsten Geschichte leite ich neun Lektionen ab, die für alle von uns initiierten Programme relevant sind, und eine zehnte Lektion, falls der wissenschaftliche Konsens bzgl. der Klimaänderung auch im nächsten Jahrzehnt noch bestehen sollte. Ich mache auch drei konkrete Vorschläge, wie man weiter vorgehen könnte.

Die Lektionen

Lektion 1: Erfolgreiche neue Energie-Technologien verbessern das Los der Menschheit

Energie aus Dampfmaschinen und Strom von Turbinen haben viele Dinge des heutigen Lebens in der entwickelten Welt erst möglich gemacht. Man muss nur zu einer abgelegenen Gemeinde in den Bergen in einem Entwicklungsland gehen, die nicht am Stromnetz hängt, um zu sehen, dass Dinge wie Lebensweise, Gesundheitsrisiken, Nahrungsmittelsicherheit, Transportmöglichkeiten und Lebenserwartung allesamt schlechter bestellt sind als in UK. Niemand, auch keine Gemeinde schiebt die Option, Zugang zu Strom oder zu fossil betriebenen Annehmlichkeiten zu haben, auf der Grundlage beiseite, dass man ohne diese Dinge besser dran ist.

Beispielhaft beschrieben wird dies anhand der Entwicklung der Telefone bis hin zu den heutigen Möglichkeiten mobiler Apparate sowie die Vorteile aus dieser Entwicklung für Menschen, die auf sichere Planungsgrundlagen angewiesen sind und sich jederzeit vor Ort abstimmen können.

Weiter lesen wir:

Innerhalb von 20 bis 30 Jahren, in der Watts Dampfmaschine in der Landwirtschaft genutzt werden konnte, hörten die Windmühlen in UK auf, sich zu drehen. Hier gab es eine neue Energiequelle, die zuverlässig war, beweglich, bequem, preiswert und mit geringer Wartung. Die relativen Positionen fossiler Treibstoffe und der Windenergie haben sich hinsichtlich der Bequemlichkeit für die Menschen seitdem nicht geändert. Es gibt keinen Wettbewerb zwischen einem Generator der Firma Aggreko und einer Windmühle der Firma Vestas, wenn es um Zuverlässigkeit geht.

Das Erreichen einer dekarbonisierten Wirtschaft macht Verbesserungen der heutigen Technologie erforderlich mit der Produktion von Objekten, die hinsichtlich des Gewichtes leichter sind. Außerdem muss das Reisen von einer Notwendigkeit in die Option der Wahl verwandelt werden (d. h. Verwendung von Tele-Systemen für den nationalen und internationalen Handel), effizientere Recycling-Methoden, die Entwicklung einfacherer Lebenswege für die Älteren, viel sauberere Luft in Städten und andere Fortschritte. …

Lektion 2: Angesichts dessen, dass 90% der globalen Verbesserungen des menschlichen Lebens seit dem Jahr 1800 durch das Verbrennen fossiler Treibstoffe möglich geworden ist, ist die Größenordnung des Dekarbonisations-Projektes historisch beispiellos.

Ein Mensch in Westeuropa verbraucht heute im Mittel 6 bis 7 mal Energie pro Tag wie jemand, der dort im Jahre 1800 gelebt hat. … Es ist sicher keine Übertreibung zu sagen, dass die Zivilisation, so wie wir sie kennen, auf fossilen Treibstoffen basiert, die seitdem über 90% der verbrauchten Energie erzeugt haben. …

Im folgenden Absatz wird kurz angerissen, wie sehr die nachgewiesenen fossilen Vorräte nach Peak Oil und Co. inzwischen größer sind als jemals zuvor, und dass wir seit der industriellen Revolution bislang höchstens 10% davon verbraucht haben.

Der nächste Absatz scheint wieder sehr bedeutsam:

Eine dekarbonisierte globale Ökonomie muss die auf fossilen Treibstoffen beruhenden Errungenschaften überflügeln. Gelingt das nicht, wird sich das Vorankommen der Menschheit hinsichtlich des erreichten Lebensstandards umkehren. Wir sollten ehrlich sein und uns der schieren Größenordnung und der enormen Herausforderung durch Dekarbonisation bewusst sein. Allgemeiner Unmut über erste Anzeichen sinkenden Lebensstandards breitet sich in vielen westlichen Ländern aus, namentlich Japan, Australien, Deutschland, Kanada und die EU).

Im folgenden Absatz werden als Beispiel des immensen Aufwandes hierzu die Kosten genannt, die allein durch die Nachisolierung von Gebäuden entstehen – Kosten in Höhe von 1,7 Billionen Pfund innerhalb von 40 Jahren. Dann stellt der Autor die Frage:

Das Problem dieser außerordentlich gewaltigen Ausgaben besteht darin, dass kaum erkennbar ist, ob es diese Ausgaben wert sind. Was bekommt man letztendlich für 1 Billion oder 10 Billionen Pfund, die man zur Abschwächung des Klimas ausgegeben hat? Antwort: Niemand weiß es. Kommt es später wirklich zu einer Katastrophe, haben wir eindeutig noch viel zu wenig ausgegeben. Bleibt die Katastrophe aus, werden wir niemals wissen, ob dies unseren Bemühungen zu verdanken ist. In jedem Falle wird also das Geld ohne bekannte vorteilhafte Auswirkungen ausgegeben, auch wenn von offizieller Seite immer wieder die Notwendigkeit solcher Ausgaben beschworen wird.

Lektion 3: Da über 50% der Weltbevölkerung im Jahre 2050 in Megastädten wohnen werden, muss dieses Problem als Erstes angegangen werden; 35% des heutigen Energieverbrauchs erfolgen in Gebäuden, hauptsächlich durch Heizen und Kühlung. Die gegenwärtige Generation der Erneuerbaren kann Megastädte nicht einmal ansatzweise mit Energie versorgen.

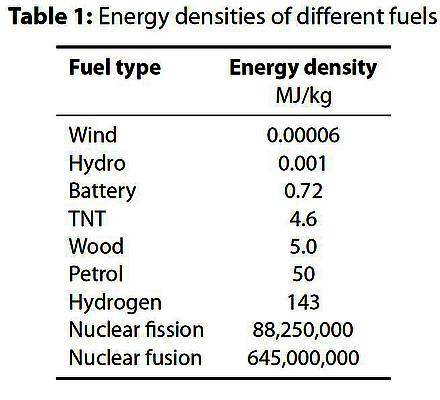

Es folgt ein Absatz über den unterschiedlichen Flächenverbrauch von Kraftwerken und Erneuerbaren. Daran schließt sich eine Tabelle über die Energiedichteverschiedener Quellen an:

Tabelle 1 zeigt die Energiedichte verschiedener Treibstoffarten. Die Zahlen umfassen 13 Größenordnungen, wobei Kernkraft eine Million mal energiedichter ist als die chemischen Prozesse eines fossilen Treibstoffs. … Dies sind keine trivialen Proportionen und spiegeln sich ultimativ in den Kosten, im Landverbrauch, der Sicherheit und anderen Faktoren der Energie-Infrastruktur, besonders hinsichtlich Mobilität.

Es folgen zwei Absätze, in denen das Problem am Beispiel der Stadt Shanghai erläutert wird, was allgemein auf die zu erwartenden Mega-Städte übertragen wird.

Lektion 4: Erfolgreiche neue Infrastruktur- und Energie-Technologien können in großem Umfang nur eingeführt werden, wenn sie sowohl ausgereift als auch ökonomisch sind, und man wird bestraft, wenn man diese Bedingungen übergeht. Jede Lektion aus der Einführung neuer Software auf Infrastruktur-Projekte, die nicht ausgereift ist, zeigt das.

Zunächst wird diese Aussage am Beispiel Japan ausgeführt. Dort ist die Installation von Solaranlagen trotz einer neuen Spitze beim Ölpreis rückläufig, haben sie doch niemals die Erwartungen auch nur annähernd erfüllt.

Die nächsten beiden Absätze beziehen sich auf das Speicherproblem und die extrem hohen Kosten für Maßnahmen, die Industrien treffen müssen, um Stromausfällen vorzubeugen. Auch auf die Speicherung in Batterien wird eingegangen. Wenn es eine brauchbare diesbezügliche Speichermöglichkeit gäbe, wäre sie wohl längst gefunden worden, denn Batterien gibt es schon sehr lange.

Die nächste Lektion soll hier wieder in ganzer Länge übersetzt werden:

Lektion 5: Es gibt heilsame Lehren aus der ersten Runde erneuerbarer Technologien, die zurückgehen auf Reaktionen auf die Ölkrise der siebziger Jahre.

In den USA gab es in den siebziger Jahren hastig zusammen geschusterte Forschungs- und Entwicklungsprogramme bzgl. alternativer Energiequellen, die die Wirtschaft vor Ölpreisschocks bewahren können. Das war eine durch und durch angemessene Reaktion. Die voreilige Einführung einiger dieser Technologien in Kalifornien vor allem Ende der achtziger Jahre bietet eine eindrückliche Lektion. Beim Ergoogeln der Begriffe ‚abandoned solar farm‘ [aufgegebene Solarfläche] oder ‚abandoned wind farm‘ [aufgegebener Windpark] kann man ganze Quadratkilometer verfallener Solaranlagen und über 14.000 aufgegebene Windturbinen allein in der Mojave-Wüste sehen. Es scheint, dass beim Fehlen von Subventionen die Solarpaneele und Windmühlen nicht genügend verwertbare Energie erzeugen, um die Kosten der Wartung und die Zinsen der Investitionen abzudecken. Seit der jüngsten Finanzkrise gab es in den USA und Europa viele Bankrotte von Unternehmen erneuerbarer Energie, und alle derartigen Industrien in China arbeiten derzeit mit substantiellen Verlusten (um 30%), was in einer kapitalistischen Ökonomie ebenfalls Bankrott bedeuten würde.

Früher oder später wird das Zurückfahren oder die gänzliche Streichung von Subventionen in den USA, Spanien, Deutschland und UK zu ähnlichen grün-industriellen Beerdigungen führen. … Der Erneuerbare-Energie-Index entsprechender Unternehmen hat zwischen 2009 und Anfang 2013 etwa 80% seines Wertes verloren, und auch wenn diese Verluste im Jahre 2013 auf 60% reduziert werden konnten, ist dies kein Ort für Investitionen (was der Fall wäre, wenn die wirtschaftliche Infrastruktur erneuerbarer Energie sinnvoll wäre).

Lektion 6: Subventionen der Regierung für die verfrühte Einführung sind eine Autobahn in die Katastrophe, während sie für R&D [Research und Development] sowie für Großversuche angemessen sind.

Es gibt auf der ganzen Welt kein Gegenbeispiel für die Feststellung, dass Subventionen der Regierung für die Entwicklung neuer Technologien in liberalisierte Energiemärkte bislang eine Litanei des Scheiterns erzeugt haben und dies auch weiterhin tun werden. Im Gegensatz dazu unterstützt jedes entwickelte Land Forschungen und Versuche bzgl. erneuerbarer Energien zur kommerziellen Einführung. Der Kosten-Nutzen-Vergleich fällt sehr stark zuungunsten der Erneuerbaren aus, so dass das Investitionsrisiko einfach zu hoch ist. Man muss einfach warten bis die neue Technologie ausgereift ist und während ihrer Lebenszeit im Wettbewerb bestehen kann.

Lektion 7: technologische Entwicklungen sind in der Regel nicht im Voraus programmierbar.

Hier wird anhand mehrerer Beispiele einfach beschrieben, dass neue Technologien Zeit brauchen und dass wohl die Einführung in der westlichen Welt viel zu überhastet erfolgt ist.

Lektion 8: Nichts wird geschehen, wenn die Bevölkerung nicht dahinter steht.

Diese Aussage spricht für sich und wird auch nur in einem kurzen Absatz ausgeführt.

Lektion 9: Die Finanzierung hat Grenzen, darum müssen Handlungsebenen priorisiert werden.

Eine Zahl von 200 Milliarden Pfund wird der Öffentlichkeit präsentiert, um ihr ein Gefühl dafür zu geben, in welcher Größenordnung Investitionen in UK im nächsten Jahrzehnt für eine neue Energie-Infrastruktur erforderlich sind. … Diese Summen müssen aus den internationalen Geldmärkten entnommen werden, im Wettbewerb mit allen anderen Investitionen.

Am Beispiel Spanien wird dann ausgeführt, was das bedeuten kann, wenn man diese Investitionen nicht aufbringen kann. Im nächsten Abschnitt geht es u. a. um Deutschland:

Inzwischen haben die Kohlenstoff-Emissionen in Deutschland angefangen zuzunehmen, und das wird auch so weitergehen, da neue Braunkohle-Kraftwerke ans Netz gehen – erstens, um die Kernkraftwerke zu ersetzen, die ohne Ausgleichszahlungen an die Investoren abgeschaltet werden, und zweitens, um die Schwankungen in dem großen Erneuerbaren-Sektor dort auszugleichen. Selbst hoch effiziente Gaskraftwerke werden in Deutschland abgeschaltet, eingemottet oder außer Betrieb genommen, teilweise weil sie als Back-Up nicht mehr wettbewerbsfähig sind, wurden sie doch als Grundlage der Energieversorgung konzipiert; teilweise aber auch wegen des sehr niedrigen Kohlepreises auf dem internationalen Markt, weil die USA immer mehr auf Schiefergas umsteigen. … In UK und der EU fehlt es einfach an einer glaubwürdigen Energiepolitik. …

Lektion 10: Falls sich die wissenschaftliche Grundlage der gegenwärtigen Klimaobjektive im nächsten Jahrzehnt ändern sollte, werden alle derzeitigen Bemühungen hinsichtlich einer dringend notwendigen Dekarbonisierung geschwächt.

Hier folgt ein kurzer Abriss der Historie der IPCC-Vorhersagen und dass Änderungen und Auswirkungen im AR 5 immer weiter abgeschwächt werden. Angesprochen wird auch das Fehlen jeder Erwärmung seit 1997. Der Autor gibt auch seine eigene Einschätzung hinsichtlich eines weiteren Stillstands oder sogar einer Abkühlung an, die seiner persönlichen Meinung nach über 50% beträgt. Außerdem sieht er diesbezüglich die Klimamodelle als gescheitert an und hält sie für unfähig, die Zukunft überhaupt vorhersagen zu können. Dazu führt er im letzten Absatz dieses Abschnitts aus:

Angesichts der diskreditierten Klimamodelle wird die Dringlichkeit einer Low-Carbon-Zukunft schwinden, und zwar deutlich bis jenseits des Zeitrahmens , die derzeit bzgl. Entscheidungen einer neuen nationalen Energie-Infrastruktur getroffen werden. Mit dem Einströmen von Schiefergas in das System werden kombinierte Kreislauf-Gasturbinen wahrscheinlich die flexibelste und wirtschaftlichste Energiequelle der nächsten 40 Jahre werden, und zwar in UK und in den meisten Gebieten der Welt. Der restliche Fahrplan zu einer Zukunft mit weniger Kohlenstoff muss aus Business-As-Usual erfolgen, wobei effizienterer Energieverbrauch und weniger Luftverschmutzung schon jetzt kommerzielle Treiber sind.

Vorschläge

Vorschlag 1:

Man bleibe bei Business-As-Usual und arbeite daran, die Wirtschaft zu einem geringeren Kohlenstoffverbrauch zu führen. Der Fehler der Malthusianer ist es, das Problem zu überschätzen und die menschliche Fähigkeit zu Innovationen zur Lösung des Problems zu unterschätzen. Die Wirtschaft sucht immer nach Wegen, bessere Erzeugnisse billiger zu machen. … Wie die bisherige menschliche Innovationsfähigkeit zeigt, ist die Geschichte auf Seiten der Optimisten.

Vorschlag 2:

Der Erfolg eines jeden Programms zur Entwicklung von Infrastrukturen sollte virtuell garantiert werden, um den Verbrauch seltener Ressourcen zu rechtfertigen. Es wäre besser, gar nicht erst anzufangen als mit einem Projekt zu beginnen, das eine große Wahrscheinlichkeit des Scheiterns aufweist. Gescheiterte Projekte im Bereich Infrastruktur hinterlassen oftmals Beweise des Scheiterns, über die man sich noch Jahrzehnte lang lustig macht: Beispiele sind die verfallenden Windmühlen und Solarpaneele in der Mojave-Wüste, aber auch Autobahnen, die irgendwo im Nichts aufhören oder anfangen.

Danach in diesem Abschnitt beschreibt der Autor die vielen Zusatzkosten bei Erneuerbaren, die offiziell nicht genannt werden, und die vielen Möglichkeiten des Betrugs, denen hiermit Tür und Tor geöffnet werden.

Vorschlag 3:

Menschliche Eigenschaften und persönliches Verhalten sind beide wichtig. Die Mehrheit der Weltbevölkerung lässt sich nur einmal davon überzeugen, dass die Gefahren der Zukunft real sind – und während der letzten beiden Jahrhunderte haben zu viele Malthusianer zu laut gebrüllt, nur um umfassend widerlegt worden zu sein. … Die öffentliche Haltung zu Rauchen auf öffentlichen Plätzen sowie zu Trinken und Fahren hat sich während der letzten 40 Jahre geändert, gefolgt von der entsprechenden Gesetzgebung.

Im letzten Absatz dieses Abschnitts zählt Kelly die vielen Nachteile der derzeitigen Politik auf, und dass es unmoralisch ist, von den Menschen einen so hohen Preis bzgl. Einschnitte in ihren Lebensstandard zu fordern. Der Absatz endet mit:

Die führende Rolle Europas hinsichtlich Dekarbonisierung bestraft die europäische Wirtschaft, während China und Indien mit der rapiden Ausweitung ihres Kohlestromes fortfahren. Zu der Zeit, zu der die Entwicklungsländer einer Low-Carbon-Wirtschaft zustimmen, sollten die entwickelten Länder ausgereifte und ökonomische Alternativen zu fossilen Technologien für die globale Verteilung bereithalten. So weit sind wir noch nicht, und wie es aussieht, werden wir vor dem Jahr 2030 auch nicht so weit sein.

Schlussfolgerungen

Der gegenwärtige Ablauf der Low-Carbon-Technologien auf der Welt wird ausgesprochen falsch verstanden. Frühere Generationen haben die Warnungen der Experten hinsichtlich des bevorstehenden Untergangs ignoriert, und bislang haben sie gut daran getan. Höchstwahrscheinlich wiederholt sich Geschichte. Ohne wesentliche soziale Verwerfungen haben sich die Niederländer an steigende Meeresspiegel in früheren Jahrhunderten angepasst, und dies sollte als Modell für die Zukunft gelten. Soviel Anpassung wie nötig sollte verfolgt werden, während meiner Ansicht nach die Notwendigkeit der Abschwächung [des Klimawandels] durch Dekarbonisierung der Wirtschaft weiterhin unbewiesen bleibt, zumindest angesichts des Fehlens irgendwelcher zuverlässigen Technologien, die das Problem im globalen Maßstab lösen würden.

Michael J Kelly FRS FREng is Prince Philip Professor of Technology, Department of Engineering, University of Cambridge.

Übersetzt und bearbeitet von Chris Frey EIKE