EIKE war natürlich auch dabei, wenn auch nicht aufs Podium gebeten. Für die, dank der Überzahl der Protagonisten, etwas undankbare Rolle des Klimarealisten war Dr. Peter Heller vom Science Sceptical Blog eingeladen. Die anderen waren Hans von Storch, Klimaforscher vom Helmholtz-Zentrum Geesthacht Zentrum für Material- und Küstenforschung, , Andreas Hense, Professor für Klimadynamik von der Universität Bonn, Oliver Geden von der Stiftung Wissenschaft und Politik sowie Frank Driescher von der Wochenzeitung Die Zeit.

Bild rechts: Die Podiumsteilnehmer; mit Diskussionsleiter Jens Peter Wiarda Bild Focus@Helmholtz

Den Auftakt -heute Impulsvortrag genannt- und damit die Debatte lenkend, machte Prof. Hans v. Storch mit einem kurzen Überblick über die, seiner Meinung nach, bestehenden Gemeinsamkeiten und Unterschiede zwischen den Klimarealisten -von ihm Klimaskeptiker genannt- und den Klimaalarmisten oder Befürwortern der Hypothese vom anthropogen induzierten Klimawandel. Sein Vortrag lässt sich kurz zusammenfassen mit seiner Aussage:„Die Erderwärmung ist ein Fakt und ohne die ebenfalls zu beobachtende Zunahme der Treibhausgase ist sie wissenschaftlich nicht zu erklären“.

Das war eine starke Aussage. Besonders der zweite Teil. Sie wurde noch unterstützt durch die Behauptung von Storchs, dass die Zustimmung der Klimawissenschaftler in den 80 bis 90er Prozentbereich lägen [1]. Und so wurde sie auch verstanden, denn Widerspruch vom Podium erhob sich nicht. Denn immerhin ist von Storch nicht irgendwer, sondern einer der Platzhirsche, dessen „Markenzeichen“ in demonstrativer Herablassung samt einer gegenüber der IPCC konformen Klimaforschung kritischen Haltung besteht.

Er begründete seine Meinung mit einigen wenigen Folien, von denen zwei hier ausschnittsweise gezeigt werden. Denn sie waren symptomatisch für die Art seiner und der IPCC Beweisführung.

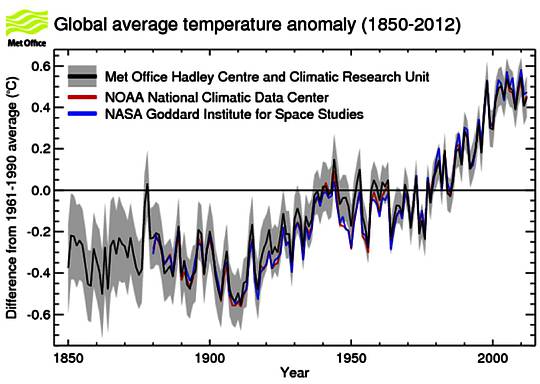

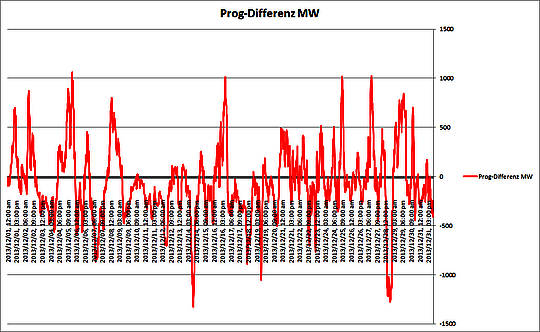

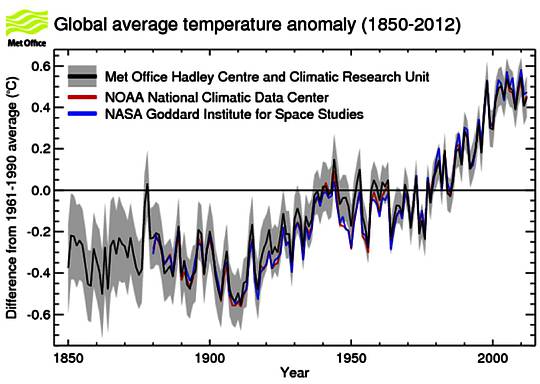

Abbildung 1: Anomalie der globalen Mitteltemperatur Quelle UK Metoffice

Den Anfang machte, wie immer, eine Kurve, wie die in Abbildung 1, welche die Erwärmung im letzten Jahrhundert bezogen auf einen Referenzwert um ca. 0,8 K zeigte. Das zeige –so v. Storch- den „Klimawandel“ deutlich. Schon in diesem Zusammenhang ist bemerkenswert, dass die Frage, ob denn diese Erwärmung des 20. Jh., gemessen an den in zahlreichen Proxy-Reihen abzulesenden Erwärmungsphasen der letzten 2000 Jahre, überhaupt als ungewöhnlich angesehen werden darf, offenbar überhaupt nicht bekannt ist. Nach unserer Kenntnis der Fachliteratur liegt die Erwärmung im 20. Jh. im Normalbereich der Vergangenheit. So zeigt beispielsweise die Reihe von Büntgen et al. (Science 331, 578, 2011), die eine Zusammenfassung unzähliger Baumringreihen, zurückgehend bis 500 vor Chr. darstellt, die Reihe von Christiansen und Ljungqvist (Clim. Past, 8, 2012), die eine Zusammenfassung von etwa 100 Einzelproxies wie Stalagmiten, Baumringen, Sedimenten etc. zurückgehend bis 0 n.Chr. ist und Einzelreihen wie die Stalagmitenkurve von A. Mangini (Earth & Planetary Science Letters 235, 2005), dass die Erwärmungsphase des 20. Jahrhunderts sowohl in ihrer Zeitlänge und ihrer Stärke in der Vergangenheit oft übertroffen wurde. Auf diese wichtige Beobachtung wurde jedoch nicht eingegangen. Richtig war allerdings seine Aussage, dass diese Kurve selber nicht umstritten sei.

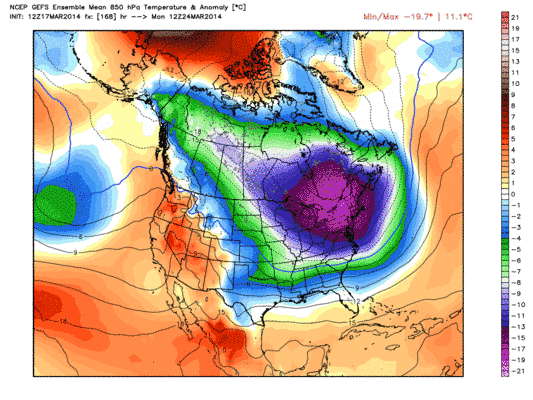

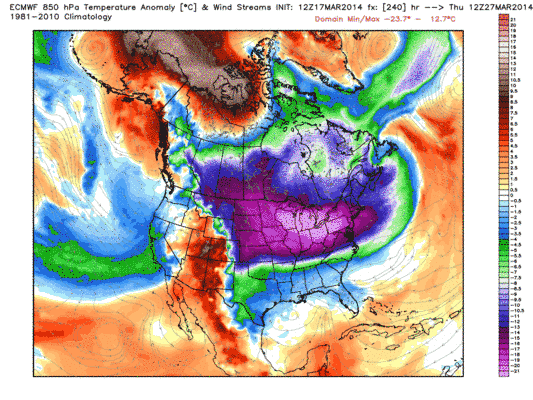

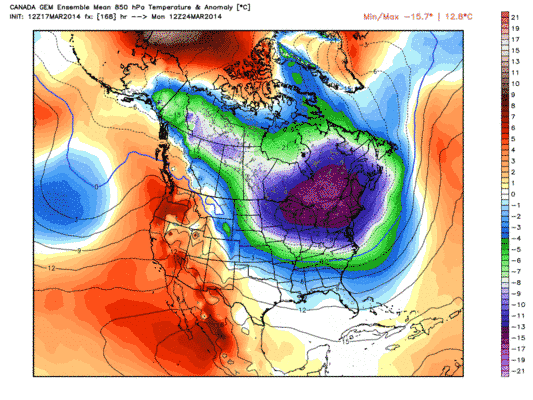

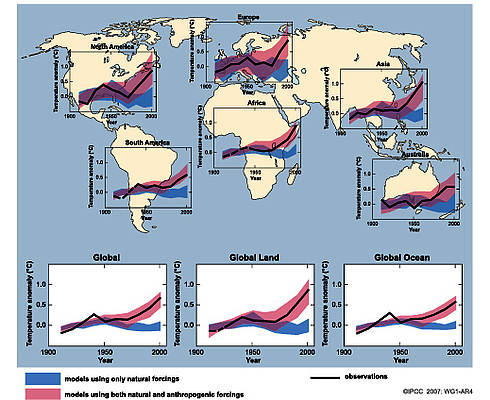

Dann zeigte v. Storch eine Abbildung, die der hier gezeigten ähnelt.

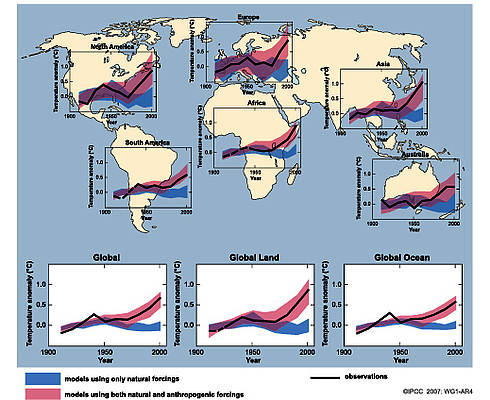

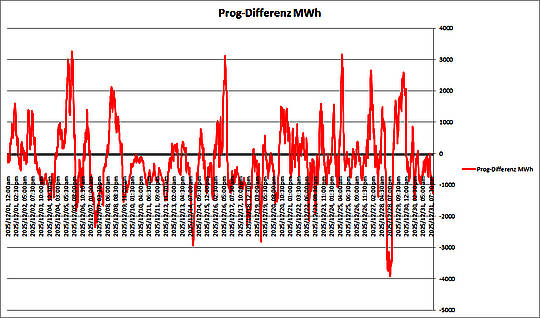

Abbildung 2: Modellberechnungen für verschiedene Kontinente des jeweiligen Verlaufs der Mitteltemperatur mit und ohne die Annahme der Wirkung der Treibhausgase (gemeint war immer als stärkster Treiber CO2 (Quelle: IPCC AR4 4)

V. Storch erklärte beispielhaft, dass man sich einig sein, dass sozusagen das Geld von der Bank weg sei, und meinte damit die beobachtete Erwärmung (darüber besteht, zumindest was die terrestrischen Stationen anbelangt, Einigkeit zwischen den Parteien) im letzten Jahrhundert und man sich jetzt nur noch um die Frage kümmern müsste, wer denn in den Kreis, der als Bankräuber zu verdächtigen, gehörte.

Und wie in Abbildung 2 gezeigt, würden die Klimamodelle eindeutig zeigen, dass der Temperaturanstieg allein aus natürlichen Ursachen heraus nicht erklärlich sei, erst die Zufügung von Treibhausgasen zu der beobachteten Erwärmung führen gäbe die gesuchte Erklärung. Wir können diese Erwärmung, so v. Storch, anders nicht erklären.

Soweit so plausibel, oder?

Jedenfalls sahen es die Podiumsteilnehmer so, denn Widerspruch zu diesem absurden logischen Schluss (man kennt den wahren Grund nicht, schließt wichtige potentielle Ursachen zudem aus, ergo muss er das anthropogene CO2 sein) erhob sich nicht.

Doch wenn man etwas tiefer in diese Art der Beweisführung – die gern die Ausschließtheorie genannt wird, wie wir sie von jedem Tatort im Fernsehen kennen- einsteigt, dann stellen sich dem interessierten Beobachter sofort die folgenden Fragen.

1. Wie viele und welche „Verdächtige“ wurden einbezogen? War der/die Haupttäter überhaupt dabei?

2. Wie wurden die Modelle programmiert. Müssen sie nicht den einprogrammierten Einfluss der Treibhausgase zeigen, weil ihr Programm, ihre Start- und Laufbedingungen genau dies vorsieht?

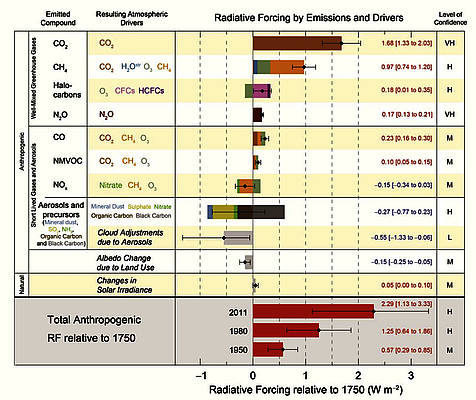

Zur Beantwortung dieser Fragen schauen wir uns an, welche „Verdächtige“ (Forcings) in die Modellläufe einbezogen werden. Beim IPCC werden wir fündig.

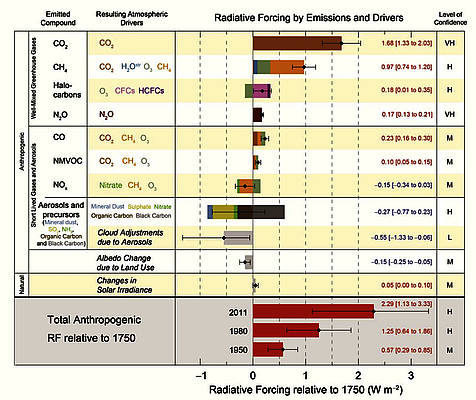

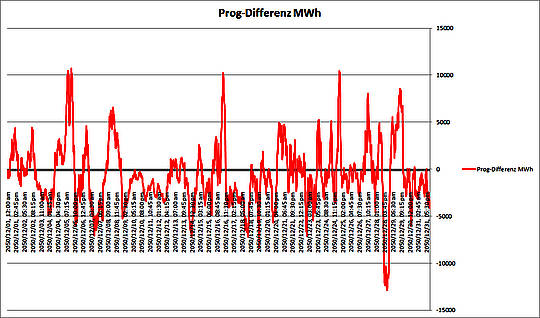

Abbildung 2: Art, Anzahl und Einfluss der Forcings lt. IPCC AR5 (Quelle Fig SPM 5 IPCC WG1 SPM)

Zur Frage 1

In Abbildung 2 erkennen wir insgesamt nur 12 Einzel- oder gruppierte Verdächtige (Forcings). Doch das stärkste Treibhausgas -nämlich der Wasserdampf- fehlt völlig. Und auch der vielfältig dokumentierte, in vielerlei Ausformungen vorhandene solare Einfluss, wie er z.B. in „die kalte Sonne“ ausführlichst und mit sehr vielen Quellen belegt, beschrieben wird, ist nur mit mickrigen 0,05 (Bandbreite 0,00 bis 0,10) Wm-2 erwähnt. Also nur mit einem Bruchteilchen von 2.2 % der „gut bekannten“ anthropogenen Einflüsse.

Zudem wird behauptet, diese Abbildung zeige den Zuwachs seit 1750, so tuend als ob man diese Zahlenwerte schon für 1750 mit hinreichender Genauigkeit kennen würde. Doch das soll uns hier jetzt nicht interessieren.

Wir können also zunächst festhalten, dass die Suche nach dem „Bankräuber“ sich von vornherein auf wenige „Sollverdächtige“ konzentriert, aber die Hauptverdächtigen Sonne und Wasserdampf -aus welchen Gründen immer- gar nicht erst gesucht werden.

Aus meiner Sicht ein klassischer Fall von Justizirrtum, man kann auch sagen Schauprozess, der uns da vorgeführt wird. Beweiskräftig, wie es nun mal die Wissenschaft normalerweise verlangt, ist das jedenfalls nicht. Besser eine versuchte Irreführung. So etwas funktioniert wohl nur in der zur „Königsdisziplin“ erhobenen Klimawissenschaft.

Zur Frage 2

Stellen Sie sich vor, sie schreiben ein einfaches Computermodell zur Lösung der Aufgabe wie man 2 Äpfel und 2 Äpfel addiert. Das Ergebnis würde immer 4 lauten. Und da sie Zahlen nach einer bestimmten Regel berechnen, ist es egal, ob sie Äpfel, Birnen, Kirschen addierten. Der Computer kommt immer zu dem Ergebnis 4. So ist er programmiert und das würde auch stimmen.

Nun werden sie aufgefordert doch bestimmte Rücksichten zu nehmen, aus einem wichtigen Grunde solle immer 5 statt 4 herauskommen, wenn eine bestimmte Zutat dazu gegeben würde. Sie programmieren also

2+2 = 4 + (wenn…; dann) 1

Dann rechnet ihr Programm, oder Modell, immer dann 5 aus, wenn diese Bedingung erfüllt ist. Diese Bedingung heißt bei den IPCC Klimamodellierern

„Wenn Treibhausgas CO2 in bekannter Konzentration vorhanden; dann 5, wenn nicht, dann 4″

Also wird ihre Modell genau nach dieser Vorgabe rechnen. Übertragen auf unseren Fall heißt das, mit CO2 gibt’s eine Temperaturerhöhung, ohne CO2 gibt’s keine. Nun ist völlig klar, dass Klimamodelle um Größenordnungen komplizierter sind, als das oben angeführte Simpelmodell. Die Einflussgrößen sind weit zahlreicher, ihre Verknüpfungen Legion. Aber das Grundprinzip bleibt dasselbe. Der Computer rechnet das aus, wie und was ihm vorgegeben wird

Und da Sie -ihrem Gründungsauftrag [2] folgend nur die menschlichen Einflüsse zu untersuchen und zudem deren zuvor festgelegte „Gefährlichkeit“ zu bestimmen, und Sie die wichtigsten „Verdächtigen“ vorn vornherein ausgeschlossen haben, kann Ihre Beweisführung nur zu einem Schuldspruch für CO2 führen.

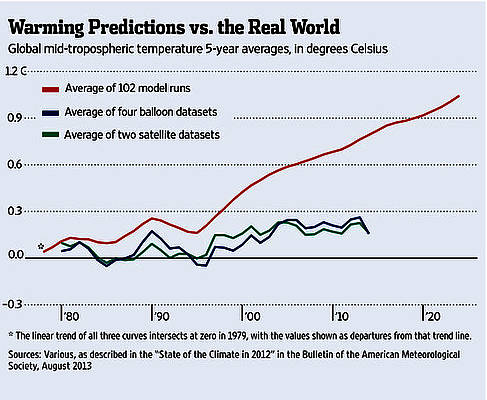

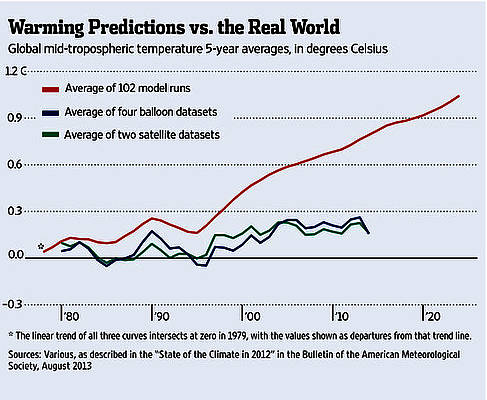

Dumm nur, dass sich die Messungen (so wie die oben erwähnten Proxy-Reihen), die Natur und zunehmend mehr Klimawissenschaftler nicht mehr an diese Vorgaben halten. Abbildung 3 zeigt dies deutlich.

Abbildung 3: Vergleich der Mittelwerte der globalen Temperaturanomalie gemessen mittels Satelliten und Radiosonden mit dem Mittelwert der sich auch 100 Modellläufen ergibt. Die Abweichungen könnten nicht größer.

Es soll nun keineswegs behauptet werden, dass auch nur einer der Anwesenden wissentlich oder gar vorsätzlich diese voreingenommene Art der Beweisführung verfolgen würde, aber die normale Logik, verbunden mit etwas Recherche, lässt keinen anderen Schluss zu, als dass wir hier alle hinters Licht geführt werden. Vermutlich ungewollt, wenn man sich die oft beeindruckende Vita der Beteiligten anschaut.

Deswegen lautet die eigentliche Frage, die das Podium hätte klären müssen:

Wem sollen wir glauben?

Im Einführungstext ist diese Frage – wenn auch vermutlich anders gemeint- gestellt worden. Beantwortet wurde sie nicht. Von keinem!

Wer daher zur Klärung der Sache etwas beizutragen wünscht, möge ich melden. Sachliche Kommentare werden gern entgegen genommen.

[1] Legates et. al 2013 fanden heraus, dass der z.B. von Cook angeführte Konsens mit der Standard-Definition: „dass der Mensch das meiste der Erwärmung nach 1950 verursacht hat“, selbst unter dieser schwächeren Definition unter den veröffentlichten wissenschaftlichen Studien der Konsens nicht 97,1% betrug, wie Cook behauptet hat, sondern nur 0,3%. Näheres dazu hier: http://www.eike-klima-energie.eu/klima-anzeige/cooks-97-prozent-widerlegt-durch-eine-neue-begutachtete-studie/

[2] Gründungsauftrag des IPCC http://www.ipcc.ch/about/index.htm: Dort steht: „Das IPCC wurde gegründet, um die (politischen) Entscheidungsträger und andere Interessierte Personen über den Klimawandel mit einer objektiven Quelle von Informationen über den Klimawandel zu versorgen. Das IPCC betreibt weder Forschung noch überwacht es Klimadaten oder Parameter. Die Aufgabe des IPCC ist es, auf einer umfassenden, objektiven, offenen und transparenten Grundlage der neuesten wissenschaftlichen, technischen und sozioökonomischen Literatur weltweit das Risikoverständnis des vom Menschen verursachten Klimawandel, seine beobachteten und der zu erwarteten Auswirkungen und Optionen für eine Schadensbegrenzung zu bewerten. IPCC-Berichte sollten politisch neutral sein, auch wenn sie objektiv politisch-relevante wissenschaftliche, technische und sozioökonomischen Faktoren behandeln. Die IPCC-Berichte sollten von hohem wissenschaftlichen und technischen Standard sein und sollten das Ziel haben, eine Reihe von Ansichten, Know-how und die breite geografische Abdeckung zu reflektieren. “ (Fettmarkierung und Unterstreichung im Text von Verfasser vorgenommen)