Die LNT Hypothese bedeutet, dass jede noch so kleine Strahlendosis ein Gefahrenpotential darstellt und wurde auf der Basis eines damals nicht bekannten Selbstheilungs-Mechanismus der Zellen eingeführt.

Da in wachsender Zahl über Untersuchungsergebnisse berichtet wird, die zeigen, dass schwache Dosen ionisierender Strahlung nicht nur keinen nachweislichen Schaden anrichten sondern im Gegenteil gesundheitsfördernd sein können, steht die LNT Hypothese auf zunehmend unsicheren Füssen und sollte dringend überarbeitet werden, um eine unnötige Verunsicherung der Bevölkerung zu vermeiden1-3.

Immerhin wird in über 3000 Berichten über einen positiven Gesundheitseffekt kleiner Strahlungsdosen berichtet (Luckey4).

Die allgemein existente Angst der Bevölkerung vor jeder Art von Strahlung behindert den medizinischen, wissenschaftlichen und technischen Einsatz von Prozessen, bei denen ionisierende Strahlung entsteht, vernichtet Menschenleben und führt zur Vergeudung von Billionen € für Stilllegungen von Kernkraftwerken, Rückbau von Anlagen, Abfallmanagement von radioaktivem Material, Umstellung der Energieversorgung etc.

Ionisierende Strahlung erzeugt Radikale, d.h. kurzlebige Molekülbruchstücke, die Körperzellen und Erbgut beeinträchtigen können. Es gibt keinen Zweifel daran, dass hohe Dosen stark gewebeschädigend sind. Neuere Untersuchungen zeigen jedoch, dass Strahlungsdosen unter einem Schwellenwert von 200 mSv nicht nur keine Gesundheitsschäden verursachen, sondern im Gegenteil gesundheitsfördernd sein können. Die Tatsache, dass die Menschheit seit dem Beginn ihrer Entstehung einer kontinuierlichen Bestrahlung mit ionisierenden Strahlen ausgesetzt ist, ließ auch kaum ein anderes Ergebnis erwarten.

Molekularbiologen führen diesen Vorgang darauf zurück, dass geringfügige Strahlungseinflüsse einen Reparaturprozess am DNA- Molekül aktivieren, der auch vor zukünftigen Schäden schützt.

Als Risiko hat die Internationale Strahlenschutzkommission (ICRP) die Wahrscheinlichkeit des Auftretens von Schäden nach einer Strahleneinwirkung bei der Einzelperson durch eine einfache Formel:

R = 0,05/1Sv

festgelegt.

Sie gilt ohne Schwellenwert und ohne zeitliche Begrenzung.

Diese Formel sagt aus, dass bei einer Ganzkörperbestrahlung von 1 Million Menschen mit 4 mSv innerhalb der nächsten Jahrzehnte 200 Menschen (0,02 %) zusätzlich von Leukämie oder Krebs befallen werden. Zur richtigen Einordnung dieser auf den ersten Blick erschreckenden Zahl muss allerdings berücksichtigt werden, dass allein 2010 in Deutschland 220.000 Menschen an Krebs starben. Bei einer Bevölkerung von 80 Millionen also 2,75%. Die Rechnung ergibt also eine Erhöhung von 2,75% auf 2,77%, wenn alle zusätzlichen Krebserkrankungen tödlich enden. Solche Unterschiede sind statistisch kaum zu ermitteln.

Die Formel regt jedoch auch zu missbräuchlichen Interpretationen an, da das relativ kleine Risiko, multipliziert mit einer großen Bevölkerungszahl eine große Zahl von „Krebsopfern“ ergibt, mit denen Horrorszenarien aufgebaut werden. Aus 1 Million Menschen, die nach einer Bestrahlung mit 1 Sv jeweils mit einer Wahrscheinlichkeit von 0,05% betroffen sind, werden reale 500 Krebstote. Oder noch abstruser : Der radioaktive Niederschlag nach den Kernwaffentests hat angeblich zu einer Erhöhung der Hintergrundstrahlung auf der Erde um 1 mSv geführt, bei 7 Milliarden Menschen auf der Erde also zu 350.000 zusätzlichen Krebstoten.

Da von der ICRP einer über lange Zeit aufsummierten Dosis das gleiche Risiko zugeordnet wird wie einer kurzzeitigen Belastung gleicher Stärke, muss die LNT Hypothese bei geringen Dosen auch aus einem weiteren Grund zu falschen Ergebnissen führen. Das Immunsystem eines lebenden Organismus kann einen Schaden umso besser abwehren kann, je länger die Zeit ist, über die die Dosis verteilt ist.

Diese Erfahrungen sind bei Beeinflussung durch Licht, Chemikalien, Bakterien und Viren bekannt, nur bei der Strahlung wird dieser Effekt offiziell nicht zur Kenntnis genommen, obwohl der menschliche Organismus auf der Erde überall einer ionisierenden Bestrahlung ausgesetzt ist, die in Deutschland5 für jeden Einwohner im Mittel ca. 4 mSv pro Jahr beträgt.

Die in Deutschland lebenden 80 Millionen Menschen erhalten damit bis zu ihrem 80. Lebensjahr im Mittel (40 Jahre) eine Dosis von ca. 160mSv. Nach der Formel des ICRP müssten in Deutschland durch ionisierende Strahlung jedes Jahr pro Million Einwohner 8000 Menschen jährlich von Leukämie oder Krebs neu befallen werden, also insgesamt 640.000 Menschen. Bei einer Heilungsrate von 50% würden 320.000 Todesfälle pro Jahr in Deutschland allein auf den Einfluss ionisierender Strahlung zurückzuführen sein. Laut deutscher Krebsstatistik und einer Harvard- Untersuchung6 sind jedoch nur 1,5% der 2010 durch Krebs erfolgten 220.000 Todesfälle auf die Einwirkung ionisierender Strahlung zurückzuführen, also 3300 Todesfälle, 1% des Vorhersagewertes nach dem ICRP Modell!

Dieser Widerspruch allein sollte zum Nachdenken darüber anregen, ob die LNT Hypothese ohne Einschränkung gilt.

Geringe Dosen schädlicher oder giftiger Substanzen können eine positive Wirkung auf den Organismus haben, ein Effekt, der in der Medizin unbestritten ist und zur Heilung eingesetzt wird. Die Giftwirkung setzt erst ein, wenn eine gewisse spontan eingenommene Dosis überschritten wird. Auch über einen Gewöhnungseffekt des menschlichen Organismus an geringe Dosen besteht kein Zweifel. Wenn das nicht so wäre, würde jedes Glas Wein ein Schritt in Richtung Selbstmord durch Alkohol sein, was ein übermäßiger Alkoholgenuss ohne Zweifel ist.

Dem Menschen wird jedoch dieser Schutzmechanismus bzgl. der radioaktiven Strahlung abgesprochen, obwohl er seit Beginn seiner Existenz auf der Erde einer anfänglich weitaus höheren Bestrahlung ausgesetzt war und immer noch ist. Kaum eingegangen in die Betrachtungen des ICRP ist die Tatsache, dass in einigen Gegenden der Welt die in Deutschland vorherrschende Bodenstrahlung von 0,47mSv deutlich überschritten wird und Werte von 10 mSv! erreicht (Monazit-Abbaugebiete in Kerala, Indien), ohne feststellbar erhöhte Krebs- und Leukämieraten.

Doch nicht nur in Indien findet man bewohnte Gebiete mit hoher natürlicher Strahlung. Yangjiang in China, Guarapari in Brasilien und Ramsar im Iran sind weitere bekannt Gebiete mit sehr hoher natürlicher Strahlung.

In Ramsar liegt die mittlere Strahlenbelastung bei 10 mGy pro Jahr, einige Gebiete der Stadt mit ca. 2000 Einwohnern weisen eine Strahlenbelastung bis zu 260mGy pro Jahr aus.

Eine Strahlendosis von 100 mSv pro Jahr stellt nach deutschen Richtlinien den Eingreifrichtwert für eine Umsiedlung der betroffenen Bevölkerung dar, da angeblich mit einer steigenden Krebsrate und Genschäden zu rechnen ist. Die Bewohner von Ramsar leben seit vielen Generationen mit dieser hohen Hintergrundstrahlung, die nach dem LNT- Modell genetische Abnormitäten und ein erhöhtes Krebsrisiko bedeuten. Da im allgemeinen davon ausgegangen wird, dass ca. 1,5% aller Krebsarten von ionisierender Strahlung hervorgerufen werden, müssten im Laufe der Zeit alle Einwohner Ramsars bereits an Krebs gestorben sein. Die Untersuchungen von S.M.J. Mortazavi, M. Ghiassi-Nejad, P.A. Karam, T. Ikushima, A. Niroomand-Rad, J.R. Cameron7 zeigen jedoch bei zytologischen Untersuchungen keine signifikanten Unterschiede im Vergleich zu Menschen, die unter normalen Umweltverhältnissen leben.

Im Gegensatz zur allgemeinen Ansicht zeigen viele Versuche mit geringen Strahlendosen einen positiven Effekt bezüglich Schutz vor bzw. Verlangsamung einer Krebsausbreitung bei Tierversuchen, wie in den Veröffentlichungen von Sanders8, Doss9, Jolly und Meyer10 berichtet wird.

In seiner Arbeit: „The health effect of low dose ionizing radiation“ zeigt Luckey11 dass ein optimaler Gesundheitszustand bei Säugetieren bei einer Strahlenbelastung von 60 mSv/y erreicht wird, dass das Lungenkrebsrisiko mit steigender Radonbelastung amerikanischer Häuser zurückgeht (Cohen12), dass die Krebs-Mortalitätsrate mit steigender Dosis schwacher Strahlung sinkt und dass mit steigender natürlicher Strahlenbelastung mit rückläufigen Krebserkrankungen zu rechnen ist (Nambi et all13).

In die gleiche Richtung weisen die Ergebnisse einer Untersuchung in Taiwan14 . Dort wurde 1980 in Taipeh mit Co-60 (Halbwertzeit 5,3 Jahre) kontaminierter Stahl in Wohngebäuden verbaut. Erst nach 20 Jahren wurde dieser Fehler festgestellt.

Die anfängliche Bestrahlung erreichte bis zu 900 mSv!! pro Jahr und ließ entsprechend der Halbwertszeit in den Jahren nach. Die mittlere Dosis für alle betroffenen Personen wird mit 400 mSV pro Jahr angegeben.

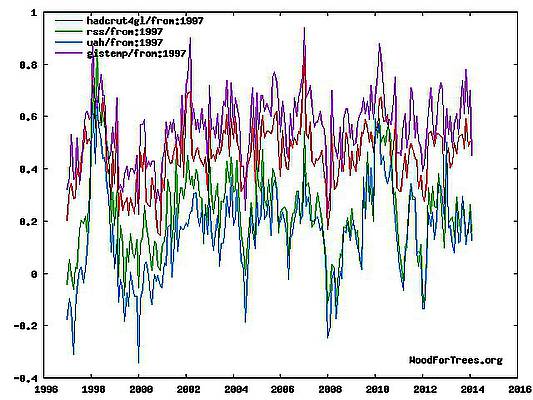

Der Gesundheitszustand der Bewohner wurde nach Bekanntwerden des Baufehlers eingehend auf Krebs, Leukämie und Missbildungen untersucht. Die folgende Abbildung zeigt den Einfluss der Bestrahlung auf die Krebs-Sterberate im Vergleich zum allgemeinen Verlauf in Taiwan.

Die mittlere Mortalitätsrate für Krebs lag in Taiwan in den Jahren zwischen 1983 und 2002 bei 116 Toten auf 100000 Personen- Jahren. Das bedeutet z. B. für 10.000 Personen in einem Zeitraum von 20 Jahren (10000*20*116/100000) erwartete 232 Tote. An Krebs starben von den Bewohnern jedoch nur 3% dieser erwarteten Zahl, obwohl Untersuchungen von S.I Hwang et.all15. zeigten, dass ein Krebsbefall in dieser Gruppe nicht ausgeschlossen ist. Von 7271 Menschen mit 101560 Personen- Jahren unter einer mittleren Strahlenbelastung von 47,8 mSv im Bereich von 1- 2363 mSv wurden 141 Krebsfälle diagnostiziert.

Obwohl viele der Bewohner über lange Zeit eine sehr hohe Strahlendosis erhalten hatten, wurden keine nachteiligen Krankheitssymptome, wie Strahlenkrankheit, deutlich steigende Krebsrate oder Missbildungen beobachtet. Auch Chromosom- Veränderungen konnten ausgeschlossen werden.

Diese Ergebnisse sind ein weiteres Beispiel dafür, dass lebende Organismen in der Lage sind, Schäden durch ionisierende Strahlung zu reparieren und Schutzmechanismen auch gegen Zellschädigungen durch andere Ursachen aufzubauen.

Im Gegensatz zum Anstieg der Krebsrate bei kurzzeitig sehr hohen Dosen (größer 2 Sv), der bei Personen beobachtet wurde, die durch Atombomben geschädigten waren, wurde in Taiwan ein positiver Effekt bzgl. der Gesundheit bei geringeren Dosen schon kurze Zeit nach der Bestrahlung beobachtet, wie die obige Abbildung zeigt.

Diese Ergebnisse widerlegen die allgemein verbreitete und politisch verankerte Annahme, dass jede auch noch so kleine Dosis potentiell schädlich ist. Die Konsequenzen für alle Risikoanalysen in Bezug auf ionisierende Strahlung bei der Anwendung der Kerntechnologie in Medizin und Technik liegen auf der Hand und relativieren die in Deutschland allgemein verbreitete Ansicht, Strahlung sei grundsätzlich gesundheitsschädlich.

Das Gegenteil scheint Realität zu sein, geringe Strahlungsdosen scheinen eine aussichtsreiche Waffe gegen Krebs zu sein und könnten für eine deutliche Reduktion der Sterblichkeitsrate sorgen.

Eine seriöse Überprüfung der LNT Hypothese ist angesagt.

Anstatt aus Angst vor Strahlenschäden Milliarden für die „Energiewende“ auszugeben und sich bzgl. der Energieversorgung mit „Erneuerbaren Energien“ ins Mittelalter zurückzubewegen, sollte man diese Erkenntnisse ernsthaft überprüfen und die Strahlenschutzverordnungen entsprechend anpassen. Die Einführung eines Schwellenwertes, bis zu dem keine Strahlenschäden sondern im Gegenteil positive gesundheitliche Auswirkungen zu erwarten sind, würde die Strahlenschutzmaßnahmen drastisch vereinfachen und Billionen € einsparen, Mittel, die erheblich sinnvoller zur Lösung sozial- und wirtschaftspolitischer Probleme eingesetzt werden könnten.

Über den Autor:

Dr. Jürgen Langeheine ist Diplomphysiker. Sein beruflicher Werdegang verschaffte ihm ein breites Wissen in Physik, Chemie und Verfahrenstechnik. Als langjähriger Vorsitzemder der Geschäftsführung der BASF- Magnetics/ EMTEC sind ihm wirtschaftliche Zusammenhänge geläufig. Dr. Langeheine ist Autor des Buches „ Energiepolitik in Deutschland- das Geschäft mit der Angst“

Zusammen mit seiner Frau wohnt er in Gauting bei München.

Literatur:

1. K. Becker, E. Roth: Zur Wirkung kleiner Strahlungsdosen : atw (10) 616-620, 1998

2. K. Becker: LNT or not LNT that ist he question, Strahlenschutzpraxis 2/2006 ,44-48

3. K. H. Weber: Kritik an der linearen Extrapolations- Hypothese biologischer Strahlenwirkungen

http://leibnizsozietaet.de/wp-content/uploads/2000/07/03_weber_kh.pdf

4. T.D.Luckey, Abundant health from radioactive waste: IntJ LowRadiation 5, 71-82, 2008

5. J. Langeheine: Energiepolitik in Deutschland-das Geschäft mit der Angst, Athene- Media Verlag , ISBN 978-3-86992-054-2

6. Harvard Reports on Cancer Prevention 1996

7. S.M.J. Mortazavi, M. Ghiassi-Nejad, P.A. Karam, T. Ikushima, A. Niroomand-Rad, J.R. Cameron, Int. J. of Low

Radiation, 2006 Vol.2, No.1/2, pp.20 – 27

8. Charles L. Sanders: Radiation Hormesis and the Linear No Threshold Assumption

Springer Verlag, Berlin Heidelberg 2010, ISBN 978-3-642-03719-1

9. M. Doss, Dose Respose, 10;584-592, 2012

10. D. Jolly, J. Meyer, A brief review of radiation hormesis, Austral.Phys. EngSci Med 2009; 32; 180-7

11. T.D.Luckey,The health effect of low dose ionization radiation: J. of American Physicians and surgeons Vol. 13, 2, 39-42

12. B.L. Cohen, The test of the linear no thresthold theory of radiation carcinogenesis for inhaled radon decay products,

Health Phys 1995:68:157-174

13. KSV Nambi, SD Soman. Environmental radiation and cancer deaths in India. Health Phys 1987;52:653-666

14. Dose Response. 2006 Aug 25;5(1):63-75.doi:10.2203/dose-response.06-105.

Effect of cobalt-60exposure on health of Taiwan residents suggest new approach needed in radiation protection

Chen WL, Luan YC, Shieh MC, Chen ST, Kung HT, Soong KL, Yeh YC, Chou TS, Mong SH, Wu JT, Sun CP, Deng

WP, Wu MF, Shen ML.

15. S.L. Hwang,H.R.Guo, W.A.Hsieh, J.S.Hwang, S.D. Lee, J.L.Tang, C.C. Chen, T.C. Chang, J.D. Wang, Dr. W. P. Chang

Intern. J. rad. Boil. 2006 Vol 82 no. 12 ,848-858

*Die Strahlenbelastung wird in Gray Gy ( J/ kg) gemessen und gibt die Strahlungs-( Energie-) Dosis an, die von 1 kg des bestrahlten Materials absorbiert wird. Üblicherweise wird jedoch die biologische Wirksamkeit einer Strahlung mit der Äquivalentdosis bewertet. Diese ist das Produkt aus der Energiedosis und einem dimensionslosen Strahlungsgewichtungsfaktor q und wird in Sv (Sievert) gemessen. da sich der Zahlenwert der Dosisgröße durch den Strahlungswichtungsfaktor auch ändern kann, werden für Energiedosen Gray verwendet, für gewichtete Dosisgrößen Sievert . Der Strahlungsgewichtungsfaktor beträgt für Gamma – Strahlung 1, für Alpha- Strahlung 20. Die Dosisleistung, also die Strahlenbelastung pro Zeiteinheit wird dann durch Gray pro Jahr (Gy/a) oder Sievert pro Jahr (Sv/a) beschrieben. Da 1 Gy oder 1Sv eine sehr hohe Strahlenbelastung darstellt, werden diese Strahlenbelastungen in mGy oder mSv angegeben.