Viele Wärmeinseleffekte führen zur scheinbaren Klimaerwärmung (hier):

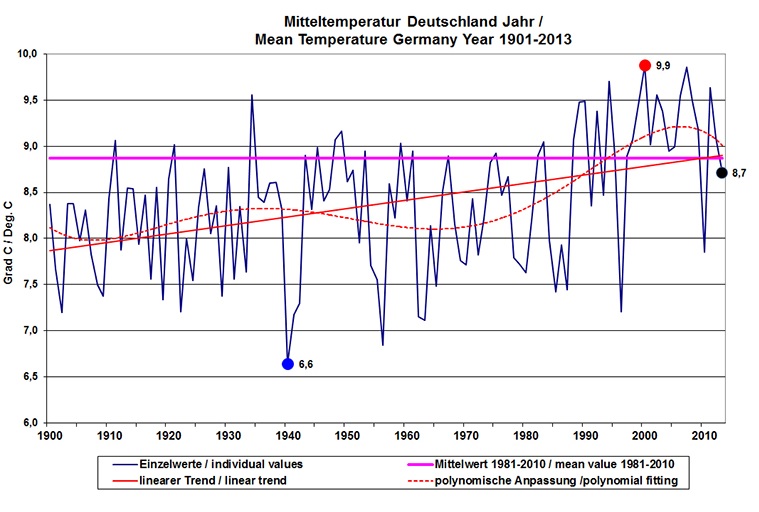

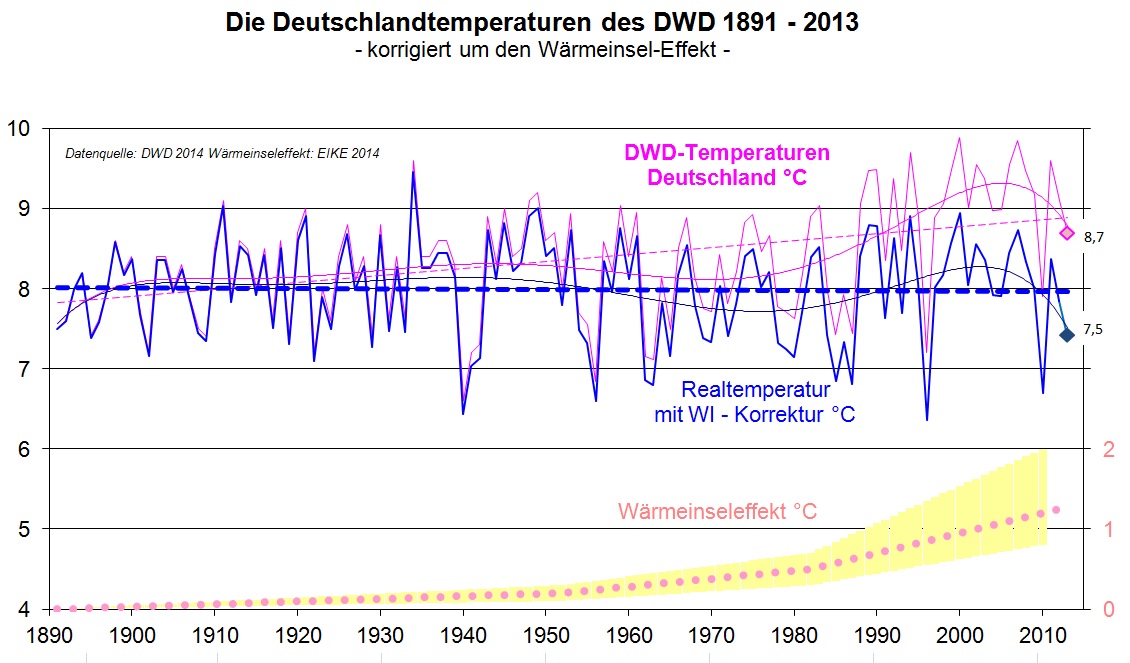

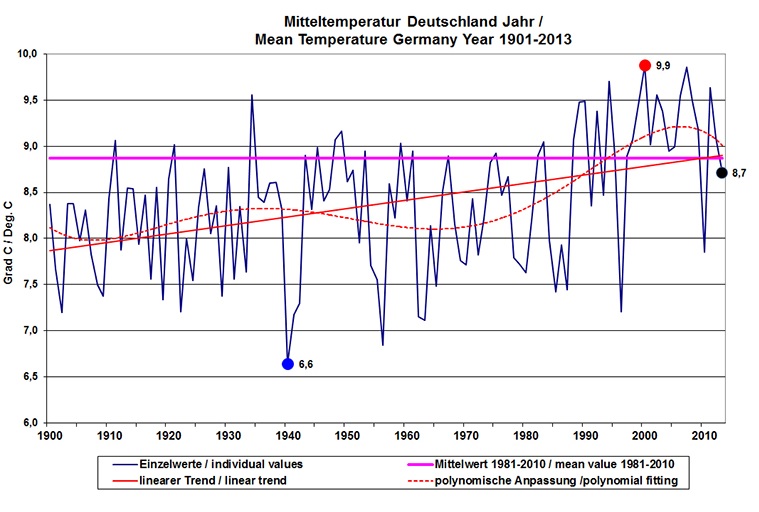

Wie wir in Teil 1 zeigten, fallen seit 17 Jahren nach DWD-Daten die Deutschlandtemperaturen, siehe Abb. 4. und vor 25 Jahren haben die Temperaturen aufgehört zu steigen, siehe Abb. 3. Der Deutsche Wetterdienst (DWD) zeigt daher gerne Grafiken, die über einen längeren Zeitraum gehen, z. B. hier:

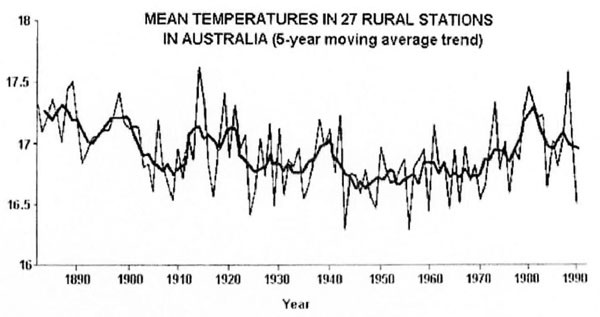

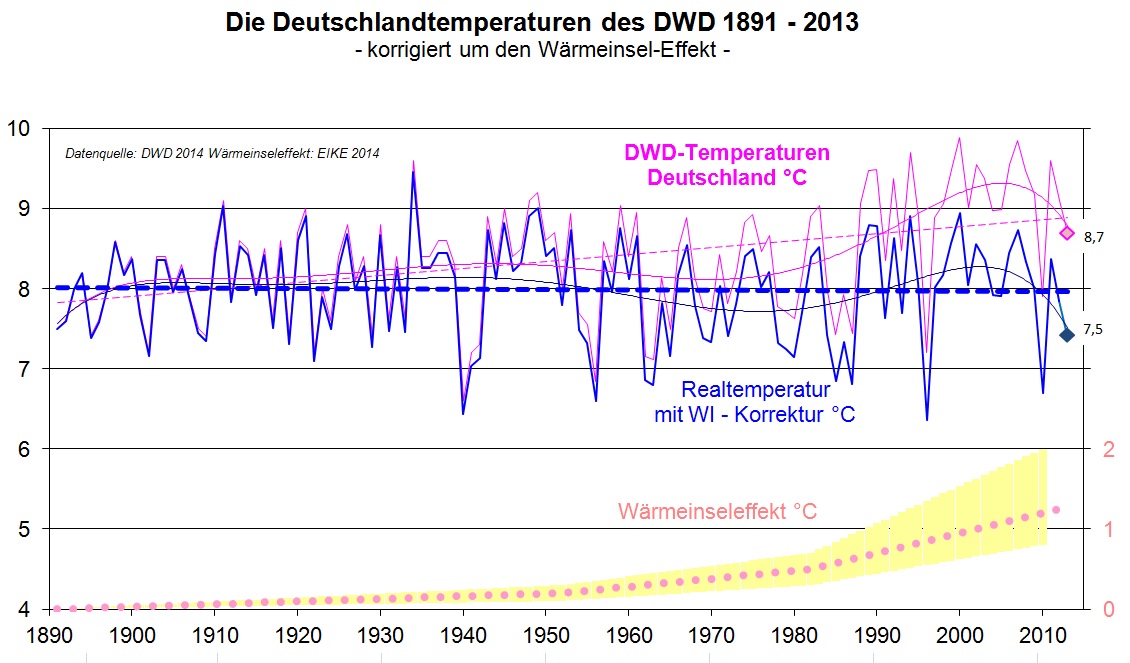

Abb. 8: Werden die Temperaturen Deutschlands über einen langen Zeitraum betrachtet, dann sieht man an den Trendlinien ein allmähliches Ansteigen, also eine allmähliche Temperaturzunahme. Die Befürworter der Treibhausthese führen diese Erwärmung auf den steigenden CO2-gehalt der Luft zurück. Doch das Deutschland von 1900 und das von heute ist nicht mehr dasselbe. Dazu noch zwei widersprüchliche Meldungen vom DWD: „Der langfristige Trend zu steigenden Temperaturen ist in Deutschland und weltweit ungebrochen." (Berlin, 3. Mai 2012, DWD-Presse- Mitt.); aber dann ein Jahr später „Die Erdmitteltemperatur stagniert seit etwa 15 Jahren auf hohem Niveau….." (Berlin, 7. Mai 2013, DWD-Presse- Mitt.). Dass die Deutschland- Temperaturen sogar schon seit einem Vierteljahrhundert nicht mehr steigen, verschweigt uns der DWD.

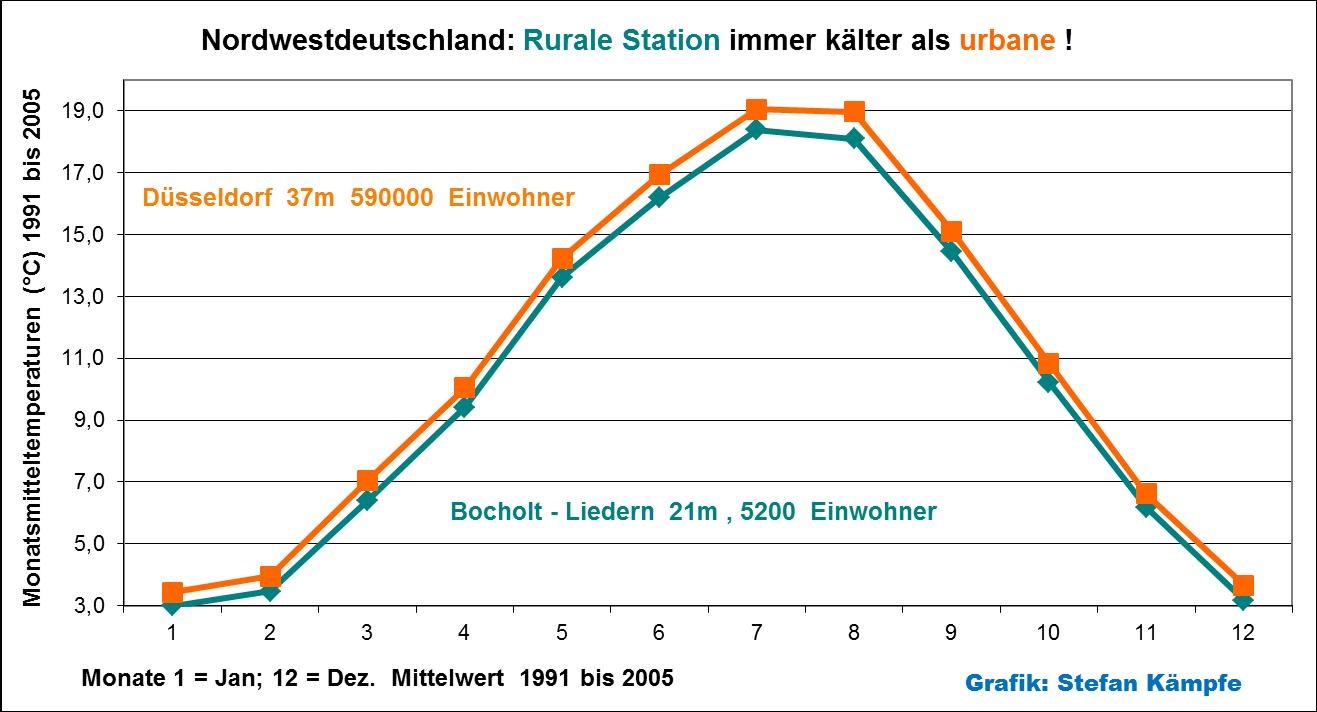

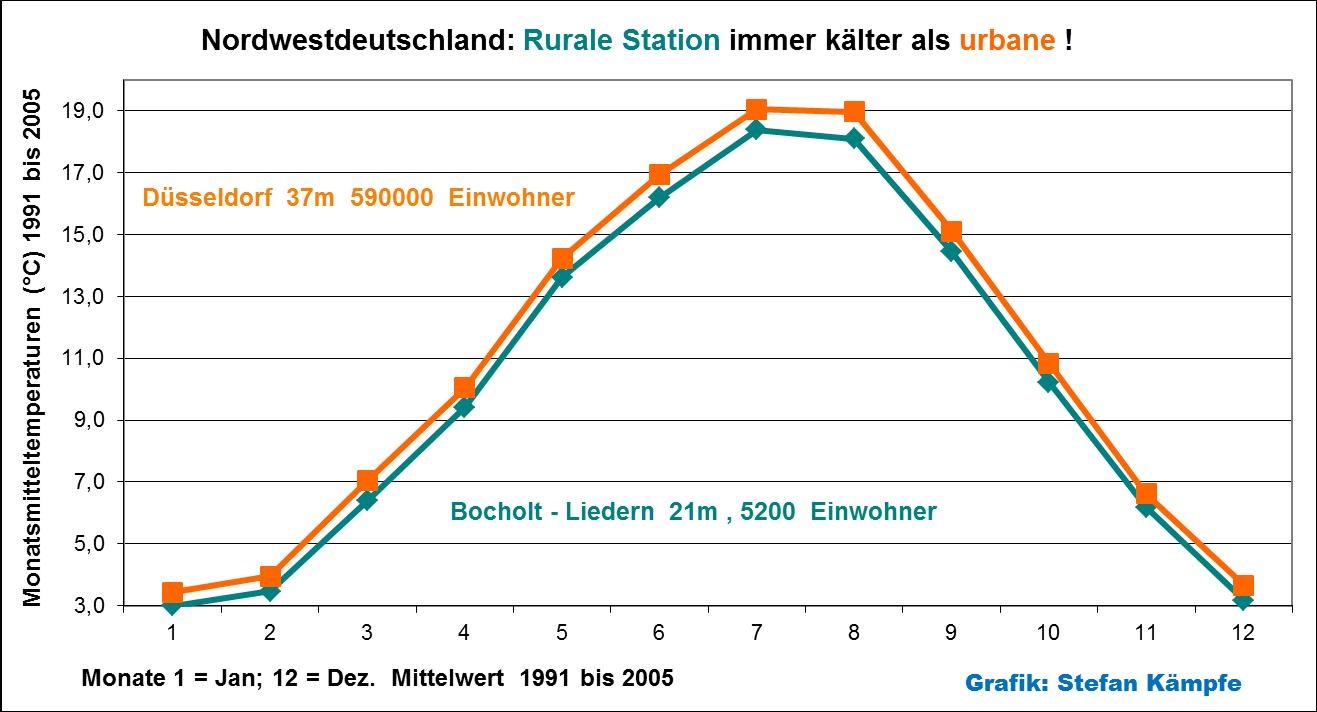

Dass rurale Messstationen (unbebaute oder dörfliche bis höchstens kleinstädtische Umgebung) ein etwas niedrigeres Temperaturniveau als Großstadt- Stationen aufweisen, lässt sich anhand von Vergleichen nachweisen. Voraussetzung eines solchen Vergleichs ist, dass die Stationen eine möglichst identische Höhenlage aufweisen (weil die Lufttemperatur stark höhenabhängig ist) und sie derselben geografischen Region angehören. Dann zeigt sich folgendes Bild:

Abb. 9: Zwei annähernd gleich hoch gelegene Stationen der Region Niederrhein. Die Groß- und Landeshauptstadt Düsseldorf ist in allen Monaten wärmer als das ländliche, nahe der holländischen Grenze gelegene Liedern (ein Vorort der Mittelstadt Bocholt). Im Untersuchungszeitraum (1991 bis 2005) betrug die Differenz der Jahresmitteltemperaturen beachtliche 0,61°C! Quelle des Datenmaterials: DWD, 1991 bis 1998 Beilagen zur Wetterkarte des Deutschen Wetterdienstes, 1999 bis 2005 Witterungsreport.

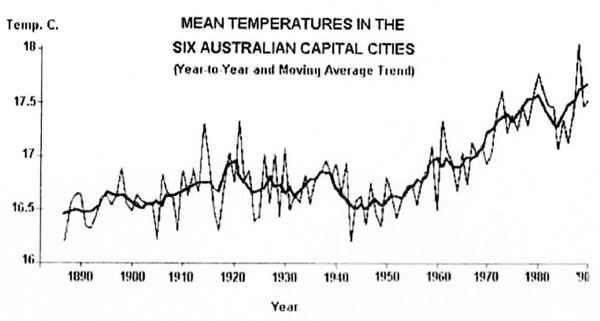

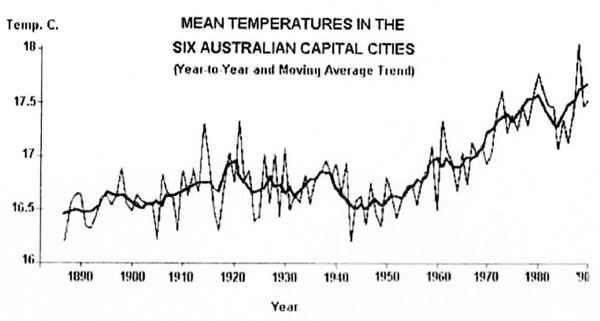

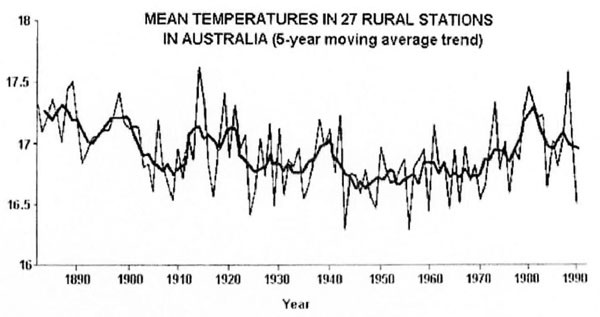

Auch anderswo in der Welt wurde dieser Effekt untersucht, wie folgendes Beispiel von Australien zeigt:

Abb. 10 (Quelle http://www.germanclimateblog.com/de/blogde/blogliste/92-der-urbane-waermeinsel-effekt-verzerrt-die-globalen-temperaturen.html) In Australien hat man das Temperaturmittel der 6 australischen Hauptstädte mit dem von 27 ländlichen Stationen über einen Zeitraum von mehr als 100 Jahren (1880 bis 1990) verglichen. Während in den Großstädten ab etwa 1950 ein deutlicher Temperaturanstieg zu beobachten war (obere Abbildung), zeigt das Mittel der ländlichen Stationen im selben Zeitraum keinen Trend- außerdem war es dort im späten 19. Jahrhundert fast sogar noch etwas wärmer, als im späten 20. Jahrhundert.

Soll also eine realitätsnahe Vergleichsaussage der Temperaturwerte über einen längeren Zeitraum erfolgen, so müssen diese, auf menschliche "Zivilisation" zurückgehenden Einflüsse herausgefiltert werden. Darum ist der zunehmende Wärmeinseleffekt bei Temperaturbetrachtungen so wichtig.

Bekanntlich verändert die Zeit den Raum und mit ihm alle „Eigenschaften“ die diesen Raum bestimmen. Eine dieser (Zustands)-Eigenschaft, wenn wir dies so nennen dürfen, ist dessen Energieinhalt und damit auch dessen Temperatur. Soll nun ein heute gemessener Temperaturwert, mit einem gemessenen Temperaturwert von vor 100 Jahren verglichen werden, muss der Raum von heute, auf den Raum von vor 100 Jahren „angepasst“ werden, weil sonst jede Vergleichsbetrachtung sinnlos ist. Dieser „Raumkorrekturfaktor“ für die Temperatur ist der WI. Ohne seine Berücksichtigung, sind alle Temperaturvergleichsbetrachtungen sinnlos und damit wertlos.

Für die Datenreihe des DWD bedeutet das: Die 9,1°C von 2012 sind in der Vergleichsbetrachtung etwas kälter als die gemessenen 9,1°C von 1998. Warum, weil zusehends Fläche, wir nannten 108 ha pro Tag, der Natur entzogen werden. Auch in den letzten 25 Jahren haben sich die Wärmeinseln in Deutschland weiter ausgebreitet, der die Umwelt wärmende Energieverbrauch ist weiter gestiegen und die Thermometer messen die Zusatzerwärmung aus den größer gewordenen Wärmeinseln der Städte und Bebauungen automatisch mit. Neuerdings wird die Erwärmung mittels der „Energiewende“ weiter verstärkt in der freien Landschaft getragen, denn „Windparks“ bremsen den in Bodennähe kühlenden Wind, und „Solarparks“ wandeln nur etwa 10% der auftreffenden Sonnenenergie in elektrischen Strom um, haben aber wegen der dunklen Oberfläche der Paneele eine geringere Albedo als die freie Landschaft (Rückstrahlungsvermögen, das heißt, sie erwärmen sich deutlich stärker, als gewachsene Böden oder die Vegetation). Vor allem über längere Zeiträume wird es notwendig, einen WI-Korrekturfaktor zu berücksichtigen, denn die Thermometer der Messstationen messen den zunehmenden Wärmeeintrag in die Landschaft einfach mit.

Hinzu kommt, dass vermehrt eine Verlagerung von Messstationen (Leistenschneider/Kowatsch berichteten darüber) in städtische Gebiete und vor allem auf Flughäfen erfolgt. Wegen der wärmenden Abgasschleppen ist dort das Temperaturniveau deutlich angehoben. Wie Leistenschneider/Kowatsch für den Frankfurter Flughafen nachweisen konnten, um bis zu +2,5°C. Gehen solche Stationen in die Mittelwertbetrachtung ein (weltweit kommen die Daten der Temperaturmessungen von über 50% von Flughafenmessstationen), so wird künstlich das Temperaturniveau angehoben.

Um Temperaturen mit früher vergleichen zu können, braucht man eine WI-bereinigte Grafik.

Abb. 11 (Quelle: EIKE, nach Berechnung von Leistenschneider) zeigt den unmittelbaren Vergleich der Deutschlandtemperaturen DWD und der WI-bereinigten von 1891 – 2013. Die blau gestrichelte Linie zeigt den Temperaturmittelwert im Betrachtungszeitraum. Die Temperaturen in Deutschland durchbrechen die Mittellinie nach unten, was bedeutet, dass die heutigen Temperaturen im 120-Jahresvergleich zu kalt sind. Zum berechneten WI wurde, wie dies auch beim IPCC üblich ist, der Fehlertoleranzbereich angegeben (gelb).

Ein Beispiel zum Gebrauch der Grafik: 1891 betrug die Jahrestemperatur 7,5°C und 2013 8,7°C. Der WI-Korrekturfaktor für diesen Zeitraum beträgt etwa 1,2°C. (siehe rote gestrichelte Linie mit Schwankungsbreite). Hätte sich Deutschland in den letzten 123 Jahren nicht verändert und würden die Messstationen auch noch in der gleichen Umgebung stehen wie damals, dann wäre der Jahreswert für 2013 auch im Bereich von 7,5°C (siehe Fehlertoleranzbereich).

Unter Berücksichtigung eines Korrekturfaktors WI kommen wir zum 6. Ergebnis:

Die gemessene Erwärmung in Deutschland seit 120 Jahren ist in erster Linie auf die ständige Zunahme des Wärmeinseleffektes (WI) zurückzuführen, also auf die flächenhafte Ausbreitung der Wärmezonen. Die blaue WI-bereinigte polynome Trendlinie zeigt, dass wir nach einer Phase der Abkühlung wieder bei den Temperaturen um 1900 angekommen sind.

Kürzere Zeiträume

Die letzten 25 Jahre mit Berücksichtigung des WI

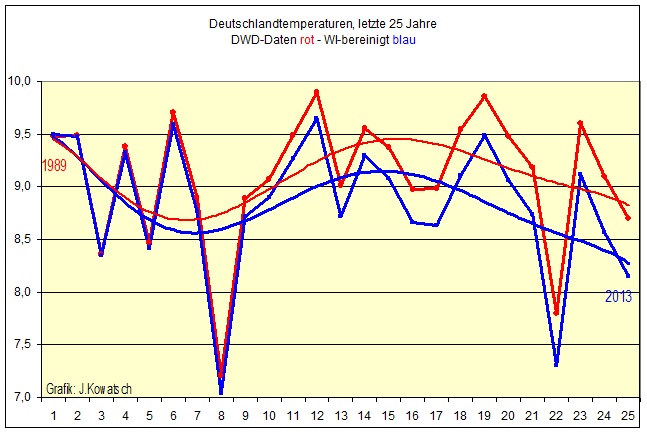

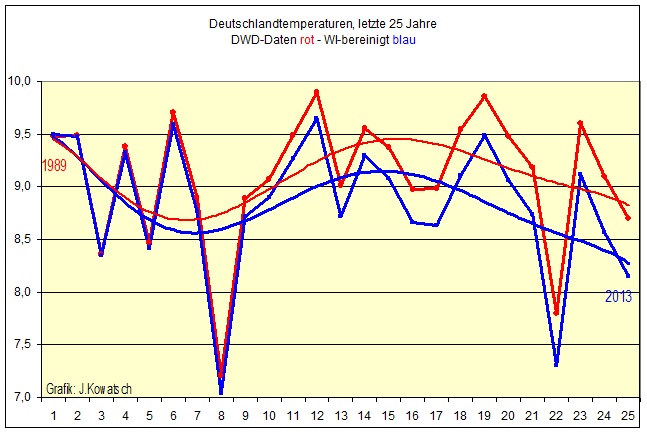

Im Teil 1 zeigten wir, dass die Temperaturen nach Daten des DWD seit 25 Jahren nicht weiter gestiegen sind. Abbildung 12 zeigt im Vergleich den Temperaturgang in Deutschland nach DWD-Daten mit und ohne Berücksichtigung des WI.

In ihrem EIKE-Beitrag Klimaerwärmung in Deutschland nicht nachweisbar: Der DWD hantiert mit falschen Daten – Eine Bestandsaufnahme der Deutschlandtemperaturen aus 2010, wiesen die Autoren nach, dass der WI in Deutschland im 20. Jahrhundert die Vergleichstemperaturen in Deutschland um +1,2°C verfälscht (Abb.11 zeigt die aktualisierte Datenreihe bis zum Jahr 2013). Anhand einer Relationsbetrachtung der Deutschlandtemperaturen und der Referenzstation Hohenpeißenberg und einer theoretischen Betrachtung, die auf zwei fundamentalen physikalischen Gesetzen, den Strahlungsgesetzen nach Planck und dem Abkühlungsgesetz nach Newton basiert, ermittelte Leistenschneider anhand der jeweiligen DWD-Daten diesen Wert. Insbesondere seit den 1980er Jahren ist ein verstärkter WI-Einfluss vorhanden. Er beträgt für die letzten 3 Jahrzehnte +0,6°C. Hieraus lässt sich der mittlere Jahres-WI für diesen Zeitraum statistisch ermitteln und die DWD-Temperaturen, die wir in Abb. 3 und 4 (Teil 1) zeigten, entsprechend dem WI bereinigen, so dass wir die realen Vergleichstemperaturen für Deutschland erhalten. In Abb. 12 und 13 haben wir diese jeweils mit den DWD-Daten verglichen, so dass sichtbar wird, dass im Grunde die DWD-Veröffentlichungen zu Vergleichstemperaturbetrachtungen, wie z.B. wärmster Monat, wertlos und falsch sind, da der DWD in seinen Vergleichsbetrachtungen die bekannten "Äpfel" mit "Birnen" bergleicht und so zu einer falschen Schlussfolgerung kommt, die er dann veröffentlicht.

Abb. 12: In den letzten 25 Jahren sind die Temperaturen in Deutschland unter Berücksichtigung des WI sichtlich gefallen. 1988 betrug die Jahrestemperatur 9,1°C und 25 Jahre später 8,6°C. im Jahre 2012. 1989 war sie 9,5 Grad und unter Einberechnung des WI wäre sie 2013 nur 8,1C, deswegen die fallende Tendenz am Schluss. Dazwischen gab es Phasen von leichten Abkühlungen, aber auch Erwärmungen, momentan liegt wieder ein Abkühlungstrend vor. (gezeichnet in rot nach den Originalangaben des DWD und den von Leistenschneider berechneten WI-Werten in blauer Farbe).

Auch auf 25 Jahre betrachtet, macht sich der WI- Effekt bereits leicht bemerkbar, schließlich werden täglich 108 ha in Deutschland überbaut und der kühlenden Vegetation entzogen. Besonders bemerkenswert ist in diesem Zusammenhang die Entwicklung der Wintertemperaturen. KOWATSCH/KÄMPFE hatten in ihrem Aufsatz http://www.eike-klima-energie.eu/klima-anzeige/winter-werden-in-deutschland-seit-einem-vierteljahrhundert-deutlich-kaelter/ nachgewiesen, dass die Winter in Deutschland wieder deutlich kälter geworden sind- der sehr milde Winter 2013/14 ist da nur eine zirkulationsbedingte Ausnahme, denn die in Deutschland fehlende Kälte war dafür umso reichlicher anfangs im Nahen Osten, dann in Nordamerika zu finden, siehe unter anderem „Extremwetter einmal anders:

In Kairo fiel nach 112 Jahren wieder Schnee bei http://www.eike-klima-energie.eu/klima-anzeige/extremwetter-einmal-anders-in-kairo-faellt-nach-112-jahren-wieder-schnee/ . Selbst die Wochenzeitung „DIE ZEIT“, normalerweise immer darauf bedacht, die katastrophale Klimaerwärmung herbeizuschreiben, gab, wenngleich wohl "zähneknirschend" und auf den hinteren Seiten im Wirtschaftsteil platziert, die winterliche Abkühlung in einem Artikel über die Probleme der alpinen Skigebiete zu: http://www.zeit.de/2013/52/ski-luxus-guenther-aigner

Somit erhalten wir Ergebnis 7

Unter Berücksichtigung eines WI-Korrekturfaktors sind in den letzten 25 Jahren die tatsächlichen Vergleichstemperaturen in Deutschland leicht gesunken.

Die letzten 17 Jahre:

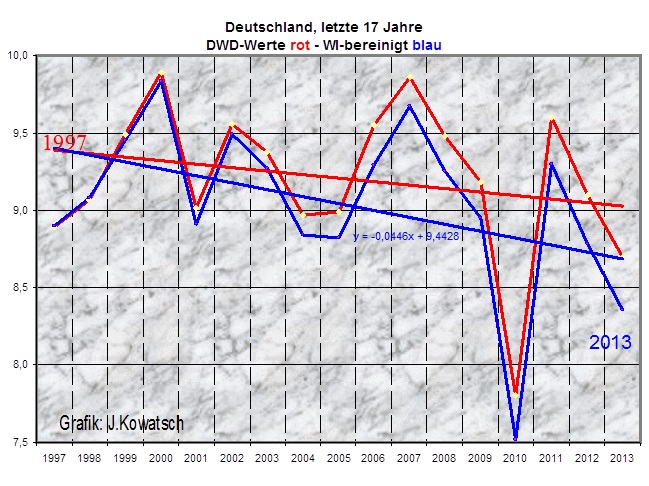

Wie sehen nun die letzten 16/17 Jahre aus, die bereits ohne WI fallende Temperaturen zeigen? Und wohin geht der weitere Trend?

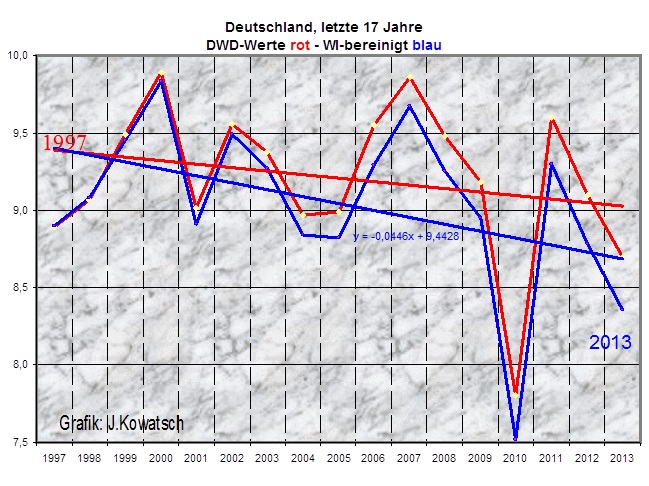

Das Jahr 1997 wird beim DWD mit 8,9C und 1998 mit 9,1 Grad in der Statistik geführt, und 2013 war mit 8,7C unwesentlich kälter.

Ob ein Trend nach oben oder nach unten geht, darüber entscheiden die Jahre dazwischen. Ab 1997 stiegen zunächst noch die Temperaturen bis zur Jahrtausendwende. Das Jahr 2000 war laut DWD-Statistik das wärmste Jahr in Deutschland in den letzten 150 Jahren. Das haben ich wir uns vom Deutschen Wetterdienst auch schriftlich bestätigen lassen: „Weltweit war 1998 das wärmste Jahr und in Deutschland ist es das Jahr 2000. Das ist kein Geheimnis und das darf auch jeder wissen.“ (Teil1) Doch seit diesem Temperaturwendepunkt zur Jahrtausendwende waren alle Jahre kälter, und das bedeutet für die Statistik einen abnehmenden Trend.

Abb 13: Die Deutschlandtemperaturen der letzen 17 Jahre. (Quelle: DWD-Werte Offenbach), mit und ohne WI-Betrachtung. Die von Excel errechnete Trendlinie sinkt um 0,7°C in den letzten 17 Jahren. Vorhergesagt war eine Erwärmung um +0,4°C.

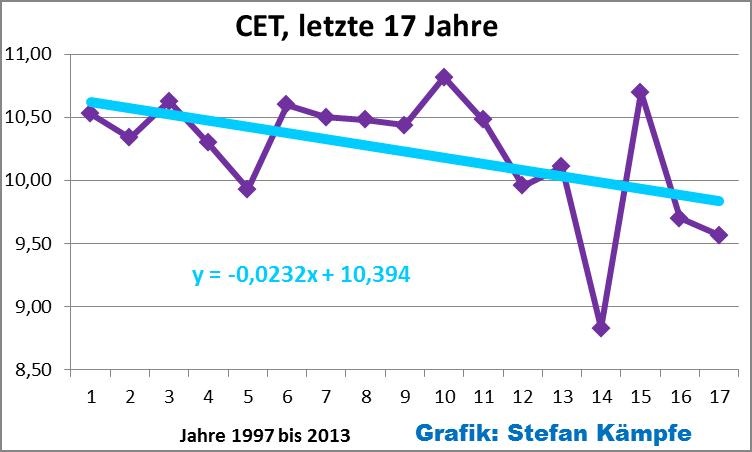

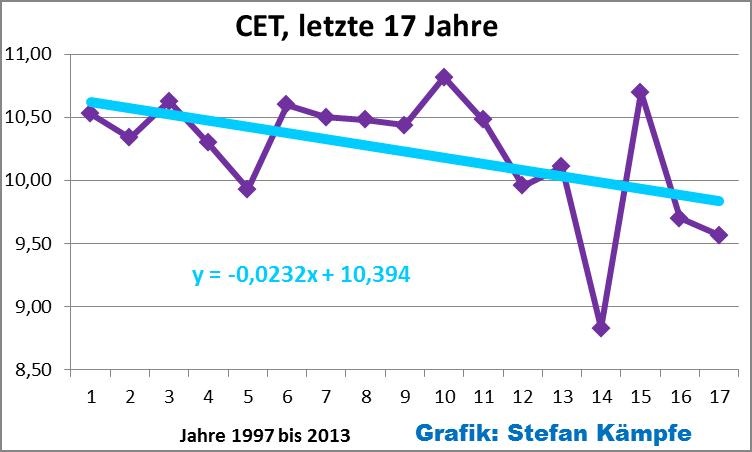

Dass wir in Deutschland auf keiner "Insel" leben, dürfte jedem klar sein. So sinken nicht nur in unserem Land seit 17 Jahren die Temperaturen, sondern auch in Zentralengland, Abb.14.

Abb. 14: Ähnlich wie in Deutschland (Teil 1, Abb. 4) sind auch in Zentralengland die Temperaturen in den letzten 17 Jahren deutlich gefallen. Der Rückgang war hier sogar noch etwas deutlicher, und diese CET- Werte sind nicht WI- bereinigt! Datenquelle http://www.metoffice.gov.uk/climatechange/science/monitoring/CR_data/Daily/HadCET_act.txt

Ergebnis 8:

Es ist wieder kälter in Deutschland geworden. Vor allem in der freien Fläche, weitab den Wärmeinseln bestätigen gute Naturbeobachter diese Aussage sofort. In der freien Fläche hat auch 2013 der Mai wieder die Bäume grün gemacht wie schon vor 250 Jahren als unsere Maienlieder entstanden sind und das wird auch 2014 so bleiben. http://www.youtube.com/watch?v=RJzXw-s3rCY

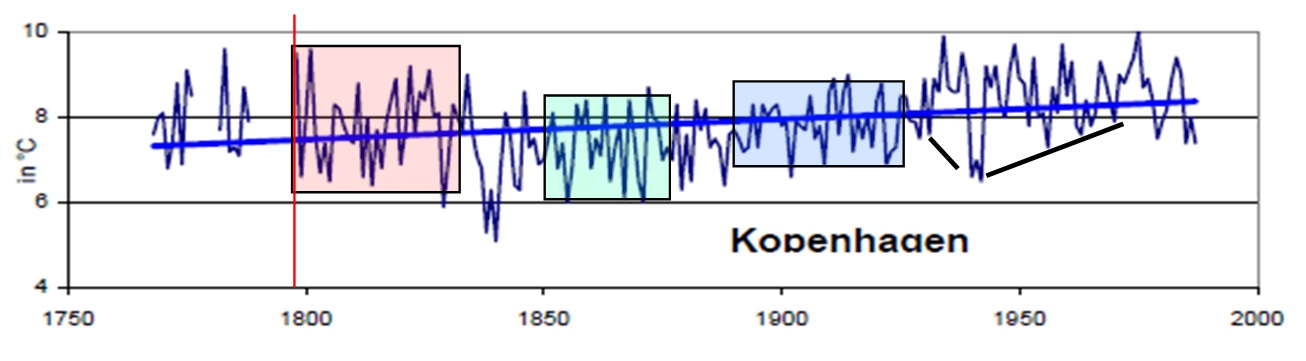

Nach dem deutlichen Absinken der Temperaturen seit der Jahrtausendwende, haben wir in der freien Fläche außerhalb der Wärmeinseln wieder die Temperaturen wie zu Mozarts Zeiten erreicht. Seit 250 Jahren gibt es ein Auf und Ab, es hat sich aber grundlegend am Klimaverlauf Deutschlands nichts geändert. Die gegenwärtige vergleichsweise hohe Schwankungsbreite in den Temperaturen ist dabei typisch für einen Wechsel von einer wärmeren Zeitspanne zu einer kühleren Phase, wie Leistenschneider bereits 2011 in seiner EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“, Teil 8 gezeigt hat. Abb.15 entstammt dieser.

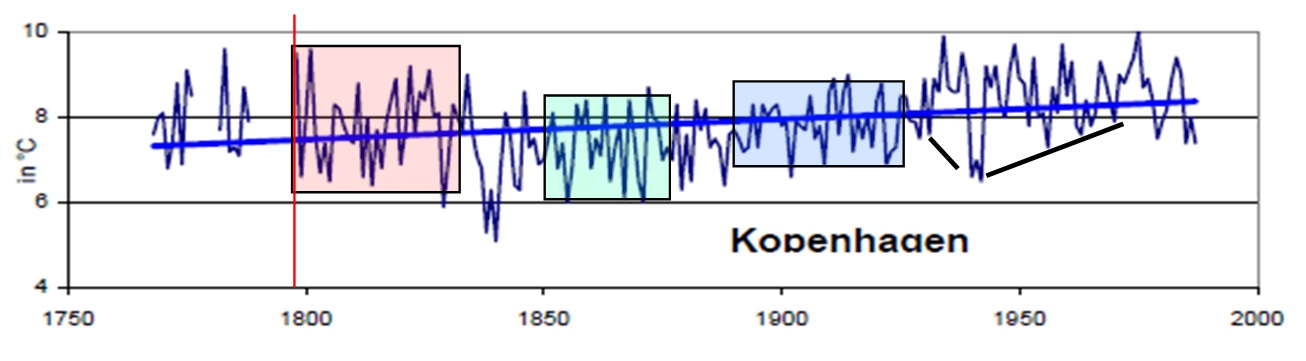

Abb. 15, Quelle: Prof. Ewert, EIKE, zeigt den Temperaturgang von Kopenhagen. Die rote Linie gibt den Zeitpunkt des Maximums im Hauptsonnenzyklus an. Bis zu einem Zeitraum von 20 – 30 Jahren nach dem Hauptsonnenzyklus schwanken die Temperaturen am stärksten zwischen warm und kalt (rote Fläche). Bis zu dessen Minimum sind immer noch relativ hohe Temperaturausschläge zu verzeichnen, jedoch auf insgesamt niedrigerem Niveau (grüne Fläche). Unmittelbar vor und nach dessen Minimum ist das Klimasystem sozusagen in seinem eingeschwungenen, kalten Zustand und die Ausschläge sind am geringsten. Vor einem Temperaturanstieg fallen die Temperaturen auf ein relatives Minimum und steigen dann kontinuierlich an (schwarze Linien).

“Anhand der solaren Aktivitätsschwankungen, dem derzeitigen und weiteren Rückgang der solaren Aktivität, sowie der Vergleiche der Temperaturentwicklung nach einem Hauptsonnenzyklus, ist für die nächsten 40-50 Jahre mit einem spürbaren Rückgang der Temperaturen zu rechnen. Nach einem Hauptsonnenzyklus fallen die Temperaturen deutlich, dabei unterliegen sie hohen Schwankungen zwischen warm und kalt, wie wir es übrigens auch gegenwärtig wieder erleben, so dass der Temperaturgang für die nächsten 10 Jahre weiter diesen Extrema zwischen warm und kalt unterliegen sollte…

Obwohl die Untersuchungen anhand eines, bzw. 2 Hauptsonnenzyklen sicherlich zu gering sind, um eine abschließende Aussage treffen zu können, zeigt sie, dass starke Temperaturschwankungen zwischen warmen und kalten Jahren in den ersten Jahrzehnten nach einem Hauptsonnenzyklus, insbesondere in Mitteleuropa, nichts ungewöhnliches darstellen. Die heutigen Schwankungen passen somit in sehr guter Weise zu den historischen. (“ EIKE, Teil 8 .“Dynamisches Sonnensystem“)

Raimund Leistenschneider – EIKE

Josef Kowatsch, Hüttlingen

Stefan Kämpfe, Weimar

Bildmaterial zu Kommentar 59

Die folgende Bilderserie zeigt anschaulich, dass es sich bei der DWD-Station auf der Zugspitze um keine naturbelassene Messstation handelt. Im Gegenteil, sie befindet sich in einer vom Menschen stark beeinflussten und umbauten Umgebung. Quelle: http://www.panoramio.com/photo/21499625 und http://www.planet-wissen.de/laender_leute/berg_und_tal/zugspitze/erschliessung.jsp und http://www.top-wetter.de/themen/zugspitze.htm

Schlimmer noch, auch natürliche Einflüsse machen die Station ungeeignet für Vergleichsmessungen. Wie der Name "Zugspitze" es bereits sagt, liegt die Station auf der Spitze eines Berges. Diese topographischen Orte sind jedoch immer Orte, die starken Einflüssen von Thermik ausgesetzt sind. Jeder weiß dies, der schon einmal Großvögel beobachtete, die die Thermik (sie ist nichts anderes als Energie) benutzen, um an Höhe zu gewinnen. Die Station liegt also an der Oberseite eines Kamins, an dem bei Sonnenscheindauer zusätzliche Energie nach oben fließt und die Station mehr beeinflusst, als Stationen ohne Thermik-Einflüsse. Thermik entsteht nur bei Sonnenscheindauer. Nun ist aber in den Alpen (Abb.16) eine stetige Zunahme der Sonnenscheindauer zu verzeichnen, so dass die Station auf der Zugspitze, zu den menschengemachten Veränderungen, auch noch den Fehler beinhaltet, dass sie durch die Zunahme der Sonnenscheindauer vermehrt mit Energie beaufschlagt wird und diese Zusatzenergie (die Station befindet sich, wie gesagt, am Oberrand eines Kamins) als Fehler in ihre Vergleichsmessungen eingeht. Dies alles zeigt, dass die DWD-Station ungeeignet für Vergleichsmessungen und keine Station ohne WI ist. R.L.

Abb.16 zeigt die prozentuale Änderung der mittleren Sonnenscheindauer im Zeitraum von 1884 – 2007, bezogen auf den Mittelwert von 1961 – 1990. Die blaue Kurve zeigt die Jahreswerte, rot ist der dynamische Trend und grün der Anstieg über die gesamte Zeitdauer. Im Zeitraum lag der Tiefstwert der Sonnenscheindauer 1912 und der Höchstwert im Jahre 2003, der interessanterweise mit dem Maximum des Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries-Suess-Zyklus zusammen fällt.