Der preisgekrönte israelische Astrophysiker Dr. Nir Shaviv [siehe Bild rechts] verdammt ‚die Absurdität des neuen UN-Klimaberichtes‘ – ‚die IPCC-Autoren stellen unverblümt weitere lächerliche Behauptungen auf‘ – ‚Nachdem man vielleicht Milliarden Dollar über drei Jahrzehnte hinweg in die Klimaforschung gesteckt hat, sind wir hinsichtlich der wichtigsten Frage zum Klima immer noch nicht auch nur ansatzweise weitergekommen!‘

Dr. Richard Lindzen vom Massachusetts Institute of Technology MIT: Der IPCC-Bericht ist ein politisches Dokument: Jeder IPCC-Bericht sieht so aus, als ob die Dringlichkeit eines internationalen Abkommens hinsichtlich der Beschneidung von Kohlendioxid-Emissionen zugenommen hat‘

IPCC-Begutachter Dr. Don Easterbrook zum IPCC: ‚Es ist absolut keine Wissenschaft – es ist dogmatische, politische Propaganda‘.

Vorhersage-Experten stellen die IPCC-Modelle bloß: ‚Wir haben entdeckt, dass die IPCC-Szenarien 72 von 89 relevanten wissenschaftlichen Vorhersage-Prinzipien verletzt haben‘.

Monckton: ‚Einstein hat die Welt auf 30 Seiten verändert – das IPCC langweilt die Welt auf 10.000 Seiten!‘

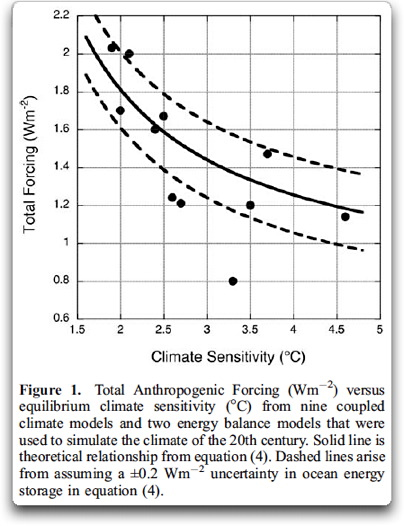

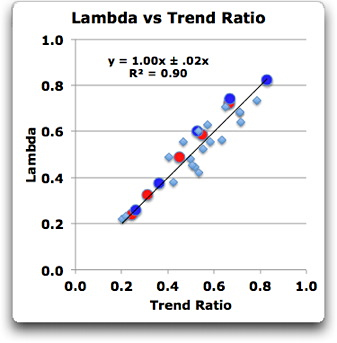

Der preisgekrönte israelische Astrophysiker Dr. Nir Shaviv verdammt den UN-Klimabericht. Er unterstreicht ‚die Absurdität des neuen Berichtes‘ und sagt, dass die IPCC-Autoren unverblümt weitere lächerliche Behauptungen aufstellen, um die riesige Lücke zwischen ihren Modellen und der Wirklichkeit zu füllen [hier]. Und weiter: ‚Die wahrscheinliche Bandbreite der Klimasensitivität hat sich seit dem Charney-Bericht aus dem Jahr 1979 nicht verändert. Mit anderen Worten, nachdem man vielleicht Milliarden Dollar über drei Jahrzehnte hinweg in die Klimaforschung gesteckt hat, sind wir hinsichtlich der wichtigsten Frage zum Klima immer noch nicht auch nur ansatzweise weitergekommen!‘ Shaviv weiter: Das IPCC und seinesgleichen sind Gefangene eines falschen Konzeptes – das IPCC tut immer noch sein Bestes, um Beweise zu umgehen, dass die Sonne in großem Umfang das Klima beeinflusst [hier].

Ein Grund für das Fehlen eines besseren Verständnisses kann die Inkompetenz der beteiligten Personen auf diesem Gebiet sein [hier]. Falls die Grundpfeiler einer Theorie falsch sind, gibt es keine zunehmende Übereinstimmung, wenn immer mehr Daten gewonnen werden. Tatsächlich passiert normalerweise das Gegenteil, die Unstimmigkeit nimmt zu. Mit anderen Worten, das oben beschriebene Verhalten reflektiert die Tatsache, dass das IPCC und seinesgleichen Gefangene eines falschen Konzeptes sind. Das Auseinanderdriften von Theorie und Daten beschreibt exakt die Lage der vergangenen Jahre hinsichtlich des Fehlens eines Temperaturanstiegs … würde man ein legitimes wissenschaftliches Verhalten an den Tag legen, hätte man die Obergrenze parallel dazu erniedrigt, aber in diesem Fall war das nicht so. Und zwar deshalb, weil dies die Aufgabe der zugrunde liegenden großen Klimasensitivität erfordert hätte. Da die Daten eine geringe Klimasensitivität zeigen und der Alarmismus eine große Sensitivität fordert, wird die ‚wahrscheinliche Bandbreite‘ der Klimasensitivität groß bleiben, bis die Angst vor der globalen Erwärmung [the global warming scare] verschwindet. Ein zweiter wichtiger Aspekt des jetzigen Berichtes ist, dass das IPCC mit allen Kräften den Beweis verschleiern will, dass die Sonne in großem Umfang das Klima beeinflusst. Sie werden natürlich niemals diesen quantifizierbaren Effekt zugeben, weil dies die Argumentationslinie einer zumeist vom Menschen verursachten globalen Erwärmung eines sehr sensitiven Klimas zerschlagen würde‘.

Al Gore: Die Medien müssen sich bei der Verwendung des Wortes ‚Klima‘ zu Tode ängstigen – Er verdammt die Berichterstattung zur globalen Erwärmung als ‚lächerlich‘ [hier].

Klimawissenschaftler Dr. Richard Lindzen am MIT: ‚Der IPCC-Bericht ist ein politisches Dokument: Jeder IPCC-Bericht sieht so aus, als ob die Dringlichkeit eines internationalen Abkommens hinsichtlich der Beschneidung von Kohlendioxid-Emissionen zugenommen hat [hier]. Trotz der zunehmenden Diskrepanzen zwischen den Modellen und den Beobachtungen besteht das IPCC darauf, dass sein Vertrauen in die Modellvorhersagen größer denn je ist. Die Unterstützung des Alarms zur globalen Erwärmung zeigt kaum einen intelligenten Respekt vor der Wissenschaft‘.

UN IPCC-Begutachter Dr. Don Easterbrook: Es ist überhaupt keine Wissenschaft – es ist dogmatische, politische Propaganda! Man muss den IPCC-Bericht als die größte Fehlinterpretation von Daten aller Zeiten ansehen. Nach all den Jahren hat das IPCC es immer noch nicht verstanden: Wir sind seit mehreren hundert Jahren aus der Kleinen Eiszeit gekommen, haben aber immer noch nicht das Temperaturniveau vor dieser Kleinen Eiszeit erreicht. Dieses Niveau war während 90% der vergangenen 10000 Jahre vorherrschend. Seit Millionen Jahren hat es Erwärmungen und Abkühlungen gegeben, lange bevor das CO2 irgendetwas damit zu tun gehabt haben kann. Daher beweist die Erwärmung selbst in keiner Weise, dass sie durch CO2 verursacht worden ist‘.

Vorhersage-Experten stellen die IPCC-Klimamodelle bloß: Unser Audit der Prozesse, die zur Erstellung der IPCC-Szenarien geführt hatten, kam zu dem Ergebnis, dass 72 von 89 relevanten wissenschaftlichen Vorhersage-Prinzipien verletzt worden sind. Kesten C. Green (University of South Australia, Direktor von forecastingprinciples.com) und J. Scott Armstrong (University of Pennsylvania, Herausgeber der Prinzipien zur Vorhersage): ‚Das IPCC und seine Unterstützer tun bei diesen Szenarien so, als seien es Vorhersagen. Szenarien sind jedoch nicht das Ergebnis von auf Beweisen fußenden Vorhersage-Verfahren.

Spitzenwissenschaftler stellen die UN-Studie zur globalen Erwärmung in Frage – Die Ergebnisse sind politisiert worden! Der Spiegel schreibt außerdem, dass nur 3 der 114 Klimamodelle in der Lage waren, den nunmehr 15 Jahre langen Stillstand abzubilden. Diese Tatsache wurde vollständig weggelassen in dem, was die UN den Politikern und der Öffentlichkeit mitgeteilt hatte‘.

‚Vorsätzlich geplante Ermordung der Wissenschaft:’ Klimatologe Dr. Tim Ball: Die von den UN proklamierte Gewissheit von 95% ist genau das ist, was passiert, wenn man die Wissenschaft ‚vorsätzlich ermorden‘ will. – Wir gehen derzeit auf Zeiten zu, wie sie um das Jahr 1800 geherrscht hatten. Man nannte es das Dalton-Minimum geringer Sonnenflecken-Aktivität. Wir haben diese geringe Anzahl von Sonnenflecken in diesem Jahr wieder erreicht. Das bedeutet, dass die Abkühlung noch mindestens bis zum Jahr 2030 dauern wird. Und doch bereitet sich die Regierung auf Erwärmung vor. Das ist empörend!‘

UK Express: ‚Das IPCC hat nicht eine einzige Person eingeladen, die dem zuvor festgelegten Ergebnis nicht zustimmt … das ist keine Wissenschaft! Vor dem IPCC-Treffen in Stockholm wurde ein Kommuniqué veröffentlicht, in dem genau die Schlussfolgerung stand, die zuvor festgelegt worden war. Das ist auch keine Wissenschaft. Wirkliche Wissenschaft probiert, zweifelt, testet, untersucht ununterbrochen und heißt Abweichungen willkommen. Hässliche Fakten (wie z. B. dass es derzeit auf der Welt überhaupt nicht wärmer wird) wurden in die Tonne getreten‘.

Das Schweizer Nachrichtenmagazin ‘Weltwoche’: Skeptiker auf dem Vormarsch … Keine Spur von Konsens in der Klimawissenschaft! Seit Jahren behauptet Al Gore, dass die Wissenschaft ‚settled‘ ist. Und doch gibt es absolut keine Anzeichen für irgendeinen Konsens in der Klimawissenschaft‘.

Rückschau: SPECIAL REPORT: Über 1000 internationale Wissenschaftler stimmen den Behauptungen über die vom Menschen verursachte globale Erwärmung nicht zu. Sie fordern das IPCC und Al Gore heraus.

Ein wöchentlich erscheinendes Schweizer Nachrichtenmagazin greift das IPCC massiv an: ‚Schicksals-Propheten, keine Wissenschaftler!‘ Skeptiker auf dem Vormarsch: Der Konsens unter den Klimawissenschaftlern, der seit Jahrzehnten zementiert worden ist, zerbricht – oder bricht sogar völlig in sich zusammen. Seit einem Vierteljahrhundert haben führende Klimawissenschaftler vor einer gefährlichen globalen Erwärmung infolge von CO2-Emissionen gewarnt. Jetzt veröffentlichen sie unter Schweizerischer Leitung (Thomas Stocker) einen neuen Bericht. Dieser zeigt: Die Wissenschaftler lagen falsch! Nach 25 Jahren können viele der Vorhersagen jetzt evaluiert werden – und das Ergebnis für das IPCC ist verheerend‘.

‘Politische Manipulation eines wissenschaftlichen’ Dokumentes?! 10 Seiten wissenschaftlicher Fehler des IPCC? Allein schon in Kapitel 2 sind die Autoren kollektiv verantwortlich für 18 Beispiele wissenschaftlicher Fehler, die jetzt der Korrektur bedürfen. Vor einigen Tagen hat das IPCC seine neue, verbesserte Summary veröffentlicht. Zwei Tage danach machte es die Versionen der 14 Kapitel öffentlich. Einer der Gründe, warum sich diese Kapitel immer noch im Entwurfsstadium befinden ist, dass jetzt Änderungen an ihnen vorgenommen werden müssen. Offensichtlich war es nicht nur die Summary, die während des viertägigen Treffens verfälscht worden ist. In vielen Fällen waren die Veränderungen so substantiell, dass das IPCC jetzt sagt, der Text von 9 der 14 Kapitel muss geändert werden … Ganze Absätze werden eingefügt, Daten und Zahlen werden verändert, Kursivsetzungen hinzugefügt, und Manches wird einfach verschwinden … Die Autoren von Kapitel 5 machten genauso 11 wissenschaftliche Fehler. Und die Autoren von Kapitel 11 machten 21 wissenschaftliche Fehler‘.

Analyse: Die vielleicht lächerlichste Graphik im 5. Zustandsbericht des IPCC ist diejenige, die eine ‚dekadische Mitteltemperatur‘ zeigt. Warum ist diese Graphik so schlecht? Weil nicht einzusehen ist, warum darauf hingewiesen wird. Erstens bedarf es einer Kurve mit 160 Datenpunkten darauf und reduziert diese auf 16, d. h. die meisten Daten werden effektiv weggeworfen. Die Einführung dieser Graphik in den AR 5, die in den vorigen Berichten nicht vorhanden ist, macht das IPCC offen für Anklagen, den ‚Rückgang zu verstecken [to hide the decline] hinsichtlich der Erwärmung in diesem Jahrzehnt, obwohl natürlich der begradigte Verlauf aus der obigen Graphik klar hervorgeht. Also scheint die Graphik ziemlich sinnlos.

Monckton: Einstein hat die Welt auf 30 Seiten verändert. Das IPCC hat die Welt auf 10.000 Seiten gelangweilt!

Judith Curry: ‚Trotz hysterischer Behauptungen sind die IPCC-Modelle nicht in der Lage, abrupte Klimawechsel zu simulieren‘. Und weiter: ‚Das IPCC hat hohes Vertrauen darin, dass wir uns über die wirklich gefährlichen Szenarien keine Sorgen machen müssen (z. B. Zusammenbruch der Eisschilde, Kollaps der AMOC), und zwar im Zeitrahmen eines Jahrhunderts. Diese Zusammenbrüche gab es schon in der Vergangenheit ohne AGW, und sie werden sich auch unvermeidlich irgendwann in der Zukunft wieder ereignen, mit oder ohne AGW. Ist das IPCC hinsichtlich seiner Schlussfolgerungen da genauso sicher?

Bob Tisdale: IPCC immer noch dem Wahn über Kohlendioxid verfallen – die Klimamodelle haben sich so weit von der Realität entfernt, dass sie nicht dazu verwendet werden können, um die globale Erwärmung natürlichen Prozessen oder anthropogenen Faktoren zuzuordnen, und auch nicht dazu, Vorhersagen des zukünftigen Klimas auf der Grundlage von Projektionen anthropogener Treibhausgase zu machen. Amüsanterweise benutzt das IPCC die Klimamodelle als „Beweis“, dass die letzte globale Erwärmung durch Kohlendioxidemissionen verursacht worden ist und dass die globalen Temperaturen weiterhin steigen werden aufgrund des weiter zunehmenden CO2-Gehaltes. Der unverrückbare Glauben der Klimawissenschaftler, dass Kohlendioxid die globale Erwärmung treibt, obwohl die Klimamodelle ganz klar das Gegenteil zeigen, ist Beweis für ihre Wahnvorstellungen über CO2 oder ihr dringendes Bedürfnis, ihre Modelle falsch zu interpretieren (aus welchen Gründen auch immer). Die Wassertemperatur war global in der Erwärmungsperiode von 1914 bis 1945 stärker gestiegen als während der jüngsten Erwärmungsperiode von 1975 bis heute‘.

Analyse: Klima wegen des Wasserkreislaufes, nicht wegen Kohlendioxids

Einer Studie zufolge hat sich die globale Erwärmung der Ozeane während der letzten 50 Jahre halbiert. Die Studie wurde 2012 in Nature Climate Change veröffentlicht.

Gute Nachrichten: Das IPCC verwirft den planetarischen Notfall: Es glaubt jetzt, dass ein Zusammenbruch der atlantischen Ozeanzirkulation im 21. Jahrhundert ‚sehr unwahrscheinlich‘ ist, dass der Kollaps der Eisschilde ‚extrem unwahrscheinlich‘ ist und dass eine katastrophale Freisetzung von Methan aus Methanhydraten ‚sehr unwahrscheinlich‘ ist.

Die Klimatologen PATRICK J. MICHAELS und CHIP KNAPPENBERGER: Wäre das IPCC stärker daran interessiert gewesen, die aktuelle Wissenschaft zu reflektieren anstatt sich der Rettung eines rasch zerfallenden Konsens‘ zu widmen, wäre der 5. Zustandsbericht ein viel freundlicheres und netteres Dokument gewesen. Damit die IPCC-Projektionen der Evolution der mittleren Temperatur der Erde die jüngsten wissenschaftlichen Schätzungen der Klimasensitivität besser reflektieren können, ist es notwendig, diese um 30% nach unten zu korrigieren in Richtung der Untergrenze der Bandbreite, etwa 50% weg von der Obergrenze und 40% tiefer als die Mitte.

Jetzt hören: Ein eine ganze Stunde dauerndes Interview mit Morano von Climate Depot in der Mike Rosen-Show: ‚Ein neues Klimagate! Das IPCC wird angeklagt, die Führer der Welt und die Öffentlichkeit in die Irre geführt zu haben! Hat das IPCC ‚die Fakten festgeschrieben‘? – Gesendet am 2. Oktober 2013 auf KOA Radio. – Moderator Mike Rosen zu Marc Morano: ‚Sie bekommen mehr Redezeit in Gestalt von Wörtern pro Minute als jeder andere, den ich bisher in dieser Show zu Gast hatte!‘

Erwärmung mit einem Signal auf eine Rauschen-Rate von 0,00 lässt das Vertrauen der Wissenschaftler in die Erwärmung zunehmen [hier]

Nicola Scafetta: Die vom IPCC verwendeten Klimamodelle scheitern bei der Reproduktion dekadischer und multidekadischer Phänomene seit 1850.

Christopher Booker: Klimawissenschaftler sind lediglich eine weitere Interessengruppe.

Professor in der NYTimes: Das Scheitern der Klimamodelle an der Realität ist unwichtig, da wir sie zur Vorhersage der Zukunft nutzen

Klimatologe Dr. Tim Ball: Das IPCC: Ein Erzeugnis von Lügen, verdammten Lügen und auf ungeeigneten Daten beruhenden Statistiken [auf Deutsch beim EIKE hier]

Ein Schweizer Journalist sagt voraus: ‚Die Klimakatastrophe wird bald vergessen sein‘ – genau wie alle anderen Angst erzeugenden Umweltstorys‘.

Analyse: IPCC: Wenn die Daten nicht zur Theorie passen, ändere man die Daten – Das IPCC hat in Zusammenarbeit mit der NASA und der NOAA die Erdgeschichte völlig umgeschrieben. Im Jahre 1975 hat die National Academy of Sciences diese Graphik veröffentlicht und vor einer dramatischen globalen Abkühlung gewarnt.

Der politisch neutrale SPM-Autor des IPCC Rowan Sutton: ‚Alle Beweise zeigen eindeutig, dass das Hinterlassen des Themas Klimaänderung für zukünftige Generationen, sich damit zu befassen, eine phänomenal risikobehaftete Option ist‘.

Außenminister John Kerry: ‚Das Fehlen eines gemeinsamen globalen Vorgehens gegen die Klimaänderung ist wie die Einladung einer Katastrophe‘.

Die Warmisten machen für den Stillstand die Ozeane verantwortlich: Der Wärmegehalt der Ozeane ist das Wort des Tages. Die Graphik zeigt die Anzahl der bei einer Google-Suche auftauchenden Links zu ‚Ocean Heat‘ auf der (alarmistischen) Website Skeptical Science für jedes Jahr seit 2006. Im Jahr 2007 wurde es 7 mal angeklickt, in diesem Jahr (projiziert auf das gesamte Jahr 2013) 166 mal (125 mal bis heute).

Hauptschlagzeile in Der Spiegel: Widersprüchliche Prognosen: Forscher entdecken Unstimmigkeiten im Uno-Klimabericht. Renommierte Forscher kritisieren nun diverse Ungereimtheiten im Report. Sie erheben fünf Vorwürfe gegen den Welt-Klimarat.*

*Originalzitat, keine Rückübersetzung!

Nuttercelli: ‚Die katastrophal gescheiterten Klimamodelle waren auf den Punkt genau – offensichtlich hat das IPCC tatsächlich keine Erwärmung während der letzten 17 Jahre und auch die Rekord-Schneefälle vorhergesagt. Aber sie haben sich so ausgedrückt, dass es so klingt, als hätten sie genau das Gegenteil gesagt‘.

Analyse: Das IPCC hat vergessen, den spektakulären Eiszuwachs in der Arktis zu erwähnen. Man würde denken, dass zumindest einer unter den Tausenden Spitzen-Klimaexperten der Welt die Tatsache bemerkt hätte, dass das arktische Meereis inzwischen wieder das Niveau des Jahres 2006 erreicht hat. Vor allem, weil das Wort ‚Arktis‘ viele tausend Male in dem Bericht erwähnt wird.

Der vergangene Sommer war der kälteste jemals gemessene in der Arktis und war gekennzeichnet durch den größten Eiszuwachs von einem Jahr zum nächsten seit Beginn von Beobachtungen.

Ein 3 Minuten langes Nachrichten-Video auf der ABC-Radiostation KSTP stellt den IPCC-Bericht dem Bericht des NIPCC mit dem Titel ‚Climate Change Reconsidered II‘ gegenüber [Auszüge demnächst beim EIKE auf Deutsch] und lässt Joseph Bast vom Heartland Institute zu Wort kommen.

Reuters zum IPCC-Bericht aus dem Jahr 1995: ‚Nachrichten-Rückblick von 1995: ein früherer IPCC-Bericht war ausgelassen [hilariously] falsch‘.

Jüngster IPCC-Trick: Ausweitung der Bandbreite der Modelle, um diese richtig aussehen zu lassen.

‚Die Beobachtungen würden gut innerhalb der extrem breiten grauen Bereiche liegen, die im AR 4 nicht erschienen sind und die das ziemlich interessante Phänomen aufweisen, im Jahre 1990 eine Ungewissheit von Null zu zeigen. Daher lautet die Frage: Was sind diese Bereiche?‘ [hier]

AR 5 des UN IPCC: Die Behauptung einer ‚beispiellosen‘ dekadischen globalen Erwärmung ist durch jüngste empirische Beweise widerlegt. Nach 7 Jahren Forschung und Milliarden Dollar für den AR 5 ist das beste, mit dem das IPCC aufwarten kann, die dünne Schleimsuppe einer ‚beispiellosen‘ dekadischen Erwärmung, die sich bei näherem Hinsehen als falsche Repräsentation der jüngsten Erwärmung hinsichtlich Manipulation, Dauer und Größenordnung erweist. Haben doch die letzten 15 Jahre bewiesen, dass natürliche Klimaantriebe den CO2-Einfluss einfach überkompensieren. Die Wahrscheinlichkeit, dass die moderne dekadische Erwärmung mehr eine Folge natürlicher (nicht anthropogener) Klimakräfte ist, beträgt mehr als 95%.

Jetzt ansehen: Prof. Roger Pielke Jr. Zum, Thema Extremwetter – er verwirft die Proklamation einer ‚neuen Normalität‘ bzgl. des Wetters. Das Interview führte Dr. David Whitehouse für die Fernsehstation GWPF TV.

Auch ansehen: Das Interview mit der Alarmistin Jennifer Francis, in dem sie von zunehmenden AGW-Trends beim Wetter faselt.

Alarmisten: Die Schließung [wegen des US-Haushaltstreites] hindert die NOAA-Bediensteten daran, den IPCC-Bericht für Medien und Politiker zu interpretieren.

Analyse: Was könnte die Zunahme des Vertrauensniveaus von 90 auf 95% rechtfertigen, und in welcher Hinsicht sind zusätzliche Beweise für den menschlichen Einfluss seit dem AR 4 2007 aufgetaucht? Hier folgen ein paar Ereignisse seit 2007, die das Vertrauensniveau verändert haben könnten: Es gab weitere sechs Jahre ohne jede Erwärmung; die Klimawissenschaftler waren nicht in der Lage, dies vorherzusagen (tatsächlich haben sie vorhergesagt, dass die Erwärmung wieder einsetzen werde). Klimagate enthüllte die privaten Sorgen der Klimawissenschaftler in dieser Hinsicht und auch die Beeinflussung von Journalen und das Zurückhalten von Daten. In vielen neuen Studien von Mainstream-Klimawissenschaftlern wurde eingeräumt, dass es eine zunehmende Inkonsistenz zwischen Modellen und Beobachtungen gibt. Und doch hat das Vertrauen zugenommen, und die Beweise haben sich vermehrt?

Analyse: Die IPCC-Behauptung, man hätte ein sehr hohes Vertrauen in die Abnahme der Schneebedeckung, ist nicht wahr – das ist wie ‚Rosinen picken im Schnee‘.

U.S. TV Networks: Bericht über den IPCC-Bericht: CBS News sendet eine ‚unverantwortliche‘ Behauptung über einen Temperaturanstieg um 212 Grad.

Rückblende: In dem Hollywood-Film ‚The 11th Hour‘ aus dem Jahr 2007, in dem es um die globale Erwärmung ging, wird der Physiker Stephen Hawking mit der unwidersprochenen Hypothese zitiert, dass es das ‚worst-case-Szenario wäre, wenn die Erde wie ihr Schwesterplanet Venus werden würde mit einer Temperatur von 250°C‘.

Die Medien tun alles, um den Hype um die globale Erwärmung wiederzubeleben – es gibt Ärger darüber, dass man skeptischen Stimmen Raum gibt: Ein Gremium wird zusammengerufen, um zu diskutieren, ob man das zulassen sollte oder nicht.

Der Meteorologe Art Horn: Das IPCC hat hohes Vertrauen darin, nicht sicher zu sein

Eine Begutachter-Studie kommt zu dem Ergebnis, dass es während der Mittelalterlichen Warmzeit signifikant wärmer war als heute, als der CO2-Gehalt im ‚grünen Bereich‘ lag.

Die Warmisten erzeugen buchstäblich ein Klima der Verrücktheit: Ein Wettermann drückt es so aus: ‚Wir leben derzeit in einer Welt, in der es für einen erwachsenen Menschen völlig normal ist, über ein modernes Märchen zu heulen wie ein Kind über ein Schauermärchen mit Hexen und Geistern‘.

‚Wenn Klimadaten Aktien wären, wäre es jetzt an der Zeit, sie zu verkaufen‘.

Und nochmal der Wettermann Eric Holthaus: Was das IPCC so wichtig macht, ist einfach: Sie sind dazu aufgefordert übereinzustimmen. Das IPCC hat ‚vertrauensvoll‘ düsterste Konsequenzen projiziert, sollten die Regierungen der Welt nicht agieren.

Link: http://tinyurl.com/mmztr4u

Übersetzt von Chris Frey EIKE