Erwärmungshysterie und 2°-Ziel – warum?

Und auch dort erinnert sich Herr Schellnhuber nicht mehr daran, dass er 2003 als Mitautor das Gegenteil publiziert hat, zitiert als [3]. Mit dem 2°-Ziel der Klimapolitik hat sich der Autor in „Fallgruben der Klimawandler“ befasst, und ebenso mit den Ursachen der Erwärmungshysterie, zitiert als [1]. Der Teil 4 der Video-Reihe und die Stockholmer Veranstaltung des IPCC veranlassen den Autor, die beiden Kapitel dieser „Fallgruben“ zu ergänzen. „Das 2°-Ziel der Politik“ wird hier behandelt, „Wie konnte die Klimawandel-Hysterie entstehen“ folgt in Kürze.

Das 2°-Ziel der Politik

Was ist Klimawandel wirklich und wie entstand das 2°-Ziel ?

Begriff ‚Erderwärmung’

Zunächst ist eine Begriffsklärung nötig, denn Klimaforscher, Medien und Politiker sprechen oft von einer ‚Erderwärmung’, die wir Menschen ihrer Meinung nach verursachen. Der Begriff ist falsch! Dass sie diesen Begriff benutzen, charakterisiert allerdings ihren Kenntnisstand von der Erde, und das gilt sowohl für den Erdkörper selbst als auch für seine Klimageschichte, denn von ihren 4,5 Mrd Jahren werden bestenfalls nur knapp 100 Jahre berücksichtigt, also der 45Million-ste Teil.

Unter der Erdoberfläche schwankt die Temperatur des Bodens mit der aktuellen Temperatur der Luft. Im Boden verringern sich nach unten die Temperaturschwankungen und erreichen in etwa 10 m Tiefe die Jahresmitteltemperatur, die bei uns etwa 9,5°C beträgt. Zur Tiefe hin nimmt die Temperatur dann mit der ‚geothermischen Tiefenstufe’ zu – bei uns sind das 3°C/100m; in 1000 m Tiefe beträgt die Temperatur also 9,5+ (10´3) = 39,5°C. Von örtlichen Besonderheiten abgesehen erreicht die Temperatur in etwa 50 km Tiefe die Schmelztemperatur der Gesteine von ca. 1500°C. Von dort sind es bis zum Zentrum des Erdkerns noch ca. 6320 km, wo die Temperatur 5000°C übersteigt. Von Temperaturänderungen der Atmosphäre ist schon in Tiefen von 10 m nichts mehr zu spüren. Deshalb: von ‚Erderwärmung’ zu sprechen ist falsch.

Klimawandel

Von offizieller Seite wird der Begriff ‚Klimawandel’ mit größter Selbstverständlichkeit benutzt und auf den gegenwärtigen Zustand des Klimas angewandt. Dabei wird in der Öffentlichkeit ständig der Eindruck erweckt, dass die in historischem Maßstab derzeit marginale Temperaturänderung maßgeblich vom Menschen verursacht werde. Die jüngste IPCC-Veranstaltung in Stockholm hat dies wieder bestätigt.

Aber was ist Klimawandel wirklich? Das Wetter wechselt von Tag zu Tag, von Woche zu Woche – etc., aber wie groß muss (darf, soll) eine Änderung sein, um als Klimawandel zu gelten? Welches Kriterium ist ausschlaggebend für den Unterschied zwischen Temperaturschwankungen und Klimawandel? Klare Definitionen gehören zu den Grundlagen der Naturwissenschaften – schon als Schüler erfährt man, wie beispielsweise unsere Längenmaße definiert sind, und warum. Dass für den Klimawandel immer noch eine klare Definition fehlt, ist erstaunlich, wo doch sonst alles mit Maß und Zahl geklärt ist. Könnte dies beabsichtigt sein, weil mit der gegenwärtigen Praxis sich auch schon die kleinen Temperaturschwankungen der Gegenwart als Klimawandel propagieren lassen?

Dass die Übergänge zwischen Eiszeiten und Warmzeiten einen Klimawandel darstellen, versteht sich von selbst, doch diese Änderungen erreichen Größenordnungen bis zu 10°C und mehr. Beim wirklichen Klimawandel kleineren – bzw. geringeren bzw. üblichen – Ausmaßes wandelt sich ein Klima in ein anderes, und man kann die Größenordnung der einen Klimawandel bewirkenden Veränderung abschätzen, wenn man die Mittelwerte der Temperaturen mehrerer Klimazonen vergleicht. Beispielsweise unterscheiden sich die Durchschnittstemperaturen von Mailand, Berlin und Stockholm um jeweils etwa 3°C, Vergleiche mit subtropischen oder periglazialen Zonen ergeben erheblich größere Unterschiede. Ein wirklicher Klimawandel erfordert Änderungen von einigen Grad.

Wie von Ewert in [1] dargestellt, ist die Temperatur seit etwa 1700 ausweislich der Langzeit-Temperaturreihen von 60 Stationen (von 82) weltweit jedoch nur um 0,6°C/100a angestiegen – allerdings nicht überall auf der Erde, denn während 3 Stationen keine Änderungen registrierten, verzeichneten 19 Stationen für die 310 Jahre eine Abkühlung ihrer Regionen von –0,2°C/100a. Die Erwärmungsrate enthält noch den Wärme-Insel-Effekt, der vor allem im 20 Jh. wirksam wurde. Schellnhuber (!) et alt. erhielten bei ihrer Auswertung von 95 Stationen weltweit ein noch ‚kühleres’ Ergebnis und folgerten schließlich, dass man „im größten Teil der Stationen keine Anzeichen für eine globale Erwärmung der Atmosphäre gefunden hat“ [2].

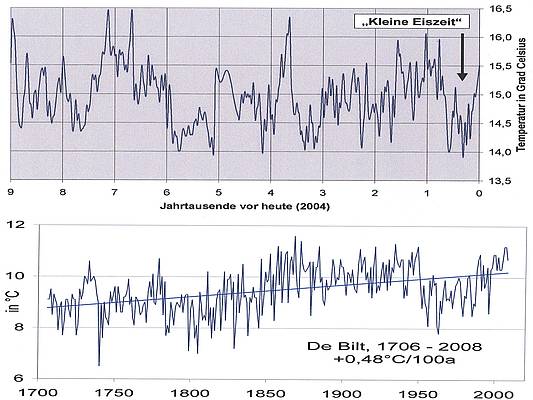

Nun beziffert selbst die etablierte und politisch motivierte Klimaforschung die Änderungen im vergangenen Jahrhundert mit nur einigen Zehntel Grad und bezieht sich dabei auf die von ihnen zu Grunde gelegte Beobachtungszeit seit etwa 1880. Wenn man berücksichtigt, dass im weitaus größeren Teil der Erdoberfläche bis vor etwa 40 Jahren mangels eines auch nur annähernd ausreichenden Stations-Netzes überhaupt nicht gemessen wurde, weil die Satellitenmessungen erst später begannen, scheint es angemessen zu sein, für die Temperaturänderung im 20. Jh. unter Abzug des Wärme-Insel-Effekts eine Größenordnung von 0,6°C (±0,2° ) anzunehmen. Wäre das wirklich schon ein Klimawandel? Nein! Wie Abb. 1 zeigt, hat es in den letzten 9000 Jahren den üblichen Wechsel von Warm- und Kaltphasen mit Änderungen auch von mehr als 2°C gegeben. Der letzte Wechsel findet seit 1800 statt, nämlich die Rückerwärmung nach dem Ende der Kleinen Eiszeit (roter Pfeil). Diese Rückerwärmung enthält außer den üblichen Temperaturschwankungen auch Erwärmungs- und Abkühlungsphasen. Die 1708 beginnende Ganglinie der Station De Bilt liefert als repräsentatives Zeugnis der wirklichen Temperaturentwicklung keinen Beweis für einen ‚menschengemachten Klimawandel’. Die Ganglinie zeigt für das 20. Jh. keine Entwicklung, die es nicht vorher – und sehr viel stärker – auch schon gab.

Abb. 1: Schwankungen der globalen Durchschnittstemperatur (oben: Comnispa-Temperaturkurve A.Mangini, Univ- Heidelberg), Temperaturganglinie der Station De Bilt seit 1708 (unten, aus [1])

Diese geringen Temperaturschwankungen wurden in einer politisierten und von Profiteuren angeheizten "Klima-Wandel-Hysterie" in einen angeblich anthropogenen Klimawandel umfunktioniert, und so von der UN übernommen. Er beruht auf einem politischen und auf einem wirtschaftlichen Konzept, denn die Möglichkeit eines „long lasting business“ wurde schnell erkannt. Die angenommene Zusammenhang zwischen Temperaturänderungen und CO2-Konzentration kann nicht bewiesen werden – und ist nicht beweisbar. Sie basiert auf Klimasimulationsmodellen, während die in der Natur gemessenen Fakten ignoriert werden. Das in den 1980er Jahren erfundene Modell ‚anthropogener Klimawandel’ hat zu einem hektischen Aktionismus (CO2-Minderungs-Maßnahmen) geführt, denen aber statt eines wirklichen Klimawandels nur die üblichen Temperaturschwankungen geringen Ausmaßes zu Grunde liegen.. Die weltweit praktizierte Klimabürokratie und der Klimatourismus von Rio bis Kopenhagen kosten Aber-Milliarden und leben von einem ‚Klimawandel’, der nicht stattfindet.

Das 2°-Ziel

Kritische Einwände gegen diesen angenommenen Klimawandel werden seitens der Regierung stereotyp mit dem Argument abgelehnt, man folge mit der Akzeptanz des 2°-Zieles der offiziellen Klimapolitik, denn auf dem G-8-Gipfel im italienischen L’Aquila haben sich die USA, Kanada, Japan, Deutschland, Großbritannien, Italien, Frankreich und Russland am 08.07.2009 zu dem Ziel bekannt, den globalen Temperaturanstieg im Vergleich zum Beginn des Industriezeitalters auf zwei Grad Celsius zu begrenzen. Danach soll die angeblich durch uns bewirkte Erderwärmung 2°C nicht erreicht werden, denn anderenfalls wäre die Existenz der Menschheit gefährdet.

In Die Zeit vom 20.8.2009 urteilte Prof. Dr. Hans von Storch (GKSS HH): „Zwei Grad ist eine politische, eine sinnlose Zahl. Ich halte das für Verarschung.“ In einem am 28.10.2009 veröffentlichten Interview der Frankfurter Allgemeinen Zeitung haben die Präsidenten des Geoforschungszentrums Potsdam, Prof. Dr. Hüttl, des Alfred-Wegener-Instituts Bremerhaven, Prof. Dr. Lochte, und des Senckenberg-Museums, Prof. Dr. Mosbrugger, das 2°-Ziel als unbegründet und nicht zweckmäßig beurteilt. Dieses Urteil der höchsten geowissenschaftlichen Fachinstanzen blieb unberücksichtigt. Die Bundesregierung und ein Teil der Wissenschaft hielten daran fest – und selbstverständlich in populistischer Ausschlachtung auch die Medien. Kompetente Gegenstimmen gab es genug, sie blieben unwirksam. Der geologischen Sicht des Autors kommt die Bewertung von Prof. Dr. Horst Malberg (FU Berlin) am nächsten [3]: "Wie ideologisch vermessen muss man sein, um der Natur ein „2-Grad-Ziel“ vorzugeben. Der dominierende solare Einfluss auf unser Klima in Verbindung mit dem thermischen Gedächtnis des Ozeans wird sich auch dann nicht ändern, wenn sich der Mensch als Zauberlehrling versucht."

Wer die Entstehungsgeschichte dieses Gebotes erfährt, kann nicht glauben, dass eine durch nichts bewiesene und dazu noch völlig fachfremde Annahme zu einem Handlungsgebot für die ganze Welt mutieren konnte. Joachim Müller-Jung, Fachjournalist der FAZ und durch viele Beiträge als Verfechter des Modells vom menschengemachten Klimawandel bekannt, hat diese Entstehungs-geschichte am 9.12.2009 in der FAZ in einem gründlichen Beitrag behandelt. Danach hat die Geschichte der Zwei-Grad-Grenze 1977 durch William D. Nordhaus begonnen: Nordhaus war an der Yale-Universität Wirtschaftsprofessor, ohne eigenen fachlichen Bezug zum Klima und zur Klimaforschung; d.h. das 2°-Ziel ist kein Ergebnis der Forschungen der Klimawissenschaftler, sondern eine Erfindung der Wirtschaftswissenschaft.

Der tatsächlich fehlende Bezug zur Klimaforschung ergibt sich u.a. schon daraus, dass das 2°-Ziel in einer Abkühlungsphase entstand, in der Wissenschaftler eher eine Eiszeit befürchteten: Am 25.2.1977 zitierte die Frankfurter Allgemeine Zeitung den amerikanischen Chemiker und Nobelpreisträger Linus Pauling mit dem Satz: „Die Klimaveränderung könne in eine globale Katastrophe münden, in den bisher härtesten Test für die Zivilisation“. Damals fürchtete man sich vor einer neuen Eiszeit, heute vor der Erderwärmung. Am 22.4.2011, also 34 Jahre später, schreibt Welt Online dazu: „In den 70-Jahren hatten wir schon mal eine intensive Debatte um die Zukunft des Weltklimas. Damals warnten uns die Wissenschaftler allerdings vor genau dem Gegenteil: einer neuen Eiszeit. Was aus der Rückschau von heute besonders auffällt: Die erwarteten Folgen glichen denen, die heute im Zusammenhang mit der Erderwärmung diskutiert werden, wie ein Ei dem anderen: Unbewohnbarkeit der Erde, Extremereignisse, Hurrikane, Dürren, Fluten, Hungerkrisen und andere Katastrophen, die CIA erwartete Klimakriege. Auch machte man den Menschen verantwortlich für den sich abzeichnenden Klimawandel“.

Das 2°-Ziel machte Karriere, weil manche Klimaforscher es gelesen oder davon gehört hatten, seine Anwendbarkeit und Nützlichkeit für ihre Zwecke begriffen, und sich gegenseitig der Bedeutung dieses Zieles versicherten. Das 2°-Ziel ist nicht das Ergebnis wissenschaftlicher Untersuchungen, sondern erinnert vielmehr an die Sage von der Wechselbeziehung zwischen dem Glöckner von Notre-Dame und dem Kanonier auf der Bastille: Wenn der Glöckner um die Mittagszeit sah, dass der Kanonier zur Kanone ging, begann er die Glocke zu läuten, und der erste Glockenschlag veranlasste den Kanonier, den Mittagsschuss abzufeuern.

Carlo Jaeger , Ökonom, Soziologe und Humanökologe und Leiter des Forschungsfeldes Transdisziplinäre Konzepte und Methoden am Potsdam-Institut für Klimafolgenforschung (PIK), hat in einem Buchkapitel geschrieben "Das Zwei-Grad Limit ist fast zufällig aufgetaucht, und es entwickelte sich dann eigentümlich widersprüchlich weiter: Politiker haben es wie ein wissenschaftliches Ergebnis behandelt, Wissenschaftler als eine politische Angelegenheit."

Weitere von Müller-Jung beschriebene Details können in diesem Rahmen nicht berücksichtigt werden. Zusammengefasst zeigt sich, dass der Einfall eines Wirtschaftsprofessors durch Weitererzählen Karriere machen konnte. Indem das 2°-Ziel auf dem G8-Gipfel zum Gebot einer offiziellen Klimapolitik erhoben wurde, ist es zum Handlungsgebot für die Welt geworden. Tatsächlich fehlt ihm jeder kausale Bezug zum Klima, wissenschaftlichen Begründungen fehlen und seine Unvereinbarkeit mit Grundgesetzen der Physik ist bewiesen. Die Karriere des 2°-Ziels gleicht einer Geschichte aus einem Märchenbuch. Trotzdem dient es dem PIK und dem WBGU (Wissenschaftlicher Beirat der Bundesregierung Globale Umweltveränderungen) als Handlungsanweisung. Der WBGU fordert einen Weltklimavertrag und schlägt sogar eine De-Karbonisierung vor – also eine Begrenzung des Kohlenstoff-Umsatzes, ungeachtet der Tatsache, dass Kohlenstoff der Grundbaustein unserer Nahrungsmittel ist, also lebensnotwendig. In der Politik und in führenden Medien gilt das 2°-Ziel längst als sakrosanktes Dogma, das zwar keiner versteht oder dessen Entstehung kennt, der aber jeden bemitleidet – oder verleumdet – , der es zu hinterfragen oder gar zu kritisieren wagt.

Schließlich sei noch an eine Tatsache erinnert: Temperaturänderungen von ³ 2°C hat es in der Erdgeschichte immer wieder gegeben, die Ganglinie in Abb. 1 verzeichnet allein drei in 6000 Jahren. Warmzeiten sind dem Leben auf der Erde immer gut bekommen. Warum sollte eine solche Erwärmung also die Menschheit gefährden? Die Weltbewegung ‚Erwärmung vermeiden’ unterliegt offensichtlich einer Auto-Hypnose.

4°C und mehr ?

In Unkenntnis klimatologischer Grundlagen haben die Agitatoren ‚unseres’ Klimawandels nicht berücksichtigt, dass die Sonne als Regisseur unseres Klimas es auf der Erde phasenweise wärmer oder kühler werden lässt. Gegenwärtig wird es wieder mal kühler, so dass die Diskrepanz zwischen Messwerten und Simulationsergebnis wächst. Vielleicht haben Anhänger des Modells ‚anthropogener Klimawandel’ auch nur gehofft, dass der Unterschied zwischen Wunsch und Wirklichkeit erst nach Erreichen der eigenen Pensionsgrenze so offensichtlich wird, dass selbst die Hartliner die Realität nicht mehr übersehen können.

Dieser Klimawandel wurde von Teilen seiner Initiatoren als Geschäfts- und Beschäftigungsmodell angelegt, wie in Teil 2 dieser Stellungnahme begründet wird. Anderen Anhängern wurde er im Laufe der Zeit zu einer Ersatzreligion. Nun raubt ein seit 15 Jahren andauernder Erwärmungs-Stop mit einer deutlichen Tendenz zu einer neuen Abkühlungsphase den Propagandisten und den Gläubigen ihre Handlungsgrundlage. Wie darf man trotzdem dabei bleiben? Man erklärt sie als Pause und praktiziert Mark Twain (frei angepasst): „Als das Ziel ihren Augen entschwand, verdoppelten sie ihre Anstrengungen, es zu erreichen.“ Also wird unsere Klimazukunft in noch düsteren Farben gemalt, damit die Politik weiter für die existenzsichernden Ressourcen sorgt. Der Weltklimarat prognostiziert jetzt eine noch stärkere Erwärmung und wieder einen viel stärkeren Anstieg des Meeresspiegels. Dass bei diesen Bemühungen naturwissenschaftliche Grundkenntnisse vergewaltigt werden, nimmt man in Kauf.

Und was wurde gemessen ?

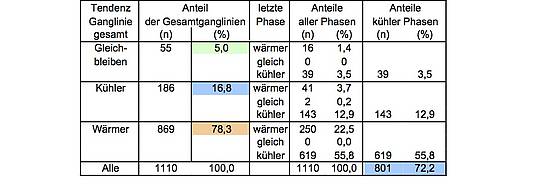

Was zu erwarten war, ist eingetreten: Offiziell macht die Erwärmung nur eine Pause, tatsächlich beweisen die gemessenen Temperaturen, dass statt der vorausberechneten Erwärmung seit etwa 15 Jahren eine Abkühlungsphase stattfindet, wie die von Ewert vorgenommene Detailauswertung der von NASA-GISS angebotenen Kurzzeit-Temperaturreihen von weltweit 1110 Stationen demonstriert. Dabei wurden für jede Ganglinie insgesamt und für deren aufeinanderfolgende Warm- und Kaltphasen die Gradienten bestimmt; eine Kurzfassung ist bei EIKE archiviert [4]. Die Ergebnisse sind in Tab. 1 zusammengefasst. Es zeigt sich, dass immerhin 22% der Stationen zwischen 1880 und 2010 überhaupt keine Erwärmung registriert haben, sondern Gleichbleiben oder Abkühlung, und dass 72% aller Stationen in der letzten Phase eine deutliche Abkühlung gemessen haben, die zwischen 1995 und 2000 beginnt und noch andauert.

Tab. 1: Ergebnisse der Auswertung von 1110 Kurzzeit-Temperaturreihen angeboten von NASA-GISS

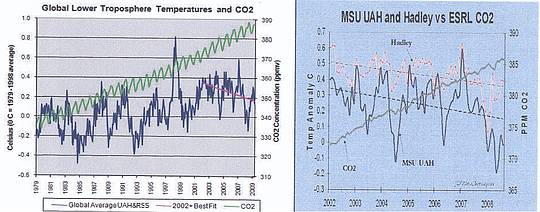

Trotz dieser Abkühlung ist der CO2-Gehalt der Atmosphäre weiter gestiegen, wie Abb. 3 exemplarisch zeigt. Solch’ gegenläufige Entwicklungen hat es in der Erdgeschichte wiederholt gegeben, als der Globus trotz sehr viel größerer CO2-Gehalte weitreichend vergletschert war.

Abb. 2: Gegenläufige Entwicklung von Temperatur und CO2-Konzentration – links: ab 1979, rechts: ab 2002

Fazit

Die um 1800 beginnende natürliche Rückerwärmung nach der Kleinen Eiszeit umfasst Erwärmungs- und Abkühlungsphasen, wobei dem generellen Trend entsprechend die Erwärmung stärker ausfällt, so dass im 20 Jh. die Erwärmung etwa 0,6°C erreicht. Es findet derzeit kein nennenswerter oder gar dramatischer wirklicher Klimawandel statt, denn für einem Wandel in ein wärmeres Klima werden einige Grad benötigt.

Das 2°-Ziel wurde in der Abkühlungsphase 1960-1980 zunächst wirtschaftswissenschaftlich definiert. Seinem Ursprung entsprechend hat es keine klimatologische Bedeutung. Es wurde von Klimaforschern übernommen, die es für ihre Zwecke nützlich fanden. Und danach wurde es auf einem G8-Gipfel als Gebot der offiziellen Klimapolitik definiert.

Es bleibt abzuwarten, ob mit der gegenwärtigen Abkühlungsphase das Ende der Rückerwärmung nach der Kleinen Eiszeit erreicht ist, oder ob – und wann – eine neue Warmphase folgt. Die Klimageschichte der Erde kennt viele Erwärmungsphasen von 2°C – und mehr. Sie haben das Leben der Primaten nicht gefährdet, Warmphasen haben das Leben gefördert.

Literatur

[1] Ewert F-K: Langzeit-Temperaturreihen widerlegen menschengemachten Klimawandel. Fusion 32,

2011, Nr. 3, S.31-61, 29 Abb, 14 Tab.

[2] Eichner J.F., Koscielny-Bunde E., Bunde A, Havlin S. and Schellnhuber H.-J., Power-law persistence

and trend

in the atmosphere: A detailed study of long temperature records, Phys. Rev. E 68, 046133 (2003)

[3] Malberg H.: Beitr. z. Berliner Wetterkarte, 28.9.2010, 58/10, SO 26/10,

http://www.Berliner- Wetterkarte.de,

[4] Ewert F-K.: „Was lehren die GISS-Originaldaten?“ und „GISS ‚korrigiert’ seine Temperaturdaten“, Auswertungsberichte, 2011 bei EIKE archiviert; Publikation in Vorbereitung.

Der Beitrag kann auch als pdf heruntergeladen werden.