John Cook, ein Blogger, der die Site mit dem hinterhältigen Titel „SkepticalScience“ betreibt, (der ganz unskeptisch die Mainstream-Position verteidigt), hat versucht, die Schmierenstrategie gegen die Tausende Wissenschaftler wiederzubeleben, die eine abweichende Meinung vertreten. Die neue Studie verwechselt Klimaforschung mit finanziellen Kräften, basiert auf den falschen Hypothesen, benutzt trügerische Schlussfolgerungen, war nicht unabhängig und verwechselt einen Konsens unter Klimawissenschaftlern mit einem wissenschaftlichen Konsens; nicht das ein Konsens irgendetwas beweist, so er überhaupt existiert.

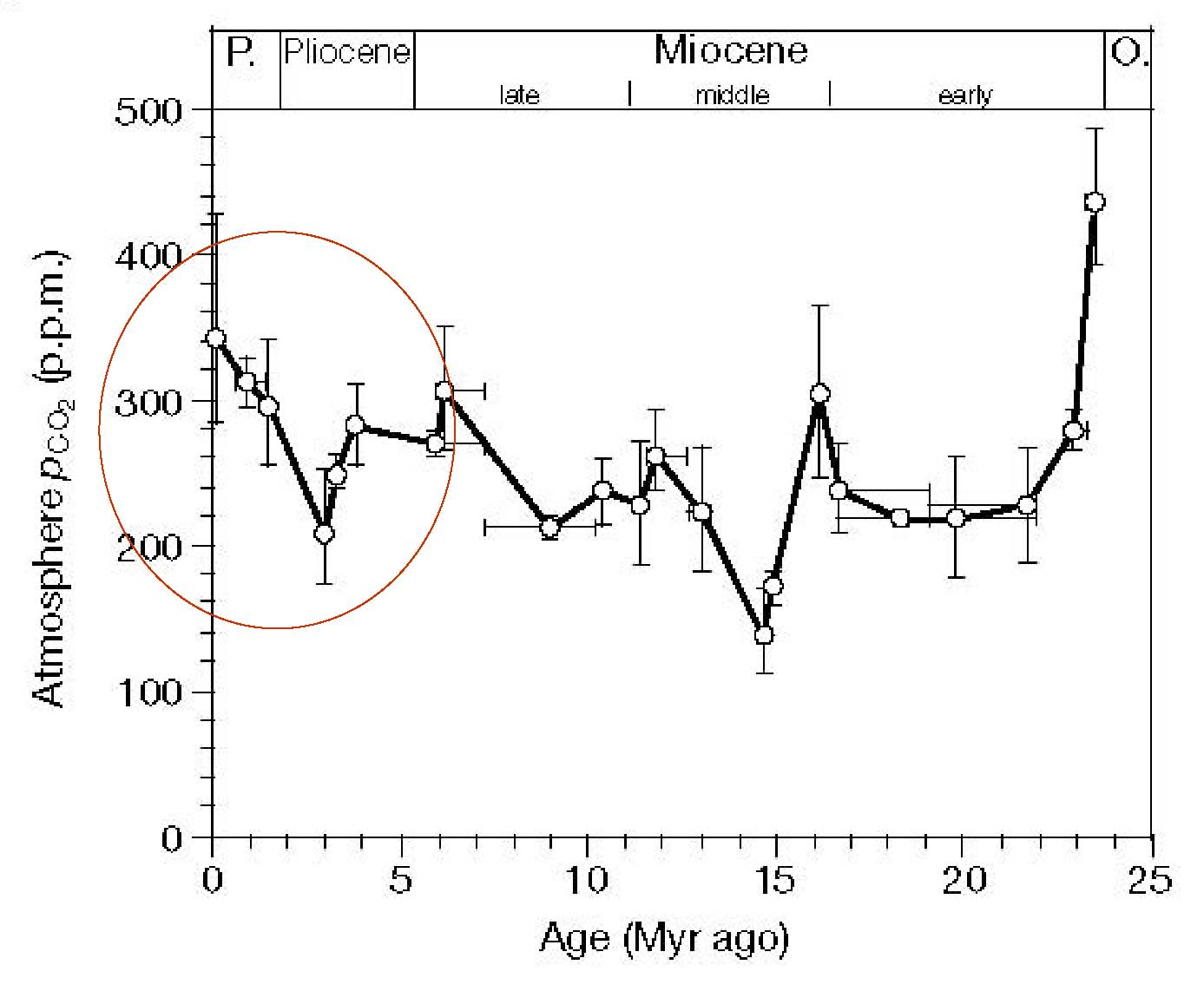

Angesichts der monopolistischen Finanzierung der Klimawissenschaft während der letzten 20 Jahre sind die von ihm gefundenen Resultate vollständig vorhersehbar.

Die zwölf Hinweise, die sich gute Journalisten merken sollten:

1. Tausende Studien unterstützen die vom Menschen verursachte Klimaänderung, aber in keiner einzigen findet sich dafür ein schlüssiger Beweis

Cook mag 3896 Studien gefunden haben, in denen die Theorie, dass menschliche Emissionen das Klima kontrollieren, befürwortet wird, aber er kann keine einzige Studie nennen mit Beobachtungen, die zeigen, dass die Hypothesen der IPCC-Klimamodelle über Wasserdampf und Wolken-Rückkopplungen richtig sind. Diese Hypothesen erzeugen die Hälfte bis zwei Drittel der in den Modellen projizierten Erwärmung. Wenn die Hypothesen falsch sind (und in Dutzenden Studien wird gezeigt, dass genau das der Fall ist), dann ist die vorhergesagte Erwärmung erheblich übertrieben. In vielen der Studien auf seiner Liste geht es um diese falschen Modelle.

Mit anderen Worten, er hat 3896 nicht beweiskräftige und danach gescheiterte bzw. korrekte, aber irrelevante Studien gefunden. Das Wichtigste an seiner Studie ist die Aussage, dass – nachdem Tausende Wissenschaftler die besten Daten, die sie während 20 Jahren finden konnten, ins Spiel brachten – sie immer noch keine schlüssige Unterstützung bekommen haben.

2. Die Studie von Cook zeigt, dass 66% der Studien nicht die vom Menschen verursachte globale Erwärmung befürworten

Cook nennt dies einen „überwältigenden Konsens“.

Sie haben „11944 Klima-Abstracts von 1991 bis 2011 zu den Themen ‚globale Klimaänderung’ oder ‚globale Erwärmung’ untersucht. Wir finden, dass 66,4% der Abstracts keine Haltung zu AGW ausdrückten, 32,6% befürworteten AGW, 0,7% wiesen AGW zurück und 0,3% waren sich über die Ursache der globalen Erwärmung unsicher“.

Vielleicht spiegelt die große Zahl derer, die unsicher waren, einfach folgende Situation: Klimawissenschaft ist kompliziert, und die meisten Wissenschaftler sind sich nicht sicher, von wem oder was das Klima angetrieben wird. Das relative Fehlen skeptischer Studien hier liegt an den in den Punkten 4, 5 und 7 beschriebenen Ursachen. Es ist aber auch in jedem Falle irrelevant. Man braucht nur eine einzige Studie, um zu zeigen, dass seine Theorie falsch ist. Wer zählt?

3. Cooks Methode ist ein logischer Trugschluss: Argument durch Autorität. Das ist nicht Wissenschaft, sondern PR.

Der Unterschied zwischen Wissenschaft und Religion besteht darin, dass nur empirische Beweise zählen und nicht Meinungen. Es gibt keine Götter der Wissenschaft. Daten und nicht Menschen sind die Autorität, die das Sagen hat (es gibt keinen Pabst der Studien). Cook verkehrt das in sein Gegenteil. Das ist Anti-Wissenschaft. Es ist so, als ob sie sagen, dass die Schwerkraft die Erde in ihrem Orbit hält, und sie sagen nicht, dass dies deswegen so sei, weil „97% aller Geophysiker dafür gestimmt haben“.

Cook weiß das (ich erinnere ihn fortwährend daran), aber er tut so, als umgehe er es. Erkennen Sie die Täuschung: „Wissenschaftler müssen ihre Meinungen mit einer auf Beweisen beruhenden Analyse stützen, die die sorgfältige Prüfung durch Experten auf dem Gebiet übersteht. Dies bedeutet, dass begutachtete Literatur ein robuster Indikator des Status’ des wissenschaftlichen Konsens’ sind“. Cook vermutet, dass die Meinungen der Wissenschaftler sofort und akkurat und ausschließlich auf den Beweisen ruhen, als ob Menschen Intel Chips sind. Er vermutet, dass „Begutachtung“ nicht korrupt ist (anders als jede andere menschliche Institution), dass zwei unbezahlte anonyme Begutachter „Sorgfalt“ ist, dass aktivistische Klimawissenschaftler nicht daran arbeiten, Skeptiker aus dem Begutachtungsprozess herauszuhalten und dass Klimagate niemals bekannt gemacht hatte, was wirklich in der Klimawissenschaft los ist.

Müssen Leute, die psychologische Forschungen betreiben, die Grundlagen der menschlichen Natur verstehen? Wissenschaftler können der falschen Ansicht jahrelang anhängen – man schaue nur auf diejenigen, die dachten, dass die Menschen niemals fliegen würden (selbst noch zwei Jahre nach dem ersten Flug der Gebrüder Wright), oder dass Röntgenstrahlen in Schuhgeschäften sicher seien, oder dass Geschwüre nicht infektiös sind oder dass Proteine nicht ansteckend seien (damals BSE genannt).

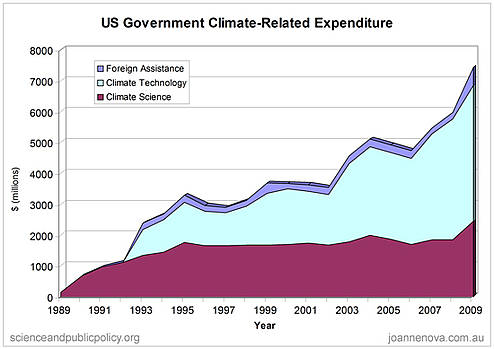

4. Die Anzahl der Studien ist ein Proxy der Förderung

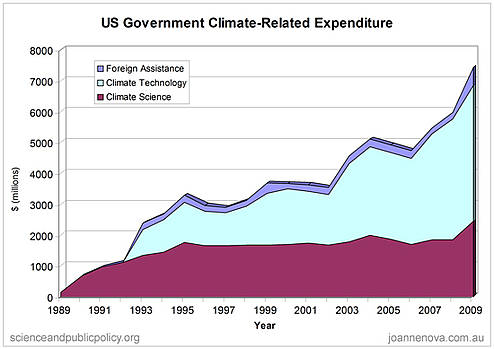

Mit dem Anwachsen der Förderung dirigierten die Wissenschaftler ihre Arbeiten um auf Felder, die für Zuwendungen attraktiv waren. Das ist keine Konspiration, sondern lediglich Adam Smith [= Adam Riese?] bei der Arbeit. Es gab keine Förderung skeptischer Wissenschaftler, die das IPCC oder die Theorie, dass die vom Menschen durchgeführte Klimawissenschaft die Erwärmung übertreibt, in Frage stellte. Mehr als 79 Milliarden Dollar wurden von 1989 bis 2009 in Forschung und Technologie der Klimawissenschaft gesteckt. Da ist es kein Wunder, das Wissenschaftler sich wiederholende, irrelevante und schwache Ergebnisse hervorbrachten. Die Steuerzahler wurden sogar für Forschungen an klimaresistenten Austern zur Kasse gebeten. Man lasse kein Blatt unumgedreht.

Die schiere Quantität von Abstracts, die die vom Menschen verursachte Klimaänderung befürworten, hat zugenommen, die Förderungen jedoch ebenfalls.

Während des gleichen Zeitraumes wurden 79 Milliarden Dollar in die Klimaforschung und die Entwicklung mit dem Klima zusammenhängender Technologien gesteckt.

Das Problem monopolistisch geförderter Modelle besteht darin, dass es kaum Wettbewerb gibt. Nur wenige Forscher werden dafür bezahlt, Forschungsnischen zu erkunden, die vermutlich mit der Theorie nicht übereinstimmen. Freiwillige, die ihre eigenen Forschungen durchführen wollen, erhalten keinen freien Zugang zu Journalen, haben Schwierigkeiten, an Daten zu kommen (manchmal dauert es Jahre oder es bedarf Gesetzen, sie zu bekommen, und manchmal erhält man sie niemals). Freiwillige verfügen nicht notwendigerweise über die Ausrüstung, die Analysen durchzuführen, und ihnen stehen keine Doktoren oder Ehrenstudenten als Hilfen zur Verfügung. Man bezahlt ihnen auch nicht die Reisen zu Konferenzen, und sie leiden unter der Behinderung, dass sie Zeit aufbringen müssen, um sich unabhängig von ihren Forschungen ihren Lebensunterhalt zu verdienen. Wenn sie wirklich etwas herausfinden, dann stehen keine PR-Teams bereit, ihre Studien zu propagieren oder Presseerklärungen zu formulieren.

In der Finanzwelt gibt es Audits, im Gericht die Verteidigung, im Parlament die Opposition, aber in der Wissenschaft gibt es … was immer die Regierung zu finanzieren gedenkt.

Im Endeffekt gibt es keinerlei Förderung, weder durch eine Zuwendung noch ein Institut, das aktiv die Menschen ermuntert, nach Gründen zu forschen, warum die vom IPVV favorisierte Theorie falsch sein könnte.

5. Die meisten dieser Konsens-Studien vermuten, dass die Theorie korrekt ist, haben dies aber niemals geprüft. Sie sind irrelevant.

Die aufgezählten, die durch den Menschen verursachte globale Erwärmung befürwortenden Studien enthalten auch die „implizite Befürwortung“, was diese Studie mehr zu einer Analyse der Förderung anstatt der Beweise macht. Cook nennt folgendes Beispiel einer Studie mit einer impliziten Befürwortung: …die Sequestrierung von Kohlenstoff in der Erde ist wichtig, um die globale Klimaänderung abzuschwächen. Jeder Forscher, der die Sequestrierung von Kohlenstoff erforscht, hat fast mit Sicherheit die von der oberen Troposphäre ausgehende Strahlung analysiert oder die Hypothesen hinsichtlich der Relativen Feuchtigkeit in Klimasimulationen. Ganz ähnlich wissen Forscher, die Auswirkungen der Klimaänderung an Lemuren, Schmetterlingen oder Eisbären untersuchen, vermutlich wenig über Berechnungen des Wärmegehalts der Ozeane. Diese Forscher sind „ich auch“-Forscher.

Falls eine konservative Regierung Milliarden ausgegeben hat, um die Kosten gescheiterter Klimamodelle und die Auswirkungen desaströser grüner Programme zu analysieren, sind Skeptiker in der Lage, genauso viele ich-auch-Studien wie Cook zu nennen. (Aber wir würden es nicht tun, weil die Analyse des Klimas mit Stichwort-Studien [keyword studies] keine Wissenschaft wäre.

6. An Gläubige wurde 3500 mal mehr Geld gezahlt als an Skeptiker (aus allen Quellen zusammen).

Cook scheint zu glauben, dass es organisierte Bemühungen gibt, die Öffentlichkeit zu verwirren. Handelt es sich hier um eine schändliche Absicht mit konspirativen Vorschlägen mysteriöser Kampagnen?

Kampagnen, die darauf abzielen, die Öffentlichkeit über das Niveau der Übereinstimmung unter den Klimawissenschaftlern zu verwirren, tragen zu dieser ‚Konsens-Lücke’ bei.

Angesichts seiner Verwirrung darüber, was Wissenschaft ist, denkt er möglicherweise, dass die Leute ihn zu verwirren versuchen, wenn sie es ihm direkt sagen.

Sein eigener persönlicher Bias bedeutet, dass er der falsche Mann für diese Studie ist (falls das Ganze wirklich einer Studie wert ist, was es nicht ist).

Sie trägt alle Anzeichen aktivistischer Propaganda, nicht Forschung. Cook versucht zu vermitteln, dass Skeptiker es für Geld tun, und ignoriert völlig, wohin die Gelder wirklich fließen. Die Regierungen haben nicht nur 79 Milliarden Dollar in die Forschung gesteckt, sie geben auch jedes Jahr 70 Milliarden Dollar an Subventionen für Erneuerbare aus (eine Industrie, die davon abhängig ist, dass Forscher einen Zusammenhang finden zwischen Kohlendioxid und einer katastrophalen Klimaänderung). Kohlenstoffmärkte setzen pro Jahr größenordnungsmäßig um 170 Milliarden Dollar um, und Investitionen in Erneuerbare summieren sich zu einer Viertelbillion Dollar [a quarter of a trillion dollars]. Diese persönlichen Interessen hängen vollständig von der Verbindung mit einer Katastrophe ab – wo steckt der Sinn, Kohlenstoffemissionen zu stoppen, wenn der Kohlenstoff nicht zu einer Krise führt? Und gegen all diese Milliarden glaubt Cook, dass eine 20 Jahre alte Zahlung von 150000 Dollar von Western Fuels der Erwähnung wert ist. Was genau war das große Verbrechen von Western Fuels? Ihr primäres Ziel bestand vermutlich in der Sünde zu versuchen, die globale Erwärmung als Theorie, nicht als Faktum zu beschreiben, was zufälligerweise genau stimmt, außer das die „globale Erwärmung“ technisch nicht einmal eine Theorie, sondern eine Hypothese ist, also etwas mit viel geringerem wissenschaftlichen Gewicht.

Spielt Klimageld eine Rolle? Ist ein Monopol gut für einen Markt?

Glauben Sie, dass Sie – im Falle Ihnen stünden 79 Milliarden Dollar zur Verfügung – 3896 Studien veröffentlicht bekommen?

7. Beim Suchen nach Stichworten findet man die wichtigsten skeptischen Studien nicht

Die Suche nach Stichworten fördert mit größerer Wahrscheinlichkeit eher „Konsens“-Studien zutage. In vielen skeptischen Studien kommen die Begriffe „globale Erwärmung“ oder „globale Klimaänderung“ gar nicht vor. Beispiele: Svensmark (1998), Douglass (2007), Christy (2010), Loehle (2009) und Spencer (2011). Waren sie enthalten? Vielleicht, aber sie scheinen nicht zu den Suchbegriffen zu passen. Dies sind lediglich einige wenige grundlegende Studien, die nicht gefunden worden sind.

Aktualisierung: Lucia und JunkPschology bestätigen in Kommentaren, dass diese genannten sechs Studien nicht in Cooks Liste aufgetaucht wären. Also kann ich in lediglich einer halben Stunde in einer Stichprobensammlung leicht wesentliche Studien von Skeptikern aufrufen, die aus der Liste von Cooks primitiver Stichwortsuchliste herausfallen. Wie viele andere findet er auch nicht?

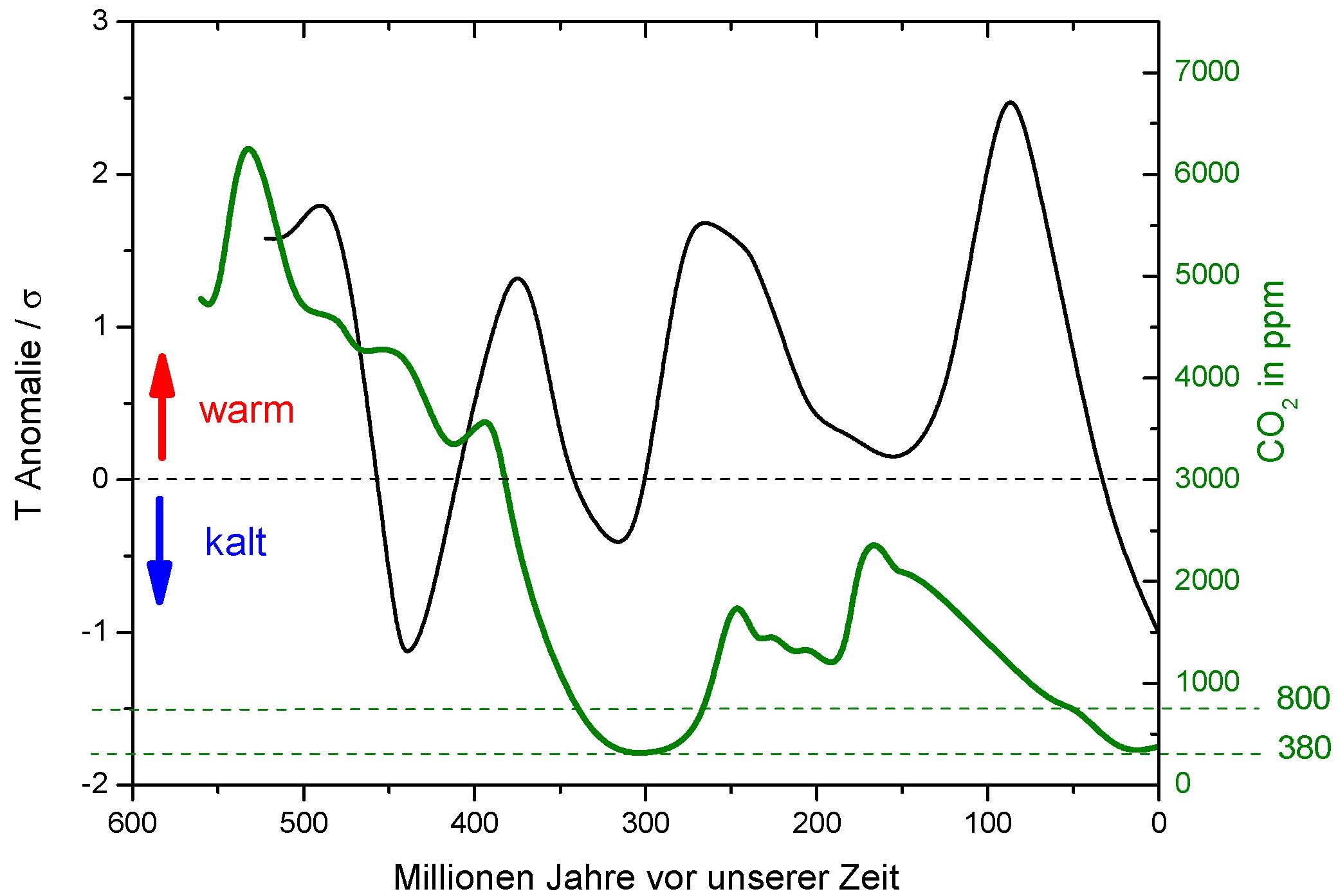

8. Einige dieser Abstracts sind 20 Jahre alt – ändern zwei Jahrzehnte neuer Beweise irgendetwas?

Vor 20 Jahren hat das IPCC vorhergesagt, dass wir eine Erwärmung um 0,3°C pro Dekade bekommen werden. Der bisherige Erwärmungstrend lag deutlich noch unterhalb ihrer niedrigstmöglichen Abschätzung egal welchen wesentlichen Datensatz man heranzieht. Damals wussten die Wissenschaftler noch nicht, dass es in Eisbohrkernen eine Verzögerung von 800 Jahren gab (wobei die Temperatur Jahrhunderte vor einem Anstieg des Kohlendioxids gestiegen ist). Im Jahr 1992 haben die Wissenschaftler noch nicht mitbekommen, dass die Erwärmung schon bald fünfzehn Jahre lang zum Stillstand kommen würde. Sie wussten nicht, dass 28 Millionen Radiosonden zeigen würden, dass ihre Modelle auf falschen Hypothesen über Wasserdampf beruhen. Sie wussten nicht, dass 3000 ARGO-Bojen schließlich zum ersten Mal adäquat die Ozeane vermessen würden (seit 2003) – und herausfinden würden, dass die Ozeane nicht wie in ihren Modellen simuliert die fehlende Energie speichern oder sich auch nur annähernd so schnell aufheizen wie die Modelle vorhergesagt hatten. Mit anderen Worten, selbst wenn es 1992 einen Konsens gegeben hat, ist das irrelevant.

9. Naomi Oreskes hat 928 Studien gefunden mit Abstracts, die die vom Menschen verursachte globale Erwärmung nicht explizit zurückgewiesen haben. So? Die Skeptiker haben 1100 Studien gefunden, die skeptische Standpunkte stützen.

Skeptiker veröffentlichen keine Presseerklärungen, die behaupten, dass das irgendeine wissenschaftliche Bedeutung hat. Es bedeutet vielmehr, dass die Medien und das IPCC blind und taub gegenüber massenhaften Beweisen sind, und dass der Ausdruck „Leugner“ … nun, Marketing ist, nicht Wissenschaft. Die Leute, die die Existenz dieser 1100 Studien leugnen, sind diejenigen, die die anderen Wissenschaftler mit Ausdrücken verunglimpfen. Wann endlich werden Journalisten das zur Kenntnis nehmen?

Angesichts der Geldsummen, die gezahlt worden sind, um Beweise zu finden – die Frage, die echte Investoren stellen sollten lautet: „ist das alles, was sie gefunden haben?“

10. Wollen Sie Autoritäten? Die Skeptiker können 31500 Wissenschaftler benennen, die deren Standpunkten zustimmen, darunter 9000 mit einem PhD, 45 NASA-Experten (einschließlich zweier Astronauten, die den Mond betreten hatten) und zwei Gewinner des Physik-Nobelpreises.

Skeptiker veröffentlichen keine Presseerklärungen, die behaupten, dass wir den Gläubigen an Zahl überlegen sind, aber Skeptiker bevorzugen es, die Beweise vorzubringen. Cook ignoriert die Autoritäten, die ihm nicht folgen. Skeptiker bekommen Nobelpreise, aber Gläubige scheinen nur Preise für den Frieden zu bekommen. Phil Jones ist einer der größten Experten unter den Klimawissenschaftler-Experten, aber er konnte in Excel keine lineare Trendlinie erzeugen. Andererseits waren einige Skeptiker auf dem Mond.

Kein Wunder, dass die Öffentlichkeit nicht glaubt, dass es einen Konsens gibt. Es gibt unter den Wissenschaftlern keinen Konsens.

Cook glaubt gefunden zu haben, dass die Öffentlichkeit durch eine vorsätzliche Kampagne genarrt worden ist, aber solange verschlagene Skeptiker Kontinente unter Wasser oder mit Schnee überziehen können, kann es sein, dass die Öffentlichkeit das Scheitern der Modelle mit eigenen Augen erkennen kann.

11. Was ist mit den wissenschaftlichen Vereinen? Aber sie bestehen nicht aus Massen von Wissenschaftlern – sondern bilden lediglich ein Komitee mit sechs von ihnen.

Die meisten wissenschaftlichen Vereine fordern ihre Mitglieder niemals zur Abstimmung auf (oder, wenn das doch der Fall ist, legen bizarre Regeln fest, wie es die Royal Society getan hatte, die ihre Mitglieder kürzlich aufforderte, mit Ja oder mit Ja zu stimmen bei der Frage, ob man Prinz Andrew die Mitgliedschaft antragen sollte). Wenn wissenschaftliche Vereine alle ihre Mitglieder befragen, bestehen die meisten Antworten aus einem nachhallenden „nein“. Mit den Milliarden Dollar im Hintergrund – ist es da ein Wunder, dass unermüdlicher Aktivismus seitens Regierungsabteilungen, Erneuerbaren-Unternehmen und andere Akademiker verzweifelt versuchen, den Geldzug am Rollen zu halten, dazu gedacht, die Komitees in den Schatten zu stellen?

12. Cook sagt im Wesentlichen, dass es hier nicht um einen wissenschaftlichen Streit geht – sondern es ist eine Taktik, die öffentliche Meinung durch Wiederholen der Trugschlüsse zu ändern.

Im ersten Satz sowohl im Abstract als auch in den Conclusions heißt es, dass es in dieser Studie um die öffentliche Auffassung und die Regierungspolitik geht. Es geht nicht um Wissenschaft. Sie ist gedacht zu helfen, die öffentliche Meinung zu ändern. Es gab keinen Versuch herauszufinden, ob es einen wissenschaftlichen Konsens gibt – geschweige denn einen Konsens unter allen Wissenschaftlern. Cook erklärt pragmatisch: falls die Menschen glauben, dass es einen Konsens gibt, unterstützen sie bereitwilliger eine Politik zur Abschwächung der globalen Erwärmung. Wir wissen von Cooks früheren Verlautbarungen, dass er persönlich politische Maßnahmen bevorzugt, das Wetter zu ändern. Finanziert der australische Steuerzahler Forschungen, um etwas Neues zu erfahren, oder um die öffentliche Meinung und das Wählerverhalten zu ändern? (wie wurde diese Studie finanziert? In den Danksagungen [acknowledgements] steht davon nichts?)

Cook fährt fort, mit Ausdrücken um sich zu werfen sowie mit dem unwissenschaftlichen Missbrauch der englischen Sprache.

Selbst Cook räumt ein, dass der Ausdruck „Klimaleugner” nicht gerechtfertigt ist, und doch benutzt er diesen Ausdruck weiterhin. Es ist ein Missbrauch der englischen Sprache, der Außenstehende dazu bringt zu glauben, dass Cook hier einen echten Punkt macht. Wenn die Beweise, die sie haben, wirklich so überwältigend sind, warum wollen Cook und andere dann nicht in eine höfliche Diskussion einsteigen? Man zeige uns einfach die fehlenden Beweise! Man zeige uns relevante Modellvorhersagen von vor 20 Jahren, die sich als richtig herausgestellt haben. Der alte Trick mit anschwärzen und beschimpfen funktioniert nicht mehr.

Cook behauptet auch, dass jedes Abstract von „zwei unabhängigen, anonymisierten Bewertern“ kategorisiert worden ist. Und doch kommen die Bewerter aus seinem Partisanen-Blog, haben ihr Rating miteinander besprochen und eingeräumt, dass sie unter sich nicht unabhängig waren. Was also bedeutet „unabhängig“? Können wir stattdessen englisch sprechen?

Wissenschaft hat keine Götter

Willkommen bei den letzten Resten der Großen Angst-Kampagne, wobei die Endzeit-Strategie darin besteht, einfach das zu wiederholen, was zuvor so gut funktioniert hat, was erbärmlich falsch und ausgesprochen unwissenschaftlich ist, bis zu einer Verfügung, dass wir an die Götter der Wissenschaft glauben müssen.

Das Traurige dabei ist, dass einige Umwelt- und „Wissenschafts“-Reporter so geringe Kenntnisse haben, dass sie auf das hereinfallen, was im Wesentlichen Marketing ist, das im wissenschaftlichen Mäntelchen daherkommt.

Wenn nun nur die Überzeugten Beweise für ihre bevorzugte Lieblingstheorie haben? Dann wären Aktivisten wie Cook in der Lage, öffentlich zu diskutieren, höflich zu bleiben und ihre Sache zu erklären anstatt auf billige Schmähungen, fragwürdige Forschungen und irreführende Statements zurückzugreifen.

Link: http://joannenova.com.au/2013/05/cooks-fallacy-97-consensus-study-is-a-marketing-ploy-some-journalists-will-fall-for/

Übersetzt von Chris Frey EIKE