Alarm um das Ausbleiben der globalen Erwärmung: die fortgesetzte Abkühlung könnte die Klimawissenschaft und die Förderung grüner Energien torpedieren!

Bild rechts: Eiszeitliche Erde zum glazialen Maximum. (Global Biogeochemical Cycles, Vol. 9, 1995, pp. 377-389 (Photo credit: Wikipedia)

Kältere Temperaturen lassen Regierungs-Bürokraten, nach Profit gierenden Kapitalisten-Kumpanen und anderen Krämerseelen, deren Ambitionen von heißer Luft abhängen, den Wind kräftig ins Gesicht blasen. Selbst in Westeuropa, der Wiege der CO2-basierten Klima-Verrücktheit und der Zertifikatehandels-Korruption, fühlt man den kalten Atem. Alister Doyle, Reporter für Reuters in Oslo hat vor Kurzem beobachtet: „Schwaches wirtschaftliches Wachstum und der Stillstand der Erwärmung unterminieren den Willen der Regierung, eine rapide, Milliarden Dollar teure Verschiebung weg von fossilen Treibstoffen durchzuführen. Fast 200 Regierungen haben beschlossen, bis Ende 2015 einen Plan zur Bekämpfung der globalen Erwärmung auszuarbeiten“.

Im April hat das Europa-Parlament in Strassburg gegen ein künstliches Aufblähen des Preises im europäischen Zertifikatehandel votiert, und zwar nach dem Kollaps der Energienachfrage im Zusammenhang mit der ökonomischen Krise des Kontinents. Während der niedrige Preis für Kohlenstoff-Zertifikate für Energieverbraucher großartig ist, kann man sich sicher sein, dass dies durch Befürworter der so genannten „erneuerbaren“ Energie und des Kohlenstoffhandels ganz anders gesehen wird, hängen diese doch von höheren Treibstoffpreisen als der Markt hergibt ab, um im Geschäft zu bleiben. Das Veto des Parlaments reflektiert die ermutigende Erkenntnis, dass die ungerechtfertigte, die Wirtschaft schleifende Rationierung von Kohlenstoff eine wahnhafte Narretei ist.

Himmel… an welchem Punkt sind all die teuren Klimamodelle in die falsche Richtung gelaufen?

Der Kommentar eines Wissenschaftlers in einer Klimagate-E-Mail wurde gründlich missverstanden, als er schrieb: „Es ist unfasslich, dass politische Entscheidungsträger Entscheidungen mit einer Tragweite in Höhe von Milliarden und Billionen Dollar treffen aufgrund der Vorhersagen regionaler Klimaänderungen, die auf Modellen basieren, die nicht einmal in der Lage sind, die Prozesse, die die Klimavariabilität ausmachen, richtig zu beschreiben und zu simulieren“. Wie sich gezeigt hat, haben unsere Politiker diese horrend teuren Entscheidungen getroffen auf der Grundlage von hoch spekulativen Modell-Projektionen, zumeist vom IPCC kommend.

Ein anderer Forscher hat wohl ebenfalls den Punkt getroffen, wenn er einige sehr verstörende Konsequenzen befürchtet: „Was ist, wenn sich die Klimaänderung einfach als eine multidekadische natürliche Fluktuation herausstellt? Wahrscheinlich werden sie uns töten…“ Selbst Paul Ehrlich, am bekanntesten durch sein 1968 erschienenes Buch des Untergangs „The Population Bomb“, erkennt diese Gefahr. In einem Editorial in der Ausgabe von Nature im März 2010 schrieb er, dass eine Barriere von Herausforderungen, die der Vorstellung von einer drohenden globalen Erwärmungs-Katastrophe widersprechen, seine Alarmisten-Kollegen stärker als gewöhnlich alarmiert hat. Und weiter: „Jedermann ist bis zum Anschlag verängstigt, aber sie wissen nicht, was sie tun können”.

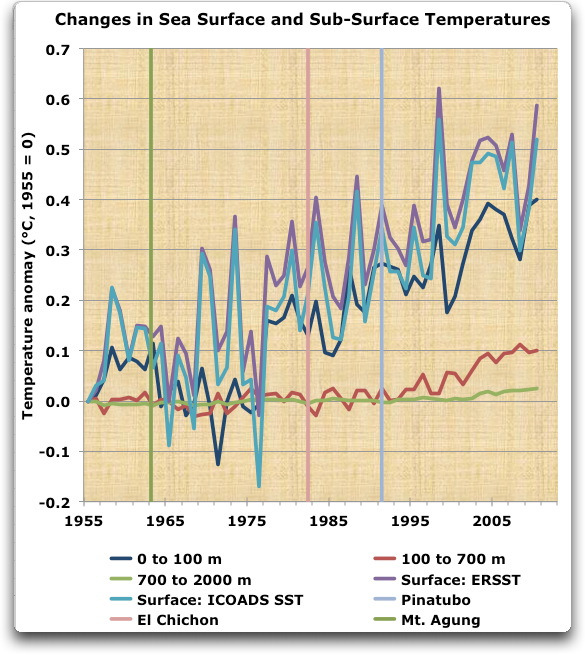

Es gibt gute Gründe für diese Betroffenheit bzgl. des sich abkühlenden Klimas. David Whitehouse von der Global Warming Policy Foundation weist darauf hin: „Wenn wir diesen Punkt nicht längst überschritten haben, sitzen wir auf einem großen Haufen globaler Beobachtungen die mit dem Konsens der Theorie der Klimaänderung immer weniger kompatibel sind“. Whitehouse merkt an, dass es seit 1997 keinen statistisch signifikanten globalen Temperaturanstieg mehr gegeben habe. Und weiter: „Wenn der Stillstand der Temperaturen noch einige weitere Jahre anhält, bedeutet das, dass niemand, der gerade das Erwachsenen-Alter erreicht hat oder noch jünger ist, Zeuge einer sich erwärmenden Erde während seines Lebens geworden ist“. (Seit 1997 hat der atmosphärische CO2-Gehalt von 370 ppm auf 390 ppm zugenommen).

Diese beobachteten Entwicklungen haben das Climate Center des UK Met.-Office dazu gebracht, seine Projektionen still und leise zu revidieren. Dort heißt es jetzt: „Die jüngste dekadische Vorhersage zeigt, dass [die Temperatur] während der nächsten fünf Jahre wahrscheinlich etwas niedriger liegen wird als in der Vorhersage zuvor angenommen“. Die vorhergesagte Zunahme von 2013 bis 2017 lag 0,43°C über dem Mittel der Jahre 1971 bis 2000, während es in der Prognose zuvor geheißen hatte, die Temperatur würde von 2012 bis 2016 um 0,54°C zunehmen. Einfacher gesagt, es wird kühler sein, als sie es vorhergesagt haben!

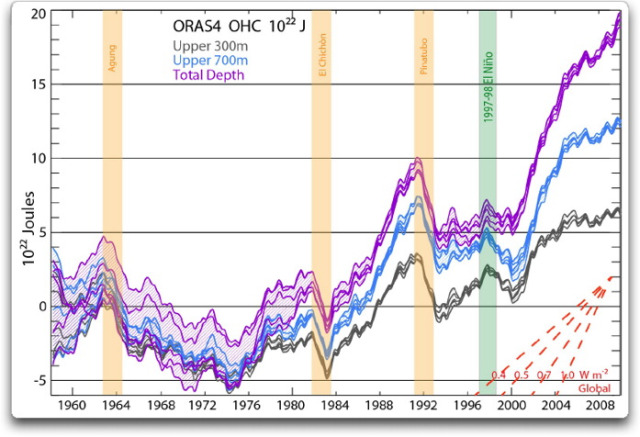

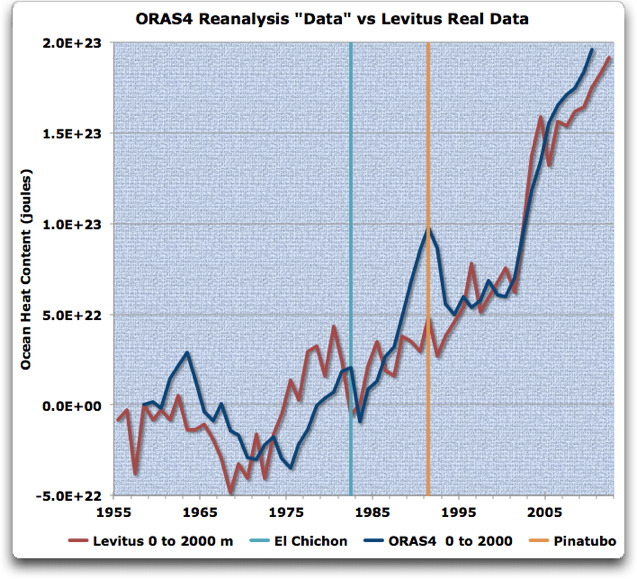

Die Daily Mail in London veröffentlichte eine Graphik, die ihren Worten nach „enthüllt, wie sehr die IPCC-Schätzung von 95%, mit der sich die Erde erwärmen soll, eine Fehlkalkulation war“. Vergleicht man den aktuellen Temperaturverlauf mit diesen IPCC-95%-Projektionen, verlief die Temperatur bis vor einigen Jahren etwa im projizierten Bereich, während sie seitdem „dabei ist, aus den Grenzen der untersten Grenzwerte auszubrechen“. Angenommen worden war, dass sie nach 1990 stark steigen sollte.

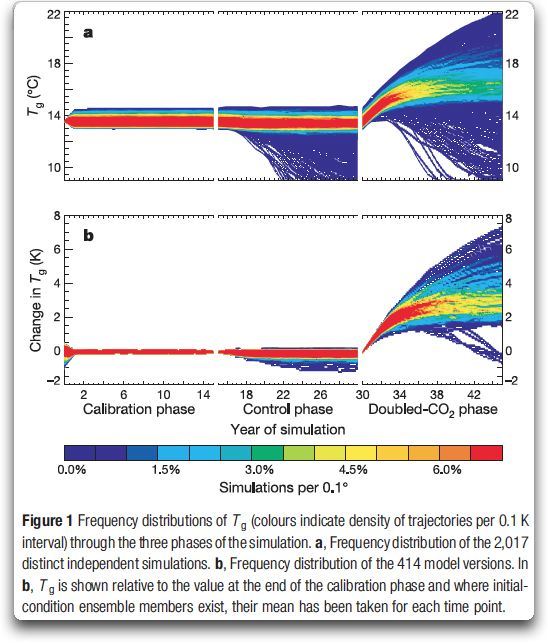

Während das IPCC vorhergesagt hat, dass die Temperatur bis zum Jahr 2050 um 3°C steigen wird, falls sich der CO2-Gehalt der vorindustriellen Zeit von 1750 verdoppelt, bezog das Research Council of Norway die realen Temperaturdaten von 2000 bis 2010 ein und berechnete, dass eine solche Verdoppelung lediglich zu einem Anstieg von 1,9°C führen würde. In einer anderen Studie in dem Journal Proceedings of the National Academy of Sciences werden Temperaturänderungen seit 1750 mit natürlichen Änderungen in Verbindung gebracht (wie zum Beispiel der Wassertemperatur im Atlantik). Dabei zeigt sich: „…der anthropogene globale Erwärmungstrend könnte in der zweiten Hälfte des 20. Jahrhunderts um einen Faktor zwei überschätzt worden sein“.

Peter Stott, ein Forscher, der das jüngste Kapitel im IPCC-Bericht zu globalen Klimaprojektionen geschrieben hatte, kam zu der Überzeugung, dass die Klimamodell-Projektionen eines alarmierenden Temperaturanstiegs mit den derzeitigen Beobachtungen inkonsistent sind. Wenn er und seine Kollegen am UK Met.-Office den von den Modellen projizierten Temperaturanstieg und die tatsächliche gegenwärtige Erwärmung miteinander vergleichen, hat sich der angenommene Temperaturanstieg infolge menschlicher Treibhausgasemissionen substantiell verringert. Mit anderen Worten, je besser die Klimamodelle die Vergangenheit abbilden, umso weniger ängstigend sieht die wahrscheinliche Zukunft aus.

Stott steht nicht allein. Während der letzten zwei Jahre kamen mindestens sieben begutachtete Studien in der wissenschaftlichen Literatur zu dem Ergebnis, dass die Auswirkungen einer Verdoppelung des CO2-Gehaltes in der Erdatmosphäre wahrscheinlich substantiell geringer sind, als das IPCC berechnet hat. Sie haben die Projektionen mit dem gewaltigen Anstieg am Ende ausgeschlossen.

James Annan, einstmals ein starker Verteidiger von Michael Manns infam betrügerischen alarmistischen „Hockeyschläger“ und ein Experte hinsichtlich der „Klimasensitivität“ von CO2 und anderen Einflussgrößen, kam in seinem Blog vor kurzem zu dem Ergebnis, dass sich das IPCC zunehmend einem vollständig unwissenschaftlichen Wirken verschreibt.

Annan weiter: „Da das IPCC seine alten Analysen nicht mehr in irgendeiner bedeutenden Weise verteidigen kann, scheint es, als ob sie sich auf eine substanzlose Haltung verlegen, etwa ‚das ist es, was wir glauben, weil wir unsere Kumpel gefragt haben’ … es hat sich selbst mit seiner politisch bequemen langen Reihe hoher Werte verbündet, und seine Antwort auf neue Beweise ist wenig mehr als sich die Ohren zuzuhalten und zu singen , la la la I can’t hear you’.”

Jene IPCC-Berichte bilden die Basis für die regulatorischen Aktivitäten der EPA im Rahmen des Clean Air Act … genauso wie die Verkündigungen des Präsidenten, dass die politischen Maßnahmen seiner Administration auf „der überwältigenden Beurteilung der Wissenschaft“ beruhen. Im Rahmen seiner Ansprache an die Nation (State of the Union Address), dass die globale Erwärmung bei der Bildung von tödlichen und zerstörerischen Stürmen wie Sandy eine Rolle spielt, sagte Präsident Obama: „Wir müssen mehr tun, um gegen die Klimaänderung zu kämpfen … Es stimmt, dass kein Einzelereignis einen Trend markiert. Aber Tatsache ist, dass die 12 wärmsten Jahre seit Beginn von Aufzeichnungen alle während der letzten 15 Jahre aufgetreten sind. Hitzewellen, Dürren, Buschfeuer und Überschwemmungen – alle kommen jetzt häufiger vor und sind intensiver“.

Aber hier gibt es eine starke Abweichung von den Fakten. In Wirklichkeit gab es keine Zunahme der Stärke oder Häufigkeit von auf das Festland übergetretenen Hurrikanen, jedenfalls in den fünf Haupt-Hurrikangebieten der Welt während der letzten 50 bis 70 Jahre; es gab keine Zunahme der Stärke und Häufigkeit bei der Entwicklung von Hurrikanen im tropischen Atlantik während der letzten 370 Jahre; die USA erleben derzeit die längste Periode denn je ohne einen Übertritt von Hurrikanen der Kategorie 3 bis 5 auf das Festland; es gab seit 1950 keinen Trend zu einer gesteigerten Häufigkeit starker Tornados (F3 bis F5); es gab keine Zunahme der Größenordnung von Überschwemmungen in den USA während der letzten 85 Jahre; und der langzeitliche Anstieg des Meeresspiegels beschleunigt sich nicht.

Aber, wenn das IPCC falsch liegt, was ist dann mit den jüngsten Hitzewellen?

Unter Verweis auf die hohen Temperaturen in den USA während des vorigen Sommers hat uns der frühere NASA-Mitarbeiter und ewige Anti-fossile-Treibstoffe-Aktivist James Hansen gewarnt, dass „der August die Art Zukunft gezeigt hat, die die Klimaänderung uns und unserem Planeten bringen würde“. Dies nachplappernd hat Al Gore auf seiner Website lamentiert: „schmutziges Wetter wird erzeugt durch schmutzige Energie“ … „eine Menge Leute rufen lauthals ‚mir ist zu heiß!’“. Selbst die NOAA sagte, dass das Festland der USA im Jahr 2012 das wärmste jemals erlebt hat.

Und doch, wie der bekannte Blogger Marc Morano bei Climate Depot feststellt: „Die NOAA kann nur wegen statistischer Tricks behaupten, das Jahr 2012 sei das wärmste jemals gewesen … einschließlich des ‚Anpassens’ von Rohdaten und der Hinzufügung von Daten zum Gesamt-Datensatz von Stationen, die zu Beginn der Aufzeichnungen noch gar nicht existiert hatten. Unterlässt man diese illegitimen Aktionen, zeigt sich, dass es in den dreißiger Jahren immer noch wärmer war als von 1990 bis 2010“.

Vielleicht ist es keine Überraschung, dass wir aus den Medien nicht viel über die Tatsache erfahren haben, dass im Juni vorigen Jahres in 46 US-Städten einschließlich einiger ganz im Süden, bestehende Kälterekorde eingestellt oder gebrochen worden waren … oder das Alaska, das nicht Teil der 48 zusammenhängenden US-Staaten ist, einen der kältesten Winter seit 2000 registriert hatte. Dem Alaska Climate Research Center an der University of Alaska-Fairbanks zufolge war dieser Rekord an 19 der 20 nationalen Wetterstationen aufgetreten, die sich von einer Ecke des Staates bis zur anderen erstrecken.

Die New York Times berichtete atemlos: „Die Temperaturunterschiede zwischen den Jahren werden gewöhnlich in Bruchteilen eines Grads gemessen, aber das Mittel von 55,3°F [ca. 13°C] in den zusammenhängenden Staaten brach den Rekord aus dem Jahr 1998 um ein ganzes Grad Fahrenheit [=ca. ein halbes Grad Celsius]“. Aber aus irgendwelchen Gründen sahen sie keinen Grund zu erwähnen, dass das Jahr 2008 zwei Grad kälter war als 2006, oder dass die Jahre 2000, 2003, 2004, 2008, 2009 und 2010 alle kälter ausgefallen waren als 1998, und zwar mehr als das Jahr 2012 verglichen mit 1998 wärmer ausgefallen war. Und übrigens sollte man nicht vergessen, dass die USA nicht der Globus sind. Jene 48 Staaten repräsentieren lediglich 1,58% der Erdoberfläche.

Die meiste Zeit im Winter 2011/2012 lag die Eisausdehnung in der Beringsee zwischen 20 und 30 Prozent über dem Mittel der Jahre 1979 bis 2000 (hier), wobei im Februar die größte Ausdehnung jemals gemessen worden ist. James Taylor berichtete, dass das antarktische Meereis ebenfalls eine Rekordausdehnung erreichte, wobei die größte jemals gemessene Eismenge am 256. Kalendertag des Jahres 2012 aufgetreten war. Tatsächlich hat sich das antarktische Meereis stetig ausgedehnt, seit die Überwachung mit Satelliten vor 33 Jahren begonnen hat, und die Ausdehnung lag das ganze Jahr 2012 über ununterbrochen über dem 33-jährigen Mittelwert.

Hitze- und Kältewellen der Vergangenheit: Vorsicht bei dem, was man sich wünscht

Vieles des gegenwärtigen Warm-Alarmismus’ konzentriert sich um einen Temperaturtrend, der in den achtziger Jahren begonnen hat, weniger als ein Jahrzehnt, nachdem unser Planet aus einer drei Jahrzehnte langen Abkühlungsphase gekommen war, die viele das Einsetzen einer neuen Eiszeit hat befürchten lassen. Wie sich der Klimatologe und Forbes-Mitarbeiter Patrick Michaels erinnert: „Als ich meine Schulausbildung abgeschlossen habe, war es allgemein verbreitet, dass die Eiszeit jetzt beginnen wird. Ich hatte auch Schwierigkeiten, mich dafür zu erwärmen“. Unter Hinweis auf den gegenwärtigen Alarmismus beobachtet er: „Diese Treibhaushysterie ist nicht die erste Klima-Apokalypse, aber mit Sicherheit die lauteste“.

Der weltbekannte Atmosphären-Wissenschaftler Reid Bryson, einst an vorderster Stelle der Warner vor einer neuen Eiszeit stehend, sagte: „Bevor es genug Menschen gab, um überhaupt einen Unterschied zu machen, vor zwei Millionen Jahren, hat niemand das Klima geändert, und doch hat es sich geändert, oder?“ Bryson sagte den Wisconsin Energy Cooperative News im Jahr 2007: „All dieser Streit darüber, ob die Temperatur steigt oder fällt, ist absurd. Natürlich steigt sie. Sie steigt seit den frühen achtziger Jahren vor der industriellen Revolution, weil wir aus der Kleinen Eiszeit gekommen sind, und nicht weil wir mehr Kohlendioxid in die Luft pumpen“. Er fuhr fort: „Man kann hinausgehen und auf den Boden spucken – das hat die gleiche Auswirkung wie die Verdoppelung des Kohlendioxids“.

Es könnte der Erwähnung wert sein, dass einige Schwergewichte von Sonnenphysikern in den USA wieder einmal vorhersagen, dass der Planet Erde sehr gut in eine verlängerte Periode der Abkühlung eintreten kann, und zwar wegen der langen Dauer geringer Sonnenflecken-Aktivität … potentiell eine weitere kleine Eiszeit. Diese Ankündigung kam von Wissenschaftlern am U.S. National Solar Observatory und dem U. S. Air Force Laboratory und basierte auf drei verschiedenen Analysen des jüngsten Verhaltens der Sonne.

Einer der führenden Solarwissenschaftler der Welt, Habibullo Abdussamatov, Leiter der Russian Academy of Sciences Pulkovo in St. Petersburg und Direktor der Russland-Abteilung der internationalen Weltraumstation, stimmt zu, dass der Planet Erde vor einer langen Kaltperiode stehen könnte. Er weist darauf hin, dass es während der letzten 1000 Jahre fünf mal zu intensiven Kaltphasen gekommen war. Jede einzelne stand in Zusammenhang mit einer Abnahme der Solarstrahlung, so wie wir sie auch jetzt wieder erleben (hier).

Dr. Abdussamatov glaubt: Eine globale Abkühlung (a global freeze) wird kommen, egal ob industrialisierte Länder einen Deckel auf ihre Treibhausgas-Emissionen setzen oder nicht. Die weit verbreitete Ansicht, dass menschliche Aktivitäten ein entscheidender Faktor bei der globalen Erwärmung sind, hat sich aus einer Verwechslung von Ursache und Wirkung ergeben“. Er sagt voraus, dass eine neue Kleine Eiszeit etwa in den Jahren 2013/2014 beginnen wird, die größte Abkühlung wird um das Jahr 2040 erreicht sein, und die Kaltphase (a deep freeze) wird das restliche Jahrhundert über anhalten.

Die letzte Kleine Eiszeit, die sich Mitte des 16. Jahrhunderts ereignet hatte, war allgemein nicht als eine gute Zeit angesehen worden. Diese Zeit, die etwa 150 Jahr gedauert hat, hat in Europa Millionen Todesopfer gefordert und endete nicht lange, nachdem Washingtons Truppen brutale Wintertemperaturen in Valley Forge im Jahre 1777 erdulden mussten und nach dem bitterkalten Rückzug Napoleons aus Russland im Jahr 1812.

Ob die Abkühlung nun weitergeht oder nicht, gibt es überhaupt einen Grund, um in Panik zu verfallen? Nein, und selbst wenn die globale Erwärmung aus welchen Gründen auch immer wieder einsetzt, was sie wahrscheinlich tun wird, jeweils immer wieder unterbrochen durch Abkühlungsphasen, dann wollen wir dankbar sein für die vielen Vorteile für die menschliche Gesundheit und das Wohlergehen, das die Wärme mit sich bringt. Lassen Sie uns feiern, wenn die vom CO2-Gehalt abhängige Landwirtschaft blüht, mit verlängerten Wachstumszeiten und mit abnehmenden Raten von Kältetoten.

Lassen Sie uns die Tatsache akzeptieren, dass sich das Klima aus vielen Gründen ändert. Ohne Erlaubnis oder Hilfe von uns … das hat es immer getan … das wird es immer tun … und nicht immer zum Schlechteren. Und lassen Sie uns skeptisch sein hinsichtlich der Ratschläge von Alarmisten, die offensichtlich von Angst erzeugenden Taktiken abhängen, um uns mit einer Flut von Rechnungen zu überziehen.

Larry Bell

Link: http://www.forbes.com/sites/larrybell/2013/04/30/global-warming-alarm-continued-cooling-may-jeopardize-climate-science-and-green-energy-funding/

Übersetzt von Chris Frey EIKE