Umweltbundesamt und IPCC heizen den „Klimakrieg“ kräftig an!

Den Vogel schoss dabei das Umweltbundesamt (UBA) in Berlin ab, einer Bundesoberbehörde, die dem Bundesumweltministerium untersteht. Sie warf eine Broschüre in den Markt, die allen Treibhauskritikern, gerne als „Klimawandelleugner“ diffamiert, ein-für-alle-mal den Mund stopfen sollte. Daher auch der trotzige Titel: „Und sie erwärmt sich doch“! Man will sich damit auf die Stufe von Galileo Galilei (1564-1642) stellen, der vor dem Inquisitions-Tribunal 1632 gesagt haben soll „Und sie bewegt sich doch“ (Eppur si muove). Man verkündet eine „Wahrheit“, deklariert sie für „sakrosankt“ und stellt alle „Nichtgläubigen“ an den Pranger. Dies machen nur Ideologen! Das Gehabe erinnert an die Totentanz-Malereien des 15. und 16. Jahrhunderts, wo der Tod befahl: „Ihr tanzt nach meiner Pfeife!“ Oder kam dem UBA diese Erleuchtung beim Anblick des Holzschnitts „Der Sternenseher“ von Hans Holbein der Jüngere (1497-1543) vom Jahre 1525?

Dabei schießt das UBA gleich mit der 1. Frage „Was ist eigentlich Klima?“ ein grandioses Eigentor. Es antwortet dem nicht selbständig denken sollenden Leser auf die selbst gestellte Frage: „Klima ist der mittlere Zustand der Atmosphäre an einem bestimmten Ort oder in einem bestimmten Gebiet über einen längeren Zeitraum“, den die Weltorganisation für Meteorologie (WMO) mit mindestens 30 Jahre angibt. Damit ist eigentlich alles gesagt. Da es keinen 30jährigen „mittleren Zustand der Atmosphäre“ an einem Ort gibt, gibt es auch kein „Klima“, keine „Klimakatastrophe“, keinen „Klimaschutz“. Das besagt die Definition! Und wenn man im UBA logisch und nicht ideologisch denken würde, dann folgt aus der Definition, dass man zuerst den Wetterschutz angehen müsse, wenn man einen Klimawert konstant halten will. Doch wie will der Mensch, die Menschheit das Wetter schützen? Und welches?

Natürlich kann die „Klimatologie“ aus den langjährig erhobenen meteorologischen Messdaten Mittelwerte errechnen und in „Klimakarten“ Linien gleichen mittleren Druckes (Isobaren) oder gleicher mittlerer Temperatur (Isothermen) einzeichnen, aber das so errechnete „Azorenhoch“ oder „Islandtief“ ist ein stationäres weil statistisches Konstrukt und hat im Gegensatz zum Wetter kein Eigenleben. Sie bewegen sich nicht, verändern sich nicht. Das Wetter dagegen ist ein höchst lebendiges „Wesen“, das völlig eigenständig agiert. Es erzeugt Wirbelstürme und Tornados wie jüngst in Oklahoma (USA), ohne „Rücksicht“ auf den Menschen. Das gibt auch das UBA zu: „Das Klima wird durch statistische Eigenschaften der Atmosphäre charakterisiert, wie Mittelwerte“. Aber auch das ist bei exakter Interpretation falsch, denn die Atmosphäre hat keine „statistischen Eigenschaften“. Es ist der Mensch, der die in der Atmosphäre gemessenen Einzeldaten statistisch bearbeitet und Mittelwerte berechnet. Aber von einer politisch finanzierten „Klimawissenschaft“ darf man solch eine Exaktheit nicht einfordern, oder doch?

Entsprechend des Gesetzes der Fehlerfortpflanzung geht vom UBA inszenierte Frage-Antwort-Spiel, das als Aufklärungsinitiative deklariert ist, durch die gesamte Broschüre. So etwas können sich nur staatliche Institutionen leisten, die Wissenschaftsfreiheit als staatlich dienliche Narrenfreiheit interpretieren und sich vor staatsanwaltlichen Ermittlungen sicher wähnen dürfen. Jedenfalls sollte mal der Bundesrechnungshof prüfen, warum für solch eine Erklärung wie „Klimaänderungen haben verschiedene Ursachen“ wie die „interne Klimavariabilität“ Geld rausgeschmissen wird. Jedenfalls, der Schnellschuss der UBA-Diffamierungs-Aktion zur Diskriminierung der „Klimaskeptiker“, die man als inkompetent bis blöd an den Pranger stellte, ging nach hinten los und verärgerte sogar das ZDF. Thorsten Koch, Professor für Öffentliches Recht an der Universität Osnabrück, kommentiert am 23. Mai 2013 in der WELT: „Staatspropaganda – Das Umweltbundesamt missachtet die Regeln der Neutralität!“

Klimaforscher James Hansen verlässt seinen Posten bei der NASA

Für James Hansen gilt die Aussage, dass keineswegs immer „Mehrheiten“, sondern „Männer“ Geschichte machen. Es war Hansen, seit 1981 Leiter des „Goddard Institute for Space Studies“ der NASA, der die NASA bei einer Anhörung vor dem US-Kongress in arge Verlegenheit brachte, als er eigenmächtig den heißen Sommer 1988 den Abgeordneten als „Beweis“ für die unaufhaltsame „globale Erwärmung“ präsentierte. Hansen hatte seine Anhörung bewusst auf Ende Juli legen lassen in der Hoffnung auf schweißtreibende Temperaturen. Das Pokerspiel ging auf. Amerika ächzte gerade unter einer Hitzewelle, so dass die Aussage von Hansen ein riesiges Medienecho hervorrief und viele Politiker umstimmte, die ihre Meinung an der Medienmeinung ausrichten.

Nun ist James Hansen im Alter von 72 Jahren in den Ruhestand gegangen, um sich ganz dem Kampf gegen die Emissionen von Treibhausgasen zu widmen. Noch im Dienst hatte er 2008 gar einen „Runaway Greenhouse Effect“ propagiert, einen sich verselbständigenden Treibhauseffekt mit gigantischer Erwärmung wie auf der Venus (Venus-Syndrom). Die Venustemperaturen von über 400° C liegen einzig und allein an der Tatsache, dass die Venus in 100 Millionen km Entfernung die Sonne umkreist und nicht wie die Erde in 150 Millionen km. Jeder kennt das R2-Gesetz, das besagt, dass die Strahlungsintensität pro Flächeneinheit mit dem Quadrat der Entfernung zu- oder abnimmt. Was macht Hansen nun im Ruhestand? Er bekennt: „Die essentielle Voraussetzung, um die Klimakatastrophe abzuwenden, ist CO2 freie Elektrizität. Zur Zeit gibt es zwei grundsätzliche Alternativen für die Grundversorgung mit Elektrizität: Fossile Brennstoffe und Kernkraftwerke. Jeder Erfolg der Anti-Atom-Bewegung, das heißt die Abschaltung eines AKW, gefährdet die Zukunft unserer Kinder.“

Wie man James Hansen auch bewertet, er ist nicht „alternativlos“! Mit seiner Pro-Kernkraft-Haltung wird er nur wenige „Freunde“ in der deutschen politischen Szene haben, am wenigsten beim Bündnis90/Die Grünen. Der Mohr hat seine Schuldigkeit getan. Seinem Abgang wird keine Träne nachgeweint werden. Er hat sich unheilbar wie bei einer eingebildeten Krankheit in die Wahnsinnsidee einer treibhausbedingten globalen „Klimakatastrophe“ verrannt, aber er bleibt sich wenigstens selbst treu.

DWD – Globaltemperatur wird trotz gegenwärtiger Stagnation langfristig steigen

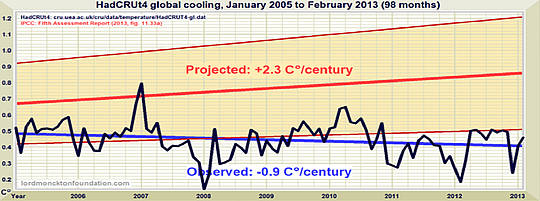

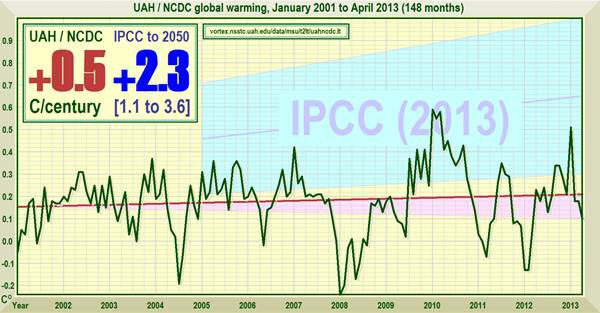

Hatte James Hansen die Latte bei einem Wert von 350 ppm CO2 angelegt, bei dem unweigerlich die „Klimakatastrophe“ über die Welt hereinbricht, so hob der UNO-Weltklimarat diesen Wert auf 450 ppm an, nachdem am 9. Mai 2013 der „historische Rekordwert“ von 400 ppm überschritten war, aber die „Erderwärmung“ schon seit 1998 Richtung Abkühlung tendiert. In den Medien erregte die Diskrepanz zwischen dem steigenden CO2-Wert und der abnehmenden globalen Erwärmung Aufmerksamkeit. Die Baseler Zeitung vom 18. Mai 2013 sprach von einer „Klimapause“. Keiner fragte nach der „Wetterpause“, doch plötzlich befanden sich die Klimaexperten mitsamt ihren Klimamodellen in der Defensive.

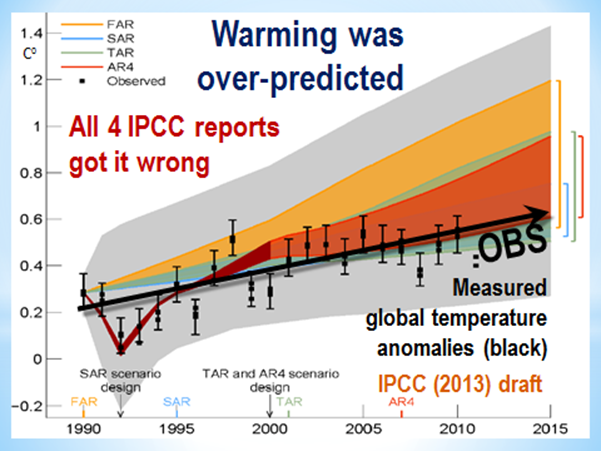

Dem Eindruck, dass keine Kausalbeziehung zwischen dem CO2-Wert und dem Globaltemperatur bestehe, musste massiv propagandistisch entgegengewirkt werden. So überschrieb die Mainzer Allgemeine Zeitung am 21. Mai 2013 eine dpa-Meldung mit „Studie: Erde erwärmt sich langsamer. Internationale Wissenschaftler erwarten dennoch katastrophale Folgen“. Ausgelöst wurde die Debatte von einem Forscher-Team um Alexander Otto an der Universität Oxford, um den lästigen Abkühlungsparolen Paroli zu bieten. Nach dem Klimaforscher Reto Knutti von der ETH Zürich lägen vorübergehend sinkende Temperaturen in der Natur der Sache: „Es gab im 20. Jahrhundert immer wieder Perioden der Stagnation.“ Doch was als Rechtfertigung gedacht war, provozierte noch intensiver die Frage nach der Qualität der Klimamodelle. Deren Fehlerhaftigkeit schob man flugs auf das „Schwächeln der Sonne“, obgleich deren Einfluss kategorisch verneint worden war.

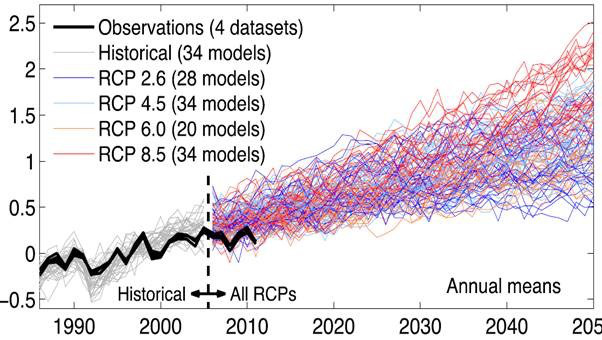

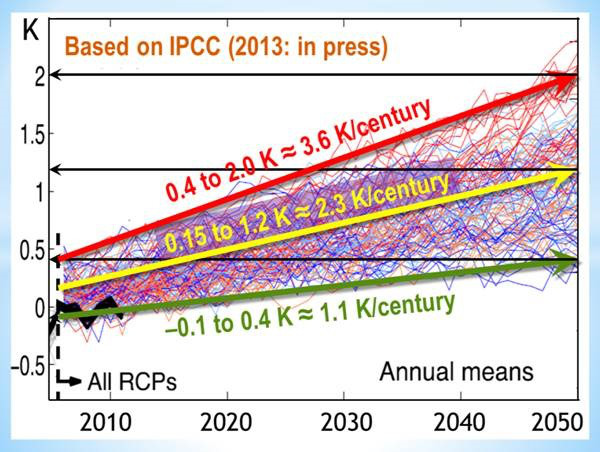

Die Klimamodelle selbst sind der eigentliche Schwachpunkt. Sie werden immer wieder vor aller Öffentlichkeit als extrem komplex hingestellt, in Wirklichkeit sind sie von beispielloser Primitivität. Sie bauen einzig auf der Annahme einer Monokausalität auf zwischen CO2-Gehalt und Temperatur. Man inszeniert drehbuchartig Szenarien-Spiele und verkauft die Ergebnisse immer wieder bewusst verfälschend als „Klimaprognosen“. Der Trick ist, dass man der „Treibhausgasen“ eine fiktive „Strahlungskraft“ (radiative forcing) andichtet. Erhöht man die deren Konzentration, erhöht sich automatisch die Temperatur, dank der Annahme einer fiktiven „Gegenstrahlung“. Dies wird sogar offen bekannt in der Annahme, dass die Medien den Satz, „Grundlage für ihre Berechnungen ist der Kohlendioxidgehalt in der Atmosphäre“ nicht verstehen und damit hinterfragen. Im Klartext heißt das: Nichts anderes als das CO2 geht in die Berechnungen ein! Es ist also ein numerischer Automatismus, der in die Modelle einprogrammiert hat. Damit kann man nach Gutdünken je nach politischer Großwetterlage die Erderwärmung beschleunigen oder verlangsamen. Im Moment scheint die Verlangsamung opportun! Auch der Direktor des Max-Planck-Institut für Meteorologie in Hamburg, Jochen Marotzke blies in das Horn und wiegelte ab: „Es sei wichtig, Veränderungen innerhalb eines Jahrzehnts nicht über zu bewerten.“ Dann hätte dies auch für das Jahrzehnt 1988-1998 gelten müssen, als die Wärmerekorde nur so purzelten. Man biegt sich jede „Wahrheit“ so zurecht, wie man sie gerade benötigt!

Bei dieser Lage musste sich auch der Deutsche Wetterdienst (DWD), der sich bei seiner ureigensten Aufgabe, der kurzfristigen Wettervorhersage, sehr schwer tut, auch zu Wort melden, um nicht ganz dem UBA die öffentliche Bühne zu überlassen. Er lud zur „Klima-Pressekonferenz 2013“ nach Berlin ein. Vizepräsident Paul Becker gab zu, dass die „Erdmitteltemperatur“ seit 15 Jahren stagniere, um ablenkend hinzuzufügen, dass man dennoch „die Geschichte des Klimawandels nicht neu schreiben müsse“. Das Klima unterliege „vielen Einflüssen“ und diese „maskieren gewissermaßen den vom Menschen verursachten Klimawandel – an dem kein Zweifel besteht.“ Aber die Klimamodelle rechnen eben nicht mit vielen Einflüssen, sondern wie zugegeben allein nur mit dem CO2-Einfluss!

Doch der DWD, der „Wetter und Klima aus einer Hand“ anbietet, ist um Distanz zum UBA wie Originalität bemüht und geht in seiner Presseerklärung einen Schritt weiter. Er fordert, „es müsste auch der künftige gesellschaftliche Wandel berücksichtigt werden. So führe zum Beispiel das Zusammenspiel von Klimawandel und demographischer Entwicklung zur Verschärfung der Hitzeproblematik. … Der DWD hat deshalb sein Hitzewarnsystem um die Vorhersage der nächtlichen Innenraumtemperaturen erweitert.“ Das ist schon Satire von der feinsten Art! Soll das Temperament der alternden Bevölkerung so herunter gekühlt und das Raum- wie Bettklima so reguliert werden, um im Zusammenspiel zwischen Mensch und Klima eine harmonische, aber nicht reproduktive, die demographische Entwicklung nicht störende Symbiose herzustellen? Will der DWD dem Klimaservice der Autowerkstätten oder der Heizungs- und Klimatechnik Konkurrenz machen oder zuarbeiten? Es ist schon grandios, was sich bei der Behörde DWD abspielt. Dabei erwartet der Bürger vom Wetterdienst nichts anderes als bessere und zuverlässigere Vorhersagen des Wetters.

Globale Erwärmung und die angebliche „Klimapause“

Die schon erwähnte Studie der Universität Oxford spaltete das öffentliche Meinungsklima. Titelte die FAZ am 21. Mai 2013 „Forscher zweifeln an Klimawandel“, so schrieb am gleichen Tag Spiegel Online „Studie entschärft extremste Klimaszenarien“. Was war geschehen? Man hat die gängigen Computermodelle „überprüft“ und mit modifizierten Modellen neue Berechnungen angestellt. Die ergaben, dass bei einer „Verdopplung der CO2-Konzentration“ der Temperaturanstieg nicht mehr 2,2 bis 4,7 Grad betrage, sondern nur noch 1,2 bis 3,9 Grad. Die Universität argumentierte: „Die Reaktionen des Klimasystems auf steigende Treibhausgas-Konzentrationen stimmen mit den herkömmlichen Schätzungen der langfristigen Klimaempfindlichkeit überein.“ Weiter hieß es: „Otto und seine Kollegen haben lediglich festgestellt, dass die extremsten der bisherigen Temperaturszenarien mit geringerer Wahrscheinlichkeit eintreffen. Die wirklich wichtigen Vorhersagen aber – jene, welche die Temperaturen der kommenden 50 bis 100 Jahre betreffen – liegen im Bereich der aktuellen Klimamodelle.“

Alles nur ein Sturm im Wasserglas? Wann merken die Journalisten und mit ihr die Öffentlichkeit, dass hier „viel Lärm um nichts“ erzeugt und ein geschicktes Täuschungsmanöver veranstaltet wurde? Man hat keine besseren Klimamodelle und will an den alten Simulationen festhalten, um an der Erwärmungsspirale nach Belieben weiterdrehen zu können. doch je nach Situation werden diese als „Szenarien“ oder als „Vorhersagen“ verkauft, wobei die „wirklich wichtigen Vorhersagen“ die „kommenden 50 bis 100 Jahre betreffen“. Das ist genauso wie wenn ein Meteorologe sagen würde: bei der 3-Tage-Wettervorhersage bin ich mir nicht sicher, aber bei der wichtigeren 300-Tage-Vorhersage bin ich mir sicher.

So argumentiert auch der ETH-Zürich-Wissenschaftler Reto Knutti aus dem Oxford-Team. Zur gegenwärtigen „Klimapause“ meint er abwiegelnd: „Eine Beurteilung von Trends über weniger als 20 Jahre sei heikel.“ Heikel war damit auch der Projektionstrend der „Wärmerekorde der 80er Jahre“. Die kurzfristigen Schwankungen des Wetters seien „für den langfristigen Klimawandel global vernachlässigbar, aber lokal beträchtlich“. Natürlich, ein „lokaler“ Tornado ist „global“ vernachlässigbar, aber jeder „Klimawert“ beruht auf örtlichen Messungen, wie die Definition der WMO eindeutig sagt! Dann erläutert er den schillernden Begriff der „Klimasensitivität“, der „Klimafühligkeit“ bedeutet. Doch wie will man eine Mitteltemperatur fühlen, eine Mittelwind spüren? Klima kann man nicht fühlen, wohl aber Wetter, daher gibt es auch eine Wetterfühligkeit, die von Mensch zu Mensch unterschiedlich ausgeprägt ist. Manche leiden unter Föhn, andere nicht. Der hochtrabende und nebulöse Begriff „Klimasensitivität“ umschreibt die Reaktion eines Klimamodells auf die von den Klima-Programmierern eingegebenen CO2-Werte. Reto Knutti: Mit „Sensitivität“ ist „definitionsgemäß die durchschnittliche globale Erwärmung“ gemeint, „mit der das Klimasystem auf eine Verdopplung der CO2-Konzentration in der Atmosphäre reagiert. Als Ausgangspunkt nehmen die Forscher die Verhältnisse der vorindustriellen Zeit vor rund 200 Jahren, als der CO2-Gehalt 280 ppm betrug.“

Die Ausgangsbasis der „früheren Modelle“ lag also bei 560 ppm CO2. Diese habe man nun, die Emissionen eilen weltweit von Rekord zu Rekord, angepasst. Reto Knutti: „Für die zukünftigen möglichen Trends“ ging man „von Emissions-Szenarien aus, die zu Treibhausgas-Konzentrationen zwischen knapp 500 und gut 1400 ppm führen.“ Dennoch soll der Temperaturanstieg geringer sein? Dieses Bekenntnis besagt im Klartext: Der Manipulationsspielraum bei der Festlegung der „Strahlungskraft“ der „Treibhausgase“ wie der Programmierung von Klimamodellen ist gigantisch. Welch Außenstehender kann da noch hinter die Kulissen schauen?

Verfolgt man seit 30 Jahren die Unzahl an Klimaszenarien, so verdichtet sich die Meinung, dass die modernen multimedialen Computertechniken von den Klimaexperten dazu benutzt werden, um mit politisch erwünschten Weltuntergangszenarien ein „Klima der Angst“ zu erzeugen, das für wirtschaftliche, soziale wie parteipolitische Veränderungen dienlich erscheint. Illusionen werden in Simulationen verwandelt und ständig neue Welten produziert. Wie in der Filmindustrie wird die Realität zur Virtualität umgeformt und die potentielle Virtualität zur künftigen Realität erklärt. Der einzelne Mensch befindet sich in einer schier hoffnungslosen Lage: Soll er den Verheißungen einer „schönen neuen Klimawelt“ entsagen? Kann er das überhaupt bei dem Druck des „Zeitgeistes“?

Hat der Bürger noch eine freie Wahl? Ja er hat die Pflicht dazu, solange der „Fußabdruck“ noch nicht gesetzlich vorgeschrieben ist. Es bedarf nur des Mutes, sich nach Immanuel Kant seines eigenen Verstandes zu bedienen.

Für den Fall, dass es noch einen „heißen Sommer“ geben sollte, die Schuhindustrie hat vorgesorgt und bietet „Klimaanlagen“ für die Füße an: „Klimaporen-Slipper“ für ein garantiert frisches Fuß-Klima! Die Chancen stehen „gut“, denn laut Meldung des Deutschen Wetterdienstes vom 24. Mai 2013 liege aktuell der Temperatur-Mittelwert für den Mai in Hessen bei 8,3 Grad. Statistisch gesehen sei es nicht zu kalt oder nass in Hessen. Das ist nur ein winziges Minus von 5,4 Grad gegenüber dem Mai-Mittel von 13,7°C in Frankfurt. Und im Vergleich zu Darmstadt, Fulda, Giesen, Marburg, Kassel, Wiesbaden? Hoch lebe die Statistik!

Oppenheim, im Mai 2013 ; Dipl.-Met. Dr. phil. Wolfgang Thüne