Kernenergie: 100 Gründe und 100 gute Antworten. Fortsetzung #28 bis #31

Nun müssen Fernsehsendungen nicht zwangsläufig falsche Zahlen verbreiten, aber in einer Doktorarbeit darf man schon etwas mehr Gründlichkeit erwarten, zumal Hohmeyers gesamte weitere Rechnung zur "Bösartigkeit" der Kernenergie auf dieser Zahl aufbaut. Hier lediglich eine Fernsehsendung zu zitieren hätte seinem Betreuer Rudolf Hickel eigentlich auffallen müssen, aber es lag wohl nicht in seinem Interesse, hier ehrlich zu sein. Auch können 1 Jahr nach dem Vorfall kaum zuverlässige Schätzungen vorgelegen haben. Hinzu kommt, dass diese hypothetische Dosis ja nicht wie bei Hiroshima und Nagasaki in Sekundenbruchteilen, sondern über lange Zeiträume verabreicht worden wäre (s.a. hier).

Jedenfalls wurde diese Zahl nun zur Grundlage für Risikoabschätzungen, Versicherungssummen und "versteckten" Strompreisen. Durch die von der Universität Bremen abgesegnete Doktorarbeit wurde diese freie Erfindung des Fernsehjournalisten Gerhard Bott zur Wissenschaft, und Hohmeyers Arbeit wurde oft zitiert. Die Zahl wanderte in Studien und Bücher, wobei ihr wissenschaftlicher "Wert" dadurch weiter gesteigert wurde, und immer konnte man sich auf die Universität Bremen berufen, statt auf einen Fernsehjournalisten. Der Höhepunkt war offensichtlich eine Studie der Prognos AG im Auftrag des Bundeswirtschaftsministeriums von 1992, die auf der Doktorarbeit aufbaute. Seitdem gilt es in Antiatomkreisen als gesichertes Wissen.

In den "100 guten Gründen" wird diese Studie allein 6 mal zitiert, in weiteren Gründen verwendete Behauptungen leiten sich daraus ab. In den deutschen Bibliotheken wird sie allerdings nicht geführt. Die Datenbanken der Prognos AG reichen bis 1992 zurück, sie müsste also wenigstens dort auffindbar sein, ist sie aber nicht. Offensichtlich war es der Prognos AG zu peinlich, diesen Unsinn weiter verbreiten. Im WWW kursiert eine Kopie, die Echtheit kann allerdings nicht überprüft werden. Glaubt man dem Inhalt, stammen die Zahlen von Hohmeyer, und damit ausschließlich aus der erwähnten Fernsehsendung. Einmal mehr bleibt nur, den Sladeks zu gratulieren, die Methode des wissenschaftlichen "Reinwaschens" verbreitet und damit gefördert zu haben. Lügen zahlt sich eben aus, aber man muss es auch gut machen.

Natürlich sind weitere Übertreibungen davon unbenommen. Aufbauend auf der unauffindbaren Studie der Prognos AG ergibt sich gleich eine Vielzahl an Möglichkeiten, die in den folgenden Gründen ausgeschöpft wird. Da wären die übliche Verwechslung eines Schadensfalls mit einem "Super-GAU", was es erlaubt, die Wahrscheinlichkeiten mal eben mit 100 zu multiplizieren (#29) und aufbauend auf den nochmals weiter hochgerechneten Hohmeyerzahlen exorbitante Versicherungssummen (#28), noch gewürzt mit der dreisten Lüge, die Haftung sei grundsätzlich gedeckelt. Aber es gibt auch wieder einen Favoriten, nämlich Grund #30, in welchem den deutschen Kernkraftwerken unterstellt wird, Wasserstoffexplosionen seien im internationalen Vergleich "besonders wahrscheinlich". Sehr originell. Und natürlich genügt ein Unwetter (#31), und wir müssen schon wieder betroffen zusehen, wie Ursula und Michael Sladeks Teil eines Weltuntergangs werden. Es will einfach nicht aufhören.

Nun zu den Antworten #28 bis #31, die bisherigen Antworten finden Sie in den EIKE-News (Energie) vom 29.3.2013, 3.4.2013, 7.4.2013, 10.4.2013, 16.4.2013, 19.4.2013 und 26.4.2013.

#28: Versicherungsschutz

Behauptung: 50 Autos sind zusammen besser versichert als ein Atomkraftwerk.

Die EWS behaupten

Ein Super-GAU in einem Atomkraftwerk in Deutschland verursacht Gesundheits-, Sach- und Vermögensschäden in Höhe von 2.500 bis 5.500 Milliarden Euro. Das hat die Prognos AG 1992 in einem Gutachten für das FDP-geführte Bundeswirtschaftsministerium errechnet.

Die Haftpflichtversicherung aller Atomkraftwerksbetreiber zusammen deckt ganze 2,5 Milliarden Euro ab – also 0,1 Prozent des zu erwartenden Schadens. 50 Autos auf dem Parkplatz eines Atomkraftwerks sind zusammengenommen besser versichert als das Atomkraftwerk selbst!

„Weiterführende Informationen” der EWS und „Quellen” der EWS

Richtig ist …

Die Behauptung ist falsch, denn die Haftung ist grundsätzlich unbeschränkt und erstreckt sich sogar auf das Ausland (§31 und §25 AtG). Eine vergleichbare Haftung ist für Autos undenkbar. Nur in Fällen höherer Gewalt, Unruhen, Kriegen u.ä. ist die Haftung auf 2,5 Mrd. Euro beschränkt (§25 Absatz 3). Und dies auch nicht für „alle Atomkraftwerksbetreiber zusammen” sondern für jede Anlage einzeln.

Es ist weiterhin falsch, dass die Prognos AG selbst ein „Gutachten” erstellt hat. Dort werden lediglich Behauptungen aus der 1988 angefertigten Doktorarbeit des Volkswirten Olav Hohmeyer kopiert. Das „Gutachten” ist im Zentralregister der deutschen Bibliotheken nicht verzeichnet und im Archiv der Prognos AG nicht auffindbar. Hohmeyers Doktorarbeit hingegen schon, aber dort muss man mit Schrecken feststellen, dass dieser seine Basisdaten aus einer 1987 ausgestrahlten Fernsehsendung des NDR bezogen hat. Daten aus Fernsehsendungen sind in Ingenieurs- und Naturwissenschaften alles andere als wissenschaftlicher Standard.

Quellen von KRITIKALITÄT

#29: Super-GAU

Behauptung: Der Super-GAU kann jeden Tag passieren.

Die EWS behaupten

Die ›Deutsche Risikostudie Kernkraftwerke Phase B‹ von 1989 beziffert das Risiko eines Super-GAUs aufgrund technischen Versagens in einem westdeutschen Atomkraftwerk mit 0,003 Prozent pro Jahr. Das klingt wenig. Aber allein in der EU gibt es (Stand Ende 2007) 146 Atomkraftwerke. Bei einer Betriebszeit von 40 Jahren käme es hier demnach mit einer Wahrscheinlichkeit von über 16 Prozent zu einem Super-GAU. Viele mögliche Störfallszenarien und gefährliche Altersmängel in den Reaktoren sind dabei gar nicht berücksichtigt – genauso wenig wie alle Unfälle, die, wie Harrisburg und Tschernobyl, unter anderem durch menschliches Versagen passieren.

„Weiterführende Informationen” der EWS und „Quellen” der EWS

Richtig ist …

Die angeführte Studie schätzt das Eintreten sogenannter Schadensfälle ab, der Begriff „Super-GAU” ist eine Erfindung der Antiatombewegung. Ein Schadensfall muss noch lange nicht zu einer Kernschmelze führen, eine Kernschmelze noch lange nicht zur Freisetzung größerer Mengen Radioaktivität, und freigesetzte Radioaktivität noch lange nicht zu gesundheitlichen Folgen. Die absolute Wahrscheinlichkeit, soviel Radioaktivität wie in Fukushima oder mehr freizusetzen, ist nach der ›Deutschen Risikostudie Kernkraftwerke Phase B‹ nochmal etwa um einen Faktor 100 geringer.

Der Vergleich der Unfälle Tschernobyl und Harrisburg wäre etwa so, als vergleiche man für die Insassensicherheit den Aufprallschutz eines Trabants mit einem Panzer. In Harrisburg kam es zur Kernschmelze, die Störungen wurden erst Stunden später bemerkt, der Aufwand der Gegenmaßnahmen hielt sich in Grenzen. Trotzdem kam kein Mensch zu Schaden, bereits nach 2 Wochen zog dort wieder der Alltag ein. In Fukushima schmolzen gleich 3 Kerne infolge eines sehr schweren Naturereignisses, das 20 000 Tote forderte, wobei bereits damals bekannt war, dass die Notstromdiesel gegen Hochwasser schlecht gesichert und keine Filter vorhanden waren. Es werden auch hier keine Strahlenopfer zu beklagen sein.

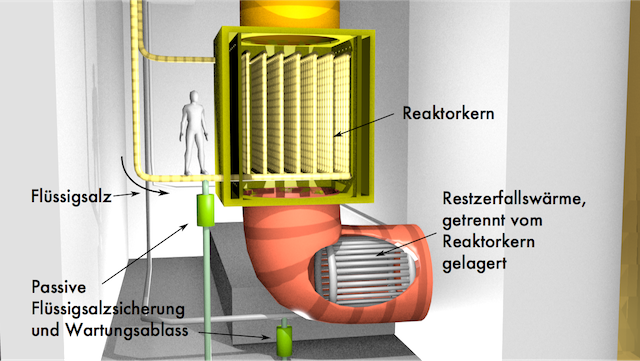

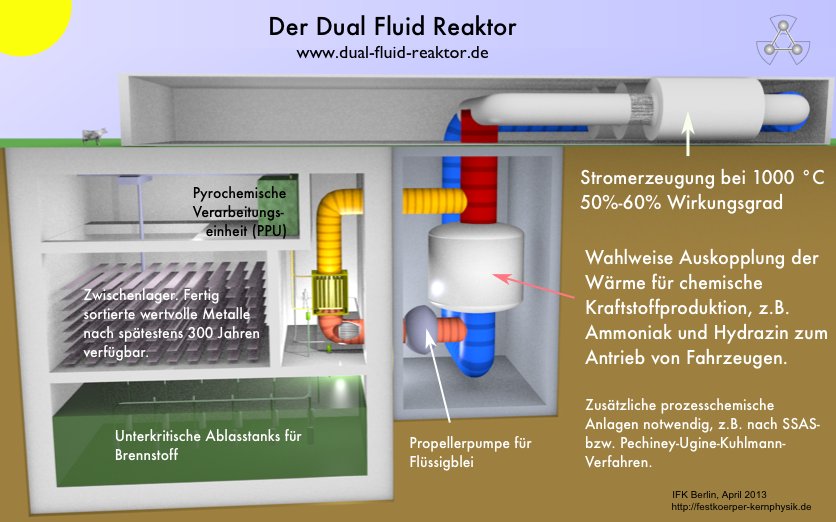

Dies zeigt, dass bereits die wassermoderierten Reaktoren extrem verzeihend auf Planungs- und Bedienfehler reagieren, die passiven Barrieren wirkten, wie vorgesehen. Die deutschen Reaktoren sind passiv mindestens so gut ausgerüstet wie Harrisburg. Es sind zukünftige Reaktoren baubar, bei denen eine Kernschmelze bzw. das Austreten nennenswerter Mengen von Radioaktivität bei intakten Strukturen nicht möglich ist.

Quellen von KRITIKALITÄT

#30: Sicherheitsranking

Behauptung: Deutsche Atomkraftwerke sind sogar im internationalen Vergleich unsicher.

Die EWS behaupten

Deutsche Atomkraftwerke gehören »zu den sichersten der Welt«? Von wegen! Bei einem internationalen Sicherheitsvergleich der OECD im Jahr 1997 schnitt das bundesdeutsche Referenz-Atomkraftwerk (Biblis B) hinsichtlich der Kernschmelz-Festigkeit am schlechtesten ab. Wasserstoffexplosionen seien besonders wahrscheinlich, der Sicherheitsbehälter aus Stahl besonders instabil, urteilten die Gutachter: In Biblis sei »die Gefahr extrem hoch, dass es bei einer Kernschmelze zu massiven Freisetzungen von Radioaktivität kommt«.

„Weiterführende Informationen” der EWS und „Quellen” der EWS

Richtig ist …

Es empfiehlt sich, die OECD-Studie auch zu lesen. Dort steht nämlich, dass es beim Kernkraftwerk Biblis B statistisch seltener als alle 100 Millionen Jahre zur Freisetzung von Radioaktivität kommt. Es ist damit das mit Abstand sicherste unter allen untersuchten 19 Kernkraftwerken. Aus Angst vor Radioaktivität wurde es nun endgültig abgeschaltet. Sehr konsequent.

Auch dass Wasserstoffexplosionen in Biblis B besonders wahrscheinlich sind wurde der OECD-Studie falsch entnommen. Dort wird vielmehr darauf hingewiesen, dass Biblis B als eines unter wenigen Kernkraftwerken passive Wasserstoff-Rekombinatoren und Frühzünder einsetzt. Das schließt gefährliche Wasserstoffexplosionen praktisch aus. Somit ist auch der Sicherheitsbehälter nicht „instabil”, sondern lediglich für etwas geringere Drücke ausgelegt – denn große Wasserstoffexplosionen können nun nicht mehr auftreten. Außerdem befindet sich im Betrieb überhaupt kein Sauerstoff im Sicherheitsbehälter, der für Wasserstoffexplosionen nötig wäre.

Das Zitat, in Biblis B sei »die Gefahr extrem hoch, dass es bei einer Kernschmelze zu massiven Freisetzungen von Radioaktivität kommt« stammt auch nicht von den OECD-Gutachtern, sondern von selbsternannten „Fachleuten” des IPPNW. Denen kann man, wie gesagt, nur empfehlen: Erst lesen, dann darüber schreiben.

Quellen von KRITIKALITÄT

#31: Unwetter

Behauptung: Schon ein Gewitter kann das Aus bedeuten.

Die EWS behaupten

Ein Stromausfall im Atomkraftwerk, der sogenannte Notstromfall, gehört zu den gefährlichsten Situationen in einem Reaktor. Ohne intakte Notstromversorgung fällt dann die Kühlung aus, es droht die Kernschmelze. Als Auslöser genügt oft schon ein simples Unwetter. Achtmal zwischen 1977 und 2004 führten Blitz oder Sturm in einem westdeutschen Atomkraftwerk zum Ausfall wichtiger Instrumente, zum gefürchteten Notstromfall oder gar, wie am 13. Januar 1977 im Atomkraftwerk Gundremmingen A, zum Totalschaden. Gefahren drohen auch durch Überschwemmungen: Im französischen Atomkraftwerk Blayais an der Atlantikküste fallen deswegen regelmäßig Teile der Kühlsysteme aus.

„Weiterführende Informationen” der EWS und „Quellen” der EWS

Richtig ist …

Auslöser des Unglücks in Gundremmingen A 1977 war kein Unwetter am Reaktor, sondern ein Ausfall der externen Hochspannungsleitungen, wodurch der Strom nicht mehr abtransportiert werden konnte und eine Drosselung der Leistung notwendig wurde. Hier kam es zu Fehlschaltungen, die in einer kontrollierten Flutung des Reaktorgebäudes mit Primärkühlwasser endeten. Zu der Schadensbeseitigung, die überschaubar gewesen wäre (das Wasser wurde abgepumpt, Dekontamination wäre denkbar gewesen), kamen durch Behördenauflagen noch weitere 180 Millionen DM an Kosten dazu. Da zwei weitere Reaktorblöcke bereits im Bau waren, hat man Block A stillgelegt.

Diesen 35 Jahre zurückliegenden Vorfall am ersten deutschen Leistungsreaktor als repräsentativ darzustellen ist so, als zöge man wegen Haarrissen an einer De Havilland Comet die Sicherheit moderner Linienmaschinen in Zweifel. In allen Fällen zeigt sich die Wirkung redundanter Sicherheitssysteme. So in Blaylais, wo trotz hochwassergefluteten Kühlsystems und gewittergeschädigter Hochspannungsleitungen die Schnellabschaltung samt Notkühlung funktionierten – wie bei der Auslegung geplant.

Wer jeden Instrumentenausfall als „kurz vor dem Super-GAU” darstellt weiss es offenbar besser als internationale Fachgremien, Einrichtungen zur Reaktorsicherheitsforschung mit jahrzehntelanger Erfahrung und weltweit vernetzte Atomaufsichtsbehörden. Die ordnen fast allen derartigen Vorfällen nämlich nur geringe oder keine Relevanz zu.

Quellen von KRITIKALITÄT

herunterladen

herunterladen