Schildbürger nicht ärgern: Für Licht und Strom gibt es keine Eimer!

Bild 1 unten: Hübsch, aber vergänglich: Die Akkus in Solarleuchten fallen oft schon nach 1-2 Jahren komplett aus

Zunächst einmal: Ja, rein vom Prinzip her kann man Licht und Strom durchaus speichern. Jeder kennt beispielsweise diese matt leuchtenden Kunststoffe, die Tageslicht aufnehmen und bei Stromausfall als Notmarkierung für Fluchtwege dienen. Auch so manches Kinderherz haben sie schon erfreut, wenn sie in Form von Spielzeug die Dunkelheit in Kinderzimmern mildern. Doch kein vernünftiger Mensch käme auch nur im Entferntesten auf die Idee, so etwas als Beleuchtung für unsere Wohnzimmer und Fabriken oder als Ersatz für Straβenlaternen einsetzen zu wollen.Ähnlich verhält es sich beim Strom. Wollte man für den Stromverbrauch eines durchschnittlichen deutschen Haushalts beispielsweise handelsübliche Mignonzellen verwenden, so würde man bei Kosten von mehr als 1 Mio. € landen – eine völlig indiskutable Idee also. Auch Akkumulatoren sind bei weitem nicht leistungsstark oder langlebig genug, um auch nur näherungsweise einen solchen Job zu erledigen. Jeder, der beispielsweise die heute so beliebten Solar-Gartenleuchten verwendet, stellt schnell fest, dass die Akkus schon nach 1-2 Jahren den Geist aufgeben. Selbst mit professionellen heute angebotenen Batteriesystemen [RWE] liegen die Speicherkosten – man muss nur selbst ein wenig nachrechnen – deutlich über 50 ct pro kWh, bei Investitionskosten oberhalb von 3000,- €/ kW. Der Versuch, gröβere Mengen Strom beispielsweise mit Batterien speichern zu wollen ist, macht sowohl wirtschaftlich als auch technisch keinen Sinn. Ebensowenig mit irgendeiner der anderen verfügbaren Speichertechnologien. Und genau darin liegt das Grundproblem der gesamten Energiewende.

Worauf es beim Strom ankommt

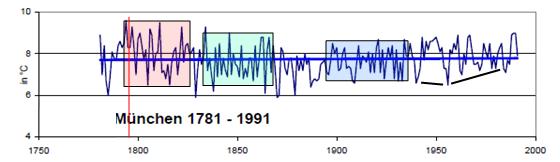

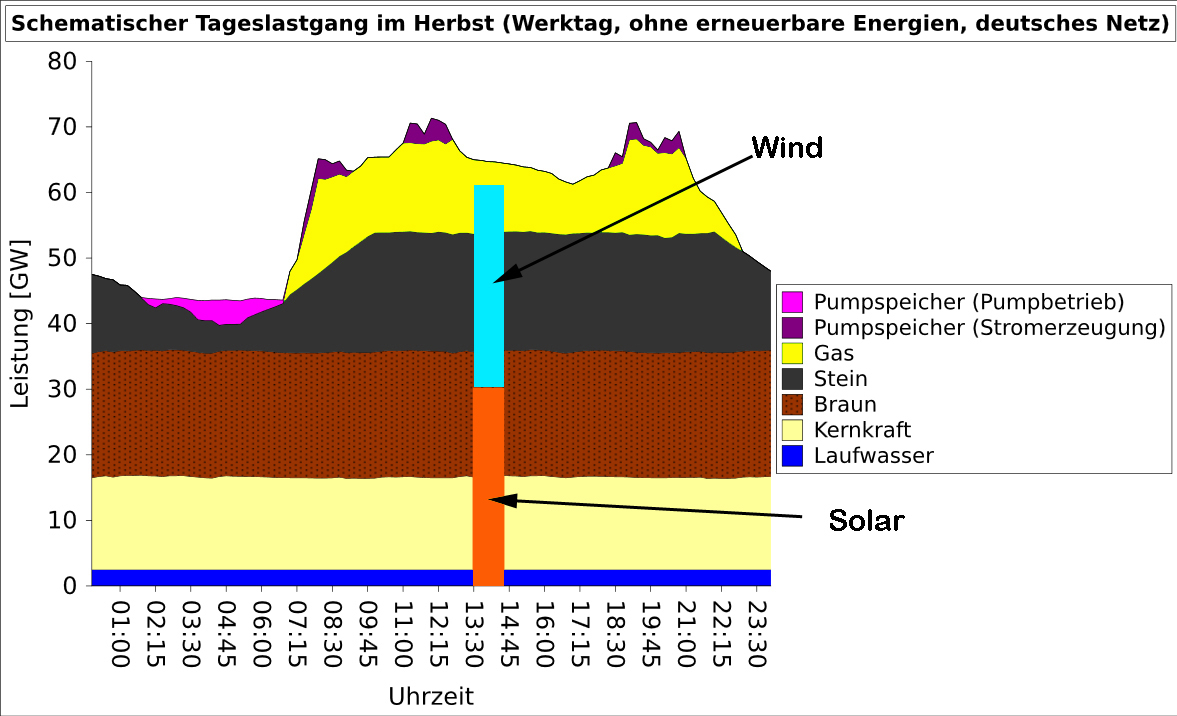

Bild 2. Schema des Tagesgangs der Strom-Tageslast im deutschen Netz an einem Herbst-Werktag (ohne „erneuerbare Energien“). (Grafik: Wikimedia Creative Commons)

Unser technisch hoch komplexes Stromnetz bleibt nur stabil, wenn Produktion und Verbrauch ständig exakt im Gleichgewicht sind. Das deutsche Stromnetz gehört vor allem deshalb zu den Besten der Welt, weil wir nicht nur hervorragende Ingenieure haben, sondern diesen auch ausgefeilte Technik zur Verfügung steht, um für eine ständige Anpassung beider Faktoren zu sorgen. Das entscheidende ist dabei, dass der Verbrauch stets Vorrang hat, d.h. dass die Produktion sich dem Verbrauch anpassen muss. Ein anderes System, bei dem die Dusche abgeschaltet, die Produktion mal kurz unterbrochen oder der Herd der Hausfrau für eine Stunde vom Netz genommen wird, weil die Stromerzeugung gerade nicht nachkommt, würde uns auf den Status einer Bananenrepublik zurückwerfen. Um die Produktion dem Verbrauch anzupassen, arbeiten die Elektrizitätsgesellschaften zunächst mit ausgetüftelten Prognosen, mit deren Hilfe der Tagesgang der Netzlast vorausgeplant wird. Dieser schwankt in Deutschland zwischen etwa 40.000 MW in den Nachtstunden und 75.000-85.000 MW an kalten Wochentagen, wenn Fabriken und Heizungen auf Hochtouren laufen [WIKI1]. Für die ständige Feinanpassung sorgt ein komplexes Netzwerk aus unterschiedlichsten Kraftwerken, die je nach Typ für Grundlast, Mittellast und Spitzenlast zum Einsatz kommen.

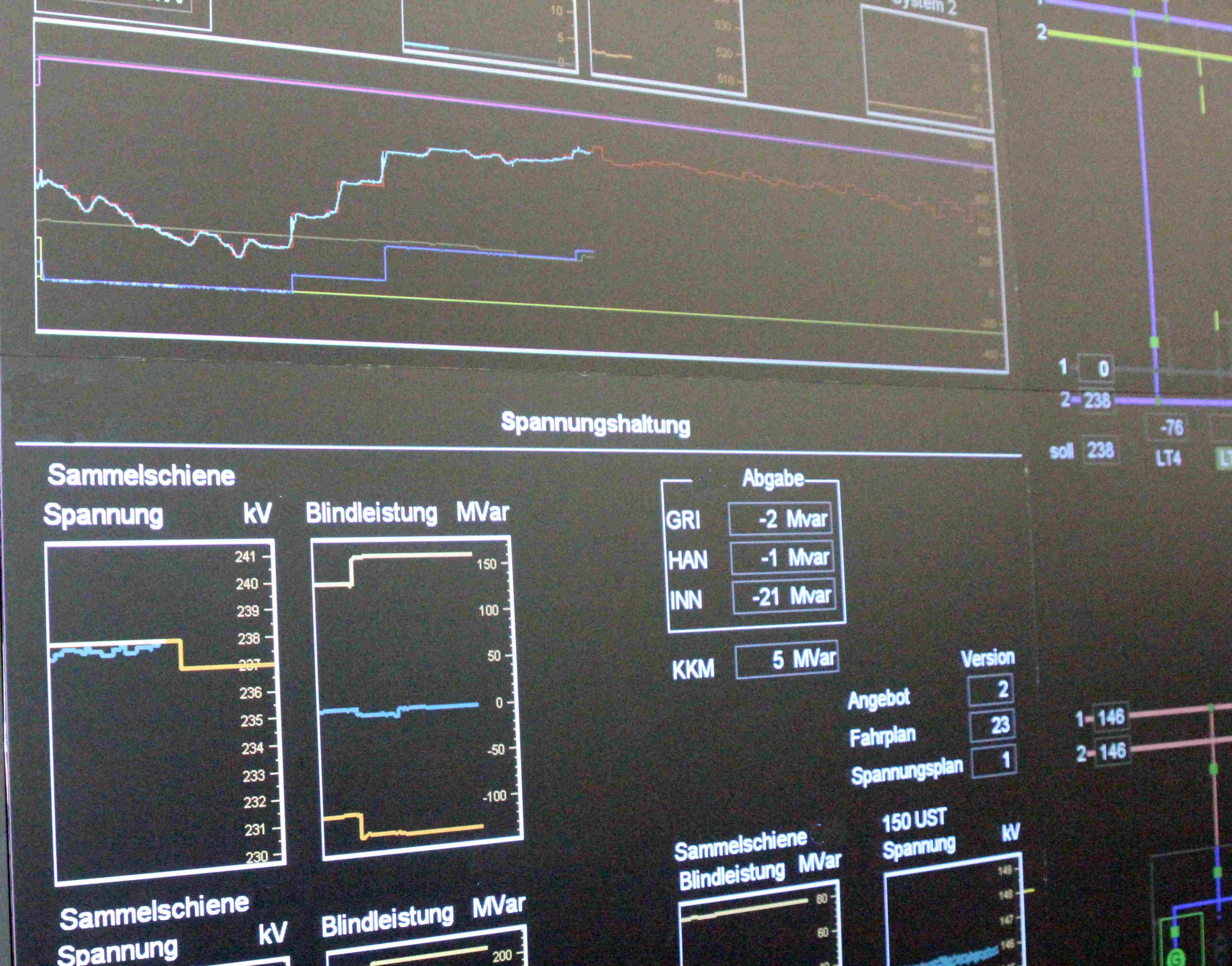

Bild 3. Ausschnitt der Anzeigen in der Leitwarte eines Kraftwerks. Hier sorgt ausgeklügelte Technik für die ständige Anpassung der Produktion an den Bedarf

Kraftwerke kann man nicht einfach ein- und ausschalten

Grundlastkraftwerke sind die Arbeitspferde des Elektrizitätsnetzes. Es sind die gröβten, zuverlässigsten und von ihren Produktionskosten her günstigsten Kraftwerke, dafür gebaut, 24 Stunden am Tag und wenn möglich 365 Tage im Jahr für den erwähnten Sockel von 40.000 MW zu sorgen, ohne den in Deutschland die Zivilisation – und das ist wörtlich zu nehmen – zusammenbrechen würde. Diese Kraftwerke werden auf den sogenannten optimalen Betriebspunkt gebracht und bleiben dann dort, weil jede Abweichung einen schlechteren Wirkungsgrad – und damit auch mehr CO2-Ausstoss – verursachen würde. Ihre riesigen, oft über 100 m hohen Kesselanlagen, die viele Tausend Tonnen Stahl in Form komplexer Rohrbündel enthalten, erleiden schon bei kleineren Temperaturänderungen Schäden durch Wärmeausdehnung. Solche Kraftwerke kann man nicht wie ein Auto einfach per Zündschlüssel und Gaspedal bedienen. Dafür erzeugen sie Strom – zumeist aus Braunkohle oder Kernkraft – zu sehr günstigen Preisen von etwa 2,5-3,5 ct/ kWh [WIKI2].

Für die Mittellast kommen in der Regel Steinkohlekraftwerke zum Einsatz, die sich zumindest innerhalb eines gewissen Bereichs herauf- und herunterregeln lassen. Dennoch gilt auch für sie, dass sie aufgrund ihrer groβen Massen und der mit Laständerungen verknüpften Schädigungen geänderten Anforderungen nur träge folgen. Um sie nachts nicht zu weit herunterregeln zu müssen, wird der von ihnen erzeugte Strom in den Stunden geringster Netzlast genutzt, um sogenannte Pumpspeicherkraftwerke zu füllen. Diese pumpen mit dem überschüssigen Nachtstrom Wasser in hochgelegene Staubecken. Am Tag kann man es dann auf Turbinen leiten und so Strom erzeugen.

Bild 4. Pumpen-Turbinenblöcke in einem Pumpspeicherkraftwerk. Solche Anlagen bieten die beste zurzeit groβtechnisch verfügbare Möglichkeit zur Speicherung von Strom

Die Spitzenlast übernehmen vor allem Gaskraftwerke. Das sind groβe Gasturbinen, die innerhalb weniger Minuten von Stillstand auf hohe Leistung gebracht werde können. Sie gehören zu den teuersten, zugleich aber auch flexibelsten Einheiten im deutschen Kraftwerkspark und sorgen zusammen mit den direkt regelbaren Pumpspeicherkraftwerken für die Feinabstimmung der Stromerzeugung auf den tatsächlichen Verbrauch. Ständige Regelimpulse von den Netzleitstellen sorgen dafür, dass dieses Orchester verschiedenster Kraftwerke ständig im Einklang spielt. Anderenfalls würde das Netz sehr schnell instabil und könnte zusammenbrechen.

Die Rolle der erneuerbaren Energien

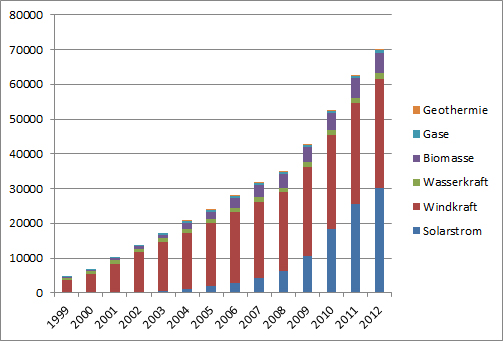

Bild 5. Die nominelle Stromerzeugungs-Kapazität der in Deutschland installierten Kraftwerke, die mit „erneuerbaren Energien“ arbeiten, reicht theoretisch schon fast aus, um das Maximum des Tagesbedarfs zu decken

Mit der massiven Förderung der sogenannten „Erneuerbaren Energien“ sowie der Abschaltung der Kernkraftwerke wird dieses über Jahrzehnte aufgebaute und durchoptimierte Stromversorgungssystem jetzt mit Situationen konfrontiert, für die es niemals ausgelegt war. Wie man an Bild 5 sieht, entspricht die installierte Erzeugungskapazität aller erneuerbaren Energien nach den inzwischen erfolgten Investitionen von mehreren 100 Mrd. € inzwischen fast dem Maximalwert dessen, was für die Stromversorgung Deutschlands erforderlich ist [EMAP]. Kann man also in Bälde das vom US-Präsidenten Bush her bekannte Banner „Mission accomplished“ aufhängen und darangehen, zusammen mit den restlichen Kernkraftwerken auch die als „Dreckschleudern“ in Verruf gekommenen Kohlekraftwerke abzuschalten?

Hohe Kapazitäten von Wind und Sonne

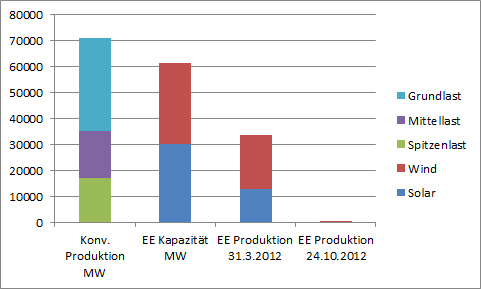

Sieht man sich die Darstellung der installierten Kapazitäten „erneuerbarer“ Energien in Bild 5 genauer an, so stellt man fest, dass Wind und Fotovoltaik mit zusammen rund 61.500 MW daran den mit Abstand gröβten Anteil haben. Allein die Kapazitäten dieser beiden Energiequellen reichen zusammen bereits aus, um theoretisch fast 80 % des benötigten Stroms zu erzeugen. Verdeutlicht wird dies im Bild 6, wo die entsprechenden Kapazitäten in Form von Balken eingetragen wurden. Allerdings stehen diese Kapazitäten weder ständig noch zuverlässig zur Verfügung. Wind und Sonne folgen nur ihren eigenen Regeln, so dass die tatsächlich zur Verfügung stehende Energie innerhalb sehr weiter Grenzen schwankt. Strom aus Sonne steht sogar stets nur tagsüber zur Verfügung. Genau dies ist das Problem.

EE-Strom als Störenfried

Bild 6. Die theoretische Kapazität der deutschen Wind- und Solarkraftwerke erreichte 2012 schon mehr als 61.000 MW (Grafik: Wikimedia Creative Commons)

Die Auswirkungen dieser Schwankungen verdeutlicht Bild 7. Der linke Balken zeigt die typische Höchstlast eines Tagesgangs mit ihren Anteilen aus Grund-, Mittel- und Spitzenlast. Der Balken rechts daneben zeigt die theoretisch verfügbaren Erzeugungskapazitäten von Wind- und Solarstrom, den beiden Hauptakteuren der „erneuerbaren“ Stromproduktion. Das tatsächliche kumulierte Aufkommen dieser beiden Erzeugungsarten für den Tag maximaler gemeinsamer Produktion zeigt der dritte Balken: Am 31.3.2012 standen um 07:30 Uhr kurzzeitig 12567 MW Solarleistung und 20843 MW Windleistung gleichzeitig zur Verfügung [EEX]. Für diesen Zeitpunkt hätte man demnach theoretisch nicht nur alle Spitzenlastkraftwerke, sondern darüber hinaus auch nahezu die gesamte Mittellast vom Netz nehmen können. Praktisch ist das jedoch nicht möglich, denn die Stromerzeugung dieser Einheiten muss im Voraus geplant und verkauft werden, weil sowohl Produzenten als auch Abnehmer des Stroms Planungssicherheit brauchen. Die übrigen, zum Spot(t)preis extrem kurzfristig an den Börsen gehandelten Strommengen sind vergleichbar mit den „last-minute“-Angeboten im Reisesektor. Sie ersetzen nicht das reguläre Reisegeschäft, sondern sind ein Entlastungsventil, wo Notverkäufer und Schnäppchenjäger miteinander handelseinig werden können. Selbst theoretisch hätte man am 31.3. nicht alle Kraftwerke der Mittel- und Spitzenlast abschalten können, denn solche EE-Leistungen stehen nur kurzzeitig zur Verfügung, und Mittellastkraftwerke sind nur in gewissen Grenzen regelbar.

Bild 7. Wenn die Stromproduktion aus Sonne und Wind – wie am 24.10.2012 mit lediglich 258 MW – bei weniger als 1 % des Bedarfs liegt, sind konventionelle Kraftwerke unverzichtbar. Es kann also keine Rede davon sein, dass diese „ersetzt“ würden

Viel bedeutsamer ist jedoch die Situation am 24.10.2012 um 6:00 Uhr morgens [EEX]. Den entsprechenden Balken kann man in der Grafik nicht sehen, weil der betreffende Strich zu dünn ist: Zu diesem Zeitpunkt gab es gar keinen Solarstrom, und der Wind steuerte nur 258 MW zur deutschen Stromversorgung bei. Anders ausgedrückt: Nur mit Wind und Sonne hätte Deutschland restlos stillgestanden. Trotz gigantischer Investitionen in Wind- und Solaranlagen muss für solche Fälle der gesamte Bestand konventioneller Kraftwerke weiter vorgehalten werden. Das heiβt auch, dass der damit verbunden Kostenapparat – wie Personal, Instandhaltung, Verwaltung und Kapitaldienst – ständig weiterlaufen muss, damit die Kraftwerke im Notfall zur Verfügung stehen können. Eingespart werden lediglich die Brennstoffkosten, diese Einsparung wird jedoch durch erhöhte Reparaturaufwendungen wegen der schadenträchtigen Anfahr- und Abschaltvorgänge in der Regel mehr als nur kompensiert. Im Prinzip läuft demnach die Stromerzeugung aus Wind und Sonne im Wesentlichen darauf hinaus, dass ein bestens eingespieltes und durchoptimiertes Stromversorgungssystem nicht im geringsten ersetzt werden kann. Stattdessen wird es vor allem gestört und durcheinandergebracht. Mit jedem Wind- und Solarkraftwerk, das zusätzlich ans Netz gebracht wird, nehmen diese Probleme sogar noch weiter zu. Bis jetzt wurden „nur“ die Spitzen- und die Mittellast beeinträchtigt. Wenn es erst soweit kommt, dass auch der Betrieb von Grundlastkraftwerken nicht mehr störungsfrei möglich ist, dann gute Nacht Deutschland.

Stromspeicherung wäre einziger Ausweg

Die einzige Möglichkeit, solche katastrophalen Auswirkungen zu verhindern, wäre eine Zwischenspeicherung des am Bedarf vorbei erzeugten EE-Stroms, um diesen dann bei schlechter Wetterlage wieder ins Netz zurückzuspeisen, so wie es ja auch bereits mit dem Strom aus vorübergehend nicht ausgelasteten Mittellastkraftwerken geschieht. Als einzige groβtechnisch bewährte Methode stünden hierfür die bereits erwähnten Pumpspeicherkraftwerke zur Verfügung [WIKI3]. Sie haben einen Wirkungsgrad von rund 70-80 %, deutlich besser als der aller anderen Technologien wie Druckluft, Wasserstoff oder Power-to-Gas, die von interessierten Kreisen hierfür gerne und häufig in die Diskussion gebracht werden.

Das Problem: Es gibt nicht die geringste Aussicht, auch nur annähernd die benötigten Speicherkapazitäten aufzubauen, da es in Deutschland aufgrund der geographischen Gegebenheiten kaum noch geeignete Standorte für Pumpspeicherkraftwerke gibt. Die derzeit vorhandenen Anlagen haben eine Leistung von insgesamt rund 7000 MW, etwa ein Zehntel dessen, was bereits jetzt an kombinierter Erzeugungskapazität im Bereich Wind- und Solarkraftwerke installiert ist. Neben der zu geringen Leistung ist auβerdem auch ihre Speicherkapazität völlig unzureichend. Sie wurden für einen regelmäβigen Tag-Nacht-Zyklus ausgelegt und können selbst bei voller Aufladung meist nur wenige Stunden Strom liefern. Da Schlechtwetterperioden mit wenig Wind und kaum Sonne jedoch gerade im Winter über Wochen andauern können, braucht man über diese Option gar nicht erst nachzudenken. Und auch unsere Nachbarländer Norwegen, Schweiz und Österreich haben nicht im Entferntesten die Möglichkeit, mit ausreichenden Kapazitäten in die Bresche zu springen.

Wünsche und Wirklichkeiten

Bild 8. Beim Transport und der Speicherung elektrischer Energie liegen die Leitungs- und Umspannverluste schnell im zweistelligen Prozentbereich

Wie sehr Politik und interessierte Ideologen dennoch gerade auf diesem Gebiet dem Bürger Halbwahrheiten und Unsinn präsentieren, zeigt sich besonders krass in diesem Bereich. Herausragendes Beispiel ist in diesem Zusammenhang ein Gutachten des von der Bundesregierung eingesetzten Sachverständigenrats für Umweltfragen, der laut einem Wikipedia-Artikel im Mai 2010 in einem Sondergutachten „100 % erneuerbare Stromversorgung bis 2050: klimaverträglich, sicher, bezahlbar“ davon ausging, dass „die Kapazitäten der Speicherkraftwerke insbesondere in Norwegen (allein nahezu 85 TWh Wasserbeckenkapazität der dortigen zu Pumpspeichern ausbaufähigen Speicherwasserkraftwerke) und Schweden bei weitem ausreichen, um Schwankungen der zukünftig eingespeisten erneuerbaren Energien auszugleichen [WIKI4].“ Macht man sich jedoch die Mühe, die Tatsachen z.B. in Norwegen zu überprüfen, so stellt man fest, dass es dort zurzeit so gut wie gar keine installierten Pumpspeicherkapazitäten gibt. Als einziges tatsächlich vorhandenes norwegisches Pumpspeicherkraftwerk findet sich das Kraftwerk Saurdal mit einer installierten Pumpleistung von gerade einmal 320 MW, daneben werden zwei weitere Projekte aufgeführt – ohne Angaben zu einem Inbetriebnahmedatum. Es ist schon erschreckend zu sehen, in welcher Weise hier theoretische Möglichkeiten als Fakten dargestellt werden. Über die Kosten scheint man sich dabei gar keine Gedanken gemacht zu haben.

Der Wirkungsgrad ist entscheidend

Zu allen anderen Speichertechnologien, die zurzeit als Alternativen zur Pumpspeicherung angeboten werden, kann kurz und bündig ausgesagt werden, dass ihr Wirkungsgrad viel zu schlecht und ihre Kosten viel zu hoch sind, um sie als Alternativen auch nur in Betracht zu ziehen. Daran wird auch noch so viel Forschung nicht viel ändern. Selbst unter optimalen Bedingungen erreichen viele dieser Technologien nur 30 bis 54 %, lediglich in Ausnahmefällen werden 62 % erreicht. Dazu muss man noch Leitungs- und Umspannverluste von 15 % und mehr rechnen, da der Strom von weit her zu den Speichern und von dort wieder zu den Verbrauchern transportiert werden müsste. Addiert man beide Verluste, so bedeutet dies, dass mehr als 50 % des teuren EE-Stroms verloren gingen, was volkswirtschaftlich völlig untragbar wäre. Zudem läge die zeitliche Reichweite dieser Speichersysteme meist im Bereich weniger Stunden statt der Wochen bis Monate, die zur effektiven Vorratshaltung benötigt würden.

Fred F. Mueller

Der Beitrag erschien zuerst bei Science Sceptical

Quellen

[EEX] http://www.transparency.eex.com/en/

[EMAP] www.EnergyMap.info (16.2.2013)

[RWE] http://www.rwe.com/web/cms/de/37110/rwe/presse-news/pressemitteilungen/pressemitteilungen/?pmid=4008636 (am 18.3.2013)

[WIKI1] http://de.wikipedia.org/wiki/Mittellast (am 18.3.2013)

[WIKI2] http://de.wikipedia.org/wiki/Stromerzeugung (am 18.3.2013)

[WIKI3] http://de.wikipedia.org/wiki/Liste_von_Pumpspeicherkraftwerken (am 18.3.2013)

[WIKI4] http://de.wikipedia.org/wiki/Pumpspeicherkraftwerk (am 18.3.2013)