…So konnten anhand historischer und aktueller Daten, nach einem Hauptsonnenzyklus starke Ausschläge zwischen warm und kalt nachgewiesen werden und sind in unseren Breiten als „normal“ anzusehen, was bedeutet, dass das Klima/Wetter in Deutschland für die nächsten Jahre starken Schwankungen zwischen warm und kalt unterliegt. So freut es uns natürlich, dass die Warmisten von PIK und Co. zu ähnlichen Aussagen, was die Schwankungen betrifft, gelangen. Dass deren Erklärungen hierzu, jedoch an der Wirklichkeit vorbeigehen und der Realität (wieder einmal) nicht standhalten, zeigt unser Teil 2.

Obwohl wir kälteren Zeiten entgegen gehen, werden Mammut und Wollnashorn in unseren Breiten nicht mehr erscheinen. Übertreibungen solcher Art, wenn auch in die andere Richtung, überlassen wir PIK, AWI, ZDF und Co. Wir wollen uns mehr an der Naturwischenschaft orientieren. Abbildung, Quelle: Wikimedia.commons

PIK und AWI behaupten: Es ist kälter, weil es wärmer wird

Dass für die nächsten Jahrzehnte mit hohen Schwankungen zwischen warm und kalt zu rechnen ist, hat Leistenschneider bereits in 09/2011 in seiner EIKE-Reihe, “Dynamisches Sonnensystem – Die tatsächlichen Hintergründer des Klimawandels“ festgehalten und dies anhand historisch gemessener Temperaturdaten, wie sie z.B. in den Abbildungen 15 bis 19 (Teil 1) zu sehen sind, festgehalten und mit der Sonnenphysik beschrieben. Umso erfreulicher, dass gegenwärtig die sog. Warmisten sich seine Feststellung zu Eigen machen. Abenteuerlich hingegen ist deren Begründung für die aktuelle Abkühlung. Aber dazu später mehr. Lassen Sie uns zuerst unser Ergebnis, dass die Wintertemperaturen den Jahrestemperaturen um ca. 10 Jahre vorlaufen und somit deren Trend vorweg nehmen, weiter prüfen.

Unsere eingangs gezeigte Auswertung ergab das Jahr 2070, bis die Temperaturen in unserem Land wieder zu steigen beginnen. Wird bei unserem Ergebnis weiter dem Fakt Rechnung getragen, dass bei inaktiver Sonne sich das Verhältnis Abstiegszeit (Abkühlung) zu Anstiegszeit (Erwärmung) zugunsten der Abkühlung verschiebt, so trifft unser Ergebnis sehr exakt die Realität des letzten Hauptsonnenzyklus – so, wie sich seinerzeit die Temperaturen entwickelten. Keine gute Nachricht, denn eine Warmzeit ist eine gute Zeit. Nicht nur wegen der Heizkosten und dem Freizeitwert, sondern vor allem für die Biosphäre. Aber wissenschaftliche Erkenntnis richtet sich nun einmal nicht an menschlichen Wünschen.

Wie gesagt, möchten wir unsere Ergebnisse jedoch noch weiter absichern, bzw. prüfen. Besteht der von uns ermittelte jahreszeitliche Vorlauf der Temperaturen noch bei weiteren Datenreihen. Hierzu möchten wir Frühling und Herbstgang der Temperaturen vergleichen.

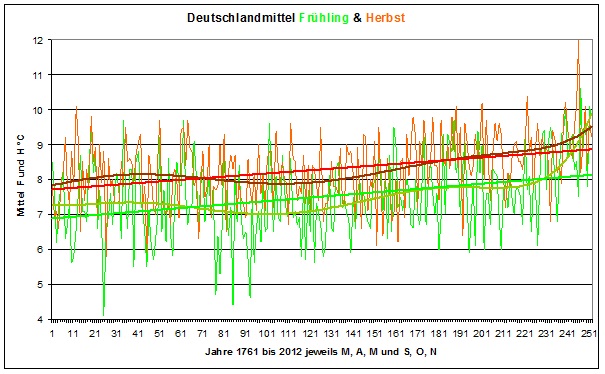

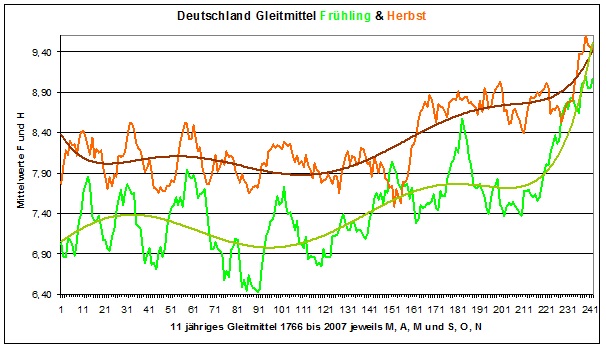

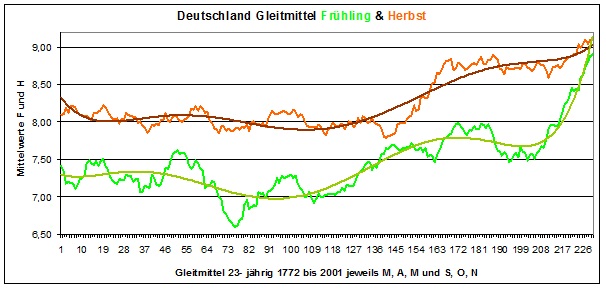

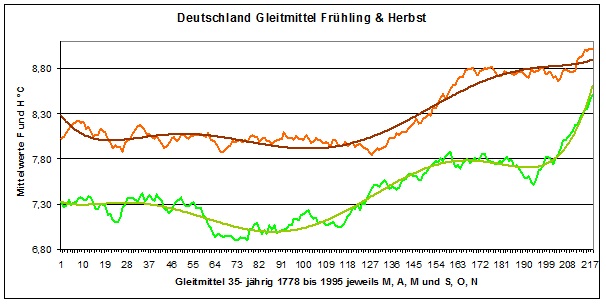

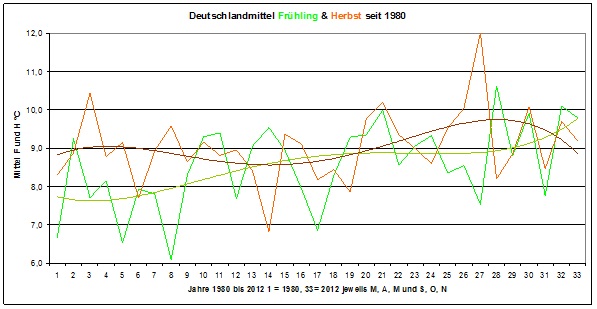

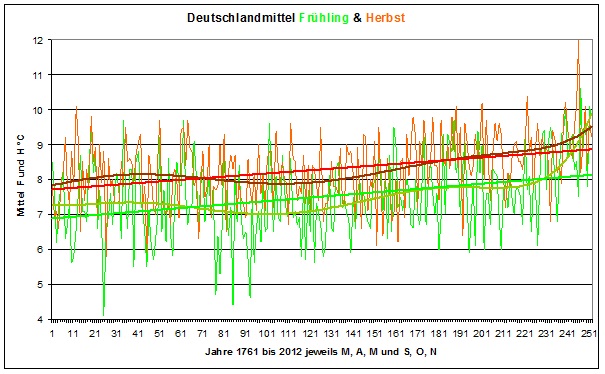

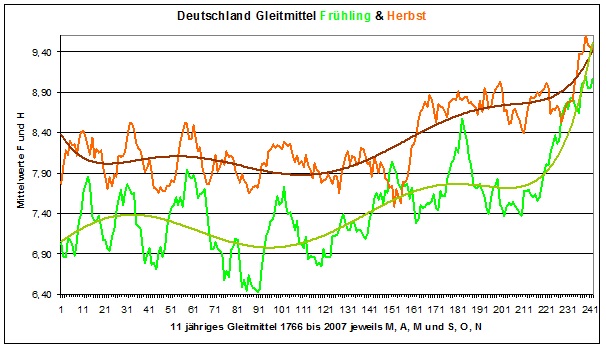

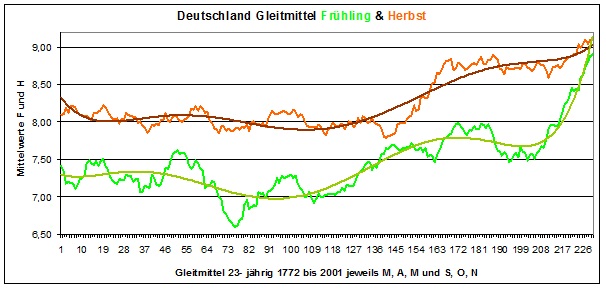

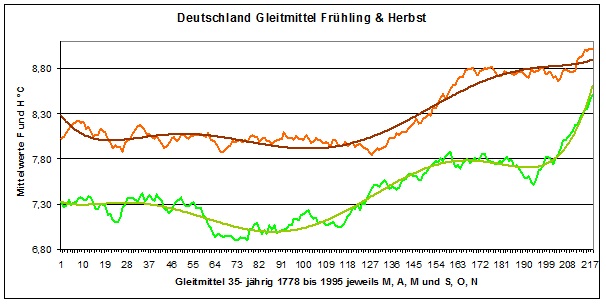

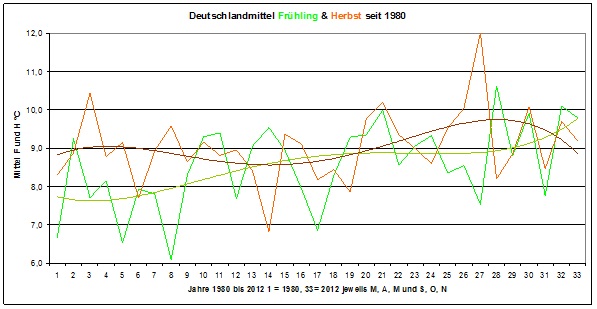

Abbildungen 20 – 24: Basis dieser Untersuchungen waren das „Wikipedia- Deutschlandmittel“ ab 1761 und das Rastermittel Deutschland ab 1881. Ganz oben Einzelwerte ab 1761 mit Linear- und Polynomtrends. Bei langfristiger Betrachtung sind die Lineartrends gleich, was auch zu erwarten war. Abbildungen 22 – 24 zeigen Gleitmittel 11-, 23- und 35- jährig mit Polynom- Trends. Die untere Abbildung 25 zeigt, dass sich auf der kurzfristigen Skala (1980 bis 2012) sogar ein gegenläufiges Verhalten zeigt- wenn Frühling warm, dann Herbst tendenziell eher kalt- und umgekehrt. Man erkennt außerdem bei allen Abbildungen, dass die Frühjahrsmittel die Herbstmittel gegen Ende des Betrachtungszeitraums eingeholt haben. Als mögliche Ursachen kommen eventuell unterschiedliche Auswirkungen der verschiedenen Wärmeinsel- Effekte in Betracht. Außerdem nahm die herbstliche Sonnenscheindauer während der vergangenen 30 Jahre weniger deutlich zu, als die des Frühjahres; und der Frühling, besonders der April, zeichnete sich durch eine wachsende Anzahl von Hochdruckwetterlagen aus (KÄMPFE/LEISTENSCHNEIDER/KOWATSCH 2013: „Erst zum Gipfel, dann wieder talwärts: Die Temperaturentwicklung in Deutschland seit 1980 und deren wesentliche Ursachen“, Teile 2 und 3) bei http://www.eike-klima-energie.eu/news-cache/erst-zum-gipfel-dann-wieder-talwaerts-die-temperaturentwicklung-in-deutschland-seit-1980-und-deren-wesentliche-ursachen/

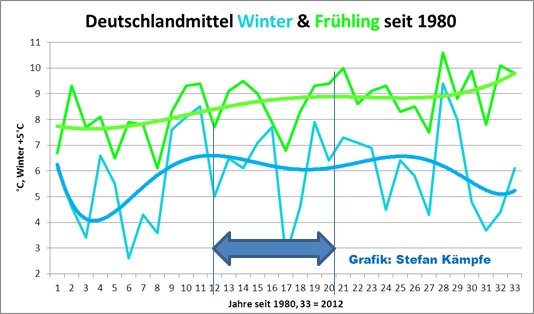

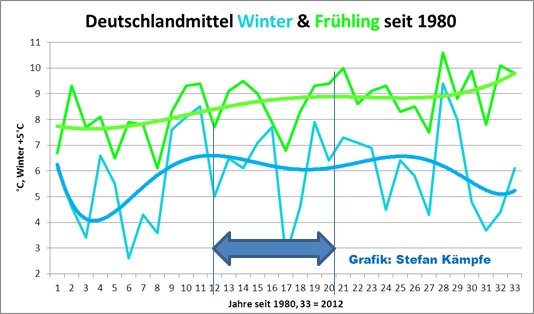

Inwieweit die Wintertemperaturen, einen Trend vorwegnehmen, haben wir auch am Vergleich zu den Frühlingstemperaturen geprüft (Abbildungen 25 und 26).

Abb. 25 und 26: Sowohl die Deutschland-Langzeitzeitmittel aus den Wikipedia-Daten, als auch die Deutschlandmittel der DWD-Daten zeigen das gleiche Verhalten der Temperaturen, insbesondere ihres Trends (Polynom 6): Die Wintertemperaturen eilen den Frühjahrtemperaturen voraus und zwar um gut 10 Jahre, wobei in einer Abkühlungsphase auch hier sich das Verhältnis verschiebt – größer wird. Eine mögliche Erklärung für diese Verschiebung sind die Strahlungsgesetze nach Planck und die Abkühlungsgesetze nach Newton, wie sie auch Leistenschneider in 2010 als Basis für die Berechnung seines WI-Temperaturwertes der Deutschlandtemperaturreihe des DWD heranzog, EIKE berichtete darüber (http://www.eike-klima-energie.eu/uploads/media/Waermeinseleffekt-k-L_I_und_II.pdf). Ein gleich starker Erwärmungsantrieb wirkt im niedrigen Temperaturniveau deutlicher, als bei höherem Ausgangsniveau der Temperaturen. Seine Überlegungen und seine ermittelten WI-Werte für Deutschland, wurden übrigens jüngst bei WUWT zu 100% bestätigt (http://wattsupwiththat.com/2013/04/16/revisiting-temperature-reconstructions-used-in-climate-change-modeling/).

Anhand weiterer Untersuchungen, wird dieses Verhalten, sowie die unterschiedliche Temperaturentwicklung der Jahreszeiten eingehender geprüft werden müssen; besonders zur Rolle der WI-Effekte.

Deutschland: Frühlingsmittel laufen den Herbstmitteln und die Wintermittel, den Frühlingsmitteln um 1 bis 1,5 Jahrzehnte voraus! Wie bereits der Wintervorlauf zu den Jahrestemperaturen.

Eine mögliche Erklärung, dass die Herbstmittel den Frühlingsmitteln nachlaufen, also eine Abkühlung später anzeigen, könnte in der Erwärmung der Speicherflächen Land und Wasser liegen. Diese geben die im Frühjahr und Sommer gespeicherte Sonnenwärme an die Atmosphäre ab und diese gespeicherte (Zusatz)Wärme wird zu der direkten solaren Strahlung über die vorherrschenden Luftströmungen (West, Südwest) zu uns getragen. Genauere Untersuchungen werden z.Z. durchgeführt.

Daraus kann der Schluss gezogen werden, dass in naher Zukunft die Frühlingstemperaturen zuerst und stärker sinken werden, während der Herbst tendenziell noch ein paar Jahre relativ warm bleiben könnte- das deutete sich in den vergangenen Jahren schon so an.

Und nun zu den abenteuerlichen Versuchen der sog. Warmisten, die Kälte, die wir seit mehreren Jahren vorfinden, der aus Computermodellen abgeleiteten postulierten Erderwärmung zuzuschreiben. So war am 28.03.2013 in der Südwestpresse folgendes zu vernehmen: “Weil das Eis in der Arktis schmilzt, fließt kalte Polarluft nach Mitteleuropa. Im Nordosten Deutschlands geht laut Deutschem Wetterdienst der kälteste März seit 130 Jahren zu Ende. Klimaforscher rechnen für die Zukunft mit häufiger auftretenden extremen Wintereinbrüchen.“ Aha, “Klimaforscher rechnen für die Zukunft mit häufiger auftretenden extremen Wintereinbrüchen“. Auf EIKE hat dies bereits Leistenschneider in der erwähnten Reihe zum Einfluss der Sonne auf unser Wetter/Klima in 09/2011 aufgezeigt und hergeleitet (ohne aufwendige Klimamodelle und Supercomputer, sondern anhand der Sonnenphysik und historischer Temperaturdaten).

Die Erklärung, die die sog. Warmisten anführen, klingt indes so: “Mehrere Klimastudien hatten diese Kälteeinbrüche bereits vorhergesagt. Eine Ursache ist demnach das mit der Erderwärmung immer stärker schmelzende Arktiseis. PIK-Forscher Vladimir Petoukhov hatte 2010 in einer Modellrechnung eine Verdreifachung extremer Wintereinbrüche in Europa und Nordasien prognostiziert. Grund: Das dunkle, offene Meer in der Arktis heize untere Luftschichten weiter auf. Das führe zu einer Luftströmung, die in der Computersimulation kalte Winterwinde nach Europa brachte.“ Oder wie folgt:

“Wladimir Petoukow vom Potsdam-Institut für Klimafolgenforschung und Klaus Dethloff in der Forschungsstelle Potsdam des Alfred-Wegener-Instituts haben alles herausgefunden: Mithilfe von Computermodellen zeigen beide Forschergruppen, wie der Klimawandel Teile Europas in einen Eiskeller verwandeln könnte: Wenn die moderne Zivilisation viel Kohle, Öl und Gas verbrennt, steigen weltweit die Temperaturen und auf dem Nordpolarmeer schmilzt das Eis. Genau das registrieren Forschungssatelliten seit einigen Jahren. Mit dem Eis aber fehlt auch der Deckel, der die Energie im Wasser hält. Daher erwärmt sich auch die Luft über den eisfreien Wasserflächen. Dadurch aber verändert sich auch der Luftdruck über dem Atlantik in arktischen und in mittleren Breiten und es kann sich ein Hoch über Skandinavien bilden, das uns zurzeit eisige Temperaturen beschert.“

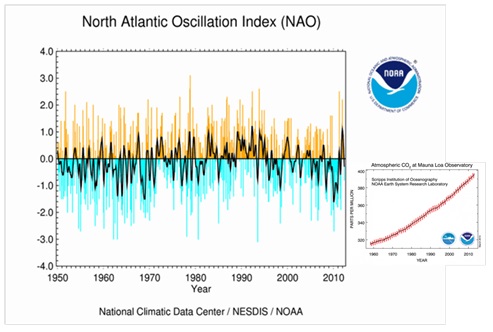

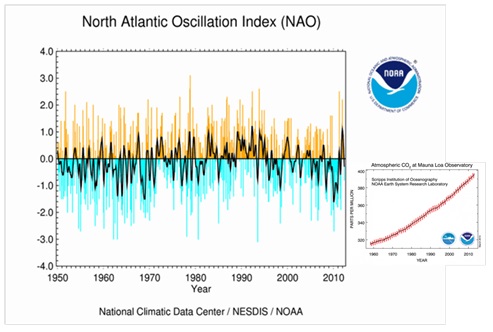

Nun zu den Fakten. Die Luftströmungen, die sich angeblich wegen den vielen Treibhausgasen geändert haben, werden von der NAO (North Atlantic Oscillation) bestimmt. Die NAO gibt das Druckgefälle zwischen Islandtief und Azorenhoch an und ist Hauptfaktor für das Wetter in Europa und für die dortigen Klimaschwankungen. Sie ist ein regionaler Teil der ringförmigen Arctic Oscillation (AO) und beschreibt den Druckunterschied zwischen dem Islandtief und dem Azorenhoch. Wie der Name sagt, ist dieser Druckunterschied nicht konstant, sondern Schwankungen unterworfen, die einen oszillierenden Charakter besitzen.

Die NAO bestimmt den Verlauf der Zugbahnen atlantischer Sturmsysteme und die daraus resultierende Beeinflussung der Niederschlags- und Temperaturmuster im Nordatlantik. Sie wird auch in Zusammenhang gebracht mit der arktischen Meereisausbreitung, dem Eisvolumen in der “Davis Strait“ und den Eisbergflussraten vor der Küste Labradors. Sie ist maßgeblich für unser Wettergeschehen und wird daher an dieser Stelle näher betrachtet.

Als Maß für die NAO wird ein Index der Luftdruckunterschiede an repräsentativen Stationen benutzt. In der Definition nach Hurrell sind dies “Stykkysholmur“ auf Island und “Ponta del Gada“ auf den Azoren. Der NAO-Index nach Jones verwendet anstelle der Station “Ponta del Gada“ die Station auf Gibraltar. Allgemein gilt, dass der NAO-Index die Differenz der Druckanomalie auf den Azoren minus der auf Island ist, d.h. ist der NAOI stark positiv, hat man ein ausgeprägtes Azorenhoch bzw. Islandtief, was mit einem starken westwärts gerichteten Grundstrom und dafür typischen wandernden Zyklonenfamilien im nord-west-atlantischen und west-europäischen Raum verbunden ist und Mitteleuropa milde Winter beschert. Im Gegensatz dazu, wenn der NAO-Index niedrig oder negativ ist, dann ist der Grundstrom schwach, was oft mit meridionalen, blockierten Wetterlagen einhergeht. Die NAO soll sich demnach wegen der vielen Treibhausgase verändert haben. Dazu schauen wir, inwieweit die NAO vom atmosphärischen CO2-Pegel abhängt.

Abbildung 27 zeigt sowohl den NAO-Verlauf, als auch den atmosphärischen CO2-Pegel nach NOAA. Es bedarf keiner weiteren Erläuterungen, dass beide Verläufe, nichts gemeinsam haben. Auch der Langfristtrend der NAO zeigt keine steigende, fallende, oder sonst wie geartete Tendenz, die einen Ansatz für die Behauptungen von PIK und Co. geben.

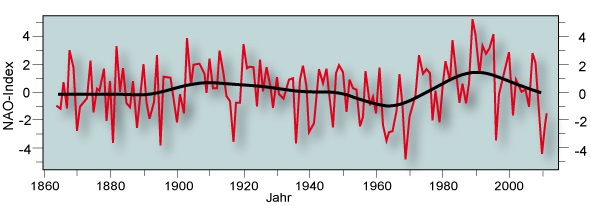

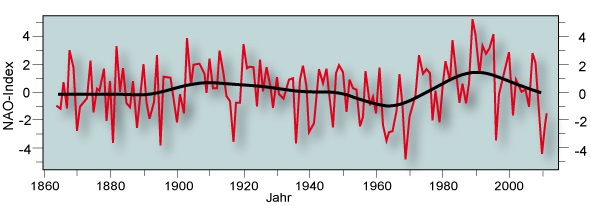

Abbildung 28: NAO von 1860 – 2011 (Quelle: Hamburger Bildungsserver). Während der atmosphärische CO2-Pegel steigt und steigt, fällt derzeit das Langfristmittel der NAO, wie z.B. auch in den 1950er Jahren. Dies lässt auf zyklische Muster schließen, die nicht auf das Freisetzen sog. Treibhausgase reagieren, sondern auf die Sonnenaktivität. Dies ist seit langem bekannt, siehe ”Length of the solar cycle influence on the relationship NAO-Northern Hemisphere Temperature”, L. Torre, L. Gimeno, M. Tesouro, J. A. Añel, R. Nieto, P. Ribera, R. García, E. Hernández, Geophysical Research Abstracts, Vol. 5, 30-1-2003.

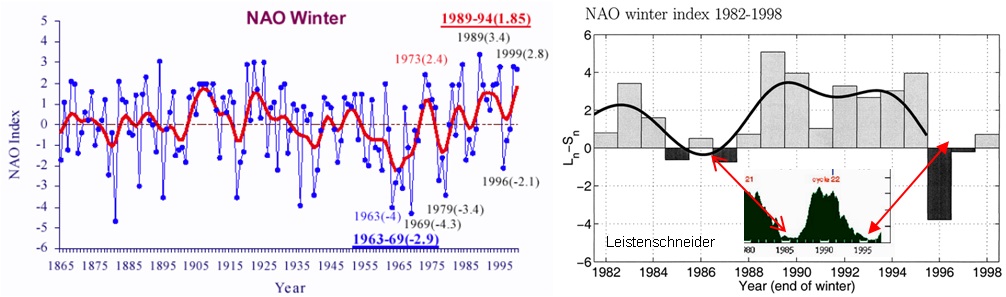

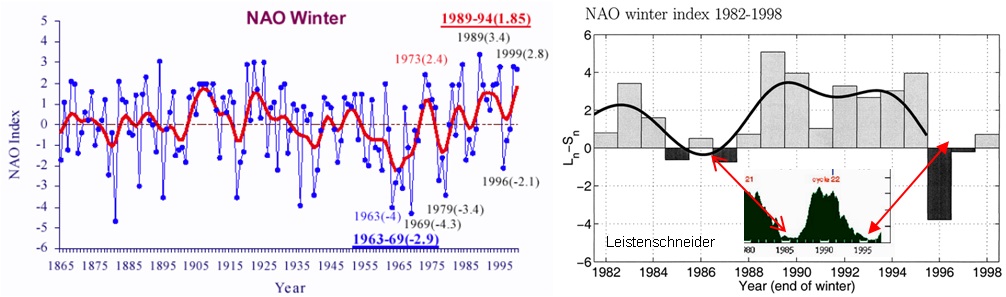

Abbildung 29 zeigt den NOA-Index nach Hurrel. Sowohl in der linken und noch mehr in der rechten Abbildung ist deutlich der Schwabe-Zyklus der Sonne abgebildet. Die Schwankungen der NAO sind in Übereinstimmung mit den Sonnenzyklen.

Abbildung 29 links zeigt den NAO-Winterindex von 1865 – 2000 (Quelle: Deutscher Wetterdienst). Deutlich ist in der Wellenform ein 10-Jahres-Zyklus abgebildet, der zeitlich mit dem Schwabezyklus korreliert. Hohe Indexwerte sind mit einer intensiven nordatlantischen Westdrift und damit milderen Temperaturen verbunden. Rechts ist der NAO-Winterindex von 1982 – 1998 abgebildet (ergänzt nach Quelle: American Meteorological Society Journal Online, Volume 13, Issue 5, März 2000). Die kleine Abbildung ist hineinkopiert und zeigt den Schwabezyklus der Sonne im selben Zeitraum. Er stimmt exakt mit dem NAO-Winterindex überein.

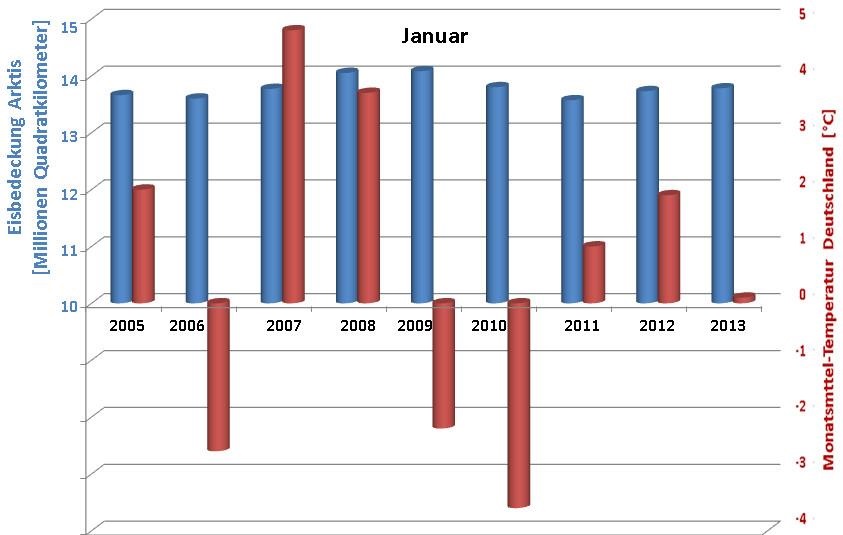

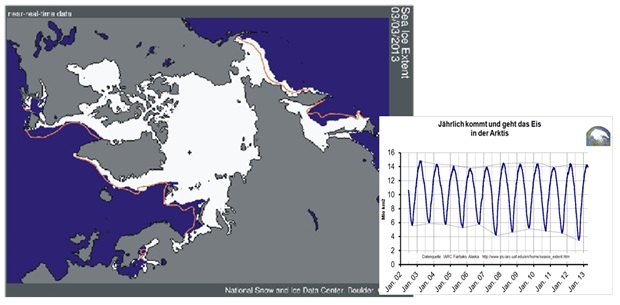

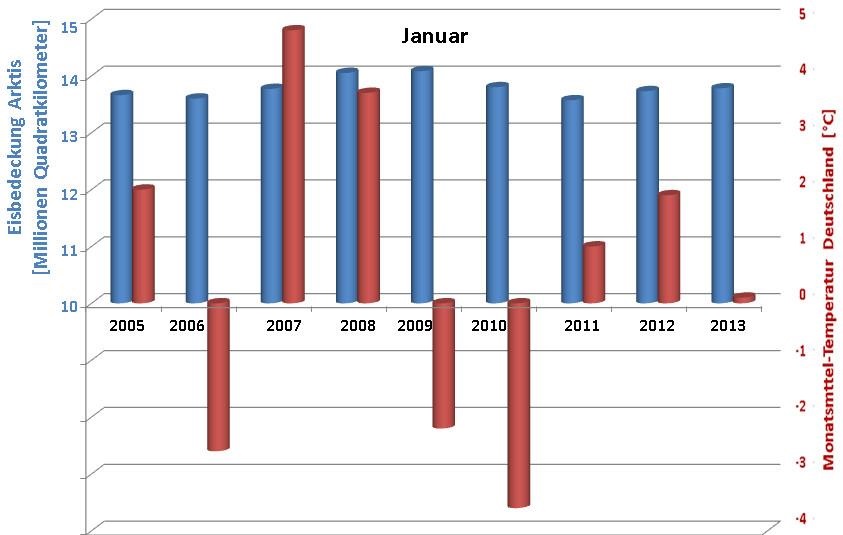

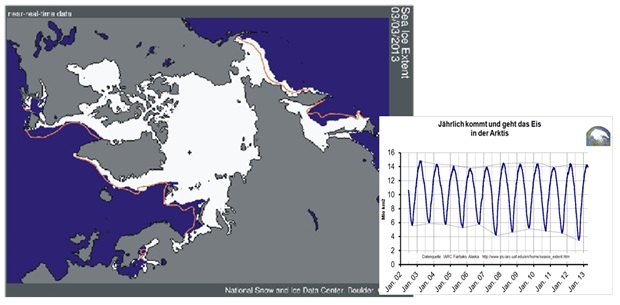

Unnötig zu erwärmen, dass ebenfalls kein Zusammenhang zwischen dem Einfluss der arktischen Meereisbedeckung und den Wintertemperaturen besteht (Abbildung 30).

Abbildung 30 (Quelle: Privatdozent Dr. Dr. Eckhard Schulze -EIKE): “Die Eisbedeckung der Arktis bewegt sich im Januar in engen Grenzen zwischen 14,5 und 15 Millionen Quadratkilometern. Die Monatsmitteltempertaturen in Deutschland (Quelle DWD) lassen, bezogen auf das jeweils selbe Jahr, keinerlei Abhängigkeiten zu den Eisbedeckungsflächen erkennen. Dies wird drastisch illustriert, wenn man die Jahre 2007 und 2010 betrachtet. In diesen beiden Jahren sind die Januarwerte der eisbedeckten Flächen nahezu gleich, die Monatsmitteltemperatur ist jedoch 2007 mit 4,8°C atypisch hoch und in 2010 mit -3,6°C recht tief für den Januar.“

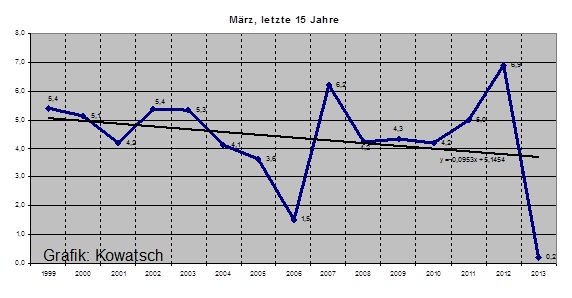

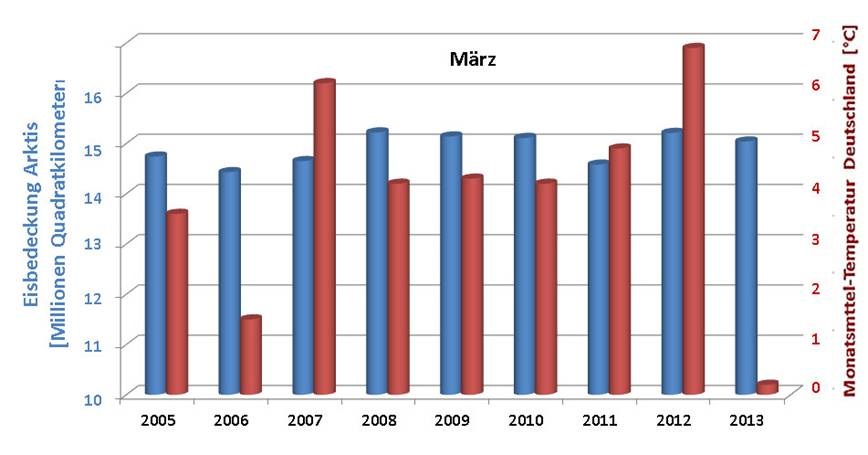

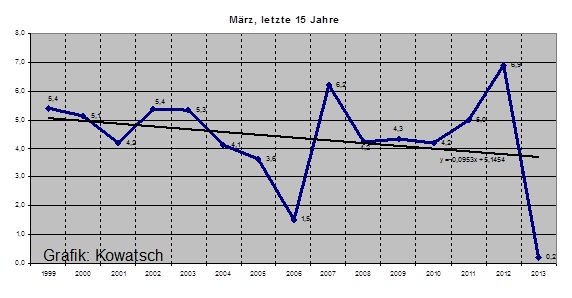

Noch deutlicher wird dies, wird zu den Märztemperaturen verglichen (Abbildung 31).

Abbildung 31, Quelle, wie Abb 30 (Datenquelle der Temperaturen, DWD, Datenquelle Monatsmittel der Eisbedeckungsflächen http://www.woodfortrees.org/data/nsidc-seaice-n). Wie unschwer zu erkennen, gibt es keinen Zusammenhang zwischen der arktischen Eisbedeckung und den Temperaturen in Deutschland. Somit kann die o.g. Aussage von PIK und AWI als widerlegt angesehen werden.

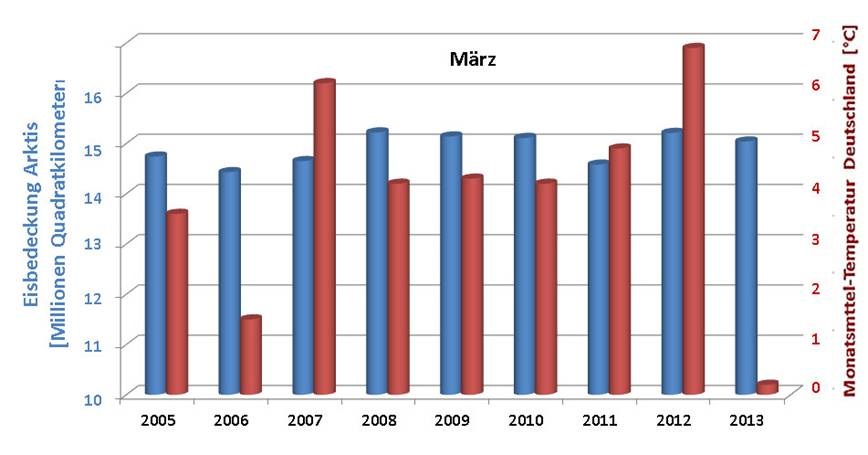

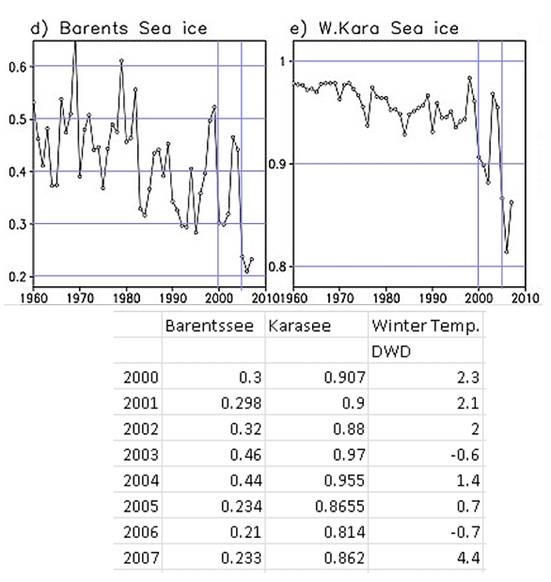

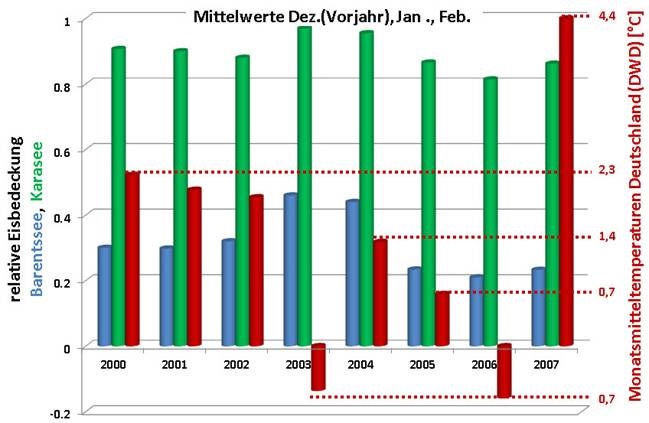

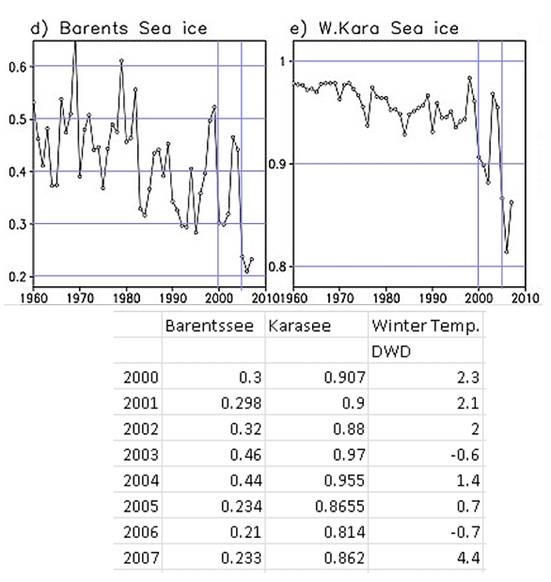

Ausgangspunkt der erneut von PIK und AWI vorgebrachten These, dass es in Deutschland kälter wird, weil es wärmer wird, um es einmal bildhaft auszudrücken, ist die Untersuchung von Petoukhov, V., Semenov, V. A. (2010): A link between reduced Barents-Kara sea ice and cold winter extremes over northern continents. – Journal of Geophysical Research, 115, D21111 (Abbildung 32):

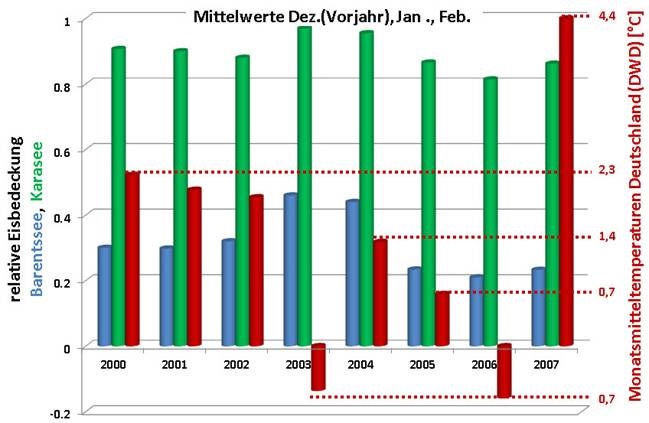

Abbildung 32 zeigt die Eisbedeckung in der Barentssee und Karasee nach Petoukhov et al. Von 2000 bis 2007 und dazu das Wintermittel für Deutschland nach DWD-Daten.

Abbildung 33, Quelle, Dr. Dr. Schulze – EIKE: Dazu in graphischer Darstellung, die Eisbeckungen Barentssee (blau) und Karasee (grün), sowie das Wintermittel der Temperaturen von Deutschland (rot). Wer daraus nun ableitet, die dortigen Eisbeckungen hätten etwas mit den Wintertemperaturen in Deutschland zu tun, der hat sehr viel Phantasie.

Zu gleichem Ergebnis kommt Herr Dr. Herold (EIKE). Die PIK-Aussage lautet: "Die vorliegenden Modellrechnungen zeigen, dass der Luftdruckgegensatz bei geringerer sommerlicher arktischer Meereisbedeckung im darauf folgenden Winter abgeschwächt wird, so dass arktische Kälte bis in die mittleren Breiten vordringen kann." Und was zeigen die Daten?

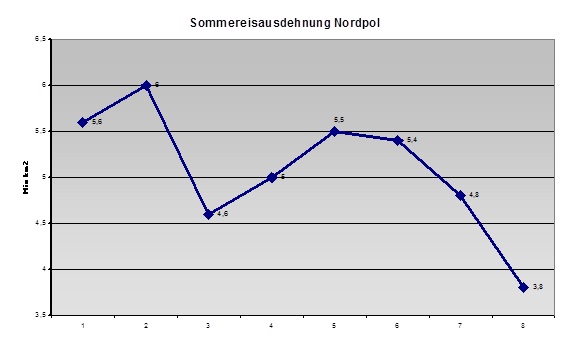

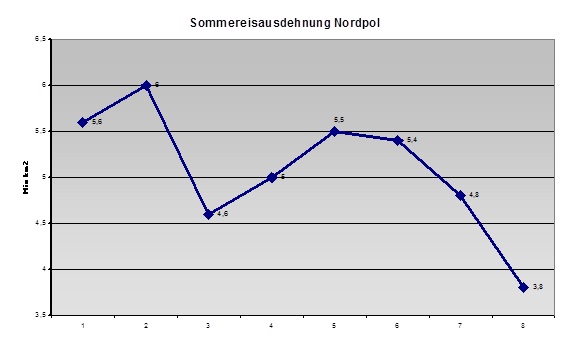

Abbildung 34 (Datenquelle: Dr. Herold – EIKE): die blaue Kurve zeigt die arktische Eisbedeckung im Zeitraum Ende August 2005 bis Ende August 2012. (8 Werte)

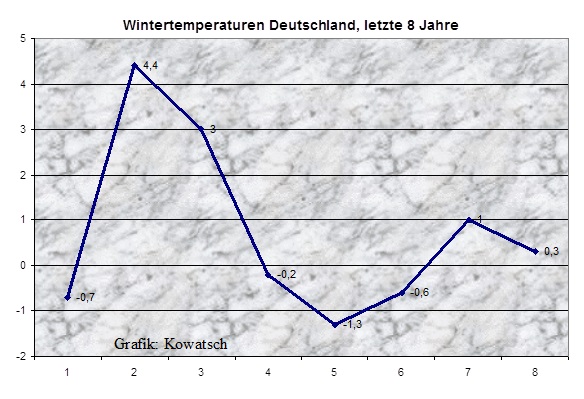

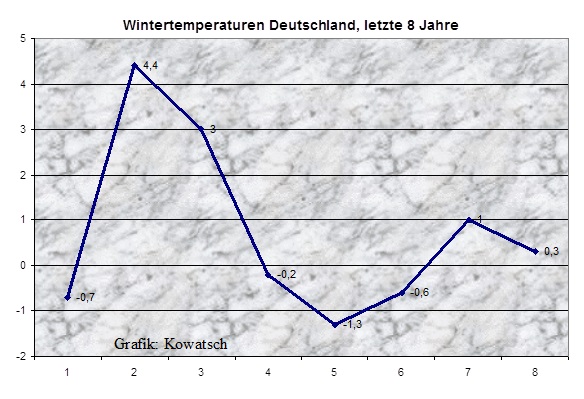

Laut PIK bestimmt diese Meereisausdehung vom Sommer die Wintertemperaturen ein halbes Jahr später in Mitteleuropa. Wenig Meereis soll kalte Winter bringen. Die entsprechenden 8 Winter haben diesen Verlauf:

Abb35a: (Datenquelle DWD). Die Wintertemperaturen Deutschlands zeigen keinerlei Zusammenhang mit der Größe der arktischen Meereisbedeckung vom Sommer davor. Die beiden Grafiken entlarven eindeutig die PIK-Aussagen als falsch.

Dieses Jahr war der März ein zusätzlicher Wintermonat in Asien, in Europa und in Deutschland. Deshalb soll dieser eigentlich erste Vorfrühlingsmonat auch in die Betrachtung mit einbezogen werden.

Abb 35b (Datenquelle DWD). Keinerlei Zusammenhang besteht auch für die Sommereisausdehnung Nordpol und den nachfolgenden Märztemperaturen. Der vom PIK behauptete Zusammenhang trifft nur zufällig für die letzte Betrachtung zu.

Außerdem sind extrem kalte Märzmonate auch in der Vergangenheit immer wieder vorgekommen. So wiesen die Märzen 1785, 1786, 1789, 1804, 1808, 1814, 1845, 1853 und 1883 an der Station Berlin- Tempelhof ein Monatsmittel unter 0°C auf, ohne dass es damals eine erhöhte CO2- Konzentration in der Atmosphäre gab!

Damit beweisen die zuvor vorgelegten Grafiken eindeutig, dass die von PIK verkündete neue Theorie, vollkommen falsch ist, denn die Grafiken von zuvor beweisen keinerlei Zusammenhang. Die Ausdehnung des Sommereises am Nordpol hat noch niemals den darauffolgenden Winter in Deutschland maßgeblich vorbestimmt. Das ist blanker Unsinn. Die Winter wurden kälter, weil seit 1998 die Temperaturen weltweit abnehmen.

Und schließlich lässt sich auch der kalte März 2013 nicht mit einer außergewöhnlich geringen Eisbedeckung im März erklären, wie die folgende Abbildung 36 beweist.

Abbildung 36 : Eisbedeckung der Arktis Anfang März 2013, Quelle: http://nsidc.org/arcticseaicenews/ (kleine Abbildung: EIKE)

Es zeigt sich, dass es gar keinen dramatischen Eisschwund im Spätwinter gibt! Wie übrigens generell nicht, was Abbildung rechts zeigt. Nach jeder noch so starken Sommerschmelze, kehrt das Wintereis auf volle Ausdehnung zurück. Es gibt demnach keine Nordpoleisschmelze. Zwar wird die orange Linie (große Abbildung, Langjähriges Median- Mittel der Eisbedeckung) vereinzelt leicht unter-, an einzelnen Stellen aber auch überschritten- für Europa (links ganz unten liegend) können diese geringen Änderungen der winterlichen Eisdecke keine wesentlichen Auswirkungen haben.

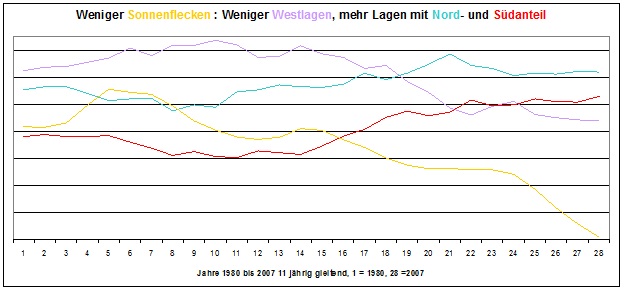

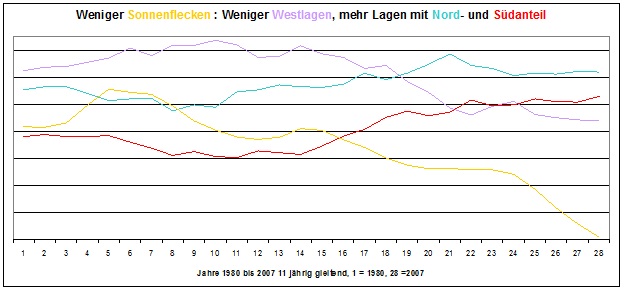

KÄMPFE/LEISTENSCHNEIDER/KOWATSCH (2013) fanden aber eine andere Ursache für die geänderten Häufigkeitsverhältnisse der Großwetterlagen, und zwar die Sonnenaktivität. Eine sehr aktive Sonne begünstigt mildernd wirkende Westlagen, die aktuell nachlassende Aktivität hingegen Extremlagen:

Abbildung 37: Man erkennt, dass mit fallender gelber Linie (Anzahl der Sonnenflecken, Gleitmittel) die Zahl der mildernd wirkenden Westwetterlagen (violette Linie) deutlich abnahm; gleichzeitig wurden Lagen mit nördlichen (blaugrün) und südlichen (rot) Strömungsanteilen häufiger, was Extremwetter begünstigt und vor allem insgesamt kältere Winter fördert (auch Südlagen können im Winter mitunter bitterkalt sein!). Man beachte, dass wegen des „11- jährigen Gleitmittels“ die Werte seit 1975 und bis 2012 mit eingeflossen sind.

Ergebnis 3

Die Abbildungen widerlegen eindeutig die von PIK und AWI vertretene These. Die Wintertemperaturen haben nichts mit einer arktischen Eisschmelze zu tun, sondern gehen, so wie von uns dargestellt, auf die rückläufige solare Aktivität zurück und das typische Verhaltensmuster der Temperaturen nach einem Hauptsonnenzyklus.

Soviel zu den Computermodellen von PIK, AWI und Co., über die angeblich durch „Treibhausgase“ ausgelöste „arktischen Eisschmelze“ und die dadurch bedingten niedrigen Temperaturen in Deutschland.

Dass dieser Unsinn, der wieder einmal von deutschen Journalisten, deren Kenntnisse meist bereits an der Oberfläche enden, ungeprüft nachgeredet wurde, vom PIK und AWI in die Welt gesetzt wurde, verwundert denn nicht wirklich. Auch nicht, dass das ZDF wieder einmal an vorderster Linie zu finden ist, da deren Journalisten und Nachrichtensprechern zuweilen der Durchblick fehlt (EIKE berichtete darüber, hier und hier ). Auch nicht, dass deren Meteorologen, wie Frau Niedek, die für den Unsinn, der anthropogenen Klimaerwärmung bezahlt werden (EIKE berichtet ebenfalls darüber auf Seite 35), dass jedoch ebenso Herr Dr. Tiersch auf den PIK (Unsinns-)Zug aufgesprungen ist und dies in der Karwoche im Heute Journal gegenüber der bereits beschriebenen ZDF-Sprecherin, Frau Slomka, eine breite Öffentlichkeit damit überraschte, dass es kälter wird, weil es wärmer wird, überrascht uns nun doch ein wenig. Offensichtlich ist das ZDF bestrebt, seinen runden Geburtstag unter dem Motto zu begehen: 50 Jahre Unsinn (und kein Ende abzusehen).

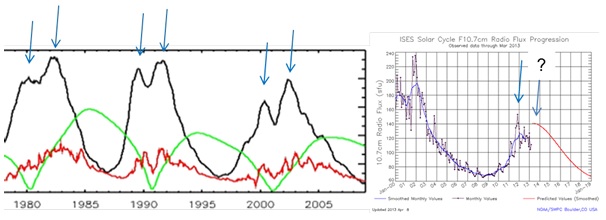

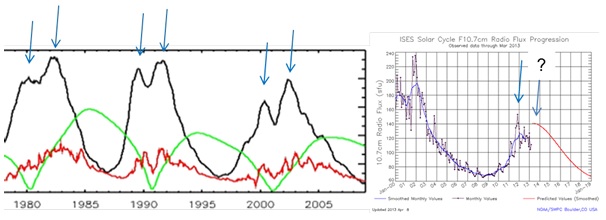

Wie sich die Temperaturen in Deutschland kurzfristig entwickeln werden, wie also die Temperaturen der nächsten Monate oder des Sommers werden, hängt somit stark von der solaren Aktivität und der Sonnenscheindauer ab. Gegenwärtig steigt die solaren Aktivität wieder, was an der vermehrten Sonnenfleckenaktivität sichtbar ist. Inwieweit sich daraus in diesem Jahr ein 2. Aktivitätsmaximum im 11-jährigen Schwabe-Zyklus entwickelt, werden die nächsten Monate zeigen. Warum Aktivitätszyklen dort ein 2. Maximum ausbilden können, hat Leistenschneider in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ beschrieben – wegen der Fließrichtungen des elektr. und magn. leitfähigen Sonnenplasmas im 200.000 km starken Sonnenmantel.

Abbildung 38 zeigt links die Sonnenzyklen 21 – 23 (Quelle: Max Planck Gesellschaft). Jeder Zyklus bildet teils deutlich ein 2. Maximum aus. Rechts daneben ist der aktuelle 24. Zyklus bis März 2013 zu sehen. Ein Erstes Maximum fand in der zweiten Hälfte 2011 statt. Inwieweit sich in 2013 ein zweites Maximum ausbildet, was dann Einfluss auf unser Wetter hat, werden die nächsten Monate zeigen. Anhand der Auswertung vergangener solarer Zyklus, liegen beide Maxima ca. 1 ½ Jahre auseinander, so dass ein zweites solares Maximum in 2013 eintreten sollte. Danach geht die Sonne in ihre inaktive Phase, wie bei jedem Schwabezyklus. Solange, bis der nächste, der 25. Sonnenzyklus beginnt. Der jedoch, wegen dem übergeordneten Gleissberg-Zyklus (stellt die Hüllkurve des Schwabezyklus dar und hat im 25. Sonnenzyklus sein Minimum), sehr schwach ausfallen dürfte.

Damit die deutsche Öffentlichkeit die tatsächlichen Gründe für die vergangenen kalten Temperaturen, den nicht enden wollenden Winter und die zu erwartende Temperaturentwicklung in unserem Land, erfährt, werden wir von EIKE diesen Part übernehmen, den eigentlich die deutsche Presse übernehmen sollte: Für Aufklärung zu sorgen. Wie es scheint, ist man dort zuweilen aus eigenem Interesse (Geld) und ideologischer Verblendung (der Mensch und seine Industrie ist an allem Schuld) dazu nicht mehr in der Lage.

Stefan Kämpfe, Weimar

Josef Kowatsch, Hüttlingen

Raimund Leistenschneider – EIKE