Instrumenten-Aufzeichnungen

Die meisten wenn nicht alle Klimamodelle benutzen die Temperaturaufzeichnung aus Zentral-England [Central England Temperature CET], um historische Temperaturen mit Modellergebnissen zu vergleichen (hindcasting). Die CET ist die längste Temperaturaufzeichnung mittels Instrumenten der Welt und reicht zurück bis zum Jahr 1659.

Die Temperaturen im Rahmen von CET wurden an Orten aufgezeichnet, die von Lancashire im Norden über Bristol im Südwesten und London im Südosten von England reichen. Seit 1974 waren die Temperaturwerte angepasst worden, um dem UHI Rechnung zu tragen. Mehr: http://www.metoffice.gov.uk/hadobs/hadcet/ [1]

Als Beispiel einer CET-Meßstation sei hier Ringway in Chesire genannt als eine der nördlich gelegenen Original-Meßstellen. Von dort gibt es Aufzeichnungen der Ringway-Kapelle, die während des Englischen Bürgerkriegs (1642 bis 1651) verwendet worden sind. Im Jahr 1723 war die alte Kapelle durch ein neues Gebäude aus roten Klinkersteinen ersetzt worden. Im Jahr 1894 war sie erneut zerstört und dann als Ringway-Pfarrkirche wieder aufgebaut worden.

Ringway, eine typische ländliche Örtlichkeit, wurde als Ort für einen Flugplatz von Manchester ausgewählt, und die Arbeit begann im Jahr 1935. Das erste Flugzeug landete in Ringway im Jahr 1937 auf einer teilweise fertig gestellten, komplett grasbewachsenen Landebahn. Der erste Hangar wurde ebenfalls im Jahr 1937 fertig gestellt. Bis zum Jahr 1938 waren ein Terminal-Gebäude, ein Kontrollturm und andere Bauwerke eröffnet worden, und die ersten Linienflüge starteten mit 400 Passagieren im ersten Jahr.

Im Jahr 1939 begann der Bau der Luftwaffenbasis Ringway [RAF Ringway] im nordöstlichen Teil des Flugplatzes mit zwei weiteren neuen Hangars an der Südseite und noch zwei weiteren im Nordwesten. Während des Jahres 1941 wurden zwei asphaltierte Rollbahnen (3000 Fuß) [ca. 900 m] gelegt auf einer Achse von 06/24 und 10/28 [?]. Weitere drei riesige Hangars wurden an der Südseite während der Jahre 1942 und 1943 errichtet. Ebenfalls 1943 wurde die Rollbahn 06/24 auf 4200 Fuß [ca. 1300 m] verlängert, und eine weitere, 3300 Fuß [ca. 1006 m] lange Rollbahn wurde gebaut.

Nach dem Krieg, zwischen den Jahren 1946 und 1957 fand Ringway überwiegend wieder eine zivile Verwendung, obwohl die RAF dort weiterhin ein Geschwader stationiert hielt. Während dieser Zeit wuchs der Flugplatz erheblich. Im Jahre 1952 wurde ein 24-Stunden-Betrieb eingeführt mit internationalen und transatlantischen Flügen. Im Jahre 1954 zählte man den millionsten Passagier seit dem Zweiten Weltkrieg. 1962 wurde ein weiteres, 2,7 Millionen Pfund teures Terminal eröffnet, das das erste „Gangway“-System Europas war, und im Jahre 1969 wurde die Rollbahn auf 9006 Fuß [ca. 2700 m] verlängert. Bis zum Jahr 1978 flogen über 100 Fluggesellschaften den Flughafen an, und die Zahl der Beschäftigten wuchs auf über 5000.

Im Jahre 1981 war die Rollbahn nochmals verlängert worden, diesmal auf 10000 Fuß [über 3000 m], um Langstreckenflieger anzulocken, und bis zum Jahr 1987 erreichten die Passagierzahlen 1 Million pro Monat. 1986 wurde ein neues Welt-Frachtterminal eröffnet und 1989 ein neues Inland-Terminal mit extra Parkplätzen. Während der neunziger Jahre wurde Terminal 2 1993 eröffnet, gemeinsam mit einer Bahnstation, die direkte Verbindungen zu vielen Städten im Nordwesten bot. Bis 1995 erreichten die Passagierzahlen 15 Millionen pro Jahr.

Eine neue zweite Rollbahn wurde 2001 fertig gestellt, Erweiterungen der Terminals 1 und 2 2003. 2007 gab es eine wesentliche Renovierung von Terminal 1 und die Einweihung eines neuen Terminals 3. 2008 eröffnete das Concord-Konferenzzentrum.

Parallel zu all diesen Entwicklungen entstanden auch viele Parkplätze, Hotels sowie andere Betriebs- und Nebengebäude.

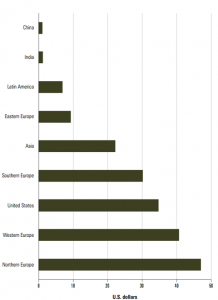

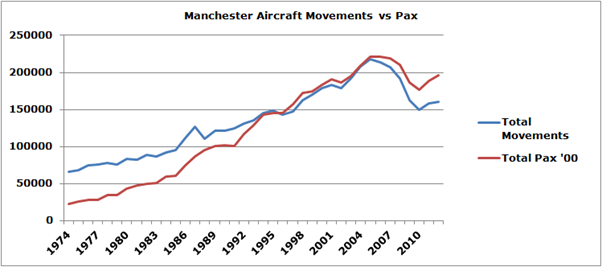

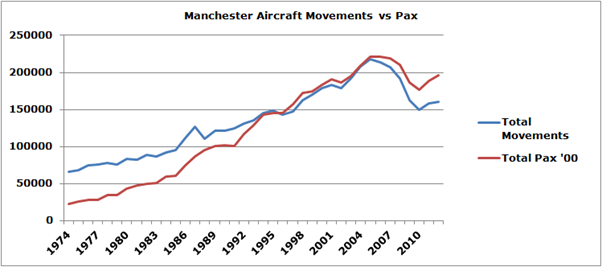

Abbildung 1: Wachstum des Flughafens Manchester bzgl. Flugbewegungen und Passagierzahlen .

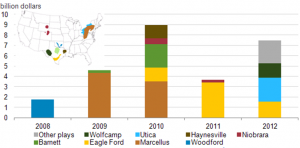

Es gibt eine Reihe von Dingen, die in Abbildung 1 beachtenswert sind: Der Zuwachs der Passagierzahlen war größer als der der Flugbewegungen. Dies bedeutet, dass mehr Menschen mit größeren Flugzeugen geflogen sind oder dass freie Plätze in bestehenden Flugverbindungen besser ausgefüllt werden konnten. Abbildung 2 zeigt, dass die Wachstumsrate auf einer Linie mit dem Wachstum aller anderen Flughäfen in UK liegt.

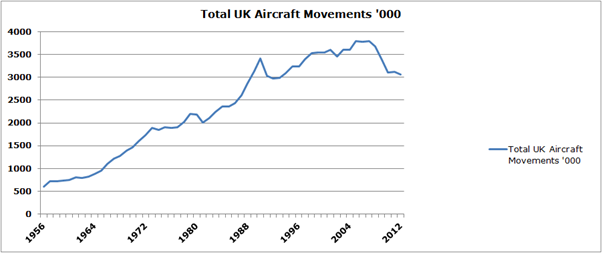

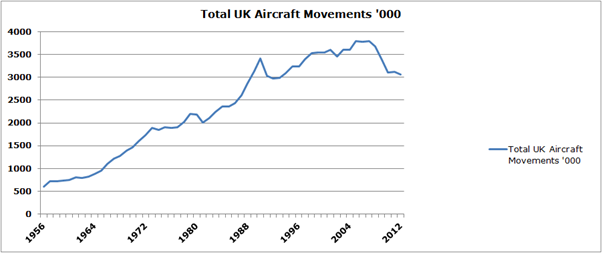

Abbildung 2: Gesamtzahl der Flugbewegungen in UK seit 1956

Interessant ist der Rückgang des Luftverkehrs nach einer Spitze im Jahr 2005, der in beiden Abbildungen hervor tritt.

Aus der Entwicklung des Flughafens Manchester wird offensichtlich, dass sich die Infrastruktur erheblich ausgeweitet hat, und zwar praktisch von einem Acker mit einer kleinen Landebahn in den dreißiger Jahren zu einem wichtigen internationalen Flughafen heute. Dies macht den Flughafen Manchester zu einem guten Beispiel für den UHI-Effekt. Allerdings gibt es keine vergleichbare ländliche Örtlichkeit in der Umgebung, um den Unterschied zu messen.

In einer Studie in dem Magazin Weather im Dezember 2009 verglich Dr. Philip D. Jones [2] verschiedene Orte in und um London, um den UHI-Effekt zu bestimmen. In der Studie wurden zwei Stellen im Zentrum von London (St. James Park und London Weather Centre) mit ländlicheren Gegenden verglichen (Rothampstead und Wisley). Vergleiche gab es auch zwischen den Orten Kew und Heathrow; die Stellen Gatwick und Stansted wurden aber ausgeschlossen. Das Argument für den Ausschluss dieser beiden basierte auf dem Umstand, dass sie nicht vom Met. Office, sondern seit 1990 von der Civil Aviation Authority CAA betrieben worden waren und „nur sporadisch Eingang in die Datenbasis des Met. Office“ gefunden hatten. Dass alle CAA-Beobachter vom Met. Office angelernt worden waren und die Daten von beiden Stellen vollständig verfügbar waren, spielte keine Rolle. Ich selbst habe die Daten von Gatwick seit 15 Jahren gesammelt.

In seinen Schlussfolgerungen stellt er fest: „Die UHIs haben zugenommen, und zu einer mit der Verstädterung verbundenen Erwärmung kam es in Heathrow und Kew am Stadtrand von London. In Heathrow ist die mittlere Temperatur um 0,4°C gestiegen, und zwar zwischen dem Beginn der Aufzeichnungen im Jahr 1949 und 1980. Seit 1981 gab es keine weitere Zunahme des UHI. Es wird erwartet, dass sich die UHIs an anderen Orten am Rand von Zentral-London (wie Heathrow und Kew) während des 20. Jahrhunderts ähnlich verhalten haben. Orte innerhalb Zentral-Londons würden keinen mit der Verstädterung verbundenen Erwärmungstrend zeigen (d. h. konstante UHIs) im Vergleich mit ländlichen Orten rund um London“.

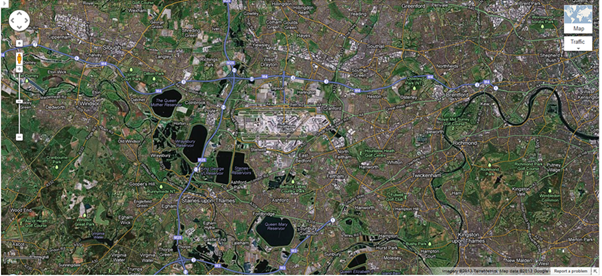

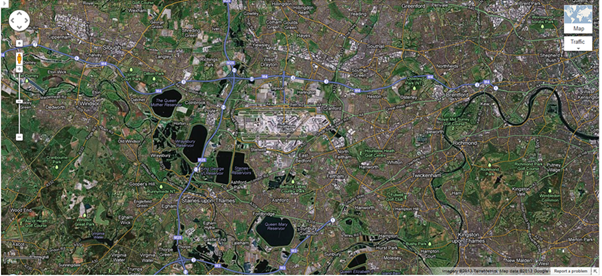

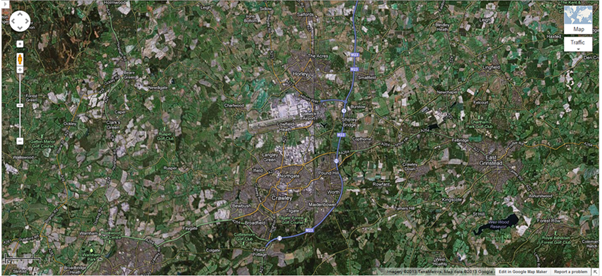

Abbildung 3: Wetterstation des Met. Office bei Heathrow (courtesy Google Maps)

Nicht nur, dass die Station des Met. Office bei Heathrow (seit 1949 nicht mehr verlagert) im Norden, Osten und Westen sehr nahe stark befahrener Autobahnen liegt (Northern Perimeter Rd W), sich im Süden geteerte und betonierte Rollbahnen befinden und 500 m entfernt von wichtigen Terminals (T1, T2,T3), sondern auch, dass sich eine der am stärksten frequentierten Rollbahnen (27R/09L) 200 m entfernt befindet. Jüngsten Aufzeichnungen zufolge (2011) benutzen 652 Flugzeuge jeden Tag diese Rollbahn. Die Station befindet sich sehr nahe der Stelle, an der die Flugzeuge ihre Triebwerke zum Start auf maximale Stärke hochfahren oder den Umkehrschub zum Landen einschalten. In beiden Fällen wird sehr viel Wärmeenergie freigesetzt.

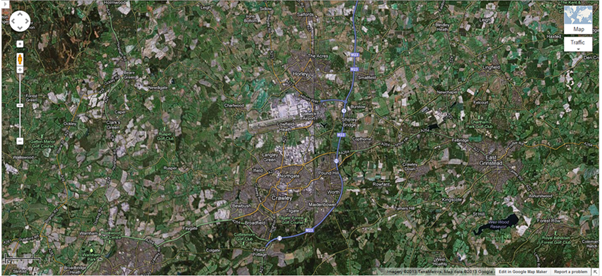

Abbildung 4: Luftaufnahme von Heathrow (courtesy Google Maps)

Abbildung 5: Luftaufnahme von Gatwick (courtesy Google Maps)

Vergleicht man die Luftaufnahmen von Heathrow (Abb. 4) mit Gatwick (Abb. 5), wird sofort augenfällig, dass Heathrow viel städtischer ist als Gatwick. Der ländliche Charakter des Letzteren kommt schon durch die Menge der Vegetation (grün) in der Umgebung heraus. Beide Flughäfen liegen auf NN, so dass keine Temperaturanpassung infolge eines Höhenunterschieds erforderlich ist.

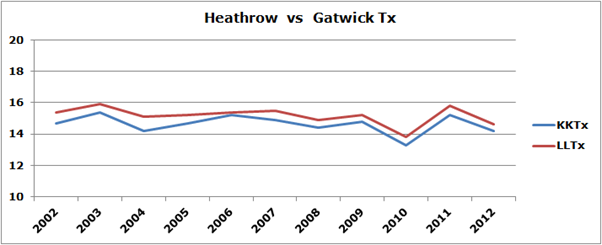

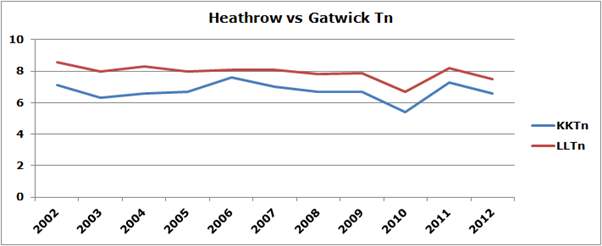

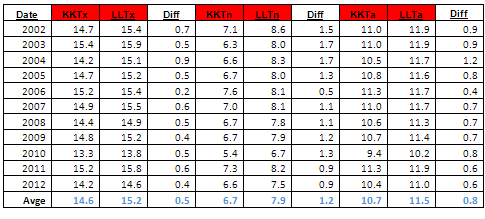

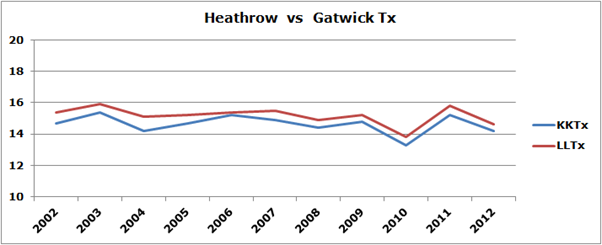

Abbildung 6: Vergleich der Maximum-Temperatur zwischen Heathrow und Gatwick in °C.

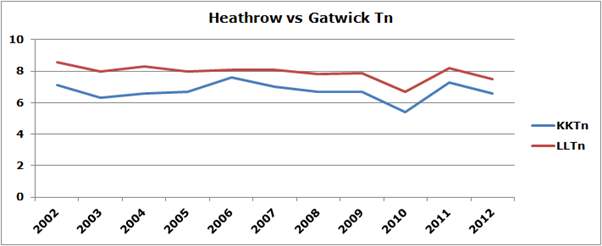

Abbildung 7: Vergleich der Minimum-Temperatur zwischen Heathrow und Gatwick in °C.

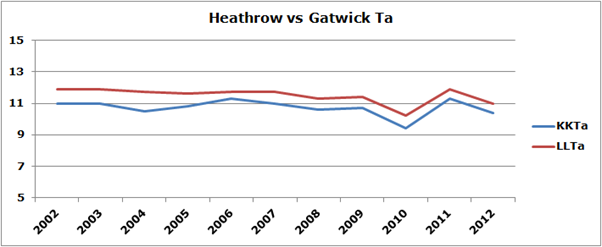

Abbildung 8: Vergleich der Mitteltemperatur zwischen Heathrow und Gatwick in °C.

Während der letzten 11 Jahre war es in Gatwick anhaltend kühler als in Heathrow, wie die Abbildungen 6 bis 8 zeigen.

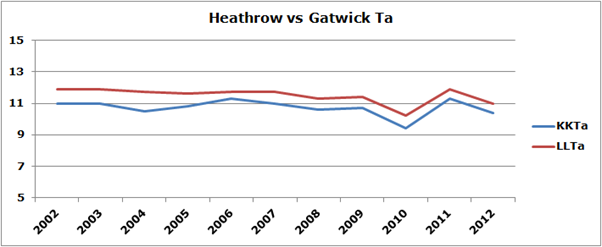

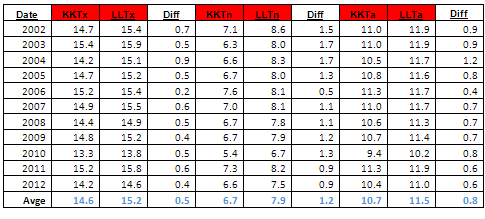

Tabelle 1: Temperaturdifferenz zwischen Heathrow und Gatwick

In diesen Beispielen ebenso wie in Tabelle 1 wird natürlich eine mehr städtische Stelle in Heathrow mit einer weniger städtischen Stelle in Gatwick verglichen. Aber Gatwick hat sich wie die meisten Flughäfen mit der Zeit in seiner Infrastruktur ausgeweitet und hat jetzt sein eigenes UHI-Niveau. Die UHI-Differenz zwischen Heathrow und Gatwick beträgt 0,8°C. Unter der Annahme, dass Gatwick im Vergleich zu einer gänzlich ländlichen Stelle ebenfalls einen UHI von 0,8°C aufweist, beträgt der potentielle UHI in Heathrow 1,6°C und nicht 0,4°C (mittlerer Wert), wie er in der Schlussfolgerung der Studie von Philip Jones angeführt wird.

Anekdotisch: wenn man mit dem Auto durch große Städte fährt, steigt die Temperatur am Autothermometer unvermeidlich um mindestens 2°C im Vergleich zu ländlichen Gebieten. Und selbst in den Wettervorhersagen in der BBC heißt es in bestimmten Situationen, dass es auf dem Lande „ein paar Grad kühler“ ist.

Eine wirklich ländliche Stelle gibt es natürlich nicht, weil selbst an ländlichen Stellen in der Umgebung der Messeinrichtungen die Vegetation wächst (Bäume, Büsche usw.), was das Temperaturprofil an dieser Stelle beeinflusst.

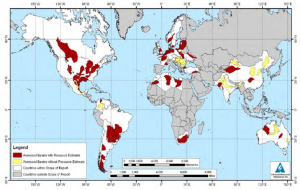

Viele der Stationen, an denen auf dem Festland die Temperatur gemessen wird, liegen an Flughäfen, hauptsächlich aus historischen Gründen, weil meteorologische Messungen für die Luftfahrtindustrie wichtig waren und sind. Hat man an diesen Stellen Anpassungen bzgl. des UHI vorgenommen?

Die Schlussfolgerung dieser Untersuchung zeigt, dass UHI-Anpassungen für Instrumenten-Messungen, die für Temperatur-Rekonstruktionen verwendet werden, nicht robust genug sind, um die erforderliche hohe Genauigkeit aufzuweisen.

Verwendung von Photosynthese betreibende Organismen als Temperaturproxies

Für die Photosynthese benötigen alle Bäume und andere lebende Organismen (Alkenone/Phytoplankton) spezielle Mengen Luft (Gase), Wärme, Licht (Photonen) und Wasser. Mit anderen Worten, ohne Luft (Gase), ohne Wärme, ohne Licht und ohne Wasser kann der Baum jeweils keinen Baumring ausbilden. Es ist eine Kombination von Wetterelementen, die das Wachstum des Baumes und die Bildung von Baumringen stützt.

Aber um einen Baumring zu bilden braucht der Baum auch einen biologischen Mechanismus, der die Aufnahme bestimmter Nährstoffe kontrolliert, die für das Wachstum notwendig sind. Nun ändert sich jedoch die Zufuhr von Luft, Wärme, Licht und Wasser fortwährend. Daher muss dieser biologische Mechanismus in der Lage sein, mit unterschiedlichen Niveaus von Sauerstoff/CO2, Wärme/Kälte, Licht/Dunkelheit und nass/trocken umzugehen. Als solcher reagiert dieser biologische Mechanismus auf das Wetter. Dieser mit dem Wetter umgehende Mechanismus ist auch ein genetischer An- und Ausschalt-Mechanismus, ein homöostatischer Regulator und eine biologische Uhr.

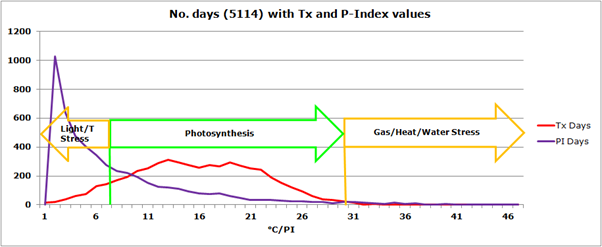

In diesem Teil dieser Untersuchung wird eine spezifische Kombination von Wetterelementen (Luft, Wärme, Licht und Wasser), die im Folgenden als Photosynthese-Index (P-Index) bezeichnet wird, mit der Temperatur allein verglichen. Der P-Index hat eine Bandbreite von 0 bis 100. Die Photosynthese wird ab einem Wert von 6,9 ausgelöst, ist jedoch variabel, da jede Spezies sein eigenes Toleranzniveau zu diesem Input entwickelt hat (Luft, Wärme, Licht oder Wasser).

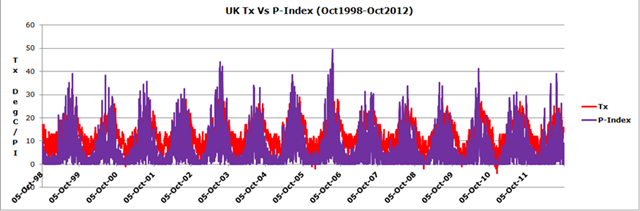

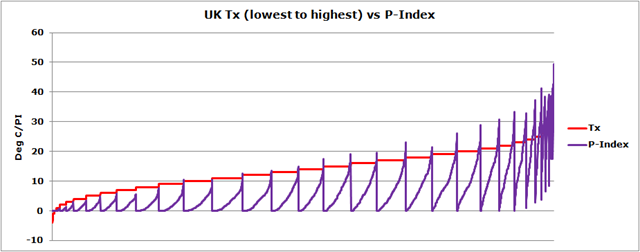

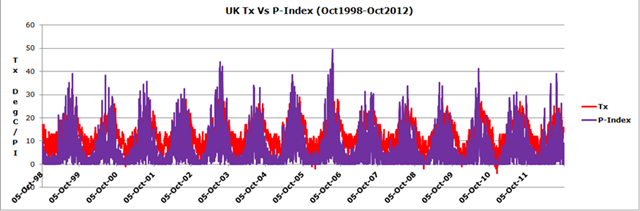

Abbildung 9: 14-jähriger Vergleich zwischen der täglichen Höchsttemperatur (Tx) und dem P-Index an einer Stelle in UK.

Der Vergleich zwischen den Höchstwerten der Temperatur und dem Photosynthese-Index (Abbildung 9) ergibt eine Korrelation von +0,69. Vergleicht man jedoch den P-Index mit den niedrigsten bzw. höchsten Werten der Maximum-Temperatur, ergibt sich ein anderes Bild, wie Abbildung 10 zeigt:

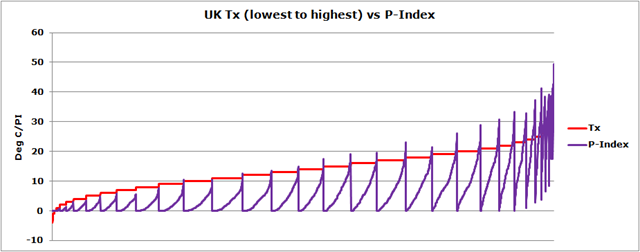

Abbildung 10: Höchste bzw. niedrigste Werte der Maximum-Temperatur im Vergleich zum P-Index.

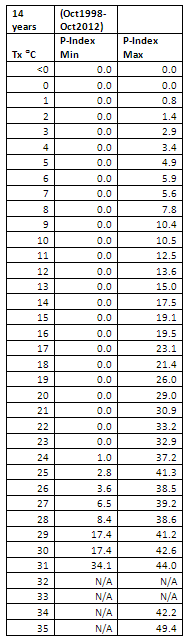

Abbildung 10 zeigt, dass alle Temperaturen bis zu 23°C einen P-Indexwert von 0 annehmen können. Bei einem PI von 0 gibt es keine Photosynthese. Hinsichtlich des Photosynthese auslösenden Wertes von 6,9 zeigt sich eine klarere Erklärung in Tabelle 2.

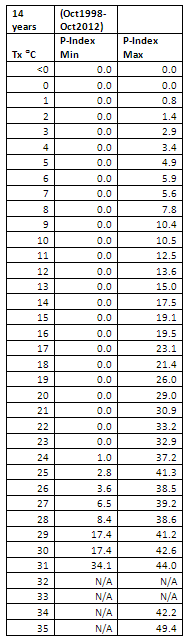

Tabelle 2: Vergleich zwischen Tx und P-Index min/max.

Aus den 14-jährigen täglich erfolgten Aufzeichnungen des Vergleichs zwischen Tx und P-Index (min und max) ergibt sich ein Indexwert von 6,9 für die volle Photosynthese. Die meisten Bäume werden keine Baumringe ausbilden, bis die Temperatur etwa 7,5°C beträgt. Der wichtigste Punkt: Photosynthese findet in der Bandbreite von 7,5°C bis 27°C statt.

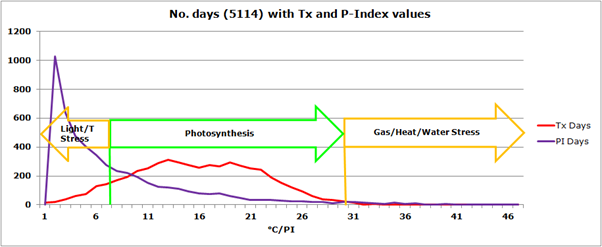

Abbildung 11: Anzahl der Tage mit Photosynthese

Aus der Analyse der 5114 Tage an einer Stelle in UK gibt es an 4125 Tagen Höchstwerte, die Photosynthese zulassen würden, aber nur 1600 PI-Tage, wenn die volle Photosynthese wirklich stattfindet. Mit anderen Worten, es gibt 2525 von 5114 Tage (49,9%), an denen das Wachstum von Baumringen kein gutes Proxy für Temperatur-Rekonstruktionen ist.

Diese Untersuchung wirft Zweifel auf die Verwendung von Baumring-Proxies als zulässige Temperatur-Rekonstruktionen.

(Letzte Meldung: Die jüngste Studie von Marcott et al. mit der Verwendung von Alkenone-Daten (erzeugt durch Phytoplankton) erweckt wahrscheinlich die gleichen Zweifel (unabhängig von der schlecht durchgeführten statistischen Analyse) wie andere lebende Organismen wie Baumringe!!!)

Proxies aus Eisbohrkernen:

Nicht genug Hintergrundwissen für eine Besprechung!

CO2

Eine sehr einfache Analyse des Vergleichs zwischen Temperatur und CO2 zeigt nur eine geringe Korrelation (mehr Daten wären erforderlich, um eine gesicherte Studie durchzuführen).

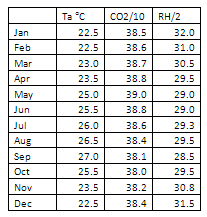

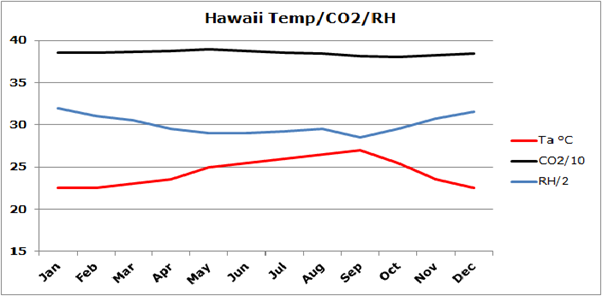

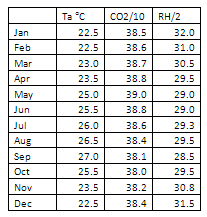

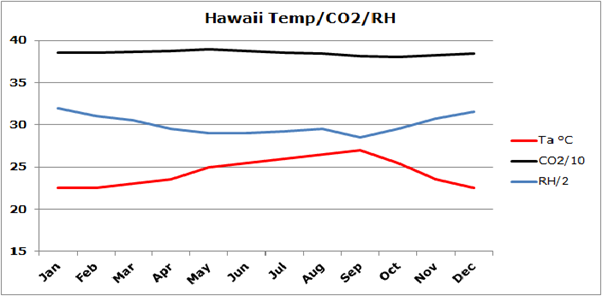

Tabelle 3: Mitteltemperatur (Ta), CO2 und Relative Feuchtigkeit (RH) in Hawaii

Abbildung 12: Vergleich zwischen Mitteltemperatur (Ta), CO2 und Relativer Feuchtigkeit (RH) in Hawaii

Die Korrelationen zeigen -0,23 zwischen Ta und CO2 sowie -0,08 zwischen RH und CO2. Beide Werte sind statistisch nicht gesichert.

Das gegenwärtige CO2-Niveau beträgt 390 ppm in der Atmosphäre (0,039%), was auch Wasserdampf und andere Treibhausgase einschließt. Der natürliche Kohlenstoff-Kreislauf erzeugt 2960000 metrische Tonnen CO2 [3]. Der Beitrag der Menschheit wird mit 33500 metrischen Tonnen angenommen[4], was 1,13% ausmacht. Der UK-Beitrag bleäuft sich auf 458 metrische Tonnen CO2 [3] oder 0,0155%. Daher ergibt sich die Gesamtmenge aller Treibhausgase zu 2960*0.039%*100=758974358974 metrischen Tonnen.

[*Die Einheit in diesem Absatz lautet „{Zahl}m tonnes“. Ich habe das mit metrischen Tonnen angenommen, weil in diesem ganzen Aufsatz ausschließlich britische Maßeinheiten verwendet werden. Sollten „Millionen Tonnen“ gemeint sein, bitte ich das im Geiste zu korrigieren. A. d. Übers.]

Der prozentuale UK-Anteil der globalen atmosphärischen [Treibhaus?]Gase beträgt: 0,0000000604%.

Diskussion:

Es scheint, dass historische Daten, Temperatur-Proxies, die in der Analyse der Klimaänderung verwendet werden, nicht robust genug sind, um eine genaue Temperatur-Rekonstruktion zu ermöglichen. Ich zeige, dass die UHI-Anpassungen zu gering sind und dass Baumring-Proxies keine genauen Temperatur-Rekonstruktionen ergeben können.

Was die Beziehung und die Hypothese von Klimawissenschaftlern zwischen Temperatur und CO2 betrifft, zeigt sich einfach keine signifikante Korrelation. Hat irgendjemand eine in die Tiefe gehende Studie unter Verwendung signifikanter Daten durchgeführt, in der Temperatur und CO2 miteinander verglichen werden? Oh, es gibt die historischen Temperaturaufzeichnungen aus Hawaii; alle 13 Meßstationen liegen an Flughäfen. Man wähle sich eine aus und sie wird den UHI-Effekt aufweisen. Man beziehe Bevölkerungswachstum und daraus folgende Infrastruktur-Ausweitungen ein – oh, noch mehr UHI. Aber was würden wir vergleichen, CO2-Niveau mit realer Temperatur oder CO2-Niveau mit dem UHI-Effekt? Auf der einen Seite der Mauer zeigen die „realen Temperaturen“ nur sehr geringe Korrelationen. Auf der anderen Seite der Mauer ANTHROPOGENE GLOBALE ERWÄRMUNG.

Noch eine Bemerkung zum Schluss: Das vom IPCC eingeräumte Fehlen von Wissen der Strahlungs-Rückkopplung von Wolken und Wasserdampf ist interessant. Man betrachte irgendein globales Satellitenbild im Infrarot-Bereich, im sichtbaren Bereich oder im Wasserdampf-Bereich (Abbildung 13*). Dann erkennt man die Bedeutung dieser zwei Faktoren für die Klimaforschung. Und doch zeigt das Wissen des IPCC in ihrer Graphik aus dem 3. Zustandsbericht, dass deren Kenntnisse sehr gering sind. Der P-Index (Luft {Gase}, Wärme, Licht und Wasser) zeigt eine Korrelation von 0,69 im Vergleich zur Maximum-Temperatur (14 Jahre lang tägliche Daten), die statistisch signifikant ist. Aber man erinnere sich an die Auswirkung auf die Photosynthese und das Wachstum von Baumringen und in dieser Hinsicht an alle Photosynthese durchführende Organismen.

[*Abbildung 13 im Anschluss an die References fehlt im Original!]

Vielleicht ist der P-Index ein sinnvollerer Indikator von Strahlungs-Rückkopplung und der Auswirkung auf die Temperatur, da er wie Photosynthese wirkt.

Schlussfolgerung: Das gegenwärtige Wissen über das Klima ist nicht ausreichend für politische Entscheidungen, die auf diesem Wissen basieren. Politische Entscheidungen hinsichtlich des Climate Change Act und der Energiepolitik basieren auf zweifelhafter Wissenschaft, gleichbedeutend mit Homöopathie.

References:

1. http://www.metoffice.gov.uk/hadobs/hadcet/

2. Jones P. D., Lister D. H. The urban heat island in Central London and urban-related warming trends in Central London since 1900, Weather, December 2009, Vol. 64, No.12

3. http://www.esrl.noaa.gov/gmd/infodata/faq_cat-3.html#9

4. G.P. Peters et al. Global carbon budget 2010 (summary), Tyndall Centre for Climate Change Research

5. https://www.gov.uk/government/publications/final-uk-emissions-estimates

Mid-IR/Water Vapour 18Mar2013 1200 Vis Green/Red 18Mar2013 1200 IR 18March2013 1200

Abbildung 13: Satellitenbilder in drei Spektralbereichen – fehlen im Original!

Link: http://wattsupwiththat.com/2013/04/16/revisiting-temperature-reconstructions-used-in-climate-change-modeling/

Übersetzt von Chris Frey EIKE

Bemerkung des Übersetzers: Der gesamte erste Teil dieser Arbeit ist eine eindrucksvolle Bestätigung der vor einiger Zeit hier bei EIKE veröffentlichten Ergebnisse von Leistenschneider et al. Für mich ein weiteres Indiz dafür, dass die letzte globale Erwärmung eben nicht global, sondern überwiegend an den ausgewählten Messpunkten aufgetreten ist – und hier tatsächlich anthropogenen Ursprungs ist.

Welchen prozentualen Anteil haben diese Messpunkte an der gesamten Erdoberfläche?

C. F.

Original der Studie hier

Original der Studie hier