Kurvenreiche Strecke: Im ständigen Auf und Ab des Klimas ist nun wieder die Kälte „dran“, und für Warmisten wird nicht nur die Straße schmaler, sondern auch die Luft immer dünner. Foto: Stefan Kämpfe.

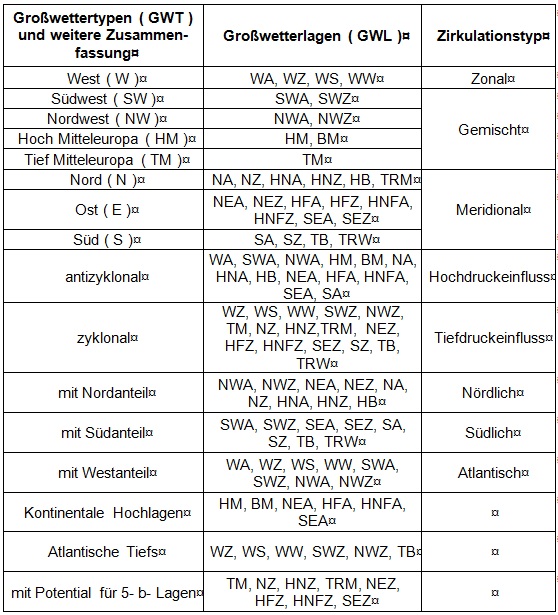

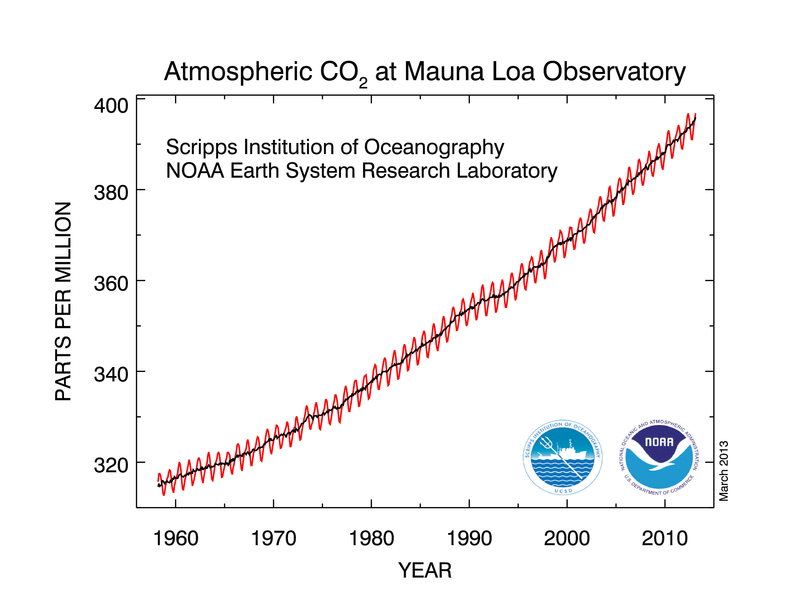

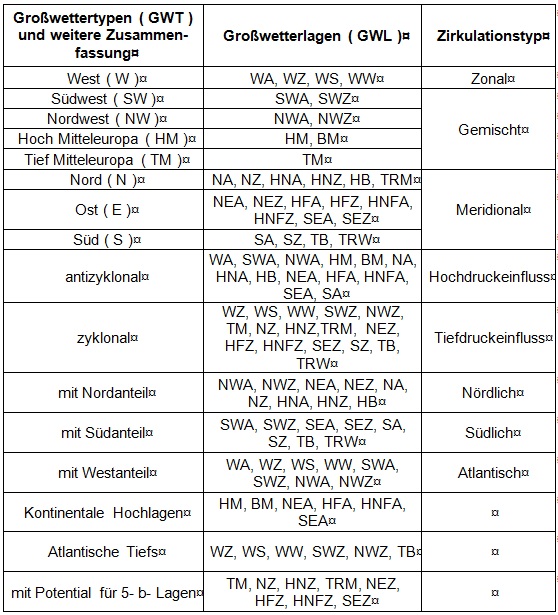

Ohne Untersuchung der Großwetterlagen und der Sonnenaktivität kann eine umfassende Erklärung des Temperaturverhaltens während der vergangenen gut 3 Jahrzehnte nicht gelingen. Zwar behauptet die einseitig auf „Treibhausgase“ fixierte Klimawissenschaft noch immer, dass der Einfluss der Sonne auf unser Klima gering sei. Aber in den vergangenen 15 Jahren hat die Zahl der Studien, Veröffentlichungen und kritischen Beiträge, welche das genaue Gegenteil beweisen, enorm zugenommen. Spätestens mit der Veröffentlichung des Buches „Die kalte Sonne- warum die Klimakatastrophe nicht stattfindet“ von VAHRENHOLT/LÜNING (2012) erreichte die Diskussion über die tatsächlichen Ursachen des Klimawandels nun auch die breite Öffentlichkeit. Wir können im Rahmen dieser Arbeit nicht alle bekannten meteorologischen, klimatologischen, solar- und astrophysikalischen Zusammenhänge untersuchen und aufzeigen. Zunächst einmal wollen wir uns die Häufigkeitsentwicklung der Großwetterlagen seit 1980 ausführlich ansehen. Nach HESS/BREZOWSKY (1952, 1969, 1977) werden 29 Großwetterlagen (GWL) für Mitteleuropa unterschieden, hinzu kommen einzelne, nicht diesen 29 Lagen zuordenbare Fälle, welche dann als sogenannte „Übergangslagen“ bezeichnet und im Rahmen dieser Untersuchung nicht weiter berücksichtigt wurden, da sie nur an 0 bis höchstens 3 Tagen je Monat auftreten. Bei der Ermittlung der Großwetterlagen, welche auch vom Deutschen Wetterdienst (DWD) monats- und jahresweise veröffentlicht werden, gilt die Regel, dass eine einzelne Wetterlage mindestens 3 Tage hintereinander andauern muss, um eindeutig als solche klassifiziert zu werden (monats- und jahreswechselübergreifendes Ermitteln ist selbstverständlich möglich). Jede GWL ist durch 2, 3 oder höchstens 4 Großbuchstaben eindeutig bestimmt. Es ergeben sich dadurch zunächst sieben GWL, die sich durch gerichtete Strömung über Mitteleuropa auszeichnen (Strömung „kommt“ aus N, NE, SE, S, SW, W oder NW). Die fehlende Richtung E (Ost) „verbirgt“ sich hinter der Lagebezeichnung des dabei für Mitteleuropa wetterbestimmenden Hochs über (Fenno)- Skandi(navi)en (HF) oder über dem Nordmeer und (Fenno)- Skandi(navi)en (HNF). Es handelt sich dabei also um Lagen, bei der die geografische Lage des für Mitteleuropa bestimmenden Druckgebiets (hier: Ein Hoch über Skandinavien im weitesten Sinne) namensgebend war, ähnlich ist es beim Hoch, der Hochdruckbrücke, beim Tief und beim Trog über Mitteleuropa (HM, BM, TM, TRM), beim Hoch über dem Nordmeer (HN), dem Trog über Westeuropa (TRW) und dem Hoch oder dem Tief über den Britischen Inseln (HB, TB). Den kursiv gekennzeichneten Lagen wird außerdem jeweils der Großbuchstabe A für antizyklonal nachgestellt, wenn sie sich über Mitteleuropa durch Hochdruckeinfluss auszeichneten, oder Z (zyklonal) bei über Mitteleuropa vorherrschendem Tiefdruckeinfluss. Da die Lagen HM, BM und HB über Mitteleuropa immer vorwiegend antizyklonal, das TM, TB, der TRW, TRM sowie die beiden Sonderfälle der Westlagen, Südliche Westlage (WS) und Winkelförmige Westlage (WW), stets zyklonal sind, erübrigt sich für diese ein weiterer Buchstabe. Es bedeutet also beispielsweise WZ „Zyklonale Westlage“ oder HNFZ „Hoch über dem Nordmeer und (Fenno)- Skandi(navi)en, in Mitteleuropa mit Tiefdruckeinfluss (zyklonal)“. Für Statistiken werden ähnliche Großwetterlagen zu Großwettertypen zusammengefasst; für spezielle Fragestellungen ist außerdem noch eine weitergehende Zusammenfassung möglich; siehe folgende Tabelle:

Entscheidend ist nun, ob sich, parallel zum beobachteten Temperaturverlauf seit 1980, auch die Häufigkeit bestimmter GWL und GWT geändert hat. Leider ist es fast unmöglich, vielen Großwetterlagen eine eindeutige Erwärmungs- oder Abkühlungswirkung zuzuordnen, da erstens eine Gewichtung nach der sehr unterschiedlichen Häufigkeit der einzelnen GWL vorgenommen werden müsste, und zweitens gibt es enorme jahreszeitliche Unterschiede. So kann eine antizyklonale Südlage (SA) im Winter strenge Kälte bringen (Mitte Januar 1982), im Sommer hingegen große Hitze (Anfang August 1994), denn die für die Lufttemperaturen letztendlich entscheidenden Luftmassen sind besonders bei den von Hochdruckgebieten dominierten Wetterlagen jahreszeitbedingt extrem unterschiedlich; und selbst innerhalb einer Jahreszeit können bei ein und derselben Wetterlage sehr unterschiedliche Luftmassen auftreten. Eine Ermittlung der Luftmassenhäufigkeit war wegen des enormen Aufwands im Rahmen dieser Arbeit nicht möglich und bleibt späteren Studien vorbehalten. Anhand klimatischer Erfahrungswerte lassen sich jedoch folgende Regeln für die Jahresmitteltemperaturen aufstellen:

- Westlagen (besonders WA und WZ) „tragen“ das insgesamt etwas mildere Klima Westeuropas nach Deutschland (Jahresmittel von Plymouth 10,8°C, Deutschland auf demselben 50. Breitengrad, selbe Höhenlage 9,5 bis 10,5°C), so dass Westlagen im Jahresmittel geringfügig erwärmend wirken.

- Südwestlagen wirken in allen Jahreszeiten erwärmend, besonders im Herbst und Winter.

- Ostlagen wirken- trotz ihrer Wärme im Sommer- insgesamt kühlend (Jahresmittel von Kiew auf dem 50. Breitengrad nur 7,4°C, mit Höhenkorrektur etwa 8,4°C).

- Nordlagen wirken überwiegend kühlend, Südlagen überwiegend wärmend.

- Die wärmsten Jahre sind solche mit einem hohen West- und Südwestanteil zwischen November und März und einem hohen Anteil von Hochdruck-, Süd- und Südwestwetterlagen zwischen April und Oktober.

- Zentralhochlagen (HM, BM) sind zwar im Winter (Dez.- Feb.) meist etwas zu kalt, mitunter temperaturnormal oder selten zu mild, besonders zwischen April und Mitte Oktober aber meist deutlich zu warm. Generell tendieren antizyklonale Wetterlagen im Winter zu unter- und im Sommer zu übernormalen Temperaturen.

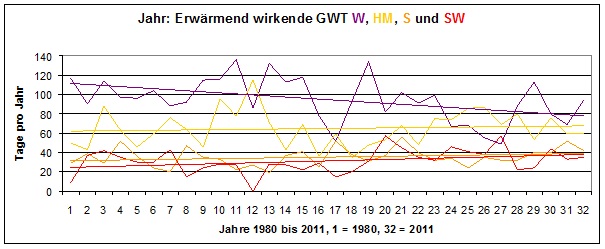

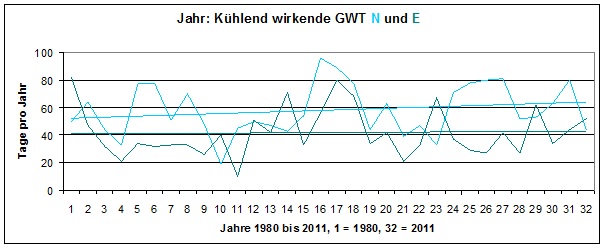

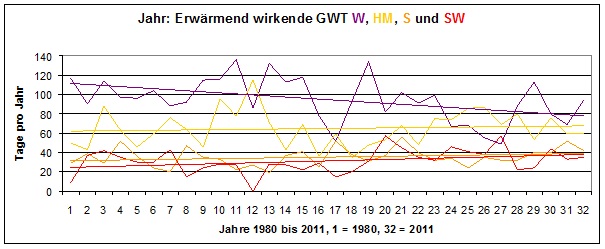

Zunächst lohnt also einmal ein Vergleich, wie sich wärmende und kühlende Großwettertypen (GWT) im Jahresverlauf seit 1980 entwickelt haben:

Abb. 1: Eine augenscheinliche, wesentliche Änderung der Häufigkeiten wichtiger Großwettertypen ist nur bei den Westlagen erkennbar- diese nahmen deutlich ab, weil auch der NAO- Index seit Beginn der1980er Jahre einen fallenden Trend aufweist.

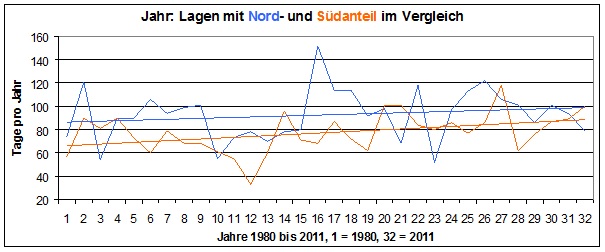

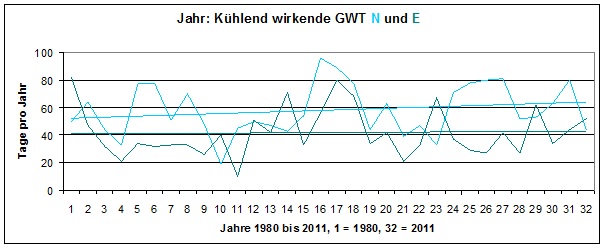

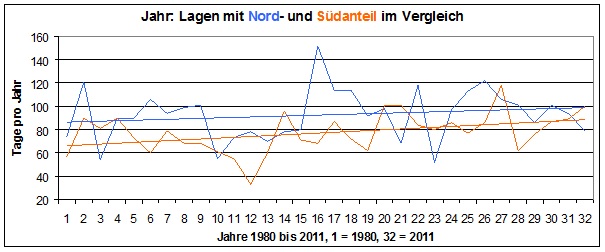

Die folgende Abbildung zeigt, dass Lagen mit südlichem Strömungsanteil etwas stärker zunahmen, als solche mit Nordanteil:

Abb. 2: Zwar nahmen Lagen mit Südanteil etwas stärker zu, als die mit Nordanteil. Aber auch daraus lässt sich nur ein geringer Teil der insgesamt beobachteten Temperaturänderung seit 1980 erklären, vor allem erklärt dies nicht die mit dem Jahr 2001 beginnende leichte Abkühlung.

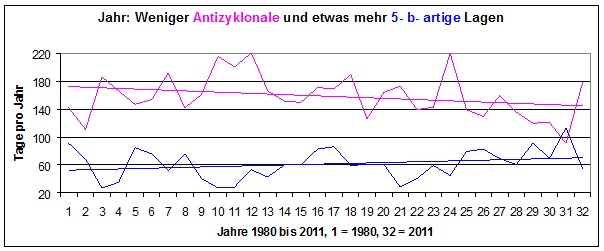

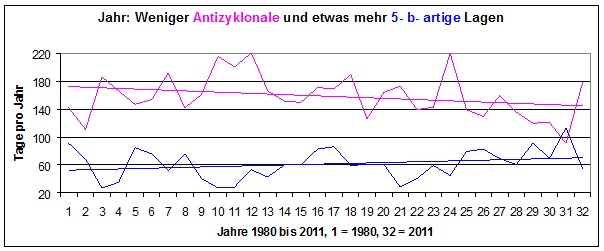

Weiterhin zeigt sich, dass antizyklonale (hochdruckbeeinflusste) Wetterlagen deutlich abnahmen, während 5- b- artige Lagen (das sind zyklonale Lagen mit nördlicher bis östlicher Anströmung in den unteren Luftschichten, bei denen es aber in höheren Luftschichten oft zu einem mehr oder weniger intensiven Aufgleiten feuchter Mittelmeerluft kommt, was mitunter starke Niederschläge besonders in Süd- und Ostdeutschland auslöst; diese Lagen sind außerdem fast durchweg zu kalt und sehr sonnenscheinarm) etwas zunahmen:

Abb. 3: Hochdruckwetterlagen nahmen deutlich ab, 5- b- artige etwas zu.

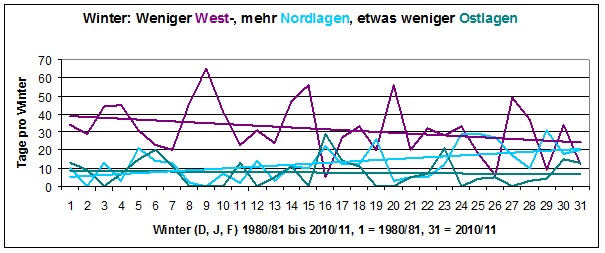

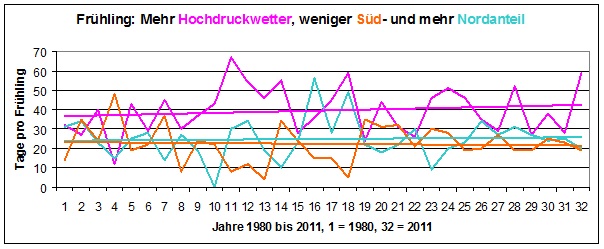

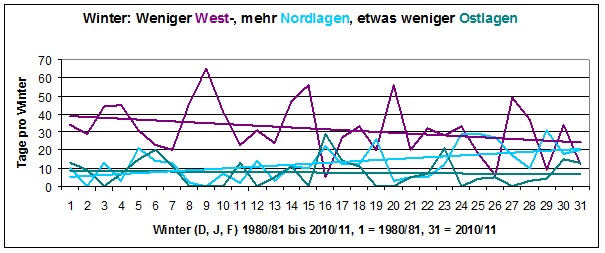

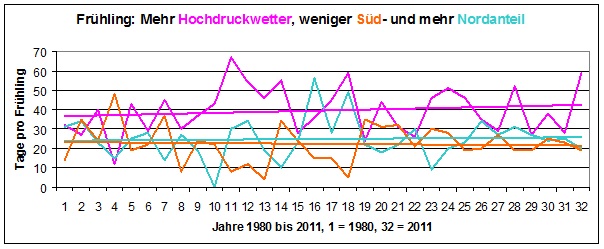

Insgesamt bestätigen diese Untersuchungen unsere für den Temperaturverlauf von Erfurt (2012) getroffenen Aussagen, dass Änderungen in den Zirkulationsverhältnissen, speziell bei den Großwetterlagen, nur relativ geringe Teile der beobachteten Temperaturänderungen erklären können und statt dessen WI- Effekte, höhere Sonnenscheindauer und die Sonnenaktivität dominant sind (dass es aber auch einen bemerkenswerten Einfluss der Sonnenaktivität auf die Häufigkeit der Großwetterlagen gibt, werden wir gleich noch sehen). Am ehesten lassen sich noch die tendenziell schon länger anhaltende Abkühlung im Winter und die Erwärmung im Frühling mit geänderten Zirkulationsverhältnissen erklären:

Abb. 4: Kältere Winter auch durch weniger West- und mehr Nordwetter, wärmere Frühjahre auch durch mehr Hochdruckwetter (antizyklonale Lagen).

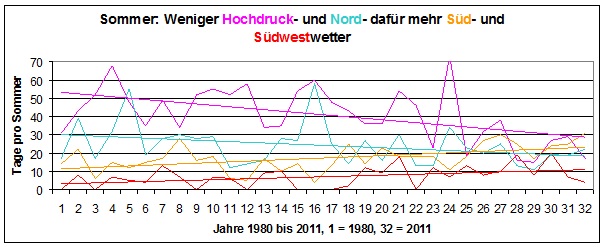

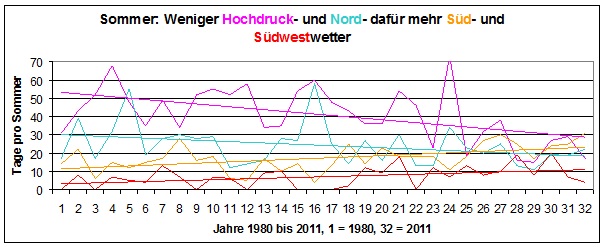

Im Sommer sind die Verhältnisse insgesamt noch schwieriger zu bewerten. Zwar nahm die Häufigkeit von Wetterlagen mit Nordanteil ab und die mit Südanteil, darunter besonders Südwest, deutlich zu, aber dafür wurden die im Sommer besonders warmen antizyklonalen Lagen seltener:

Abb. 5: Im Sommer nahmen die besonders stark erwärmend wirkenden antizyklonalen Wetterlagen („Hochdruckwetter“) sehr deutlich ab.

Insgesamt sei noch angemerkt, dass im Herbst Westwetterlagen deutlich ab- und Wetterlagen mit Süd- und Nordanteil etwas zugenommen haben.

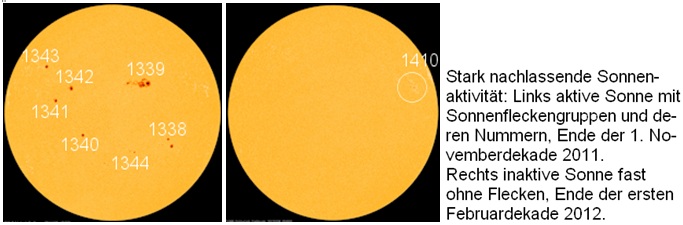

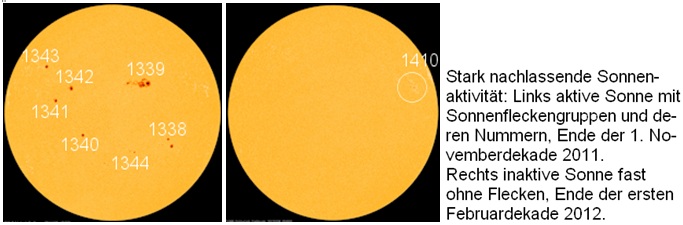

Nun stellt sich natürlich die Frage, was die schwankende Häufigkeitsverteilung der Großwetterlagen beeinflussen könnte. Beim Blick in historische Wetterkarten fallen die strengen Februarmonate 1956, 1986 und 2012 mit ihrer Häufung nördlicher bis östlicher Wetterlagen auf. Vor jedem dieser kalten Februare gab es im November eine relativ hohe Sonnenaktivität, die im Dezember und Januar deutlich abnahm. F. BAUR (1956) schrieb dazu sinngemäß „… dass die Entwicklung des Großwetters auf zwei Ursachenkomplexe zurückzuführen ist: Auf die vorausgegangenen Zustände und Vorgänge des Weltwetters und auf die mengen- und artmäßigen Schwankungen der die Erde treffenden Sonnenstrahlung.“ Vor dem kalten Februar 2012 hat die im November 2011 noch hohe Sonnenaktivität ähnlich deutlich nachgelassen, wie 1956, auch 1985/86 war die Abnahme deutlich. F. BAUR schreibt weiter: „… der Einzigartigkeit des Temperaturverlaufs im Winter 1955/56… ging eine gleichfalls in 2 Jahrhunderten noch nie beobachtete Entwicklung auf der Sonne voraus… . Die Sonnenfleckenrelativzahlen… sind 1955 im November bis auf 89,2 gestiegen… danach folgte ein starker Fall des Monatsmittels der Sonnenfleckenrelativzahlen vom Nov. zum Dez. um 14% und zum Januar um weitere 8%… . Einigermaßen vergleichbar ist dieser Verlauf nur mit 1847/48… Es ist bemerkenswert, dass auch damals ein (einzelner) strenger Wintermonat auftrat, jedoch … um einen Monat früher als 1956, nämlich im Januar 1848 (Temp.- Abw. minus 6,8°C).“ Er merkt weiterhin an, dass die gut zu beobachtenden Sonnenflecken selbst zwar keinen nennenswerten Einfluss auf die Abstrahlung der Sonne im Bereich des sichtbaren Lichtes haben, sie aber die Photosphäre der Sonne so verändern, dass unter anderem die Menge der abgegebenen Ultravioletten Strahlung schwanken kann. Heute weiß man, dass eine zurückgehende Anzahl der Sonnenflecken auch ein Anzeichen für eine Abnahme der Stärke des solaren Magnetfeldes, des Sonnenwinds („Teilchenstrahlung“) und der solaren Radiostrahlung ist. Diese letztgenannten Größen sind es letztendlich, welche über verschiedenartige, komplizierte Mechanismen Witterung und Klima maßgeblich beeinflussen (die Sonnenflecken selbst bilden das Verhalten der „unsichtbaren“ Solarstrahlungsfrequenzen nur unvollständig ab). Da aber nur Daten über die Anzahl und Entwicklung der Sonnenflecken („Sonnenfleckenrelativzahlen“) in guter Qualität für den gesamten Betrachtungszeitraum verfügbar waren, sollen diese hier bei den weiteren Untersuchungen genutzt werden. Die folgende Abbildung zeigt die Entwicklung der Verhältnisse auf der Sonne vor und während des Kälteeinbruchs im Winter 2011/12:

Abb. 6: Starke Abnahme der Sonnenaktivität zwischen November 2011 und Februar 2012, Quelle: EIKE).

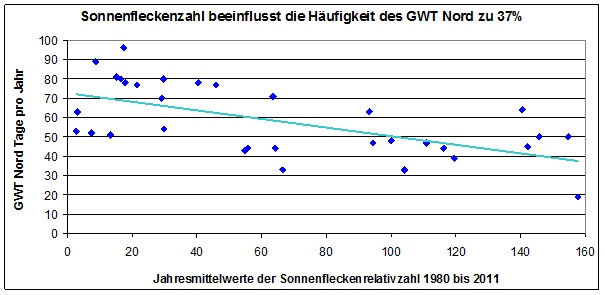

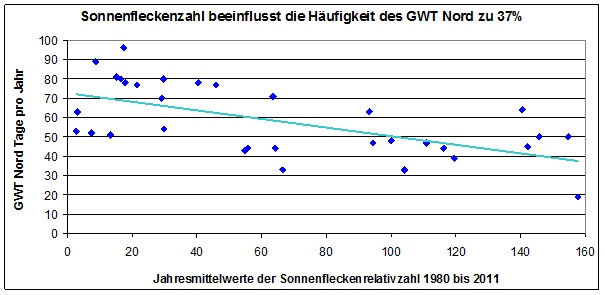

Es lag also nahe, einmal die Beziehungen zwischen der Anzahl der Sonnenflecken und der Häufigkeit der Großwetterlagen zu untersuchen. Zunächst haben wir die Jahresmittelwerte der Sonnenfleckenrelativzahlen zur jährlichen Anzahl der Großwettertypen (GWT) in Beziehung gesetzt. Bei den meisten GWT ergaben sich bei jährlicher Betrachtungsweise nur geringe bis mäßige Zusammenhänge, was bei der starken Schwankung der einzelnen Jahreswerte aber auch nicht wundert. Immerhin zeichneten sich positive Zusammenhänge zu West- und HM- Lagen ab, während Meridionallagen gehäuft bei geringer Sonnenaktivität auftraten. Durchaus bemerkenswert ist aber der Zusammenhang aber zum GWT Nord:

Abb. 7: Bei höherer Sonnenaktivität werden Nordlagen tendenziell seltener.

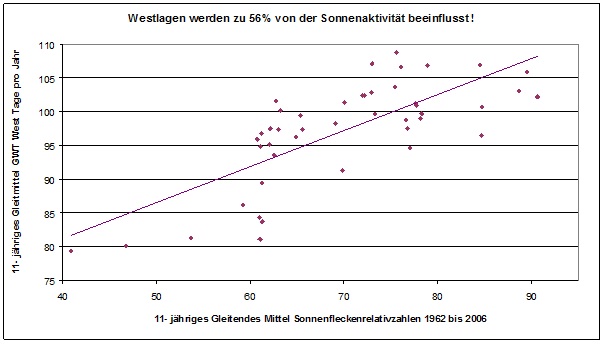

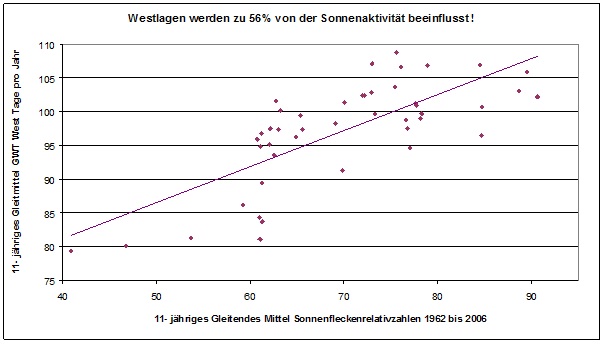

Um die starken, jährlichen Schwankungen auszugleichen, sind wir erstens in der Zeit weiter zurück und zweitens zu einer gleitenden Mittelbildung übergegangen. Wir konnten die Großwetterlagen bis einschließlich 1957 zurückverfolgen und haben ein über 11 Jahre gleitendes Mittel gewählt (bei der Betrachtung eines bestimmten Jahres fließen außer dessen Wert auch die Werte der jeweils 5 Vorgänger- und Nachfolgerjahre gleichrangig in das Gleitende Mittel ein). Somit ist das erste Betrachtungsjahr 1962 (inklusive 1957 bis einschließlich 1967), das letzte 2006. Der 11jährige Zeitraum wurde gewählt, weil er in etwa der Länge des Schwabe- Zyklus der Sonnenaktivität entspricht. Da Witterung und Klima verzögert auf Störgrößen, so auch auf Änderungen der Sonnenaktivität, reagieren, sollte sich bei dieser Vorgehensweise ein deutlicherer Zusammenhang zeigen. Die Ergebnisse sind bemerkenswert:

Abb. 8: Die Variabilität der Häufigkeit des GWT West wird zu 56% positiv von der Variabilität der Sonnenaktivität beeinflusst- bei höherer Sonnenaktivität treten tendenziell mehr Westlagen auf.

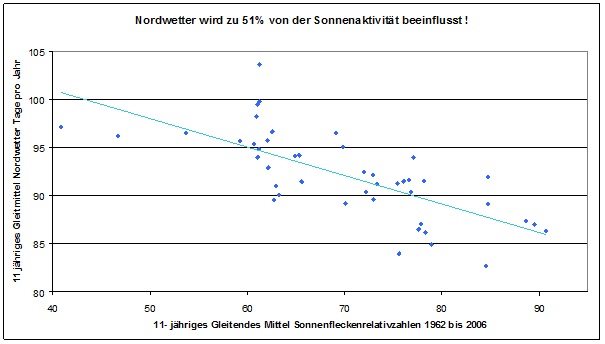

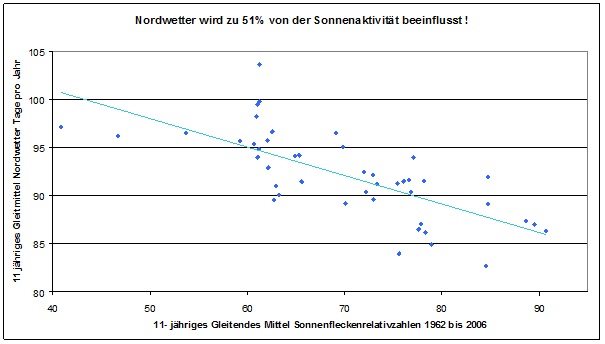

Abb. 9: Die Variabilität der Häufigkeit von Wetterlagen mit Nordanteil wird zu 51% von der Variabilität der Sonnenaktivität beeinflusst, allerdings negativ, so dass bei höherer Sonnenaktivität tendenziell weniger Nordwetter auftritt.

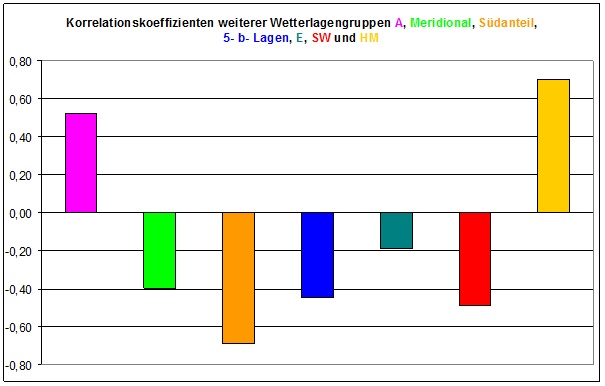

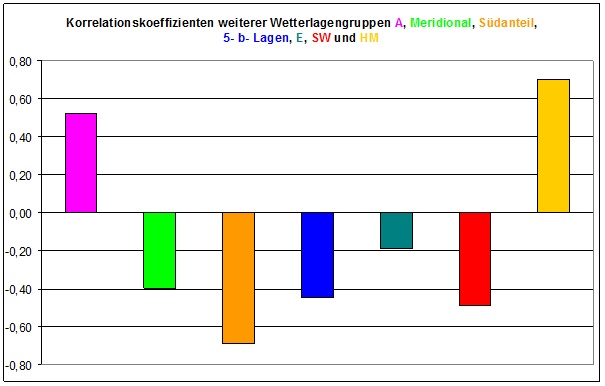

Die folgende Abbildung zeigt die Korrelationskoeffizienten einiger weiterer wichtiger Wetterlagengruppen bei 11- jähriger, gleitender Mittelung:

Abb. 10: Den abgebildeten Korrelationskoeffizienten entsprechen Bestimmtheitsmaße von 49 % beim GWT HM und 47 % bei Wetterlagen mit Südanteil. Antizyklonale Lagen (27 %), 5- b- Lagen (20 %) und Meridionallagen (16 %) werden noch mäßig, Ostlagen (GWT E)mit 3 % praktisch gar nicht von der Sonnenaktivität beeinflusst.

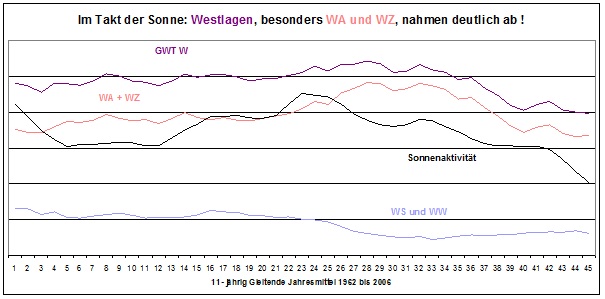

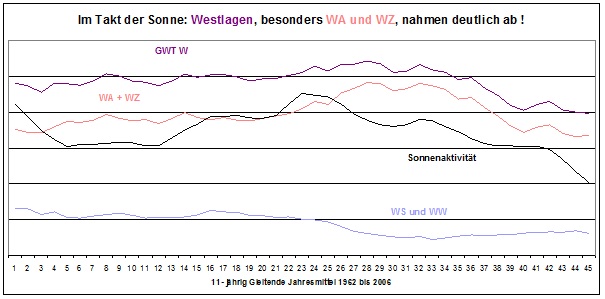

Zum Abschluss der Betrachtungen zum Einfluss der Sonnenaktivität auf die Großwetterlagen wollen wir uns noch einmal die Westwetterlagen etwas näher ansehen, denn von der nachlassenden Sonnenaktivität sind die einzelnen Großwetterlagen des GWT West unterschiedlich stark betroffen, was die folgende Abbildung zeigt:

Abb. 11: Die Häufigkeit der Westwetterlagen (GWT W) folgt im Großen und Ganzen der Sonnenaktivität (Schwarze Kurve). Dabei nahmen besonders die im Winter stark erwärmend wirkenden GWL WA und WZ im Verlauf der letzten 3 Jahrzehnte stark ab, während die Südlichen und die Winkelförmigen Westlagen (WS und WW) schon etwas eher und weniger deutlich zurückgingen. Bei geringerer Sonnenaktivität, welche auch zu einer Südverlagerung der Frontalzone führt, verschieben sich also die Gewichte innerhalb der Westlagen zumindest indirekt in Richtung der meist kühleren WS- und WW- Lagen.

Abschließend sei noch angemerkt, dass die Sonnenaktivität natürlich nicht allein das Verhalten der Großwetterlagen steuert. Auf andere wichtige Faktoren wie die AMO, die NAO und das ENSO- Phänomen, konnten wir im Rahmen dieser Arbeit nicht eingehen.

Zum Abschluss ein kurzer Ausblick- Wie könnte sich unser Klima in naher Zukunft entwickeln?

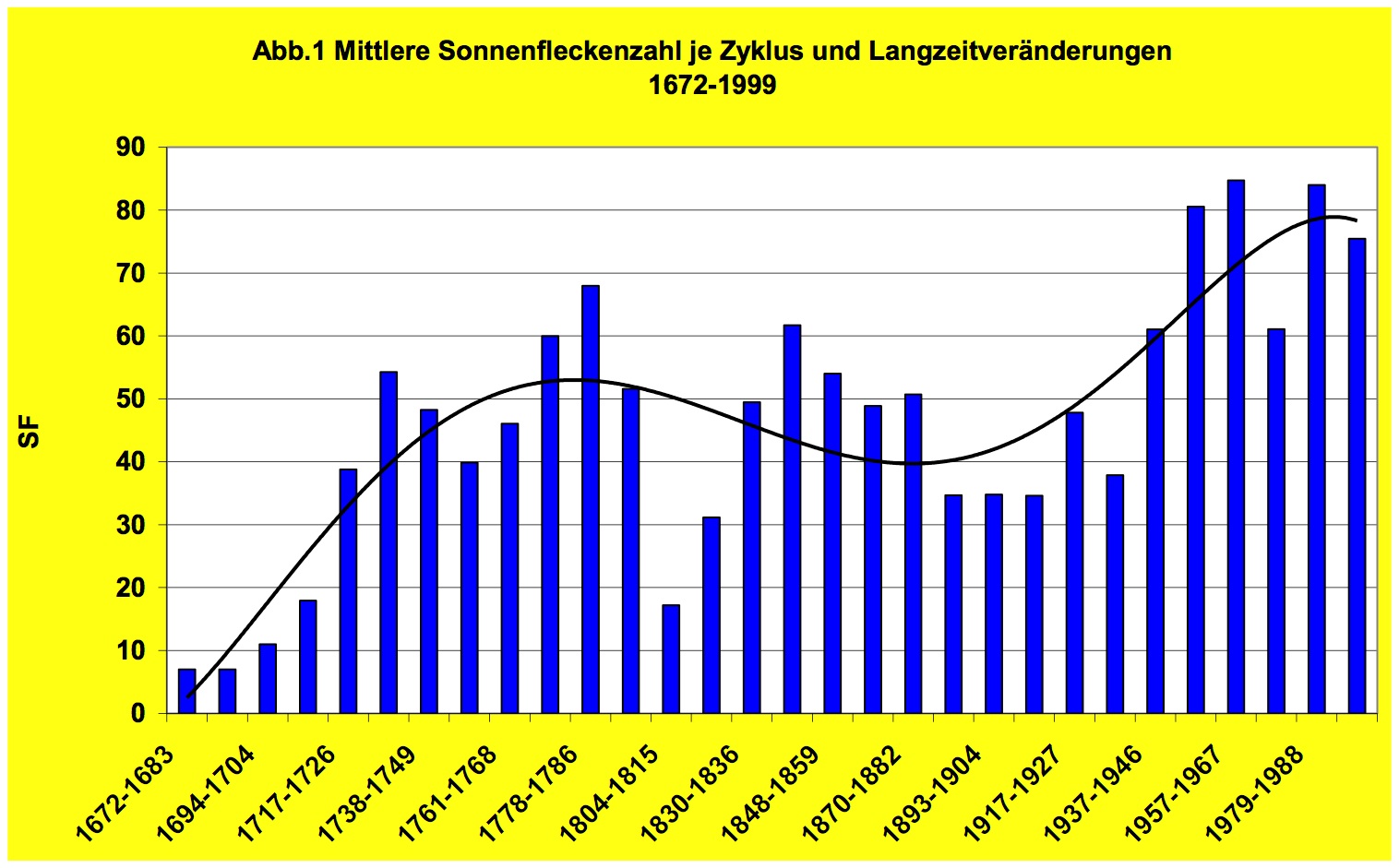

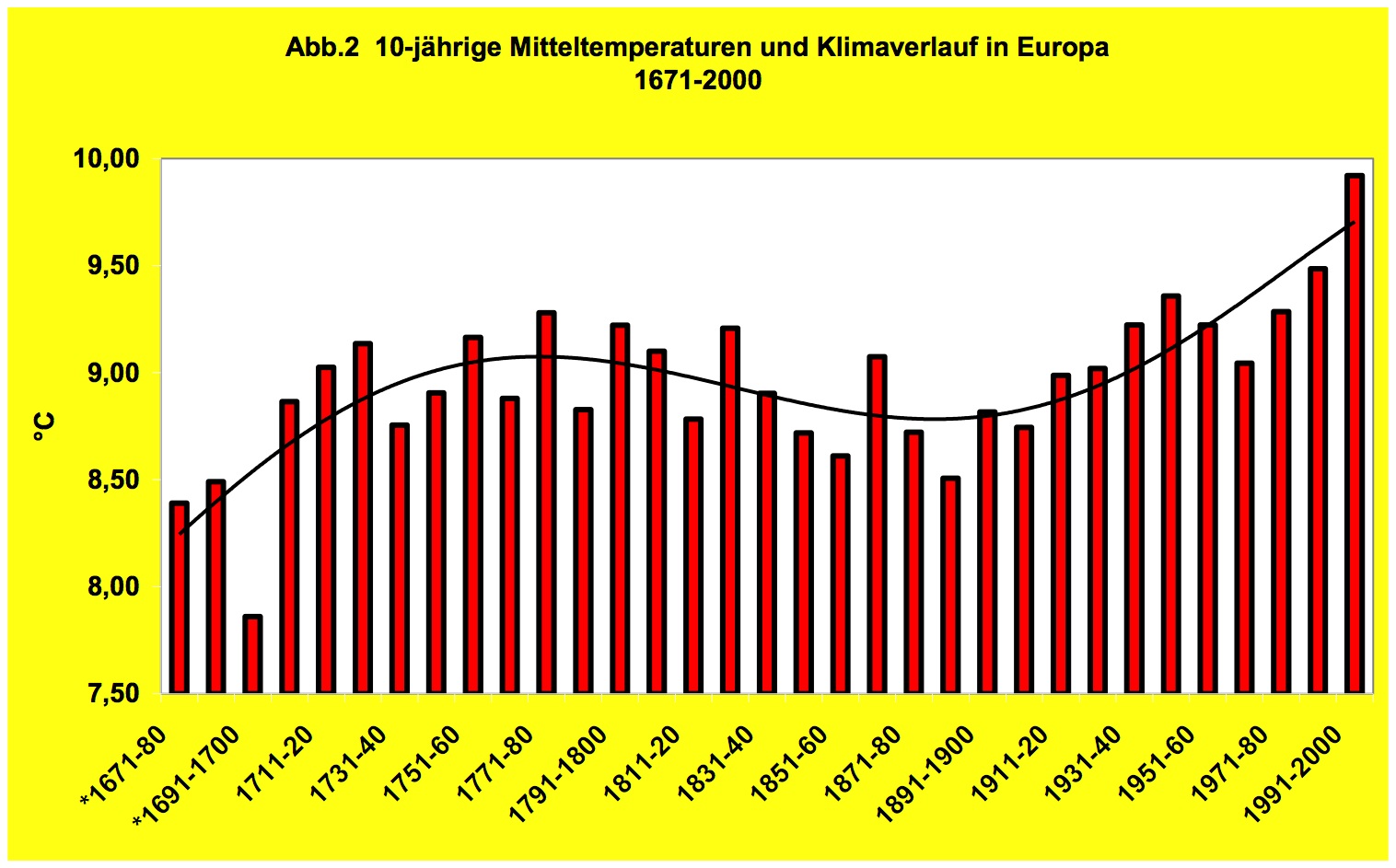

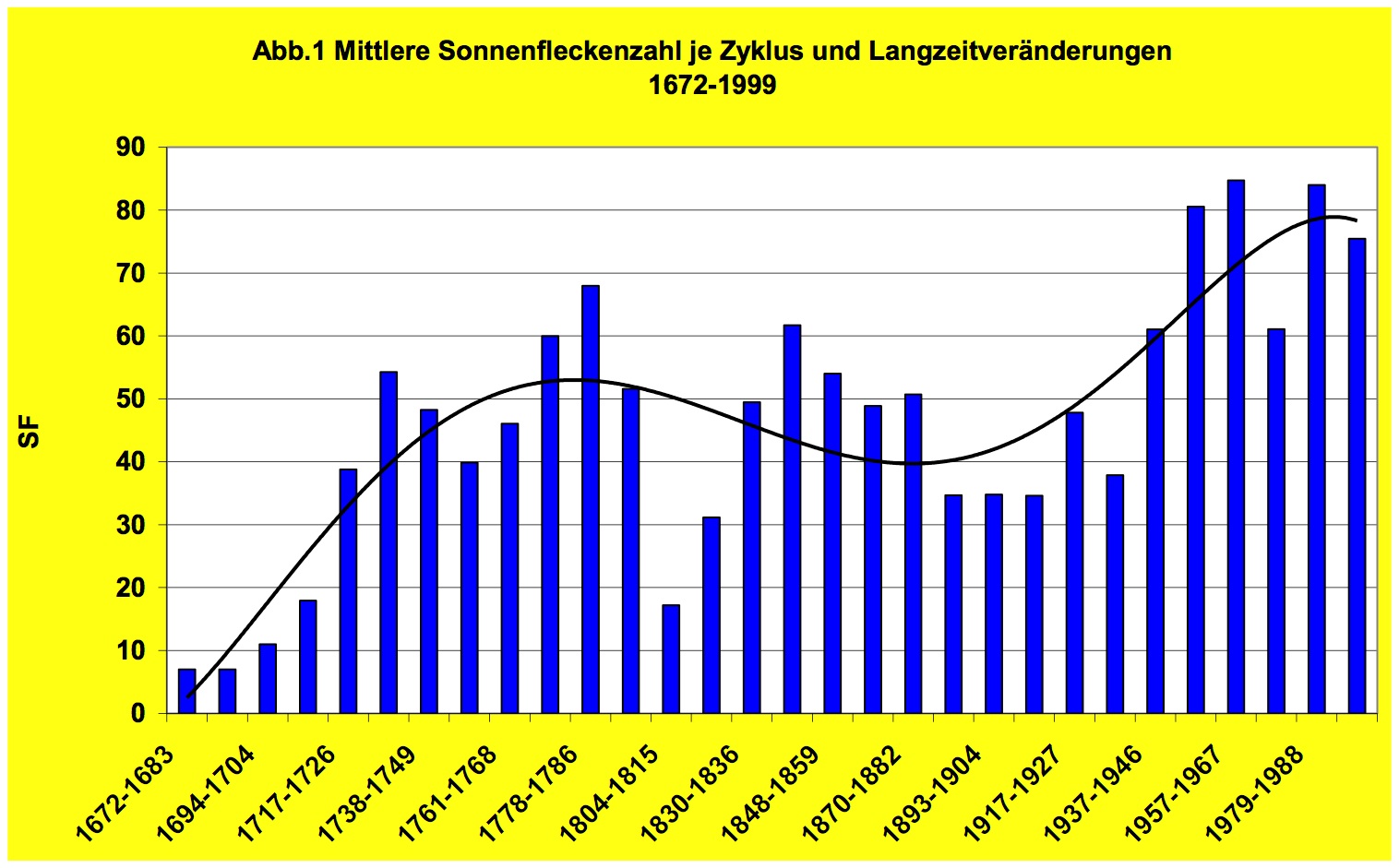

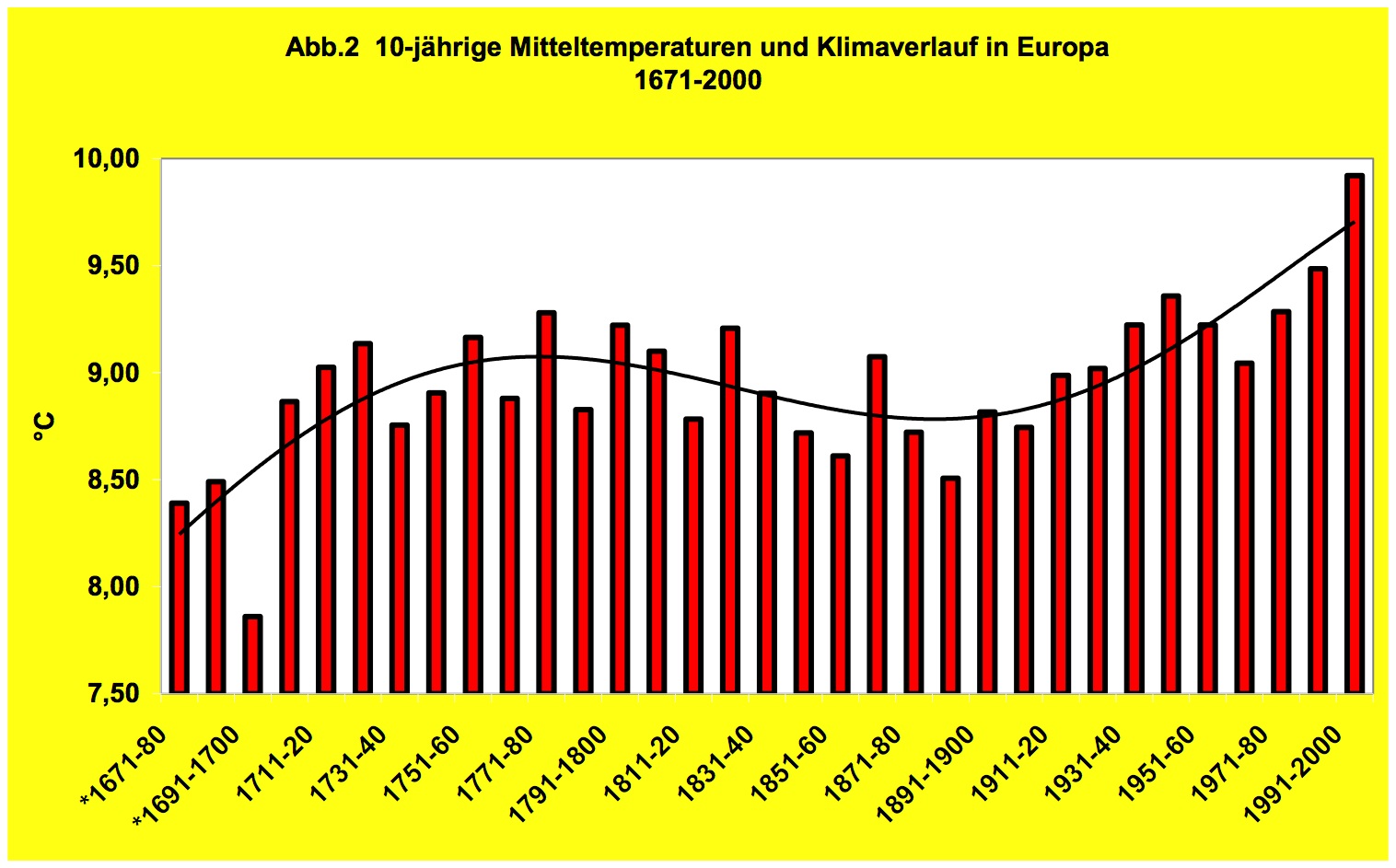

Klimaprognosen sind leider bei weitem nicht so einfach, wie uns das die Experten vom IPCC oder vom PIK immer einreden wollen. So wurde der gerade zu Ende gegangene Hochwinter (Januar und Februar) 2013 von fast allen Langfristvorhersagen deutlich zu mild vorhergesagt; er fiel aber im Vergleich zur Normalperiode 1961 bis 1990 etwas zu kalt, im Vergleich zum Mittel der vorangehenden 30 Jahre (1983 bis 2012) sogar deutlich zu kalt aus. Deshalb können und wollen wir keine exakte Prognose abgeben. Es verdichten sich jedoch die Anzeichen, dass es in den kommenden 3 bis 5 Jahrzehnten zu einer mehr oder weniger deutlichen Abkühlung kommen dürfte; manche Forscher halten sogar eine „Kleine Eiszeit“ mit ähnlichen Verhältnissen wie zur Zeit des „Dalton- Minimums“ der Sonnenaktivität in der 1. Hälfte des 19. Jahrhunderts für sehr wahrscheinlich. H. MALBERG hat in zahlreichen Arbeiten den engen, langfristigen Zusammenhang zwischen Sonnenaktivität und Lufttemperaturen nachgewiesen (folgende Abbildung):

Abb. 12: Die Sonnenaktivität (obere Abbildung) beeinflusst maßgeblich den Temperaturverlauf in Europa (Quelle: MALBERG, 2013).

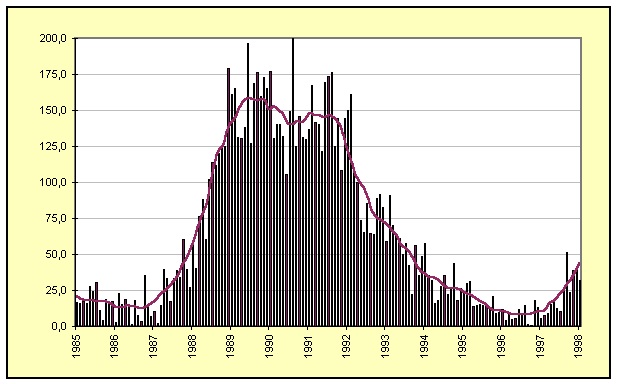

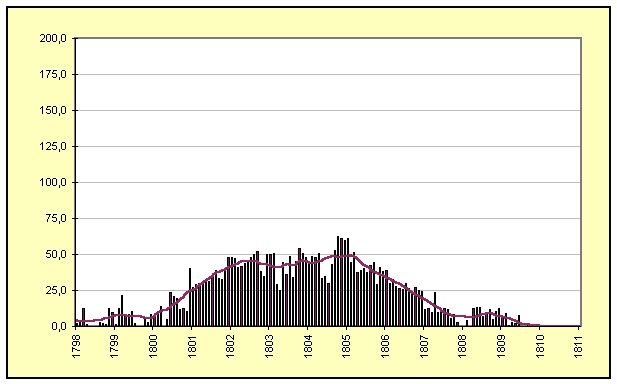

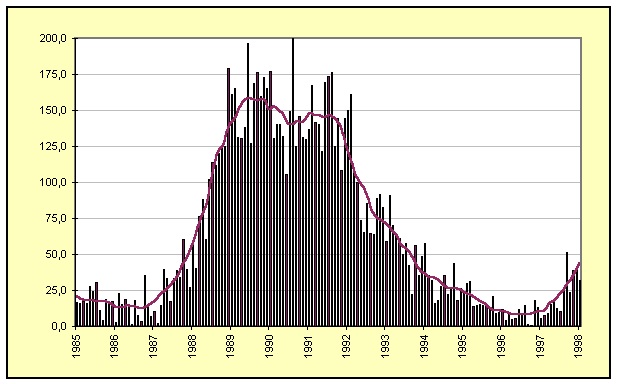

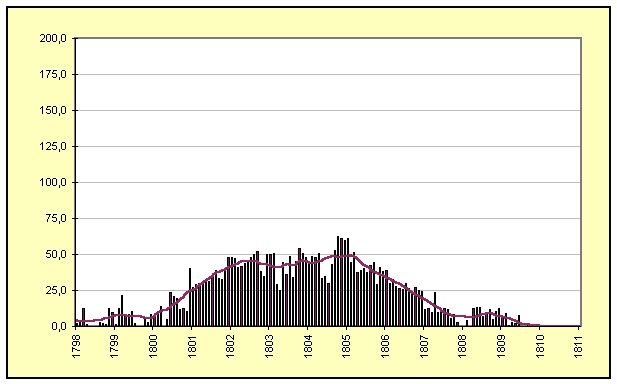

In unserer Arbeit haben wir uns vorrangig mit den Ursachen des Temperaturverlaufs in Deutschland seit 1980 befasst. Zu Beginn dieses Untersuchungszeitraumes war das Maximum des intensiven Schwabe- Zyklus 21 zu beobachten; um 1990 folgte das noch intensivere des Zyklus 22, während der Zyklus 23, der sein Maximum 2000/2001 erreichte, schon deutlich schwächer ausfiel, allerdings nur in der Sonnenfleckenrelativzahl, nicht in der magnetischen Aktivität, oder der Röntgenaktivität der Sonne, diese stiegen bis ca. 2003 weiter an. Der aktuelle, noch nicht beendete Zyklus 24 fiel bislang sehr schwach aus und ähnelt hinsichtlich seiner sehr geringen Intensität den Zyklen 5 und 6, welche zu Beginn des 19. Jahrhunderts den letzten Höhepunkt der „Kleinen Eiszeit“ einleiteten. Die folgende Abbildung zeigt den sehr aktiven Zyklus 22 im Vergleich zum Zyklus 5, welcher dem jetzigen Zyklus 24 ähnelt:

Abb. 13:Während bei dem Schwabe- Zyklus 22 zu Beginn der 1990er Jahre sehr hohe Sonnenfleckenrelativzahlen von bis zu 200 aufgetreten sind, ähnelt der momentane Zyklus 24 dem unten abgebildeten Zyklus 5 vom Beginn des 19. Jahrhunderts. Er dauert länger, und die Sonnenfleckenrelativzahlen bleiben sehr niedrig (Quelle: www.schulze-md./de)

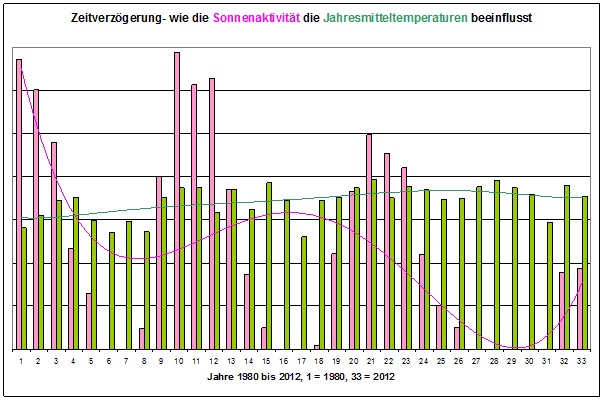

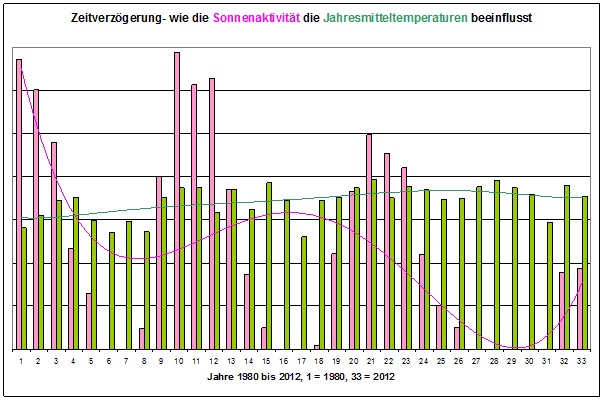

Weil die mittleren Lufttemperaturen der Sonnenaktivität aufgrund der Trägheit des Klimasystems mit einer deutlichen Verzögerung von mindestens einem halben Jahrzehnt folgen, wird auch der Temperaturverlauf der letzten Jahrzehnte transparenter. Auf die intensiven Schwabe- Zyklen 21 und 22 reagierte das Klima in Deutschland mit einer Erwärmung, die zeitversetzt etwa 10 Jahre später ihr Maximum (Jahr 2000) erreichte und dann- als Reaktion auf den schon schwächeren Zyklus 23- wieder zu fallen begann. Seit Mitte der 2000er Jahre ist die Sonnenaktivität nur noch sehr gering ausgefallen, und tendenziell nahm die Sonnenaktivität im Betrachtungszeitraum insgesamt stark ab, was sich nun auch zunehmend auf die Temperaturen auswirkt:

Abb. 14: Träges Klima- die Jahresmitteltemperaturen in Deutschland (Grün) folgten der Sonnenaktivität (Rosa) mit einer Verzögerung von mehr als einem Jahrzehnt, wenn man nur die sichtbaren Parameter der solaren Aktivität betrachtet. Die sehr hohe Sonnenaktivität der späten 1970er bis frühen 1990er Jahre wirkte darauf noch lange- bis zum Jahr 2000- nach.

Werden indes die bereits erwähnten, nicht sichtbaren Parameter, wie magnetische Aktivität oder kurzwellige elektromagnetischen Strahlung der Sonne betrachtet oder die Sonnenwindaktivität (für deren Einflüsse auf das Wetter z.B. der Svensmark- Effekt als Oberbegriff steht) und diese in Zusammenhang zur Temperaturentwicklung gesetzt, wird der unmittelbare Einfluss der solaren Aktivität auf unser Wetter/Klima sichtbar.

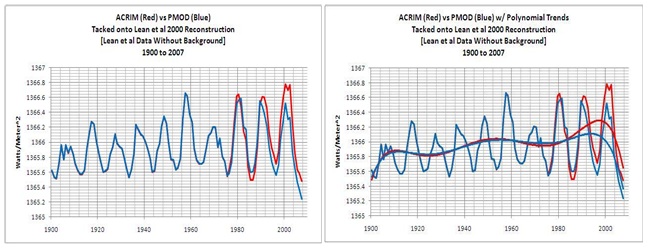

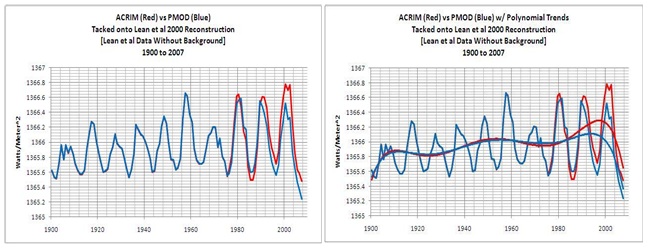

Abb. 15 (Quelle: http://bobtisdale.blogspot.com/2008/08/reference-graphs-total-solar-irradiance.html) zeigen die PMOD-TSI-Kurve von 1900 – 2007 (blau, vor 1980 rekonstruiert, PMOD = Physikalisch-Meteorologisches Observatorium Davos) und in rot die Satelliten-ACRIM-TSI-Kurve. Deutlich ist erkennbar, dass die solare Aktivität zum ausgehenden 20. Jahrhundert deutlich ansteigt und ihr Maximum erreicht. Dies wird noch mehr in der Abbildung rechts deutlich, wird jeweils der polynomische Trend angelegt. Anzumerken ist noch, dass der 23. Zyklus aufgrund der anderen Messcharakteristik von ACRIM III gegenüber ACRIM I (ACRIM = Active Cavity Radiometer Irradiance Monitor) im Vergleich zu seinen beiden Vorgängerzyklen gedämpft ist, also, würde auf ACRIM I normiert, er nochmals höher ausfiele.

Werden die NASA-Satellitenmessungen ab 1980 mit den rekonstruierten TSI-Werten (TSI = Total Solar Irradiance) verknüpft, so ergibt sich die nachfolgende Datenreihe links.

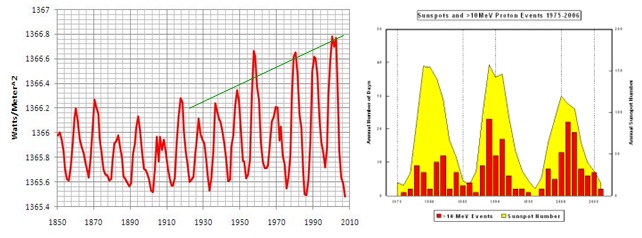

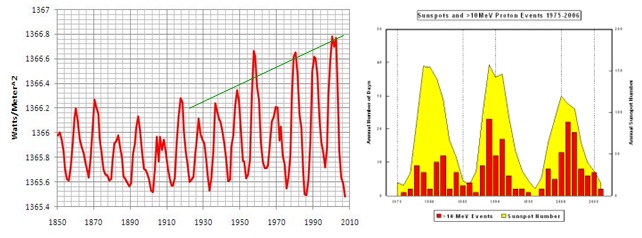

Abb. 16: Die Datenreihe zeigt den TSI von 1850, dem Jahr, indem das IPCC seine Temperaturbetrachtung beginnen lässt, bis 2007. Sie passt auch zur Protonenaktivität (rot = Hochenergie: >10 MeV, gelb = Sonnenfleckenzahl) der Sonne, die als Maß ihrer Gesamtaktivität gilt, Abbildung rechts, Quelle: NOAA Space Environment Center. Ebenso zum Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries/Suess-Zyklus, der in 2003 sein Maximum hatte und der den Schwabe-Zyklus elementar beeinflusst, sowie zur Aussage der Max Planck Gesellschaft aus 2004, “Sonne seit über 8.000 Jahren nicht mehr so aktiv wie heute“.

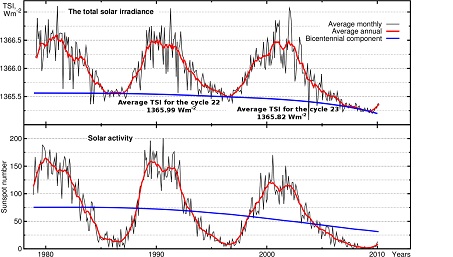

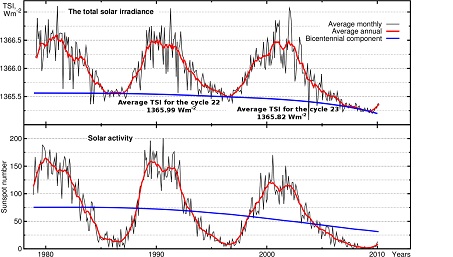

Auch die folgende Abbildung belegt, dass die Aktivität der Sonne bis in den 23. Sonnenzyklus stetig ansteigt und diese Aktivitätssteigerung in den Sonnenflecken nicht sichtbar wird. D.h. die Sonnenflecken sind kein geeignetes Maß, um die tatsächliche solare Aktivität wieder zu geben. Sie sind dann erste Wahl, wenn es gilt, lange Zeitreihen, miteinander zu vergleichen, weil deren Beobachtungen einige Jahrhunderte zurück reichen.

Abb.17 (http://www.gao.spb.ru/english/astrometr/index1_eng.html) verdeutlicht, die Sonnenflecken sind nur eingeschränkt aussagefähig zur solaren Aktivität. Während der 23. Zyklus deutlich weniger Sonnenflecken zeigt als seine beiden Vorgänger und dadurch fälschlich abgeleitet wird, die solare Aktivität wäre deutlich niedriger, ist die Höhe der Strahlungsleistung gleich zu seinen Vorgängern. Der Betrag (Flächenintegral)ist sogar größer.

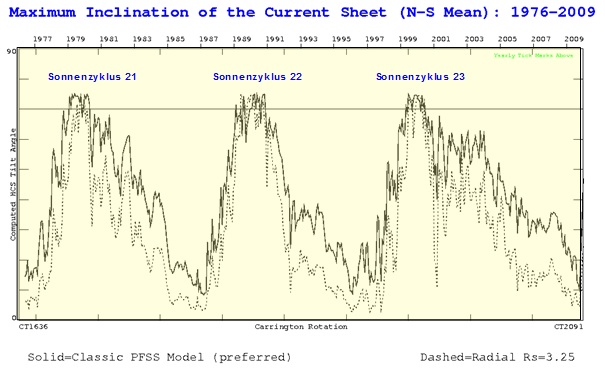

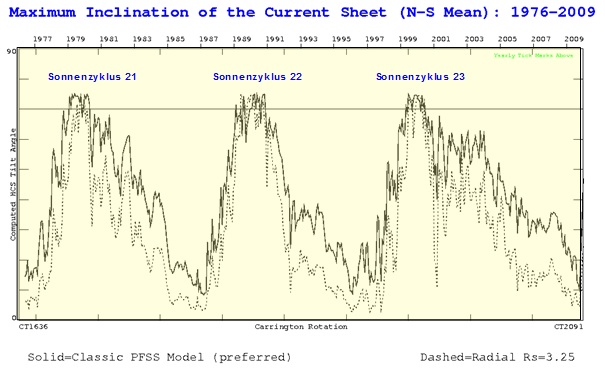

Dies zeigt auch sehr deutlich ein weiterer Parameter, der von Solar Stanford University verwendet wird und der für ein Maß für die magnetische und Sonnenwindaktivität ist, die Heliosphärische Stromschicht.

Abb. 18 (Quelle: ”Analysis of the heliospheric current sheet at Earth’s orbit and model comparisons”, Lepping, R. P.; Szabo, A.; Peredo, M.; Hoeksema, T., NASA Goddard Space Flight Center, International Solar Wind 8 Conference, p. 95, http://wso.stanford.edu/gifs/Tilts.gif) zeigt die Lage der Heliosphärischen Stromschicht der Sonne (Heliospheric Current Sheet) während der Sonnenzyklen 21 – 23 anhand zweier Analysemethoden, wobei angegeben wird, dass die Radialdaten möglicherweise genauer sind. Wie Leistenschneider übrigens in seiner 8-teiligen EIKE-Reihe, “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ zeigen konnte, ist dies eine falsche Einschätzung der Fachleute in Stanford. Deutlich ist zu sehen, dass die Sonne im 23. Sonnenzyklus am aktivsten war. Dieser fiel mit dem Maximum des Hauptsonnenzyklus, dem im Mittel 208-jährigen de Vries- Suess- Zyklus zusammen, der in 2003 sein 200-jähriges Maximun hatte.

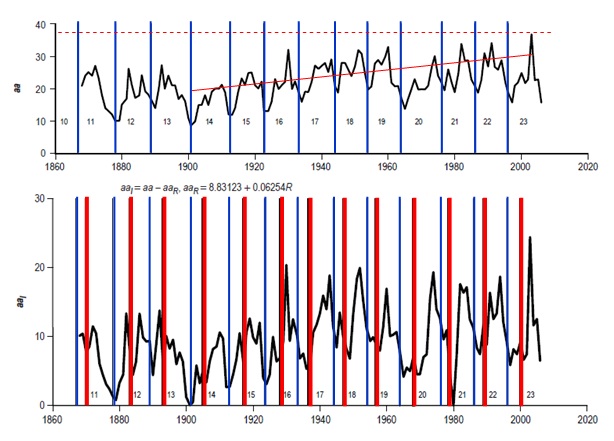

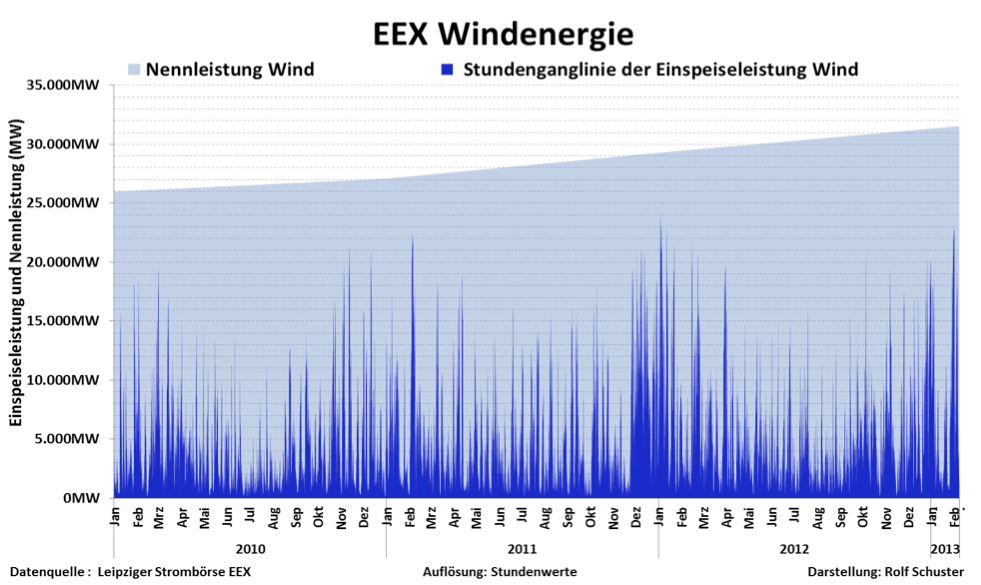

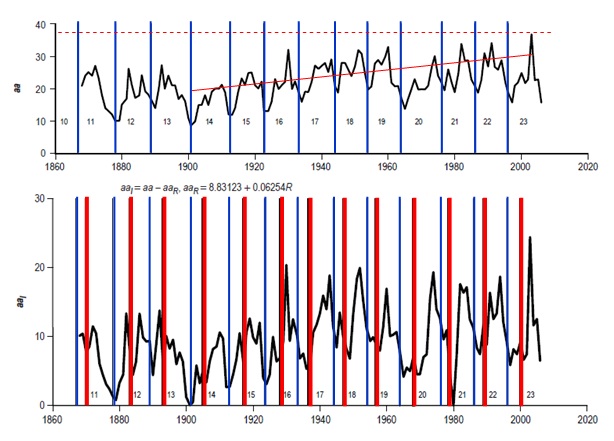

Das gleiche Bild der Sonnenaktivität zeichnen Wilson & Hathaway in ihrer Arbeit “On the Relationship Between Solar Wind Speed, Geomagnetic Activity, and the Solar Cycle Using Annual Values”, NASA (Marshall Space Flight Center). Dort ist die folgende Abbildung des geomagnetischen aa- Index abgebildet.

Abb. 19 oben zeigt den aa- Index von 1868 – 2006. Die blauen Balken geben das Sonnenminimum der Sonnenzyklen an. Deutlich ist zu sehen, dass die geomagnetische Aktivität ab 1900 zunimmt und ihr Maximum im 23. Schwabe-Zyklus um 2003 hat. Die Abbildung darunter zeigt den geomagnetischen aa- Index in Verbindung der Sonnenfleckenzahl R für die Jahre 1868 – 2006. Die blauen Balken zeigen das jeweilige solare Minimum und die roten Balken das jeweilige solare Maximum. Auch hier ist ab 1900 eine deutliche Steigerung der Sonnenaktivität zu verzeichnen und im 23. Schwabe-Zyklus um 2003 die Sonnenaktivität am höchsten. Im ihrem Bericht weisen Wilson & Hathaway übrigens darauf hin, dass die magnetische Aktivität jeweils nach dem Zyklusmaximum, wie es anhand der Fleckentätigkeit ermittelt wird, ihr Maximum erreicht.

Weil fast alle Astrophysiker von einer auch in den kommenden Jahren geringen Sonnenaktivität ausgehen, dürften nach unseren Untersuchungen auch die Temperaturen in naher Zukunft weiter sinken. Es ist bemerkenswert, dass T. LANDSCHEIDT schon in den 1980er Jahren diese Entwicklung bereits im Großen und Ganzen richtig vorhergesagt hatte. Ihm zu Ehren wäre es wünschenswert, das aktuelle Aktivitätsminimum der Sonne als Landscheidt- Minimum zu bezeichnen.

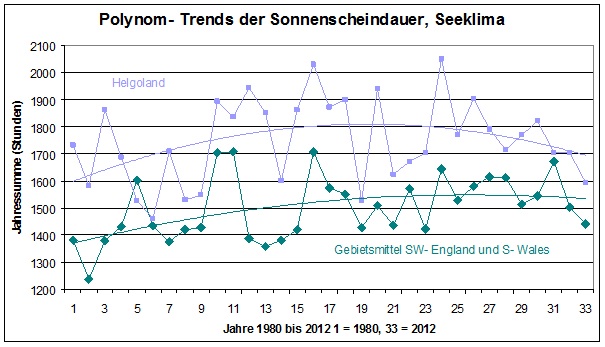

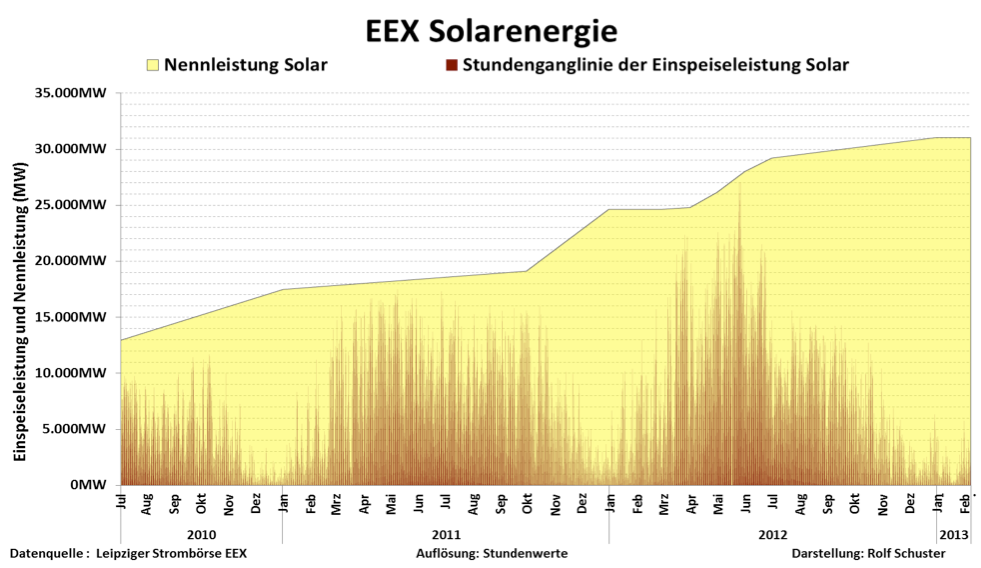

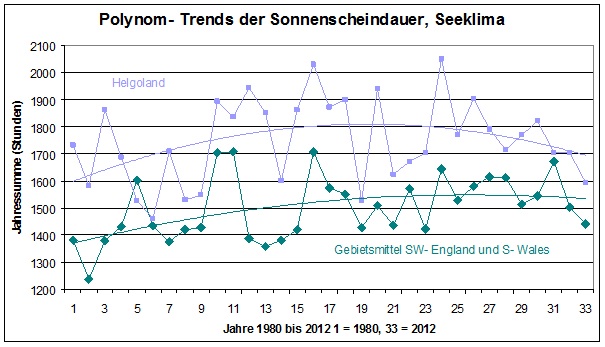

Da wir uns im letzten Teil unserer Arbeit mit der Sonnenaktivität beschäftigt haben, wollen wir ganz am Ende noch einmal kurz auf die Sonnenscheindauer zurückkommen, deren Zunahme maßgeblich an der Erwärmung der vergangenen Jahrzehnte beteiligt war (siehe Teil 2). H. SVENSMARK fand heraus, dass die bis in tiefere Luftschichten vordringende Kosmische Strahlung bei höherer Sonnenaktivität abnimmt (dafür sorgt das dann stärkere solare Magnetfeld). „Kosmische Strahlung“ besteht jedoch aus hochenergetischen Teilchen, welche die Bildung von Kondensationskeimen und damit die Bildung tiefer Wolken und Nebel fördern. Im Zuge der aktuell nachlassenden Sonnenaktivität schwächt sich auch das solare Magnetfeld deutlich ab, so dass sich die Intensität der Kosmischen Strahlung wieder erhöht. Mehr tiefe Wolken und mehr Nebel bedeuten aber weniger Sonnenschein. Dass die Zunahme der Sonnenscheindauer an den meisten deutschen Stationen trotzdem bis in die Gegenwart andauerte, liegt an den umfangreichen Luftreinhaltemaßnahmen, welche den „Svensmark- Effekt“ bislang noch überkompensierten. Es gibt aber bereits Gegenden, wo sich die nachlassende Sonnenaktivität bereits auf die Sonnenscheindauer auswirken könnte- die Hochseeinsel Helgoland oder der Westen Englands, wo der Effekt der Luftreinhaltemaßnahmen zwar auch vorhanden, aber deutlich geringer ist. Unsere letzte Abbildung zeigt, dass die Trendwende zu sonnenscheinärmeren Zeiten dort bereits begonnen hat, auch auf dem Festland dürfte sich diese Entwicklung ab sofort deutlicher bemerkbar machen.

Abb. 20: Im atlantischen Klima hat die „Trendwende“ zu sonnenscheinärmerer Witterung bereits Mitte der 2000er Jahre begonnen. Quelle für die England- Werte: http://sunshinehours.wordpress.com/category/uk-met/

Verfasst und zusammengestellt (2013) von

Stefan Kämpfe, Weimar

Josef Kowatsch, Hüttlingen

Raimund Leistenschneider, EIKE

Literaturliste

Abdussamatow, H. I. (2012): Zweihundertjährige Abnahme der Solarstrahlung führt zu einem Ungleichgewicht des thermischen Budgets der Erde und zu einer Kleinen Eiszeit. Petersburg 2012 http://nextgrandminimum.files.wordpress.com/2012/11/abduss_apr.pdf

Baur, F.: Gedanken und Tatsachen zur Frage der Ursache der strengen Kälte im Februar 1956. Nachdruck in: Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 43/06 (Sonderbeilage 12/06) vom 17.05.2006

Calder, N., Svensmark, H. (2007): The Chilling Stars – A New Theory of Climate Change, übersetzt ins Deutsche von Helmut Böttiger: Sterne steuern unser Klima: Eine neue Theorie zur Erderwärmung. Patmos Verlag, Düsseldorf 2008

Deutscher Wetterdienst (DWD) (2010, 2011): Großwetterlagen- Anzahl der Tage.

www.dwd.de

Fett, W. (2012): Klimawandelschuldzuweisung: Mensch oder doch Sonne? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 73/12 (Sonderbeilage 35/12) vom 12.12.2012

Hess, P., Brezowsky, H.: Katalog der Großwetterlagen Europas. Ber. Dt. Wetterd. in der US- Zone 33, 1952.

Hess, P., Brezowsky H.: Katalog der Großwetterlagen Europas. 2. neu bearbeitete und ergänzte Auflage. Ber. Dt. Wetterd. 15 (113), 1969.

Hess, P., Brezowsky, H.: Katalog der Großwetterlagen Europas 1881–1976. 3. verbesserte und ergänzte Aufl.. Ber. Dt. Wetterd. 15 (113), 1977.

http://.wikipedia.org/ Zeitreihe der Lufttemperatur in Deutschland ab 1761

Kämpfe, S., Kowatsch, J., Leistenschneider, R.: Starker Temperaturanstieg seit 1979 in Erfurt- warum CO2 dabei nur eine unbedeutende Nebenrolle spielt! Teil 1 Vorstellung der Hauptakteure (20.10.2012) und Teil 2 „Trittbrettfahrer“ CO2- Das Phantom der Klimawissenschaft (26.10.2012) www.eike-klima-energie.eu

Landscheidt, T. (1983): Solar oscillations, sunspot cycles and climatic change. Boulder 1983

Leistenschneider, R. (2011): Dynamisches Sonnensystem- die tatsächlichen Hintergründe des Klimawandels, Teile 1 bis 8

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4 – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

Teile 1 bis 8 bei www.eike-klima-energie.eu

Malberg, H. (2002 bis 2013) Beiträge des Instituts für Meteorologie der Freien Universität Berlin/Berliner Wetterkarte:

– Über den Klimawandel in Mitteleuropa seit 1850 und sein Zusammenhang mit der Sonnenaktivität. SO 17/02

– Die globale Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 27/02

– Die nord- und südhemisphärische Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 10/03

– Der solare Einfluss auf das mitteleuropäische und globale Klima seit 1778 bzw. 1850. SO 01/07 (2007) – In Memoriam

Prof. Richard Scherhag.

– Über den dominierenden solaren Einfluss auf den Klimawandel seit 1701. SO 27/07

– El Nino, Vulkane und die globale Erwärmung seit 1980. SO 34/07

– El Niño und der CO2-Anstieg sowie die globale Erwärmung bei CO2-Verdopplung. SO 02/08

– Die unruhige Sonne und der Klimawandel. SO 20/08

– Über die kritische Grenze zwischen unruhiger und ruhiger Sonne und ihre Bedeutung für den Klimawandel. SO 03/09

– La Niña – El Niño und der solare Einfluss – Der Klimawandel 1950-2008. SO 11/09

– Über das Stadtklima und den Klimawandel in Deutschland seit 1780. SO 18/09

– Langfristiger Klimawandel auf der globalen, lokalen und regionalen Klimaskala und seine primäre Ursache: Zukunft

braucht Herkunft. SO 29/09 (2009)

– Der solare Einfluss auf den Klimawandel in Westeuropa seit 1672. SO 37/09 (2009)

– Rekonstruktion des Klimawandels seit 1860 bzw. 1672 aufgrund solarer Aktivitätsänderungen, SO 11/10 (2010)

– Kurzperiodische und dekadische Klimavariabilität im Zeitraum 1980-2009. SO18/10 (2010)

– Über scheinbare und tatsächliche Klimaerwärmung seit 1850. SO 26/10 (2010)

– Analyse des solaren Effekts und des langfristigen Klimawandels seit 1680 sowie des gegenwärtigen kurzperiodischen

Klimaverhaltens SO 09/11 (2011)

-Über sprunghafte Anstiege von CO2 und globaler Temperatur –SO 05/12 (2012)

-Fakten zum Klimawandel seit der Kleinen Eiszeit SO 01/13

Standardisierte beziehungsweise normalisierte NAO- Werte Januar 1950 bis Dezember 2011: www.cpc.noaa.gov/

Tabellen der Sonnenfleckenrelativzahlen www.schulze-md./de (dort auch Abbildungen aller 23 Zyklen) und www.swpc.noaa.gov/solarCycle

Vahrenholt, F., Lüning, S.(2012): Die kalte Sonne. Warum die Klimakatastrophe nicht stattfindet. Hoffmann und Campe, Hamburg 2012

Werner, P. C., Gerstengarbe, F.W. (2010): KATALOG

DER GROSSWETTERLAGEN EUROPAS

(1881-2009)

NACH PAUL HESS UND HELMUT BREZOWSKY. PIK Report

No. 119 Potsdam 2010

http://sunshinehours.wordpress.com/category/uk-met/ Sonnenscheindauer in Südwestengland und Wales

”Analysis of the heliospheric current sheet at Earth’s orbit and model comparisons”, Lepping, R. P.; Szabo, A.; Peredo, M.; Hoeksema, T., NASA Goddard Space Flight Center, International Solar Wind 8 Conference, p. 95

Wilson & Hathaway, “On the Relationship Between Solar Wind Speed, Geomagnetic Activity, and the Solar Cycle Using Annual Values”, NASA

Related Files