Vor über 100 Jahren wurde die radioaktive Strahlung einzelner Elemente erstmalig experimentell nachgewiesen. Tatsächlich leben Menschen aufgrund der Beschaffenheit der Erdkruste und der durch kosmische Quellen verursachten Höhenstrahlung immer schon in einem radioaktiv strahlenden Umfeld, dessen Stärke im Wesentlichen von der geographischen Lage abhängt. Wegen der (glücklicherweise) sehr geringen Wirkung natürlich auftretender Dosen können statistische Aussagen nur dann getroffen werden, wenn eine genügend große Zahl exponierter Personen und eine nichtexponierte Vergleichsgruppe vorliegen.

Mit Sicherheit lässt sich sagen, dass eine über einen kurzen Zeitraum (wenige Minuten) aufgenommene extrem hohe Dosis (mehrere Sievert) äußerlich zu verbrennungsartigen Erscheinungen, begleitet von Nekrose und Organversagen führt. Bei einer deterministischen Wirkung wie in diesem Fall ist der Zusammenhang zwischen Ursache und Wirkung offensichtlich, ähnlich einem Autounfall. Schwieriger ist die Beurteilung statistischer Langzeitrisiken, also der Frage, wie stark sich das Risiko gesundheitlicher Beeinträchtigungen (z.B. Tumorbildung) über die gesamte Lebensspanne erhöht, wenn eine Person einer bestimmten Strahlendosis ausgesetzt wurde.

Blitzdosis und Langzeitdosis

Dosis ist nicht gleich Dosis. Obwohl in der Summe identisch, hat eine hohe Einzeldosis eine ganz andere Wirkung als die gleiche Dosis verteilt über einen langen Zeitraum. Zur Unterscheidung werden wir den ersten Fall als Blitzdosisbezeichnen, den zweiten dagegen als Langzeitdosis. Beide Arten der Dosis haben wiederum die oben genannten statistischen Langzeitwirkungen. Deterministische Kurzzeitwirkungen kann es naturgemäß nur bei einer Blitzdosis geben.

Der Unterschied zwischen Blitzdosis und Langzeitdosis ist vergleichbar mit der Aufnahme von Wärmeenergie: Wenige Minuten in loderndem Feuer führen unweigerlich zum Tod. Dagegen wird die gleiche Energie, verteilt über einen längeren Zeitraum, als angenehme Wärme empfunden. Allgemein gilt für jede Art Energiefreisetzung: Eine explosionsartige Freisetzung führt immer zu Zerstörung, eine langsame Freisetzung derselben Energiemenge dagegen kann einen erwünschten Nutzen erfüllen.

Als Zeitmaß einer Blitzdosis nehmen wir die biologische Reaktionszeit des Körpers an. Nach neueren Erkenntnissen gibt es mehrere Reparaturmechanismen, die die biologisch negative Wirkung sogar überkompensieren können. Diese arbeiten auf unterschiedlichen Zeitskalen, so dass die Grenze zwischen Blitzdosis und Langzeitdosis bei einigen Stunden bis einigen Wochen liegen kann.

Bei der Ermittlung gesundheitlicher Auswirkungen radioaktiver Emissionen z.B. auf die Bevölkerung im Umkreis des verunfallten Kernkraftwerks Tschernobyl aber auch auf Nukleararbeiter als Grundlage für den Strahlenschutz geht es im Allgemeinen um die Langzeitfolgen einer Langzeitdosis. Grundlage dieser Schätzungen sind dagegen die Überlebenden der Atombombenabwürfe über Hiroshima und Nagasaki, also die Studie der Langzeitfolgen einer Blitzdosis. Dieser offensichtliche Widerspruch wird im Strahlenschutz hingenommen, vor allem weil in der "Gründerzeit" des Strahlenschutzes die Hiroshima- und Nagasakiüberlebenden mit 90 000 Personen die einzige größere exponierte Gruppe bildeten, bei der Langzeitwirkungen beobachtet werden konnten.

Inzwischen existieren aber zahlreiche Studien von großen Personengruppen, die einer erhöhten Langzeitdosis ausgesetzt waren. Das prominenteste Beispiel ist die Kontamination mehrerer Wohngebäude mit radioaktivem Kobalt in Taipei, Taiwan, im Jahre 1983, mit 10.000 betroffenen Personen. Studien dazu sind erst wenige Jahre alt, so dass die neuen Erkenntnisse noch nicht den Weg durch die internationalen Strahlenschutzinstanzen gefunden haben.

Obwohl aus den o.g. Gründen als Vorlage für den allgemeinen Strahlenschutz nur sehr beschränkt geeignet, bilden die Hiroshima- und Nagasakibeobachtungen immer noch die Grundlage gesundheitlicher Risikoabschätzungen. Nicht nur die Tatsache, dass die Wirkung einer Blitzdosis sich von der einer Langzeitdosis dramatisch unterscheidet, sondern auch das abgeleitete Risikomodell der Blitzdosis selbst ist kritisch zu betrachten, wie in den folgenden Abschnitten gezeigt wird.

Die Hiroshima- und Nagasakiüberlebenden

Seit den Abwürfen der Atombomben über Hiroshima und Nagasaki am 6. und 9. August 1945, bei denen unmittelbar rund 200.000 Menschen vorwiegend durch die Folgen der Hitze- und Druckwelle starben, wurden statistische Daten der Überlebenden gesammelt mit dem Ziel, einen biologischen Dosis-Wirkung-Zusammenhang für die Spätfolgen radioaktiver Bestrahlung zu etablieren.

Bis zu jenem Zeitpunkt kannte man nur die deterministischen Schäden, also die Sofortwirkung radioaktiver Strahlung, während es über statistische Langzeitschäden nur Vermutungen gab. Rund 90.000 Überlebende der Atombombenangriffe auf Hiroshima und Nagasaki wurden einer lebenslangen Beobachtung (Life Span Study) unterzogen. Mit Berechnungen und Simulationen, die auch heute noch verfeinert werden, wird die in Sekundenbruchteilen empfangene individuelle radioaktive Dosis abgeschätzt. Die Erhebungen werden von der Radiation Effects Research Foundation (RERF)durchgeführt, finanziert vom japanischen Gesundheitsministerium (MHLW) und dem US-amerikanischen Energieministerium (DoE). Beginnend im Oktober 1950 fand die letzte Aktualisierung mit dem Ende des Jahres 2000 statt. Zu diesem Zeitpunkt waren 55% der untersuchten Überlebenden verstorben. (Es gibt eine weitere Aktualisierung, die bis Ende 2003 reicht, seitdem wurden aber keine neuen Daten veröffentlicht.)

In der vom RERF erstellten Datenbank werden die Personen in Gruppen nach Alter, Geschlecht und geschätzter Strahlendosis eingeteilt. Alle 5 Jahre wird erfasst, wie viele Personen einer Gruppe noch leben. Aus diesen Daten ist ein Zusammenhang zwischen Dosis und Sterberate klar zu erkennen, man muss sich aber dennoch klar machen, wie hoch die Dosis sein muss, um tatsächlich gefährliche Auswirkungen zu haben. Um dies deutlich zu machen, präsentieren wir hier eine vereinfachte Analyse.

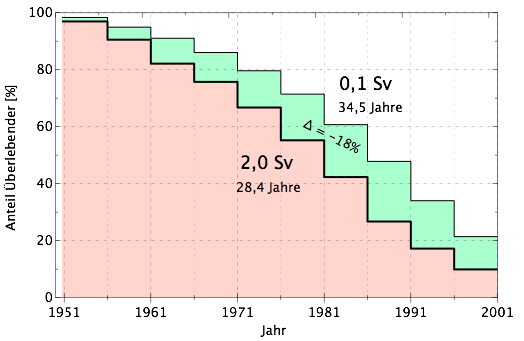

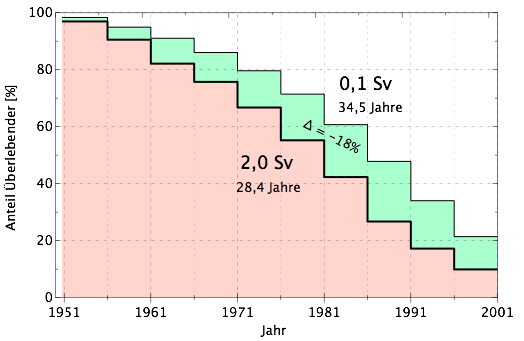

Zur besseren Veranschaulichung haben wir hier nur die Mitglieder der Altersgruppe berücksichtigt, die zum Zeitpunkt der Detonation vor 66 Jahren zwischen 30-45 Jahre alt waren und demnach heute fast alle verstorben sind. Im Jahr 1951 lebten 100% der Personen, weil hier die Erhebungen beginnen. In den Jahren davor, zwischen 1945 und 1951 sind natürlich auch Personen gestorben, die von der Statistik nicht erfasst werden. Diese vermutlich den Nachkriegswirren geschuldete Lücke ist für eine ca. 80 Jahre dauernde Langzeitstudie aber vertretbar. In der Grafik wird zwischen zwei Dosisgruppen unterschieden. Diejenigen, die einer Dosis unter 1,5 Sievert ausgesetzt waren (im Durchschnitt 0,1 Sievert) sind grün gekennzeichnet; die rötlich gefärbten Daten beziehen sich auf eine mit über 1,5 Sievert stark exponierte Gruppe (Durchschnitt 2,0 Sievert).

Hiroshima- und Nagasaki-Überlebende, die zum Zeitpunkt der Bombenabwürfe 30 bis 45 Jahre alt waren. Die Gruppe mit starker Strahlendosis lebt 18% kürzer. (Quelle: IFK)

Man sieht, wie die Anzahl der Personen über die Jahre abnimmt, was zunächst der normalen Sterberate entspricht. Es gibt aber auch einen erkennbaren Unterschied zwischen beiden Gruppen: Personen aus der grünen Gruppe lebten nach dem Jahr 1950 durchschnittlich noch weitere 34,5 Jahre, die Mitglieder der roten, stärker exponierten Gruppe hingegen durchschnittlich nur 28,4 Jahre, also 18% weniger. Das Fazit dieser einfachen Analyse wäre also: Eine Strahlendosis von 2 Sievert verringert die Lebenserwartung um 18%.

Die Einteilung in nur zwei Gruppen ist für die Herleitung eines Risikomodells natürlich zu ungenau. Sie eignet sich aber für eine anschauliche Darstellung der Wirkung um eine Vorstellung der Größe zu entwickeln. 1-2 Sievert ist eine Blitzdosis, die – neben den Bombenopfern – in der Geschichte nur einige wenige Personen in nuklearen Einrichtungen als Folge von Unfällen ertragen mussten. In der Bevölkerung sind derartige Dosen sonst nie auch nur näherungsweise aufgetreten. Anders verhält es sich bei der Langzeitdosis; hier kann allein die natürliche Radioaktivität in Deutschland eine Lebensdosis von 1-2 Sievert verursachen.

Das lineare Modell ohne Schwellenwert (LNT-Modell)

Wie verhält es sich nun mit Dosen kleiner als 2 Sievert? Ist die Annahme, dass 1 Sievert die Lebenserwartung um 9% verringert oder 0,1 Sievert um 0,9%, zulässig? Sie entspräche dem linearen Modell ohne Schwellenwert (Linear No-Threshold = LNT). Mithilfe des LNT-Modells lässt sich das Risiko leicht abschätzen. Es bleibt jedoch zu überprüfen, ob eine derartige Abschätzung mit den Beobachtungen übereinstimmt.

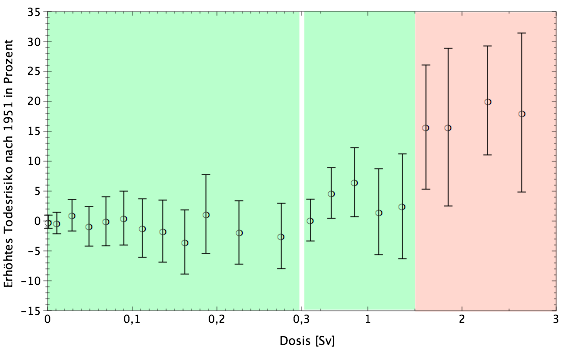

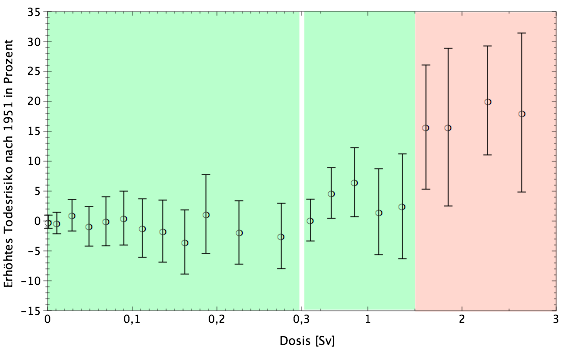

Um das LNT-Modell zu überprüfen, verfeinern wir die obige Dosiseinteilung. Das folgende Diagramm zeigt die verringerte Restlebenserwartung relativ zu der der nichtexponierten Gruppe (Dosis 0 Sievert) in Abhängigkeit von der Dosis.

Erhöhtes Todesrisiko der Hiroshima/Nagasaki-Überlebenden in Abhängigkeit von der Strahlendosis. Zwischen 0 und 0,3 Sievert ist die Skala gestreckt. Die vertikalen Balken sind Unsicherheiten. Bis 1,5 Sievert ist keine Risikoerhöhung innerhalb der Unsicherheiten erkennbar. Anmerkung für Statistiker: Die Unsicherheiten beruhen auf der Annahme einer Poisson-Verteilung. Die Schwankungen sind aber offensichtlich kleiner als die Unsicherheiten. (Quelle: IFK)

Da die Anzahl der untersuchten Personen mit zunehmender Dosis immer kleiner wird, vergrößert sich die statistische Ungenauigkeit. Dies wird in dem Diagramm durch die vertikalen Fehlerbalken dargestellt. Grün unterlegt sind wieder jene Gruppen, deren Mitglieder einer Strahlung von maximal 1,5 Sv ausgesetzt waren, im Schnitt 0,1 Sv. Im rötlichen Bereich liegen die Gruppen zwischen 1,5 und 3,0 Sv, im Schnitt 2 Sv. Die Darstellung unterhalb 0,3 Sievert ist horizontal gestreckt worden, um einzelnen Punkte noch unterscheiden zu können.

Das Diagramm zeigt, dass das Risiko bei einer Blitzdosis von bis zu 0,3 Sievert um Null schwankt, also nicht erhöht ist. Zwischen 0,3 und 1 Sievert scheint es leicht anzusteigen und oberhalb 1 Sievert zunächst wieder abzufallen. Diese Änderungen spielen sich aber innerhalb der Unsicherheiten ab, sind also nicht signifikant. Erst ab 1,5 Sievert wird ein sprunghafter Anstieg der Daten deutlich sichtbar. Wie im vorherigen Abschnitt bereits festgestellt liegt die Risikoerhöhung um 2 Sievert bei 18%.

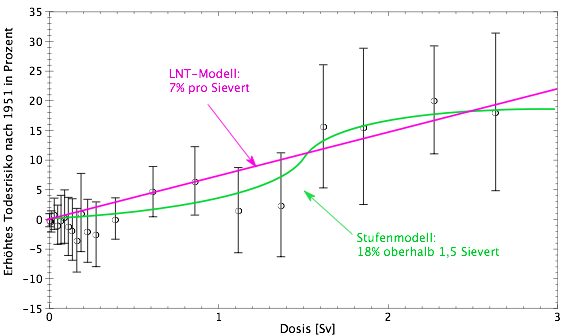

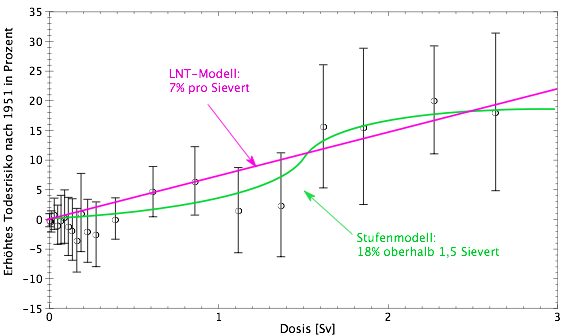

Das folgende Diagramm zeigt die gleichen Daten noch einmal auf einer durchgehenden Dosisskala ohne die Streckung unterhalb 0,3 Sievert. In magenta und grün sind mögliche Modellkurven (grüne Kurve flacher) dargestellt.

Das erhöhte Sterberisiko der Hiroshima- und Nagasaki-Überlebenden, die zum Zeitpunkt der Bombenabwürfe 30-45 Jahre alt waren, dargestellt in Abhängigkeit von der Strahlendosis. Zusätzlich sind 2 Modellfunktionen eingezeichnet. Die LNT-Modellfunktion beschreibt die Beobachtungen nur unzureichend. (Quelle: IFK)

Würde man das LNT-Modell (magenta) nutzen, ergäbe sich eine lineare Risikozunahme von 7% pro Sievert. Die LNT-Gerade läuft aber nur schlecht durch die tatsächlichen Datenpunkte. Sie liegt bei kleinen Dosen über den Daten, bei hohen Dosen jedoch unterhalb der tatsächlichen Beobachtungen. Mit anderen Worten: Das LNT-Modell überschätzt das Risiko geringer Strahlendosen auf Kosten einer Unterschätzung bei hohen Dosen. Wichtiger ist aber die Feststellung, dass unterhalb einer Schwelle gar keine Risikozunahme zu beobachten ist. Dies schließt nicht aus, dass es ein Risiko gibt, nur ist dieses so klein, dass selbst unter Zehntausenden von bestrahlten Personen keine Auffälligkeiten sichtbar sind.

Das LNT-Modell in den wissenschaftlichen und politischen Instanzen

Trotz der erwähnten offensichtlichen Unzulänglichkeiten wurde in den ersten Jahrzehnten nach den Bombenabwürfen das LNT-Modell zur Grundlage für den Strahlenschutz, um wenigstens einen theoretischen Ansatz für den Umgang mit geringer radioaktiver Strahlung zu haben. Dabei war den Strahlenschutzexperten implizit bewusst, dass für Dosen unterhalb einiger hundert Millisievert keine gesundheitlichen Auswirkungen bekannt sind.

Es sei noch einmal ausdrücklich darauf hingewiesen, dass das LNT-Modell doppelt unzulänglich ist:

- Das LNT-Modell basiert nur auf den Beobachtungen einer Blitzdosis, die sich nicht auf Langzeitdosen übertragen lassen.

- Selbst die Beobachtungen der Blitzdosis deuten klar auf einen Schwellenwert hin, im Widerspruch zum LNT-Modell.

Das 1955 gegründete "United Nations Scientific Committee on the Effects of Atomic Radiation", UNSCEAR, gab 1958 einen ersten Bericht heraus, in dem verschiedene Modelle zur Abschätzung der Gesundheitsrisiken durch radioaktive Strahlung vorgestellt wurden. Die Diskussion ist auch im Zusammenhang mit den gesundheitlichen Auswirkungen der damaligen Kernwaffentests zu sehen. So kommt UNSCEAR zu dem Schluss, dass weltweit 60.000 Leukämiefälle oder kein einziger als eine Folge der nuklearen Waffentests gewertet werden müssen, je nachdem ob die Daten mit einem Modell ohne Schwelle oder mit einer Schwelle von 60 Millisievert pro Jahr (über eine Lebensspanne von 70 Jahren) ausgewertet wurden. Auch in den neueren UNSCEAR-Reports werden Schwellenwerte im Hundert-Millisievert-Bereich diskutiert, neuerdings auch auf mikrobiologischer Basis.

Bezugnehmend auf die von UNSCEAR diskutierten Probleme mit einem Modell ohne Schwellenwert gibt die Internationale Strahlenschutzkommission ICRP in ihren Empfehlungen (zuletzt Report 103) ein erhöhtes Krebserkrankungsrisiko von 4% pro Sievert vor. Dieses Risiko, so ICRP, skaliere unterhalb 100 Millisievert linear mit der Dosis. wobei ein Gewichtungsfaktor ausdrücklich zugelassen wird (Report 103, Abs. 65). Schon im folgenden Absatz 66 wird darauf hingewiesen, dass das LNT nur als praktische Anleitung für den Strahlenschutz, nicht aber zur Schätzung des Gesundheitszustands einer großen Bevölkerung mit geringer Langzeitdosis anzuwenden sei. Diese umständlichen Formulierungen rühren von der nicht sauberen Unterscheidung zwischen Blitzdosis und Langzeitdosis her.

Zusammenfassung

Die hier gezeigte Dosis-Wirkungsbeziehung für eine exemplarische Auswahl der Hiroshima- und Nagasakiüberlebenden lässt einen Schwellenwert bei mindestens einigen hundert Millisievert vermuten. Überdies lässt sich das Modell einer Blitzdosis nicht auf eine Langzeitdosis übertragen.

Dennoch empfiehlt die Internationale Strahlenschutzkommission ICRP basierend auf den Hiroshima- und Nagasakidaten für den Strahlenschutz ein lineares Modell ohne Schwelle, schließt die Anwendung auf eine größere Bevölkerung aber gleichzeitig aus. Diese letzte Aussage wird oft übersehen; der oft zitierte Satz "Jede Strahlendosis ist gefährlich" hat seinen Ursprung diesem falschen Verständnis des LNT-Modells.

Die Blitzdosis-Gruppe der 90.000 Hiroshima- und Nagasakiüberlebenden war lange Zeit die einzige Quelle zur Erfassung statistischer Langzeitwirkungen. Inzwischen gibt es aber statistisch gut gesicherte Untersuchungen, bei denen eine große Gruppe einer überhöhten Langzeitdosis ausgesetzt war. Diese Studien sind noch nicht oder nur zu einem geringen Teil in die ICRP- und UNSCEAR-Berichte eingeflossen.

von Götz Ruprecht, Institut für Festkörper-Kernphysik Berlin Den Originalartikel gibt es hier.

Quellen

- Oranisationen:

- Sehr schöne Übersicht über Fehlanwendungen des LNT-Modells, insbesondere zu Tschernobyl:

Z. Jaworowski, "Observations on the Chernobyl Disaster and LNT", Dose-Response 8 (2010) 148, DOI: 10.2203/dose-response.09-029.Jaworowski

- Zu DNA-Reparaturmechanismen und -zeiten:

G. Iliakis, et al., "Mechanisms of DNA double strand break repair and chromosome aberration formation", Cytogenet Genome Res. 104 (2004) 14, DOI: 10.1159/000077461

- Zum Hormesis-Vorfall in Taiwan:

S.-L. Hwang, et al. "Cancer risks in a population with prolonged low dose-rate Gamma-radiation exposure in radiocontaminated buildings, 1983-2002". International Journal of Radiation Biology 82 (2006) 849. DOI:10.1080/09553000601085980

- Zu eindeutig deterministischen Strahlenschäden durch Blitzdosis:

J. Schoenen, "Historische Strahlenunfälle bis 1945", Medizinisches ABC-Manual