Golfstrom im Visier der Klima-Alarmisten!

Seit einiger Zeit kann man Schlagzeilen dieser Art lesen [4]: "Forscher warnen – Der Golfstrom läuft heiß", dagegen aber auch [5]: "Golfstrom ist stabil" und [6] "Kein Trend bei der Meeresströmung an der Grönland-Schottland-Schwelle".

Der Golfstrom

Das weiß jeder: Die warme Meeres-Strömung namens Golfstrom transportiert große Mengen warmen Wassers von West nach Ost über den Nordatlantik und sorgt an den Westküsten Europas zwischen etwa 50 und 70 Grad nördlicher Breite ganzjährig für ein mildes Klima. Diese Wohltat der Natur begreift man erst, wenn man in der genannten geographischen Breite über den Atlantik an die Ostküste des nordamerikanische Kontinents schaut. Dort bestimmt der Antagonist des Golfstroms Wetter und Klima, nämlich der aus der eisigen Baffin-Bay nach Süden strömende kalte Labrador-Strom. So hat St. Jones an der Ostküste von Neufundland in 47°N ein Jahresmittel von 5°C, dagegen haben am Westeingang des Englischen Kanals die Orte Brest auf 48°N und Plymouth auf 50°N ein Jahresmittel von jeweils 11°C ! Das sind Wetter- und Klima-Welten in einer anderen Liga!

Wer von den historischen Seefahrern diese quer über den Atlantik reichende Meeres-Strömung als erster bemerkt hat, wird im Dunkel der Geschichte verborgen bleiben. Fest steht soviel [7]: "1513 entdeckte der spanische Seefahrer Ponce de Leon vor der Küste Floridas eine starke Strömung, die seinen Schiffen das Vorwärtskommen nach Westen erheblich erschwerte. Später wurde diese Strömung als Golfstrom bezeichnet, weil ein großer Teil der Strömung aus dem Golf von Mexiko stammt."

Zur Namensgebung findet man [8] : "Der Name Golfstrom wurde von Benjamin Franklin geprägt und bezieht sich auf den Golf von Mexiko. Früher wurde er auch "Floridastrom“ genannt, auf den Karten des 16. und 17. Jahrhunderts heißt er Canal de Bahama."

Die erste systematische Erfassung und Untersuchung von Meeres-Strömungen, also auch des Golf-Stromes, wurde auf Veranlassung des US-Amerikanischen Seefahrers und Wissenschaftlers Matthew Fontaine Maury (1806-1873) veranlasst [9]: "Maury war Initiator und Organisator der Golfstromforschung, durch die wichtige technische Entwicklungen angestoßen wurden. Diese wurden speziell durch Probleme sowohl bei der Erfassung der Wassertiefe und die Beschaffung von guten Bodenproben als auch durch die Messung der Wassertemperatur als Funktion der Tiefe ausgelöst."

Was treibt die Meeres-Ströme ?

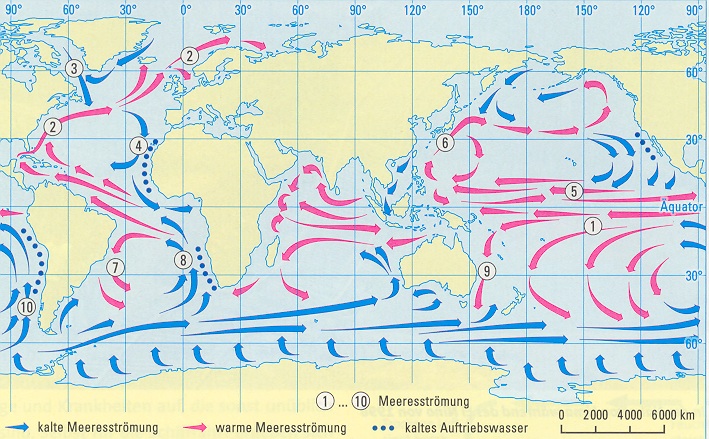

Die Planetarischen Windsysteme sind Ursache und Antrieb der weltweiten Meeres-Ströme (Abb.1).

Abbildung 1

Planetarische Windsysteme

Wie die Abbildungen 1 und 2 veranschaulichen, sind die Passate und die West-Wind-Gürtel dabei von herausragender Bedeutung. Die Zusammenhänge sind unübersehbar.

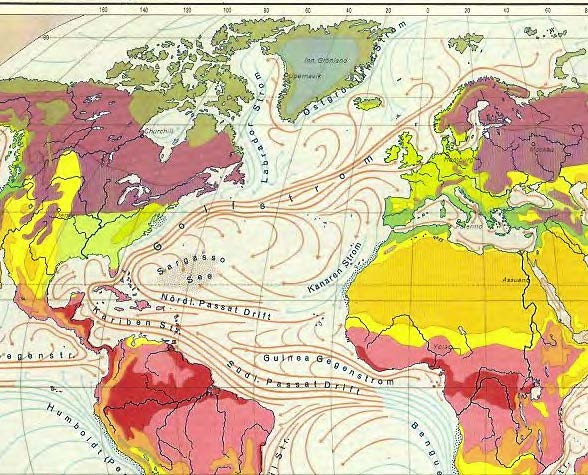

Abbildung 2

Meeres-Ströme, Schema

Auf dem Nord-Atlantik entsteht durch stetigen Nordostpassat die Meeresströmung "Nördliche Passat-Drift" (Abb.3). Dieser Meeres-Strom wird durch die in Strömungsrichtung nach rechts ablenkende Kraft der Erdrotation, die so genannte Coriolis-Kraft, zunächst in eine nach Westen und dann mehr und mehr nach Nordwesten und Norden gerichtete Strömung umgelenkt. Zusätzlich trägt dazu die Küsten-Konfiguration Mittel- und Nordamerikas bei, wie die Abb.3 veranschaulicht. Eine bedeutsame Rolle spielt dabei auch der Golf von Mexiko, letztlich sogar als Namensgeber. Bei 40° Nord – also östlich von New York – hat der Golfstrom eine Strömungs-Geschwindigkeit von 5 km/h. Das ist für einen Meeresstrom gewaltig, die Seefahrer müssen damit seit eh und je zurecht kommen.

Abbildung 3

Entstehung und Verlauf des Golf-Stromes

Meeres-Ströme: "Flüsse" im Meer ?

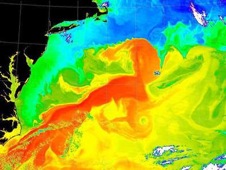

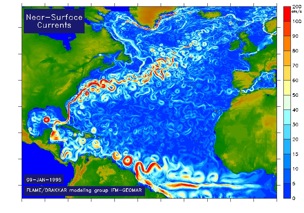

Nein – ganz und gar nicht. Denn es gibt weder Ufer noch sonstige Begrenzungen, abgesehen von Küsten natürlich. So passiert auch bei den Meeres-Strömen das, was wir von jeglicher strömender, fließender Materie auf der Erde kennen: Infolge von Reibungen, physikalischen Instabilitäten, Temperatur- und Dichte-Unterschieden, Corioliskraft sowie auch Wetterlagen (Stürme) bilden sich Wirbel in verschienen Größenordnungen. Die Natur arbeitet in Wirbeln, fast überall, insbesondere auch in der Atmosphäre. Wirbel transportieren Masse und Energie. Natürlich entstehen bei Meeres-Strömen durch Wind und Wellen auch vertikale Wirbel, im Wesentlichen in den oberen Dekametern. Die Wirbel an der Meeres-Oberfläche sind seit etwa 20 Jahren in den Infrarot-Aufnahmen der Satelliten erkennbar, auch beim Golfstrom – Abb.4.

Abbildung 4

Infrarot-Bild des Golf-Stromes [10]

Aus vielen solcher IR-Aufnahmen kann man dann ein detailliertes Schema modellieren, wie in der Abb. 5 dargestellt [11].

Abbildung 5

Modell-Bild des Golf-Stromes [11]

In den Abbildungen 3 und 5 ist erkennbar, daß der Golfstrom nach dem Einschwenken in die gemäßigten Breiten nun von den Stürmen des Westwind-Gürtels in östlicher Richtung weiter getrieben wird. Dabei fächert der Golfstrom auf (èAbb. 3). Der Hauptstrom geht an Irland, Schottland und Skandinavien vorbei bis in Barents-See, und sorgt entlang seiner Bahn ganzjährig für eisfreie Häfen. Ein kräftiger Seitenarm schwenkt in die Biskaya und den Englischen Kanal. Ein anderer Arm zweigt ab in die Irminger See, und zum Teil sogar weiter zwischen Grönland und Island hindurch nach Norden.

Die thermo-haline Zirkulation

Der Golfstrom verliert auf seinem Weg durch die Subtropen und die gemäßigten Breiten Wasser und Wärme durch Verdunstung. Hinzu kommt ein Verlust von fühlbarer Wärme an die immer kälter werdende Luft, je weiter der Golfstrom nach Norden kommt. Infolge von Verdunstung und Temperatur-Abfall steigt die Salz-Konzentration, das Wasser wird dichter und – bezogen auf die Volumen-Einheit – damit auch "schwerer". So beginnt in höheren Breiten ein Absinken des Golf-Oberflächen-Wassers. Das hat eine masse-ausgleichende Gegenströmung zu Folge: Kaltes Tiefenwasser strömt aus nördlichen Breiten nach Süden. Damit gibt es also – zusätzlich zu den o.a. Windsystemen (Abb. 1) – für das System der Meeres-Strömungen mit dieser thermo-halinen Zirkulation einen weiteren Antrieb, der wie eine "Umwälzpumpe" wirkt.

AGW: Kollabiert der Golfstrom ?

Im Zusammenhang mit der seit etwa 150 Jahren gemessenen mäßigen Erderwärmung von einem Dreiviertel Grad werden nun immer wieder Horror-Meldungen durch die Medien gejagt – z.B. derart, daß es zu einem Kollaps des Golfstromes und damit zu einer "Europäischen Eiszeit" kommen könne.

Dabei werden häufig zunächst drei Aspekte außer Acht gelassen:

(1) Schwingungen und Veränderungen (auch) des Golfstroms gehören zur Normalität der globalen Zirkulationen;

(2) Selbst in den Warmzeiten unserer aktuellen Klima-Periode (Holozän) hat es keine solche Kollapse gegeben, obwohl z.B. die Temperaturen während der Optima des Holozäns (4000-8000 vor heute), der Römer (um 2000 v.h.) und des Mittelalters (um 1000 v.h.) phasenweise höher lagen als heute;

(3) Es gibt zwar auch in den letzte Jahrzehnten "Pendelungen" im Golfstroms bezüglich Strömungs- und Temperatur-Änderungen, aber keinerlei Anzeichen für dramatische Veränderungen oder gar Umbrüche.

So ließ jüngst das MPI Hamburg zu (1) verlauten [12] :

"Doch was die Forscher noch gar nicht so lange wissen: Die Zirkulation schwankt. Sie variiert mit den Jahren und kann mal schwächer, dann wieder stärker ausfallen."

Bei den Diskussionen zum Golfstrom sollte man – zumindest im Ansatz – zwei Aspekte unterscheiden:

(A) Änderungen der Strömung in Intensität und Richtung, als ggf. signifikante Abweichungen von normalen säkularen Schwingungen;

(B) Temperatur-Änderungen, ebenfalls unter dem Gesichtspunkt extremer Veränderungen gegenüber normaler säkularer Fluktuation.

Zu alledem gibt es eine Menge Literatur, mit z.T. widersprüchlichen Aussagen.

Intensität und Richtung

Seit 1996 beobachten und untersuchen Forschungs-Institute aus Kiel [13] in einem umfangreichen Projekt den Golfstrom: "Nahezu alle Klimamodelle zeigen, dass sich der Golfstrom in Zukunft abschwächen wird und einige unserer ausländischen Kollegen meinten, erste Anzeichen dafür in Messdaten erkennen zu können … Dies konnte aber in den von uns durchgeführten Langzeitbeobachtungen nicht bestätigt werden“. Und weiter heißt es in diesem Forschungsbericht: "Selbst wenn sich die Vorhersagen der Klimamodelle bestätigen sollten, werden wir hier in Europa nicht über kurz oder lang in eine Eiszeit rutschen … Bestenfalls wird die zu erwartende Klimaerwärmung in Nordeuropa etwas moderater ausfallen".

Für die Seegebiete vor Neufundland, in dem Golf- und Labrador-Strom aufeinander treffen, gibt es ebenfalls Ernüchterung: "Anders als erwartet zeigten die Strömungsmessungen am Ausgang der Labradorsee zwar große Schwankungen über Zeiträume von Wochen und Monaten, aber bislang keine dramatischen langfristigen Trends, die auf eine Abnahme der Golfstromzirkulation hindeuten würden."

Sogar in den katastrophilen Medien [5] steht dann manchmal Sachliches:

"Entgegen Befürchtungen von Klimaexperten ist der Golfstrom in den vergangenen Jahren nicht schwächer geworden. Seit 1995 habe die warme Meeresströmung, die für das Klima in Europa von großer Bedeutung ist, keinerlei Anzeichen einer Verlangsamung gezeigt, berichtet der NASA-Ozeanograf Josh Willis in der Fachzeitschrift ‚Geophysical Research Letters‘. Seine Studie stützt sich auf Satellitenbilder und Messdaten von mehr als 3000 Forschungs-Bojen, die unter anderem Informationen über Temperatur und Salzgehalt lieferten. Die Fließgeschwindigkeit des Golfstroms habe sich demnach sogar leicht erhöht, was einem natürlichen Zyklus entspreche. Klimaforscher hatten indes vorhergesagt, daß die globale Erwärmung und das mit ihr einher gehende Abschmelzen polarer Gletscher viel Süßwasser in den Atlantik spülen würde. Dadurch könnte, so ihre Befürchtung, der Golfstrom abgeschwächt werden."

Von Grönland über Island bis nach Schottland erstreckt sich am Meeresboden ein Höhenrücken – die Grönland-Schottland-Schwelle. Diese wirkt hemmend für den Wasser-Austausch, folglich auch bei Meeres-Strömen. Wenn der kalte nördliche Tiefenstrom sich in diesem Bereich verändert, so kann sich das auch auf den in oberen Atlantik-Schichten nach Norden fließenden Golfstrom auswirken, wegen einer abschwächenden themo-halinen Zirkulation (vgl.w.o.). Das wurde bereits 1973 in einer großen internationalen Forschungs-Expedition untersucht [14], und die Ergebnisse bis heute immer wieder überprüft [6]: "Kein Trend bei der Meeresströmung an der Grönland-Schotland-Schwelle : … Im Nordatlantik fließt warmes Wasser in den Arktisraum, sinkt dort durch Abkühlung ab, und gelangt als Tiefenwasser wieder nach Süden. Bisher wird vermutet, daß sich zukünftig diese Zirkulation durch den Klimawandel abschwächen kann. Messungen und Modellrechnungen einer neuen Studie lassen aber zumindest lokal für die Tiefenwasser-Strömung in der Nähe der Faröer-Inseln keinen Trend seit 60 Jahren feststellen."

Bleibt festzuhalten:

In den letzten 60 Jahren keine signifikanten Änderungen, kein Klima-Trend!

Golfstrom-Prognose möglich ?

Neuerdings gibt es Ansätze, den Golfstrom zu modellieren [12] : "Nun präsentieren Hamburger Klimaforscher im Fachmagazin "Science" ein Verfahren, mit dem sich die Schwankungen des Golfstroms treffsicher prognostizieren lassen."

Bei den Untersuchungen dazu gab es offensichtlich Erkenntnisse, die den ganzen Golfstrom-Alarmismus der letzten Jahre widerlegen: "Bis 2014 bleiben Atlantikzirkulation und Golfstrom weitgehend konstant und ändern sich kaum." …. "Eine durchaus beruhigende Nachricht. Denn im Frühjahr 2010 hatte es so ausgesehen, als würde die Zirkulation nachlassen. Manche werteten das schon als Zeichen einer dauerhaften Abschwächung oder gar eines Versiegens des Golfstroms, und zwar als mögliche Folge des Klimawandels. Doch heute ist klar: Das Nachlassen der Zirkulation vor zwei Jahren war nichts anderes als ein Intermezzo, hervorgerufen durch kurzzeitige Störungen in der Atmosphäre."

Ist nun eine Vorhersage des Golfstrom-Verhaltens möglich? Bezüglich des komplizierten Zusammenspiels zwischen Golfstrom, atmosphärischer Zirkulation, Wechselwirkungen mit anderen Meeres-Strömen sowie mit der themo-halinen Zirkulation gilt das, was auch für das ganze Klima-System gilt: Es handelt sich um ein nicht-lineares, überwiegend stochastischen System [15], daher sind Zweifel an einer realistischen Modellierbarkeit und gar Vorhersagbarkeit angebracht. Zumindest das Versagen der Klima-Modelle hinsichtlich der stagnierenden bzw. leicht zurück gehenden Temperaturen der letzten 14 Jahre gestatten auch bezüglich einer Vorhersagbarkeit des Golfstrom-Verhaltens erhebliche Zweifel. Unter all diesen Aspekten mutet die o.a. Aussage [12] über "… ein Verfahren, mit dem sich die Schwankungen des Golfstroms treffsicher prognostizieren lassen" … recht vermessen an. Aber auch hier gilt für Gegenwart und Zukunft: Die Natur schreibt die Wahrheit, und die sieht meist ganz anders aus, als die Ergebnisse der Modell-Szenarien!

Temperaturen des Golfstromes

Die Temperaturen des Oberflächenwassers sinken auf dem langen Weg des Golfstromes von etwa 30°C in den Subtropen bis auf Werte nahe Null in den hohen Breiten ab.

Nun gab es jüngst dramatische Meldungen [16]: "Der Golfstrom dreht Europas Fernheizung auf!", wozu u.a. ausgeführt wurde: Ein "internationales Forscherteam … kommt im Fachmagazin ‚Nature Climate Change‚ zu dem Schluss, dass sich der Golf- beziehungsweise Nordatlantikstrom im Verlauf eines Jahrhunderts doppelt bis dreifach stärker erwärmt hat als der Rest des Atlantiks und die Weltmeere insgesamt. Während der Atlantik an der Oberfläche um 0,9 Grad Celsius zulegte und die Ozeane weltweit um 0,6 Grad, erwärmte sich der Golfstrom um 1,8 Grad."

AGW-Klima-Katastrophe ? Nicht unbedingt, denn (a.a.O.): "Noch ist nicht definitiv geklärt, was Auslöser der Erwärmung ist."

Mehr noch: Noch ist auch nicht geklärt, ob diese Erwärmungs-Meldungen überhaupt signifikant und bewiesen sind, denn z.B. die Messungen des ARGO-Bojen-Systems zeigen das nicht (vgl.w.u.).

Dennoch Alarm (a.a.O.): "Die thermohaline Zirkulation könnte im Extremfall ganz zum Stillstand kommen", …aber zugleich wieder Entwarnung: "In diesem Jahrhundert wird dies allerdings kaum passieren".

Und dann wird – ausnahmsweise – auch mal darauf hingewiesen, daß weder die Forscher noch die Modelle irgend etwas im Griff haben (a.a.O.): "An diesem Punkt sehen sich die Forscher mit einer verzwickten Situation konfrontiert. Was überwiegt: die gerade entdeckten überproportional steigenden Temperaturen des Golfstroms, die dem Norden mehr Wärme bringen? Oder dessen Stocken, was Europas Fernheizung drosselt? Die Forscher wissen es noch nicht."

Schließlich wird für die ganz Ängstlichen sogar noch eine kleine Beruhigungspille verabreicht [16]: "Keineswegs würde das Stocken des Nordatlantikstroms also bedeuten, dass sich die Nordhemisphäre plötzlich dramatisch abkühlt".

Fazit: Vielleicht rettet AGW uns Europäer doch noch vor der Kälte-Starre ?

Wie dem auch sei – einer Nachprüfung halten die angeblich dramatischen Anstiege von Golfstrom-Temperaturen nicht stand, denn umfangreiche und langfristige Messungen der Temperaturen der Weltmeere u.a. auch mit dem Bojen-System ARGO finden nichts dergleichen:

Meeres-Temperaturen

Alarmistische Behauptungen, die Meere würden sich dramatisch erwärmen, werden durch Messungen widerlegt.

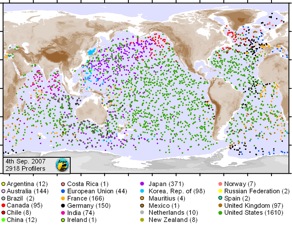

Zum Beispiel: Seit 1999 gibt es ein globales Netz von mittlerweile 3000 Bojen, die durch Auf- und Absteigen in den oberen 2000 Metern die Meeres-Temperaturen messen : ARGO.

Abb. 6

Das Bojen-System ARGO

Auswertungen von ARGO ergaben zum Beispiel [17]:

"Die ARGO-Bojen haben die AGW-Alarmisten enttäuscht, weil sie keinerlei Anzeichen für einen bevorstehenden Klimawandel gefunden haben. Wie Dr. Josh Willis, der für das Jet Propulsion Laboratory (JPL) der NASA arbeitet, in einem Interview mit National Public Radio bemerkte: Es gab eine ganz schwache Abkühlung …. aber das ist nicht wirklich signifikant.”

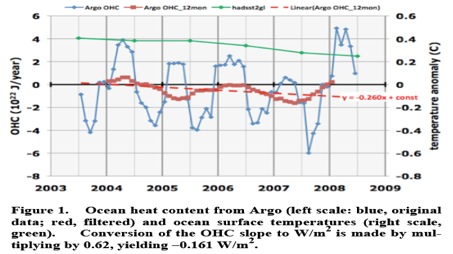

Eine Übersicht zu den zeitlichen Verläufen von Meeres-Temperaturen auf den Ozeanen geben die Abbildungen 7 bis 13 :

Abb. 7 [18]

Wasser-Temperaturen (SST) ARGO ; 2003-2008;

Fluktuationen, aber kein Trend.

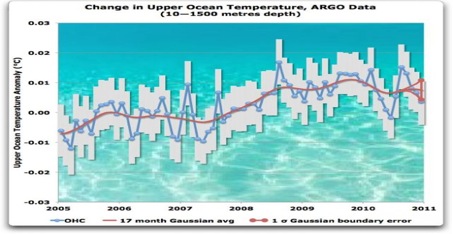

Abb. 8 [19]

Wasser-Temperaturen ARGO (10 – 1500 Meter Tiefe); 2005-2011;

Fluktuationen im Bereich von Hundertstel(!) Graden, aber kein Trend.

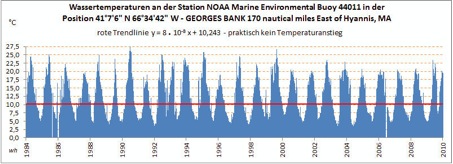

Abb. 9

Wasser-Temperaturen östlich vor New York (1984-2010);

Die erheblichen Temperatur-Schwankungen zwischen 27°C im Sommer

und 5°C im Winter lassen erkennen, daß diese Meßboje im

mäandernden Bereich zwischen Golf- und Labrador-Strom liegt (è Abb.3);

Fluktuationen, aber kein Trend.

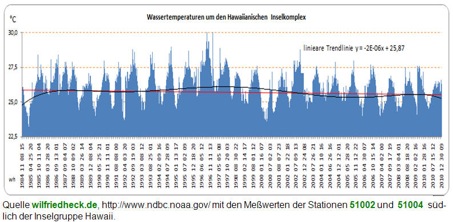

Abb. 10

Wasser-Temperaturen im Pazifik (Hawaii-Inseln);

1984 – 2010; Fluktuationen, aber kein Trend.

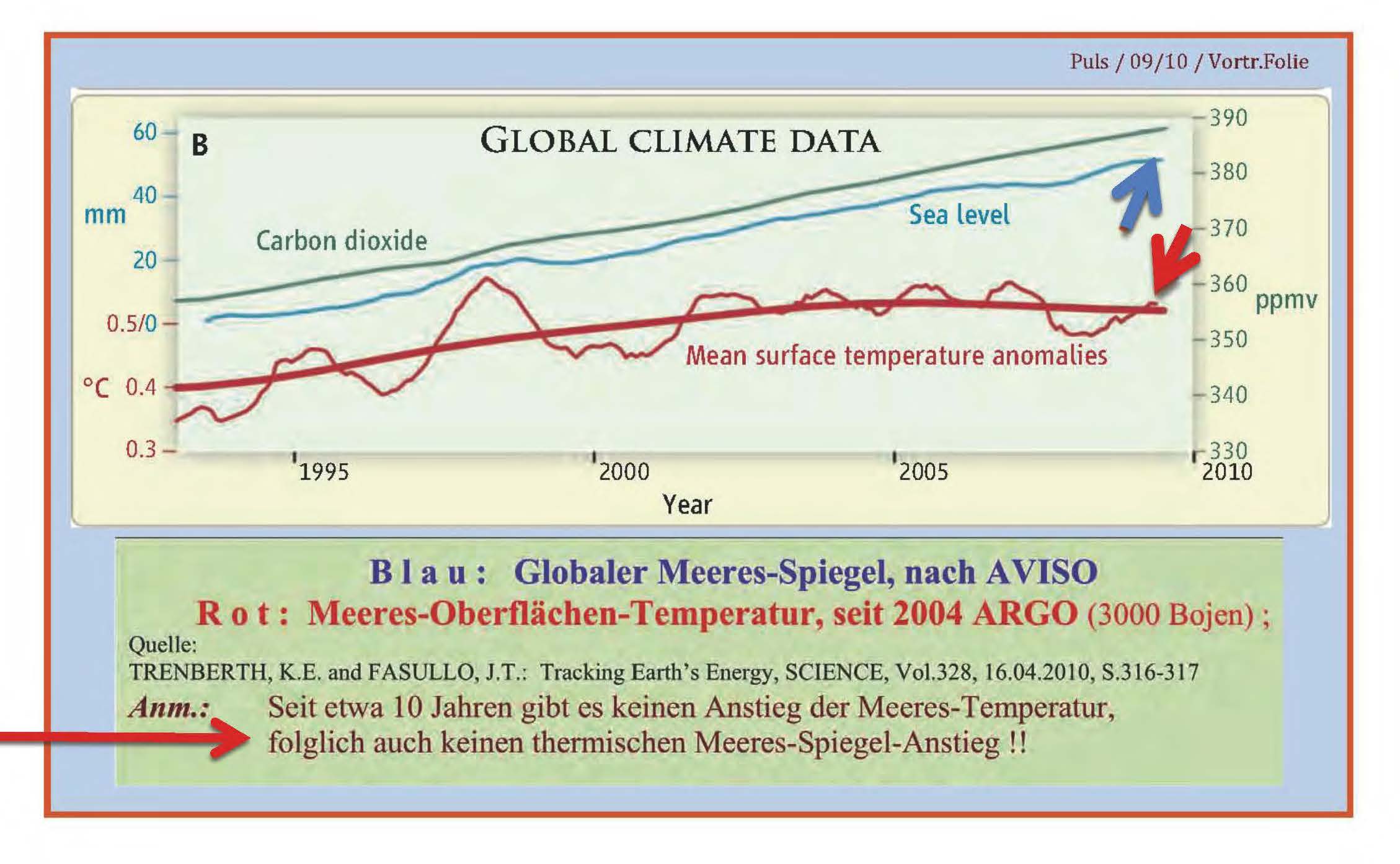

Abb. 11

Trends von CO2, Sea-Level und Meeres-Temperaturen (1993-2009)

(Hinweis-Pfeile eingefügt)

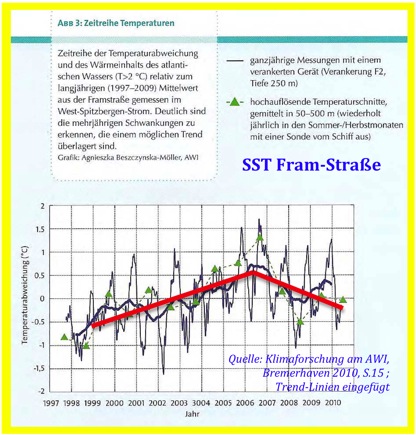

Auch in der Fram-Sraße zwischen Grönland und Spitzbergen ist kein Erwärmungs-Trend erkennbar, obwohl die Arktis sich angeblich dramatisch erwärmt :

Abb. 12

Meeres-Temperaturen (0 – 500 Meter Tiefe) in der Fram-Straße

zwischen Grönland und Neufundland; 1997-2010.

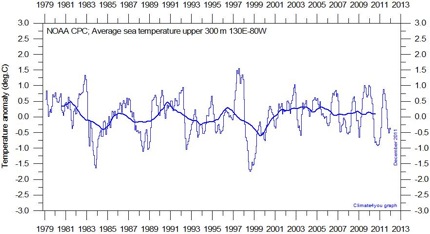

Abb. 13

Meeres-Temperaturen in den oberen 300 Metern;

Pazifik 130°E – 80°W; 1979-2011;

Fluktuationen, aber kein Trend.

=================================================================

F a z i t

Als Fazit genügt hier die Einschätzung zweier Fach-Institute, welche die Golf-Strom-Debatte kurz+knapp auf den Punkt bringen:

(1) Das Max-Planck-Institut in Hamburg: [20]

"Kann die globale Erwärmung zum Abriss des Golfstroms führen? Kann dies eine neue Eiszeit hervorrufen? Die kurze Antwort ist: Nein. Einen Golfstrom wird es immer geben, solange der Atlantik von Kontinenten umgeben ist, sich die Erde dreht und die Passat- und Westwinde wehen. Der Golfstrom kann also nicht abreißen. Ebensowenig kann die menschengemachte globale Erwärmung eine globale Abkühlung, vergleichbar mit der letzten Eiszeit, nach sich ziehen."

(2) Der Deutsche Wetterdienst: [21]

"Über eine Abschwächung des Golfstromes bei weiter zunehmender globaler Erwärmung wird immer wieder spekuliert. Bisher liegen jedoch keine verläßlichen Messungen über eine Abschwächung vor. Vorübergehende Schwankungen sind normal."

Klaus-Eckart Puls EIKE

Q u e l l e n :

[1] http://www.eike-klima-energie.eu/news-cache/g-l-o-b-a-l-c-o-o-l-i-n-g-wo-bleibt-die-erderwaermung/ ; 25.02.2012

[2] (a) http://www.eike-klima-energie.eu/news-cache/aktuell-zur-durban-un-klimakonferenz-neuer-ipcc-bericht-zunahme-von-extremwetterlagen/ ; 23.11.2011

(b) http://www.eike-klima-energie.eu/news-cache/presseschau-zum-ipcc-extremwetterbericht-mehr-extremwetter-fehlanzeige/ 09.12.2011

[3] http://www.eike-klima-energie.eu/climategate-anzeige/falscher-pik-alarm-beim-meeres-spiegel-neue-satelliten-daten-zeigen-keinen-grund-fuer-alarmismus/ 16.07.2011

[4] http://www.welt.de/wissenschaft/umwelt/article13840350/Forscher-warnen-Der-Golfstrom-laeuft-heiss.html ; 29.01.2012

[5] DIE WELT: Wissenschaft/Umwelt, 03.04.2010

[6] Naturwissenschaftliche Rundschau, Heft 2 (2009), Seite 82-83

[7] http://www.google.com/imghp

[8] http://de.wikipedia.org/wiki/Golfstrom#Entstehung

[9] R. A. Krause, Matthew Fontaine Maury, Pathfinder of the Seas, Deutsches Schiffahrtsarchiv, 32 (2009), Oceanum Verlag

[10] http://www.revelation-of-silence.com/upload/golfstrom.jpg

[11] http://www.ifm-geomar.de/index.php?id=3583

[12] http://www.dradio.de/dlf/sendungen/forschak/1646447/

Deutschlandfunk, Forschung aktuell : Stabile Wärmepumpe, 6. Januar 2012

[13] http://www.ifm-geomar.de/index.php?id=3583 ; 16.11.2010

PULS, K.E.; MEINCKE, J.: General Atmospheric Circulation and Weather Conditions in

the Greenland-Scotland-Area for August and September 1973, "Overflow ’73" – Expedition

Contribution No.17, Ber.Inst.f.Meeresk.Univ.Kiel, Nr.14 (1975), 24 S.

[14] PULS, K.E.; MEINCKE, J.: General Atmospheric Circulation and Weather Conditions in the Greenland-Scotland-Area for August and September 1973, "Overflow ’73" – Expedition Contribution No.17, Ber.Inst.f.Meeresk.Univ.Kiel, Nr.14 (1975), 24 S.

[15] IPCC, 3. Ass.Rep., 2001, Sect. 14.2.2.2, S. 774

[16] DIE WELT, 01.02.2012; http://www.welt.de/wissenschaft/umwelt/article13845405/Der-Golfstrom-dreht-Europas-Fernheizung-auf.html?wtmc=Newsletter.NL_Weltbewegt

[17] http://www.klimaskeptiker.info/index.php?seite=einzelmeldung.php?nachrichtid=407 ; 26.03.2008

[18] http://www.klimaskeptiker.info/index.php?seite=einzelmeldung.php?nachrichtid=1504 ; 16.01.2012

[19] http://www.eike-klima-energie.eu/climategate-anzeige/mr-spock-uebernehmen-sie-ueber-die-bearbeitung-der-daten-der-argo-bojen/ ; 16.01.2012

[20] MPI Hamburg; http://www.mpimet.mpg.de/aktuelles/presse/faq-haeufig-gestellte-fragen/kann-die-globale-erwaermung-zum-abriss-des-golfstroms-fuehren-kann-dies-eine-neue-eiszeit-hervorrufen.html, August 2011

[21] DWD, Gerhard Müller-Westermeier, Leiter DWD-Abt. "Nationale Klima-Überwachung": "Wetter ist nun mal chaotisch", Sächs.Zeitg., 01.02.2011, S.5