Die vorgeschlagenen Regulationen wurden mit der vom (IPCC),[1] in Worte gekleideten betrügerischen Auffassung begründet, dass zunehmende atmosphärische CO2-Konzentrationen das Klima dramatisch verändern würden, was in der Folge zu wesentlichen ökologischen und ökonomischen Schäden führen würde.

Während viele Wissenschaftler einschließlich uns beiden einige Änderungen des Klimas beobachtet haben, sind die hypothetischen gefährlichen Konsequenzen des steigenden atmosphärischen CO2-Gehaltes zu spekulativ für eine verantwortbare Regulations-Politik. Bei der Analyse der Klimapolitik sollten die Entscheidungsträger drei Schlüsselüberlegungen durchführen hinsichtlich der Auswirkung des projizierten CO2-Anstiegs: (1) politische Entscheidungen werden wahrscheinlich keinen messbaren Effekt auf Extremwetterereignisse haben; (2) positive Auswirkungen auf Ökosysteme und die Biodiversität sind wahrscheinlich und sollten gegen die Negativa abgewogen werden; und (3) es ist unwahrscheinlich, dass Kohlenstoffhandels-Schemata (wie das in Kopenhagen so aufdringlich verkündete) zu einer Reduktion des CO2 in der Atmosphäre führen werden.

Mit diesen Überlegungen müssen politische Entscheidungsträger sorgfältig ihre Ziele und die potentiellen Auswirkungen einer Kohlenstoff-Emissionskontrolle abwägen, sowohl positiv als auch negativ. Sollte diese Regelung der Klimaänderung unbewertet weitergehen, wird es wahrscheinlich zu politischen Maßnahmen führen, die jeden Kontakt sowohl zur realen Welt als auch objektiver Wissenschaft verlieren. Außerdem werden wahrscheinlich der Gesellschaft horrende Kosten entstehen, von denen nur ein kleiner Kader von „Klimaunternehmern” profitiert und die keine bedeutsame Auswirkung auf das Klima der Erde haben werden.

Überlegung Nr. 1: Politiker müssen die Fähigkeit der Menschheit beurteilen, globale und regionale Klimaänderungen beeinflussen zu können

Es stimmt, das seine Fülle von Forschern die Änderungen der lokalen, regionalen und globalen Temperaturen untersucht haben, ebenso wie die Regenmenge, das Tier- und Pflanzenleben sowie den Meeresspiegel; und dass viele die Schlussfolgerung gezogen haben, dass der steigende Gehalt von Treibhausgasen (GHGs) bis zu einem gewissen Grad verantwortlich ist für die beobachteten und/oder für die Zukunft vorhergesagten Klimaänderungen. Politiker sollten jedoch nicht einfach auf diesen Zug aufspringen. Sie haben die Verpflichtung, die Grenzen dieser Studien sorgfältig zu bedenken, ebenso wie die Auswirkung von Faktoren außer dem vom Menschen erzeugten CO2. Es wäre falsch, alle beobachteten Auswirkungen mit der Klimaänderung in Zusammenhang zu bringen – das gilt noch mehr für Treibhausgase – oder gar den Anschein zu erwecken, dass die Menschen hier etwas kontrollieren können. Hier sehen wir die erste Überlegung für die Politiker: Dass der steigende CO2-Gehalt in der Atmosphäre nicht zu ungünstigem Wetter und Klimaänderungen führt, die über die natürlicher Variation hinausgehen.

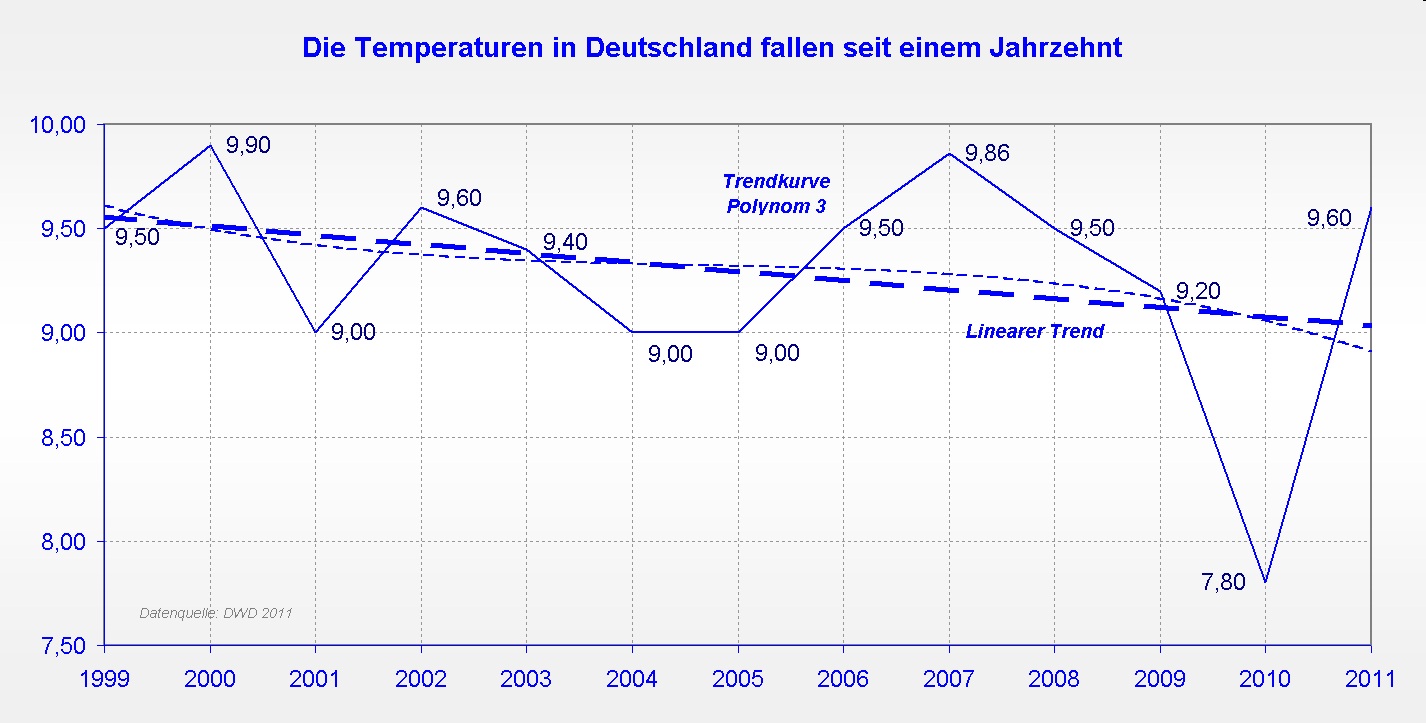

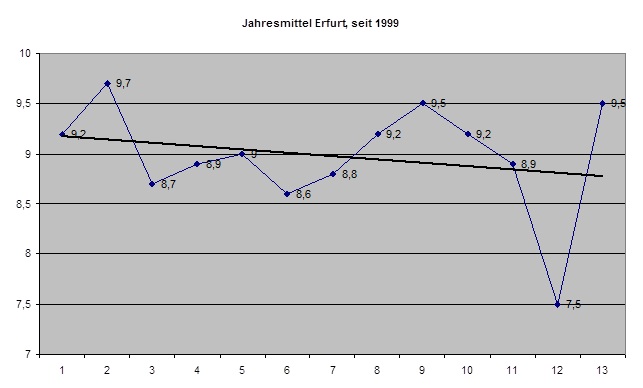

Politiker sollten sich vor Augen führen, dass die Hypothesen des IPCC hinsichtlich zukünftiger Schäden durch den steigenden atmosphärischen CO2-Gehalt durch Beweise widerlegt sind, vor allem durch neueste Daten, die belegen, dass das Märchen von der „globalen Erwärmung“ als Klimaänderung ernstlich auf Betrug beruht [seriously flawed]. Zum Beispiel zeigen die jüngsten Daten der globalen Temperatur und des ozeanischen Wärmegehalts [2] das Gegenteil der Behauptungen über katastrophale Konsequenzen. Während Forscher oft bestimmte Zeitperioden auswählen, um ihre Hypothese der gefährlichen Erwärmung zu untermauern, ist inzwischen offensichtlich, dass Vorhersagen einer fortgesetzten Erwärmung und des Anwachsen des ozeanischen Wärmegehalts im Gegensatz zu Beobachtungen der letzten Dekade stehen [3]. Außerdem haben Computermodellierer Schwierigkeiten, die signifikanten Diskrepanzen zwischen der auf der Basis der gefährlichen CO2-Hypothese vorhergesagten Zunahme des ozeanischen Wärmegehaltes und der beobachteten Daten hierzu zu erklären [4].

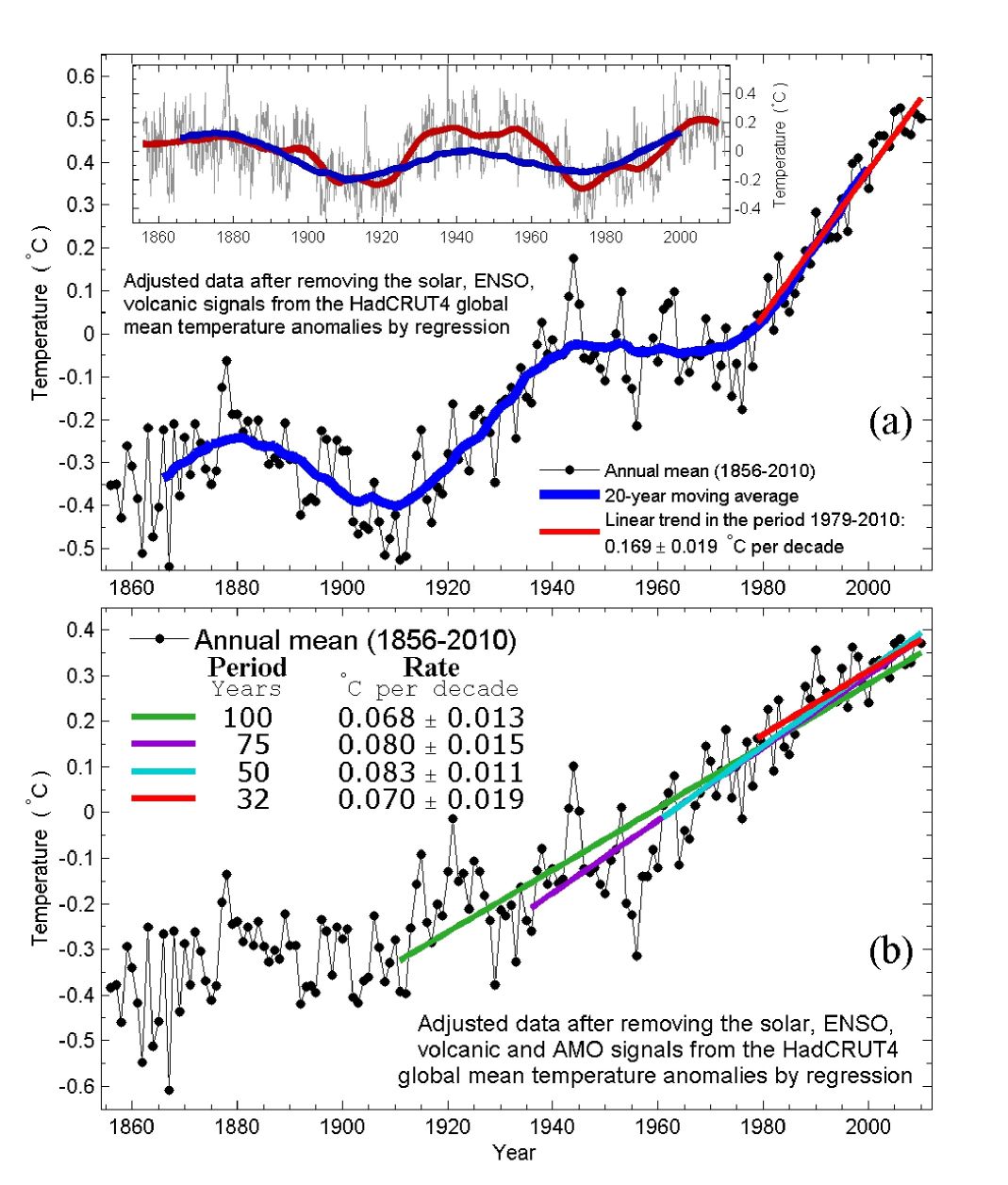

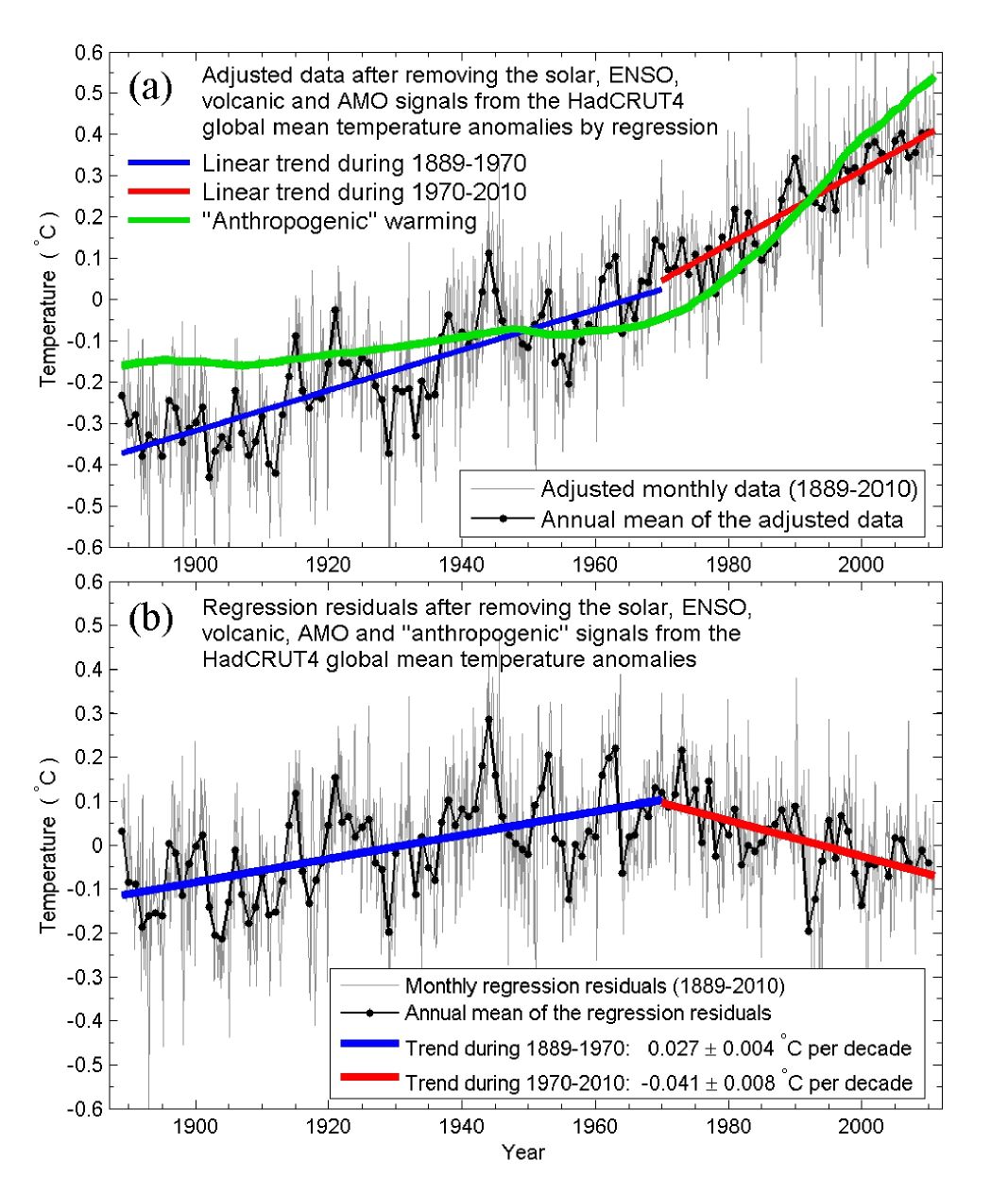

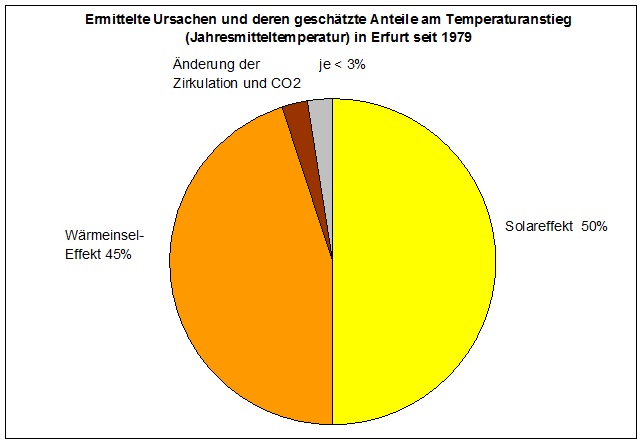

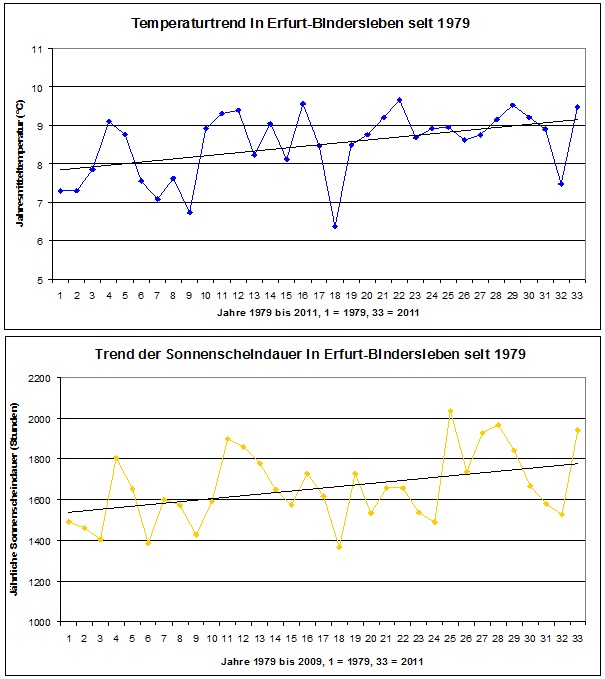

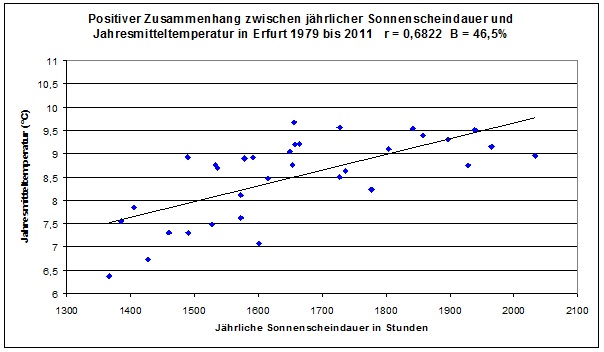

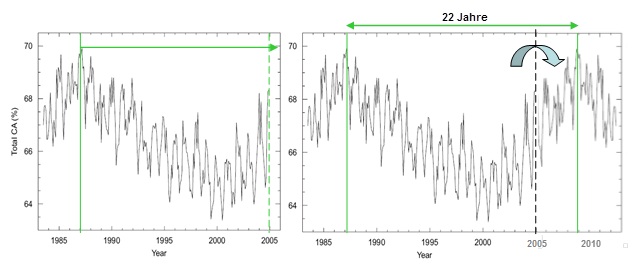

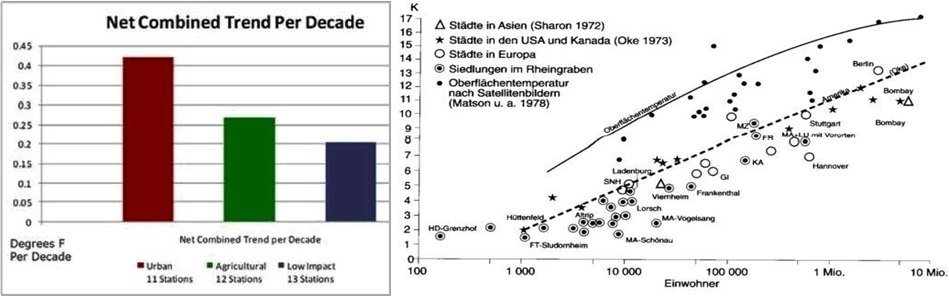

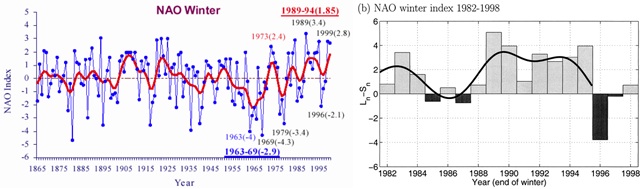

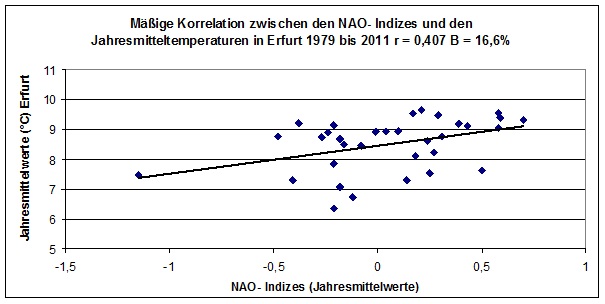

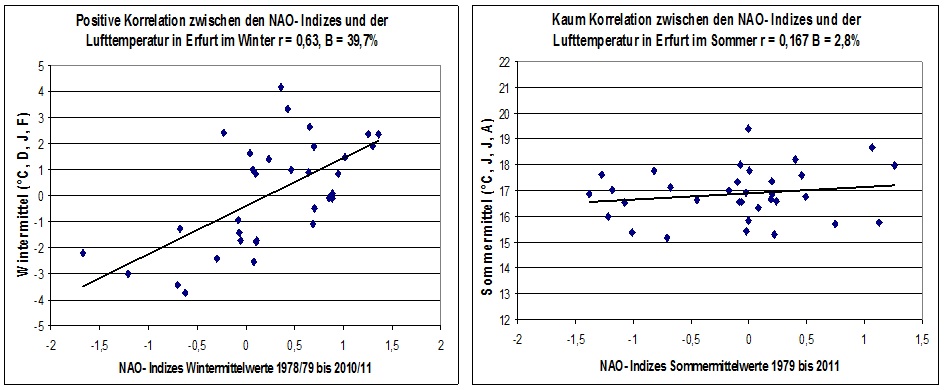

Genauso vorsichtig sollte man sein, wenn man bestimmen will, ob andere Gründe als die GHGs für die beobachteten Effekte in Frage kommen. Von Küstenstationen in Grönland stammende Temperaturdaten aus der Arktis und Mittel über den arktischen Pazifik, den Nordatlantik, Grönland-Island und das gesamte Gebiet rings um die Arktis stehen nicht im Einklang mit dieser Hypothese der gefährlichen, vom Menschen verursachten Erwärmung [5]. Diese Daten zeigen abrupte Erwärmungen und Abkühlungen alle paar Jahrzehnte, die sehr gut zu den natürlichen Fluktuationen der Sonnenaktivität passen [6]. Im Gegensatz dazu erklärt der stetige Anstieg der atmosphärischen CO2-Konzentrationen während des vergangenen Jahrhunderts, einschließlich vor allem der letzten fünfzig Jahre nicht die Variabilität der Temperatur in und um die Arktis, was ein weiterer Beleg dafür ist, dass die Auswirkungen durch etwas Anderes als GHG2 verursacht worden sein könnten [7]. Genauso hat der Nachweis der Erwärmung in den Städten gezeigt, dass Erwärmung und hydrologische Änderungen das direkte Ergebnis des UHI und künstlichen Veränderungen der Landschaft sind, und nicht die atmosphärische CO2-Konzentration [8]. Als Konsequenz wären Politiker gut beraten, auch alternative Gründe für die beobachteten Effekte zu erwägen.

Während einige Forscher einschließlich uns beiden sagen, dass andere Gründe als die GHGs ausschlaggebend für beobachtete Klimaänderungen sind, tun viele dies nicht. Politiker brauchen die Ergebnisse beider Lager nicht zu akzeptieren, sollten aber diese alternativen Ansichten beachten und auch wirklich bedenken, wenn sie ihre Entscheidungen treffen.

Politiker müssen auch das Scheitern der Wissenschaftler, trotz der extensiven und objektiven Bewertung von Klimadaten aus der ganzen Welt während des vergangenen Jahrhunderts [9] ein Erwärmungssignal durch das CO2 zu finden, in Einklang bringen. Wir und andere Wissenschaftler haben eine sehr einfache Erklärung: atmosphärisches CO2 ist kein wichtiger Antrieb von Wetter und Klima [10]. Diese Hypothese steht in sehr scharfem Kontrast zu den Spekulationen der Computermodelle, welche sich durch eine starke Beziehung zwischen atmosphärischem CO2 und der Lufttemperatur auszeichnen [11]. Solche Ergebnisse zeigen, dass simulierte Computermodelle in ihrer Fähigkeit, akkurate Vorhersagen eines Systems vorherzusagen, das so komplex ist wie das Klimasystem, inhärent begrenzt sein könnten. Damit sagen wir nicht, dass Forschung per Computer per se trivial ist; sondern vielmehr, dass diese Simulation noch nicht weit genug entwickelt ist, um zuverlässige Prognosen für politische Entscheidungen zu liefern.

Politiker sind es ihren Wählern schuldig, Entscheidungen nur unter Berücksichtigung aller Informationen zu treffen und alle beobachteten Klimadaten einzubeziehen, anstatt sich auf Ergebnisse der künstlichen Welten von Computer-Klimamodellen zu verlassen.

Überlegung Nr. 2: Politiker müssen sowohl potentielle Vorteile als auch potentielle Kosten eines sich verändernden Klimas abwägen.

Kommentatoren und politische Aktivisten charakterisieren die Klimaänderung oft negativ als einen unnatürlichen Prozess, der nur zu Katastrophen führen könne. Unglücklicherweise haben einige dieser Charakterisierungen Eingang in rechtliche Entscheidungen und legislative Aktionen gefunden, was zu einem Missverständnis über die Natur der Klimaänderung geführt hat [12]. Um diese Schwachstellen in der nächsten Runde von Aktionen bzgl. des Klimawandels zu vermeiden, sollten vernünftige Politiker die Vorstellung zurückweisen, dass ein sich änderndes Klima etwas durchweg Einseitiges ist. Stattdessen sollten sie die bestmöglichen verfügbaren wissenschaftlichen Daten nutzen, um die potentiell positiven Auswirkungen der Klimaänderung gegen die negativen und die Kosten abwägen, um festzulegen, welchen Weg man einschlagen sollte. Folglich sollte bei der Evaluierung der chemischen und biologischen Einflüsse eines steigenden CO2-Gehaltes in der Atmosphäre unserer zweiten Überlegung für Politiker besondere Aufmerksamkeit zuteil werden: Dass die negativen Auswirkungen auf Ökosysteme und die Biodiversität durch den zunehmenden CO2-Gehalt genau gegen dessen Vorteile abgewogen werden.

Politiker müssen sorgfältig den Fehler vermeiden, wissenschaftlich ungenaue Definitionen in Gesetze und Regeln zu gießen. Im Jahr 2007 beispielsweise hat der Oberste Gerichtshof der USA geurteilt, dass Treibhausgase zur umfassenden Definition von „Luftverschmutzern“ im Rahmen des Clean Air Act gehören [13], was zu einer Definition führte, die nicht der Wissenschaft entspricht. Das atmosphärische CO2 ist kein „Luftverschmutzer“, sondern die Basis allen Lebens, genauer aller Photosynthese betreibenden Organismen: grüne Pflanzen, Algen in Süß- und Salzwasser sowie photosynthetische Bakterien [14]. Es bildet die Basis der meisten Nahrungsketten und ist für das biologische Leben unabdingbar. Legale Definitionen, die im Gegensatz zur Wissenschaft stehen, machen es schwierig, sinnvolle Politik in Gang zu setzen.

Ungenaue Beschreibungen können auch zu Übertreibungen hinsichtlich der Gefahren von CO2 führen, die Politiker dazu bringen können, die Dringlichkeit der Lage falsch zu beurteilen. Beispielsweise liegt das heutige CO2-Niveau bei etwa 390 ppm und ist damit nicht „gefährlich hoch“ aus der Perspektive photosynthetischer Organismen [15]. Tatsächlich liegen diese 390 ppm weit unterhalb der Nahrungssättigung für diese Organismen und auch unter dem optimalen Niveau für das Wachstum [16]. Dies bedeutet, dass ein Mehr an CO2 einige kritische Ökosysteme stärken kann; und doch sind es nur wenige Wissenschaftler, Politiker oder „Klima-Unternehmer“, die diese positiven Auswirkungen auf die Pflanzen betrachten. Unabhängig davon können manche maritimen Organismen tatsächlich besser gedeihen und produktiver sein als Folge der Versauerung der Ozeane durch die Lösung von CO2 im Meerwasser [17]. Als Konsequenz werden einige der sofortigen biologischen Reaktionen sehr wahrscheinlich das maritime Leben und die Erzeugung von Nahrung in den Ozeanen stimulieren – höchstwahrscheinlich sind dabei positive synergetische Wechselwirkungen zwischen den Änderungen der Temperatur, der Solarstrahlung und Bikarbonate involviert. Die Biologin und Ozeanographin Dr. Debora Iglesias-Rodriguez fasst die Ergebnisse ihrer Arbeit so zusammen:

Die Zunahme von CO2 in der Erdatmosphäre führt bei einigen mikroskopischen Ozeanpflanzen dazu, dass sie größere Mengen Kalziumkarbonat produzieren – mit potentiell weit reichenden Implikationen bei der Vorhersage des Kohlenstoffkreislaufs in den Ozeanen und die Modellierung des globalen Klimas … Unsere Forschung hat auch gezeigt, dass während der vergangenen 20 Jahre einzellige Algen und Phytoplankton jeweils um 40 Prozent größere Mengen Kalziumkarbonat gebildet haben. Diese Ergebnisse stimmen mit früheren Beobachtungen überein, dass diese Organismen während vergangener Perioden mit einer Versauerung der Ozeane überreichlich vorkamen, so wie es vor etwa 55 Millionen Jahren der Fall war [18].

Eine Untersuchung der Verfahren, die in Studien mit einem gegenteiligen Ergebnis hinsichtlich der Auswirkungen von CO2 auf maritime Organismen angewendet worden waren, hat gezeigt, dass sie ungerechtfertigt behauptet haben, den Säuregehalt der Ozeane durch Hinzufügen von Salzsäure zum Meerwasser zu bestimmen, anstatt sich die Mühe zu machen, CO2 durch das Wasser zu blasen, um natürliche Bedingungen viel besser zu simulieren. Das frühere Verfahren, Säuren oder Basen direkt in das Wasser zu geben, verpasst die Schlüsselwirkung von CO2 mit den Karbonaten und Bikarbonaten geochemischer Zyklen im Ozean, weshalb man zu einer entgegen gesetzten Schlussfolgerung kommt gegenüber Studien, die wirklich CO2 durch Wasser blasen. Es ist klar, dass es sowohl Verlierer als auch Gewinner bei der Versauerung der Ozeane gibt; und sich ausschließlich auf die negativen Effekte zu stürzen wäre ein armseliges Vorgehen für eine auf guten Informationen beruhende Politik.

Vor Kurzem haben einige Ökologen und Geologen vor den Gefahren der Kohlenstoff-Kurzsichtigkeit gewarnt – damit meinten sie, dass man nicht nur die vermeintlichen Gefahren eines steigenden CO2-Niveaus in der Atmosphäre betrachten soll, während man gleichzeitig die potentiell schädlichen Auswirkungen eines CO2-Managing ignoriert. Mehr noch, Putz und Redford haben davor gewarnt, dass die kohlenstoffbasierte Konservierung schlecht für die Biodiversität und schädlich für Pflanzen und Tiere sein kann [21]. Sie schreiben, dass die karbonbasierte Ungleichbehandlung [carbon based discrimination {?}] nicht verholzte Pflanzen [non-arboreal plants] nachteilig beeinflussen werde. Das Ergebnis wären kürzere Baum-Spezies, die Ökosysteme außerhalb von Wäldern [non-forested ecosystems] in Gefahr bringen [22]. Außerdem „könnte das Pflanzen von Bäumen unter Kohlenstoff-Investoren verkehrte Anreize erzeugen, die zu massiven Verlusten bei der Biodiversität führen“ [23].

[Diesen Abschnitt { ab „Sie schreiben…} habe ich inhaltlich nicht verstanden. Er lautet im Original so: „They note that carbon-based discrimination will adversely affect non-arboreal plants, result in shorter tree species, and put non-forested ecosystems at risk[22] and that “tree planting among carbon investors could create perverse incentives leading to major biodiversity losses.”[23] A. d. Übers.]

Neben einigen wenigen Spezies, die zur Bestäubung und für die Verbreitung der Samen gebraucht werden, sind die „meisten Wirbel- und andere Tiere in Wäldern, die für Kohlenstoff gemanagt werden, überflüssig, wenn nicht ein Ärgernis“, lautet die Schlussfolgerung von Putz und Redford [24]. Das bedeutet, dass Anreize, diese Spezies zu unterstützen und zu bewahren begrenzt sein werden, wenn sie sich nicht als nachteilig herausstellen, zumindest wenn sich die Politiker ausschließlich auf die Reduktion des atmosphärischen Kohlendioxids konzentrieren.

Natürlich wird es Gewinner und Verlierer bei einem sich verändernden Klima geben, aber die Politiker müssen die Kosten für die negativen Folgen (mit den Kosten des Versuchs, den jetzigen Status quo zu erhalten) mit den positiven Vorteilen abwägen. Nicht alle biologischen, chemischen und ökologischen Reaktionen auf den steigenden CO2-Gehalt bedeuten gleich den Untergang [portend gloom and doom]. Politiker sollten sich in ihren Diskussionen darauf konzentrieren, das Für und Wider auszubalancieren, anstatt eine einseitige Strategie zur CO2-Reduktion zu verfolgen.

Überlegung Nr. 3: Politiker müssen die Möglichkeit erkennen, dass Kohlenstoff-Handelsschemata nicht zu einer Reduktion des CO2 führen könnten

Jüngste Fehlschläge beim Kohlenstoffhandel, sowohl an der Chicago Climate Exchange als auch beim Emissionshandel in der EU, bestätigen die einfache, aber raue Realität, dass der Kohlenstoffhandel ein künstliches und nicht funktionierendes System ist, dass wahrscheinlich mehr schadet als nützt, einfach weil es zu viele Betrüger gibt, zu viele Möglichkeiten, zu betrügen und damit davonzukommen und zu viele Gelegenheiten, mit diesen Betrügereien große Profite zu machen. Professor Roger Pielke Jr. hat kritisch angemerkt, dass momentan „sehr komplexe politische Maßnahmen voller buchhalterischer Tricks, politischer Schweinereien [political pork] und falscher Politik“ [25] ausgearbeitet werden, um das falsche Versprechen einer internationalen Klimalösung zu erzeugen. Selbst das Magazin Science äußerte sich am 23. Oktober 2009 zustimmend, dass:

„Die derzeit stattfindende Buchführung, eine Einhaltung der vom Kyoto- Protokoll festgelegten Kohlenstoff-Obergrenzen (http://unfccc.int/kyoto_protocol/items/2830.php) zu erreichen, und die Klima-Gesetzgebung enthalten einen weit reichenden, aber bestimmbaren Betrug, der ernsthaft die Ziele der Reduktion von Treibhausgasen unterminieren wird … Das Roden alter Wälder, um Holz zu verbrennen oder Energiepflanzen anzubauen wird als hundertprozentige Reduktion von Energie-Emissionen angesehen, obwohl dabei große Mengen von Kohlenstoff freigesetzt werden“ [26].

Dies leitet zu unserer dritten Überlegung für Politiker über: dass der Kohlenstoffhandel nicht direkt zu einer Reduktion des CO2-Gehaltes führen wird.

Derzeit kriecht eine gefährliche Lähmung in unsere moderne Ära, und zwar als Konsequenz einer unwissenschaftlichen Kohlenstoff-Kurzsichtigkeit. Diese Lähmung wird illustriert durch den Albtraum des Kohlenstoff-Budgets, bei dem das Abscheiden von Kohlendioxid-Emissionen durch zusätzliches Speichern und den Schutz von Kohlenstoff-Pools in menschlichen Siedlungen erreicht werden kann. Menschliche Siedlungen speichern Kohlenstoff in natürlichen Senken wie Vegetation und Erdboden, ebenso wie in anthropogenen Pools. Anthropogene Kohlenstoff-Pools umfassen Gebäude, bedruckte Materialien, Deponien, Kleidung und lebende Organismen [27].

Wer dem Handelspreis von Kohlenstoffemissionen an der Chicago Climate Exchange nicht gefolgt, ist, wird daran interessiert sein zu erfahren, dass der Kohlenstoffhandel im Januar 2004 mit dem bescheidenen Preis von 1 Dollar pro metrischer Tonne begonnen hatte [28]. Die Preise fluktuierten wild hin und her und erreichten im Mai/Juni 2008 einen Spitzenwert von 7 Dollar pro metrischer Tonne [29]. Als das öffentliche Interesse jedoch immer mehr schwand (sehr wahrscheinlich zumindest teilweise wegen des Fehlens einer Korrelation zwischen den verkündeten extremen Szenarien und Beobachtungen in der realen Welt), schwankte der Preis zwischen Oktober und Dezember 2009 nur noch zwischen 0,10 bis 0,20 Dollar pro metrischer Tonne [30].

Ein Investor der ersten Stunde in Reduktionen von Kohlenstoffemissionen im Januar 2004 hat inzwischen 90 Prozent seiner ursprünglichen Investition verloren, und zwar auf etwas, das zu einer Steuer auf eine gasförmige atmosphärische Komponente geworden ist, die unabdingbar für alles Leben ist – und auf die Kohlenwasserstoff-Energie, die 85 Prozent der US-Wirtschaft stärkt. Spekulanten, die dem Kohlenstoffmarkt am 30. Mai 2008 beigetreten sind, haben 98,6 Prozent ihrer Investitionen verloren.

In ganz ähnlicher Weise ist der Markt des Emissionshandels in der EU vollständig zusammen gebrochen. Der Handel erreichte einen Spitzenwert um 30 Euro im April 2006, fiel bis Februar 2007 auf weniger als 1 Euro und danach wohl noch weiter auf 0,02 Euro im Dezember 2007 [31] – ein Rückgang auf 0,1 Prozent des Spitzenwertes. Ironischerweise liegt der Grund für diesen Rückgang zumindest teilweise darin, dass zu viele Kohlenstoff-Zertifikate relativ zu den tatsächlichen Emissionen vergeben worden waren. Mehr noch, die EU-Emissionen haben tatsächlich während der ersten Phase des Experiments mit dem Kohlenstoffhandel in der EU zugenommen – in einigen Ländern um 10 bis 54 Prozent [32]. Beispielsweise lagen die Emissionen Ende 2007 sowohl in Griechenland als auch in Irland um 25 Prozent über dem Niveau von 1990; die Emissionen in Portugal lagen um 38 und in Spanien um 54 Prozent darüber [33]. Dies waren natürlich genau die Ergebnisse, die der Kohlenstoffhandel verhindern sollte.

Die zweite Phase des Handels in der EU ist auch nicht vielversprechend, da neue Hindernisse und Fragen aufgetaucht sind. Dies wird illustriert durch die Entscheidung des Europäischen Gerichtshofes im September 2009, die sich gegen den Plan der Europäischen Kommission wandte, Polen und Estland Quoten für Emissionsreduktionen vorzuschreiben. Der Gerichtshof urteilte, dass die beiden Länder nicht gegen ihren Willen gezwungen werden können, den niedrigeren Emissions-Quoten zu folgen, die von der Europäischen Kommission als Folge der Akzeptanz des Kyoto-Protokolls festgelegt worden waren [34].

Als weiterer Beweis für die Trennung zwischen der Welt, die sich Politiker und Wissenschaftler vorstellen, die nach Kopenhagen geeilt sind, und der realen Welt, in der wir leben, steht der Vorschlag der australischen Regierung, mit Kohlenstoff unter einem eigenen Emissions-Handelsschema zu handeln, mit einem festgesetzten Preis von 10 australischen Dollar pro Tonne in jedem Jahr bis zum Juli 2012. Zu dieser Zeit sollen Kosten und Preise durch Marktkräfte bestimmt werden [35]. Wir wetten dass dieser Wert bis Dezember 2012 erheblich unter den 10 australischen Dollar liegen wird, falls man wirklich die Entwicklung eines freien Marktes zulässt.

Betrachtet man all diese mit den Systemen zum Kohlenstoffhandel in Zusammenhang stehenden Probleme – vor allem dem Potential und der Gelegenheit zu betrügen und dem steilen Wertverfall beim Kohlenstoffhandel – sollten sich die Politiker sorgfältig die Negativa überlegen, bevor sie Kohlenstoff-Handelssysteme auf den Weg bringen.

Schlussfolgerung

Umsichtige Politiker sollten nicht durch die Kurzsichtigkeit der alarmistischen Berichterstattung in den Medien über eine vom Menschen induzierte globale Erwärmung in Panik verfallen. Stattdessen sollten sie angesichts der potentiellen Kosten und Auswirkungen gegenüber den Befürwortern vorsichtig sein, die die Wissenschaft aus undurchsichtigen Gründen unterwandert haben [36]. Verständlicherweise könnte das Ausmaß der Ungewissheit hinsichtlich der Rolle und der Auswirkungen des steigenden CO2-Gehaltes für jene einen Schock bedeuten, die durch den Fanatismus angesteckt worden sind. Angesichts der involvierten Unsicherheit sollten Politiker die wissenschaftlichen Daten sorgfältig prüfen.

Entscheidungsträger sollten sich die folgenden Fragen stellen: Wollen wir wirklich eine Zukunft, die auf einem durch die Kohlenstoff-Kurzsichtigkeit erzeugten schweren Missverständnis basiert? Kann es sich die Menschheit wirklich leisten, den wirklichen Schaden zu ignorieren, der durch diese Trugschlüsse über Kohlenstoff entsteht? Wir müssen den Mut haben, uns gegen den Klimaalarmismus aufzulehnen und für eine rationale Verwaltung einzustehen, ebenso wie für eine zuverlässige, bezahlbare Energieversorgung. Wir drängen die politischen Führer der Welt, das Richtige zu machen und jeden Deal zurückzuweisen, der Kohlenstoff-Emissionen besteuern oder begrenzen würde. Nur auf diese Weise können sie Arbeitsplätze schützen, ebenso wie Gesundheit, Wohlergehen, wirtschaftliche Möglichkeiten, Umweltqualität, Lebensstandard und Zivilrechte, die so unabdingbar von Kohlenwasserstoff-Energie abhängen.

Willie Soon* and David R. Legates**

Dr. Soon ist ein Astrophysiker an der Solar, Stellar and Planetary Sciences Division am Harvard-Smithonian Center for Astrophysics. Dr. Soon hat viele Artikel ausschließlich über Themen über die Sonne, andere Sterne und das Klima geschrieben und begutachtet. Die Anscihten von Willie Soon sind strikt seine eigenen und reflektieren nicht notwendigerweise jene der Harvard University, der Smithonian Institution oder des Harvard-Smithsonian Center for Astrophysics.

Dr. Legates ist ein Mitarbeiter am College of Earth, Ocean, and Environment, University of Delaware, und seine Ansichten äußert er als Mitglied der Fakultät an der Universität im Rahmen der akademischen Freiheitsrechte. Er arbeitet auch als Klimatologe des US-Bundesstaates Delaware.

References

[1] See, e.g., Intergovernmental Panel on Climate Change, Climate Change 2007: The Physical Science Basis (Susan Solomon et al., eds. 2007).

[2] The phrase “global temperature” and “heat” are used here in laymen sense rather than in the correct manner as properly founded in physics.

[3] See, e.g., Kevin E. Trenberth, An Imperative for Climate Change Planning: Tracking Earth’s Global Energy, 1 Current Opinion in Envtl. Sustainability 19 (2009); see also Willie Soon & David Legates, Answering 3 Simple Questions, Quadrant Online, Aug. 3, 2009, at fig.1(plotting Hadley Centre/UEA air temperature data from 1995 to 2009 and atmospheric CO2).

[4] See Josh K. Willis et al., In Situ Data Biases and Recent Ocean Heat Content Variability, 26 J. Atmospheric & Oceanic Tech. 846, fig.4 (2009); David H. Douglass & Robert S. Knox, Ocean Heat Content and Earth’s Radiation Imbalance, 373 Physics Letters A 3296 (2009); see also Bob Tisdale, OHC Linear Trends and Recent Update of NODC OHC (0-700 Meters) Data, Feb. 5, 2010, at fig.2.

[5] For a more complete discussion of this issue, see Willie Soon, Solar Arctic-Mediated Climate Variation on Multidecadal to Centennial Timescales: Empirical Evidence, Mechanistic Explanation, and Testable Consequences, 30 Physical Geography 144 (2009).

[6] See Alexander Ruzmaikin & Joan Feynman, Solar Influence on a Major Mode of Atmospheric Variability, 30 J. Geophys. Res. 4209 (2002); Willie Soon, Variable Solar Irradiance as a Plausible Agent for Multidecadal Variations in the Arctic-Wide Surface Air Temperature Record of The Past 130 Years, 32 Geophys. Res. Lett. 16712 doi.10.1029/2005GL023429 (2005); Willie Soon, Solar Arctic-Mediated Climate Variation on Multidecadal to Centennial Timescales: Empirical Evidence, Mechanistic Explanation, and Testable Consequences, 30 Phys. Geo. 144 (2009).

[7] See Igor Polyakov et al., Observationally Based Assessment of Polar Amplification of Global Warming, 29 Geophys. Res. Lett. 1878 doi.10.1029/2001GL011111 (2002), Igor Polyakov et al., Variability and Trends of Air Temperature and Pressure in The Maritime Arctic, 1875-2000, 16 J. Climate 2067 (2003); Igor Polyakov et al., Arctic Ocean Freshwater Changes Over the Past 100 Years, 21 J. Climate 364 (2008).

[8] See Roger A. Pielke Sr. et al., Unresolved Issues With The Assessment of Mutidecadal Global Land Surface Temperature Trends, 112 J. Geophys. Res. D24S08 doi.10.1029/2006JD008229 (2007); Souleymane Fall et al., Impacts of Land Use Land Cover on Temperature Trends Over The Continental United States: Assessment Using the North American Regional Reanalysis, Int’l J. Climatol. doi.10.1002/joc.1996 (2009); Cynthia Rosenzweig et al., Mitigating New York City’s Heat Island: Integrating Stakeholder Perspectives and Scientific Evaluation, 90 Bull. Am. Meteorological Soc’y 1297 (2009); John R. Christy et al., Surface Temperature Variations In East Africa and Possible Causes, 22 J. Climate 3342 (2009); John R. Christy et al., Methodology and Results of Calculating Central California Surface Temperature Trends: Evidence of Human-Induced Climate Change?, 19 J. Climate 548 (2006).

[9] See Christopher Essex, What Do Climate Models Tell Us About Global Warming?, 135 Pure & Applied Geophysics 125 (1991); Willie Soon et al., Moderling Climatic Effects of Anthropogenic Carbon Dioxide Emissions: Unknowns and Uncertainties, 18 Climate Res. 259 (2001); Richard S. Lindzen, Taking GreenHouse Warming Seriously, 18 Energy & Env’t 937 (2007); David H. Douglass et al., A Comparison of Tropical Temperature Trends With Model Predictions, 28 Int’l J. Climatol.1693 (2008); Demetris Koutsoyiannis et al., On the Credibility of Climate Predictions, 53 Hydrological Sci. 671 (2008); Philip J. Klotzbach et al., An Alternative Explanation for Differential Temperature Trends at the Surface and in the Lower Troposphere, 114 J. Geophysical Res. doi.10.1029/2009JD011841 (2009).

[10] Id. For further discussion and evidence of the secondary role of atmospheric carbon dioxide and methane on the large glacial-interglacial climate transition of the past 1 to 2 million years, see Willie Soon, Implications of the Secondary Role of Carbon Dioxide and Methane Forcing In Climate Change: Past, Present, and Future, 28 Phys. Geo. 97 (2007).

[11] See Richard S. Lindzen & Yong-Sang Choi, On The Determination of Climate Feedbacks From ERBE Data, 36 Geophys. Res. Lett. doi.10.1029/2009GL039628 (2009) (explaining how climate feedbacks, rooted in the fast processes of hydrology and clouds in the tropics amplify the small warming from greenhouse effect of added atmospheric CO2, were incorrectly represented in frequently cited current climate models).

[12] Mass. v. EPA, 549 U.S. 497 (2007).

[13] Id. at 528–30.

[14] Sherwood B. Idso, Carbon Dioxide and Global Change: Earth in Transition 67–68 (1989); see also Adip Said, Carbon Dioxide and Life, Biology Cabinet, Jan. 13, 2007; Nasif Nahle, Carbon Dioxide and Health, Biology Cabinet, Jan. 13, 2007, available at http://biocab.org/Carbon_Dioxide_CO2.html.

[15] See, e.g., Arthur B. Robinson et al., Environmental Effects of Increased Atmospheric Carbon Dioxide, 12 J. Am. Physicians & Surgeons 79, fig.23 (2007) (republishing Keith Idso & Sherwood Idso, Plant Responese to Atmospheric CO2 Enrichment in the Fact of Environmental Constraints: A Review of The Past 10 years Research, 69 Agric. & Forest Meteorology 153, fig.6 (1994)). It should be noted that Stephen P. Long et al., Food for Thought: Lower-Than-Expected Crop Yield Stimulation with Rising CO2 Concentrations, 312 Sci. 1918 (2006) is often cited for his interpretation of Robertson’s data (shown in Robinson et al., supra note 15, at fig.23) indicating a negative plant response to CO2, which he hypothesized could be disastrous to crops. Francesco Tubiello et al., Crop Response to Elevated CO2 and World Food Supply: A Comment on “Food For Thought . . .” by Long et al., 26 Eur. J. Agronomy 215 (2007), have reconfirmed Robinson’s applicability, while suggesting Long’s findings grossly exaggerated. In recent literature, it is surprising to find Long et al. often cited without reference to the strong criticism offered by Tubiello et al. It should also be noted that Long et al. has not responded to this criticism.

[16] Tubiello, supra note 15.

[17] See, e.g., Frederic Bessat & D. Buigues, Two Centuries of Variation in Coral Growth in a Massive Porites Colony from Moorea (French Polynesia): A Response of Ocean-Atmosphere Variability from South Central Pacific, 175 Palaeogeography, Palaeoclimatology, Palaeoecology 381 (2001). The growing body of similar scholarship published after the 2007 UN IPCC report is also useful. See, e.g., M. Debora Iglesias-Rodriguez et al., Phytoplankton Calcification in a High-CO2 World, 320 Sci. 336 (2008); Herfort et al. 44 J. Phycology 91 (2008); Y. Feng et al., Interactive Effects of Increased pCO2, Temperature and Irradiance on the Marine Coccolithophore Emiliania Huxleyi, 43 Eur. J. Phycology 87 (2008); Philippe Tortell et al., CO2 Sensitivity of Southern Ocean Phytoplankton, 35 Geophys. Res. Lett. doi.10.1029/2007GL032583 (2008).

[18] Interview with M. Debora Iglesias-Rodriguez, ScienceWatch.com, April 2009http://sciencewatch.com/dr/fbp/2009/09aprfbp/09aprfbpRod/.

[19] Iglesias-Rodriguez et al., supra note 17, at 336 (observing that “[m]ost of these experiments used semi-continuous cultures, in which the carbonate system was modified by the addition of acid and/or base to control pH”); Elizabeth Pennisi, Calcification Rates Drop in Australian Reefs, 323 Sci. 27 (2009) (summarizing the research of Alina Szmant, a coral ecologist: “[Szmant] faults previous lab studies because they used hydrochloric acid, not carbon dioxide, to lower the pH of the water in the calcification studies”).

[20] See, e.g., Justin B. Ries et al., Marine Calcifiers Exhibit Mixed Responses to CO2 –Induced Ocean Acidification, 37 Geology 1131 (2009) (both negative and positive responses are found when a wide range of marine calcifiers were examined).

[21] Francis E. Putz & K.H. Redford, Dangers of Carbon-Based Conservation, 19 Global Envtl. Change 400 (2009).

[22] Id.

[23] Id.

[24] Id.

[25] Roger Pielke Jr., Understanding the Copenhagen Climate Deal: the Fix is In, 23 Bridges, Oct. 2009http://www.ostina.org/content/view/4458/1232/.

[26] Timothy D. Searchinger et al., Fixing a Critical Climate Accounting Error, 326 Sci. 527 (2009).

[27] Galina Churkina et al., Carbon Stored in Human Settlements: the Coterminous United States, 16 Global Change Bio. 135, 136 (2009).

[28] Chicago Climate Exchange, CCX Carbon Financial Instrument (CFI) Contracts Daily Report (last visited Jan. 25, 2009).

[29] Id.

[30] Id.

[31] See Henrik Hasselknippe, Carbon 2006 Towards a Truly Global Market, Point Carbon, Feb 28, 2006, at 25; Analyse van de CO2-markt (Analysis of Carbon Market), Emissierechten, Nov. 2007. Wikipedia also has a surprisingly robust discussion. European Union Emission Trading Scheme, Wikipedia (last visited Jan. 25, 2010).

[32] European Env’t Agency, Annual European Community Greenhouse Gas Inventory 1990–2007 and Inventory Report 2009: Submission to the UNFCCC Secretariat 9, tbl.ES.2 (2009).

[33] Id.

[34] See Cort Mortished, Court Delivers Severe Blow to EU Carbon Prices, The Australian, Sept. 24, 2009.

[35] See Ben Sharples, Australia’s Biggest Companies Lack Investment Plans for Carbon, Bloomberg, Oct. 7, 2009.

[36] See Richard Lindzen, Climate Science: Is It Currently Designed to Answer Questions?, paper prepared for meeting in San Marino from 29-31 Aug. 2008 (discussing the cultural, organizational, and political factors that influence objectivity in Climate Science grants and research).

Copyright 2009 Willie Soon and David R. Legates. All rights reserved.

[ back to top ]

Link: http://elq.typepad.com/currents/2010/02/currents37-0-soonlegates-2010-0226.html

Übersetzt von Chris Frey EIKE mit schriftlicher Genehmigung des Autors