Der anthropogene Treibhauseffekt – eine spektroskopische Geringfügigkeit

Update 25.9.12

Aufgrund der überaus aktiven Diskussion hat Dr. Hug seinen Artikel nochmals überarbeitet, evt. schlecht verständliches verständlicher dargestellt und evtl. fehlendes ergänzt. Sie finden den vollständigen aktualisierten Beitrag als pdf im Anhang

Zusammenfassung: Ganz offensichtlich wird die Wirkung des anthropogenen Treibhauseffekts weit überschätzt, denn insbesondere der CO2-Treibhauseffekt war bis auf unbedeutende, spektroskopisch begründbare Restbeträge („Peakflanken“) bereits zu Zeiten Goethes ausgereizt. Wegen des weitgehenden „Sättigungseffekts“ ist der anthropogene Anteil der Treibhausgase für die gegenwärtige Klimaänderung von untergeordneter Bedeutung. Vielmehr geht die Varianz der Erdoberflächentemperatur mit der Wolkenbedeckung einher, die wiederum von der Fluktuation des solaren Magnetfelds abhängt. Dabei hat eine größere Wolkenbedeckung des Globus in etwa die gleiche Auswirkung wie Vulkanasche nach einem Ausbruch. Der Einfluss der Wolkenbedeckung lässt sich mit den Klimamodellen des IPCC nur äußerst unzulänglich abbilden. Klimamodelle sind auch deshalb ein spektroskopisches Artefakt, weil sie mit gewillkürten Flusskorrekturen arbeiten müssen, deren Beträge den des anthropogenen Treibhauseffekts um ein Vielfaches übersteigen.

1. Was ist unter dem Begriff „Sättigung“ des Treibhauseffekts zu verstehen?

Klimaforschung ist eine in Politik gegossene Naturwissenschaft. Da beide Handlungsfelder nicht von einander zu trennen sind, gab es im Vorfeld von Rio92 in den unter Einfluss der Politik agierenden Medien ein flächendeckendes Meinungsbombardement über die kommende Klimakatastrophe.

Unter dem Eindruck der Medienhype versuchte man als Naturwissenschaftler in den neunziger Jahren etwas über die spektroskopischen Grundlagen des propagierten Klima-Harmagedons in den allgemein gelesenen Periodika zu erfahren – und biss auf Granit. Weder in „Nature“ noch in „Science“ oder in „Scientific American“ (deutsch „Spektrum der Wissenschaft“) erschien ein informativer Artikel über den grundlegenden spektroskopischen Mechanismus des „Treibhauseffekts“ und dessen Grenzen (Emissionsspektren des Erdkörpers, Strahlungstransport, Anwendung des Planckschen-Strahlungsgesetzes auf die Besetzung von Schwingungsrotationsbanden bei CO2, Integration über dem Halbraum zur Berechnung des „Treibhauseffekts“ einer Stoffmengenportion von CO2, Festlegung und Definition der als normal geltenden Mitteltemperatur (288 K) im Rahmen einer Konferenz usw.). Auch Roger Revelle, der den späteren US-Vizepräsident Al Gore am College mit der Treibhausgastheorie bekannt machte, publizierte hierzu keine brauchbare Information [2]. Es war fast so, als hätte man Angst, die Karten aufzudecken.

Da man von den allgemein gelesenen Wissenschaftsjournalen im Stich gelassen wurde und die Propagandawalze in dem Medien unaufhörlich trommelte, möchte man als Chemiker erfahren, ab welchen CO2-Gehalt der Treibhauseffekt aus spektroskopischen Gründen unter realistischen Annahmen ausgereizt ist. Dies insbesondere, wenn man beruflich mit der Quantifizierung von Analyten mittels spektroskopischer Methoden befasst ist und weiß, dass es immer einen Konzentrationsbereich gibt, ab dem die Messstrahlung nahezu komplett absorbiert wird. Es verhält sich ähnlich wie beim Eintropfen von schwarzer Tinte in ein Wasserglas. Je mehr man zufügt, desto mehr des einfallenden Lichts wird absorbiert bis die Absorption schließlich vollständig ist (Transmission t = 0).

Ganz irreführend war ein Aufsatz von 1984 in der Mitgliederzeitschrift der Gesellschaft deutscher Chemiker, den so genannten „Blauen Blättern“ [5]. In dieser Veröffentlichung, auf die ich weiter unten zurückkomme, wird die „Rolle der treibhauswirksamen Spurengase“ mit Hilfe von Transmissionsspektren erläutert. Ein deutlicher Hinweis, dass es beim Treibeffekt um die atmosphärische spektrale Strahldichte (vereinfacht Emission) durch atmosphärische Spurengase geht, wird nur unterschwellig beschrieben. Angeregt durch die Literaturstelle [5], unternahm ich Messungen zur Transmission (bzw. Absorption oder Extinktion) in einer Gasküvette, um festzustellen, inwieweit der Treibhauseffekt des CO2 „ausgereizt“ ist.

Wird durch Treibhausgase beispielsweise 35 % der vom Erdboden ausgehend Strahlung bei einer bestimmten Wellenlänge in einer bestimmten Höhe absorbiert, dann ist die Absorption (früher A) a = 0,35 (bzw. a = 35 %) Die Transmission (früher T) beträgt t = 0,65 bzw. t = 65 %.

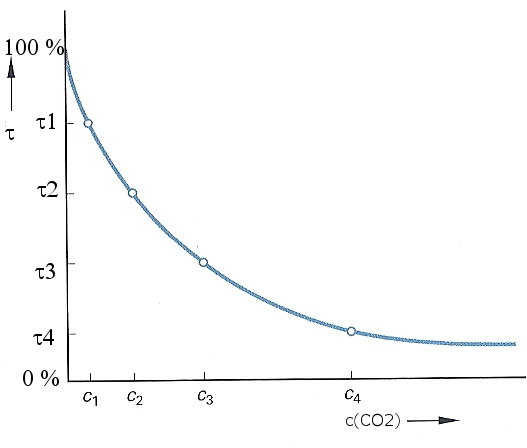

Da die Absorption von IR-Strahlung („Wärmestrahlung“) quantitativ dem Bouguer-Lambert-Beer-Gesetz (eine e-Funktion) folgt, sollte es eine „fließende Grenze“ geben, ab der bei zunehmender Konzentration des Absorbers keine wesentliche Steigerung der Absorption a erfolgt bzw. die Transmission t gegen Null geht (Bild 1).

Bild 1: Transmission und Konzentration

Die Betrachtung der Transmission t zur Abschätzung des anthropogenen Treibhauseffekts ist nicht vollkommen falsch, weil nämlich die „Emissionsfähigkeit“ der Treibhausgasmoleküle mit der Absorptionsfähigkeit gemäß dem Kirchhoffschen Strahlungsgesetz korreliert. Deshalb sollte es einen („fließenden“) Konzentrationsbereich geben, ab dem der atmosphärische Treibhauseffekt CO2 nicht mehr nennenswert ansteigt. Ich bezeichne dies als „Sättigung“, die es, wenn man in immer kleineren Kleinigkeiten kramt, tatsächlich nicht gibt. Nicht ganz korrekt aber anschaulich verhält es sich mit der „Sättigung“ ähnlich wie mit dem Grenzwert einer geometrischen Reihe. Beispiel:

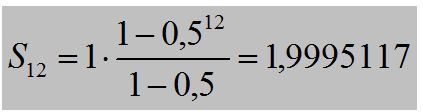

Für eine solche geometrische Reihe gilt:

![]()

Dabei ist a1 das Anfangsglied und q der Quotient zweier aufeinander folgender Glieder (q¹1). In der obigen geometrischen Reihe ist a1 = 1 und q = 0,5 (z. B. ¼ : ½ = 0,5). Setzt man jetzt beispielsweise n = 11 resultiert

![]()

und für n = 12 erhält man:

Der Zuwachs zwischen S11 auf S12 beträgt: DS = 1,9995117 – 1,9990234 = 2,777 . 10-4 entsprechend 0,014 %. Bezeichnet man den Grenzwert dieser arithmetischen Reihe als „vollständige Sättigung“ (S¥ = 2), dann ist der Betrag von S12 nur noch um

![]()

von dieser vollständigen „Sättigung“ entfernt.

Natürlich beruht der Treibhauseffekt auf der Emission von IR-Strahlung durch atmosphärische Spurengase und nicht auf der Absorption bzw. der Transmission von IR-Strahlung durch dieselben. Weil aber

– erstens IR-aktive Spurengase gemäß dem Kirchhoffsche Strahlungsgesetz genau so emittieren wie sie absorbieren,

– kann zweitens der „Sättigungscharakter“ des Treibhauseffekts in einfacher Näherung mit Hilfe des Bouguer-Lambert-Beer-Gesetzes abgeschätzt werden.

Nun basiert dieses Gesetz nicht wie oben auf einer geometrischen Reihe sondern auf einer e-Funktion, die als Potenzreihe gegen Null konvergiert (vgl. a. Bild 1).

![]()

Angenommen für eine Absorptionsbande des CO2 wird für eine bestimmte CO2-Konzentration in einer bestimmten Höhe willkürlich der Zahlenwert x = 8 eingesetzt, dann resultiert

![]()

Werden die Bedingungen gleich gehalten und lediglich die CO2-Konzentration verzehnfacht, erhält man

![]()

Man kann das Spiel beliebig weiter machen und gelangt schnell an die Grenzen eines Taschenrechners und später auch an die eines Supercomputers ( ![]() . Anschaulich gesprochen heißt das, die tatsächliche „Sättigung“ wird erst in einer reinen CO2-Atmosphäre mit unendlicher Schichtdicke erreicht. Erst dann ist die Transmission formal t = 0 und die Absorption a = ¥. Das ist natürlich Unsinn, aber orthodoxe Anhänger der Treibhausgastheorie können immer argumentieren, es gibt auch bei stetig steigenden CO2-Gehalt keine Sättigung des Treibhauseffekts und damit ein endloses Diskussions-perpetuum-mobile in Gang halten.

. Anschaulich gesprochen heißt das, die tatsächliche „Sättigung“ wird erst in einer reinen CO2-Atmosphäre mit unendlicher Schichtdicke erreicht. Erst dann ist die Transmission formal t = 0 und die Absorption a = ¥. Das ist natürlich Unsinn, aber orthodoxe Anhänger der Treibhausgastheorie können immer argumentieren, es gibt auch bei stetig steigenden CO2-Gehalt keine Sättigung des Treibhauseffekts und damit ein endloses Diskussions-perpetuum-mobile in Gang halten.

Nebenbei bemerkt hatte 1995 der englische Chemiker Jack Barrett in der Spectro Chimica Acta auf die bereits längst gegebene „Sättigung“ der Treibhauseffekts hingewiesen und damit eine heftige Kontroverse ausgelöst [3, 8, 9, 10, 11]. Der damalige Chairman und spätere Co-Chairman des IPCC, Sir John Houghton, rief Barrett nach Erscheinen der Publikation an und verlangte, er solle seine Veröffentlichung zurückziehen. Außerdem verständigte Sir Houghton die Leitung des Imperial Colleges, an dem Barrett damals arbeitete. Diese untersagte ihm umgehend unter Androhung von Konsequenzen weitere kritische Veröffentlichungen zum Treibhauseffekt [35].

2. Der Treibhauseffekt

Fälschlicherweise wird oftmals angenommen, der Treibhauseffekt sei mit der Absorption von Infrarotstrahlung (IR-Strahlung) durch atmosphärische Spurengase (CO2, CH4, Wasserdampf u. a.) identisch. Durch strahlungslose Deaktivierung der angeregten Moleküle („Thermalisierung“) würde sich die Luft erwärmen und ihre Wärmeenergie auf die Erdoberfläche übertragen. Ähnlich wie eine heiße Flüssigkeit die Wandung eines Behälters durch Wärmeübertragung erhitzt. Der Treibhaushypothese nach verhält es sich genau umgekehrt: Die Erdoberfläche wird fast ausschließlich durch Bestrahlung erwärmt und die Atmosphäre nimmt ihre Wärmeenergie durch direkten Kontakt mit dem Erdboden auf.

Die Bestrahlung der Erdoberfläche setzt sich aber aus zwei Teilen zusammen:

1. Die direkte Solareinstrahlung (abhängig von der Wolkenbedeckung)

2. Strahlung durch den atmosphärische Treibhauseffekt (im wesentlichem ausgereizt)

Die Existenz einer atmosphärischen Gegenstrahlung, die den Treibhauseffekt charakterisiert, lässt sich zwar leicht nachweisen, aber bereits die Größenordnung des natürlichen Treibhauseffekts kann nur berechnet werden und die ihm zugeschriebene Auswirkung auf das Klima entzieht sich vollkommen der Verifikation [20]. Im gleichen Maß entziehen sich Klimacomputermodelle vollkommen der Falsifikation. Man kann mit ihnen jegliche Entwicklung prophezeien, ohne je befürchten zu müssen, gegenwärtig widerlegt zu werden.

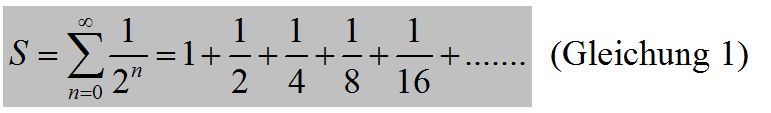

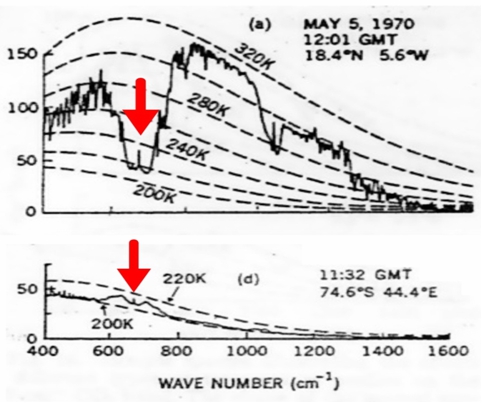

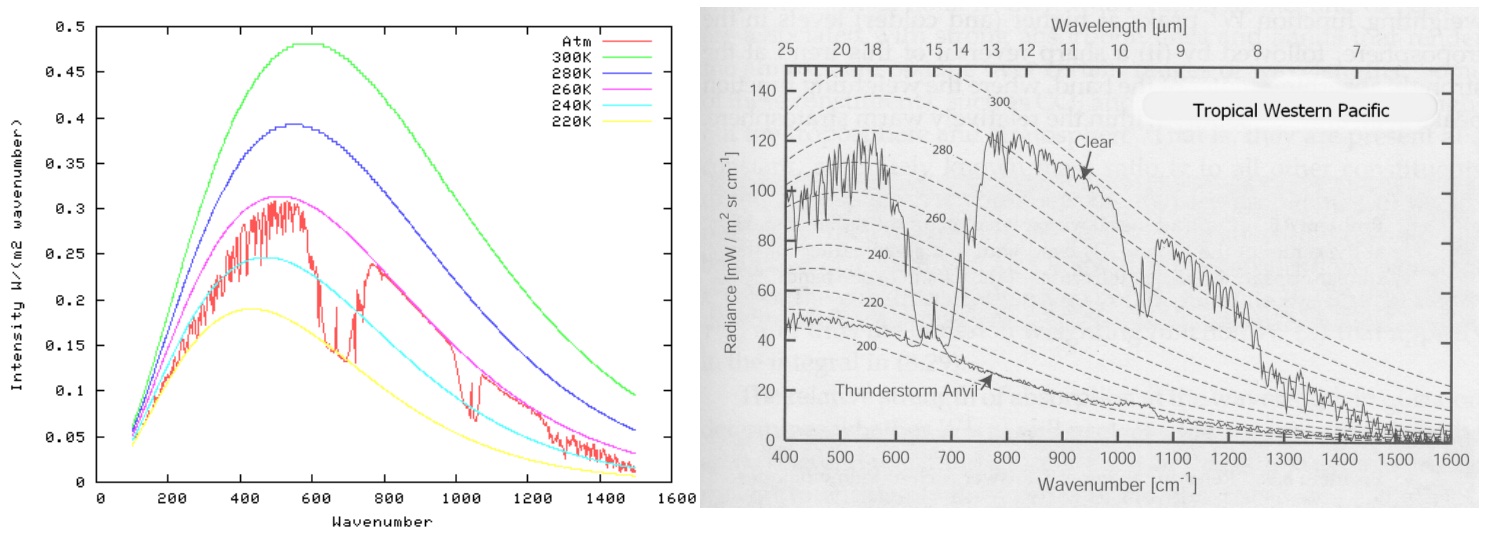

Zum Verständnis des CO2-Treibhauseffekts ist zunächst einmal die „ganz normale“ Infrarot-Absorption atmosphärischer Spurengases zu betrachten [2]. Da IR-aktive Verbindungen mit mehr als zwei Atomen meist verschiedene Absorptionsbanden bzw. Emissionsbanden besitzen, muss geklärt werden, welche der Absorptions-/Emissionsbande des CO2 von Bedeutung ist. Hierüber geben Satellitenspektren Auskunft [4].

Bild 2: Satellitenspektren, oben über der Sahara, unten über der Arktis

Die gestrichelten Linien im Bild 2 sind die idealen Planck-Strahlungskurven der Erdoberfläche berechnet bei unterschiedlichen Temperaturen in K. Die „gezackte Linien“ repräsentieren neben der ungehinderten Emission der Erdoberfläche die Emissionsgraphen der atmosphärischen Treibhausgase. Die stets offenen Strahlungsfenster liegen bei 800 – 1000 cm-1 und 1050 – 1300 cm-1. Die roten Pfeile im Bild 1 kennzeichnen die ν2-Bande um 15 μm (667 cm-1). Deshalb ist nur diese relativ schwache Bande von Bedeutung und nicht die wesentlich stärkere n3-Bande um 4,2 μm (2349 cm-1). Außerdem erkennt man, die Atmosphäre emittiert tatsächlich IR-Strahlung („Treibhauseffekt“). Dies sieht man ganz deutlich im Satellitenspektrum über der Arktis (unteres Spektrum im Bild 2). Die Bodentemperatur beträgt dort nämlich ca. 200 K (-73 °C), während die Atmosphäre in etwa 10 km Höhe eine höhere Temperatur von ca. 210 K (-63 °C) aufweist. Dies ist ein erster Hinweis darauf, dass der den IPCC-Computermodellen zugrunde liegende Strahlungstransport die Verhältnisse nicht korrekt beschreibt. Es handelt sich vielmehr um einen Energietransport infolge der natürlichen Konvektion. Dabei steigt wärmere Luft unter Abkühlung auf und gibt ihre Energie oberhalb einer Höhe von 10 km als „ungestörte Emission“ ins Weltall ab.

Die im Bild 2 deutlich erkennbaren Strahlungsfenster, die bei wolkenfreien Himmel stets offen sind, veranlassen einige Skeptiker zu argumentieren, selbst wenn es einen Treibhauseffekt gäbe, könne dieser nicht die behauptete Erwärmung der Erdoberfläche verursachen, weil die Auskühlung durch die Strahlungsfenster mindest so groß wie die Wirkung des Treibhauseffekts.

Andere Skeptiker sagen, weil „klimawirksame“ Spurengase wie CO2 usw. IR-Strahlung nicht nur absorbieren sondern im gleichem Maße auch emittieren (Kirchhoffsches Strahlungsgesetz), besitzen „Treibhausgase“ eine kühlende und keine erwärmende Wirkung. Dies beweisen u. a. die im Bild 2 mit rotem Pfeil markierten Maxima des Emissionsspektrums von CO2, der die Abgabe von Strahlungswärme ins Weltall präsentiert. Die gleichen Skeptiker sagen, gäbe es wirklich einen Treibhauseffekt, müsste die Oberfläche der Arktis (200 K) auf die Temperatur erwärmt werden, die in ca. 10 km Höhe herrscht (210 K). Außerdem verstoße der Treibhausgaseffekt gegen den 2. Hauptsatz der Thermodynamik, weil kältere, höher gelegene Luftschichten nicht dem wärmeren Erdboden durch „Rückstrahlung“ erwärmen können (vgl. Temperaturgradient im Bild 10).

3. Eigene Messungen

Weil, wie eingangs erläutert, in den allgemein gelesenen wissenschaftlichen Journalen keine auch nur annähernd brauchbare Information zur Spektroskopie des Treibhauseffekts veröffentlicht wurde, habe ich die Absorption des Kohlendioxids einmal in einem Industrielabor und einem Hochschullabor gemessen und die Transmission einzelner Banden, so weit sie erfassbar waren, auf die Atmosphäre hochgerechnet.

Ein Teil der Messungen (vgl. Bild 4) wurden mittels einer 10-cm-Küvette mit IR-durchlässigem Fenster durchgeführt, die mit synthetischer CO2-freier und wasserfreier Luft gefüllt war. Danach wurde mit einer Mikroliterspritze CO2 zugegeben, so dass 357 ppm CO2 zugegen waren (CO2-Konzentration von 1993). Weiter wurden soviel Wasser zugefügt, bis 2,6 % Wasserdampf vorlagen. Als IR-Strahlungsquelle diente ein Globar, ein elektrisch auf 1000-1200 ºC geheizter Siliziumkarbid-Stab mit nachgeschaltetem variablen Interferenzfilter. Nach der Aufnahme dieses Spektrums wurde mit CO2 aufgestockt, so dass 714 ppm enthalten waren. Die Messung erfolgte zum einem FT-IR-Spektrometer „Bruker IFS 48“.

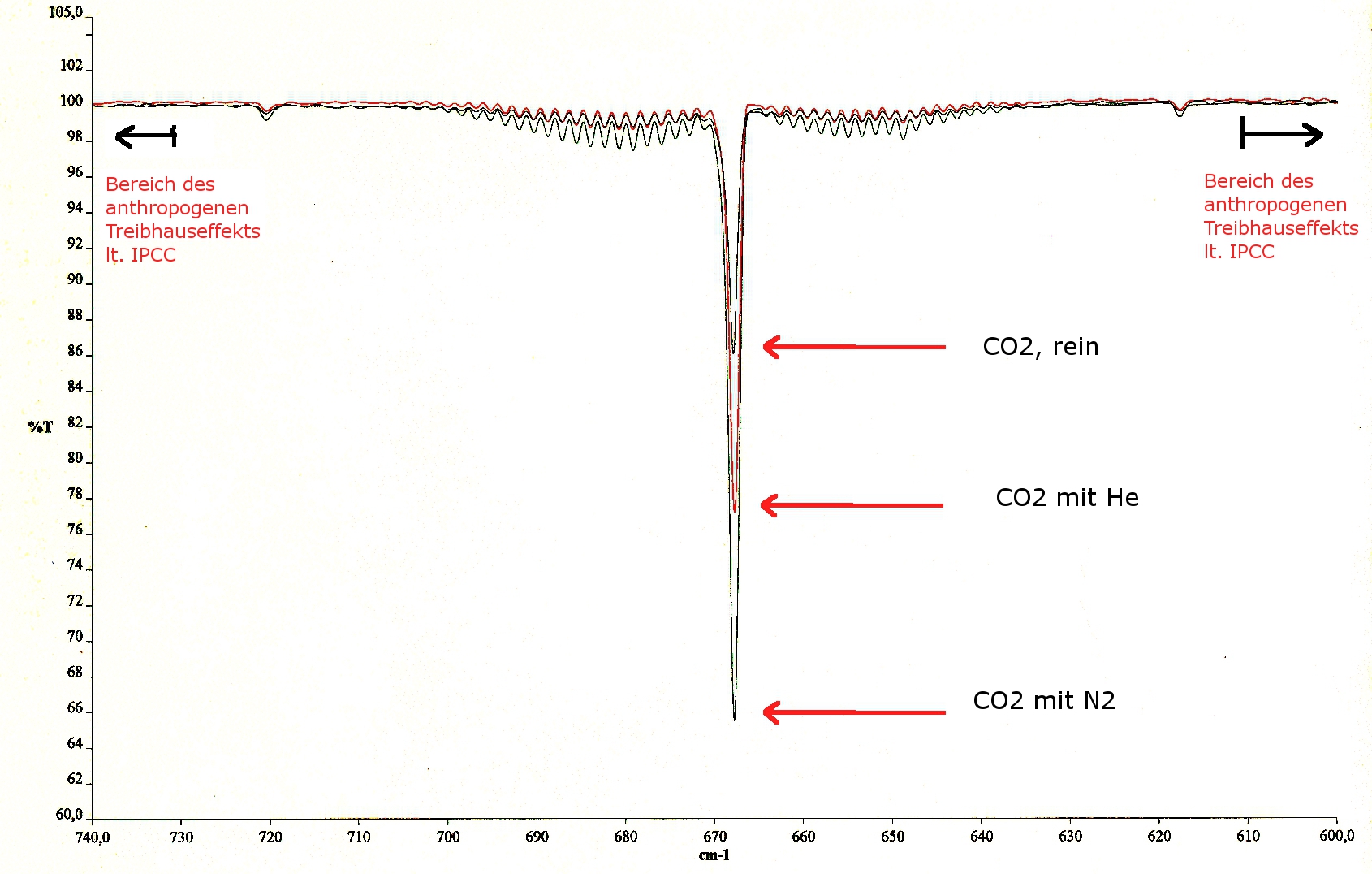

Um den Einfluss von Fremdgasen zu überprüfen wurde reines CO2 und CO2 in Gegenwart von He sowie N2 bei 1020 mbar mit einem Perkin Elmer System 2000 FT-IR-Spektrometer gemessen. Bild 3 zeigt das Ergebnis. Im Strahlengang des Spektrometers befand sich jedes Mal die gleiche Anzahl an CO2-Molekülen. Reines CO2, das die niedrigste Absorption hat, wurde bei einer Schichtdicken von 0,35 mm gemessen. Die anderen in einer 10-cm-Küvette in Gegenwart von He (mittlere Absorption) und Stickstoff (größte Absorption).

Bild 3: Spektrum von CO2 (rein) und in Gegenwart von He sowie N2

Deutlich erkennbar ist, dass in bodennahen Schichten angeregte CO2-Moleküle durch strahlungslose Deaktivierung (Thermalisierung“) in den Grundzustand zurückkehren. Ähnlich wie es Jack Barrett in seiner Spectro Chimica Acta-Publikation 1995 feststellte.

Der Bereich, der nach IPCC-Angaben den zusätzlichen – anthropogenen – Treibhauseffekt präsentiert, ist durch Pfeile im Bild 3 kenntlich gemacht. Nun kann man argumentieren, wählt man eine Küvette mit einer Länge von 1 000 m findet man an den Rändern mehr „klimawirksame“ Absorptions-/Emissionsbanden. Dies insbesondere, wenn man eine Wegstrecke vom Erdboden bis zur Tropopause (ca. 10 000 m) wählt. Wie gesagt, das Diskussions-perpetuum-mobile lässt sich endlos in Gang halten.

3.1 Auswertung der eigenen Messungen

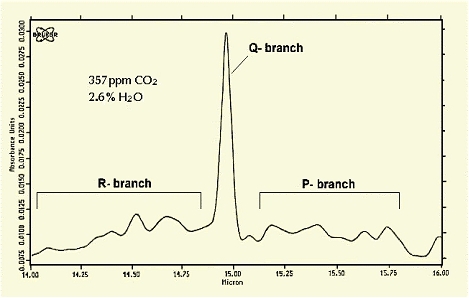

Bild 4 zeigt das unbearbeitete Spektrum der 15 µm-Bande für 357 ppm CO2 und 2.6% H2O.

(Bild 4: Unbearbeitetes Spektrum der 15 µm-Bande (ν2-Bande)

Deutlich sind wie im Bild 3 der R– (ΔJ = + 1) und der P– (ΔJ = – 1) sowie der Q-Zweig (ΔJ = 0) der n2-Bande zu erkennen. Der Extinktionskoeffizient im Maximum (ΔJ = 0) ergab sich zu:

e = 20,2 m2 mol-1 (ν2 bei 667 cm-1)

Um die Absorption zu berechnen, wurde der durchschnittliche CO2-Gehalt der Atmosphäre mit c = 1,03.10-3 mol/m3 angenommen. Setzt man die oben gemessenen molaren Extinktionen nebst der Konzentration und der Schichtdicke der Troposphäre (h = 10 km = 104 m) in das Lambert-Beer’sche-Gesetz ein, so erhält man eine Extinktion (Formelzeichen nach DIN: A) von

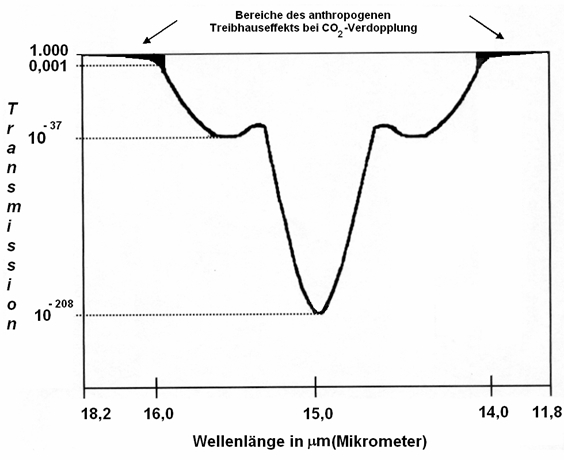

A(n2) = 20,2 m2 mol-1 × 1,03.10-3 mol/m3 × 104 m = 208

Dies bedeutet, dass die Transmissionen in der Mitte der Absorptionsbande bei den um 1997 gegebenen 357 ppm CO2 bei T(n2) = 10-208 liegt (Bild 5).

Bild 5: Spektrales Auswertungsschema

Dies ist ein extrem geringer Transmissionswert, der eine Steigerung des Treibhauseffektes bei Verdopplung des klimawirksamen Spurengases in diesem Bereich vollkommen ausschließt.

Setzt man den molaren Extinktionskoeffizient e für die n2-Bande sowie die Volumenkonzentration in mol/m3 (357 ppm CO2) in das Lambert-Beersche-Gesetz ein und nimmt eine Schichtdicke von 10 m an, resultiert eine Extinktion von

A = 20,2 m2 mol-1 × 0,0159 mol/m3× 10 m = 3,21

Dies entspricht einer Transmission von T = 10-3.21 = 0,6 Promille. Mit anderen Worten: Bereits nach 10 m absorbiert die Q-Bande 1 – T = 99,94% der IR-Strahlung.

Bei der Absorption an den Peakflanken ist die Extinktion naturgemäß kleiner. Deshalb stellt das IPCC 1990 fest, die Schwingungsrotationsbanden im mittlerem Bereich der 15 mm-Bande seien so gut wie gesättigt („saturated“), weshalb sie zum „Treibhauseffekt“ bei weiter erhöhter Konzentration kaum beitragen. Aber: „The effect of added carbon dioxide molecules is, however, significant at the edges of the 15 µm band, and in particular around 13,7 and 16,3 µm [14]“. D. h. Der vom IPCC als gefährlich eingestufte anthropogene Treibhauseffekt soll vor allem auf IR-Banden des Kohlendioxids unterhalb von 625 cm-1 bzw. auf oberhalb von 729 cm-1 beruhen [vgl. a. 36]. Was diese Aussage bedeutet, erkennt man am Besten, wenn man sich das Bild 3 noch einmal anschaut. Abgesehen davon stützen sich IPCC-Forscher auf eine vollkommen unbedeutende Oberschwingung des CO2 bei 9,6 mm, die, wie bei Oberschwingungen üblich, 15 bis 30mal schwächer ist als die zugehörige Grundschwingung. Hinzu kommen noch andere „Treibhausgase“ wie N2O, CH4 usw., auf die ich hier nicht eingehen kann. Selbst das Schwefelhexafluorid (SF6), das u. a. zur Füllung von Autoreifen verwendet wurde, damit die Fahrzeuge leiser dahinrollen, musste vor Jahren der befürchteten Klimakatastrophe weichen.

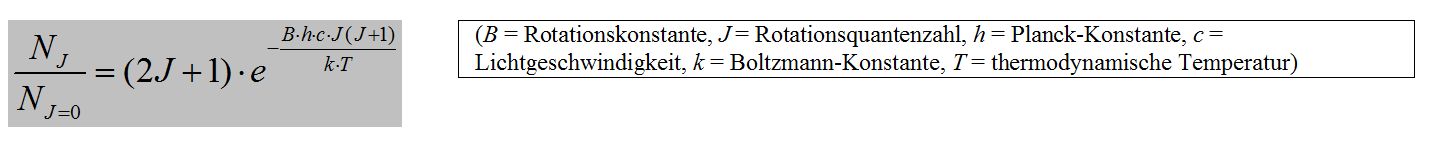

Natürlich existieren diese o. g. „edges“ um 15 mm, denn die Rotationsquantenzahl J geht von J = + 1 bis J = + ¥ und von J = – 1 bis J = – ¥. Bedauerlicherweise werden aber die „ungesättigten Bereiche“ des 15 mm-CO2-Spektrums an den Rändern immer schwächer.

Da die Besetzung (NJ/NJ=0) der Rotationsschwingungsniveaus der Boltzmann-Verteilung (Gleichung 4)

| (B = Rotationskonstante, J = Rotationsquantenzahl, h = Planck-Konstante, c = Lichtgeschwindigkeit, k = Boltzmann-Konstante, T = thermodynamische Temperatur) |

gehorchen, sind bei hohen Rotationsquantenzahlen (J) zu einem gegebenen, fixen Zeitpunkt („Momentaufnahme“) nur sehr wenige CO2-Moleküle vorhanden, die in diesem Bereich absorbieren und entsprechend dem Kirchhoffschen Strahlungsgesetz emittieren („Treibhauseffekt“). Wie schwach die Banden besetzt sind, kann man anhand folgender HITRAN-Daten überprüfen [6]:

| Wellenlänge | Absorptionskoeffizient pro Molekül in10-22 cm-1/(molec . cm2) |

| 13,5 mm (= 741,7 cm-1) | 76 |

| 15,0 mm (= 666,7 cm-1) | 79 452 (Bandenmitte) |

| 12,5 mm (= 797,3 cm-1) | 46 |

Um die Absorption an den Peakflanken abzuschätzen, wurde bei den eigenen Messungen als Arbeitshypothese angenommen, die Extinktion soll sich bei Verdopplung des CO2-Gehalts um die Größenordnung A = 3 (t = 10-3) erhöhen. Hierzu wurde das Gesamtintegral der Banden bis zu den auslaufenden Enden des R- und P-Zweiges bei A = 0 ermittelt (s. Bild. 5). Anschließend wurden die digital abgespeicherten Spektren ab einer Extinktion, die dem Wert A = 3 (Gesamtweg Erdboden-Troposphäre) entsprachen bis zu den auslaufenden Enden (A = 0) des R- und P-Zweiges integriert.

Da die Messwerte nur schwer reproduzierbar waren, wurden sämtliche Messungen 30mal wiederholt, so dass die „edges„ annähernd erfasst werden konnten. Diese „edges„ begannen beim P-Zweig bei 14,00 µm und beim R-Zweig bei 15,80 µm und liefen jeweils bis zur Grundlinie A = 0. IPCC lässt die Banden an den Rändern bei 13,7 und 16 µm beginnen und an der „HITRAN-Erfassungsgrenze“ enden [14]. Den eigenen Messungen nach ergaben sich für die n2-Bande:

| 15 µm-Bande | 357 ppm | 714 ppm |

| Gesamtintegral 624,04 cm -1 von 703,84 cm -1 | 0,5171/cm | 1,4678/cm |

| Summe der Flanken-Integrale | 1,11.10-4/cm | 9,79.10-4/cm |

Tabelle: 15 µm-Bande (Gesamtintegral und Flankenintegrale A = 0 bis A = 3)

Natürlich lassen sich Extinktionen nicht mit dem Planckschen-Strahlungsgesetz kombinieren. Das ist auch gar nicht die Absicht. Aber der aus daraus abschätzbare relative Zuwachs bei Verdopplung des CO2-Gehalts ist entscheidend. Er entspricht der Differenz der Flankenintegrale bei 714 ppm und 357 ppm im Verhältnis zum Gesamtintegral bei 357 ppm.

(9,79.10-4/cm – 1.11.10-4/cm) / 0,5171/cm = 0,17 %

Wie bereits erwähnt, es handelt sich nur um eine Abschätzung und nicht um einen exakten Messwert. Dennoch macht er deutlich, auf welch geringfügigen Größen sich die seinerzeit im Spiegel (33/1986) prophezeite „Klimakatastrophe“ stützt.

3.2. Kritik der eigenen Messungen

Obwohl die oben angegebenen Messwerte relativ ungenau sind, hatte ich sie seinerzeit veröffentlicht, weil

– erstens jeder Chemiker und nicht direkt mit der Klimaforschung befasste Physiker, wohl wissend um die Eigenschaften IR-aktiver Spurengase, unter Eindruck der Medienhype davon ausgehen musste, dass eine Verdopplung des atmosphärischen CO2 zu einer erheblichen Steigerung (eventuell sogar Verdopplung) des Treibhauseffekts führen sollte. Ich jedenfalls und ca. 30 Chemiker aus Industrie und Hochschule hatten nach meiner eigenen ca. 20 Jahre zurückliegenden Rundfrage in etwa mit einer Verdopplung des Treibhauseffekts bei 100 % mehr CO2 gerechnet.

– Zweitens die Geringfügigkeit des anthropogenen Treibhauseffekt bei der Information der Medien durch die direkt damit befassten „Klimamodellierer“ vornehm verschwiegen wurde. So etwas aber „gehört Sonntags auf den Tisch.“

Interessanterweise werden meine Messergebnisse auch durch die Aussage des Nobelpreisträges Paul Crutzen gestützt. Dieser schrieb1993 in einem Lehrbuch [21]: „Es gibt bereits so viel CO2 in der Atmosphäre, dass in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr.“ Demnach ist der Treibhauseffekt auch nach Aussage dieses Nobelpreisträgers nahezu „gesättigt“. Man kann es auch so ausdrücken: Ein Treibhaus heizt sich bestenfalls geringfügig (Spureneffekt!) stärker auf, wenn man das normale Fensterglas gegen ein zehn Zentimeter dickes Panzerglas austauscht!

Die zur Messung verwendeten FT-IR-Spektrometer werden im Chemie- und Pharmabereich sowohl in der Industrie als auch an den Hochschulen mit großem Erfolg eingesetzt (vgl. Bild 3 und 4). Sie besitzen aber nur einen Spiegelweg von 5…15 cm. Dies ergibt eine Auflösung der IR-Banden von 0,2…. 0,07 cm-1. Da die „ungesättigten“ Spektralbereiche ungewöhnlich schwache IR-Banden betrifft, benötigt man Spektrometer, die eine Auflösung von 0,0004 cm-1 erbringen [6]. Hierzu muss man ein FT-IR-Spektrometer bauen, das theoretisch über einen Spiegelweg von 2.500 cm (25 m!) verfügt. Nur dann lassen sich die äußerst schwachen IR-Banden messen, auf die sich die Klimamodellierer des IPCC stützen. Es sind Banden, mit einer „Absorptionsstärke“ von nur 0,05 % der 15 mm CO2-Hauptbande!

Die üblicherweise in der Industrie und Hochschulforschung verwendeten FT-IR-Spektrometer mit geringerer Auflösung kosten je nach Ausstattung zwischen 4 000 bis 10 000 Euro. Ein FT-IR-Spektrometer, wie das Bruker IFS 125 HR, mit denen man die Akkuratesse der HITRAN-Datenbank erreichen kann, kostet mindest 125 000 Euro. Ein Industriechemiker, der eigenmächtig ein solches Gerät beispielsweise zur Strukturaufklärung organischer Moleküle anschaffen würde, müsste mit seiner sofortigen Kündigung rechnen. Und das zu recht! Geräte dieser Art sind nur dann sinnvoll, wenn man Spureneffekte messen möchte. Deshalb findet man die Geräte vor allem in Instituten, die sich im Auftrag der Politik mit atmosphärischen Ultraspuren beschäftigen. Das Geld hierfür stammt vom Steuerzahler.

4. Vergleich mit den offiziellen Daten des IPCC

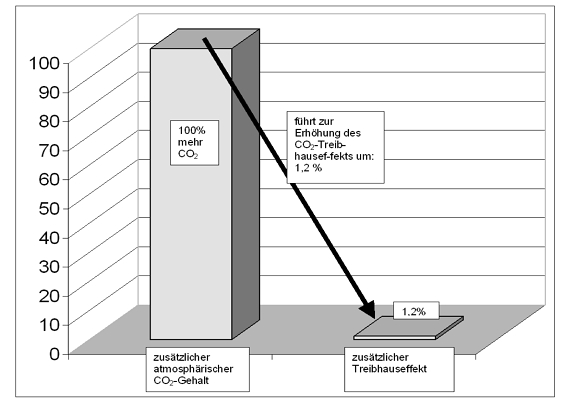

Nimmt man die offiziellen Zahlen (IPCC), dann beträgt der „natürliche“ Treibhauseffekt“ 324 W/m2 [22, 23]. Bei Verdopplung des CO2 (100 % Steigerung!) wird nach Übereinkunft („best guess“) angenommen, dass sich der Strahlungsantrieb um 3,7 W/m2 erhöht [23, 24]. Im Bild 6 sind die Verhältnisse dargestellt.

Bild 6: Prozentuale Erhöhung des Treibhauseffekts bei Verdopplung des atmosphärischen CO2-Gehalts gemäß der offiziellen Angaben des IPCC

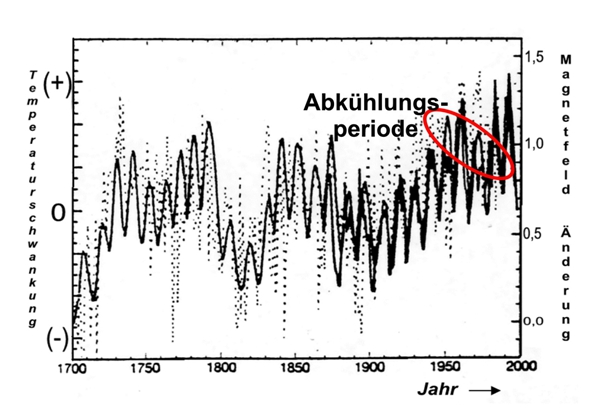

Auch das Bild 6 belegt die oben beschriebene weitestgehende Sättigung, denn die Steigerung des Treibhauseffekts bei CO2-Verdopplung beträgt nur geringfügige 1,2 %. Dies ist in der Klimaforschung bekannt. Deshalb wird versucht, den „Sättigungscharakter mit dem Argument zu entkräften, das Klima sei ein so empfindliches System, dass es bereits von kleinsten Änderungen des Strahlungsantriebs aus dem Gleichgewicht gebracht werden kann. So wird behauptet, die Abkühlung zwischen 1930 und 1970 sei durch die Staubbelastung der Industriegesellschaft verursacht. Dies ist falsch. Die Abkühlung war durch das geänderte Magnetfeld der Sonne verursacht, wie aus dem Bild 15 (rot eingekreist) hervorgeht.

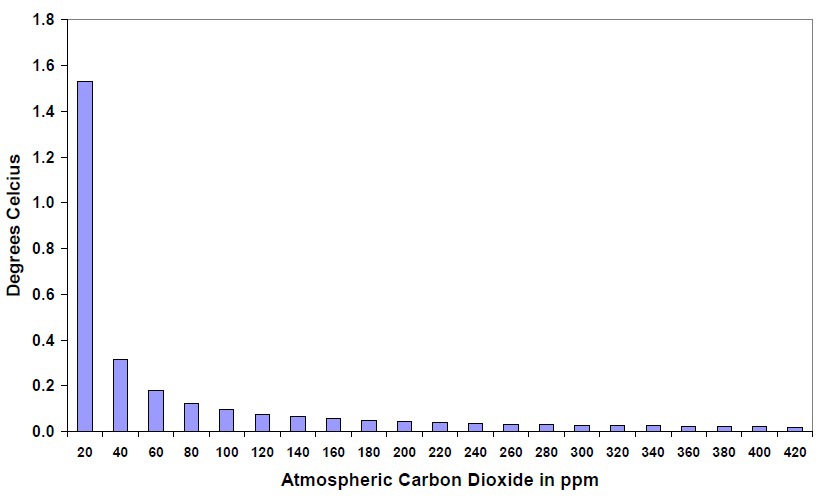

Neben der HITRAN-Datenbank kann zur Berechnung des allgemeinen und anthropogenen Treibhauseffekt das von der US-Airforce und der Fa. Spectral Sciences Incorporated entwickelte MODTRAN-Programm genutzt werden, dem sich auch die Forscher des IPCC bedienen. David Archibald hat mit Hilfe des MODTRAN-Programms der Universität Chikago [37] die Abhängigkeit der Erdoberflächentemperatur vom atmosphärischen CO2-Gehalt berechnet. Das verblüffende Ergebnis zeigt das Bild 7.

Bild 7: Wirkung des CO2 und Anstieg der mittleren Erdtemperatur

Der höchste Anstieg der mittleren Erdoberflächentemperatur wird von 20 ppm CO2 bewirkt. Danach fällt der Einfluss des CO2 rapide ab. Dies verwundert nicht, denn der Einfluss der „edges“ wird bei höherem CO2-Gehalt immer geringer. Nicht zuletzt deshalb war der CO2-Treibhauseffekt bereits zu Goethes Zeiten weitgehend ausgereizt.

5. Erdoberflächentemperatur, Treibhauseffekt und CO2-Konzentration

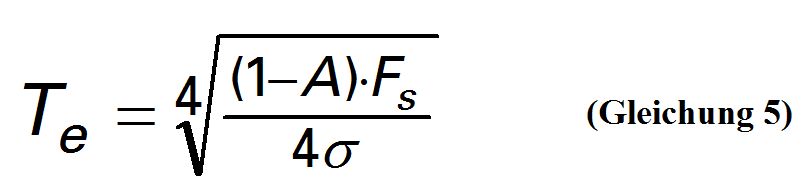

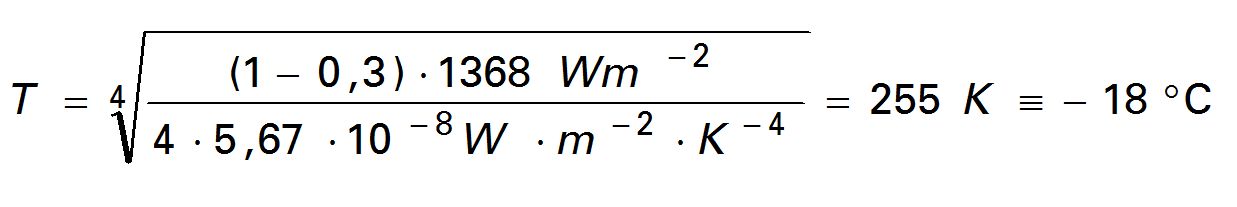

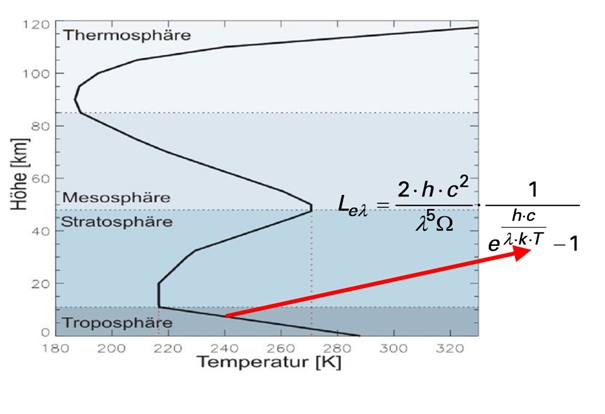

Zur Berechnung der irdischen Oberflächentemperatur ohne Treibhausgasatmosphäre wird allgemein und nicht nur von den IPCC-Forschern eine einfache Gleichung benutzt, die auf dem Stefan-Boltzmann– Gesetz beruht.

A ist dabei die Albedo – das durchschnittliche „Rückstrahlvermögen“ der Erde (nicht mit der Extinktion A verwechseln!). Sie wird mit A= 0,3 angenommen. Tatsächlich existierten in der Vergangenheit auch andere Angaben. Die Solarkonstante, die in Wirklichkeit gar nicht so konstant ist, hat den Wert Fs = 1368 W/m2. Weiterhin enthält die Gleichung die Stefan-Boltzmann-Konstante s = 5,67 . 10-8 W.m-2.K-4.

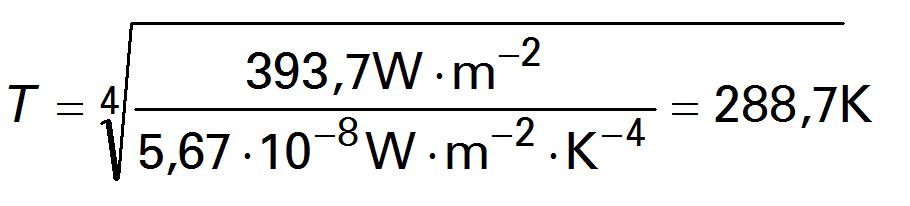

Rechnet man mit diesen Angaben, so resultiert für die Oberflächentemperatur der Erde:

Das Ergebnis ist fragwürdig. Die Erde ist nämlich kein wasserloser Gesteinshaufen im Weltall. Sehr wahrscheinlich liegt die irdische Mitteltemperatur ohne Treibhausgase um einiges höher! Aber bleibt man zunächst einmal dabei, dann beträgt die spezifische Ausstrahlung der Erdoberfläche bei dieser Temperatur (Formelzeichen M nach DIN 5031, Teil 1):

M1 = (1-0,7) . 0,25 . 1368 W/m2 = 239 W/m2

Für die Klimanormalperiode bezeichnet, hat man sich vor Jahren unter Konsensbildung auf eine Mitteltemperatur von + 15 °C (T = 288 K) geeinigt. Benutzt man jetzt das „unveränderte“ Stefan-Boltzmann-Gesetz

![]()

und berechnet damit die spezifische Ausstrahlung der Eroberfläche erneut, resultiert:

![]()

Folglich erhöht der „natürliche“ Treibhauseffekt, mit einer hypothetische Erwärmung von DT = 288 K – 225 K = 33 K (33 °C), die spezifische Ausstrahlung der Erdoberfläche um

DM = M2 – M1 = 390,0 W/m2 – 239,0 W/m2 = 151 W/m2

Wie bereits oben erläutert, wird bei Verdopplung des CO2 (100 %ige Steigerung) ein zusätzlicher Strahlungsantrieb von 3,7 W.m-2 angenommen (anfänglich gab IPCC 4,2 W.m-2 an, die Größenordnung entzieht sich der Falsifikation und beruht auf Konsens – „best guess“!).

Nimmt man die besagten 3,7 W.m-2, dann steigt die spezifische Ausstrahlung der Eroberfläche von 390,0 W.m-2 auf 393,7 W.m-2. Setzt man diesen Wert in die Stefan-Boltzmann-Gleichung (Gleichung 6) ein, resultiert als Erdoberflächentemperatur:

Demnach erhöht sich die Temperatur bei CO2-Verdopplung (100 % mehr CO2!) von 288,0 K auf 288,7 K. Das entspricht gerade einmal DT = 288,7 K – 288,0 K = 0,7 K (0,7 °C) und nicht mehr. Die Klimamodellierung hätte keinerlei politische Beachtung gefunden, wenn man nicht die Hypothese der Wasserdampfverstärkung in die Diskussion eingebracht hätte. Diese lässt sich jedoch glücklicherweise falsifizieren, wie im nächsten Absatz dargelegt wird.

6. Die Wasserdampfverstärkung

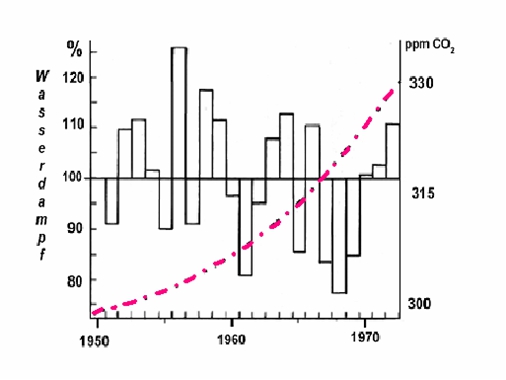

Da eine Erwärmung von lediglich 0,7 °C bei 100 % mehr CO2 zu wenig erscheint, hat man sich vor Jahren darauf geeinigt, dass diese geringfügige Temperaturerhöhung gemäß der altbekannten Clausius-Clapeyronschen-Gleichung deutlich mehr Wasser aus den Ozeanen verdunsten lasse. Weil Wasserdampf ein Treibhausgas ist, fällt deshalb Temperaturerhöhung durch CO2 wesentlich höher aus. Originalton IPCC [25]: „Der ‚Wasserdampf-Feedback’ ist nach wie vor der durchweg wichtigste Rückkopplungseffekt, der die von den allgemeinen Zirkulationsmodellen als Reaktion auf eine CO2-Verdopplung vorhergesagte globale Erwärmung verursacht.“ Wenn dies richtig ist, muss besonders in einer kälteren Periode, während der die direkte Solarstrahlung nicht so viel Wasser verdunsten lässt, dennoch der Wasserdampfgehalt (Balken in Bild 8) über den Ozeanen parallel mit dem atmosphärischen CO2-Gehalt ansteigen (rote Strich-Punkt-Linie in Bild 8). Dies ist eindeutig nicht der Fall ist, wie das Bild 8 belegt [32]. Deshalb können sich die Klimamodellierer auf keinen Fall auf den durchaus einleuchtenden, hypothetischen Wasserdampfverstärkungsmechanismus berufen, der eine viel zu große Temperatursteigerung prophezeit.

Bild 8: Prozentuale Abweichung des Wasserdampfgehalts über dem Atlantik [s. a. 34]

Um Missverständnissen vorzubeugen: Mit der Prozentangabe im Bild 8 ist natürlich nicht die relative Luftfeuchte gemeint, die niemals höher als 100 % sein kann, sondern vielmehr die Abweichung des Wasserdampfgehalts nach oben und nach unten um den Messwert von 1950. So liegt der absolute Wasserdampfgehalt 1956 um 25 % höher als 1950. 1968 liegt der Wasserdampfgehalt um ca. 45 % niedriger, obwohl der CO2-Gehalt weiter angestiegen ist! Auch wenn der Zeitraum relativ kurz gewählt ist, so belegt er eindeutig, dass die Wasserverdunstung über den Ozeanen nicht mit dem steigenden CO2-Gehalt korreliert. Die Wasserdampfverstärkung, auf denen sämtliche Vorhersagen der Klimamodelle beruhen, existiert nicht.

7. Die Strahlungstransportgleichung

Bei der Berechnung des Treibhauseffekts wird ein „Schicht- oder Kaskadenmodell“ zugrunde gelegt nach dem innerhalb der Atmosphäre eine ständige Absorption (I) und Emission (L) stattfindet. Diesem fiktiven Strahlungstransport liegt die Schwarzschild-Gleichung zugrunde, die ursprünglich entwickelt wurde, um das Verhalten von Atomen in einer Sternenatmosphäre zu beschreiben [12]. Bei einem infinitesimalen Weg dz, dem Absorptionskoeffizienten sa und der Teilchenzahl n gilt hierfür im lokalen thermodynamischen Strahlungsgleichgewicht (LTE):

![]()

Die Größe L ist hierbei die Strahldichte (vgl. DIN 5031, Teil 1), welche die Emission gemäß der temperaturabhängigen Planck-Strahlungsgleichung angibt.

Dass innerhalb der Atmosphäre ein Strahlungstransport stattfindet, meint man belegen zu können, indem man die gemessenen Satellitenspektren mit den berechneten vergleicht. Das Ergebnis ist verblüffend, wie das Bild 9 belegt.

Bild 9: Links das gemessene Emissionsspektrum der Erde (Satellitenspektrum); rechts das mit Hilfe der Strahlungstransportgleichung berechnete Emissionsspektrum

Das lokale thermodynamische Strahlungsgleichgewicht (LTE) begründet man mit dem Kirchhoff’schen Gesetz der Wärmestrahlung. Danach ist das Emissionsvermögen eines Körpers genau so groß wie sein Absorptionsvermögen. Das Ganze hat nur einen Haken. Es existiert kein „Strahlungsenergieerhaltungssatz“, wie er bei diesem Mechanismus stillschweigend vorausgesetzt wird. Tatsächlich setzt man bei der „nachvollziehenden“ Berechnung der Satellitenspektren das gemessene atmosphärische Temperaturprofil in die Plank-Strahlungsgleichung ein, wie im Bild 10 gezeigt.

Bild 10: Strahlungstransport, Planck-Gleichung und gemessener Temperaturgradient

Zur Erinnerung: Beim Treibhauseffekt geht es auch um den Temperaturgradienten („Temperaturprofil“), den die Atmosphäre im Kontakt mit dem Erdboden unter adiabatischer Expansion annimmt. Lässt man sich dies durch den Kopf gehen, dann wird das Ergebnis – die Temperatur bzw. der Temperaturgradient – in die Planck-Gleichung eingesetzt (vgl. Bild 10), um dann daraus das temperaturabhängige Emissionsspektrum der Atmosphäre und des Erdkörpers zu erhalten (vgl. auch Bild 2). Deshalb ist die Übereinstimmung der im Bild 10 gezeigten Spektren kein Beweis für den Strahlungstransport innerhalb der Atmosphäre. Es ist vielmehr ein Beweis, dass man im Kreis herumrechnet und sich dann über den mathematisch „bewiesenen“ Treibhauseffekt im Sinne eines Strahlungsenergieerhaltungssatzes freut. Natürlich kann man auch die gemessene Emission innerhalb einer Schicht (Strahldichte L) in die Planck-Gleichung einsetzen, um dann die Temperatur zu erhalten. Auch dann wird im Kreis herum gerechnet.

Experimentelle Untersuchungen und die allgemein akzeptierte Theorie belegen eindeutig, dass die Molekülfluoreszenz anders funktioniert wie die Atomfluoreszenz, bei der die absorbierte Strahlung zu 100 % wieder emittiert wird. Dies geschieht in einem Atomabsorptionsspektrometer (AAS-Gerät), mit dem man in der Instrumentellen Analytik Metalle in Proben quantifiziert (z. B. Cd in einer Bodenprobe).

Das LTE setzt eine „100%ige Molekülfluoreszenz“ voraus, die nicht existiert – auch nicht im IR-Bereich (vgl. a. Bild 3) [26, 27]. Während angeregte Atome nur unter Emission von Strahlung in den Grundzustand zurückkehren können, erfolgt die Relaxation bei Molekülen wegen der Rotations- und Schwingungsfreiheitsgrade meist strahlungslos gemäß den Prinzipien des Jablonski-Diagramms [28]. Deshalb reichte es eigentlich vollkommen aus, wenn man den „theoretischen“ Treibhauseffekt ohne jegliche Absorption nur mit der – temperaturabhängigen – Planck-Gleichung beschreibt, die man mit den jeweiligen Bandenstärken „klimawirksamer“ Spurengase und der „Anzahl IR-aktiver Moleküle in einem Luftvolumen“ multipliziert. Berücksichtigung man den Raumwinkel, erhält man die thermische Emission der Atmosphäre innerhalb eines Halbraums.

Fazit:

Dass eine atmosphärische Wärmestrahlung gemäß dem Planck-Gesetz gegeben ist, ist eine Selbstverständlichkeit. Solange aber ein atmosphärisches Temperaturprofil (oben kälter – unten wärmer) existiert, und die Konvektion erheblich zum Energietransport beiträgt, solange ist die Hypothese, im offenen System der Atmosphäre wird die Energie einer erdbodennah absorbierten IR-Strahlung mittels Strahlungstransport von unten nach oben weitergereicht, falsch. Es gibt nämlich keinen „Strahlungsenergieerhaltungssatz“. Vielmehr übertragen angeregte „erdbodennahe Treibhausgasmoleküle“ ihre Energie im Wesentlichen auf die nicht IR-aktiven Hauptbestandteile des Atmosphäre (N2 und O2).

Interessanterweise wird die Strahlungstransportgleichung angewandt, wenn man das Abkühlungsverhalten großer Glaskörper mittels Modellierung kontrollieren will, etwa bei der Herstellung von Spiegelteleskopen. Dies funktioniert sehr gut. Weil es nämlich in einer erstarrten Glasschmelze bei 600 K keine Konvektion gibt!

8. Was Klimamodelle nicht können

Klimamodelle sind Computeralgorithmen (sprich: „Rechenvorschriften“, welche die meinungsabhängigen Vorgaben der Programmierung widerspiegeln) und nicht die Realität. Weil die Komplexität des Klimageschehens gegenwärtig und auch in absehbarer Zukunft mit keinem Computer realitätsorientiert erfassbar sein dürfte, handelt es sich mehr um politische Instrumentarien, denn um exakte Naturwissenschaft.

8. 1 Die Flusskorrekturen

Der Hypothese nach soll der „natürliche“ Treibhauseffekt den Globus um 33 °C aufheizen. Irrigerweise wird dabei angenommen, die Erde, die zu 70 % mit Wasser bedeckt ist, würde sich ähnlich verhalten wie der vollkommen wasserlose Mond. Nimmt man an, nur die ersten 10 m Wassertiefe der Ozeane würden die mittlere Erdtemperatur thermostatisch regeln, ergibt die Rechnung, dass die Ozeane im Temperaturbereich von –18 °C bis +15 °C eine Energiemenge von 1,57.1018 MJ speichern. Hierzu die Gegenrechnung: In 24 Stunden werden durch den irdischen Treibhauseffekt 1,43.1016 MJ umgeschlagen [23]. Der gesamte natürliche Treibhauseffekt macht somit nur 0,9 % der Energie aus, die in den Ozeanen bei einer Wassertiefe bis zu 10 m gespeichert ist. Die Folge sind erhebliche Schwierigkeiten bei der Kopplung atmosphärischer Zirkulationsmodelle („General Circulation Atmospheric Models“) mit ozeanischen Zirkulationsmodellen („General Circulation Oceanic Models“). Diese Probleme lassen sich nur mit Hilfe so genannter „Flusskorrekturen“ überwinden, deren Beträge, wie das Bild 11 belegt, um ein Vielfaches größer sind als der anthropogene Treibhauseffekt. Die rechte Säule in Bild 11 stellt den Strahlungsantrieb des CO2 bei Verdopplung dar. Danach ist allein schon die 100 W/m2-Flusskorrektur zur Kopplung Ozeanoberfläche-Atmosphäre rund 27-mal (!) größer als der anthropogene Treibhauseffekt bei CO2-Verdopplung (3,7 W/m2).

Bild 11: Anthropogener Treibhauseffekt (rechte kleine Säule) im Verhältnis zu den bei der Klimamodellierung angewandten Flusskorrekturen

Es soll nicht unerwähnt bleiben, dass von einschlägigen Instituten in neuerer Zeit verlautbart wird, man benötige keine Flusskorrekturen mehr. Tatsächlich kommen Klimamodelle nach wie vor nicht ohne sie aus.

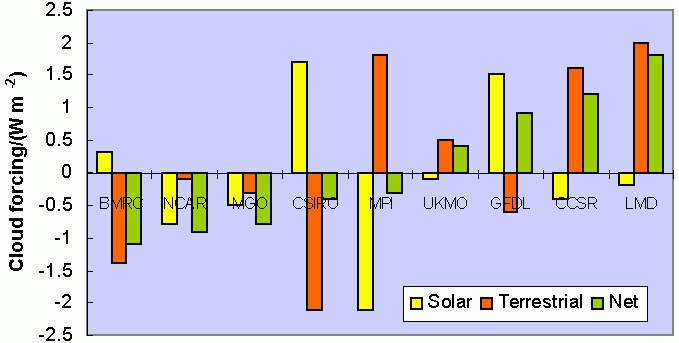

8. 2 Die Wolkendichte

Bei der Abschätzung des Strahlungsantriebs der Wolken kommen Klimamodelle zu äußerst unterschiedlichen Ergebnissen. So findet das „Bureau of Meteorology Research Center“ (BMRC) von Australien, dass die Wolken eine Abkühlung von ca. 1 W/m2 erbringen, während das Labaratoire de Météologie Dynamic (LMD) aus Frankreich meint, Wolken würden eine Erwärmung von ca. 1,7 W/m2 bewirken (Bild 12). Auch das ist beachtenswert!

Bild 12: Strahlungsantrieb der Wolken mit unterschiedlichen Klimamodellen gerechnet

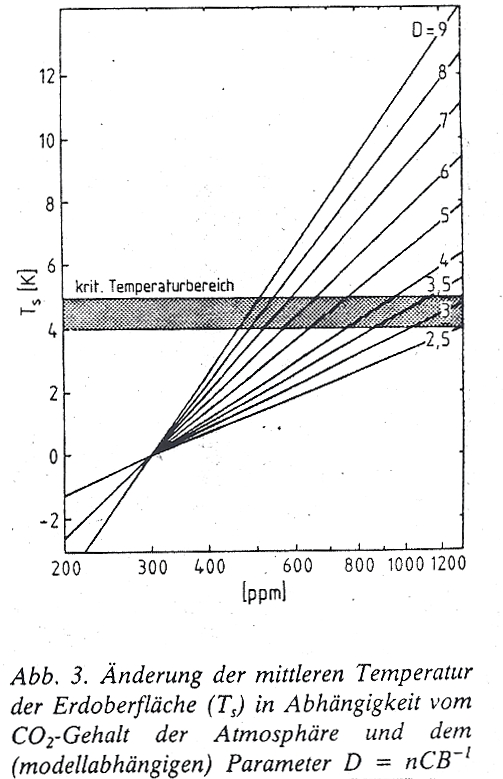

8. 3 Modellabhängige Parameter

In der bereits mehrfach zitierten Veröffentlichung von Hermann Flohn [5] stellt dieser in einer Graphik den globalen Temperaturanstieg gemäß einschlägiger Computermodellierungen vor (Bild 13). Flohn referiert in dem Aufsatz den Stand der Klimamodellierung von 1984, auf der wenig später in geringfügig verbesserter Form der Erdumweltgipfel Rio92 basierte.

Bild 13: Mittlere Erdbodentemperatur und modellabhängiger Parameter

Interessant ist bei dem einfachen Modell, das Flohn referiert, der modellabhängige Parameter „D“, der die Steigung der jeweiligen Geraden angibt.

![]()

Je größer D ist, desto stärker fällt der Temperaturanstieg aus. Die Größe n ist das Verhältnis der mit Unsicherheit belasteten Strahlungsbilanz aller Spurengase zur Strahlungsbilanz von CO2:

![]()

B und C bezeichnet Flohn vornehm als „Sensitivitätsparameter“, die u. a. natürlich die Wasserdampfverstärkung berücksichtigen (B= 1,8 W . m . K-1, C = 6,5 W . m . K-1). Flohn gibt für die Parameter einen Unsicherheitsfaktor von ca. 20 % an. D. h. je nach dem, wie n, B und C gewählt werden, resultieren im Computer (!) dramatischere oder weniger dramatischere Klimaänderungen. Dass es heute ausgefeiltere Modelle gibt, daran zweifle ich nicht, aber so lange der Wasserdampfverstärkungsmechanismus in ihnen enthalten ist, so lange sind höchste Zweifel angebracht.

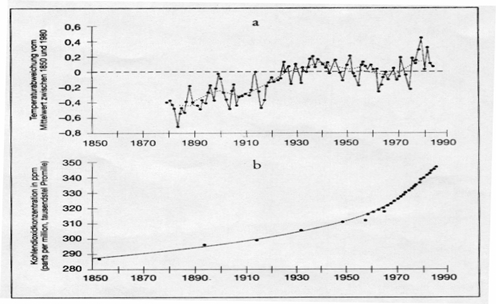

8. 4 Die Vergangenheit

Weiterhin versagen Klimamodelle bei der Reproduktion der Vergangenheit. So können sie bis heute nicht die im Bild 14 gezeigte Abkühlung zwischen 1930 und 1975 ohne Zuhilfenahme von Kunstgriffen (atmosphärischer Staubeintrag durch die Industriegesellschaft!) nachvollziehen. (Die tatsächliche Ursache des ungewöhnlichen Verlaufs zeigt Bild 15.)

Bild 14: CO2-Gehalt und Temperaturverlauf

Im Sachstandsbericht des IPCC von 2001 tauchte noch eine Kurve auf, die das römische und das mittelalterliche Klimaoptimum zeigte, Zeiten, die mindestens so warm waren wie heute. So wurde Grönland 875 vom Wikinger Erik „der Rote“ Thorvaldsson besiedelt, der Bischof von Trondheim konnte damals seinen eigen Wein ernten und es existierten hochgelegene Gebirgsdörfer, die während der kleinen Eiszeit aufgegeben wurden und heute infolge des Gletscherrückgangs wieder auftauchen. Das stört. Deshalb kursierte in IPCC-Kreisen die Formulierung „We have to get rid of the Medieval Warm Period“. Dem wurde nachgekommen. 1999 veröffentlichte Michael E. Mann et al. Die berühmte Hockeystick-Kurve [1], in der sämtliche vorindustriellen Erwärmungsperioden „weggebügelt“ waren und die Gegenwart als wärmste Periode seit dargestellt wurde. Stephen McIntyre und Ross McKittrick haben die Studie inzwischen gründlich widerlegt [38]. U. a. konnten fast beliebige Zahlen in den Mann benutzte Programm eingesetzt werden, immer resultierte ein „Hockeystick“.

9. Die Alternative

Da treibhausgasfixierte Computer-Klimamodelle nicht nur im Zeitraum zwischen 1930 bis 1970 versagen sondern auch die kleine Eiszeit (14. bis 18. Jh.) und das mittelalterliche Klimaoptimum (11. – 13. Jh.) nicht nachbilden können, muss es einen anderen entscheidenden Mechanismus geben.

Sehr viel spricht dafür, dass dies die Wolkendichte ist, die von der kosmischen Strahlung beeinflusst wird, wie der Direktor des Centre for Sun-Climate Research des Danish National Space Center, Henrik Svensmark, seit Jahren betont [39]. Die kosmische Strahlung besteht überwiegend aus Protonen, die als Echo des Urknalls in unser Sonnesystem eindringen. Gelangen diese positiv geladenen Kernbausteine in die Atmosphäre, so führen sie über einen noch nicht restlos geklärten Mechanismus zur Kondensation von Wasserdampf – Wolken entstehen. Erhöht sich bei höherer Solaraktivität das Magnetfeld der Sonne, dann werden die Protonen stärker abgeschirmt. In der Folge entstehen weniger Wolken und die einfallende Sonnenstrahlung kann die Erdoberfläche (Ozeanoberflächen!) stärker erwärmen. Deshalb folgt der globale Temperaturverlauf der Schwankung des solaren Magnetfelds (Bild 15).

Bild 15: Solares Magnetfeld und Globaltemperatur [29, abgewandelt]

Wie Messungen zeigen, war im übrigen die Solaraktivität seit dem Jahr 850 noch nie so hoch wie nach 1940 [30]. Auch im Wärmehaushalt der Weltmeere macht sich die wolkenbedeckungsabhängige Schwankung der solaren Einstrahlung stärker bemerkbar. Somit dürfte der anthropogene Treibhauseffekt eine kleine, aufgesetzte Größe auf einer natürlichen Klimaschwankung sein.

Abgesehen davon erscheint die unter Punkt 5 (Gleichung 5) vorgerechnete Temperatur von – 18 °C, welche die Erde ohne Treibhausgase angeblich hätte, viel zu niedrig angesetzt sein. Sie entspricht aber der offiziellen Doktrin, die – und das muss betont werden – eine Hypothese ist. Weil, wie bereits hervorgehoben, die Erde kein wasserloser Gesteinshaufen im Weltall ist, sondern zu 70 % mit Wasser bedeckt ist, muss die direkte Absorption im nahen Infrarotgebiet (NIR) und die sehr verzögerte Strahlungsemission von Ozeanwasser stärker berücksichtigt werden.

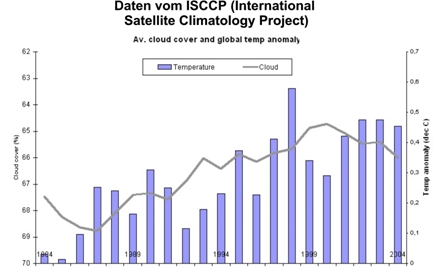

((Bild 16: Wolkenbedeckung (Wolkendichte) und globale Temperatur))

Aus dem Bild 16 geht hervor, dass sich die globale Wolkenbedeckung zwischen 1986 und 2000 von 69 % auf 65 % reduzierte (linke Ordinate, „fallend“ aufgetragen). Parallel hierzu stieg die globale Mitteltemperatur (rechte Ordinate, „steigend“ aufgetragen).

Während die Temperaturschwankungen in der Sahara im Tagesverlauf ohne weiteres bis zu Dd = 50 °C betragen können, verhalten sich Meere wesentlich träger. Der Gesamtwärmeumsatz (Wärmeenergie nicht Wärmeleistung!) eines Meeres ist die Summe vieler Größen:

Qges = (QS – QA) – QK – QV – QT + QC + QE + QF + QR

QS = im Meer absorbierte Sonnen- und Himmelsstrahlung (= „Treibhauseffekt“)

QA = effektive Ausstrahlung

QK = „fühlbarer“ Wärmeübergang Luft-Wasser

QV = latenter Wärmeübergang Luft-Wasser (Verdunstung, Kondensation)

QT = Wärmetransport durch Strömung

QC = chemisch-biologische Prozesse

QE = Wärmezufuhr aus dem Erdinnern

QF = Reibungswärme

QR = radioaktiver Zerfall

Da die Speicherfähigkeit des Wassers erheblich über der von Gesteinen liegt, ist es ausgeschlossen, dass sich die Erde bei einer Trägheit des Systems Wasser-Luft nachts schlagartig um 50 °C herunterkühlen. Denn insbesondere die Abstrahlungsleistung dQA/dt unterscheidet sich wegen der wesentlich höheren Wärmespeicherungsfähigkeit von Meerwasser deutlich von jener der Sahara. Gemäß der Stefan-Boltzmann-Gleichung (Gleichung 6) hängt nämlich die spezifische Ausstrahlung der Erdoberfläche mit der Temperatur unmittelbar zusammen. Je höher die letztere ist, desto größer ist auch die Abstrahlung.

Aus der obigen Aufzählung geht aber hervor, dass der Energiegehalt des Meerwassers auch auf der Wärmezufuhr aus dem Erdinnern, auf chemisch-biologischen Prozessen, auf radioaktiven Zerfall und auf Reibungswärme beruht. Die Größe QF (Reibungswärme) in der obigen Aufzählung hängt von der Windgeschwindigkeit ab. Wie H. Volz auf einer Tagung der Bayerischen Akademie der Wissenschaften berichtete, differiert die spezifischen Ausstrahlung bei den Windstärken 0 und 7 in einer Größenordnung von DM = 11,1 W/m2 [31]. Die Ein- und Ausstrahlungsbilanz geht aber von einer ruhenden See aus. Addiert man diese Größe zur spezifischen Ausstrahlung bei 15 °C, so erhält man:

M = 239,0 W/m2 + 11,1 W/m2 = 250,1 W/m2

Eingesetzt in die Gleichung 2 resultiert für die Temperatur T = 257,7 K (- 15,3 °C). Diese Temperatur liegt um 2,7 °C höher, als die besagten – 18 °C. Die Treibhausgase erhöhen dann die Mitteltemperatur nicht um 33 °C sondern „nur“ um 30,3 °C, insofern die These richtig ist, wonach die „normale“ Mitteltemperatur der Erde + 15 °C beträgt. Wie hoch war diese eigentlich während des mittelalterlichen Klimaoptimums (11. – 13. Jh. ) und während der „kleinen Eiszeit“ (14. bis 18. Jh)?

Ein weiteres kommt hinzu. Etwa 50 % der Sonneneinstrahlung, die den Erdboden erreicht, ist Wärmestrahlung (nahes und mittleres IR). Diese wird vom Meerwasser absorbiert. Die strahlungsfixierte Treibhausgastheorie saldiert nur die Einstrahlung und Ausstrahlung im Tagesverlauf als könnten sich die Weltmeere auf der Nachtsseite schlagartig auf – 18 °C abkühlen. Die Trägheit der Ozeane ist aber mit einer Relaxationszeit bis zu 200 Jahren sehr hoch. Folglich dürfte die mittlere globale Gleichgewichtstemperatur der Ozeane ohne atmosphärische Treibhausgase eher um + 4 °C (Wasser höchster Dichte am Grunde eines zugefrorenen Gewässers) denn bei – 18 °C liegen.

Als ich vor einiger Zeit einmal mit einem ehemaligen Leiter eines Klimarechenzentrums korrespondierte und ihn fragte, wie hoch die irdische Mitteltemperatur ohne Ozeane anzusetzen sei aber mit dem gegenwärtigen atmosphärischen Treibhausgasgehalt, erhielt ich zur Antwort, dies sei eine interessante Frage, die man aber bislang nicht durchgerechnet habe.

Zusammenfassung

· Der anthropogene Treibhauseffekt ist im wesentlichem ausgereizt, wie die Messung der Transmission von IR-Strahlung belegt. Eine globale Klimakatastrophe ist daher selbst bei einer CO2-Verdoppelung nicht zu erwarten.

· Die Steigerung des Treibhauseffekt von 324 W . m-2 auf um 327,7 W . m-2 bei 100 % mehr CO2 ist eine 1,2 %ige Geringfügigkeit (s. Bild 6), die man nur mit Hilfe des hypothetischen Wasserdampfverstärkungsmechanismus künstlich vergrößern kann.

· Zweifellos enthält die Atmosphäre gemäß der Clausius-Clapeyronschen-Gleichung mehr Wasserdampf, wenn es wärmer wird. Jedoch lässt sich der hypothetische Wasserdampfverstärkungsmechanismus, ohne den die Klimamodelle nicht auf die politisch erwünschten Temperatursteigerungen kommen, in der Realität nicht nachzuweisen. Weil sich somit der atmosphärische Wasserdampfgehalt nicht an der Konzentration der Treibhausgase orientiert, erhöht sich die globale Mitteltemperatur bei 100 % mehr CO2 bestenfalls um 0,7 K (0,7 °C). Natürlich lassen sich genügend „Computermodellierungen“ anstellen, die eindeutig beweisen, dass die Wasserdampfverstärkung als positive Rückkopplung den CO2-Treibhauseffekt verstärkt.

· Computerklimamodelle kommen u. a. deshalb zu falschen Ergebnissen, weil der hypothetische Wasserdampfverstärkungsmechanismus vollkommen überwertet wird.

· Der atmosphärische Temperaturgradient beruht auf einem Energietransport und nicht auf einem Strahlungstransportmechanismus mit dem fiktiven LTE. Deshalb wird der atmosphärischen Rückstrahlung – dem Treibhauseffekt – eine zu große Bedeutung zugemessen.

· Klimamodelle müssen mit – gewillkürten – Flusskorrekturen arbeiten, deren Größenordnung den des anthropogenen Treibhauseffekts um ein Vielfaches übertreffen. Im anderen Fall „hat (man) als Modellierer … die Wahl, entweder ohne Flusskorrektur mit einem unrealistischen Klimazustand zu operieren, oder die Flusskorrektur mit ihren Schwächen zu akzeptieren, dafür aber ein realistisches Klima zu erhalten.“ [33]

· Die Abbildung des Klimas in der Vergangenheit mit Computeralgorithmen gelingt nicht ohne massive Korrekturgrößen.

· Die globale Mitteltemperatur ohne Treibhauseffekt dürfte um einiges höher als bei 255 K (-18 °C) liegen.

· Das Klima hängt stärker von der Variation der Wolkenbedeckung ab als vom Gehalt atmosphärischer Treibhausgase.

· Das IPCC ist eine politische Organisation, die sich eines Wissenschaftlergremiums bedient, um volkspädagogische Lernziele durchzusetzen.

Abschließend möchte ich die Leser darauf aufmerksam machen, dass dem gegenwärtigen CO2-Gehalt je nach Literaturstelle ein unterschiedlicher Temperatureffekt zugeordnet wird. In dem von von J.T. Houghton herausgegebenen Buch „The Global Climate“ geben Kondratjew und Moskalenko 7,2 K an [15]. Die Autoren zitieren sich dabei selbst [16]. Besorgt man sich das in Kyrillisch geschriebene Buch und schaut auf der angegebenen Seite nach, so findet man keinerlei Information darüber, wie Kondratjew und Moskalenko auf die o. g. 7,2 K kommen. Andererseits scheint man sich doch recht sicher zu sein, denn die Angaben der Autoren werden gerne zitiert [17]. Allerdings gibt es Widersprüche, denn K.P. Shine [18] gibt einen anderen Wert an, nämlich 12 K und R. Lindzen [19] geht davon aus, dass dem CO2 nur etwa 5% des natürlichen Treibhauseffekts zuzuordnen sind. Das wären 1,65 K und damit weniger als ein Viertel des bei IPCC benutzten Werts von 7,2 K.

Literatur

[1] Michael E. Mann, Raymond S. Bradley und Malcolm K. Hughes (1999): Northern Hemisphere Temperatures During the Past Millennium: Inferences, Uncertainties, and Limitations, in: Geophysical Research Letters, Vol. 26, No. 6, S. 759–762

[2] R. Revelle, Scientific American, 247, No.2, Aug. 1982, 33-41

[3] J. Barrett, Spectrochim. Acta Part A, 51, 415 (1995)

[4] R.A. Hanel et al. Journal of Geophysical Research, 77, 2629-2641 (1972)

[5] H. Flohn, Nachr. Chem.Tech.Lab, 32, 305-309 (1984)

[6] L.S.Rothman et al., Appl.Opt. 26, 4058 (1987)

[7] H. Hug, Chemische Rundschau, 20. Febr., S. 9 (1998)

[8] P. S. Braterman, Spectrochim. Acta Part A, 52, 1565 (1996)

[9] K. Shine, Spectrochim. Acta Part A, 51, 1393 (1995)

[10] J. Houghton, Spectrochim. Acta Part A, 51, 1391 (1995)

[11] R. S. Courtney, Spectrochim. Acta Part A, 53, 1601 (1997)

[12] R. P. Wayne, Chemistry of Atmospheres, Oxford University Press,

2nd. Edition, 44-49 (1991),

[13] Murry L. Salby, Fundamentals of Atmospheric Physics, Academic Press, 198-257 (1996)

[14] Climate Change 1990. The IPCC Scientific Assessment, p. 49

[15] K.Ya. Kondratyev, N.I. Moskalenko in J.T.Houghton, The Global Climate, Cambridge

Universitiy Press, 225-233 (1984)

[16] K.Ya. Kondratyev,N.I. Moskalenko, Thermal Emission of Planets, Gidrometeoizdat,

263 pp (1977) (Russisch)

[17] C.D. Schönwiese, Klimaänderungen, Springer-Verlag Berlin Heidelberg, p. 135 (1995)

[18] K. P. Shine, A. Sinha, Nature 354, 382 (1991)

[19] R. S. Lindzen, Proc. Nat. Acad. of Sciences, 94, 8335 (1997)

[20] R. Raschke, R. Hollman, Strahlungsübertragung in der Atmosphäre, Modellierung und Messung, Preprint zum CO2-Kolloquium der DECHEMA in Frankfurt/Main am 11.10.2001

[21] T. E. Graedel, Paul J. Crutzen, Chemie der Atmosphäre, Spektrum Akademischer Verlag, Heidelberg, Berlin, Oxford 1993, S. 414

[22] IPCC, Climate Change 2001, Chap. 1.2.1 Natural Forcing of the Climate System

[23] J. T. Kiehl, K. E. Trenberth, Bull. Amer. Meteor. Soc., 78 (1997) 197

[24] IPCC, Climate Change 1994, Radiative Forcing of Climate Change and Evaluation of the IPCC IS92 Emission Scenarios, Cambridge University Press, S. 174

[25] IPCC, Climate Change 2001, Working Group I: The Scientific Basis. Contribution of Working Group I to the Third Assessment Report of the Intergovernmental Panal on Climate Change, Chap. 7.2.1.1

[26] H. Hug, Energy & Environment, 11, 631, (2000)

[27] N. D. Coggeshall and E. L. Saier, J. Chem. Phys., 15, 65, (1947), Fig. 1

[28] Matthias Otto, Analytische Chemie, Wiley-VCH Verlag, Weinheim (2000), S. 280 ff

[29] S. Solanki, M Schüssler, M Fligge, Nature, 408 (2000) 445

[30] I. G. Usoskin, S. K. Solanki, M. Schüssler, K. Mursula, K. Alanako, Phys. Rev. Let., 91 (2003) 211101-1

[31] Rundgespräche der Kommission für Ökologie, Klimawandel im 20. und 21. Jahrhundert: „Welche Rolle spielen Kohlendioxid, Wasser und Treibhausgase wirklich?“ Bayerische Akademie der Wissenschaften, Verlag Dr. Friedrich Pfeil, Müchen, April 2005, S. 93

[32] Wasserdampfgraphik nach H. Flohn, BdW 12/1978, S. 132

[33] U. Cubasch, Phys. Bl. 51 (1995) 269

[34] H. Hug, Die Angsttrompeter, Signum Verlag, München, 2006, S. 227

[35] Privatmitteilung Jack Barrett, 2001 und 2012

[36] E. Raschke et al., Chemische Rundschau, 23. Okt., S. 9 (1998)

[37] http://www.davidarchibald.info/papers/Failure%20To%20Warm.pdf

[38] Stephen McIntyre, Ross McKitrick, Geophysical Research Letters, Vol. 32, L03710, 5PP., 2005

[39] Henrik Svensmark, A&G, February 2007, Vol. 48, p 1.18

Heinz Hug, für EIKE; Wiesbaden August 2012

Linksammlung zu Dürren der Vergangenheit. Mit Dank an Sebastian Lüning

Linksammlung zu Dürren der Vergangenheit. Mit Dank an Sebastian Lüning