Neue Studie: Die Hälfte der globalen Erwärmung kommt aus der Homogenisierung von Wetterstationsdaten

Übersetzungen der Bildinschriften:

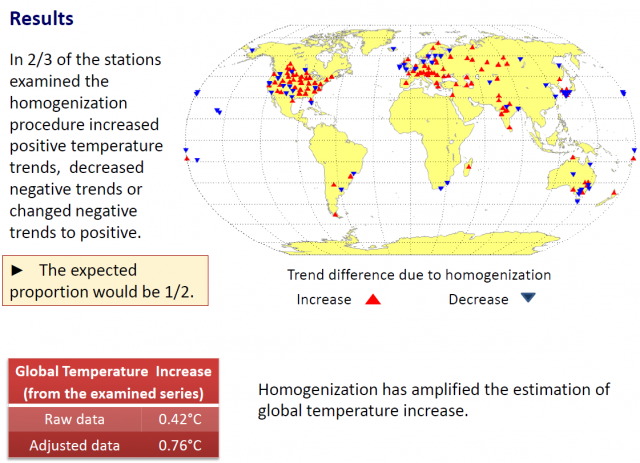

Results (Ergebnisse):

Bei zwei Drittel aller untersuchten Stationen erzeugte der Homogenisierungsprozess zunehmende positive Temperaturtrends, abnehmende negative Trends oder Veränderungen des Trends von negativ zu positiv.

Das zu erwartende Verhältnis müsste ½ sein.

Die Homogenisierung hat die Abschätzung der globalen Temperaturzunahme verstärkt.

Hier kommt der Punkt, den ich wirklich liebe: an 67% der untersuchten Wetterstationen wurden fragwürdige Anpassungen der Rohdaten vorgenommen. Dies führte zu:

„…verstärkten positiven Trends, abgeschwächten negativen Trends oder Trends, die von negativ zu positiv geändert wurden“, während „das zu erwartende Verhältnis 1 zu 2 sein müsste (50%)“.

Und…

„die bis heute angewandten Praktiken der Homogenisierung sind hauptsächlich statistisch und nicht gut durch Experimente belegt. Sie werden nur selten durch Metadaten gestützt. Man kann sagen, dass sie oft zu falschen Ergebnissen führen: natürliche Erscheinungen hydroklimatischer Zeitreihen werden als Fehler betrachtet und angepasst“.

Das Abstract der Studie und meine hilfreiche Visualisierung der Daten-Homogenisierung folgt hier:

Untersuchung der Methoden für hydroklimatische Datenhomogenisierung

Steirou, E., and D. Koutsoyiannis, Investigation of methods for hydroclimatic data homogenization, European Geosciences Union General Assembly 2012, Geophysical Research Abstracts, Vol. 14, Vienna, 956-1, European Geosciences Union, 2012.

Wir untersuchen die angewendeten Methoden zur Anpassung von Inhomogenitäten von Temperatur-Zeitreihen im Zeitraum der letzten 100 Jahre. Basierend auf einer systematischen Studie der wissenschaftlichen Literatur klassifizieren und evaluieren wir beobachtete Inhomogenitäten in historischen und aktuellen Zeitreihen ebenso wie die entsprechenden Methoden. Es stellt sich heraus, dass diese Methoden hauptsächlich statistischer Natur sind, nicht gut durch Experimente gerechtfertigt sind und nur selten von Metadaten gestützt werden. In vielen der untersuchten Fälle sind die vorgeschlagenen Korrekturen nicht einmal statistisch signifikant.

Aus der globalen Datenbasis GHCN-Monthly Version 2 untersuchen wir alle Stationen, die sowohl Roh- als auch adjustierte Daten enthalten, die bestimmten Kriterien der Kontinuität und Verteilung über den Globus entsprechen. Wegen der großen Zahl verfügbarer Stationen in den USA wurden die Stationen nach geeigneten Beispielen ausgewählt. Insgesamt haben wir 181 Stationen weltweit analysiert. Für diese Stationen berechneten wir die Differenzen zwischen den angepassten und nicht-angepassten linearen 100-Jahre-Trends. Es stellte sich heraus, dass in zwei Drittel aller Fälle die Homogenisierungs-Prozedur die positiven Temperaturtrends hat weiter zunehmen, die negativen Temperaturtrends abnehmen lassen.

Eine der gebräuchlichsten Methoden zur Homogenisierung, ‚SNHT for single shifts‘ war auf synthetische Zeitreihen mit bestimmten statistischen Charakteristiken angewendet worden, gelegentlich mit Verschiebungen (offsets). Die Methode war befriedigend, wenn man sie auf normal verteilte unabhängige Daten anwendet, aber nicht auf Daten mit einer langzeitlichen Persistenz.

Obige Ergebnisse lassen einige Zweifel bei der Verwendung von Homogenisierungs-Verfahren aufkommen und deuten darauf hin, dass der globale Temperaturanstieg im vorigen Jahrhundert zwischen 0,4°C und 0,7°C lag, wobei diese zwei Werte aus Roh- und adjustierten Daten abgeleitete Schätzungen sind.

Schlussfolgerungen

1. Die Homogenisierung ist erforderlich, um Fehler in klimatischen Zeitreihen zu entfernen.

2. Die bis heute verwendeten Methoden der Homogenisierung sind hauptsächlich statistischer Natur, nicht gut durch Experimente belegt und selten durch Metadaten gestützt. Man kann zeigen, dass sie oftmals zu falschen Ergebnissen führen: natürliche Erscheinungen in hydroklimatischen Zeitreihen werden als Fehler angesehen und korrigiert.

3. Während die Homogenisierung erreichen soll, dass die bestehenden vieljährigen Trends im gleichen Verhältnis zu- oder abnehmen sollen, ist es in Wirklichkeit so, dass in 2/3 aller Fälle der Trend nach der Homogenisierung zunimmt.

4. Obige Ergebnisse wecken Zweifel an den Methoden der Homogenisierung und deuten darauf hin, dass die globale Temperaturzunahme während des vorigen Jahrhunderts kleiner als 0,7°C bis 0,8°C ist.

5. Es ist eine neue Homogenisierungspraxis erforderlich, die auf Experimenten, Metadaten und besserer Erfassung der stochastischen Charakteristika hydroklimatischer Zeitreihen basiert.

Mehr dazu hier

- Presentation at EGU meeting PPT as PDF (1071 KB)

- Abstract (35 KB)

h/t to “The Hockey Schtick” and Indur Goklany

=============================================================

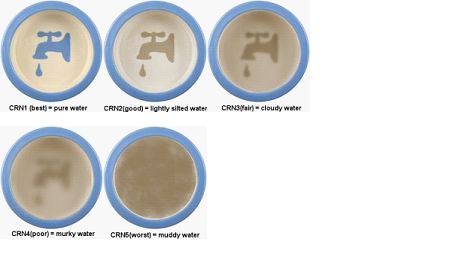

Hier folgt ein anschauliches Beispiel, den Homogenisierungsprozess anschaulich zu machen. Man stelle ihn sich wie die Messung der Verschmutzung von Wasser vor. Hier folgt eine einfache Tafel mit einer Qualitätsbewertung von CRN-Stationen (CRN station quality ratings) und wie das aussehen könnte, wenn man die Trübung durch Wasserverschmutzung mit einer Bewertung von 1 bis 5 (beste <-> schlimmste Note) versieht:

Bei der Homogenisierung werden die Daten gegen nahe gelegene Nachbarstationen innerhalb eines bestimmten Radius’ gewichtet. Und so könnte eine Station mit der Wertung „1“ mit den Daten benachbarter Stationen verschmutzt werden und mit einem neuen Wert aufwarten, „2,5“. Selbst Einzelstationen können viele andere Stationen bei den Homogenisierungs-Methoden von GISS und NOAA beeinflussen, denen die Bodentemperaturen in den USA hier und hier unterzogen werden.

In obiger Karte wird eine Glättung durch Homogenisierung angebracht, indem Stationen neben Stationen mit Fragezeichen gewichtet werden. Was würden Sie hinsichtlich der Werte (der Trübung) erwarten? Und wie nah wären diese zwei Werte an den fraglichen beiden Stationen, je eine an der Ost- und an der Westküste? Jeder Wert läge näher an einem geglätteten zentralen Mittel, das auf der Wertung der benachbarten Stationen basiert.

Aktualisierung: Steve McIntyre stimmt dem in einem neuen Beitrag zu, wenn er schreibt:

Wenn schließlich Referenzinformationen benachbarter Stationen verwendet werden, tendiert der Prüfgegenstand dazu, Anpassungsfehler zu erzeugen: das „schlimmer-Nachbar-Problem“. In diesem Falle wurden die Klimasignale nach der Anpassung bei benachbarten Stationen immer ähnlicher, selbst wenn der mittlere Bias des gesamten Netzwerkes nicht reduziert worden ist.

Gepostet von Anthony Watts

Link: http://wattsupwiththat.com/2012/07/17/new-paper-blames-about-half-of-global-warming-on-weather-station-data-homgenization/

Übersetzt von Chris Frey EIKE