Aristoteles’ Lehre von den Trugschlüssen: jeder einzelne wird in der Hysterie um die globale Erwärmung bestätigt

Der griechische Philosoph Aristoteles hat vor 2300 Jahren das Dutzend der verbreitetsten logischen Trugschlüsse in menschlichen Gesprächen in seinem Buch Sophistical Refutations aufgelistet. Nicht das Geringste unter diesen ungültigen Argumenten ist eines, das die mittelalterlichen Lehrmeister später das argumentum ad populum – den Konsens- oder Mehrheitstrugschluss – nennen sollten.

Ein Trugschluss ist ein irreführendes Argument, das logisch einwandfrei zu sein scheint, es aber tatsächlich nicht ist. Die Schlussfolgerung daraus wird im besten Falle unzuverlässig sein und im schlimmsten Fall einfach falsch. Man sollte nicht den Fehler machen, die von Aristoteles gelisteten Trugschlüsse als irrelevante Archaismen abzutun. Sie sind heute noch genauso grundlegend gültig wie zu der Zeit, als er sie niedergeschrieben hatte. Argumente, die auf irgendeinem seiner gelisteten Trugschlüsse beruhen, sind unsolide und unzuverlässig, und das ist es.

Um damit zu beginnen, fast alle der gewöhnlichen Argumente zum Alarm über das Klima sind Beispiele von Aristoteles’ Dutzend Trugschlüsse von Relevanz oder auch Anmaßung, von denen der Konsens-Trugschluss nicht der Geringste ist.

Nur weil man uns sagt, dass viele Leute sagen, sie glauben, eine Sache sei so und so, dann ist es kein Beweis, dass viele Leute das sagen und noch weniger, dass sie es glauben und wieder weniger, dass es so ist. Die bloße Tatsache eines Konsens’ – selbst wenn es einen gäbe – sagt uns überhaupt nichts darüber, ob die Angelegenheit, über die der Konsens vermeintlich besteht, richtig oder falsch ist.

Zwei Umfragen haben angeblich gezeigt, dass 97% aller Klimawissenschaftler hinter dem „Konsens“ stehen. Allerdings fand die eine Umfrage nur unter 77 Wissenschaftlern statt, eine viel zu kleine Zahl, um repräsentativ zu sein, und in der Frage, die ihnen vorgelegt worden war, ging es nur darum, ob es seit 1950 eine Erwärmung gegeben habe. 75 der 77 Befragten bejahten.

In der anderen Studie war nicht explizit festgelegt, welche Fragen den Wissenschaftlern vorgelegt worden sind, und sie erklärte auch nicht, wie sie ausgewählt worden waren, um einen Bias zu entfernen. Sie war erwiesenermaßen wertlos. Jedoch hat dies nicht die üblichen Verdächtigen davon abgehalten, – fälschlich – zu behaupten, dass es der „Konsens“ von 97% aller Klimawissenschaftler sei, dass die vom Menschen verursachte globale Erwärmung potentiell katastrophal sei.

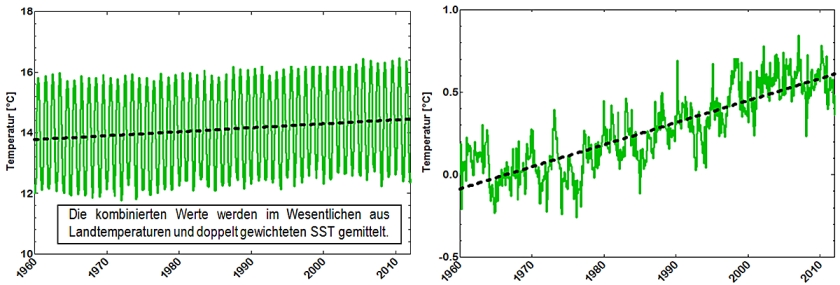

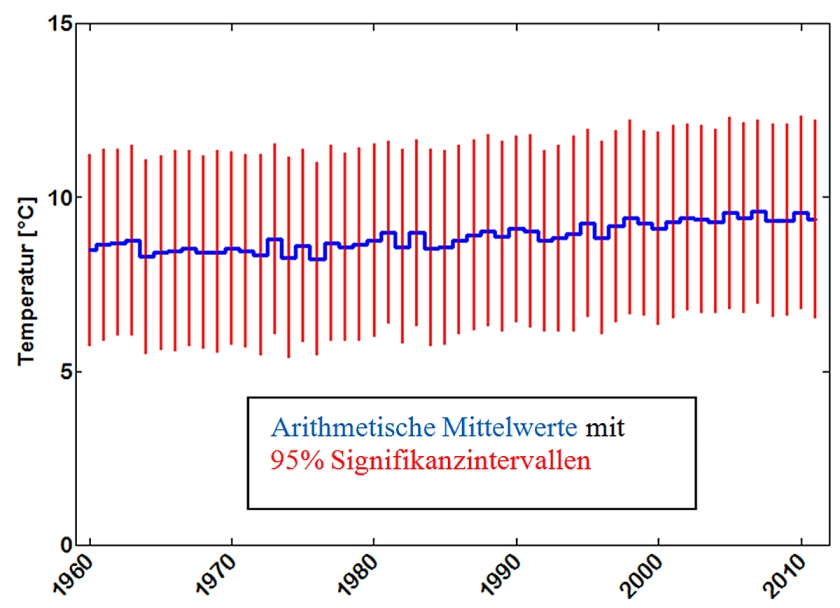

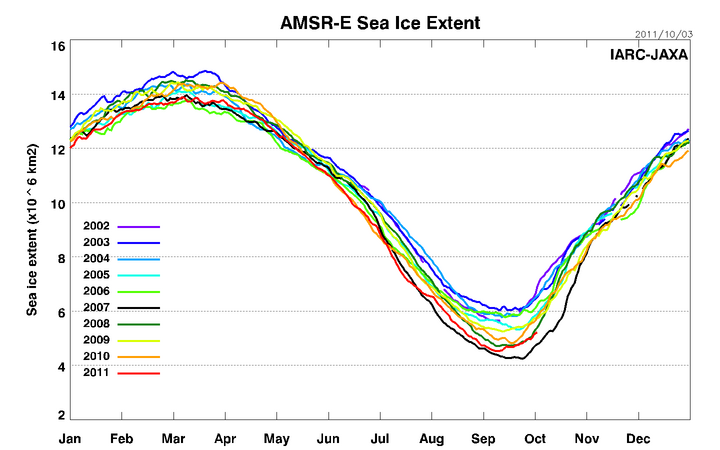

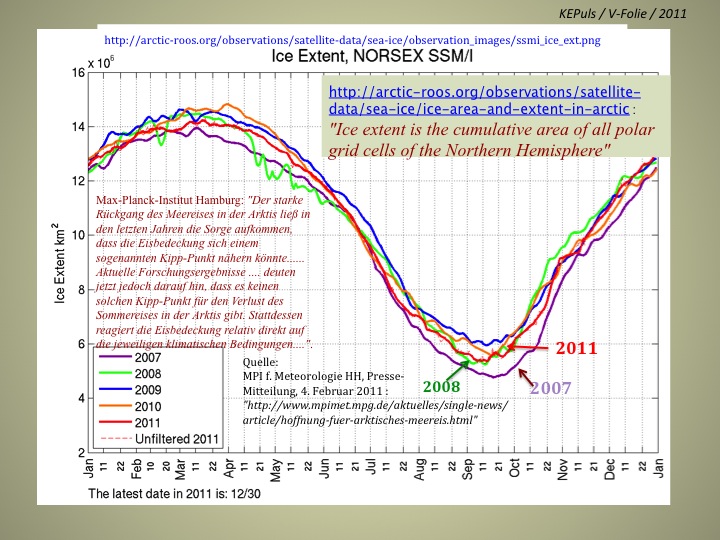

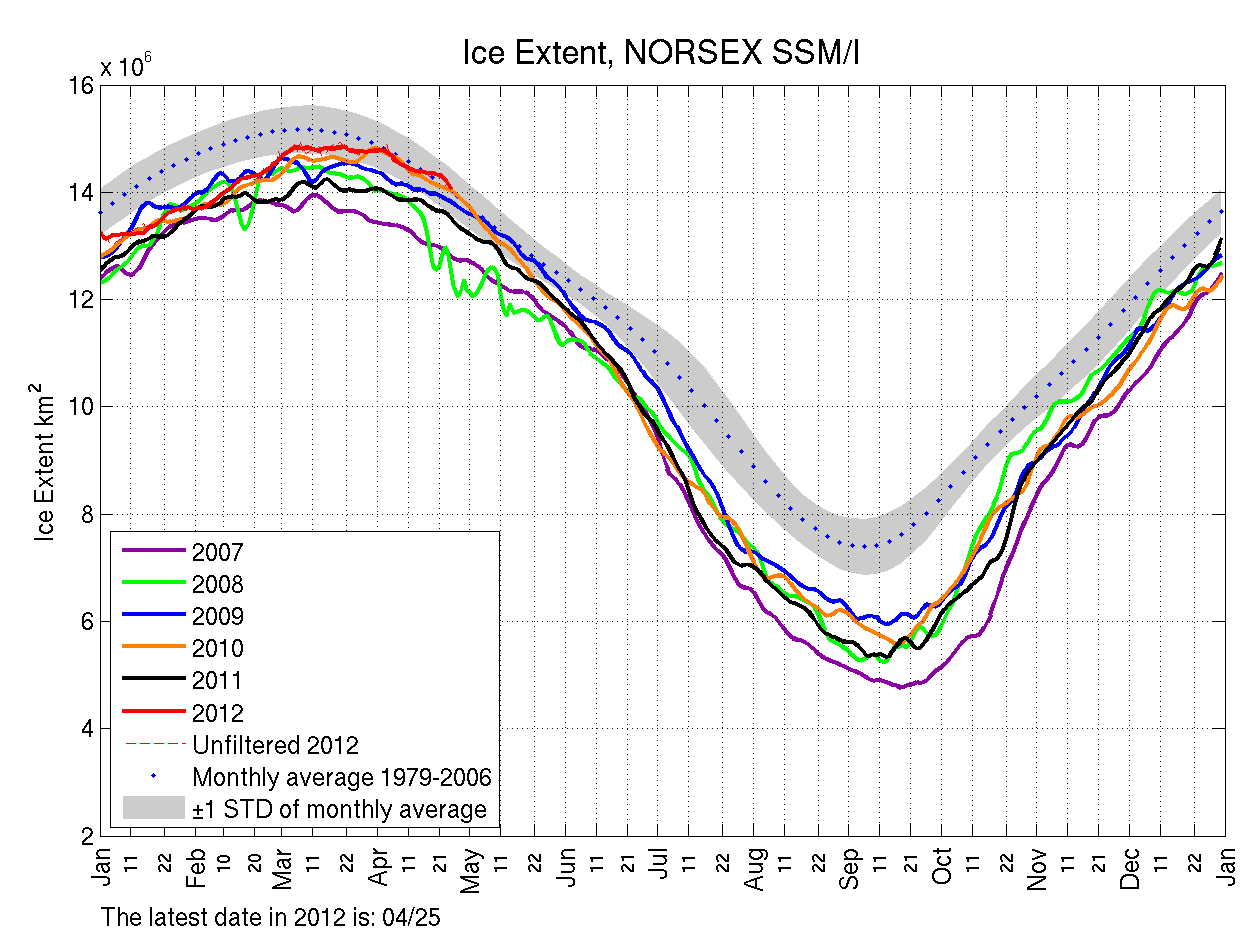

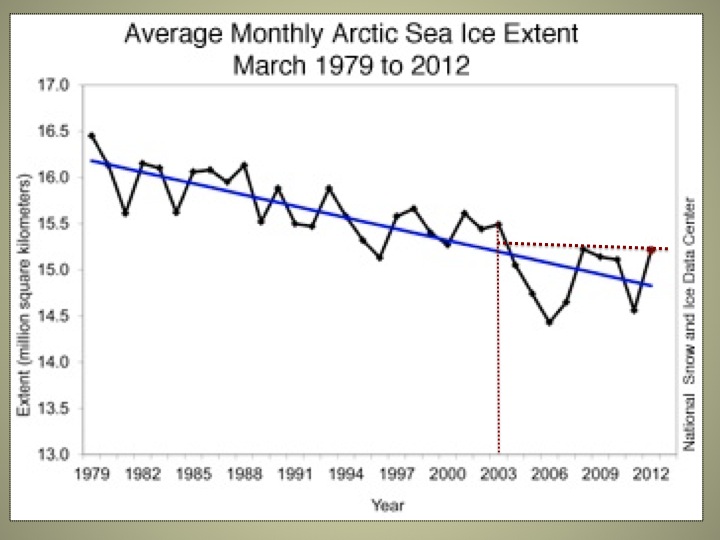

Einige Klimaextremisten sagen, dass es „einen Konsens der Beweise“ gebe. Allerdings sind Beweise keine Meinungssache. Es gab seit eineinhalb Jahrzehnten keine Erwärmung; der Meeresspiegel ist seit acht Jahren mit einer Rate äquivalent zu gerade mal 3 Zentimetern pro Jahrhundert gestiegen; die Hurrikanaktivität hat seit 30 Jahren Satellitenbeobachtung ein Rekordminimum erreicht; die globale Ausdehnung des Meereises hat sich während dieser Zeit kaum verändert; die Gletscher des Himalaya hatten keinen Eisverlust erlitten; der Wärmegehalt der Ozeane steigt viereinhalb mal langsamer als vorhergesagt; und die 50 Millionen „Klimaflüchtlinge“, von denen die UN gesagt haben, dass es sie bis zum Jahr 2010 geben würde, existieren schlicht und ergreifend nicht. Bis heute unterstützt der „Konsens der Beweise“ keinen Katastrophismus.

„Aber”, sagen die Gläubigen, „es gibt einen Konsens der Wissenschaftler und der gebildeten Gesellschaften”. Das ist das argumentum ad verecundiam, der Trugschluss, dass er richtig sein muss, weil er von Autoritäten stammt. Nur weil eine Gruppe einen Ruf hat, heißt das nicht, dass sie ihn auch verdient; und selbst wenn sie ihn verdient, muss sie sich nicht danach verhalten; und selbst wenn sie das tut, könnte er falsch sein.

„Aber nur, wenn wir von einem starken Erwärmungseffekt des menschlichen CO2 ausgehen, können wir die beobachtete Erwärmung der letzten 60 Jahre erklären. Wir können uns keinen anderen Grund für die Erwärmung vorstellen!“ Dieses Argument seitens des IPCC ist das argumentum ad ignorantiam, der Trugschluss der Argumentation aus Ignoranz. Wir wissen nicht, warum die Erwärmung erfolgt ist. Willkürlich den Menschen dafür verantwortlich zu machen ist unzulässig.

„Die Rate der globalen Erwärmung beschleunigt sich. Darum müssen wir der Grund dafür sein!“ Das ist der Trugschluss der ignoratio elenchi. Selbst wenn sich die globale Erwärmung beschleunigt, sagt uns das noch nichts darüber, ob wir dafür verantwortlich sind. Das IPCC benutzt dieses Trugschlussargument gleich zweimal in seinem Zustandsbericht von 2007. Selbst wenn dieses Argument nicht unlogisch wäre – die Erwärmungsrate nimmt nicht zu. Die Aussage, dass sie sich beschleunigt, beruht auf einem statistischen Missbrauch, den zu korrigieren sich das IPCC geweigert hat.

Oberflächlich betrachtet, könnte dieser Trugschluss ähnlich dem Trugschluss aus Ignoranz sein. Allerdings besteht ein fast unmerklicher Unterschied. Das Argument aus Ignoranz bezieht sich auf die fundamentale Ignoranz dessen, um das es bei dem Argument geht (so dass folglich eine beliebige Schlussfolgerung gezogen werden kann). Dieser Trugschluss hier bezieht sich auf die fundamentale Ignoranz der Art und Weise, wie das Argument zustande gekommen ist (so dass folglich eine irrelevante Überlegung ins Spiel gekommen ist).

„Aber was ist mit diesen knuddeligen Eisbären?“ Das ist das argumentum ad misericordiam, der Trugschluss unangebrachten Mitleids. Es gibt heute fünf mal so viele Eisbären wie in den vierziger Jahren – wohl kaum das Profil einer Spezies, deren Aussterben bevor steht. Es besteht kein Grund, Mitleid mit den Bären zu haben (und sie sind nicht knuddelig).

„Seit 60 Jahren pusten wir CO2 in die Atmosphäre. Das verursacht Erwärmung. Daher ist die Erwärmung unsere Schuld!“ Das ist der post hoc ergo propter hoc–Trugschluss, das Argument aus falschen Gründen. Nur weil ein Ereignis einem anderen Ereignis vorangeht, heißt das noch lange nicht, dass das vorangehende Ereignis Ursache des folgenden Ereignisses ist.

„Wir sagen unseren Computermodellen, dass es eine starke Erwärmung geben wird, wenn wir der Luft CO2 zuführen. Die Modelle zeigen, dass es eine starke Erwärmung geben wird. Daher ist die Erwärmung unsere Schuld.“ Das ist das argumentum ad petitionem principii, der Trugschluss des Zirkelschlusses, wobei die Voraussetzung auch die Schlussfolgerung ist.

„Die globale Erwärmung war Ursache für den Hurrikan Katrina.” Das ist das ungeeignete Argument vom Allgemeinen zum Einzelfall, der Trugschluss a dicto simpliciter ad dictum secundum quid, der Trugschluss des Zufalls. Selbst das IPCC gibt zu, dass individuelle Einzel-Extremwetterereignisse nicht der globalen Erwärmung zugeordnet werden können. Hurrikan Katrina wurde beim Übertritt auf das Festland mit Stufe 3 eingeordnet. Die wahre Ursache der immensen Schäden war, dass man die Deiche grob vernachlässigt hatte.

„Das arktische Meereis schmilzt: Daher ist die vom Menschen verursachte globale Erwärmung ein Problem.” Das ist das unpassende Argument vom Einzelfall zum Allgemeinen, der Trugschluss a dicto secundum quid ad dictum simpliciter, also des umgekehrten Zufalls. Die Arktis kann schmelzen, aber in der Antarktis zeigt sich seit 30 Jahren eine Abkühlung, verbunden mit der immer weiteren Ausdehnung des Meereises, so dass die Eisabnahme in der Arktis nicht ein Anzeichen für ein globales Problem ist.

„Monckton sagt, er sei Mitglied des House of Lords, aber der Parlamentspräsident sagt, dass er das nicht ist, also ist alles, was er sagt, Unsinn.” Das ist das argumentum ad hominem, der Angriff auf den Mann und nicht auf seine Argumente.

„Uns kümmert die Wahrheit nicht. Wir wollen mehr Besteuerung und Regulierung. Wir werden die globale Erwärmung als Grund anführen. Wenn Sie damit nicht übereinstimmen, werden wir Sie von den Internationalen Klimagerichtshof zerren!“ Das ist der schlimmste aller logischen Trugschlüsse: das argumentum ad baculum, das Argument der Stärke.

In jeder früheren Generation hätte man über die alberne Kaskade von Trugschlüssen der Klimaextremisten in Regierung, Akademien und Medien mit ihrer Unterstützung der jetzt zusammenbrechenden Klimaangst laut gelacht.

Wenn der künftige britische Premierminister Harold Macmillan in Oxford auftauchte, um die Klassiker zu studieren, sagte sein Tutor: „Vier Jahre Studium werden Sie für überhaupt nichts qualifizieren – außer zu erkennen, dass etwas faul ist, wenn Sie es hören“. Die Klimageschichte ist verfault. Um weiteren, in kunstvollem Unsinn wurzelnden kostenintensiven Betrug zu verhindern, sollten wir vielleicht die universelle klassische Bildung wieder einführen. So wie es jetzt ist, scheint es, als ob unsere herrischen Umweltaktivisten alles, was sie lernen, direkt von Mr. Spock in Raumschiff Enterprise stammt.

Lord Christopher Monckton

Financial Post

Link: http://opinion.financialpost.com/2012/04/20/aristotles-climate/

Übersetzt von Chris Frey EIKE