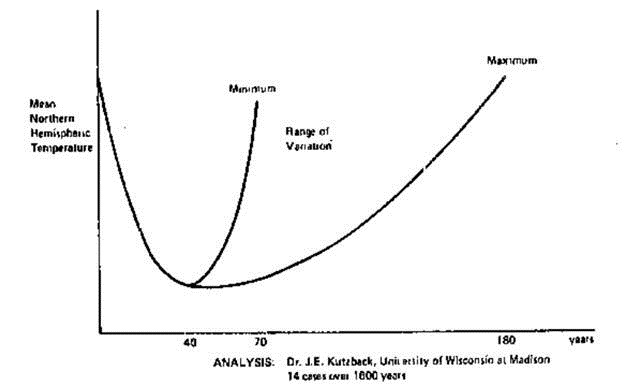

Ein nuklearer GAU soll nach Studien der Mainzer Chemiker “im momentanen Kraftwerksbestand etwa einmal in 10 bis 20 Jahren auftreten können”. Er wäre damit 200mal wahrscheinlicher als Schätzungen der amerikanischen Zulassungskommission für Kernreaktoren (NRC) im Jahr 1990 ergeben haben. Die Einschätzung der NRC beruht auf recht komplexen Risikobetrachtungen; den Mainzern reicht eine einfache Rechnung, um die Wahrscheinlichkeit einer Kernschmelze zu ermitteln: Sie teilten laut Presseerklärung die Laufzeit aller Kernreaktoren weltweit von der Inbetriebnahme des ersten zivilen Reaktors bis heute durch die Zahl der bisherigen Kernschmelzen. Also Laufzeit bislang 14.500 Jahre, Zahl der Kernschmelzen vier – eine in Tschernobyl und drei in Fukushima. Ergebnis, konservativ aufgerundet: alle 5000 Reaktorjahre ein schwerer nuklearer Unfall mit erheblicher Freisetzung von Radioaktivität. Das ergibt einen GAU alle 10 bis 20 Jahre.

Auf dieser einfachen Rechnung, die man sich gut im gymnasialen Leistungskurs Mathematik vorstellen kann, beruht die zentrale Aussage der Mainzer Studie über die Wahrscheinlichkeit von schweren Reaktorunfällen. Damit haben sich die Chemiker allerdings auf sehr dünnes Eis begeben. Die Zahlen stimmen, wie häufig in der Statistik. Aber gibt das, was Autoren der Studie aus diesen Zahlen machen, auch die Wirklichkeit wieder?

Nein. Man kann zum Beispiel nicht einfach den Reaktorunfall von Tschernobyl mit dem der Fukushima-Reaktoren gleichsetzen. Im Tschernobyl-Reaktor ist der Reaktorkern praktisch explodiert, nicht geschmolzen. Eine Sicherheitshülle gab es nicht, so dass bei der Explosion große Mengen an radioaktivem Material freigesetzt wurden. Vor allem aber der Tschernobyl-Reaktor nicht repräsentativ für den vorhandenen Reaktorbestand. Um Aussagen über die Zukunft dieses Bestandes zu treffen, wie es die Mainzer tun, ist die Nuklearkatastrophe von Tschernobyl damit ungeeignet.

Bleiben die drei Kernschmelzen im Kraftwerk Fukushima 1. Gleicher Reaktortyp, gleiche Unfallursache, ähnlicher Verlauf – es spricht vieles dafür, diese drei Ereignisse als ein Ereignis zu behandeln. Dann wird die Mainzer Rechnung absurd. Außerdem sind auch die Fukushima-Reaktoren nur bedingt repräsentativ für den weltweiten Reaktorbestand. Ausgelöst wurde das schwere Unglück im japanischen Kraftwerk durch ein extrem starkes Erdbeben, gefolgt von einem extrem starken Tsunami. Das Erdbeben haben die Reaktoren überstanden; die Flutwelle deshalb nicht, weil die Anlage eklatante Sicherheitsmängel aufwies. Inzwischen haben Stresstest belegt, dass andere Reaktoren diese Mängel nicht haben. Den deutschen Reaktoren zum Beispiel hätten Erdbeben und Tsunami wie im Norden Japans keinen nennenswerten Schaden zugefügt.

Solche und andere Unterschiede zwischen Reaktoren ignorieren die Mainzer Forscher. Sie begründen dieses Vorgehen damit, dass es “auch in einem vermeintlich sicheren Reaktor zu einer Kernschmelze kommen kann”, weil man nicht alle möglichen Ursachen eines solchen Unfalls vorhersehen könne. Das ist zweifellos richtig, aber die Annahme von Nichtwissen macht schlecht begründete Vorhersagen nicht verlässlicher. An einer detaillierten Risikoanalyse führt kein Weg vorbei.

Alles zusammengenommen, können seriöse Wissenschaftlicher die Aussage “Ein GAU all zehn bis zwanzig Jahre” guten Gewissens nicht treffen. Das sollte einer “Kampagnenwissenschaft” á la Greenpeace vorbehalten bleiben.

Die Sache mit der “radioaktiven Verseuchung”

Im Abstract zu ihrem Papier schreiben die Mainzer Chemiker zu Beginn: “Schwere Reaktorunfälle in Kernkraftwerken sind selten, aber ihre Folgen katastrophal. Aber was bedeutet ‘selten’”? Die Frage ist beantwortet, allerdings ungenügend. Viel interessanter ist die Frage: Was bedeutet ‘katastrophal’? Auch hier machen es sich die Mainzer Chemiker leicht. Sie sehen als katastrophale Folge einer Kernschmelze eine “weit über Staatsgrenzen hinweg [reichende] radioaktive Verseuchung”. In Westeuropa wären davon, so das Ergebnis ihrer Computersimulationen, durchschnittlich 28 Millionen Menschen betroffen.

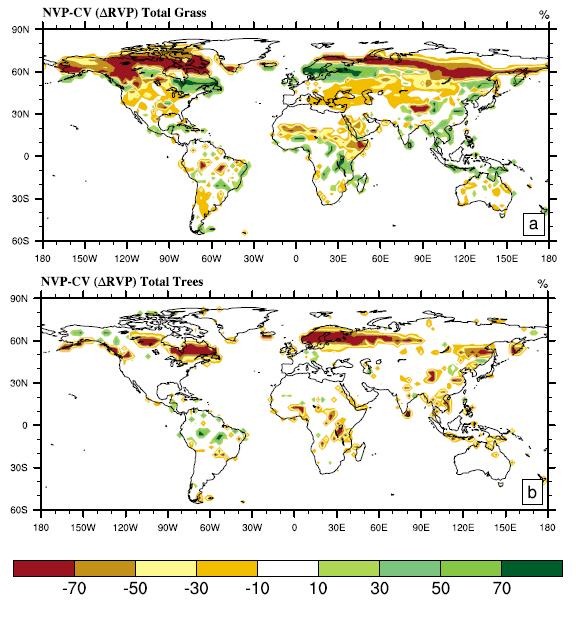

Mit diesem Computermodell ermitteln die Forscher, wie sich die bei einer Kernschmelze freigesetzten radioaktiven Gase – in diesem Fall Cäsium-137 und Jod-131 – ausbreiten. Die Menge der freigesetzten Gase bestimmen die Mainzer Forscher anhand der Mengen, die beim Tschernobyl-Unglück freigesetzt wurden. Da radioaktives Jod aufgrund seiner geringen Halbwertszeit sehr schnell verschwindet, beschränkten sie sich auf die Verteilung von Cäsium-137. Ergebnis ihrer Simulation: nur acht Prozent der radioaktiven Gase würden sich im Umkreis von 50 km um die Unglückstelle verteilen; über die Hälfte ginge innerhalb von 1.000 Kilometern nieder, und etwa ein Viertel würde weiter als 2.000 Kilometer transportiert.

Mit diesen Angaben haben die Mainzer vom Computer eine Reihe schöner Karten herstellen lassen. Darauf lässt sich das Ausmaß der radioaktiven Verseuchung ablesen, wenn mal wieder eines der Kernkraftwerke in Europa oder anderswo havariert. “Im weltweiten Vergleich”, so fasste die Rheinzeitung am 23. Mai zusammen, “tragen die Einwohner im dicht besiedelten Südwestdeutschland das größte Risiko einer radioaktiven Verseuchung.” Und der Zeitungsautor bemerkt ganz richtig, dass dies Wasser auf die Mühlen der Atomkritiker sein dürfte, die im grenznahen französischen Atomkraftwerk Cattenom ein “gewaltiges Gefahrenpotential” sähen.

Doch die schönen Computerkarten können nicht darüber hinwegtäuschen, dass sich die Mainzer Forscher, wie schon bei der Vorhersage künftiger GAUs, auch hier auf brüchigen Eis bewegen. Allererster Kritikpunkt: Es geht nicht an, die vom Tschernobyl-Reaktor freigesetzten Strahlungsmengen als Richtschnur zu nehmen, um mögliche Freisetzungen anderer Reaktortypen zu berechnen. Unfallursachen und –verläufe sind nicht vergleichbar. Das ist keine theoretische Frage, sondern praktisch nachweisbar.

Bislang gab es vier Kernschmelzen in Reaktoren, die nicht vom Tschernobyl-Typ sind: drei im Kraftwerk Fukushima und eine im amerikanischen Kraftwerk Three-Mile-Island (TMI). Letztere haben die Mainzer in ihrer Rechnung nicht berücksichtigt, da dort nur minimale Strahlung freigesetzt wurde. Kann man machen, wenn man ein wichtiges Argument ignorieren möchte: Im Gegensatz zum Tschernobyl-Reaktor sind Reaktoren wie man sie in den USA, Deutschland oder Frankreich findet, so ausgelegt, dass selbst im Fall einer Kernschmelze kein oder nur wenig radioaktives Material austreten kann. Keine Theorie, sondern belegt durch den havarierten TMI-Rektor.

Aber in Fukushima, war es da nicht viel schlimmer? Ein berechtigter Einwand. Dort wurde große Mengen an radioaktiven Jod- und Cäsiumgas freigesetzt. Die Ursachen sind bekannt; bei richtiger Auslegung wäre das nicht passiert. Aber was dort real passierte, nicht theoretisch, nicht im Computer, ist dennoch weit von dem entfernt, was die Mainzer Forscher ihren Simulationen zugrundelegen. Nach Angaben der japanischen Aufsichtsbehörde NISA lag der Gesamtbetrag der Freisetzungen von Jod-131 und Cäsium-137 in der Größenordnung von etwa 10% der in Tschernobyl freigesetzten Menge. Eine jüngere Schätzung von TEPCO beläuft sich auf etwa 15%.

Diese, verglichen mit Tschernobyl geringe Menge, stammt nicht von einem, sondern drei havarierten Reaktoren. Niemand ist daran gestorben. Nach jüngst veröffentlichten Untersuchungen der Weltgesundheitsorganisation (WHO) und des Wissenschaftlichen Ausschuss der UNO zur Untersuchung der Auswirkungen von atomarer Strahlung (UNSCEAR) haben die meisten Bewohner von Fukushima und benachbarter Bezirke Strahlendosen unterhalb von unbedenklichen 10 Millisievert (mSv) erhalten. An zwei Orten lag diese zwischen 20 und 50 mSv. Zum Vergleich: die natürliche Strahlenbelastung liegt meist um 2 bis 3 mSv, in etlichen Regionen von Brasilien, Südindien oder dem Iran liegt diese um das 10- bis 20fache höher, ohne gesundheitliche Beeinträchtigung der dort lebenden Bevölkerung. Fachleute gehen in inzwischen von so geringen möglichen Spätfolgen in Fukushima aus, dass diese nicht messbar sein werden.

Diese Werte gelten für die nähere Umgebung des Kraftwerks Fukushima. Von “radioaktiver Verseuchung” im Umkreis von 1000 bis 2000 km, wie sie die Mainzer berechnet haben, ist in diesen Untersuchungen nicht die Rede. Vielleicht ist aber auch die Bezeichnung “Verseuchung” fehl am Platz. Radioaktive Kontamination kann noch als wissenschaftliche Bezeichnung durchgehen, radioaktive Verseuchung nicht. Radioaktive Verseuchung ist negativ überladen, im Bewusstsein der Öffentlichkeit steht er für Krebs, Krankheit, Tod. Er macht Angst, treibt Menschen in die Apotheke, um Jodtabletten zu kaufen. Wer diese Bezeichnung benutzt, weiß um dessen Wirkung.

Das Perfide an der Mainzer Studie, vor allem daran, wie sie in der Presseerklärung der Öffentlichkeit präsentiert wird, ist, dass zwar ständig von “radioaktiver Verseuchung” die Rede, aber nie davon, ob und, wenn ja, welche Folgen diese Verseuchung für die menschliche Gesundheit hätte. Die Mainzer berufen sich auf die Internationale Atomenergiebehörde (IAEA), die ab einer Aktivität von 40,000 Becquerel pro Quadratmeter (40 kBq/m2) von radioaktiver Kontamination sprechen.

Was bedeutet dieser Wert? Ein Bequerel bedeutet, dass ein Atomkern pro Sekunde zerfällt. Das wissen sicherlich nicht viele Zeitungsleser; noch weniger wissen, was es für Folgen hat, wenn pro Sekunde 40.000 radioaktive Kerne zerfallen. Vielleicht hilft das: Rund 10.000 Bq beträgt die Aktivität im Körper des Menschen; pro Sekunde zerfallen also irgendwo im menschlichen Zellgewebe zehntausend radioaktive Atomkerne – tagaus, tagein. Auf Stehplätzen in Fußballstadien drängen sich pro Quadratmeter oft vier, fünf Menschen. Noch dichter steht man in Tokios U-Bahn zu Stoßzeiten. Solche Zusammenballungen müssten also als “radioaktiv verseucht” gelten.

Oder auch das: eine Cäsiumaktivität von 40 kBq entspricht einer biologischen Strahlenbelastung von weniger als einem mSv. Dieser Wert liegt deutlich sowohl unter der natürlichen Strahlendosis wie auch der Strahlenbelastung durch medizinische Anwendungen, denen der Mensch ausgesetzt ist. Welchen Wert hat, daran gemessen, die Aussage, dass im Falle eines Reaktorunfalls 30 Millionen Menschen von “gefährlicher radioaktiver Belastung” bedroht seien? Der englische Physiker Wade Allison, der ein vielbeachtetes Buch mit dem Titel “Radiation and Reason” geschrieben hat, fand die Untersuchung der Mainzer Chemiker schlicht “seicht”. Einen wissenschaftlichen Nutzen hat die Studie nicht, wohl aber einen politisch-gesellschaftlichen: sie macht Menschen unnötig und unbegründet Angst. Diese Art von “Kampagnenwissenschaft” kennt man von Greenpeace und ähnlichen Organisationen.

Ähnliche Beweggründe mögen auch bei den Mainzer Chemikern eine Rolle gespielt haben. In der Presseerklärung wünscht sich Prof. Jos Lelieveld, der Leiter der Studie:

“Vor dem Hintergrund unserer Erkenntnisse sollte meiner Meinung nach auch ein international koordinierter Ausstieg aus der Kernenergie in Betracht gezogen werden.”

Das allerdings gibt die Studie nun wirklich nicht her.

J. Lelieveld, D. Kunkel, M. G. Lawrence. Global risk of radioactive fallout after major nuclear reactor accidents. Atmos. Chem. Phys., 12, 4245-4258, 2012. http://www.atmos-chem-phys.net/12/4245/2012/acp-12-4245-2012.html

United Nations Scientific Committee on the Effects of Atomic Radiation (UNSCEAR)

Und hier der Link zur Presseerklärung des MPI

Heinz Horeis, zuerst erschienen bei ACHGUT

Update vom 1.6.12:

Offener Brief an Herrn Prof. Lelieveld, Max Plank Institut, Mainz

Sehr geehrter Herr Prof. Lelieveld,

Ihre Veröffentlichung im Namen des Max Planck Instituts: „Global risk of radioactive fallout after major nuclear reactor accidents“ hat in der Presse unter dem Titel: „Atomarer Super-GAU droht alle zehn bis 20 Jahre“ Beachtung gefunden. Sie sehen hier ja wieder deutlich, wie aus Ihrer statistisch falschen Berechnung der Häufigkeit einer Cäsium 137 Freisetzung (die zu keinem realen Gesundheitsproblem führt) ein Bürgerschreck aufgebaut wird. Insoweit tragen Sie Mitverantwortung für die Pflege und den Ausbau des Angstsyndroms vor Radioaktivität, v.a. in der deutschen Bevölkerung.

Das war Grund für mich, die Kommentare und die Kritik dazu Ihnen zu überbringen und in den öffentlichen Raum zu stellen.

Nach gängiger Praxis sollte Ihnen wegen diesem zitierten Papier nicht nur das Doktorat sondern auch die Professur aberkannt werden. Der Grund ist einfach. Sie kennen entweder nicht oder Sie ignorieren die strengen Regeln seriöser wissenschaftlicher Statistik.

Stichworte zu den strengen Regeln sind: Bildung einer homogenen Grundgesamtheit und Ziehung einer genügen großer Stichprobe. Ersparen Sie es mir, die Hintergründe dazu und die Wirkung bei Verletzung dieser Regeln Ihnen nahe zu bringen.

Beides haben Sie (und Ihre Mitautoren) sträflich ignoriert. Damit ist Ihre Veröffentlichung pseudo-wissenschaftlicher Müll, der im Nirwana des Internets hoffentlich baldmöglichst untergeht.

Für Ihren weiteren Berufsweg habe ich die Befürchtung, dass Sie es fertig bringen, z.B. die Wurm-Information aus weltweit angebauten Früchten „zusammen zu rühren“, um folgende Aussage zu treffen: „Wie ist die Häufigkeitsverteilung von Würmern in deutschen Äpfeln aus den verschiedenen Anbaugebieten in (D)?“.

Wenn Sie schon aus förderungspolitischen Überlegungen beim Max Planck Institut in Garching Ihr meteorologisches Ausbreitungsmodell bewegen wollen, liefern Sie doch dem Klima-Guru Prof. Schnellnhuber in Potsdam die Berechnung der CO2 Dosis-Verteilung auf Grund der zunehmenden CO2 Freisetzung aus deutschen Kraftwerken, angezettelt durch das planwirtschaftliche Geschäftsmodell der Energiewende der Bundesregierung.

Ich bin mir sicher, dass die kommende mittlere CO2 Dichte pro Flächeneinheit, in Deutschland Weltrekord wird. Sie müssen allerdings dazu Ihr Modell verfeinern, um alle Emittenten aus den vielen konventionellen Kraftwerken zu berücksichtigen. Die CO2 Freisetzung aus der großen Anzahl von Premium-Fahrzeugen können Sie als CO2 Grundlast führen. Die CO2 Zunahme auf Grund der von Frau Dr. Merkel verordneten 1 Mio. Elektrofahrzeugen müssen Sie aber berücksichtigen. Ebenso die Zunahme durch die propagierte Holzverbrennung und die Herstellung der Hausisolierungen. Wenn Ihr Modell es hergibt, können Sie auch die Zunahme der Kaminfeuer bei den VIP’s berücksichtigen. Abziehen dürfen Sie die in Konkurs gegangenen Firmen der Solarbranche als CO2 Emittenten. Diese Firmen können keine Klimaschädlinge mehr sein.

Mit Ihrem Papier sind Sie Steigbügelhalter geworden für die östliche Prägung der neuen Planwirtschaft, vertreten durch Frau Bundeskanzlerin Dr. Merkel, im Rahmen der zur Chefsache erklärten Energiewende.

Mit freundlichen Grüßen

Feffernitz, 24. Mai 2012

Dr. techn. Peter Kafka

Habeintenweg 129

A-9710 Feffernitz

Tel.: ++43 (0) 720 350 335

Fax: ++43 (0) 720 350 336

Mobile: ++43 (0) 660 655 2600

email: drpkafka@netcompany.at

Der Artikel von Prof. Lelieveld ist veröffentlicht bei:

http://www.mpic.de/Der-nukleare-GAU-ist-wahrscheinlicher-als-gedacht.34298.0.html