Svensmarks kosmischer Jackpot: “Beweis der Beeinflussung irdischen Lebens durch nahe Supernovae”

Bild rechts: Dem bloßen Auge sichtbar als die „sieben Schwestern“ sind die Plejaden der bekannteste aller Sternenhaufen, deren Sterne sich alle zur gleichen Zeit gebildet haben. Die Plejaden entstanden während der Zeit der Dinosaurier, und die massivsten der Schwestern sind im einen Zeitraum von 40 Millionen Jahren explodiert. Die Überreste ihrer Supernovae verursachten kosmische Strahlen. Aus dem Katalog bekannter Sternenhaufen hat Henrik Svensmark die Variation der kosmischen Strahlung der letzten 500 Millionen Jahre berechnet, ohne die Notwendigkeit, die genaue Form der Galaxie* zu kennen. Mit Hilfe dieser astronomischen Historie grub er tief in die Historie des Klimas und des Lebens auf der Erde. Bild: ESA/NASA/Hubble.

[*Original: Milky Way Galaxy. Das ist doppelt gemoppelt: Griech. Galaxy = engl. Milky Way = dt. Milchstraße. A. d. Übers.]

Als ich über den Sieg der Pioniere der Plattentektonik in ihrem Kampf gegen die bedeutendsten Geophysiker jener Zeit berichtet habe, fühlte ich mich um 40 Jahre in diese Zeit zurückversetzt. Tuzo Wilson, Dan McKenzie und Jason Morgan zerschmetterten die Lehrbücher und erklärten fröhlich Erdbeben, Vulkane, Gebirgsbildungen und selbst veränderliche Tiefen der Ozeane einfach durch die Drift der Fragmente der Lithosphäre in verschiedene Richtungen rund um den Globus. [Alfred Wegener scheint dem Autor hier kein Begriff zu sein. Merkwürdig! A. d. Übers.]

In Svensmarks neuer Studie führt eine ähnlich prägnante Theorie, nämlich dass kosmische Strahlen von explodierten Sternen durch vermehrte Wolkenbildung die Erde abkühlen, zu erstaunlichen Erklärungen, nicht zuletzt dafür, warum die Evolution manchmal Sprünge machte und manchmal stagnierte. Im doppelten Wortsinn ist dies eine wahrhaft astronomische Revision der Geschichte des Lebens.

Hier folgen die wesentlichen Ergebnisse:

1) Die langzeitliche Biodiversität im Ozean hängt ab vom Meeresspiegel, bestimmt durch die Plattentektonik und der lokalen Rate von Supernovae durch die Astrophysik, und von fast nichts Anderem

2) Die langzeitliche primäre Produktivität des Lebens im Ozean – das Gesamtwachstum photosynthetischer Mikroben – hängt von der Rate der Supernovae ab, und von fast nichts Anderem.

3) Supernovae in außerordentlich geringer Entfernung stehen für kurzfristiges Absinken des Meeresspiegels während der letzten 500 Millionen Jahre, was Geophysikern zwar schon lange bekannt ist, bisher aber nicht schlüssig erklärt werden konnte.

4) Mit der Zusammenführung geologischer und astronomischer Erkenntnisse wird auch der Zusammenhang zwischen Klima und Raten von Supernovae besser und besser, wobei hohe Raten eisige Zeiten mit sich brachten.

Präsentiert mit der notwendigen Vorsicht ebenso wie mit Rücksicht auf die Gefühle von Experten in vielen Forschungsgebieten entfaltet sich eine Story, in der alles wie in einem gut funktionierenden Uhrwerk abläuft. Jeder, der an irgendeinem Teilaspekt davon mit den Worten „Korrelation bedeutet nicht zwingend Kausalität“ herum mäkelt, sollte irgendeine andere Mega-Theorie anbieten, die erklärt, warum viele sich gegenseitig stützende Zufälle zwischen Ereignissen in unserer galaktischen Nachbarschaft und der Lebensbedingungen auf der Erde auftauchen.

Ein amüsanter Aspekt ist, dass Svensmark die gegenwärtig populäre CO2-Geschichte auf den Kopf stellt. Einige Geowissenschaftler möchten für die drastischen Schwankungen von heißen und eisigen Bedingungen während der letzten 500 Millionen Jahre zunehmende bzw. abnehmende CO2-Konzentrationen verantwortlich machen, was sie in komplizierter Art und Weise erklären. Für Svensmark regieren die von den Sternen verursachten Veränderungen die Menge des Kohlendioxids in der Luft. Klima und Leben bestimmen über das CO2, nicht umgekehrt.

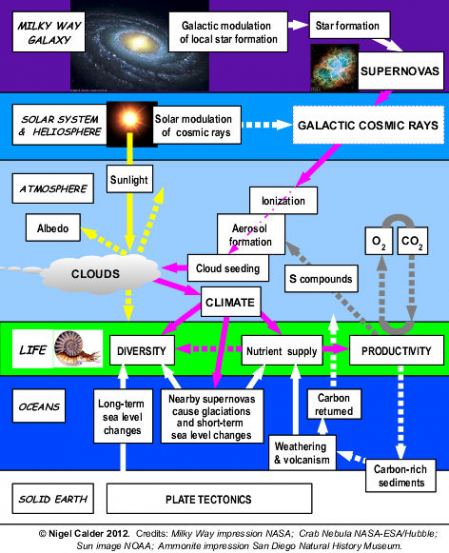

Als Begleiterscheinung bestimmen Supernovae auch über die verfügbare Menge des Sauerstoffs, den Tiere ebenso wie Sie und ich atmen. Folglich hat die inhärent einfache Hypothese kosmische Strahlen/Wolken weitreichende Konsequenzen, die ich im folgenden Diagramm darzustellen versucht habe.

Kosmische Strahlen bei der Arbeit. Die wesentlichen Ergebnisse in Svensmarks neuer Studie betreffen die oberste stellare Zone, die grüne Zone des Lebens und auf der rechten Seite die atmosphärische Chemie. Obwohl die solare Modulation galaktischer kosmischer Strahlen für uns in kürzeren Zeiträumen wichtig ist, sind deren Auswirkungen kleiner und kürzer als die wesentlichen langzeitlichen Änderungen, kontrolliert durch die Rate der Entstehung neuer Sterne in unserer Nachbarschaft sowie ihrer Selbstzerstörung durch Supernovae. Obwohl auf dieser Graphik ein Copyright liegt, darf sie mit dem Hinweis auf den Zusammenhang mit der Arbeit von Svensmark reproduziert werden.

Beigefügte Erklärungen [Original: By way of explanation]

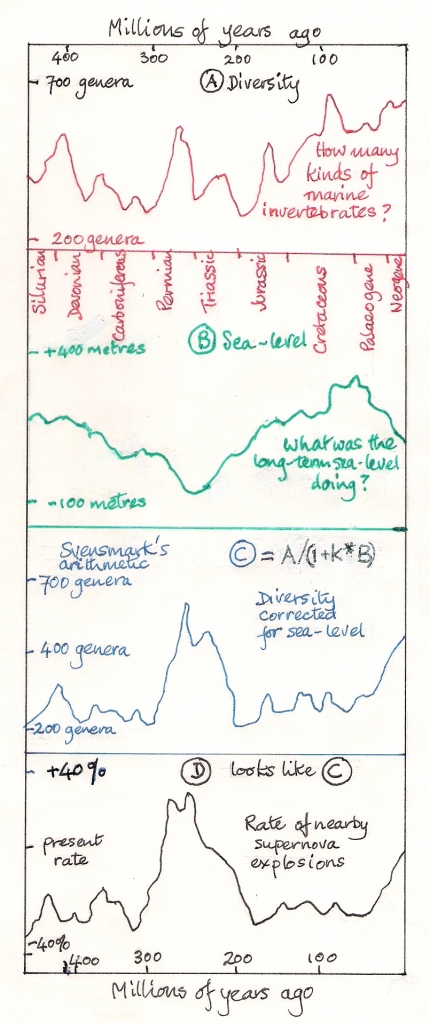

Hier ist der Text zu dieser Studie verfügbar. Sie ist hoch wissenschaftlich, wie es sich für ein Profi-Journal gehört, so dass selbst die Abbildungen für Nicht-Experten etwas verwirrend sein können. Also habe ich die Hilfe von Liz Calder in Anspruch genommen, um zu erklären, wie eine der aussagekräftigsten Graphiken, Svensmarks Abbildung 20, zustande gekommen war. Die Graphik zeigt, wie die sich ändernde Rate der Supernovae relativ nahe der Erde während der letzten 440 Millionen Jahre stark die Biodiversität maritimer wirbelloser Tiere beeinflusst hat, von den Trilobiten in historischer Zeit bis zu den Hummern unserer Zeit. Svensmarks Bildunterschrift endet mit den Worten: „Offensichtlich erklärt sich die maritime Biodiversität durch eine Kombination der Aktivität des Meeresspiegels und der Astrophysik“. Um dieses Argument zu verstehen, muss man darauf schauen, wie die Abbildung 20 auf den Informationen aus Abbildung 19 hervorgeht. Diese zeigen hinsichtlich der totalen Diversität der Meereslebewesen in den fossilen Ablagerungen den Wechsel zwischen Zeiten rapider Evolution und Rezession.

Gezählt werden Gruppen ähnlicher Tiere. Das ist hier mit einer Freihandzeichnung von Liz Calder in Sketch A dargestellt. Sketch B stammt aus einem anderen Bereich von Abbildung 19, in dem beschrieben wird, wie sich langzeitlich der globale Meeresspiegel während der gleichen Periode geändert hat. Die deutliche Übereinstimmung kommt nicht überraschend, weil bei hohem Meeresspiegel die Kontinentalränder überflutet werden und den maritimen wirbellosen Tieren eine größere Auswahl von Habitaten bietet. Aber offensichtlich ist das nicht alles. Zunächst gibt es da eine verdächtige Spitze der Diversität vor etwa 270 Millionen Jahren, die dem sinkenden Meeresspiegel widerspricht. Svensmark wusste, dass es um diese Zeit eine starke Spitze von Supernovae gegeben hatte. Also untersuchte er, was mit den Lebensformen dieser 440 Millionen Jahre geschehen würde, wenn man den Einfluss der Höhe des Meeresspiegels herausrechnet. Diese einfache Operation wird in Sketch C gezeigt, in dem die 270-Millionen-Spitze breiter und größer wird. Sketch D zeigt Svensmarks Berechnung der sich ändernden Supernova-Rate in der Nachbarschaft der Erde während des gleichen Zeitraumes. Ich betone, dass dies alles Freihandzeichnungen sind, um die Berechnungen zu erklären, und nicht, um die Daten darzustellen. In der veröffentlichten Studie werden die Graphen C und D präzise gezogen und zu Vergleichszwecken übereinander gelegt.

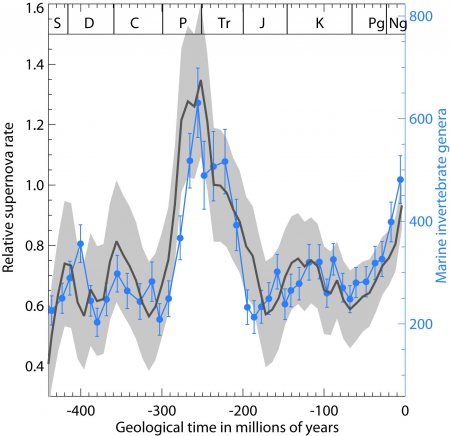

Dies ist nun Abbildung 20 von Svensmark mit den einfacheren Beschreibungen der Presseerklärung der RAS. Die Biodiversität (die Anzahl maritimer wirbelloser Tiere) ist blau dargestellt, zusammen mit vertikalen Balken, die mögliche Fehler zeigen sollen. Die Supernova-Rate ist schwarz eingezeichnet.

Es gibt viele faszinierende Einzelheiten, mit denen ich die Signifikanz der Svensmark’schen Ergebnisse illustrieren kann. Dass ich die Geschichte der Gorgone ausgewählt habe, ist nicht ganz zufällig, weil hiermit ein weiteres der wichtigsten Ergebnisse ins Spiel kommt, und zwar über Supernovae und Bio-Produktivität.

Das große Sterben zum Ende des Perm

Außer Atem, arme Gorgone? Nach Supernovae japsen? Benannt nach den ängstigenden Kreaturen der griechischen Mythologie, enthielt die Bandbreite der Gorgonen im späten Perm auch diese fossile Spezies, Sauroctonus progressus, 3 Meter lang. Wie viele andere Therapoden, sowie naher Verwandter unserer eigenen Vorfahren, starb sie während des Perm-Trias-Ereignisses aus. Quelle: http://en.wikipedia.org/wiki/Gorgonopsia.

Am glücklichsten unter unseren Vorfahren war ein säugetierartiges Reptil, das sich durch das Perm-Trias-Ereignis gerettet hat, der größten Katastrophe in der Geschichte der Fauna. Der Höhepunkt ereignete sich vor 251 Millionen Jahren am Ende des Perm. Fast alle Spezies in den Ozeanen starben aus, zusammen mit den meisten Spezies an Land. Das Ereignis markierte das Ende des „alten Lebens“, dem Paläozän, und ging über in die Ära des Mesozän, wobei unsere Vorfahren zu kleinen Säugetieren wurden, die versucht haben, sich von den Dinosauriern fernzuhalten. Was also hat das große Aussterben des zuvor blühenden Lebens im späten Perm ausgelöst? Henrik Svensmark zufolge war die Galaxis der Auslöser.

Vergessen Sie die gängigen älteren Vorschläge (einschließlich meiner eigenen), dass es die Auswirkungen des Einschlags eines Kometen oder Asteroiden waren, ähnlich dem, der zum Aussterben der Dinosaurier am Ende des Mesozäns geführt hatte. Das größte Sterben fand nicht ganz so plötzlich statt. Ähnlich verhält es sich mit den eindrucksvollen Beweisen für eine Eruption vor 250 Millionen Jahren – eine Basaltflut, die Sibirien mit giftigen vulkanischen Gesteinen überzogen hatte, die eine Fläche halb so groß wie Australien überdeckten – die lediglich von einem verspäteten regionalen Gnadenstoß Zeugnis ablegte. Der geringe Vorrat an Sauerstoff bringt es mehr auf den Punkt – Geologen sprechen von einem „super-sauerstoffarmen Ozean“. Und damals war in der Luft viel mehr Kohlendioxid enthalten als heute.

„Da habt ihr es doch!” werden die Leute sagen, „wir haben euch doch erzählt, dass CO2 schlecht für euch ist!“ Dabei übersieht man natürlich die Tatsache, dass uns dieses berüchtigte Gas am Leben hält. Der in jüngster Zeit gestiegene CO2-Gehalt teilt sich mit dem Pflanzenwachstum den Dank für die Ernährung der wachsenden Bevölkerung. Pflanzen und Photosynthese durchführende Mikroben benötigen unabdingbar CO2, um zu wachsen. Folglich war dessen hohe Konzentration ein Symptom für einen einschneidenden Rückgang der Produktivität des Lebens infolge einiger Supernovae, eisfreier Bedingungen und dem Fehlen von Wettervorgängen, um die Nährstoffe zirkulieren zu lassen. Da die Photosynthese auch für die Umwandlung von Wasser in Sauerstoff unabdingbar ist, mussten die aussterbenden Tiere nach Sauerstoff schnappen. Damals gab es nur wenig mehr als halb so viel davon in der Luft als wie wir glücklicherweise heute zum atmen haben.

In seiner neuen Studie kommentiert Svensmark kurz das Perm-Trias-Ereignis in Zusammenhang mit dem Ergebnis, dass hohe Raten benachbarter Supernovae die Lebensproduktivität durch Abkühlung des Planeten begünstigen, was die Zirkulation der von den photosynthetischen Organismen benötigten Nährstoffe verbessert.

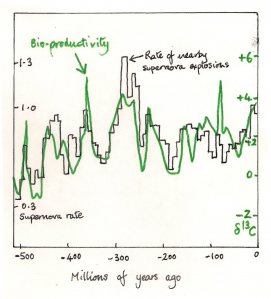

Obige Zeichnung stammt aus Abbildung 22 in der Studie, die zum besseren Verständnis vereinfacht worden ist. Schwerer Kohlenstoff, C13, ist ein Indikator für die Intensität der Photosynthese. In der Mitte ist eine abwärts weisende grüne Markierung eingezeichnet, die das Perm-Trias-Ereignis kennzeichnet. Und hinsichtlich der lokalen Supernova-Rate (schwarze Kurve) merkt Svensmark an, dass es im späten Perm den größten Rückgang der Supernova-Rate der letzten 500 Millionen Jahre gegeben hatte. Das geschah zu der Zeit, als das Sonnensystem den hyperaktiven Norma-Arm der Galaxis verlassen hatte und in das ruhige All dahinter eingetreten war. „Es hätte fatale Konsequenzen für das Leben im Meer“, schreibt Svensmark, „wenn eine rapide Erwärmung zur Verknappung von Nährstoffen führen würde… wenn dies zu schnell passiert und sich die Spezies nicht schnell genug anpassen können“.

Eine Sache passt nicht für alles, und eine umfangreichere Geschichte der Biodiversität im späten Perm wird subtiler und sogar noch überzeugender. Ungefähr 6 Millionen Jahre vor dem Massenaussterben vor 251 Millionen Jahren kam es zu einem weniger ausgeprägten Ereignis am Ende der Guadalupium-Phase [?]. Dieses frühere Aussterben war verbunden mit einem kurzen Wiederaufleben der Supernova-Rate und einer globalen Abkühlung, die die Erwärmung in der Mitte des Perm unterbrochen hatte. Die wesentlichen Opfer dieses Sterbens waren Lebewesen im Warmwasser einschließlich riesiger Muscheln und runzliger Korallen.

Warum wird es als „Astrobiologie” gekennzeichnet?

Nun können Sie sich fragen, was denn nun die günstigste Supernova-Rate für das Leben auf unserer Erde ist. Ohne wie Dr. Pangloss bei Voltaire klingen zu wollen, liegt sie möglicherweise nicht sehr weit entfernt von der mittleren Rate der letzten einhundert Millionen Jahre und ist ähnlich dem heutigen Wert. Sowohl Biodiversität als auch Bioproduktivität sind gegenwärtig in bestem Zustand.

Svensmark hat auf eine damit nahe verwandte Frage geantwortet (nicht in der Studie selbst) – wo ist in der Galaxie der beste Platz zum Leben?

Zu viele Supernovae können das Leben durch Aussterben bedrohen. Obwohl sie sich vor dem in dieser Studie behandelten Zeitraum abgespielt hatten, wurden für sehr ernste Ereignisse, Schneeball-Erde genannt, Ausbrüche rapider Sternenbildung verantwortlich gemacht. Ich habe die Studie als „Astrobiologie“ gekennzeichnet, weil wir derzeit eine sehr günstige Stelle in unserer Galaxie innehaben. Andere Regionen könnten für höhere Lebensformen unbewohnbar sein, weil es entweder zu viele oder zu wenige Supernovae gibt.“

Astronomen, die nach extraterrestrischem Leben suchen, sprechen von einer Goldilock-Zone [?] in planetarischen Systemen. Ein Planet, der Leben trägt, sollte weder zu dicht an seinem Zentralstern liegen noch zu weit davon entfernt. Innerhalb unseres Sonnensystems befinden wir uns sicherlich in einer solchen Position. Wir könnten in einer ähnlich günstigen Goldilock-Zone in unserer Galaxis liegen, und andere Galaxien mit zu vielen oder zu wenigen Supernovae könnten für Leben ungeeignet sein. Fügt man noch die gewaltige planetarische Kollision hinzu, die zur Entstehung des unverhältnismäßig großen Mondes führte, und die orbitale Stabilität und aktive Geologie, von der das Laben abhängt, kann man zu der Einschätzung kommen, dass zumindest astronomisch Dr. Pangloss recht hat: „Alles steht zum Besten in der besten aller möglichen Welten“.

Ärgern Sie sich nicht über die Betonköpfe

Falls dieser Blog einmal zu anmaßend hinsichtlich der Svensmark-Hypothese daher gekommen sein sollte, dann deshalb, weil ich wusste, was lange vor der Veröffentlichung an Theorien, Beobachtungen und Experimenten in der Pipeline stand. Seit 1996 brachte die Hypothese jedes Jahr neue Erfolge und hat zahlreiche Versuche überstanden, sie zu falsifizieren.

Neue Zusätze auf dem Niveau der Mikrophysik schließen eine zuvor nicht bekannte Reaktion auf Schwefelsäure ein, wie in einem kürzlichen Nachdruck beschrieben. In einem erheblich unterschiedlichen Maßstab vermittelt uns diese Supernova-Studie von Svensmark besseres Wissen über die Gestalt unserer Milchstraße.

Ein Kennzeichen einer guten Hypothese besteht darin, dass sie immer besser aussieht, je mehr Zeit verstreicht. Der Triumph der Plattentektonik hinterließ die Betonköpfe der Gegner tobend und mit rotem Gesicht. Im Jahre 1960 hätte man als Geologe in den USA keinen Arbeitsplatz bekommen, wenn man an die Kontinentalverschiebung glaubte, aber im Jahre 1970 hätte man keinen Job bekommen, wenn man nicht daran glaubte. Dies ist es, was eine Verschiebung eines Paradigmas in der Praxis bedeutet, und genauso wird es auch mit den kosmischen Strahlen in der Klimaphysik gehen.

Die Plattentektonik war niemals eine große politische Sache, außer im kommunistischen Block. Dort wurde die Unverrückbarkeit der Kontinente doktrinär von der sowjetischen Akademie der Wissenschaften festgelegt. Eine analoge Betonkopf-Doktrin breitete sich global vor zwei Jahrzehnten aus, als man sich das IPCC ausgedacht und erschaffen hat, um darauf zu bestehen, dass natürliche Gründe der Klimaänderung im Vergleich zu den menschlichen Einflüssen vernachlässigbar seien.

Ärgern Sie sich nicht über die Betonköpfe! [Leicht gesagt! Diese Betonkopf-Doktrin kommt uns alle schließlich äußerst teuer zu stehen! A. d. Übers]. Der Heiligenschein empirischer Wissenschaft sieht so aus: Es spielt keine Rolle, wie viele Jahre, Jahrzehnte und manchmal Jahrhunderte es dauert, aber am Ende wird jede Geschichte der Wahrheit gemäß herauskommen.

===============================================================

All jene, die unsere kosmische Abstammung bezweifeln, seien durch Svensmarks Arbeit und Calders Artikel an dieses gut bekannte Zitat erinnert:

Der Stickstoff in unserer DNA, das Kalzium in unseren Zähnen, das Eisen in unserem Blut, der Kohlenstoff in unseren Apfelpasteten entstanden als Folge kollabierender Sterne: Wir bestehen aus Sternen staub! – Carl Sagan

[Original: The nitrogen in our DNA, the calcium in our teeth, the iron in our blood, the carbon in our apple pies were made in the interiors of collapsing stars. We are made of starstuff. – Carl Sagan]

Nigel Calder

Link zum Original auf Calder’s Blog: http://calderup.wordpress.com/2012/04/24/a-stellar-revision-of-the-story-of-life/

Link zu diesem Abdruck bei WUWT: http://wattsupwiththat.com/2012/04/24/svensmarks-cosmic-jackpot-evidence-of-nearby-supernovae-affecting-life-on-earth/

Übersetzt von Chris Frey EIKE