Was die Klimawissenschaftler der Regierung sagen

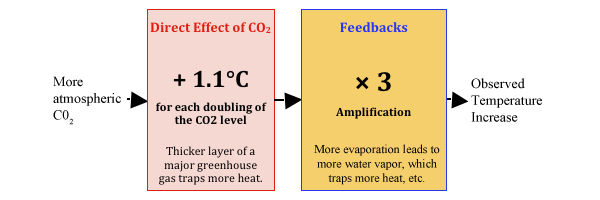

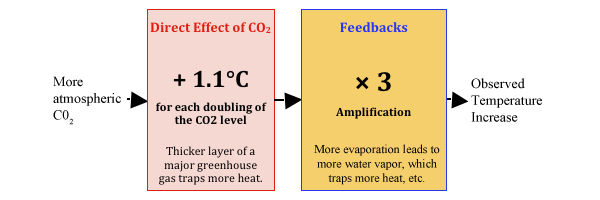

Abbildung 1: Die Klimamodelle. Falls sich der CO2-Gehalt verdoppelt (was bei der gegenwärtigen Rate frühestens 2070 oder 2100 der Fall sein kann) simulieren die Klimamodelle eine Temperaturzunahme wegen dieses zusätzlichen CO2 um 1,1°C × 3 = 3,3°C. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote1sym1

Die direkte Auswirkung ist gut verstandene Physik, die auf Laborergebnissen basiert und seit über einem Jahrhundert bekannt ist. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote2sym2

Rückkopplungen treten auf wegen der verschiedenen Arten, mit denen die Erde auf den direkten Erwärmungseffekt durch das CO2 reagiert. Die dreifache Verstärkung der Rückkopplungen basiert auf der um das Jahr 1980 entstandenen Hypothese oder der Vermutung, dass mehr Erwärmung durch CO2 zu größerer Verdunstung der Ozeane führt und das dieser zusätzliche Wasserdampf wiederum zu größerer Rückhaltung von Wärme führt, weil Wasserdampf das wesentliche Treibhausgas ist. Und zusätzliche Wärme ergibt noch mehr Verdunstung, und so weiter. Diese Verstärkung berechnen alle Klimamodelle. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote3sym3

Die Klimawissenschaftler der Regierung und die Medien erzählen uns oft etwas über die direkte Auswirkung von CO2, geben aber selten zu, dass zwei Drittel der von ihnen projizierten Temperaturzunahme aus der Verstärkung durch Rückkopplungen resultiert.

Was die Skeptiker sagen

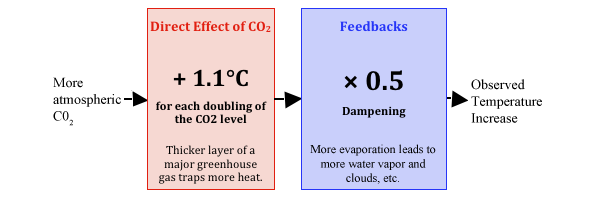

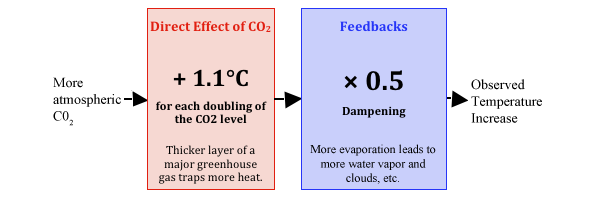

Abbildung 2: Die Sichtweise der Skeptiker. Falls sich das CO2-Niveau verdoppelt, beträgt die daraus resultierende Temperaturzunahme etwa 1,1°C × 0,5 ≈ 0,6°C. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote4sym 4

Die seriösen skeptischen Wissenschaftler stimmten immer mit den Klimawissenschaftlern der Regierung über die direkten Auswirkungen des CO2 überein. Der Streit dreht sich ausschließlich um die Rückkopplungen.

Die Rückkopplungen reduzieren die direkte Auswirkung zusätzlichen CO2, und zwar grob gesagt um etwa die Hälfte. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote5sym5. Die wesentlichen Rückkopplungen gibt es durch Verdunstung, Wasserdampf und Wolken. Im Besonderen kondensiert Wasserdampf zu Wolken, daher wird zusätzlicher Wasserdampf infolge des direkten Erwärmungseffektes von CO2 zusätzliche Wolkenbildung verursachen. Wolken reflektieren das Sonnenlicht zurück ins Universum und kühlen die Erde, so dass die allgemeine Erwärmung reduziert wird.

Es gibt buchstäblich Tausende von Rückkopplungen, von denen jede den direkten Erwärmungseffekt durch das CO2 verstärkt oder abschwächt. Nahezu jedes langlebige System wird durch Rückkopplungen bestimmt, die jede Reaktion auf Störungen dämpfen. Falls ein System stattdessen auf eine Störung mit Verstärkung reagiert, wird dieses System wahrscheinlich einen Kipp-Punkt erreichen und instabil werden (wie eine elektronische Rückkopplung, wenn ein Mikrophon seinen Lautsprechern zu nahe kommt). Das Klima der Erde ist langlebig und stabil – es geriet anders als die Venus niemals in ein „Runaway-Treibhaus“ – was stark vermuten lässt, dass die Rückkopplungen die Temperaturstörungen wie etwa von zusätzlichem CO2 dämpfen.

Was die Daten sagen

Die Klimamodelle haben sich im Wesentlichen während der letzten 30 Jahre nicht verändert und zeigen in etwa die gleiche Sensitivität zusätzlichen CO2, auch dann, wenn sie mit zunehmender Rechenleistung immer detaillierter gerechnet werden können.

- Wie gut haben die Klimamodelle die Temperatur vorhergesagt?

- Unterstützen die Daten eher die Klimamodelle oder die skeptische Sicht?

Lufttemperatur

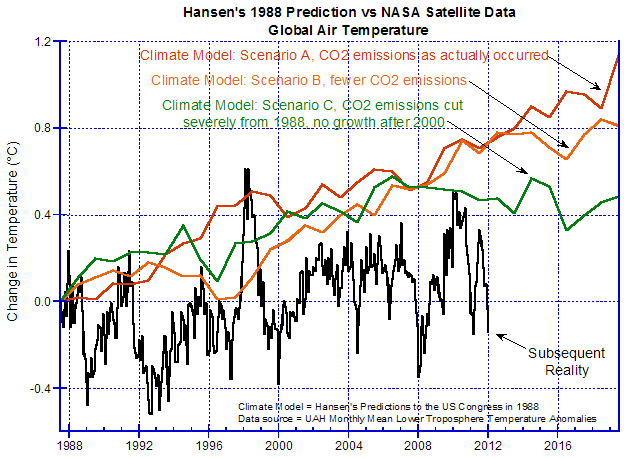

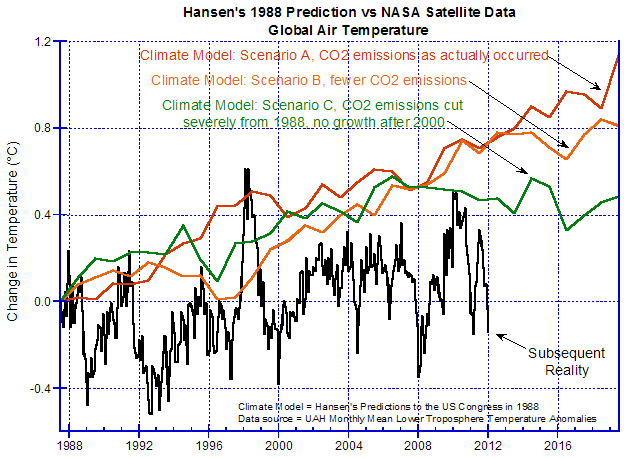

Eine der frühesten und wichtigsten Vorhersagen wurde vor dem US-Kongress im Jahre 1988 von Dr. James Hansen präsentiert, dem „Vater der globalen Erwärmung“:

Abbildung 3: Hansens Vorhersagen http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote6sym6 vor dem US-Kongress 1988, verglichen mit den nachfolgenden tatsächlichen Temperaturen, gemessen durch NASA-Satelliten http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote7sym7.

Hansens Klimamodell hat ganz klar künftige Temperaturanstiege übertrieben.

Im Einzelnen hat sein Modell die Entwicklung nach Szenario C vorhergesagt, falls die menschlichen CO2-Emissionen ab 1988 drastisch zurück gefahren werden, so dass das CO2-Niveau bis zum Jahr 2000 gar nicht mehr steigen würde. Aber in Wirklichkeit ist die Temperatur nicht einmal so stark gestiegen, obwohl die CO2-Emissionen erheblich zugenommen haben – was bedeuten würde, dass die Klimamodelle die Auswirkung der CO2-Emissionen erheblich überschätzen.

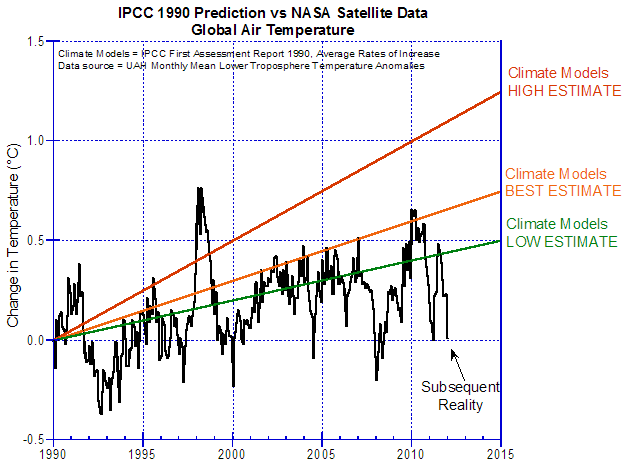

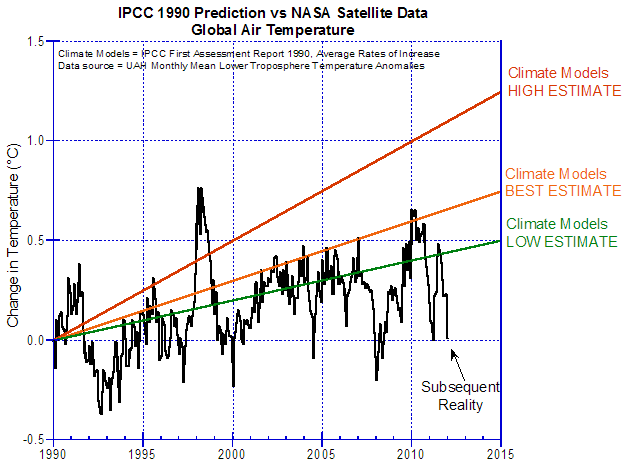

Eine genauere Vorhersage durch Klimamodelle wurde 1990 im ersten Zustandsbericht des IPCC gemacht: http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote8sym8.

Abbildung 4: Vorhersagen des IPCC in seinem ersten Zustandsbericht 1990, verglichen mit den nachfolgenden Temperaturmessungen durch NASA-Satelliten

Das war vor nunmehr 20 Jahren, und die mittlere Rate der Zunahme liegt in Wirklichkeit noch unter dem niedrigsten Trend der vom IPCC vorhergesagten Bandbreite.

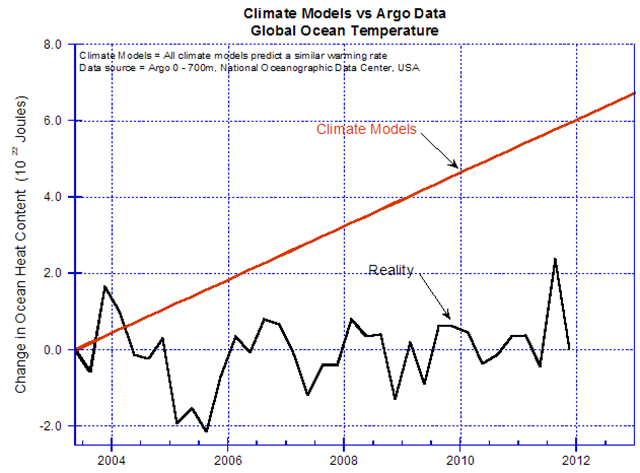

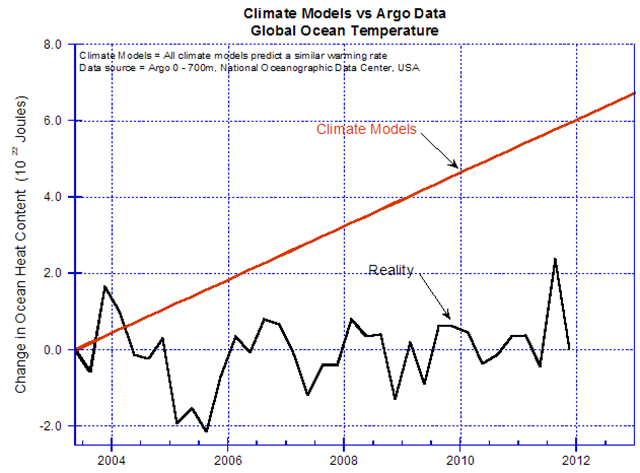

Ozeantemperaturen

Die Ozeane enthalten die große Masse der Wärme im Klimasystem. Ordentliche Messungen der Ozeantemperaturen gibt es erst seit Mitte 2003, als das ARGO-System in Betrieb genommen wurde. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote9sym9, http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote10sym10.

Abbildung 5: Vorhersagen von Klimamodellen http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote11sym11 der Ozeantemperatur im Vergleich mit den Messungen durch Argo http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote12sym12. Die Einheit der vertikalen Achse ist 1022 Joules (etwa 0,01°C)

Die Ozeantemperatur ist praktisch gleich geblieben seit dem Beginn ordentlicher Messungen und hat sich nicht so schnell erwärmt wie die Modelle vorhersagen.

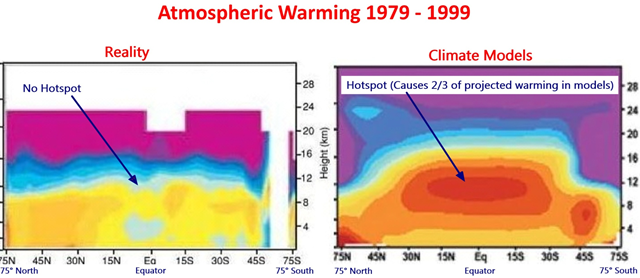

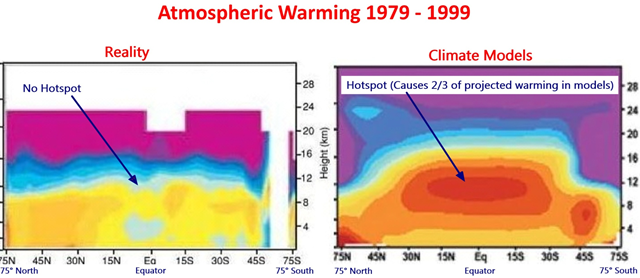

Der atmosphärische Hotspot

Während Perioden mit globaler Erwärmung sagen die Klimamodelle ein bestimmtes Muster der atmosphärischen Erwärmung vorher; die bekannteste Veränderung ist eine Erwärmung in einer Höhe von 10 km über den Tropen, der „Hotspot“.

Der Hotspot ist das Zeichen der Verstärkung in ihrer Theorie (siehe Abbildung 1). Der Theorie zufolge entsteht der Hotspot durch zusätzliche Verdunstung, und der zusätzliche Wasserdampf transportiert wärmere und feuchtere Luft in Höhen, in denen zuvor kühle, trockene Luftmassen vorherrschend waren. Die Gegenwart eines Hotspots würde ein Zeichen der Verstärkung sein, und umgekehrt.

Atmosphärische Temperaturen wurden mit Wetterballonen seit den sechziger Jahren gemessen. Millionen Wetterballone ergaben während der vergangenen Jahrzehnte ein gutes Bild der atmosphärischen Temperaturen, einschließlich der Periode mit Erwärmung von den späten siebziger bis zu den späten neunziger Jahren. Diese wichtigen und entscheidenden Daten wurden durch das Klimaestablishment bis 2006 zurückgehalten und dann an obskurer Stelle veröffentlicht. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote13sym13. Hier sind sie:

Abbildung 6: Links sieht man die von Millionen Wetterballonen gesammelten Daten. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote14sym14. Rechts sieht man das, was den Klimamodellen zufolge hätte passieren sollen. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote15sym15. Die Theorie (jedenfalls die von den Klimamodellen angenommene) ist mit den Beobachtungen nicht kompatibel. In beiden Diagrammen zeigt die horizontale Achse die geographische Breite, die rechte vertikale Achse die Höhe in Kilometern.

In Wirklichkeit gab es keinen Hotspot, nicht einmal ansatzweise. Also gibt es in Wirklichkeit keine Verstärkung – die in Abbildung 1 gezeigte Verstärkung existiert nicht. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote16sym16

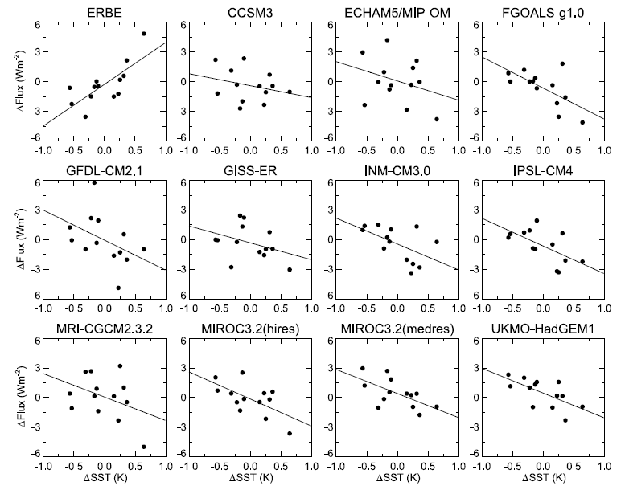

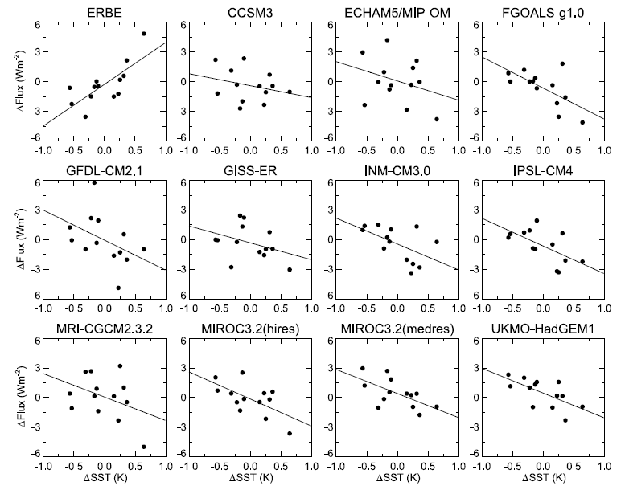

Ausstrahlung

Den Klimamodellen zufolge wird weniger Wärme in den Weltraum abgestrahlt, wenn sich die Erdoberfläche erwärmt (in wöchentlichem oder monatlichem Maßstab). Dies liegt nach der Theorie daran, dass die wärmere Oberfläche zu mehr Verdunstung führt und damit zu mehr Wärme schluckendem Wasserdampf. Dies ist der für die vermutete Verstärkung in Abbildung 1 verantwortliche Mechanismus der Wärmerückhaltung.

Satelliten haben die Ausstrahlung von der Erde während der letzten beiden Dekaden gemessen. Eine grundlegende Studie hat eine Verbindung hergestellt zwischen Änderungen der Temperatur an der Erdoberfläche und Änderungen der Ausstrahlung. Hier ist sie:

Abbildung 7: Ausstrahlung der Erde (vertikale Achse) im Vergleich zur Wassertemperatur (horizontal), gemessen durch die ERBE-Satelliten (oberer linker Graph) und wie von 11 Klimamodellen „vorhergesagt“ (andere Graphen). http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote17sym17. Man beachte, dass die Neigung der Graphen der Klimamodelle entgegen gesetzt der Neigung der Graphen der gemessenen Daten ist.

Dies zeigt, dass die Erde in Wirklichkeit mehr Strahlung aussendet, wenn die Oberfläche wärmer ist. Das ist genau das Gegenteil von den Vorhersagen der Klimamodelle. Dies zeigt, dass die Wärme den Klimamodellen zufolge viel zu stark zurück gehalten wird, und dass deren vermutete Verstärkung laut Abbildung 1 nicht existiert.

Schlussfolgerungen

Die Herkunft all dieser Daten hier ist unfehlbar angegeben – Satelliten, ARGO und Wetterballone. http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote18sym18

Die Luft- und Wassertemperatur zeigen, dass die Klimamodelle Temperaturanstiege übertreiben. Das Klimaestablishment schiebt diese Abkühlung auf bisher nicht entdeckte Aerosole, was für das bisherige Scheitern der Modelle verantwortlich sein könnte, aber diese Entschuldigung wird immer dünner – es wird immer noch nicht so viel wärmer, wie sie sagen, oder auf eine Art und Weise, die sie sagen. Andererseits ist der Anstieg der Lufttemperatur stärker ausgefallen als die Skeptiker nur wegen des CO2 gesagt haben. Die Entschuldigung der Skeptiker lautet, dass der Anstieg zumeist durch andere Faktoren ausgelöst worden ist – und sie weisen darauf hin, dass sich die Welt in einem fast gleichmäßigen Erwärmungstrend von 0,5°C pro Jahrhundert seit 1680 befindet (mit alternierenden, etwa 30 Jahre langen Perioden von Erwärmung und leichter Abkühlung). Hingegen gab es den massiven anthropogenen CO2-Ausstoß erst nach 1945.

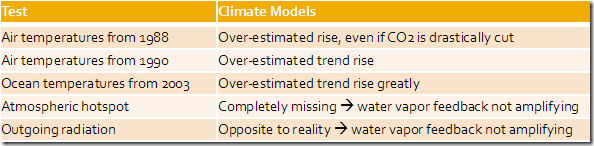

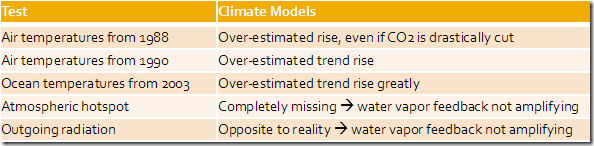

Wir haben alle wesentlichen Vorhersagen der Klimamodelle mit den besten Daten verglichen:

Die Klimamodelle waren durch die Bank falsch. Der fehlende Hotspot und die Daten der Ausstrahlung beweisen beide unabhängig voneinander, dass die Verstärkung in den Klimamodellen in Wirklichkeit nicht vorhanden ist. Ohne die Verstärkung würden die Temperaturvorhersagen der Klimamodelle um mindestens zwei Drittel niedriger ausfallen. Dies würde erklären, warum sie die gegenwärtigen Luft- und Wassertemperaturen so überschätzt haben.

Also:

- Die Klimamodelle haben fundamental versagt. Deren vorhergesagte dreifache Verstärkung durch Rückkopplungen ist in Wirklichkeit nicht existent.

- Die Klimamodelle überschätzen die Temperaturanstiege infolge CO2 mindestens um einen Faktor drei.

Der Standpunkt der Skeptiker ist mit den Daten kompatibel.

Einige politische Punkte

Die hier präsentierten Daten stammen aus eindeutigen Quellen, sie sind sehr relevant, öffentlich zugänglich und von den besten Instrumenten gemessen. Und doch tauchen sie niemals in den Main-Stream-Medien auf – oder haben Sie jemals so etwas wie einige der Abbildungen hier darin gesehen? Das allein sagt doch schon, dass die „Debatte“ um Politik und Macht geht, und nicht um Wissenschaft oder Wahrheit.

Dies ist eine ungewöhnliche politische Sache, weil es eine richtige und eine falsche Antwort gibt und jeder wissen kann, welche zutrifft. Die Leute schreiten voran und emittieren CO2 in jedem Falle, also machen wir das Experiment: Entweder heizt sich die Erde bis 2050 um mehrere Grad auf, oder eben nicht.

Man beachte, dass die Skeptiker mit den Klimawissenschaftlern der Regierung über die direkte Auswirkung des CO2 übereinstimmen; Uneinigkeit herrscht lediglich über die Rückkopplungen. In der Klimadebatte geht es nur um diese Rückkopplungen, alles andere sind Nebenschauplätze. Und doch weiß das kaum jemand. Die Klimawissenschaftler der Regierung und die Main-Stream-Medien haben die Debatte auf die direkten Auswirkungen des CO2 verengt und auf Nebenschauplätze wie das arktische Eis, schlechtes Wetter oder Psychologie. Sie erwähnen fast niemals die Rückkopplungen. Warum ist das so? Wer hat die Macht, das zu steuern?

About the Author*

*Die Angaben zum Autor werden wegen der vielen Institutsbezeichnungen und aus Zeitgründen nicht übersetzt. Man kann leicht mehr über ihn durch die angegebenen Links erfahren. A. d. Übers.

Dr David M.W. Evans consulted full-time for the Australian Greenhouse Office (now the Department of Climate Change) from 1999 to 2005, and part-time 2008 to 2010, modeling Australia’s carbon in plants, debris, mulch, soils, and forestry and agricultural products. Evans is a mathematician and engineer, with six university degrees including a PhD from Stanford University in electrical engineering. The area of human endeavor with the most experience and sophistication in dealing with feedbacks and analyzing complex systems is electrical engineering, and the most crucial and disputed aspects of understanding the climate system are the feedbacks. The evidence supporting the idea that CO2 emissions were the main cause of global warming reversed itself from 1998 to 2006, causing Evans to move from being a warmist to a skeptic.

Inquiries to david.evans@sciencespeak.com.

Republished on www.wattsupwiththat.com

Dieser Artikel ist als .pdf einzusehen bei: TheSkepticsCase

============================================================

Anmerlungen

1) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote1anc

Allgemeiner: falls das CO2-Niveau x (in parts per million) ist, dann schätzen die Klimamodelle die Temperaturzunahme infolge des zusätzlichen CO2 verglichen mit dem vorindustriellen Niveau von 280 ppm mit 4,33 ln(x/280). Zum Beispiel ordnet dieses Modell einen Temperaturanstieg von 4,33 ln(392/280) = 1.46°C einer CO2-Zunahme bis heute auf 392 ppm zu.

2) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote2anc

Die direkte Auswirkung des CO2 bleibt für jede Verdoppelung des CO2-Niveaus die gleiche (d. h. logarithmisch). Berechnungen der gestiegenen Oberflächentemperatur infolge einer CO2-Verdoppelung variieren von 1,0°C bis 1,2°C. In diesem Dokument verwenden wir den mittleren Wert von 1,1°C; allerdings hat der Wert keine Bedeutung für die hier beschriebenen Argumente.

3) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote3anc

Das IPCC projizierte 2007 in seinem jüngsten Zustandsbericht eine Temperaturzunahme bei einer Verdoppelung des CO2-Gehaltes (genannt Klimasensitivität) in einer Größenordnung von 2,0°C bis 4,5°C. Der zentrale Punkt in ihrem Modell schätzt 3,3°C, was drei mal der direkten Auswirkung des CO2 von 1,1°C entspricht, also sagen wir der Einfachheit halber, dass ihre Übertreibung dreifach ist. Präziser, jedes Klimamodell hat eine etwas unterschiedliche effektive Verstärkung, aber allgemein liegen sie um 3,0.

4) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote4anc

Allgemeiner: falls das CO2-Niveau x (in parts per million) ist, dann schätzen die Skeptiker die Temperaturzunahme infolge des zusätzlichen CO2 verglichen mit dem vorindustriellen Niveau von 280 ppm mit 0,72 ln(x/280). Zum Beispiel ordnen die Skeptiker einen Temperaturanstieg von 0,72 ln(392/280) = 0,24°C einer CO2-Zunahme bis heute auf 392 ppm zu.

5) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote5anc

Die Auswirkung der Rückkopplungen lässt sich nur schwer mit einem empirischen Beweis nachweisen, weil es viel mehr Kräfte gibt, die die Temperatur beeinflussen als nur eine Änderung des CO2-Niveaus, aber es scheint eine Multiplikation irgendwo zwischen 0,25 und 0,9 zu sein. Der Einfachheit halber haben wir hier den Wert 0,5 benutzt.

6) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote6anc

Hansens Vorhersagen stehen hier (20. August 1988), Abb. 3a Seite 9347. In der Graphik hier werden Hansens drei Szenarien alle am gleichen Punkt gestartet Mitte 1987 – wir sind nur an Änderungen (Anomalien) interessiert.

7) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote7anc

Die hier gezeigte Temperatur der Erde ist durch NASA-Satelliten gemessen worden, die die Temperatur der Erde seit 1979 vermessen, betrieben von der University of Alabama in Huntsville (UAH). Satelliten messen die Temperatur 24/7 [?] in breiten Streifen von Land und Wasser in der ganzen Welt außer an den Polen. Während es bei den Satelliten einige Probleme bei der Anfangskalibrierung gab, sind diese seit Langem zu jedermann’s Zufriedenheit gelöst worden. Satelliten sind die verlässlichsten, ergiebigsten und am wenigsten verzerrten Instrumente der Menschen, um die Lufttemperatur seit 1979 zu messen. Dies ist eine unfehlbare Datenquelle, und jeder kann sich die Daten selbst von hier herunter laden (Vorgehensweise: …)

8) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote8anc

Erster Zustandsbericht des IPCC 1990, Seite 22 (www.ipcc.ch/ipccreports/far/wg_I/ipcc_far_wg_I_full_report.pdf) in der Zusammenfassung für Politiker, Abbildung 8 und zugehöriger Text für das Szenario weiter-wie-bisher (was tatsächlich passiert ist, da es bis heute keine signifikanten Kontrollen über und eine Abnahme der Emissionen gibt). „Unter dem Weiter-wie-bisher-Szenario (A) des IPCC bzgl. der Emission von Treibhausgasen wird die mittlere Rate der globalen Temperaturzunahme im kommenden Jahrhundert mit etwa 0,3°C pro Jahrzehnt geschätzt (mit einer Unsicherheit von 0,2°C bis 0,5°C)“

9) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote9anc

http://www.metoffice.gov.uk/weather/marine/observations/gathering_data/argo.html

10) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote10anc

Messungen der Ozeantemperatur vor dem ARGO-Programm sind praktisch wertlos. Zuvor wurde die Ozeantemperatur mit Eimern gemessen oder mit Bathythermographen (XBTs) – wobei es sich um nur einmal verwendbare, im Wasser absinkende Messsonden handelt, die Temperatur- und Druckdaten übermitteln. Fast alle diese Messungen erfolgten entlang der hauptsächlichen kommerziellen Schifffahrtsrouten, so dass die geographische Ausbreitung der Messungen ärmlich war – zum Beispiel wurden die riesigen südlichen Ozeane überhaupt nicht erfasst. XBTs reichen nicht so tief wie die ARGO-Bojen, und ihre Daten sind viel weniger präzise und viel weniger akkurat (u. a. weil sie sich zu schnell durch das Wasser bewegen, um in ein Gleichgewicht mit dem umgebenden Wasser zu kommen, dessen Temperatur gemessen werden soll).

11) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote11anc

Die Klimamodelle nehmen eine Zunahme des ozeanischen Wärmegehalts von etwa 0,7 × 10^22 Joules pro Jahr an. Siehe Hansen et al. 2005: Earth’s energy imbalance: Confirmation and implications. Science, 308, 1431-1435, Seite 1432 (pubs.giss.nasa.gov/cgi-bin/abstract.cgi?id=ha00110y), wobei die Zunahme des Wärmegehaltes in Quadratmeter Oberfläche in den oberen 750 m den typischen Modellen zufolge etwa 6,0 Watt/m² pro Jahr beträgt. Das wird zu 0.7 × 10^22 Joules pro Jahr für den gesamten Ozean, was hier erklärt wird.

12) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote12anc

Der Wärmegehalt der Ozeane bis zu einer Tiefe von 700 m gemessen durch ARGO ist jetzt verfügbar, man kann es von hier herunter laden. Die Zahlen zeigen die Änderungen des mittleren Wärmegehalts während drei Monaten in Einheiten von 10^22 Joules, jahreszeitlich angepasst. Das ARGO-System ging Mitte 2003 in Betrieb, daher beginnen unsere Daten im Juni 2003.

13)http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote13anc

Die Daten der Wetterballone, die die Erwärmungsverteilung in der Atmosphäre zeigen, wurden schließlich 2006 veröffentlicht, und zwar im US Climate Change Science Program, Teil E von Abbildung 5.7 auf Seite 116 (www.climatescience.gov/Library/sap/sap1-1/finalreport/sap1-1-final-chap5.pdf). Es gibt keine anderen Daten aus dieser Zeit, und wir können keine weiteren Daten atmosphärischer Erwärmung erhalten, bis die globale Erwärmung wieder einsetzt. Dies sind die einzigen Daten, die es gibt. Übrigens, ist das nicht eine obskure Stelle, um so wichtige und entscheidende Daten zu veröffentlichen – Sie glauben nicht, dass sie etwas verbergen wollen, oder?

14)http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote14anc

Siehe vorige Anmerkung.

15)http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote15anc

Jedes beliebige Klimamodell, zum Beispiel aus dem AR 4 des IPCC 2007, Kapitel 9, Seite 675. Man kann es auch im Internet einsehen, und zwar hier (Abbildung 9.1, Teile c und f). Es gab eine geringe Erwärmung von 1959 bis 1977, so dass die allgemein verfügbaren Simulationen von 1959 bis 1999 auch anwendbar sind.

16) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote16anc

Also beträgt der Multiplikationsfaktor in der zweiten Box der Abbildungen 1 und 2 höchstens 1,0.

17) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote17anc

Lindzen und Choi 2009, Geophysical Research Letters Vol. 36: http://www.drroyspencer.com/Lindzen-and-Choi-GRL-2009.pdf. Die Studie wurde nach einiger Kritik korrigiert, kommt aber im Wesentlichen 2011 wieder zum gleichen Ergebnis: www-eaps.mit.edu/faculty/lindzen/236-Lindzen-Choi-2011.pdf.

18) http://wattsupwiththat.com/2012/02/26/the-skeptics-case/ – sdendnote18anc

Im Einzelnen haben wir Ergebnisse von Thermometern an Land nicht genannt, oder von den vereinzelten Beispielen mit Eimern und XBTs auf dem Meer. Thermometer an Land sind notorisch empfänglich für lokale Effekte – siehe Is the Western Climate Establishment Corrupt? durch den gleichen Autor: jonova.s3.amazonaws.com/corruption/climate-corruption.pdf

Link: http://wattsupwiththat.com/2012/02/26/the-skeptics-case/

Autor: David M. W. Evans

Übersetzt von Chris Frey

*Die Überschrift wurde bewusst nicht übersetzt. Man könnte es mit „Der Fall der Skeptiker“ versuchen, aber das wäre schwer missverständlich. – A. d. Übers.